Visão geral da computação de métricas ambientais, sociais e de governança

Importante

Algumas ou todas estas funcionalidades estão disponíveis como parte de uma versão preliminar. O conteúdo e a funcionalidade estão sujeitos a alterações.

Você pode selecionar e calcular as métricas predefinidas usando os notebooks e pipelines predefinidos implantados como parte desse recurso.

Observação

Você pode estender os notebooks e pipelines para oferecer suporte a métricas personalizadas. Para obter mais informações, acesse Criar métricas personalizadas.

Pré-requisitos

Carregue as definições de métricas pré-criadas nas tabelas MetricsDefinitions e MetricsLabels no lakehouse ComputedESGMetrics_LH executando o notebook LoadDefinitionsForMetrics . Você só precisa executar esta etapa uma vez. Os cadernos de computação de métricas extraem a definição da métrica dessas tabelas.

Você pode então consultar a tabela MetricsDefinitions para visualizar as definições de métricas. Para cada métrica, você pode ver as propriedades da métrica:

- nome da métrica

- medida

- dimensões

- filtros

- área de sustentabilidade

Você também pode consultar a tabela MetricsLabels para explorar as métricas por rótulos, como Padrão de relatório e Ponto de dados de divulgação.

Você pode então explorar a Biblioteca de métricas pré-criadas para determinar o conjunto de dados agregados a ser preenchido para calcular a respectiva métrica pré-criada.

Consulte Gerar tabelas agregadas para descobrir as respectivas tabelas do modelo de dados ESG e os atributos a serem preenchidos para gerar as tabelas agregadas.

Ingira, transforme e carregue os dados transformados nas tabelas do modelo de dados ESG no lakehouse ProcessedESGData_LH, implantado como parte do recurso de propriedade de dados ESG no mesmo espaço de trabalho. ...

Autentique os modelos semânticos pré-criados (DatasetForMetricsMeasures e DatasetForMetricsDashboard) usados no cálculo da métrica criando uma conexão. Você só precisa executar esta etapa uma vez.

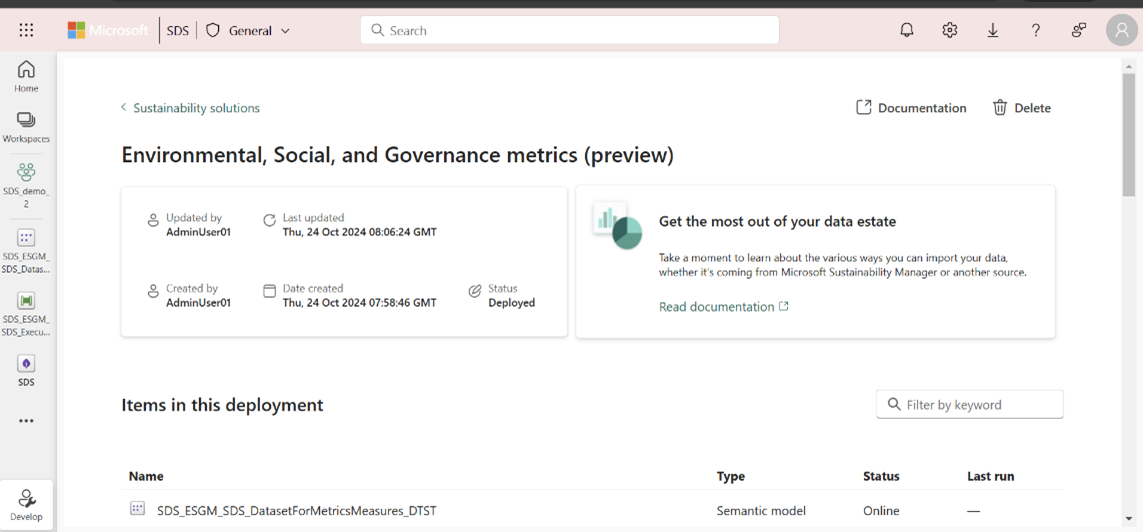

Selecione o modelo semântico DatasetForMetricsMeasures_DTST na página de recursos gerenciados para abrir o modelo semântico. Selecione Configurações no menu Arquivo . Você também pode abrir o item na página do espaço de trabalho.

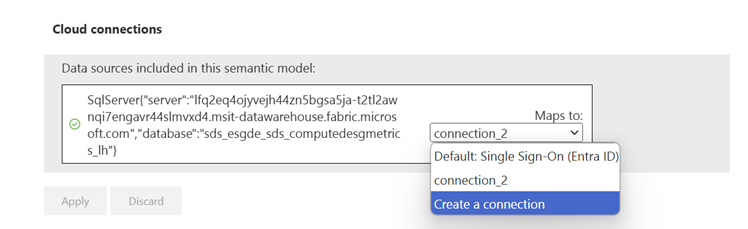

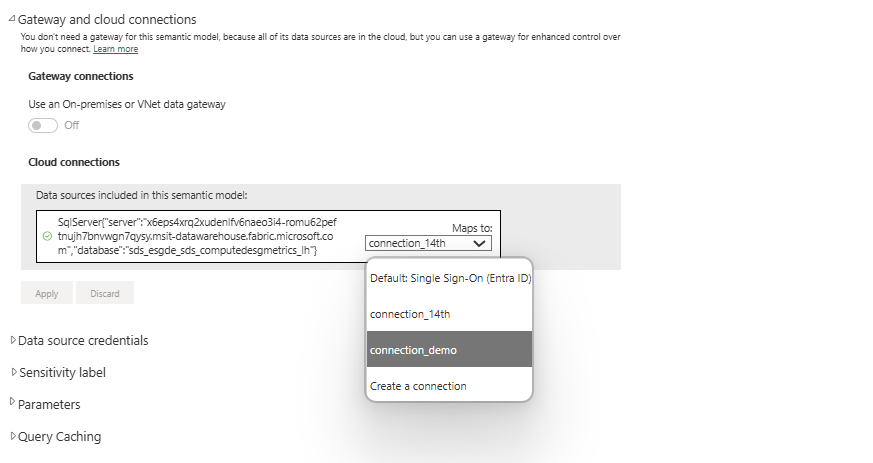

Selecione Gateway e conexões de nuvem e, em seguida, selecione Criar uma nova conexão na caixa suspensa Conexões de nuvem . Um painel lateral Nova conexão é aberto.

No painel lateral Nova conexão , insira o nome da conexão, insira OAuth 2.0 para o método de autenticação, edite as credenciais e selecione Criar.

Selecione a conexão criada na seção Conexões de gateway e nuvem .

Da mesma forma, configure uma conexão para o modelo semântico DatasetForMetricsDashboard_DTST . Abra o modelo semântico na página do espaço de trabalho, selecione Configurações no menu Arquivo e siga as mesmas etapas seguidas para DatasetForMetricsMeasures_DTST.

Use o runtime 1.3 (Spark 3.5, Delta 3.2) para executar os notebooks e pipelines pré-criados. Apache Spark

Se você estiver usando o pipeline ExecuteComputationForMetrics_DTPL para calcular métricas, também precisará executar estas etapas:

Crie uma conexão para autenticar a atividade Criar tabelas agregadas do pipeline para usar o pipeline GenerateAggregateForMetrics :

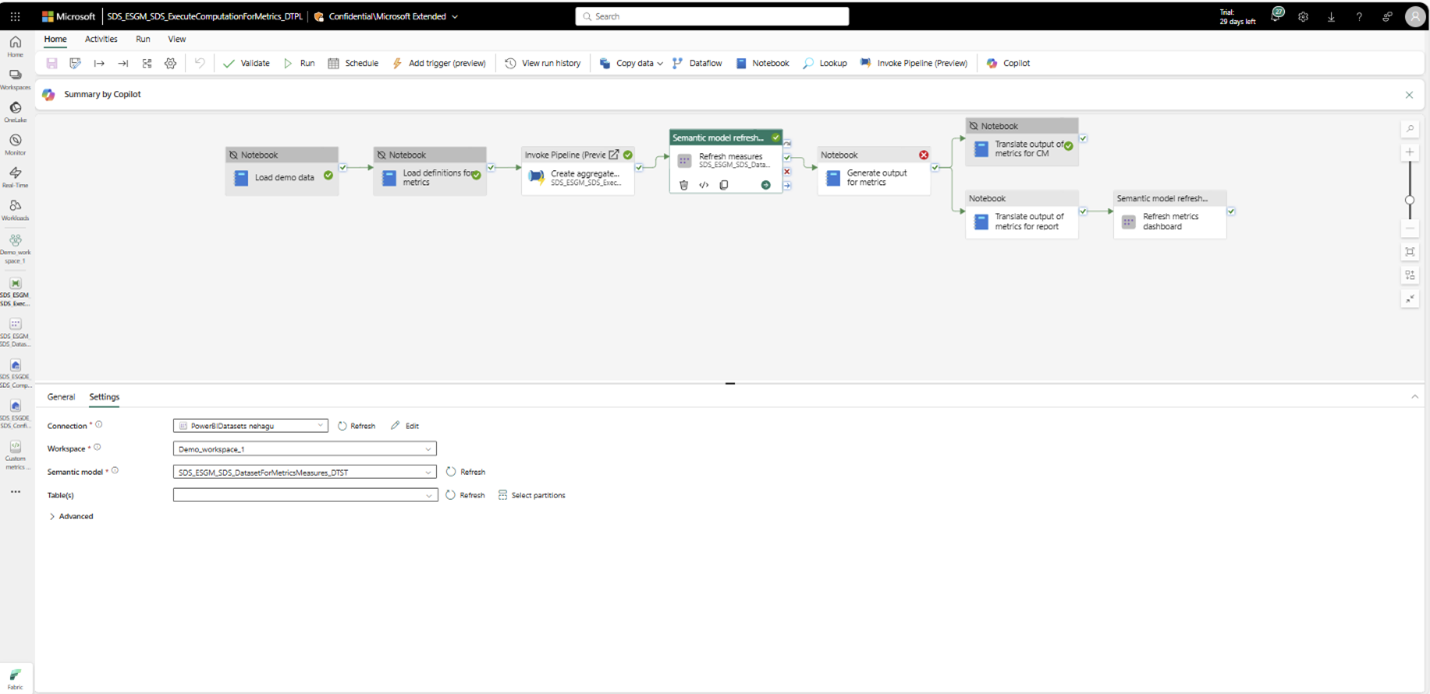

Da mesma forma, autentique configurando conexões para medidas de atualização e métricas de atualização para as atividades do painel do pipeline:

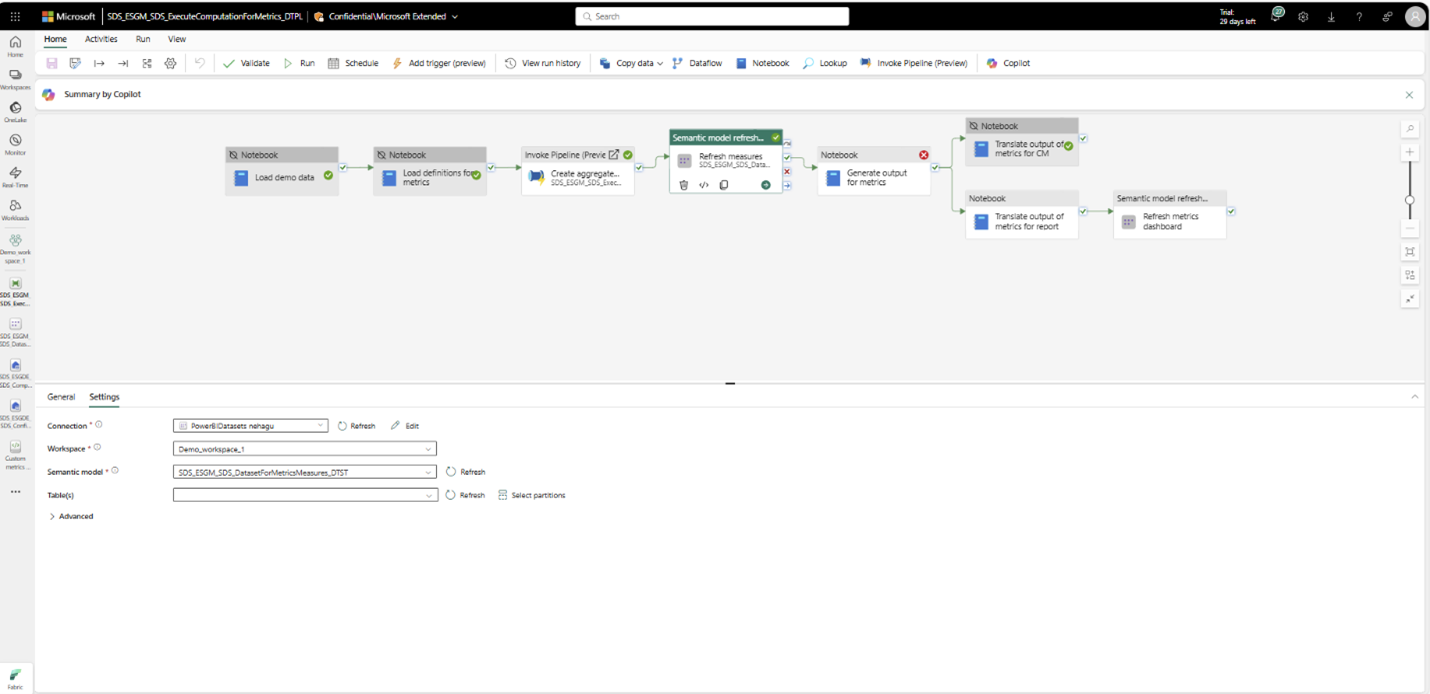

Explore com dados de demonstração

Se você estiver explorando o recurso com dados de demonstração e quiser apenas visualizar a saída de todas as métricas, poderá executar o pipeline ExecuteComputationForMetrics_DTPL . Este pipeline fornece uma experiência de ponta a ponta, desde o carregamento dos dados de demonstração no lakehouse ProcessedESGData_LH até o cálculo das métricas pré-criadas. Para saber mais sobre como configurar dados de demonstração, acesse Configurar dados de demonstração.

Antes de executar o pipeline, certifique-se de ter seguido as etapas 3 a 5 na seção Pré-requisitos .

Em seguida, crie uma conexão para autenticar a atividade Criar tabelas agregadas do pipeline para usar o pipeline GenerateAggregateForMetrics :

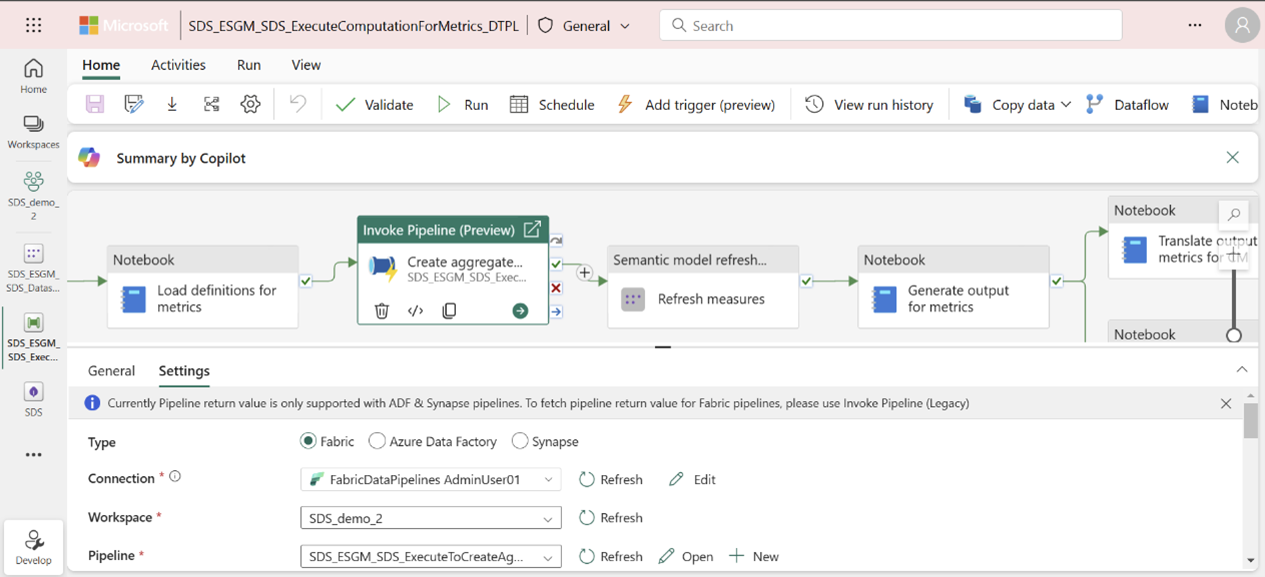

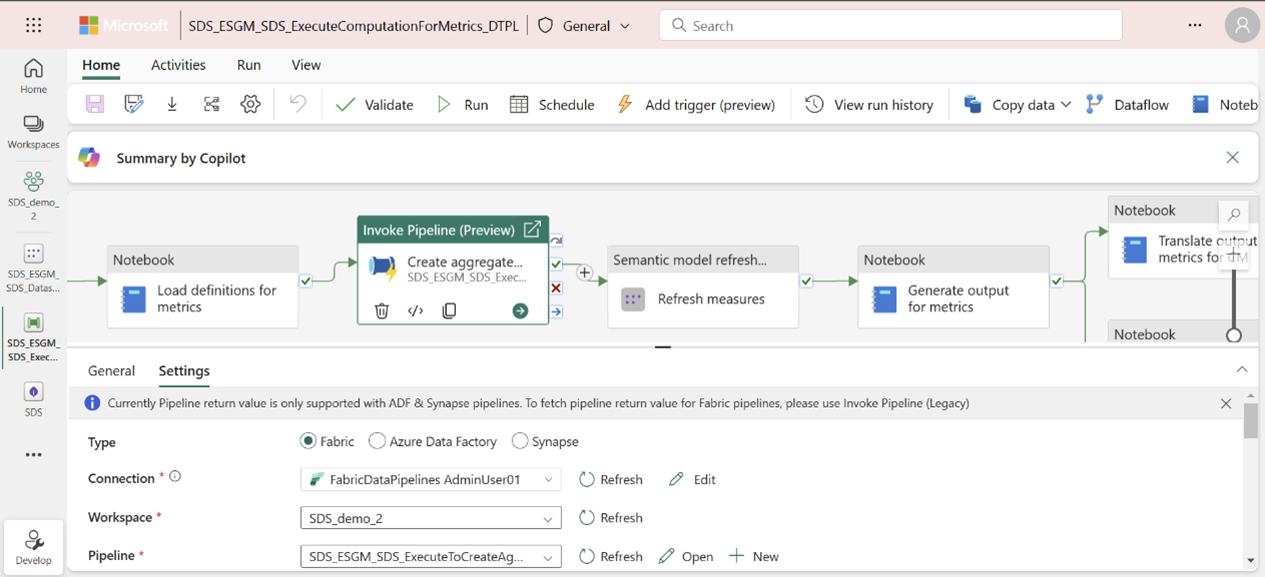

Abra o pipeline ExecuteComputationForMetrics_DTPL na página de capacidade gerenciada ou espaço de trabalho.

Selecione a atividade de pipeline Criar tabelas agregadas e, em seguida, selecione Configurações para configurar uma conexão.

Da mesma forma, autentique configurando conexões para Medidas de atualização e Métricas de atualização para as atividades do painel do pipeline. Selecione a atividade, selecione Configurações e, em seguida, selecione uma conexão no atributo Conexão .

Observação

Essas etapas de configuração de conexão são únicas e não são necessárias para execuções de pipeline subsequentes.

Depois de concluir essas etapas, selecione Executar para executar o pipeline. Você pode monitorar o pipeline selecionando o botão Exibir histórico de execução .

Este pipeline realiza estas atividades:

Carregar dados de demonstração: carrega os dados de demonstração que vêm com o recurso de propriedade de dados ESG no lakehouse ProcessedESGData_LH.

Observação

Se você mapeou seus dados de origem no processedESGData lakehouse, você pode desativar essa atividade antes de executar o pipeline para calcular métricas.

Carregar definições de métricas: carrega as definições de métricas contidas em metrics_definitions_config.json para a tabela MetricsDefinitions em ComputedESGMetrics_LH. Esta tabela é usada para buscar detalhes de métricas, como lógica de computação, nome da métrica e área de sustentabilidade.

Observação

Esta atividade só precisa ser realizada uma vez. Após o carregamento das definições de métricas pré-criadas, você pode desativar essa atividade de pipeline para execuções de pipeline subsequentes, a menos que as definições de métricas sejam atualizadas no arquivo metrics_definitions_config.json .

Atualize o modelo semântico de medidas seguindo a etapa 2 em Gerar tabelas agregadas.

Traduzir saída de métricas para consumo do Compliance Manager.

Traduzir saída de métricas para consumo de painel Power BI pré-criado.

Observação

Se você quiser executar uma atividade específica do pipeline, poderá desativar as outras atividades. Para obter mais informações, acesse Desativar uma atividade.

Computar dados de métricas

Para calcular as métricas ESG, siga as instruções nestes artigos: