Planejando sua migração do Azure Data Factory

O Microsoft Fabric é o produto SaaS de análise de dados da Microsoft que reúne todos os produtos de análise líderes de mercado da Microsoft em uma única experiência de usuário. O Fabric Data Factory fornece orquestração de fluxo de trabalho, movimentação de dados, replicação de dados e transformação de dados em escala com funcionalidades semelhantes encontradas no AdF (Azure Data Factory). Se você tiver investimentos existentes do ADF que gostaria de modernizar para o Fabric Data Factory, este documento será útil para ajudá-lo a entender as considerações, estratégias e abordagens de migração.

A migração dos pipelines e dos fluxos de dados do Synapse e do ADF de serviços de ETL/DI de PaaS do Azure pode oferecer vários benefícios importantes:

- Novos recursos de pipeline integrados, incluindo email e atividades do Teams, permitem o roteamento fácil de mensagens durante a execução do pipeline.

- Os recursos internos de CI/CD (integração e entrega contínua) (pipelines de implantação) não exigem integração externa com repositórios Git.

- A integração do workspace ao data lake do OneLake permite o gerenciamento de análise fácil de painel de controle único.

- Atualizar seus modelos de dados semânticos é fácil no Fabric com uma atividade de pipeline totalmente integrada.

O Microsoft Fabric é uma plataforma integrada para dados corporativos gerenciados por TI e de autoatendimento. Com o crescimento exponencial em volumes de dados e complexidade, os clientes do Fabric exigem soluções empresariais que dimensionam, são seguras, fáceis de gerenciar e acessíveis a todos os usuários na maior das organizações.

Nos últimos anos, a Microsoft investiu esforços significativos para fornecer recursos de nuvem escalonáveis ao Premium. Para isso, o Data Factory in Fabric capacita instantaneamente um grande ecossistema de desenvolvedores de integração de dados e soluções de integração de dados que foram criadas ao longo de décadas para aplicar o conjunto completo de recursos e funcionalidades que vão muito além da funcionalidade comparável disponível nas gerações anteriores.

Naturalmente, os clientes estão perguntando se há uma oportunidade de se consolidar hospedando suas soluções de integração de dados no Fabric. As perguntas comuns incluem:

- Todas as funcionalidades das quais dependemos funcionam nos pipelines do Fabric?

- Quais funcionalidades estão disponíveis apenas em pipelines do Fabric?

- Como migrar pipelines existentes para os pipelines do Fabric?

- Qual é o roteiro da Microsoft para ingestão de dados corporativos?

Diferenças de plataforma

Quando você migra uma instância inteira do ADF, há muitas diferenças importantes a serem consideradas entre o ADF e o Data Factory no Fabric, o que se torna importante à medida que você migra para o Fabric. Exploramos várias dessas diferenças importantes nesta seção.

Para obter uma compreensão mais detalhada do mapeamento funcional das diferenças de recursos entre o Azure Data Factory e o Fabric Data Factory, consulte Compare Data Factory in Fabric e Azure Data Factory.

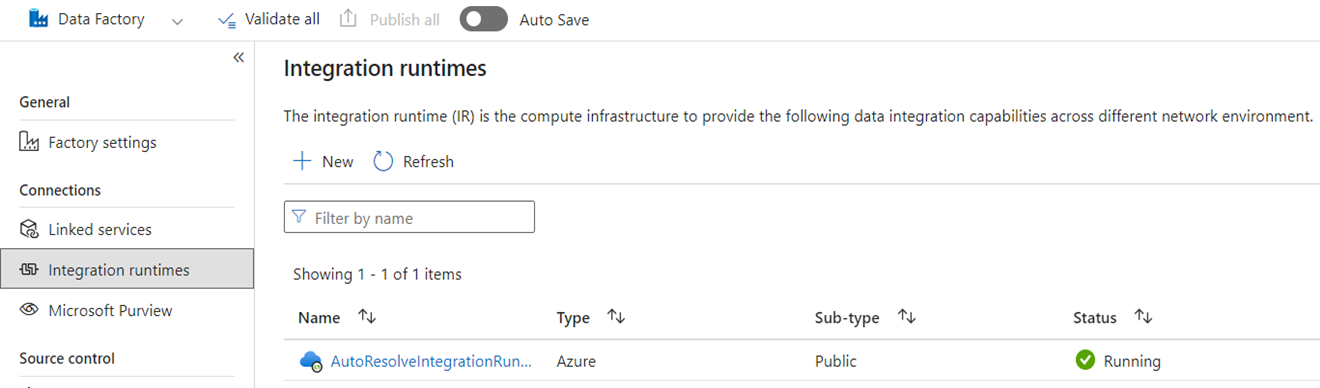

Runtimes de integração

No ADF, os IRs (integration runtimes) são objetos de configuração que representam a computação usada pelo ADF para concluir o processamento de dados. Essas propriedades de configuração incluem a região do Azure para a computação na nuvem e os tamanhos de computação do Spark de fluxo de dados. Outros tipos de IR incluem SHIRs (IRs auto-hospedados) para conectividade de dados local, IRs do SSIS para executar pacotes do SQL Server Integration Services e IRs de nuvem habilitadas para VNet.

O Microsoft Fabric é um produto SaaS (software como serviço), enquanto o ADF é um produto paaS (plataforma como serviço). O que essa distinção significa em termos de runtimes de integração é que você não precisa configurar nada para usar pipelines ou fluxos de dados no Fabric, pois o padrão é usar a computação baseada em nuvem na região em que as capacidades do Fabric estão localizadas. Os IRs do SSIS não existem no Fabric e, para a conectividade de dados local, é usado um componente do Fabric conhecido como OPDG (gateway de dados local). Para a conectividade baseada em rede virtual com redes protegidas, é usado o gateway de dados de rede virtual no Fabric.

Ao migrar do ADF para o Fabric, você não precisa migrar IRs de rede pública do Azure (nuvem). Você precisa recriar seus SHIRs como OPDGs e IRs do Azure habilitados para rede virtual como gateways de dados de rede virtual.

Tubulações

Os pipelines são o componente fundamental do ADF, que é usado para o fluxo de trabalho primário e a orquestração dos processos do ADF para movimentação de dados, transformação de dados e orquestração de processos. Os pipelines no Fabric Data Factory são quase idênticos aos do ADF, mas com componentes extras que se adequam bem ao projeto SaaS baseado no Power BI. Essa semelhança inclui atividades nativas para emails, Teams e atualizações de modelo semântico.

A definição JSON de pipelines no Fabric Data Factory difere ligeiramente do ADF devido a diferenças no modelo de aplicativo entre os dois produtos. Devido a essa diferença, não é possível copiar/colar o JSON de pipeline, importar/exportar pipelines ou apontar para um repositório Git do ADF.

Ao recriar seus pipelines do ADF como pipelines do Fabric, você usa essencialmente os mesmos modelos e as mesmas habilidades de fluxo de trabalho usados no ADF. A principal consideração tem a ver com serviços vinculados e conjuntos de dados que são conceitos no ADF que não existem no Fabric.

Serviços Vinculados

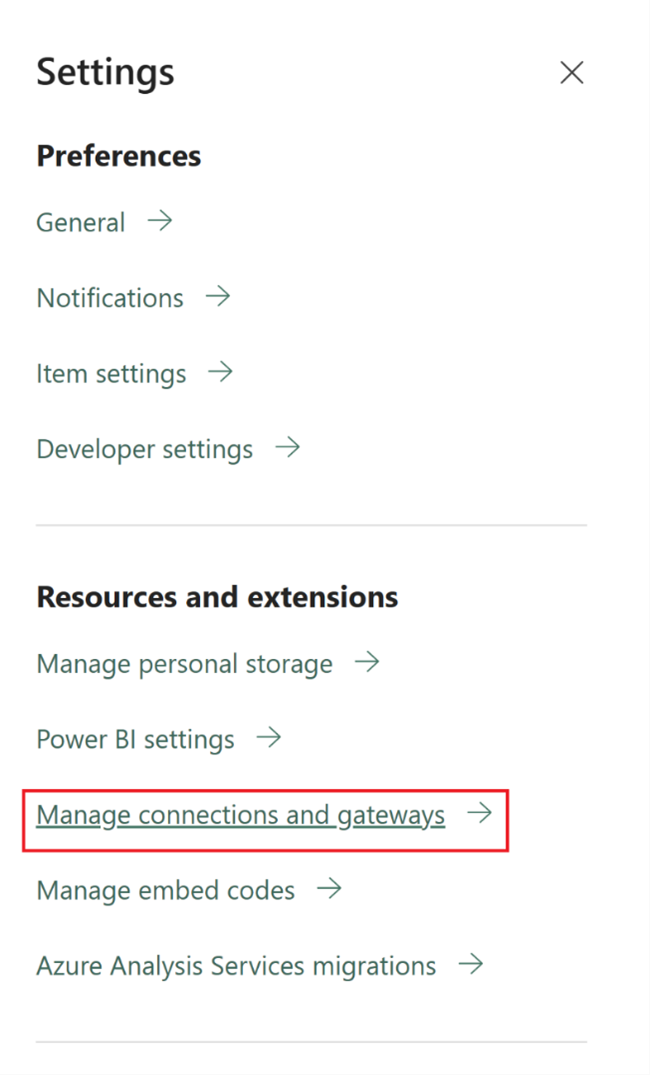

No ADF, os Serviços Vinculados definem as propriedades de conectividade necessárias para se conectar aos armazenamentos de dados para atividades de movimentação de dados, transformação de dados e processamento de dados. No Fabric, você precisa recriar essas definições como Conexões que são propriedades para suas atividades, como Copiar e Fluxos de Dados.

Conjuntos de Dados

Os conjuntos de dados definem a forma, o local e o conteúdo dos dados no ADF, mas não existem como entidades no Fabric. Para definir propriedades de dados como tipos de dados, colunas, pastas, tabelas etc. em pipelines do Data Factory do Fabric, defina essas características em linha dentro das atividades de pipeline e dentro do objeto de conexão referenciado anteriormente na seção Serviço vinculado.

Fluxos de dados

No Data Factory for Fabric, o termo fluxos de dados refere-se às atividades de transformação de dados sem código, enquanto no ADF, o mesmo recurso é conhecido como fluxos de dados . Os fluxos de dados do Fabric Data Factory têm uma interface do usuário criada no Power Query, que é usada na atividade do ADF Power Query. A computação usada para executar fluxos de dados no Fabric é um mecanismo de execução nativo que pode ser escalado horizontalmente para a transformação de dados em grande escala com o novo mecanismo de computação do Data Warehouse do Fabric.

No ADF, os fluxos de dados são criados na infraestrutura do Synapse Spark e definidos por meio de uma interface do usuário de construção que usa uma DSL (linguagem específica de domínio) subjacente conhecida como script de fluxo de dados. Essa linguagem de definição difere consideravelmente dos fluxos de dados baseados no Power Query no Fabric que usam uma linguagem de definição conhecida como M para definir seu comportamento. Devido a essas diferenças nas interfaces do usuário, linguagens e mecanismos de execução, os fluxos de dados do Fabric e fluxos de dados do ADF não são compatíveis e você precisa recriar os fluxos de dados do ADF como fluxos de dados do Fabric ao atualizar suas soluções para o Fabric.

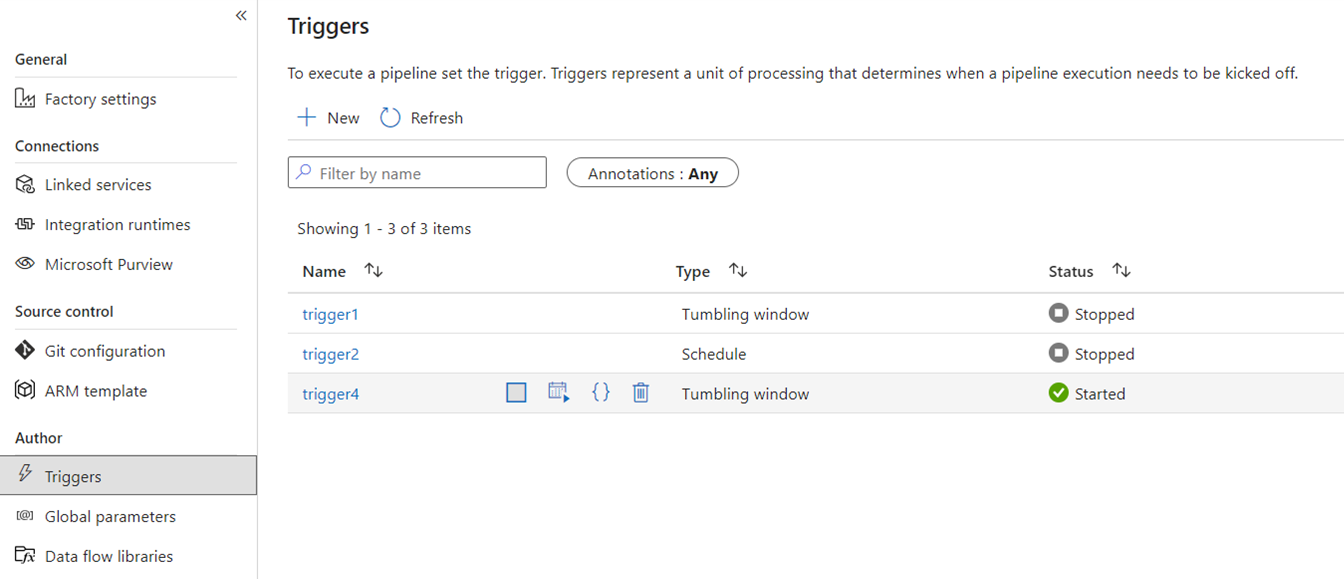

Gatilhos

Os gatilhos sinalizam para o ADF executar um pipeline com base em uma agenda de horário padrão, fatias de tempo de janela em cascata, eventos baseados em arquivos ou eventos personalizados. Esses recursos são semelhantes no Fabric, embora a implementação subjacente seja diferente.

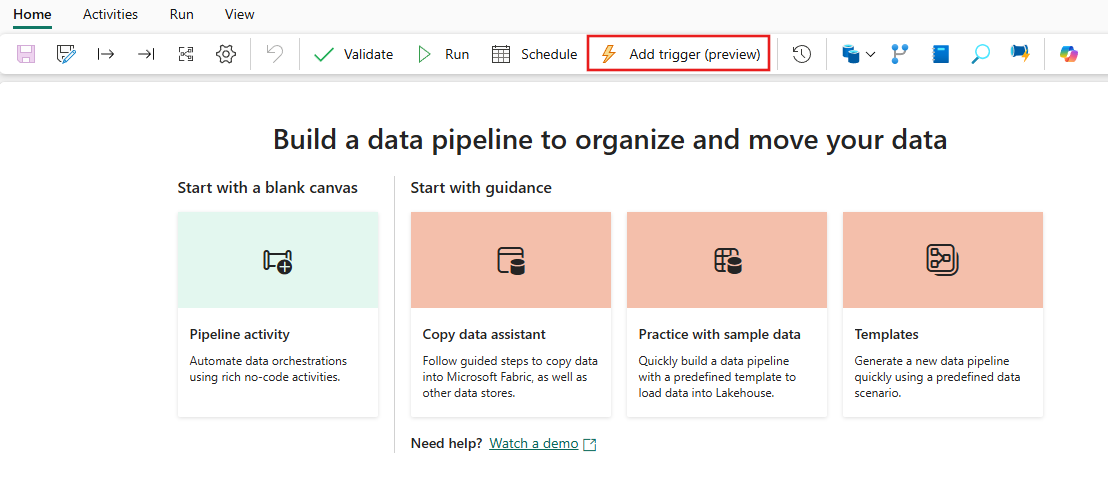

No Fabric, os gatilhos só existem como um conceito de pipeline. A estrutura maior usada pelos gatilhos de pipeline no Fabric é conhecida como Data Activator, um subsistema de eventos e alertas dos recursos de inteligência em tempo real do Fabric.

O Fabric Data Activator tem alertas que podem ser usados para criar eventos de arquivo e gatilhos de evento personalizados. Embora os gatilhos de agenda sejam uma entidade separada no Fabric conhecida como agendas. Essas agendas existem na plataforma do Fabric e não são específicos dos pipelines. Elas também não são chamadas de gatilhos no Fabric.

Para migrar seus gatilhos do ADF para o Fabric, pense em recriar os gatilhos de agenda simplesmente como agendas que são propriedades dos pipelines do Fabric. E para todos os outros tipos de gatilho, use o botão Gatilhos dentro do pipeline do Fabric ou o Data Activator nativamente no Fabric.

Depuração

A depuração de pipelines é mais simples no Fabric do que no ADF. Essa simplicidade vem do fato de que os pipelines do Data Factory do Fabric não têm um conceito separado de modo de depuração que você encontra em pipelines e fluxos de dados do ADF. Em vez disso, ao criar seu pipeline, você está sempre no modo interativo. Para testar e depurar seus pipelines, você só precisa selecionar o botão Reproduzir na barra de ferramentas do Editor de pipeline quando estiver tudo pronto no seu ciclo de desenvolvimento. Os pipelines do Fabric não incluem o padrão de depuração em etapas Depuração até de maneira interativa. Em vez disso, no Fabric, você utiliza o estado da atividade e define apenas as atividades que deseja testar como ativas ao definir todas as outras atividades como inativas para alcançar os mesmos padrões de teste e depuração. Assista ao vídeo a seguir que explica como obter essa experiência de depuração no Fabric.

Captura de dados de alterações

A CDC (captura de dados de alterações) no ADF é uma versão prévia do recurso que facilita a movimentação rápida de dados de maneira incremental, pela aplicação de recursos de CDC do lado da origem dos seus armazenamentos de dados. Para migrar seus artefatos de CDC para o Data Factory do Fabric, você recria esses artefatos como itens de trabalho Copy no workspace do Fabric. Esse recurso fornece funcionalidades semelhantes de movimentação de dados incrementais com uma interface do usuário fácil de usar sem exigir um pipeline, assim como no CDC do ADF. Para obter mais informações, confira o trabalho Copy para o Data Factory no Fabric.

Azure Synapse Link

Embora esse recurso não esteja disponível no ADF, os usuários de pipelines do Synapse frequentemente utilizam o Link do Azure Synapse para replicar dados de bancos de dados SQL para o data lake na abordagem turnkey. No Fabric, você recria os artefatos do Link do Azure Synapse como itens de espelhamento no seu espaço de trabalho. Para obter mais informações, confira Espelhamento de banco de dados no Fabric.

SQL Server Integration Services (SSIS)

O SSIS é a ferramenta de ETL e integração de dados local que a Microsoft fornece ao SQL Server. No ADF, você pode migrar por lift-and-shift os pacotes do SSIS para a nuvem usando o IR do SSIS do ADF. No Fabric, não temos o conceito de IRs, portanto, essa funcionalidade não é possível hoje. No entanto, estamos trabalhando para habilitar a execução de pacotes SSIS nativamente a partir do Fabric, que esperamos trazer para o produto em breve. Enquanto isso, a melhor maneira de executar pacotes SSIS na nuvem com o Fabric Data Factory é iniciar um SSIS IR em sua fábrica do ADF e, em seguida, invocar um pipeline do ADF para chamar seus pacotes do SSIS. Você pode chamar remotamente um pipeline do ADF por meio dos seus pipelines do Fabric usando a atividade Invoke pipeline descrita na seção a seguir.

Atividade Invocar pipeline

Uma atividade comum usada em pipelines do ADF é a atividade Execute Pipeline, que permite que você chame outro pipeline na fábrica. No Fabric, aprimoramos essa atividade como a atividade Invoke pipeline. Veja a documentação da atividade Invoke pipeline.

Essa atividade é útil para cenários de migração em que você tem muitos pipelines do ADF que usam recursos específicos do ADF, como Fluxos de Dados de Mapeamento ou SSIS. Você pode manter esses pipelines no estado em que se encontram em pipelines do ADF ou mesmo do Synapse e, em seguida, chamar esse pipeline em linha no novo pipeline do Data Factory do Fabric usando a atividade Invoke pipeline e apontando para o pipeline de fábrica remoto.

Cenários de migração de exemplo

Os cenários a seguir são cenários comuns de migração que você pode encontrar ao migrar do ADF para o Fabric Data Factory.

Cenário nº 1: pipelines e fluxos de dados do ADF

Os principais casos de uso para migrações de fábrica baseiam-se na modernização do ambiente ETL do modelo PaaS da fábrica do ADF para o novo modelo SaaS do Fabric. Os principais itens de fábrica a serem migrados são pipelines e fluxos de dados. Há vários elementos fundamentais de fábrica que você precisa planejar para a migração fora desses dois itens de nível superior: serviços vinculados, runtimes de integração, conjuntos de dados e gatilhos.

- Os serviços vinculados precisam ser recriados no Fabric como conexões nas suas atividades de pipeline.

- Os conjuntos de dados não existem no Factory. As propriedades dos seus conjuntos de dados são representadas como propriedades dentro das atividades de pipeline, como Copy ou Lookup, enquanto Connections contêm outras propriedades do conjunto de dados.

- Os runtimes de integração não existem no Fabric. No entanto, os IRs auto-hospedados podem ser recriados por meio de OPDG (gateways de dados locais) no Fabric e os IRs de rede virtual do Azure como gateways de rede virtual gerenciados no Fabric.

- Essas atividades de pipeline do ADF não estão incluídas no Fabric Data Factory:

- Data Lake Analytics (U-SQL) – esse recurso é um serviço do Azure preterido.

- Atividade Validation – A atividade Validation do ADF é uma atividade auxiliar que você pode recompilar nos seus pipelines do Fabric com facilidade usando uma atividade Get Metadata, um loop de pipeline e uma atividade If.

- Power Query – No Fabric, todos os fluxos de dados são criados usando a interface do usuário do Power Query, para que você possa apenas copiar e colar seu código M de suas atividades do ADF Power Query e compilá-los como fluxos de dados no Fabric.

- Se você estiver usando uma das funcionalidades de pipeline do ADF que não é encontrada no Data Factory do Fabric, use a atividade Invoke pipeline no Fabric para chamar seus pipelines existentes no ADF.

- As seguintes atividades de pipeline do ADF são combinadas em uma atividade de propósito único:

- Atividades do Azure Databricks (Notebook, Jar, Python)

- Azure HDInsight (Hive, Pig, MapReduce, Spark, Streaming)

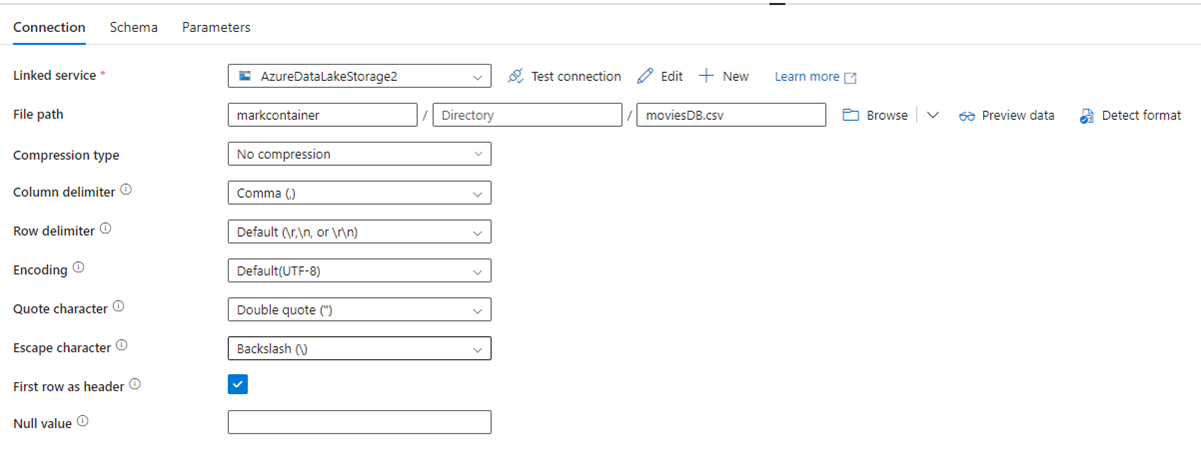

A imagem a seguir mostra a página de configuração do conjunto de dados do ADF, com seu caminho de arquivo e configurações de compactação:

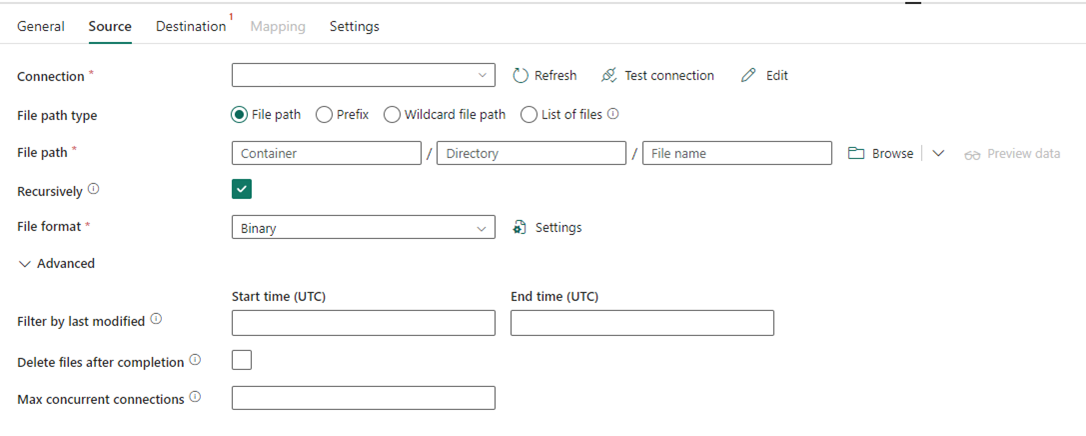

A imagem a seguir mostra a configuração da atividade Copy para Data Factory no Fabric, em que a compactação e o caminho do arquivo estão embutidos na atividade:

Cenário nº 2: ADF com CDC, SSIS e Fluxo de Ar

O CDC e o Airflow no ADF são uma versão prévia dos recursos, enquanto o SSIS no ADF é um recurso em disponibilidade geral há muitos anos. Cada um desses recursos atende a diferentes necessidades de integração de dados, mas exige atenção especial ao migrar do ADF para o Fabric. A CDC (captura de dados de alterações) é um conceito do ADF de nível superior, mas, no Fabric, você vê essa funcionalidade como a tarefa Copy.

Airflow é o recurso do Apache Airflow gerenciado pela nuvem no ADF e também está disponível no Fabric Data Factory. Você deve ser capaz de usar o mesmo repositório de origem do Airflow ou pegar seus DAGs e copiar/colar o código na oferta de Airflow do Fabric com pouca ou nenhuma alteração necessária.

Cenário nº 3: migração do Data Factory com Git habilitado para o Fabric

É comum, embora não seja necessário, que as suas fábricas e seus workspaces do ADF ou do Synapse estejam conectados ao seu provedor Git externo no ADO ou no GitHub. Neste cenário, você precisa migrar seus itens da fábrica e do workspace para um workspace do Fabric e, em seguida, configurar a integração do Git no workspace do Fabric.

O Fabric fornece duas maneiras principais de habilitar CI/CD, ambas no nível do workspace: integração do Git, em que você traz seu próprio repositório Git no ADO e se conecta a ele a partir do Fabric e pipelines de implantação internos, em que você pode promover código para ambientes mais altos sem a necessidade de trazer seu próprio Git.

Em ambos os casos, o repositório Git existente do ADF não funciona com o Fabric. Em vez disso, você precisa apontar para um novo repositório ou iniciar um novo pipeline de implantação no Fabric e recompilar os artefatos de pipeline no Fabric.

Montar suas instâncias existentes do ADF diretamente em um workspace do Fabric

Anteriormente, falamos sobre como usar a atividade Invoke Pipeline do Data Factory no Fabric como um mecanismo para manter os investimentos existentes em pipelines do ADF e chamá-los em linha no Fabric. No Fabric, você pode aprofundar esse conceito semelhante e montar toda a fábrica dentro do workspace do Fabric como um item nativo do Fabric.

Para obter mais informações sobre os cenários de uso de montagem, confira Cenários de colaboração e entrega de conteúdo.

Montar o Azure Data Factory dentro do workspace do Fabric traz muitos benefícios a serem considerados. Se você é novo no Fabric e gostaria de manter suas fábricas lado a lado dentro do mesmo painel de vidro, você pode montá-las no Fabric para que você possa gerenciar ambas dentro do Fabric. A interface do usuário completa do ADF já está disponível para você na fábrica montada, na qual você pode monitorar, gerenciar e editar por completo seus itens da fábrica do ADF no workspace do Fabric. Esse recurso facilita muito a migração desses itens para o Fabric como artefatos nativos do Fabric. Esse recurso é principalmente para facilitar o uso e torna mais fácil visualizar suas fábricas do ADF no seu espaço de trabalho do Fabric. No entanto, a execução real dos pipelines, atividades, runtimes de integração etc., ainda ocorre dentro de seus recursos do Azure.

Conteúdo relacionado

Considerações sobre migração do ADF para o Data Factory no Fabric