Criar e gerenciar definições de trabalho do Apache Spark no Visual Studio Code

A extensão do Visual Studio (VS) Code para Synapse dá suporte completo às operações de definição de trabalhos Spark CURD (criar, atualizar, ler e excluir) no Fabric. Depois de criar uma definição de trabalho do Spark, você pode carregar mais bibliotecas referenciadas, enviar uma solicitação para executar a definição de trabalho do Spark e verificar o histórico de execuções.

Criar uma definição de trabalho do Spark

Para criar uma nova definição de trabalho do Spark:

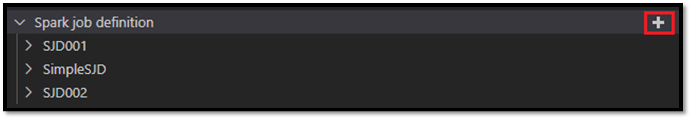

No Explorer do VS Code, selecione a opção Criar definição de trabalho do Spark.

Insira os campos iniciais necessários: nome, lakehouse referenciado e lakehouse padrão.

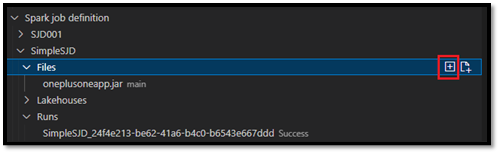

A solicitação é processada e o nome da definição de trabalho do Spark recém-criada aparece no nó raiz Definição de trabalho do Spark no Explorer do VS Code. No nó Nome da definição de trabalho do Spark, é possível ver três subnós:

- Arquivos: lista do arquivo de definição principal e outras bibliotecas referenciadas. Você pode carregar novos arquivos nessa lista.

- Lakehouse: lista de todas as lakehouses referenciadas por esta definição de trabalho do Spark. O lakehouse padrão é marcado na lista e você pode acessá-lo por meio do caminho relativo

Files/…, Tables/…. - Executar: lista do histórico de execuções dessa definição de trabalho do Spark e do status de trabalho de cada execução.

Carregar um arquivo de definição de principal em uma biblioteca referenciada

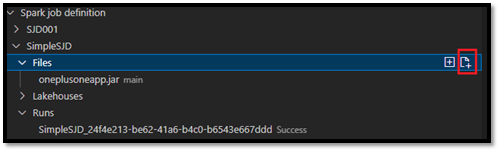

Para carregar ou substituir o arquivo de definição principal, selecione a opção Adicionar arquivo principal.

Para carregar o arquivo de biblioteca referenciado no arquivo de definição principal, selecione a opção Adicionar arquivo de biblioteca.

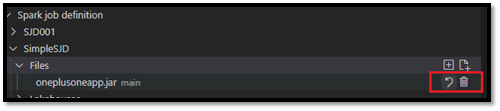

Depois de ter carregado um arquivo, você pode substituí-lo clicando na opção Atualizar arquivo e carregando um novo arquivo ou excluí-lo por meio da opção Excluir.

Enviar uma solicitação de execução

Para enviar uma solicitação para executar a definição de trabalho do Spark no VS Code:

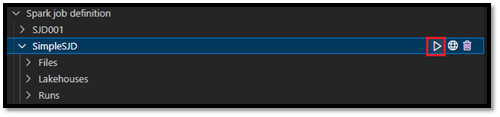

Nas opções à direita do nome da definição de trabalho do Spark que você deseja executar, selecione a opção Executar trabalho do Spark.

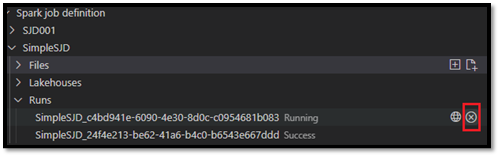

Depois de enviar a solicitação, um novo aplicativo Apache Spark aparece no Node Execuções na lista do Explorer. Você pode cancelar o trabalho em execução selecionando a opção Cancelar trabalho do Spark.

Abrir uma definição de trabalho do Spark no portal do Fabric

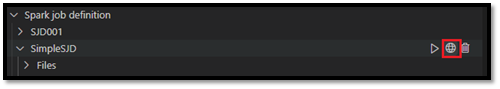

Você pode abrir a página de criação de definição de trabalho do Spark no portal do Fabric selecionando a opção Abrir no navegador.

Você também pode selecionar Abrir no navegador ao lado de uma execução concluída para ver a página de monitor de detalhes dessa execução.

Depurar o código-fonte da definição de trabalho do Spark (Python)

Se a definição de trabalho do Spark for criada com o PySpark (Python), você poderá baixar o script .py do arquivo de definição de main e o arquivo referenciado e depurar o script de origem no VS Code.

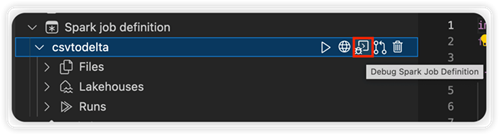

Para baixar o código-fonte, selecione a opção Depurar definição de trabalho do Spark à direita da definição de trabalho do Spark.

Depois que o download for concluído, a pasta do código-fonte será aberta automaticamente.

Selecione a opção Confiar nos autores quando solicitado. (Essa opção aparece apenas na primeira vez que você abre a pasta. Se você não selecionar essa opção, não poderá depurar nem executar o script de origem. Para obter mais informações, consulte A segurança da confiança no workspace do Visual Studio Code.)

Se você já baixou o código-fonte antes, será solicitado que confirme se você quer substituir a versão local pelo novo download.

Observação

Na pasta raiz do script de origem, o sistema cria uma subpasta chamada conf. Dentro dessa pasta, um arquivo chamado lighter-config.json contém alguns metadados do sistema necessários para a execução remota. NÃO faça nenhuma alteração nele.

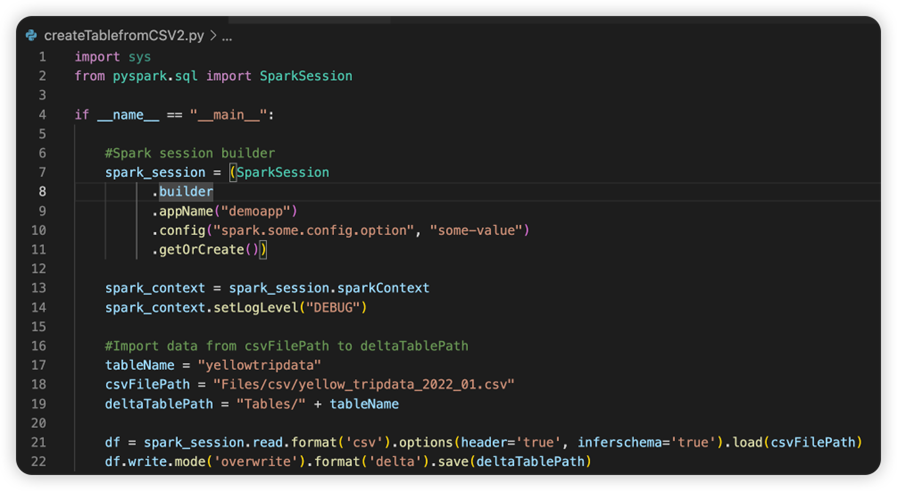

O arquivo chamado sparkconf.py contém um snippet de código que você precisa adicionar para configurar o objeto SparkConf. Para habilitar a depuração remota, verifique se o objeto SparkConf está configurado corretamente. A imagem a seguir mostra a versão original do código-fonte.

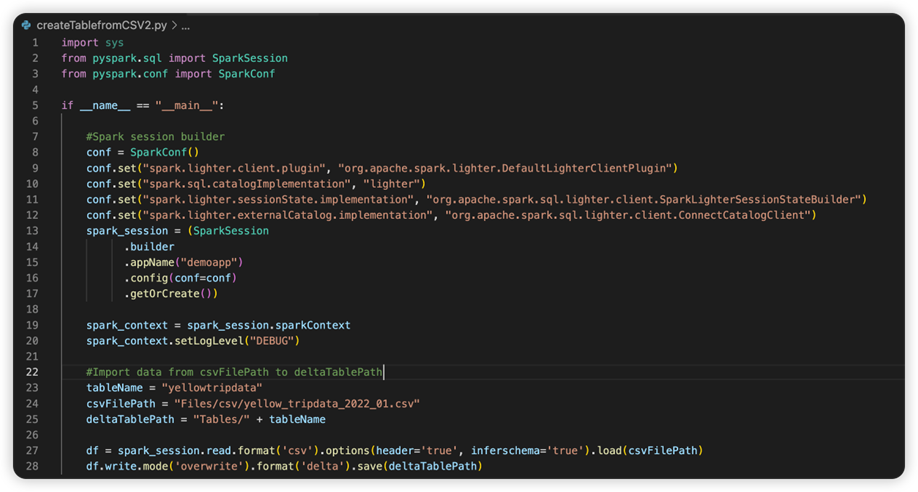

A próxima imagem é o código-fonte atualizado depois que você copia e cola o snippet.

Depois de atualizar o código-fonte com a configuração necessária, você deve escolher o Interpretador do Python correto. Certifique-se de selecionar o instalado do ambiente do Conda synapse-spark-kernel.

Editar propriedades de definição de trabalho do Spark

Você pode editar as propriedades detalhadas das definições de trabalho do Spark, como argumentos de linha de comando.

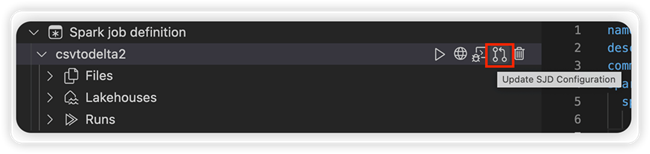

Selecione a opção Atualizar configuração do SJD para abrir um arquivo settings.yml. As propriedades existentes preenchem o conteúdo desse arquivo.

Atualize e salve o arquivo .yml.

Selecione a opção Publicar propriedade SJD no canto superior direito para sincronizar a alteração de volta para o workspace remoto.