Processamento de fluxo sem código com o Azure Stream Analytics

O editor sem código permite que você desenvolva um trabalho do Stream Analytics sem esforço para processar seus dados de streaming em tempo real, usando a funcionalidade de arrastar e soltar, sem escrever uma única linha de código. A experiência fornece uma tela que permite que você se conecte a fontes de entrada para ver rapidamente seus dados de streaming. Em seguida, você pode transformá-lo antes de gravar em seu destino de escolha no Azure.

Com o editor sem código, você pode facilmente:

- Modificar esquemas de entrada.

- Executar operações de preparação de dados como junções e filtros.

- Abordar cenários avançados, por exemplo, agregações de janela de tempo (janelas em cascata, saltos e janelas de sessão) para operações agrupadas.

Depois de criar e executar seus trabalhos do Stream Analytics, você pode operacionalizar facilmente as cargas de trabalho de produção. Use o conjunto certo de métricas internas para fins de monitoramento e solução de problemas. Os trabalhos do Stream Analytics são cobrados de acordo com o modelo de preços quando estão em execução.

Pré-requisitos

Antes de desenvolver seus trabalhos do Stream Analytics usando o editor sem código, você precisará atender a estes requisitos:

- As fontes de entrada de streaming e os recursos de destino para o trabalho do Stream Analytics devem estar publicamente acessíveis e não podem estar em uma rede virtual do Azure.

- Você deve ter as permissões necessárias para acessar os recursos de entrada e saída de streaming.

- Você deve manter permissões para criar e modificar recursos do Azure Stream Analytics.

Observação

No momento, o editor sem código não está disponível na região da China.

Trabalho do Stream Analytics do Azure

Um trabalho do Stream Analytics é criado em três componentes principais: entradas de streaming, transformações e saídas. Você pode ter quantos componentes quiser, incluindo várias entradas, ramificações paralelas com várias transformações e várias saídas. Para obter mais informações, confira a documentação do Azure Stream Analytics.

Observação

As seguintes funcionalidades e tipos de saída não estão disponíveis ao usar o editor sem código:

- Funções definidas pelo usuário.

- Edição de consulta na folha de consulta do Azure Stream Analytics. No entanto, você pode exibir a consulta gerada pelo editor sem código na folha de consulta.

- Adição de entrada/saída nas folhas de entrada/saída do Azure Stream Analytics. No entanto, você pode exibir a entrada/saída gerada pelo editor sem código na folha de entrada/saída.

- Os seguintes tipos de saída não estão disponíveis: Função do Azure, ADLS Gen1, BD PostgreSQL, fila/tópico do Barramento de Serviço, Armazenamento de tabelas.

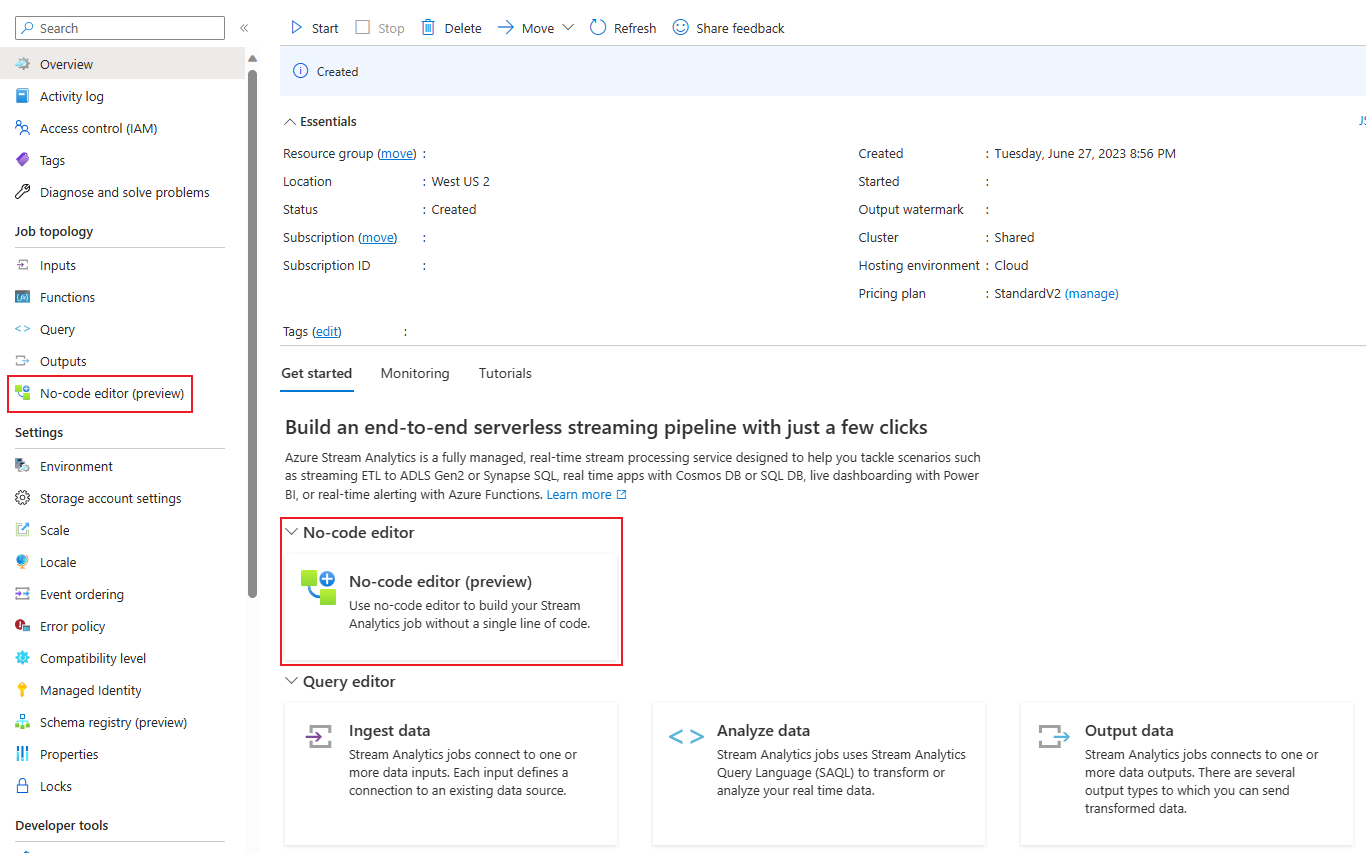

Para acessar o editor sem código para criar seu trabalho de análise de fluxo, há duas abordagens:

Por meio do portal do Azure Stream Analytics (versão prévia): crie um trabalho do Stream Analytics e selecione o editor sem código na guia Introdução na página Visão geral ou selecione Editor sem código no painel esquerdo.

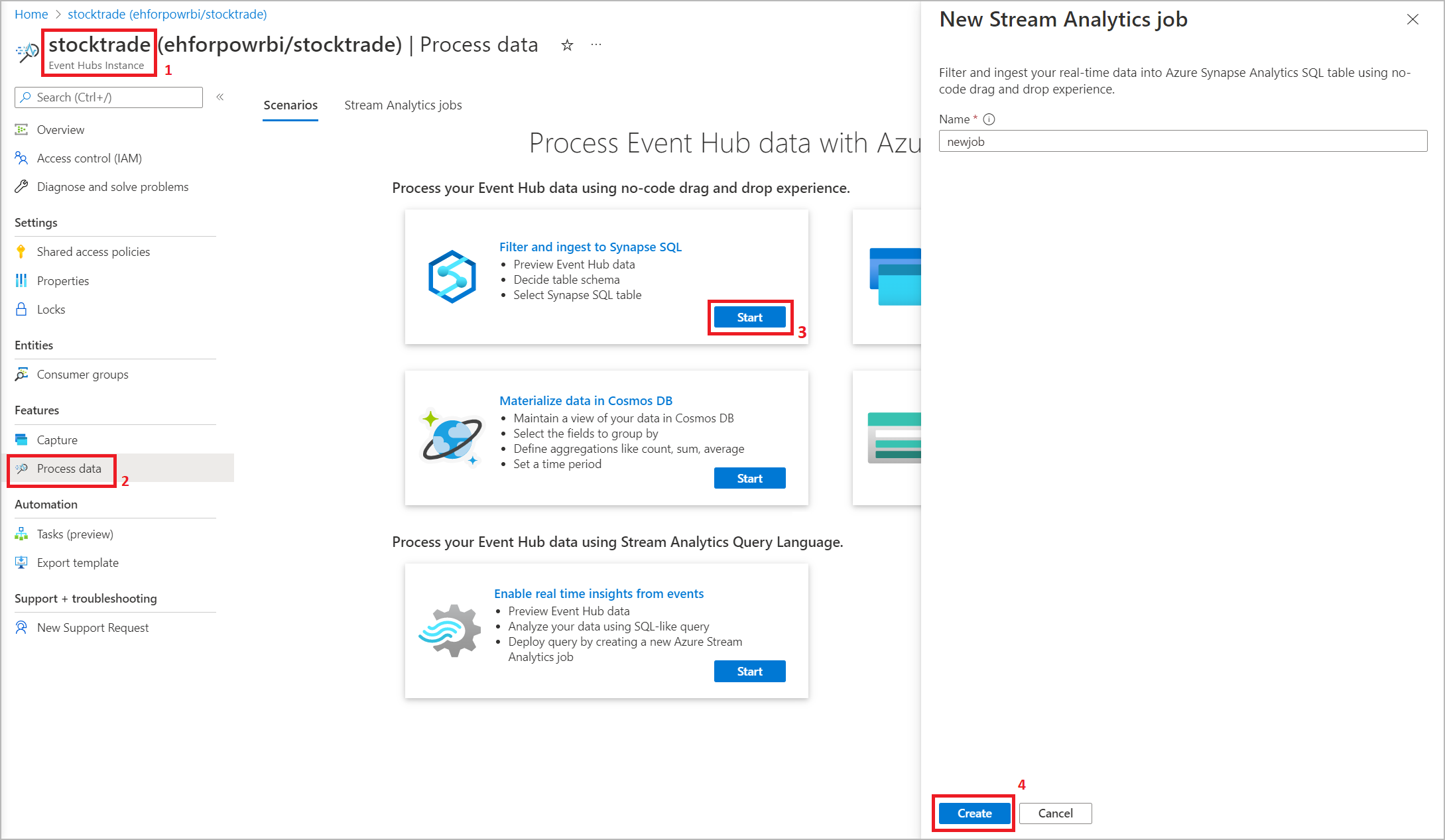

Por meio do portal Hubs de Eventos do Azure: abra uma instância dos Hubs de Eventos. Selecione Processar Dados e selecione qualquer modelo predefinido.

Os modelos predefinidos podem ajudar você a desenvolver e executar um trabalho para resolver vários cenários, incluindo:

- Criar um dashboard em tempo real com um conjunto de dados do Power BI

- Dados de captura dos Hubs de Eventos no formato Delta Lake (versão prévia)

- Filtragem e ingestão no SQL do Azure Synapse

- Captura dos dados dos Hubs de Eventos no formato Parquet no Azure Data Lake Storage Gen2

- Materialização dos dados no Azure Cosmos DB

- Filtrar e ingerir para Azure Data Lake Storage Gen2

- Enriquecer dados e ingerir no hub de eventos

- Transformar e armazenar dados no banco de dados SQL do Azure

- Filtragem e ingestão no Azure Data Explorer

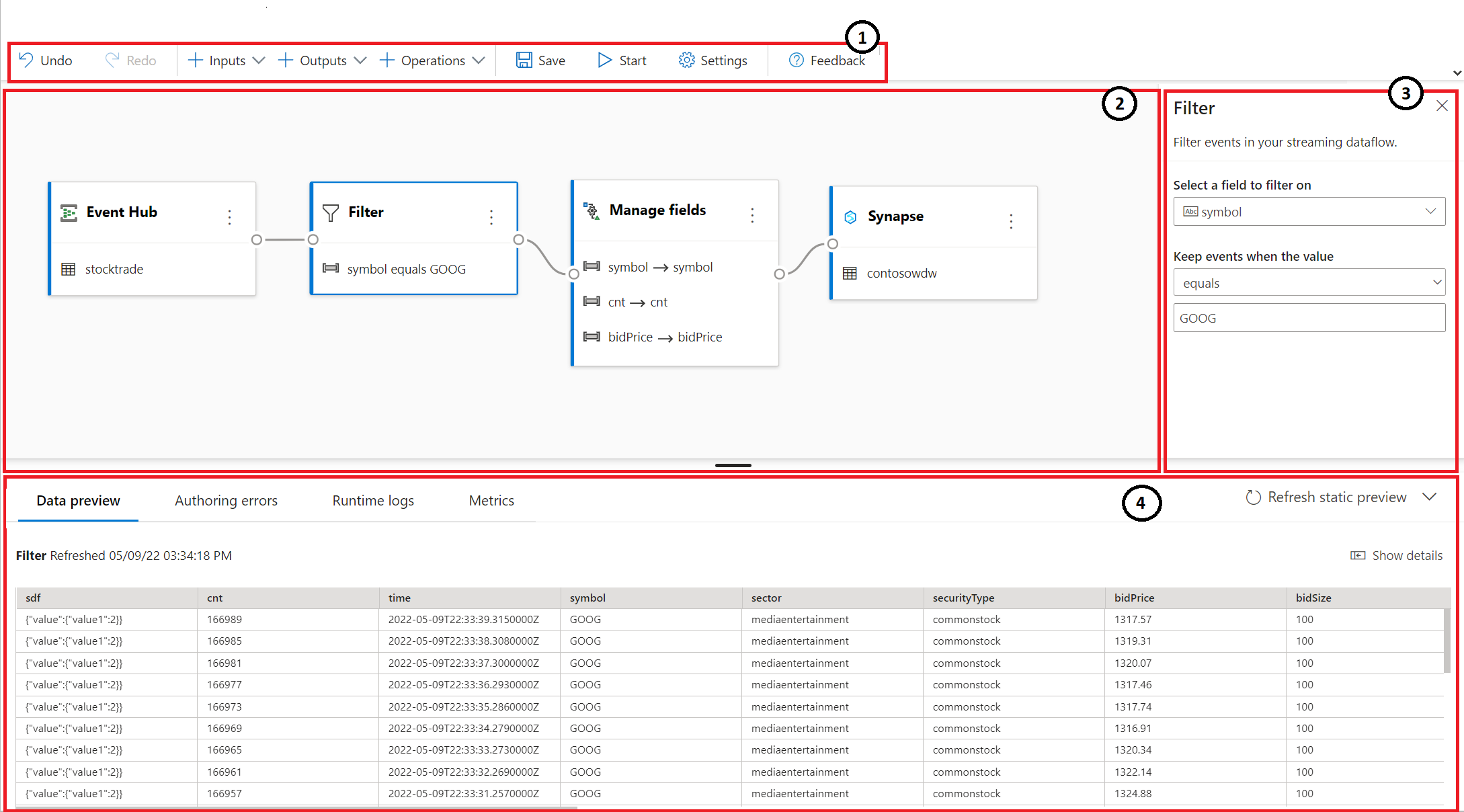

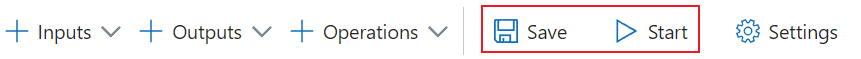

A captura de tela abaixo mostra o trabalho finalizado do Stream Analytics. Ela realça todas as seções disponíveis para você enquanto você cria.

- Faixa de Opções: na faixa de opções, as seções seguem a ordem de um processo de análise de dados clássico: um hub de eventos como entrada (também conhecido como uma fonte de dados), transformações (operações de Extração, Transformação e Carregamento de streaming), saídas, um botão para salvar seu progresso e um botão para iniciar o trabalho.

- Exibição de diagrama: é uma representação gráfica do trabalho do Stream Analytics, da entrada às operações às saídas.

- Painel lateral: dependendo de qual componente você selecionou na exibição de diagrama, você verá configurações para modificar a entrada, a transformação ou a saída.

- Guias para visualização de dados, erros de criação, erros de runtime e métricas: para cada bloco, a visualização de dados mostrará os resultados dessa etapa (ao vivo para entradas; sob demanda para transformações e saídas). Esta seção também resume todos os erros de criação ou os avisos que você poderá ter em seu trabalho quando está sendo desenvolvido. Selecionar cada erro ou aviso seleciona essa transformação. Ele também fornece as métricas de trabalho para você monitorar a integridade do trabalho em execução.

Entrada de dados de streaming

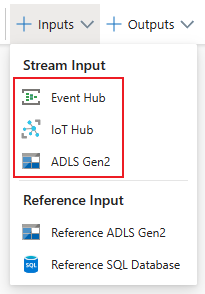

O editor sem código dá suporte à entrada de dados de streaming de três tipos de recursos:

- Hubs de eventos do Azure

- Hub IoT do Azure

- Azure Data Lake Storage Gen2

Para obter mais informações sobre entradas de dados de streaming, consulte Dados de streaming como entrada no Stream Analytics.

Observação

O editor sem código no portal Hubs de Eventos do Azure tem apenas o Hub de Eventos como uma opção de entrada.

Os Hubs de Eventos do Azure como entrada de streaming

Os Hubs de Eventos do Azure são uma plataforma de streaming de Big Data e um serviço de ingestão de eventos. Ele pode receber e processar milhões de eventos por segundo. Os dados enviados para um Hub de Eventos podem ser transformados e armazenados por meio de qualquer provedor de análise em tempo real ou adaptador de envio em lote/armazenamento.

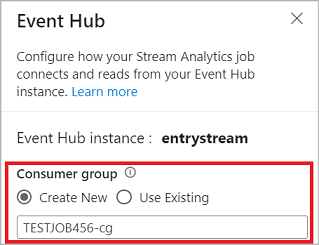

Para configurar um hub de eventos como uma entrada para seu trabalho, selecione o ícone do Hub de Eventos. Um bloco aparece no modo de exibição de diagrama, incluindo um painel lateral para sua configuração e conexão.

Quando você estiver se conectando ao hub de eventos no editor sem código, recomendamos que você crie um novo grupo de consumidores (que é a opção padrão). Essa abordagem ajuda a impedir que o hub de eventos atinja o limite de leitores simultâneos. Para entender mais sobre os grupos de consumidores e se você deve selecionar um grupo existente ou criá-lo, confira Grupos de consumidores.

Se seu hub de eventos estiver na camada Basic, você poderá usar apenas o grupo de consumidores $Default. Se o hub de eventos estiver em uma camada Standard ou Premium, você poderá criar outro grupo de consumidores.

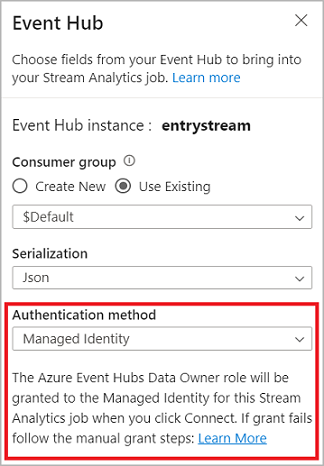

Quando você está se conectando ao hub de eventos, se selecionar Identidade Gerenciada como modo de autenticação, a função Proprietário de Dados dos Hubs de Eventos do Azure é concedida à identidade gerenciada para o trabalho do Stream Analytics. Para saber mais sobre identidades gerenciadas de um hub de eventos, confira Usar identidades gerenciadas para acessar um hub de eventos em um trabalho do Azure Stream Analytics.

As identidades gerenciadas eliminam as limitações dos métodos de autenticação baseados no usuário. Essas limitações incluem a necessidade de reautenticar quando há alterações de senha ou vencimento de tokens de usuário, o que ocorre a cada 90 dias.

Depois de configurar os detalhes do hub de eventos e selecionar Conectar, você poderá adicionar campos manualmente usando + Adicionar campo se souber os nomes de campo. Para, em vez disso, detectar campos e tipos de dados automaticamente com base em uma amostra das mensagens de entrada, selecione Campos de detecção automática. Selecionar o ícone de engrenagem permite editar as credenciais, se necessário.

Quando os trabalhos do Stream Analytics detectarem os campos, você os verá na lista. Você também verá uma visualização ao vivo das mensagens de entrada na tabela Pré-visualização de Dados na exibição de diagrama.

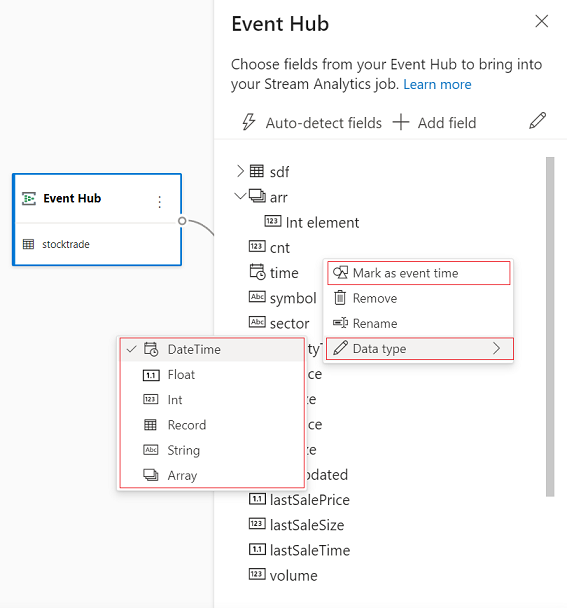

Modificar dados de entrada

Você sempre pode editar os nomes de campo, remover o tipo de dados ou alterar a hora do evento (Marcar como hora do evento: cláusula TIMESTAMP BY em um campo de tipo datetime) selecionando o símbolo de três pontos ao lado de cada campo. Você também pode expandir, selecionar e editar todos os campos aninhados das mensagens de entrada, conforme mostrado na imagem a seguir.

Dica

Isso se aplica aos dados de entrada do Hub IoT do Azure e do Azure Data Lake Storage Gen2 também.

Os tipos de dados disponíveis são:

- DateTime: campo de data e hora no formato ISO.

- Float: número decimal.

- Int: número inteiro.

- Registro: objeto aninhado com vários registros.

- Cadeia de caracteres: texto.

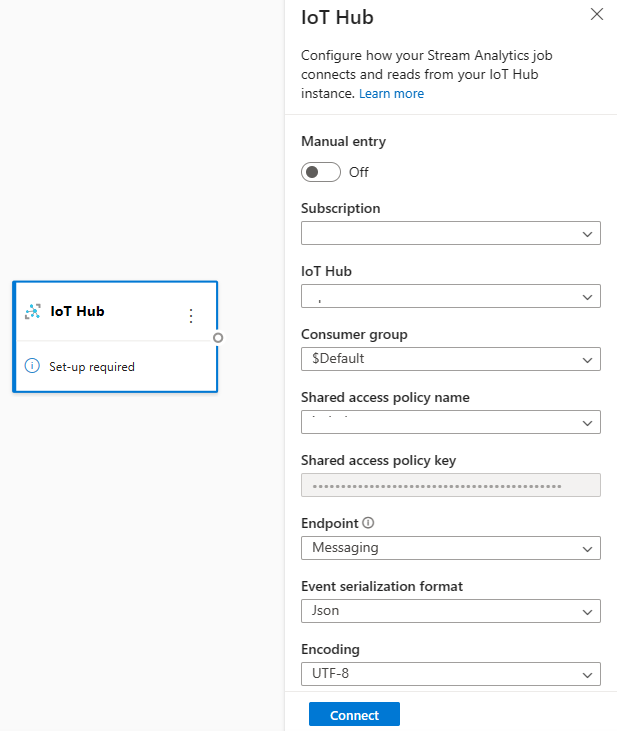

O Hub IoT do Azure como a entrada de streaming

O Hub IoT do Azure é um serviço gerenciado hospedado na nuvem que atua como um hub central de mensagens para comunicação entre um aplicativo de IoT e os dispositivos anexados a ele. Os dados do dispositivo IoT enviados ao Hub IoT podem ser usados como uma entrada para um trabalho do Stream Analytics.

Observação

O Hub IoT do Azure entrada está disponível no editor sem código no portal do Azure Stream Analytics.

Para adicionar um Hub IoT como uma entrada de streaming para seu trabalho, selecione o Hub IoT em Entradas na faixa de opções. Em seguida, preencha as informações necessárias no painel direito para conectar o Hub IoT ao seu trabalho. Para saber mais sobre os detalhes de cada campo, consulte Transmitir dados do Hub IoT para o trabalho do Stream Analytics.

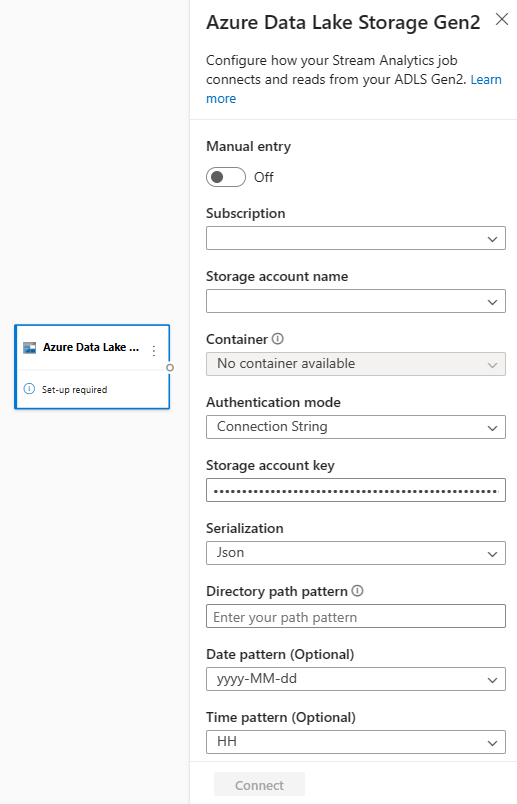

O Azure Data Lake Storage Gen2 como entrada de streaming

O Azure Data Lake Storage Gen2 (ADLS Gen2) é uma solução de data lake empresarial baseada em nuvem. Ele foi projetado para armazenar grandes quantidades de dados em qualquer formato e facilitar cargas de trabalho analíticas de Big Data. Os dados armazenados no ADLS Gen2 podem ser processados como um fluxo de dados pelo Stream Analytics. Para saber mais sobre esse tipo de entrada, consulte Transmitir dados do ADLS Gen2 para o trabalho do Stream Analytics

Observação

O Azure Data Lake Storage Gen2 entrada está disponível no editor sem código no portal do Azure Stream Analytics.

Para adicionar um ADLS Gen2 como uma entrada de streaming para seu trabalho, selecione o ADLS Gen2 em Entradas na faixa de opções. Em seguida, preencha as informações necessárias no painel direito para conectar o ADLS Gen2 ao trabalho. Para saber mais sobre os detalhes de cada campo, consulte Transmitir dados do ADLS Gen2 para o trabalho do Stream Analytics.

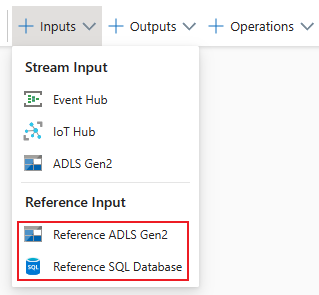

Entradas de dados de referência

Os dados de referência são estáticos ou mudam lentamente ao longo do tempo. Normalmente, eles são usados para enriquecer fluxos de entrada e fazer pesquisas em seu trabalho. Por exemplo, você pode unir entradas de fluxo de dados a dados nos dados de referência, assim como realizaria uma junção SQL para pesquisar valores estáticos. Para obter mais informações sobre entradas de dados de referência, confira Usar dados de referência para pesquisas no Stream Analytics.

O editor sem código agora dá suporte a duas fontes de dados de referência:

- Azure Data Lake Storage Gen2

- Banco de Dados SQL do Azure

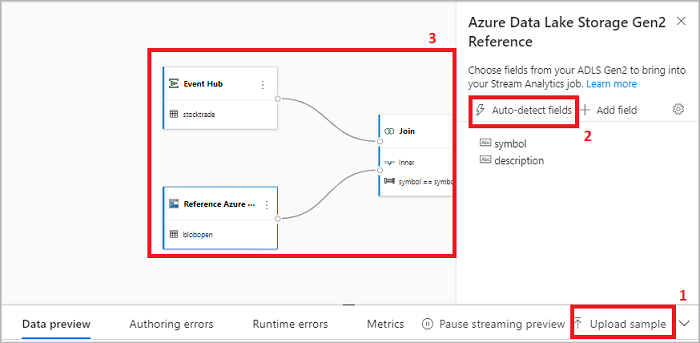

Azure Data Lake Storage Gen2 como dados de referência

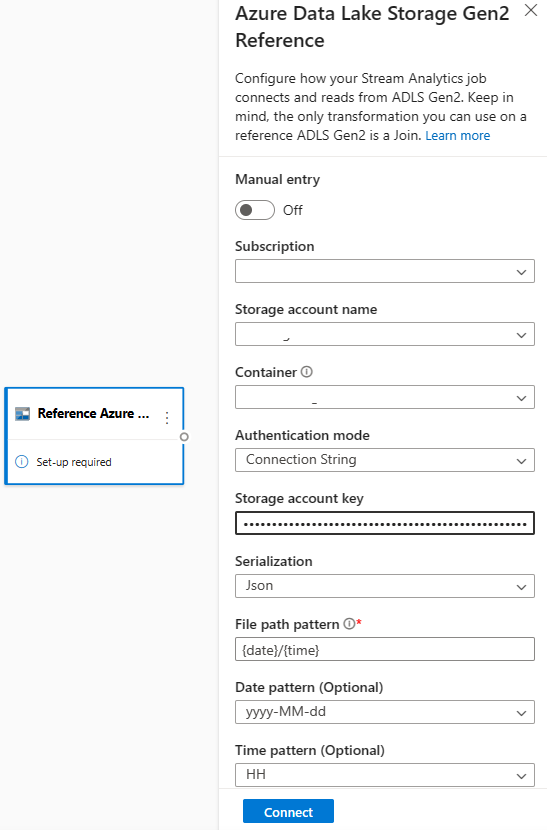

Dados de referência são modelados como uma sequência de blobs em ordem crescente segundo a combinação de data/hora especificada no nome do blob. Você só pode adicionar blobs ao final da sequência usando uma data/hora posterior à usada no último blob especificado na sequência. Os Blobs são definidos na configuração de entrada.

Primeiro, na seção Entradas da faixa, selecione Fazer referência ao ADLS Gen2. Para exibir detalhes sobre cada campo, confira a seção sobre o Armazenamento de Blobs do Azure em Usar dados de referência em pesquisas no Stream Analytics.

Em seguida, carregue um arquivo de matriz JSON. Os campos no arquivo serão detectados. Use esses dados de referência para realizar a transformação com dados de entrada de streaming dos Hubs de Eventos.

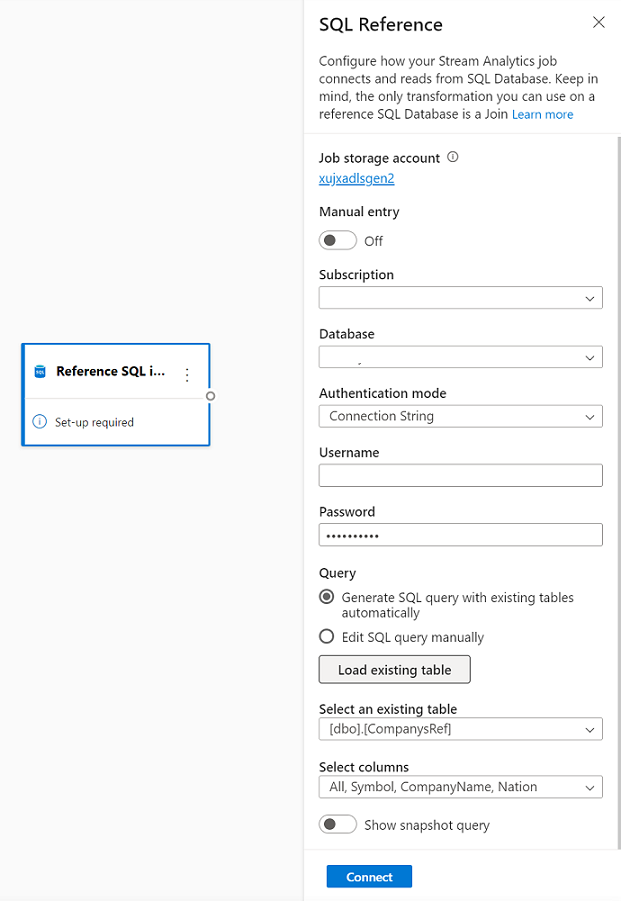

Banco de Dados SQL do Azure como dados de referência

Você pode usar o Banco de Dados SQL do Azure como dados de referência para seu trabalho do Stream Analytics no editor sem código. Para saber mais, confira a seção sobre Banco de Dados SQL em Usar dados de referência em pesquisas no Stream Analytics.

Para configurar o Banco de Dados SQL como entrada de dados de referência, selecione Fazer referência ao Banco de Dados SQL na seção Entradas da faixa. Em seguida, preencha as informações para conectar o banco de dados de referência e selecione a tabela com as colunas necessárias. Você também pode buscar os dados de referência de sua tabela editando a consulta SQL manualmente.

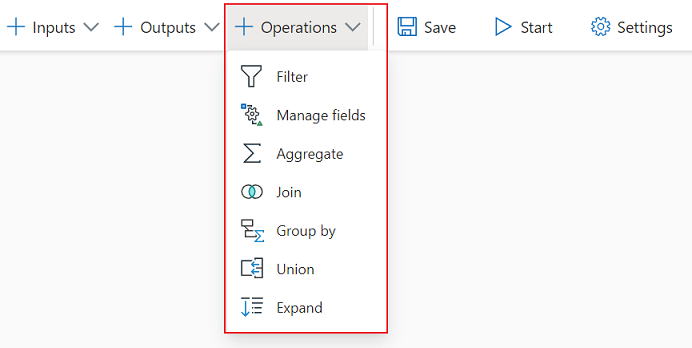

Transformações

As transformações de dados de streaming são inerentemente diferentes das transformações de dados em lote. Quase todos os dados de streaming têm um componente de tempo, que afeta todas as tarefas de preparação de dados envolvidas.

Para adicionar uma transformação de dados de streaming ao seu trabalho, selecione o símbolo de transformação na seção Operações na faixa de opções para essa transformação. O respectivo bloco será descartado na exibição de diagrama. Depois de selecioná-lo, você verá o painel lateral dessa transformação para configurá-lo.

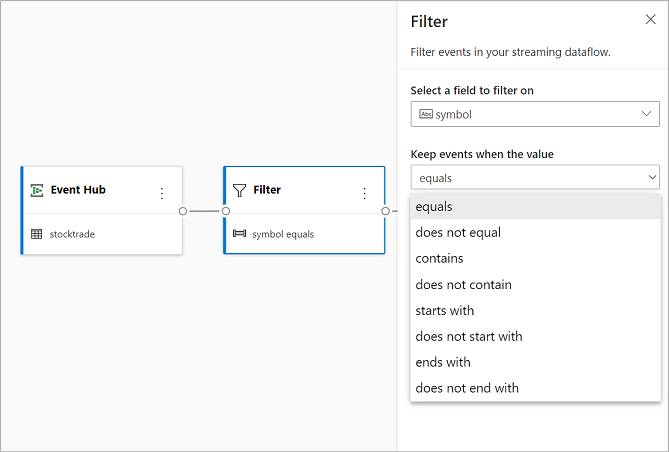

Filtrar

Use a transformação de Filtro para filtrar eventos com base no valor de um campo na entrada. Dependendo do tipo de dados (número ou texto), a transformação manterá os valores que correspondem à condição selecionada.

Observação

Dentro de cada bloco, você verá informações sobre o que mais será necessário para que a transformação esteja pronta. Por exemplo, ao adicionar um novo bloco, você verá uma mensagem de Configuração necessária. Se não tiver um conector de nó, você verá uma mensagem de Erro ou de Aviso.

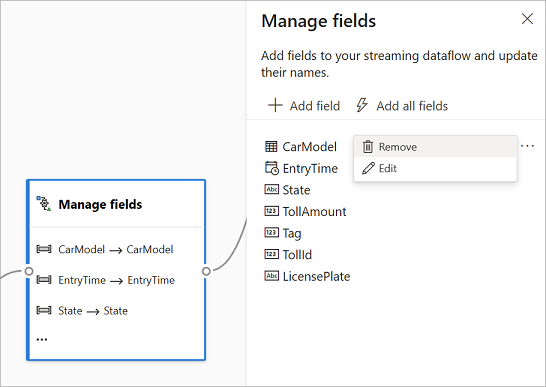

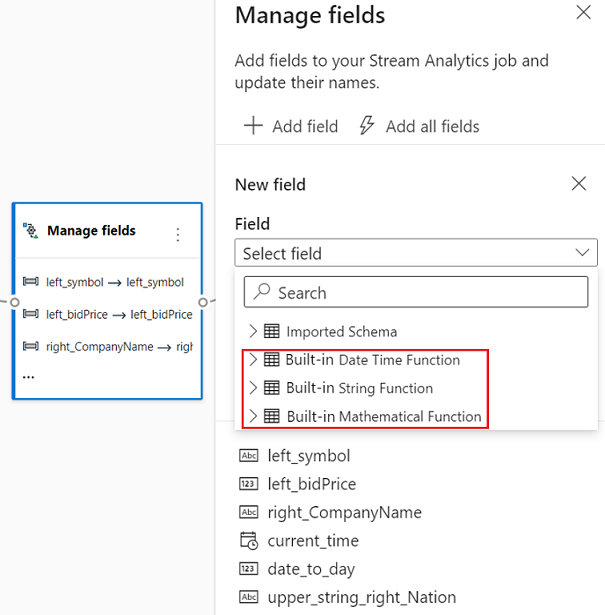

Gerenciar campos

A transformação Gerenciar campos permite adicionar, remover ou renomear campos provenientes de uma entrada ou outra transformação. As configurações do painel lateral oferecem a opção de adicionar um novo selecionando Adicionar campo ou adicionando todos os campos de uma só vez.

Você também pode adicionar outro campo com as Funções Internas para agregar dados de upstream. Atualmente, as funções internas a que damos suporte são algumas funções nas Funções de Cadeia de Caracteres, nas Funções de Data e Hora e nas Funções Matemáticas. Para saber mais sobre as definições dessas funções, confira Funções Internas (Azure Stream Analytics).

Dica

Depois de configurar um bloco, o modo de exibição de diagrama oferece uma visão das configurações no bloco. Por exemplo, na área Gerenciar campos da imagem anterior, você pode ver os três primeiros campos sendo gerenciados e os novos nomes atribuídos a eles. Cada bloco tem informações relevantes para ele.

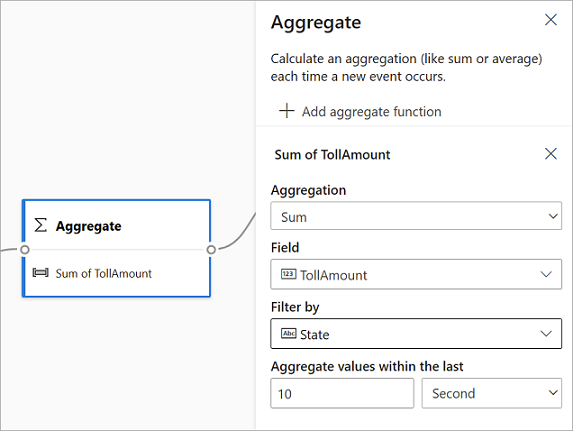

Agregado

Você pode usar a transformação de Agregação para calcular uma agregação (Soma, Mínimo, Máximo ou Média) sempre que um novo evento ocorre por um período de tempo. Essa operação também permite filtrar ou segmentar a agregação com base em outras dimensões em seus dados. Você pode ter uma ou mais agregações na mesma transformação.

Para adicionar uma agregação, clique no símbolo de transformação. Em seguida, conecte uma entrada, selecione as agregações, adicione as dimensões de filtro ou fatia e selecione o período de tempo durante o qual a agregação será calculada. Neste exemplo, estamos calculando a soma do valor de tarifa pelo estado de origem do veículo dos últimos 10 segundos.

Para adicionar outra agregação à mesma transformação, selecione Adicionar função de agregação. Tenha em mente que o filtro ou fatia será aplicado a todas as agregações na transformação.

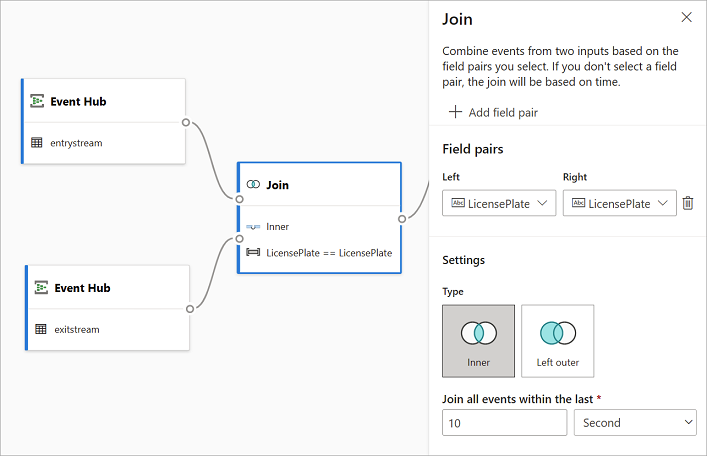

Join

Use a transformação de Junção para combinar eventos de duas entradas com base nos pares de campos que você selecionou. Se você não selecionar um par de campo, a junção será baseada no tempo por padrão. O padrão é o que torna essa transformação diferente da de um lote.

Como com as junções regulares, você tem opções para a lógica de junção:

- Junção interna: inclua somente registros de ambas as tabelas nas quais o par corresponde. Neste exemplo, é onde a placa de licença corresponde às duas entradas.

- Junção externa esquerda: inclua todos os registros da tabela esquerda (primeiro) e somente os registros do segundo que correspondam ao par de campos. Se não houver correspondência, os campos da segunda entrada ficarão em branco.

Para selecionar o tipo de junção, selecione o ícone do tipo preferencial no painel lateral.

Por fim, selecione em que período você deseja que a junção seja calculada. Neste exemplo, a junção examina os últimos dez segundos. Tenha em mente que, quanto mais tempo, a saída é menos frequente – e mais recursos de processamento serão usados para a transformação.

Por padrão, todos os campos de ambas as tabelas são incluídos. Os prefixos à esquerda (primeiro nó) e à direita (segundo nó) na saída ajudam você a diferenciar a fonte.

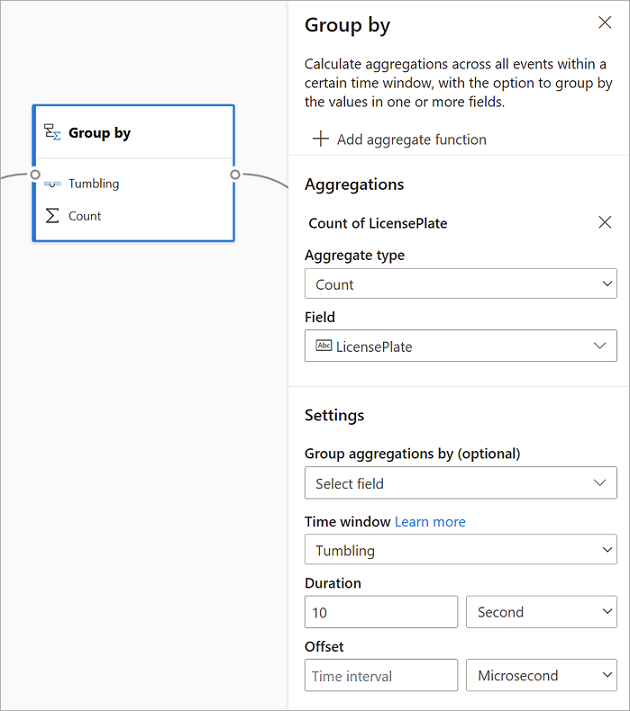

Agrupar por

Use a transformação de Agrupar por para calcular as agregações em todos os eventos dentro de uma determinada janela de tempo. Você pode agrupar pelos valores em um ou mais campos. É semelhante à transformação de Agregação, mas fornece mais opções para agregações. Ele também inclui opções mais complexas para janelas de tempo. Também semelhante à Agregação, você pode adicionar mais de uma agregação por transformação.

As agregações disponíveis na transformação são:

- Média

- Count

- Máximo

- Mínimo

- Percentil (contínuo e discreto)

- Desvio Padrão

- Sum

- Variance

Para configurar essa transformação:

- Selecione a agregação preferida.

- Selecione o campo no qual você deseja agregar.

- Selecione um campo agrupar por opcional se quiser obter o cálculo agregado sobre outra dimensão ou categoria. Por exemplo: Estado.

- Selecione sua função para janelas de tempo.

Para adicionar outra agregação à mesma transformação, selecione Adicionar função de agregação. Tenha em mente o campo Agrupar por e a função de janela será aplicada a todas as agregações na transformação.

Um carimbo de data/hora para o fim do tempo da janela de tempo aparece como parte da saída da transformação para referência. Para obter mais informações sobre janelas de tempo às quais os trabalhos do Stream Analytics dão suporte, confira As funções de janela (Azure Stream Analytics).

Union

Use a transformação União para conectar duas ou mais entradas para adicionar eventos que tenham campos compartilhados (com o mesmo nome e tipo de dados) em uma tabela. Os campos que não correspondem serão removidos e não incluídos na saída.

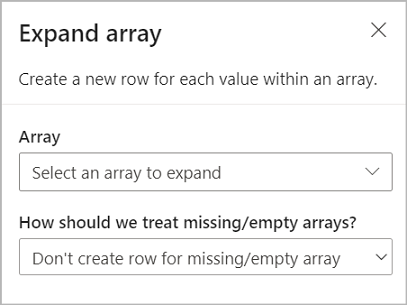

Expandir matriz

Use a transformação Expandir matriz a fim de criar outra linha para cada valor em uma matriz.

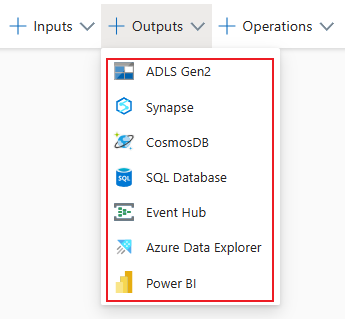

Saídas de streaming

Atualmente, a experiência de arrastar e soltar sem código dá suporte a vários coletores de saídas para armazenar os dados processados em tempo real.

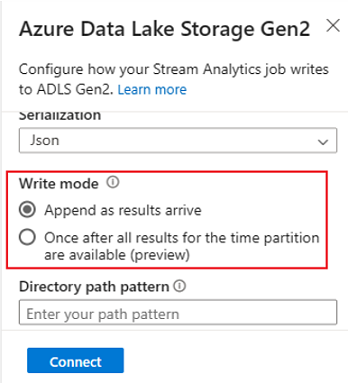

Azure Data Lake Storage Gen2

O Data Lake Storage Gen2 torna o armazenamento do Azure a fundação para a criação de data lakes empresariais no Azure. Ele foi projetado para atender a vários petabytes de informações e, ao mesmo tempo, manter centenas de gigabits de taxa de transferência. Ele permite que você gerencie facilmente grandes quantidades de dados. O Armazenamento de Blobs do Azure oferece uma solução econômica e escalonável para armazenar grandes quantidades de dados não estruturados na nuvem.

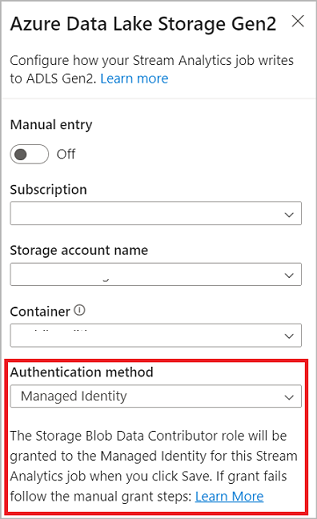

Na seção Saídas da faixa, selecione ADLS Gen2 como a saída para seu trabalho do Stream Analytics. Em seguida, selecione o contêiner para o qual deseja enviar a saída do trabalho. Para obter mais informações sobre a saída do Azure Data Lake Gen2 para um trabalho do Stream Analytics, confira o Armazenamento de Blobs e saída do Azure Data Lake Gen2 do Azure Stream Analytics.

Quando você está se conectando ao Azure Data Lake Storage Gen2, se selecionar Identidade Gerenciada como modo de autenticação, a função Colaborador de Dados do Blob de Armazenamento será concedida à identidade gerenciada do trabalho do Stream Analytics. Para saber mais sobre identidades gerenciadas no Azure Data Lake Storage Gen2, confira Usar identidades gerenciadas para autenticar o trabalho do Azure Stream Analytics no Armazenamento de Blobs do Azure.

As identidades gerenciadas eliminam as limitações dos métodos de autenticação baseados no usuário. Essas limitações incluem a necessidade de reautenticar quando há alterações de senha ou vencimento de tokens de usuário, o que ocorre a cada 90 dias.

Há suporte para a entrega exatamente uma vez (versão prévia) no ADLS Gen2 como uma saída do editor sem código. Você pode habilitá-la na seção Modo de gravação na configuração do ADLS Gen2. Para obter mais informações sobre esse recurso, confira Entrega exatamente uma vez (versão prévia) do Azure Data Lake Gen2

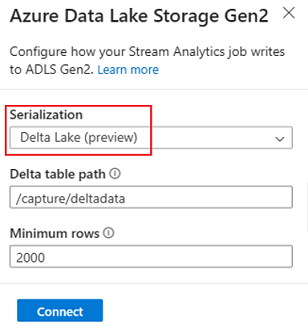

Há suporte para a gravação em uma tabela do Delta Lake (versão prévia) no ADLS Gen2 como uma saída do editor sem código. Acesse essa opção na seção Serialização na configuração do ADLS Gen2. Para obter mais informações sobre esse recurso, confira Gravação em uma tabela do Delta Lake.

Azure Synapse Analytics

Os trabalhos do Azure Stream Analytics podem enviar saída para uma tabela de pools de SQL dedicados no Azure Synapse Analytics e podem processar taxas de transferência de até 200 MB por segundo. O Stream Analytics dá suporte à análise em tempo real mais exigente e às necessidades de processamento de dados em caminho mais frequente em cargas de trabalho como relatórios e painéis.

Importante

A tabela dedicada do pool de SQL deve existir antes que você possa adicioná-la como uma saída ao seu trabalho do Stream Analytics. O esquema da tabela deve corresponder aos campos e seus tipos na saída de trabalho.

Na seção Saídas da faixa, selecione Synapse como a saída para seu trabalho do Stream Analytics. Em seguida, selecione a tabela de pools de SQL para a qual deseja enviar a saída do trabalho. Para obter mais informações sobre a saída do Azure Synapse para um trabalho do Stream Analytics, confira Saída do Azure Synapse Analytics do Azure Stream Analytics.

Azure Cosmos DB

O Azure Cosmos DB é um serviço de banco de dados distribuído globalmente que oferece escala elástica ilimitada em todo o mundo. Ele também oferece consultas avançadas e indexação automática com base em modelos de dados que independem do esquema.

Na seção Saídas da faixa, selecione CosmosDB como a saída para seu trabalho do Stream Analytics. Para obter mais informações sobre a saída do Azure Cosmos DB para um trabalho do Stream Analytics, confira Saída do Azure Cosmos DB no Azure Stream Analytics.

Quando você está se conectando ao Azure Cosmos DB, se selecionar Identidade Gerenciada como modo de autenticação, a função Colaborador de Dados será concedida à identidade gerenciada do trabalho do Stream Analytics. Para saber mais sobre identidades gerenciadas no Azure Cosmos DB, confira Usar identidades gerenciadas para acessar o Azure Cosmos DB em um trabalho do Azure Stream Analytics (versão prévia).

O método de autenticação de identidades gerenciadas também tem suporte na saída do Azure Cosmos DB no editor sem código, que tem o mesmo benefício que o do ADLS Gen2 acima.

Banco de Dados SQL do Azure

O Banco de Dados SQL do Azure é um mecanismo de banco de dados PaaS (plataforma como serviço) totalmente gerenciado que ajuda a criar uma camada de armazenamento de dados de alto desempenho e disponibilidade para aplicativos e soluções no Azure. Usando o editor sem código, você pode configurar trabalhos do Azure Stream Analytics para gravar os dados processados em uma tabela existente no Banco de Dados SQL.

Para configurar o Banco de Dados SQL do Azure como saída, selecione Banco de Dados SQL na seção Saídas da faixa. Em seguida, preencha as informações necessárias para conectar seu banco de dados SQL e selecione a tabela na qual você deseja gravar dados.

Importante

A tabela do Banco de Dados SQL do Azure precisa existir antes que você possa adicioná-la como uma saída ao seu trabalho do Stream Analytics. O esquema da tabela deve corresponder aos campos e seus tipos na saída de trabalho.

Para obter mais informações sobre a saída do Banco de Dados SQL do Azure para um trabalho do Stream Analytics, confira Saída do Banco de Dados SQL do Azure do Azure Stream Analytics.

Hubs de Eventos

Com os dados em tempo real que vêm para o ASA, o editor sem código pode transformar os dados, enriquecê-los e, em seguida, gerá-los também para outro hub de eventos. Você pode escolher a saída Hubs de Eventos quando configurar o trabalho do Azure Stream Analytics.

Para configurar os Hubs de Eventos como saída, selecione Hub de Eventos na seção Saídas da faixa. Em seguida, preencha as informações necessárias para conectar o hub de eventos no qual você deseja gravar dados.

Para saber mais sobre a saída dos Hubs de Eventos para um trabalho do Stream Analytics, confira Saída dos Hubs de Eventos para o Azure Stream Analytics.

Azure Data Explorer

O Azure Data Explorer é uma plataforma de análise de Big Data totalmente gerenciada e de alto desempenho que facilita a análise de grandes volumes de dados. Você pode usar o Azure Data Explorer como saída para o trabalho do Azure Stream Analytics usando também o editor sem código.

Para configurar o Azure Data Explorer como saída, selecione Azure Data Explorer na seção Saídas da faixa. Em seguida, preencha as informações necessárias para conectar seu banco de dados do Azure Data Explorer e especifique a tabela na qual você deseja gravar dados.

Importante

A tabela precisa existir no banco de dados selecionado e o esquema da tabela precisa corresponder exatamente aos campos e seus tipos na saída do trabalho.

Para saber mais sobre a saída do Azure Data Explorer para um trabalho do Stream Analytics, confira Saída do Azure Data Explorer do Azure Stream Analytics (Versão prévia).

Power BI

O Power BI oferece uma experiência de visualização abrangente para o resultado da análise de dados. Com a saída do Power BI para o Stream Analytics, os dados de streaming processados são gravados no conjunto de dados de streaming do Power BI e, em seguida, podem ser usados para criar a painel quase em tempo real do Power BI. Para saber mais sobre como criar o painel quase em tempo real, consulte Criar painel em tempo real com o conjunto de dados do Power BI produzido do Stream Analytics sem editor de código.

Para configurar o Power BI como saída, selecione Power BI na seção Saídas na faixa de opções . Em seguida, preencha as informações necessárias para conectar seu workspace do Power BI e forneça os nomes para o conjunto de dados de streaming e a tabela em que você deseja gravar os dados. Para saber mais sobre os detalhes de cada campo, consulte Saída do Power BI do Azure Stream Analytics.

Visualização de dados, erros de criação, logs de runtime e métricas

A experiência de arrastar e soltar sem código fornece ferramentas para ajudar você a criar, solucionar problemas e avaliar o desempenho do pipeline de análise para dados de streaming.

Visualização dos dados ao vivo para entradas

Quando você estiver se conectando a um hub de eventos e selecionando seu bloco no modo de exibição de diagrama (a guia Visualização de dados), obterá uma visualização dinâmica dos dados recebidos se todos os itens a seguir forem verdadeiros:

- Os dados estão sendo carregados.

- A entrada é configurada corretamente.

- Os campos foram adicionados.

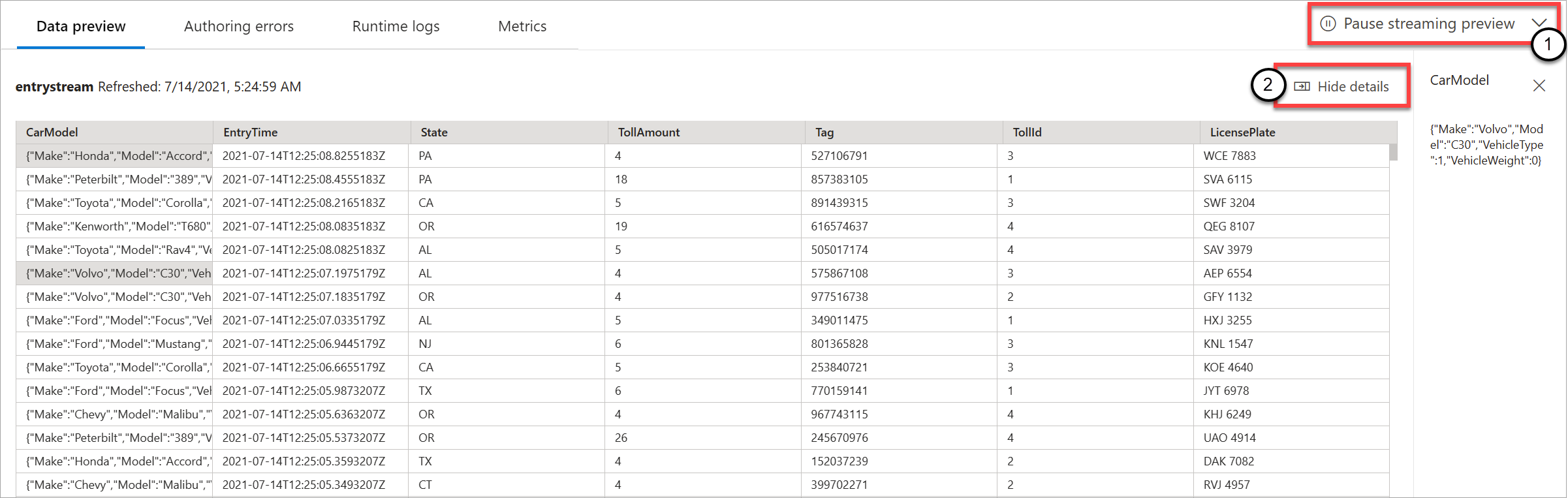

Conforme mostrado na captura de tela a seguir, se você quiser ver ou fazer uma busca detalhada em algo específico, poderá pausar a pré-visualização (1). Ou você pode iniciá-la novamente se tiver terminado.

Você também pode ver os detalhes de um registro específico (uma célula na tabela) selecionando-o e selecionando Mostrar/ocultar detalhes (2). A captura de tela mostra a exibição detalhada de um objeto aninhado em um registro.

Visualização estática para transformações e saídas

Depois de adicionar e configurar as etapas no modo de exibição de diagrama, você pode testar o comportamento selecionando Obter visualização estática.

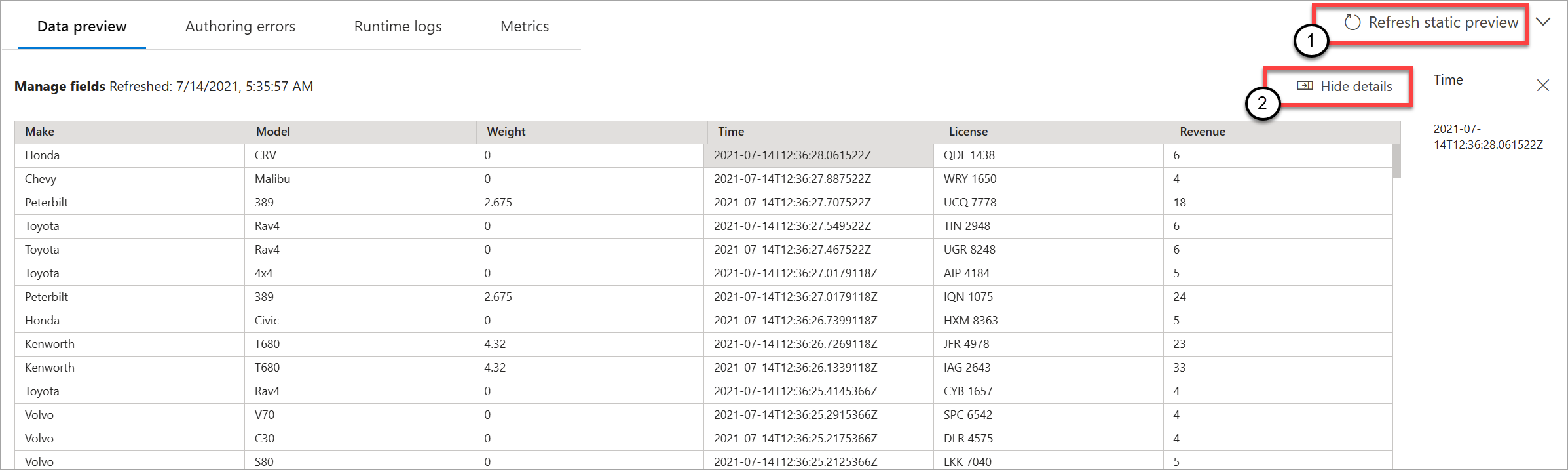

Depois disso, o trabalho do Stream Analytics avalia todas as transformações e saídas para verificar se elas estão configuradas corretamente. O Stream Analytics exibe os resultados na visualização de dados estáticos, conforme mostrado na imagem a seguir.

Você pode atualizar a visualização selecionando Atualizar pré-visualização estática (1). Quando você atualiza a versão prévia, o trabalho do Stream Analytics obtém novos dados da entrada e avalia todas as transformações. Em seguida, ele envia a saída novamente com todas as atualizações que você pode ter executado. A opção Mostrar/ocultar detalhes também está disponível (2).

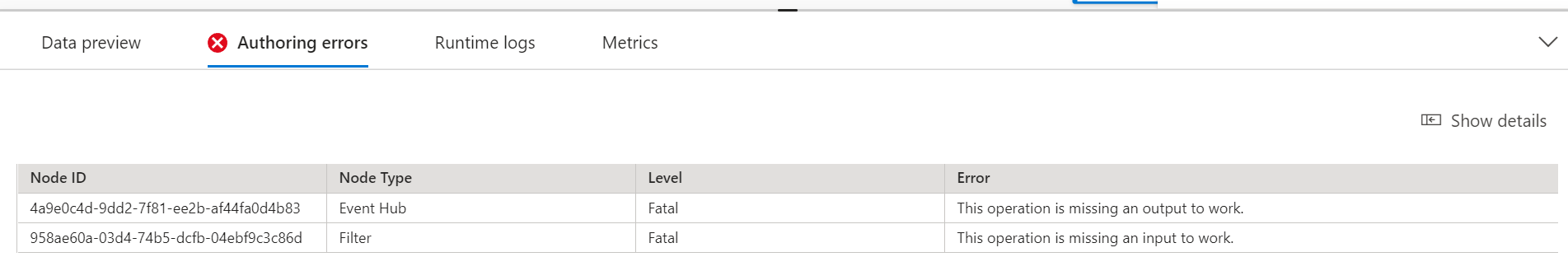

Erros de criação

Se você tiver erros ou avisos de criação, a guia Erros de criação os listará, conforme mostrado na captura de tela a seguir. A lista inclui detalhes sobre o erro ou aviso, o tipo de cartão (entrada, transformação ou saída), o nível de erro e uma descrição do erro ou aviso (2).

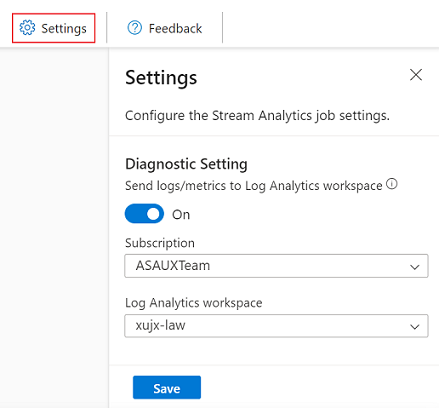

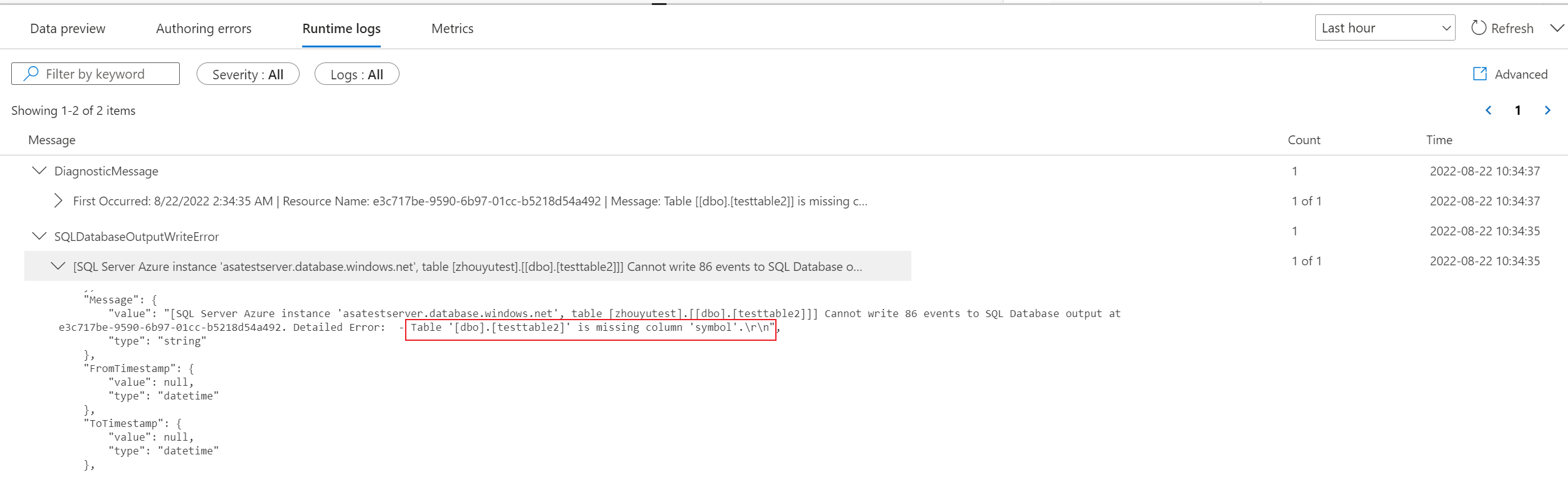

Logs de runtime

Os logs de runtime aparecem no nível de aviso, erro ou informação quando um trabalho está em execução. Esses logs são úteis quando você deseja editar a topologia ou configuração do trabalho do Stream Analytics para solução de problemas. Recomendamos que você ative os logs de diagnóstico e os envie para o workspace do Log Analytics em Configurações para ter mais insights de depuração sobre seus trabalhos em execução.

No exemplo de captura de tela a seguir, o usuário configurou a saída do Banco de Dados SQL com um esquema de tabela que não corresponde aos campos da saída do trabalho.

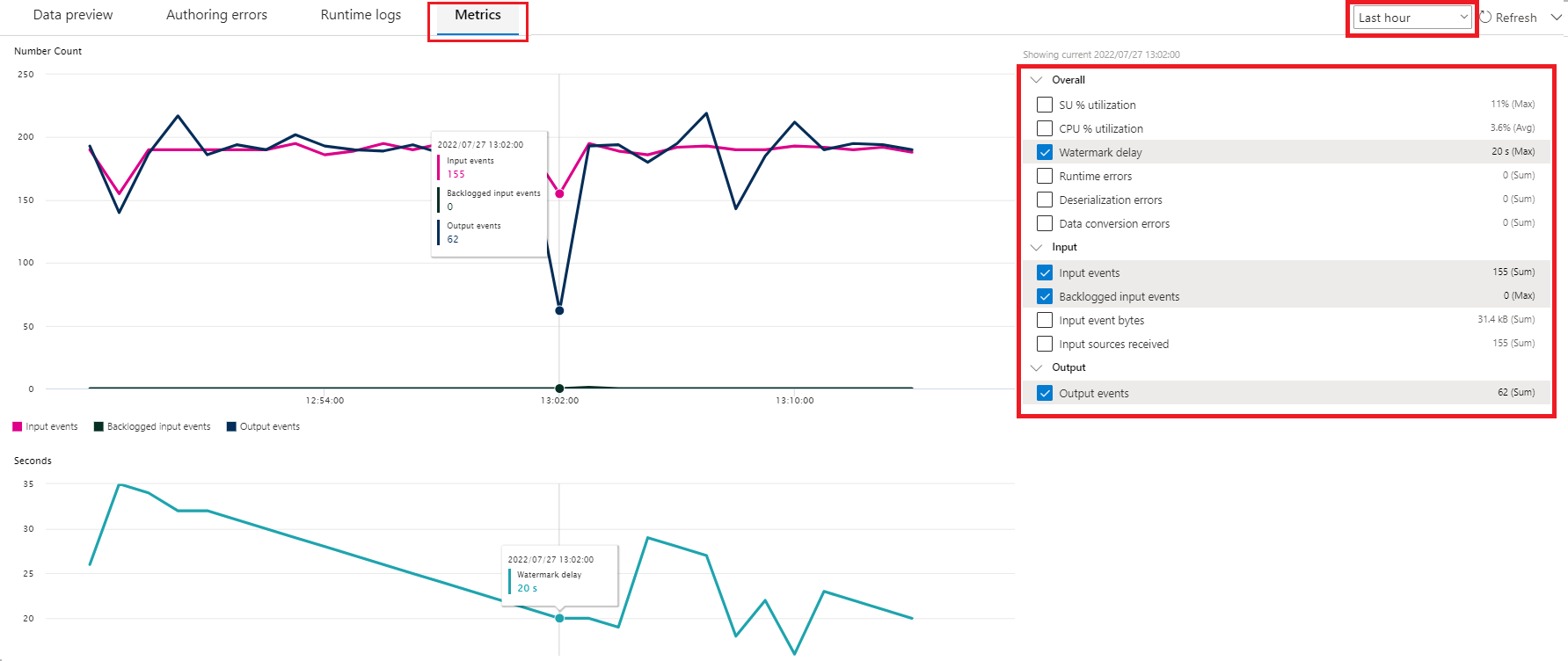

Métricas

Se o trabalho está em execução, você pode monitorar a integridade na guia Métricas. As quatro métricas mostradas por padrão são Atraso de marca-d’água, Eventos de entrada, Eventos de entrada acumulados e Eventos de saída. Você pode usar essas métricas para entender se os eventos estão fluindo para dentro e para fora do trabalho sem uma lista de pendências de entrada.

Você pode selecionar mais métricas na lista. Para entender todas as métricas em detalhes, confira Métricas do trabalho do Azure Stream Analytics.

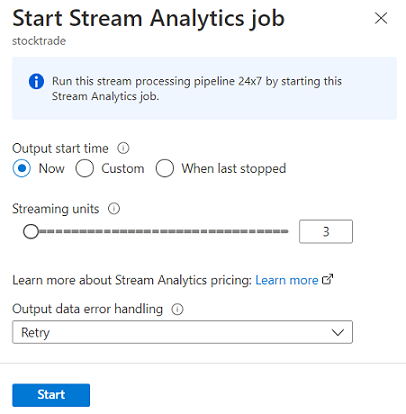

Iniciar um trabalho do Stream Analytics

Você pode salvar o trabalho a qualquer momento durante a criação. Depois de configurar o hub de eventos, as transformações e as saídas de streaming para o trabalho, você poderá iniciá-lo.

Observação

Embora o editor sem código no portal do Azure Stream Analytics esteja em versão prévia, o serviço do Azure Stream Analytics está em disponibilidade geral.

Você pode configurar estas opções:

-

Hora de início da saída: ao iniciar um trabalho, você seleciona um horário para o trabalho começar a criar saída.

- Agora: opção que torna o ponto de partida do fluxo de eventos de saída o mesmo de quando a tarefa é iniciada.

- Personalizado: você pode escolher o ponto de partida da saída.

- Quando interrompido pela última vez: esta opção está disponível quando o trabalho foi iniciado anteriormente, mas foi interrompido manualmente ou falhou. Ao escolher esta opção, a última hora de saída será usada para reiniciar o trabalho, para que nenhum dado seja perdido.

- Unidades de streaming: unidades de streaming representam a quantidade de computação e memória atribuída ao trabalho durante sua execução. Se você não tiver certeza de quantas SUs escolher, recomendamos que você comece com três e ajuste conforme necessário.

- Tratamento de erro de dados de saída: as políticas de tratamento de erro de dados de saída aplicam-se apenas a erros de conversão de dados que ocorrem quando o evento de saída produzido por um trabalho do Stream Analytics não está em conformidade com o esquema do coletor de destino. É possível configurar a política, escolhendo Repetir ou Remover. Para obter mais informações, confira Política de saída de erro do Azure Stream Analytics.

- Início: botão que inicia o trabalho do Stream Analytics.

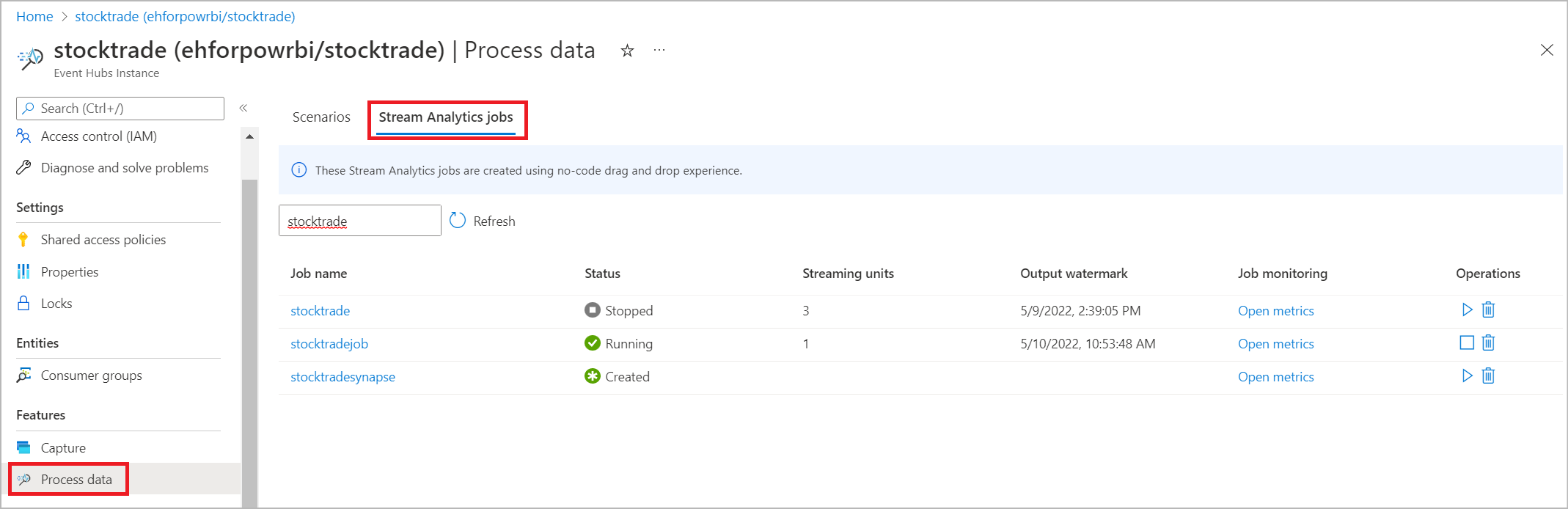

Lista de trabalhos do Stream Analytics no portal do Hubs de Eventos do Azure

Para ver uma lista de todos os trabalhos do Stream Analytics que você criou usando a experiência de arrastar e soltar sem código no portal do Hubs de Eventos do Azure, selecione Processar dados>Trabalhos do Stream Analytics.

Estes são os elementos da guia Trabalhos do Stream Analytics:

- Filtro: você pode filtrar a lista pelo nome do trabalho.

- Atualizar: atualmente, a lista não se atualiza automaticamente. Use o botão Atualizar para atualizar a lista e ver o status mais recente.

- Nome do trabalho: o nome nessa área é o que você forneceu na primeira etapa da criação do trabalho. Você não pode editá-lo. Selecione o nome do trabalho para abrir o trabalho na experiência de arrastar e soltar sem código em que você pode interromper o trabalho, editá-lo e iniciá-lo novamente.

- Status: essa área mostra o status do trabalho. Selecione Atualizar na parte superior da lista para ver o status mais recente.

- Unidades de streaming: essa área mostra o número de unidades de streaming selecionado quando você iniciou o trabalho.

- Marca-d’água de saída: essa área fornece um indicador de dinamismo dos dados que o trabalho produziu. Todos os eventos antes do carimbo de data/hora já estão computados.

- Monitoramento de trabalho: selecione Abrir métricas para ver as métricas relacionadas a este trabalho do Stream Analytics. Para obter mais informações sobre as métricas que você pode usar para monitorar seu trabalho do Stream Analytics, confira Métricas do trabalho do Stream Analytics.

- Operações: iniciar, parar ou excluir o trabalho.

Próximas etapas

Saiba como usar o editor sem código para abordar cenários comuns usando modelos predefinidos: