Copiar dados e transformar com parâmetros dinâmicos por hora

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dica

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange desde movimentação de dados até ciência de dados, análise em tempo real, business intelligence e relatórios. Saiba como iniciar uma avaliação gratuita!

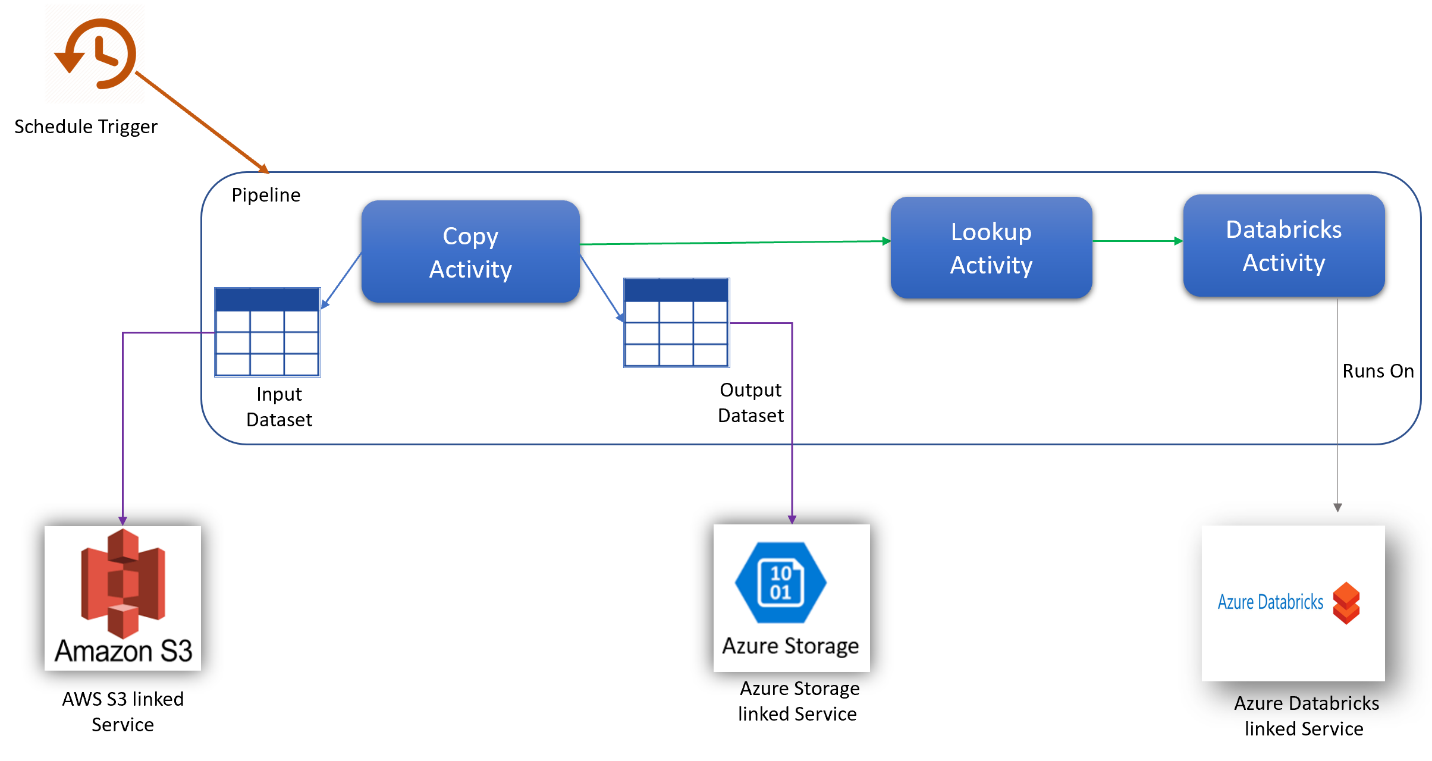

Nesse cenário, você deseja copiar dados do AWS S3 para o Armazenamento de Blobs do Azure e transformá-los com o Azure Databricks (com parâmetros dinâmicos no script) em um agendamento por hora para oito horas a cada dia por 30 dias.

Os preços usados neste exemplo abaixo são hipotéticos e não têm o objetivo de sugerir o preço real exato. Os custos de leitura/gravação e monitoramento não são mostrados, pois normalmente são insignificantes e não afetarão os custos gerais de forma substancial. As execuções de atividade também são arredondadas para os 1000 mais próximos nas estimativas da calculadora de preços.

Veja a Calculadora de Preços do Azure para ver cenários mais específicos e estimar os custos futuros para usar o serviço.

Configuração

Para executar o cenário, você precisará criar um pipeline com os seguintes itens:

- Uma atividade de cópia com um conjunto de dados de entrada para os dados a serem copiados do AWS S3, um conjunto de dados de saída para os dados no Armazenamento do Azure.

- Uma atividade de pesquisa para passar parâmetros dinamicamente para o script de transformação.

- Uma atividade do Azure Databricks para a transformação de dados.

- Um gatilho de agendamento para executar o pipeline a cada hora durante 8 horas por dia. Quando você quiser executar um pipeline, poderá acioná-lo imediatamente ou agendá-lo. Além do próprio pipeline, cada instância de gatilho conta como uma única execução de atividade.

Estimativa de custos

| Operações | Tipos e unidades |

|---|---|

| Executar pipeline | 4 Execuções de atividade por execução (1 para execução de gatilho, 3 para execuções de atividade) = 960 execuções de atividade, arredondadas para cima, pois a calculadora só permite incrementos de 1000. |

| Suposição de Copiar Dados: horas de DIU por execução = 10 minutos | 10 min\60 min * 4 Azure Integration Runtime (configuração DIU padrão = 4) Para obter mais informações sobre unidades de integração de dados e otimização de desempenho de cópia, confira este artigo |

| Executar atividade de pesquisa Suposição: horas de atividade de pipeline por execução = 1 min | 1 minuto/60 minutos de execução da atividade do pipeline |

| Suposição para a atividade de execução de Databricks: horas de execução externa por execução = 10 min | 10 min/60 min Execução de atividade de pipeline externo |

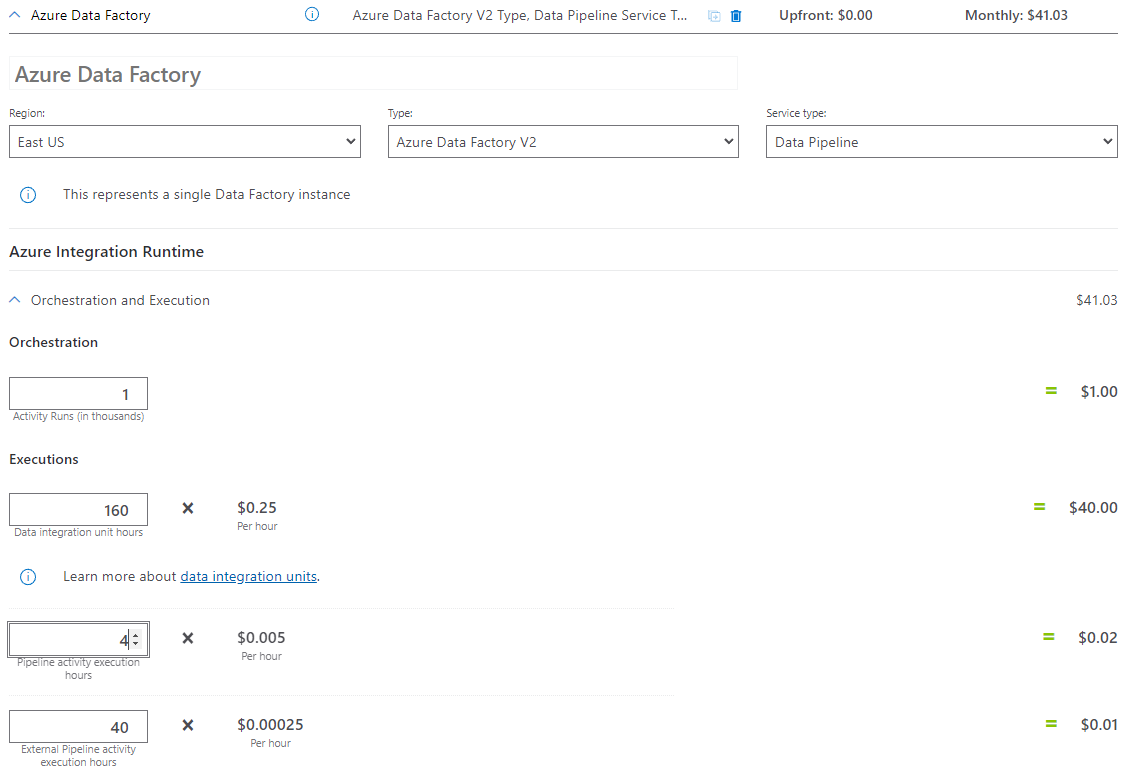

Exemplo de preços: exemplo de calculadora de preços

Preço total do cenário por 30 dias: US$ 41,03

Conteúdo relacionado

- Exemplo de preços: copiar dados do AWS S3 para o Armazenamento de Blobs do Azure por hora por 30 dias

- Exemplo de preço: copiar dados e transformá-los com o Azure Databricks por hora por 30 dias

- Exemplo de preços: executar pacotes do SSIS no runtime de integração do Azure-SSIS

- Exemplo de preços: usando a depuração de fluxo de dados de mapeamento para um dia de trabalho normal

- Exemplo de preços: transformar dados no repositório de blobs com fluxos de dados de mapeamento

- Exemplo de preços: integração de dados na VNET Gerenciada do Azure Data Factory

- Exemplo de preços: obter dados delta do ECC do SAP via CDC do SAP em fluxos de dados de mapeamento