inżynierowie danych ustawień administracji obszaru roboczego w usłudze Microsoft Fabric

Dotyczy:✅ inżynierowie danych i Nauka o danych w usłudze Microsoft Fabric

Podczas tworzenia obszaru roboczego w usłudze Microsoft Fabric tworzona jest automatycznie pula początkowa skojarzona z tym obszarem roboczym. W przypadku uproszczonej konfiguracji w usłudze Microsoft Fabric nie ma potrzeby wybierania rozmiaru węzła lub maszyny, ponieważ te opcje są obsługiwane za kulisami. Ta konfiguracja zapewnia szybsze (5–10 sekund) środowisko uruchamiania sesji platformy Apache Spark dla użytkowników w celu rozpoczęcia i uruchamiania zadań platformy Apache Spark w wielu typowych scenariuszach bez konieczności martwienia się o skonfigurowanie obliczeń. W przypadku zaawansowanych scenariuszy z określonymi wymaganiami obliczeniowymi użytkownicy mogą utworzyć niestandardową pulę platformy Apache Spark i rozmiar węzłów na podstawie potrzeb związanych z wydajnością.

Aby wprowadzić zmiany w ustawieniach platformy Apache Spark w obszarze roboczym, musisz mieć rolę administratora dla tego obszaru roboczego. Aby dowiedzieć się więcej, zobacz Role w obszarach roboczych.

Aby zarządzać ustawieniami platformy Spark dla puli skojarzonej z obszarem roboczym:

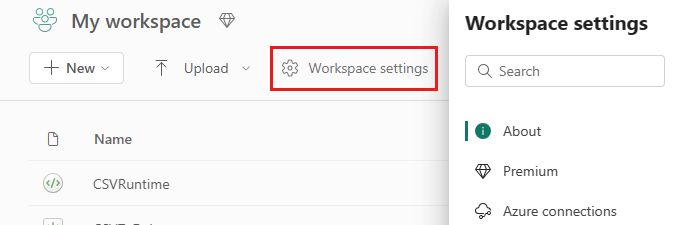

Przejdź do ustawień obszaru roboczego w obszarze roboczym i wybierz opcję inżynierowie danych ing/Science, aby rozwinąć menu:

W menu po lewej stronie zostanie wyświetlona opcja Spark Compute :

Uwaga

Jeśli zmienisz domyślną pulę z puli startowej na niestandardową pulę spark, może zostać wyświetlona dłuższa sesja (ok. 3 minuty).

Pula

Domyślna pula dla obszaru roboczego

Możesz użyć automatycznie utworzonej puli startowej lub utworzyć pule niestandardowe dla obszaru roboczego.

Pula początkowa: wstępnie wypełnianie pul na żywo automatycznie utworzonych w celu szybszego środowiska. Te klastry mają średni rozmiar. Pula początkowa jest ustawiona na domyślną konfigurację na podstawie zakupionej jednostki SKU pojemności sieci szkieletowej. Administratorzy mogą dostosować maksymalne węzły i funkcje wykonawcze na podstawie wymagań dotyczących skalowania obciążeń platformy Spark. Aby dowiedzieć się więcej, zobacz Konfigurowanie pul startowych

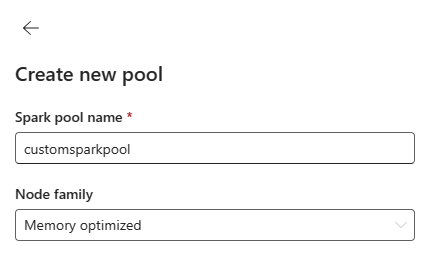

Niestandardowa pula platformy Spark: można określać rozmiar węzłów, skalowanie automatyczne i dynamicznie przydzielać funkcje wykonawcze na podstawie wymagań dotyczących zadań platformy Spark. Aby utworzyć niestandardową pulę platformy Spark, administrator pojemności powinien włączyć opcję Dostosowane pule obszarów roboczych w sekcji Obliczenia platformy Spark w ustawieniach administratora pojemności.

Uwaga

Kontrolka poziomu pojemności dla niestandardowych pul obszarów roboczych jest domyślnie włączona. Aby dowiedzieć się więcej, zobacz Konfigurowanie ustawień inżynierii danych i nauki o danych oraz zarządzanie nimi dla pojemności sieci szkieletowej.

Administratorzy mogą tworzyć niestandardowe pule platformy Spark na podstawie ich wymagań obliczeniowych, wybierając opcję Nowa pula .

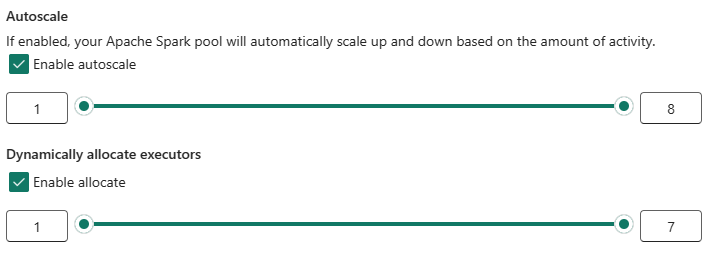

Platforma Apache Spark dla usługi Microsoft Fabric obsługuje klastry z jednym węzłem, co pozwala użytkownikom wybrać minimalną konfigurację węzła 1 w tym przypadku sterownik i funkcja wykonawcza uruchamiana w jednym węźle. Te klastry z jednym węzłem oferują wysoką dostępność podczas awarii węzłów i lepszą niezawodność zadań dla obciążeń z mniejszymi wymaganiami obliczeniowymi. Możesz również włączyć lub wyłączyć opcję skalowania automatycznego dla niestandardowych pul platformy Spark. Po włączeniu automatycznego skalowania pula uzyska nowe węzły w ramach maksymalnego limitu węzłów określonego przez użytkownika i wycofa je po wykonaniu zadania w celu uzyskania lepszej wydajności.

Możesz również wybrać opcję dynamicznego przydzielania funkcji wykonawczych do puli automatycznie optymalnej liczby funkcji wykonawczych w ramach maksymalnej liczby określonych na podstawie woluminu danych w celu uzyskania lepszej wydajności.

Dowiedz się więcej o obliczeniach platformy Apache Spark dla sieci szkieletowej.

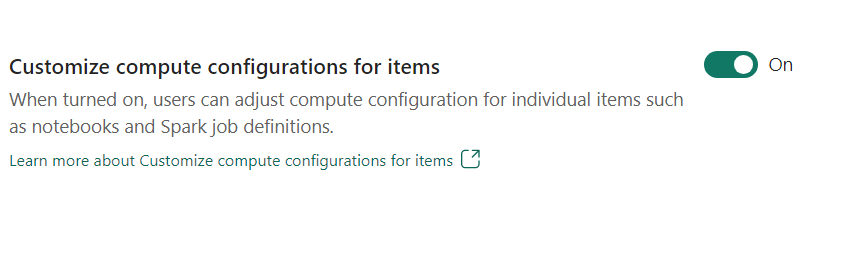

- Dostosowywanie konfiguracji obliczeniowej dla elementów: jako administrator obszaru roboczego możesz zezwolić użytkownikom na dostosowywanie konfiguracji obliczeniowych (właściwości poziomu sesji, które obejmują sterownik/funkcja wykonawcza, sterownik/pamięć funkcji wykonawczej) dla poszczególnych elementów, takich jak notesy, definicje zadań platformy Spark przy użyciu środowiska.

Jeśli ustawienie zostanie wyłączone przez administratora obszaru roboczego, domyślna pula i jej konfiguracje obliczeniowe są używane dla wszystkich środowisk w obszarze roboczym.

Środowisko

Środowisko udostępnia elastyczne konfiguracje uruchamiania zadań platformy Spark (notesy, definicje zadań platformy Spark). W środowisku można skonfigurować właściwości obliczeniowe, wybrać różne środowisko uruchomieniowe, skonfigurować zależności pakietów biblioteki na podstawie wymagań dotyczących obciążenia.

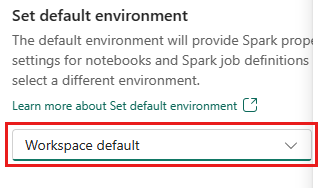

Na karcie Środowisko jest dostępna opcja ustawienia środowiska domyślnego. Możesz wybrać wersję platformy Spark, której chcesz użyć dla obszaru roboczego.

Jako administrator obszaru roboczego sieci szkieletowej możesz wybrać pozycję Środowisko jako domyślne środowisko.

Możesz również utworzyć nowy za pomocą listy rozwijanej Środowisko .

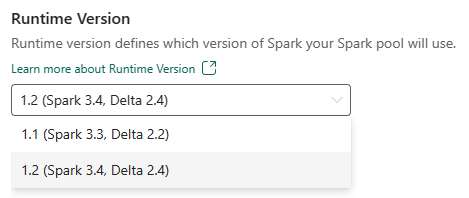

Jeśli wyłączysz opcję środowiska domyślnego, możesz wybrać wersję środowiska uruchomieniowego sieci szkieletowej z dostępnych wersji środowiska uruchomieniowego wymienionych na liście rozwijanej.

Dowiedz się więcej o środowiskach uruchomieniowych platformy Apache Spark.

Stanowiska

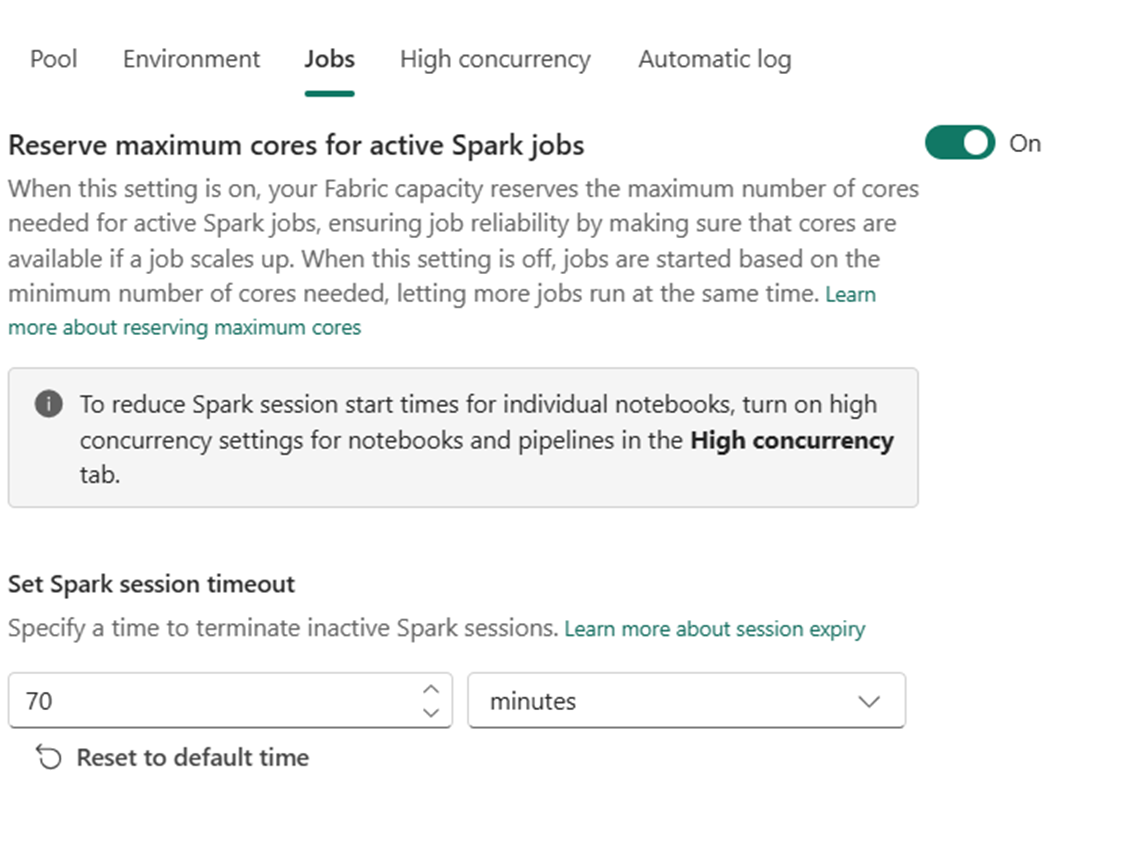

Ustawienia zadań umożliwiają administratorom kontrolowanie logiki przyjęcia zadania dla wszystkich zadań platformy Spark w obszarze roboczym.

Domyślnie wszystkie obszary robocze są włączone z optymistycznym przyjęciem zadania. Dowiedz się więcej o przyjęciu zadań dla platformy Spark w usłudze Microsoft Fabric.

Możesz włączyć rezerwę maksymalnych rdzeni dla aktywnych zadań platformy Spark, aby włączyć podejście oparte na optymistycznym zdaniu i zarezerwować maksymalne rdzenie dla zadań platformy Spark.

Możesz również ustawić limit czasu sesji platformy Spark, aby dostosować wygaśnięcie sesji dla wszystkich interakcyjnych sesji notesu.

Uwaga

Domyślny czas wygaśnięcia sesji jest ustawiony na 20 minut dla interakcyjnych sesji platformy Spark.

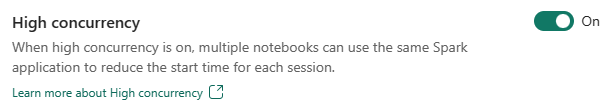

Wysoka współbieżność

Tryb wysokiej współbieżności umożliwia użytkownikom współużytkowanie tych samych sesji platformy Spark w usłudze Apache Spark dla obciążeń inżynierii danych i nauki o danych. Element podobny do notesu używa sesji platformy Spark do jego wykonania i po włączeniu umożliwia użytkownikom udostępnianie jednej sesji platformy Spark w wielu notesach.

Dowiedz się więcej o wysokiej współbieżności w usłudze Apache Spark for Fabric.

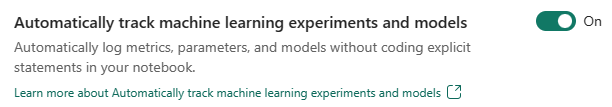

Automatyczne rejestrowanie modeli i eksperymentów usługi Machine Learning

Administratorzy mogą teraz włączyć automatyczne rejestrowanie dla modeli i eksperymentów uczenia maszynowego. Ta opcja automatycznie przechwytuje wartości parametrów wejściowych, metryk wyjściowych i elementów wyjściowych modelu uczenia maszynowego podczas trenowania. Dowiedz się więcej na temat automatycznego rejestrowania.

Powiązana zawartość

- Przeczytaj o środowiskach uruchomieniowych platformy Apache Spark w sieci szkieletowej — omówienie, przechowywanie wersji, obsługa wielu środowisk uruchomieniowych i uaktualnianie protokołu Delta Lake.

- Dowiedz się więcej z publicznej dokumentacji platformy Apache Spark.

- Odpowiedzi na często zadawane pytania: Często zadawane pytania dotyczące ustawień administracyjnych obszaru roboczego platformy Apache Spark.