Monitorowanie szczegółów aplikacji platformy Apache Spark

Za pomocą usługi Microsoft Fabric można uruchamiać notesy, zadania i inne rodzaje aplikacji w obszarze roboczym przy użyciu platformy Apache Spark. W tym artykule wyjaśniono, jak monitorować aplikację platformy Apache Spark, co pozwala śledzić ostatni stan uruchomienia, problemy i postęp zadań.

Wyświetlanie aplikacji platformy Apache Spark

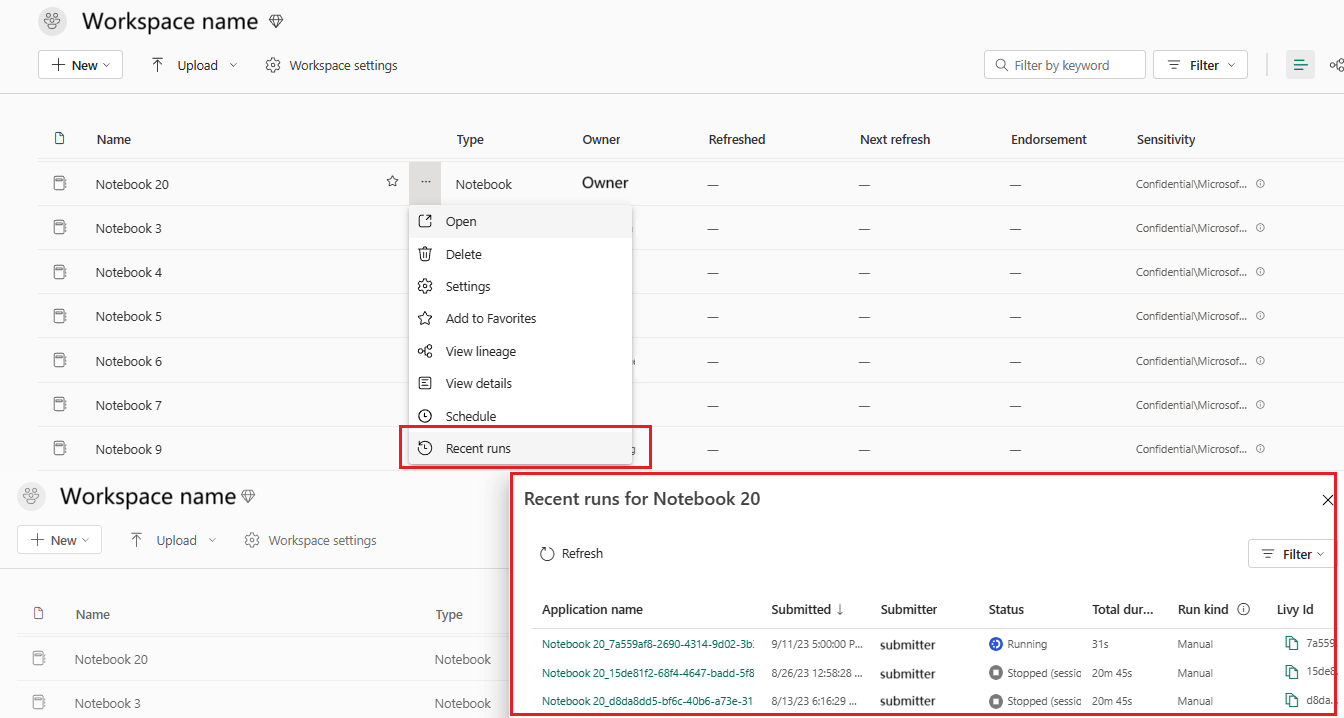

Możesz wyświetlić wszystkie aplikacje platformy Apache Spark z definicji zadania platformy Spark lub menu kontekstowe elementu notesu wyświetla ostatnią opcję uruchamiania —> ostatnie uruchomienia.

Możesz wybrać nazwę aplikacji, którą chcesz wyświetlić na liście aplikacji, na stronie szczegółów aplikacji możesz wyświetlić szczegóły aplikacji.

Monitorowanie stanu aplikacji platformy Apache Spark

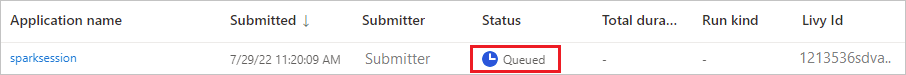

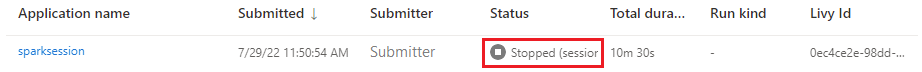

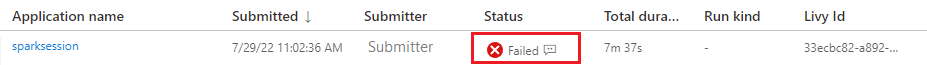

Otwórz stronę Ostatnie uruchomienia notesu lub definicji zadania platformy Spark, aby wyświetlić stan aplikacji Apache.

- Powodzenie

- W kolejce

- Zatrzymana

- Anulowany

- Niepowodzenie

Stanowiska

Otwórz zadanie aplikacji platformy Apache Spark z menu kontekstowego definicji zadania platformy Spark lub elementu notesu zawiera opcję Ostatnie uruchomienia —>>.

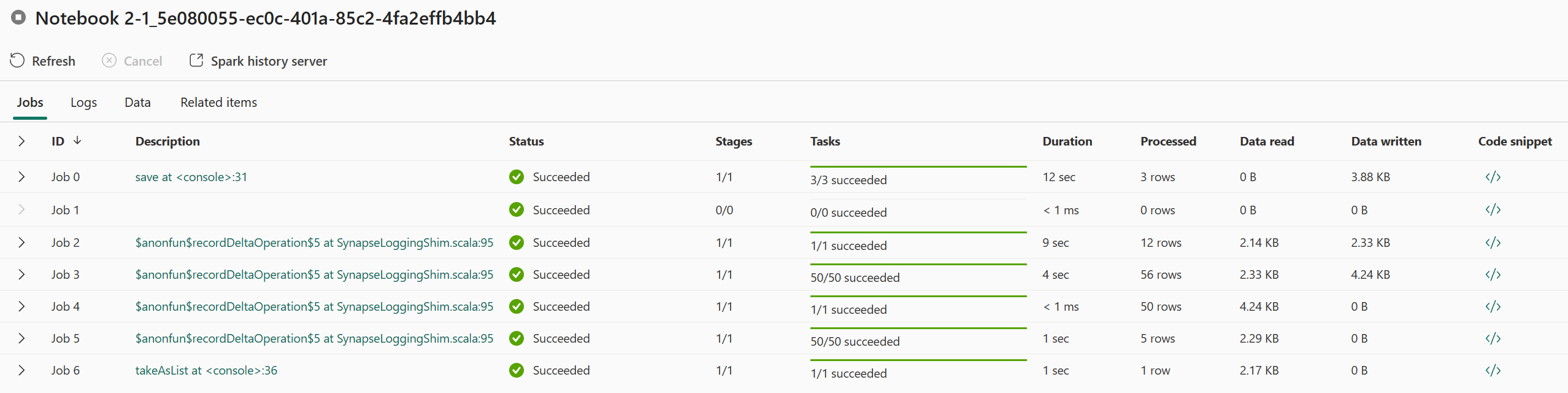

Na stronie szczegółów monitorowania aplikacji platformy Apache Spark lista przebiegów zadań jest wyświetlana na karcie Zadania. W tym miejscu można wyświetlić szczegóły każdego zadania, w tym identyfikator zadania, opis, stan, etapy, zadania, czas trwania, przetworzone, odczyt danych, zapisane dane i fragment kodu.

- Kliknięcie pozycji Identyfikator zadania może rozwinąć/zwinąć zadanie.

- Kliknij opis zadania, możesz przejść do strony zadania lub etapu w interfejsie użytkownika platformy Spark.

- Kliknij fragment kodu zadania, możesz sprawdzić i skopiować kod związany z tym zadaniem.

Zasoby

Wykres użycia funkcji wykonawczej na karcie zasoby wizualizuje alokację i wykorzystanie funkcji wykonawczych platformy Spark dla bieżącej aplikacji Spark w czasie niemal rzeczywistym podczas wykonywania platformy Spark. Zapoznaj się z tematem: Monitorowanie wykorzystania zasobów aplikacji platformy Apache Spark.

Panel podsumowania

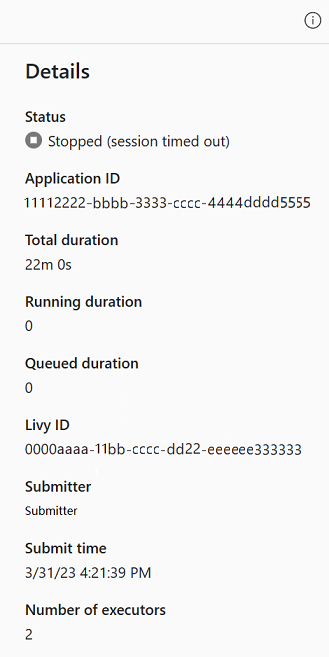

Na stronie monitorowania aplikacji platformy Apache Spark kliknij przycisk Właściwości , aby otworzyć/zwinąć panel podsumowania. Szczegóły tej aplikacji można wyświetlić w obszarze Szczegóły.

- Stan tej aplikacji spark.

- Identyfikator tej aplikacji platformy Spark.

- Całkowity czas trwania.

- Czas trwania działania dla tej aplikacji platformy Spark.

- Czas trwania w kolejce dla tej aplikacji spark.

- Identyfikator usługi Livy

- Submitter dla tej aplikacji spark.

- Prześlij czas dla tej aplikacji spark.

- Liczba funkcji wykonawczych.

Dzienniki

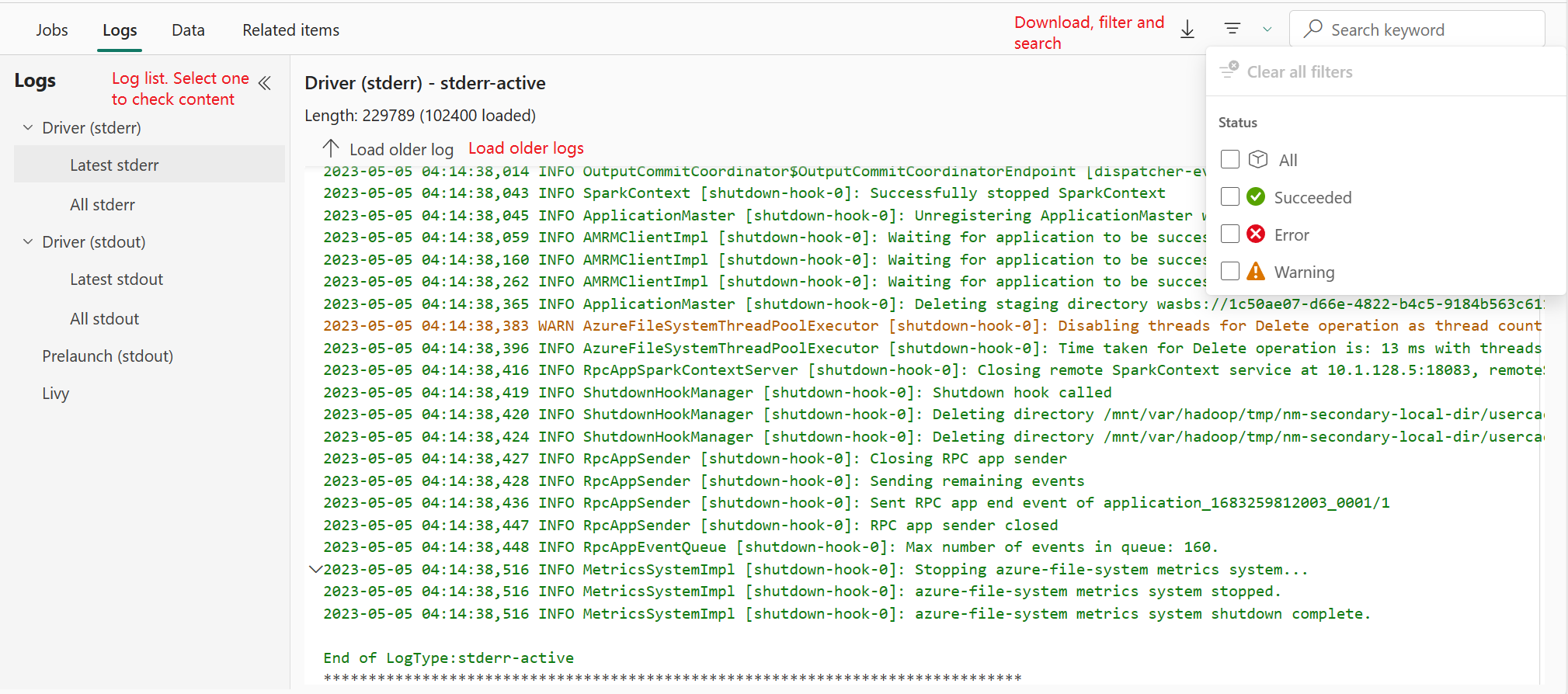

Na karcie Dzienniki można wyświetlić pełny dziennik usługi Livy, Prelaunch, Dziennik sterowników z różnymi opcjami wybranymi w panelu po lewej stronie. Możesz również bezpośrednio pobrać wymagane informacje dziennika, wyszukując słowa kluczowe i wyświetlając dzienniki, filtrując stan dziennika. Kliknij pozycję Pobierz dziennik, aby pobrać informacje dziennika do lokalnego.

Czasami nie są dostępne żadne dzienniki, takie jak stan zadania jest kolejkowany, a tworzenie klastra nie powiodło się.

Dzienniki na żywo są dostępne tylko wtedy, gdy przesyłanie aplikacji zakończy się niepowodzeniem, a także zostaną udostępnione dzienniki sterowników.

Data

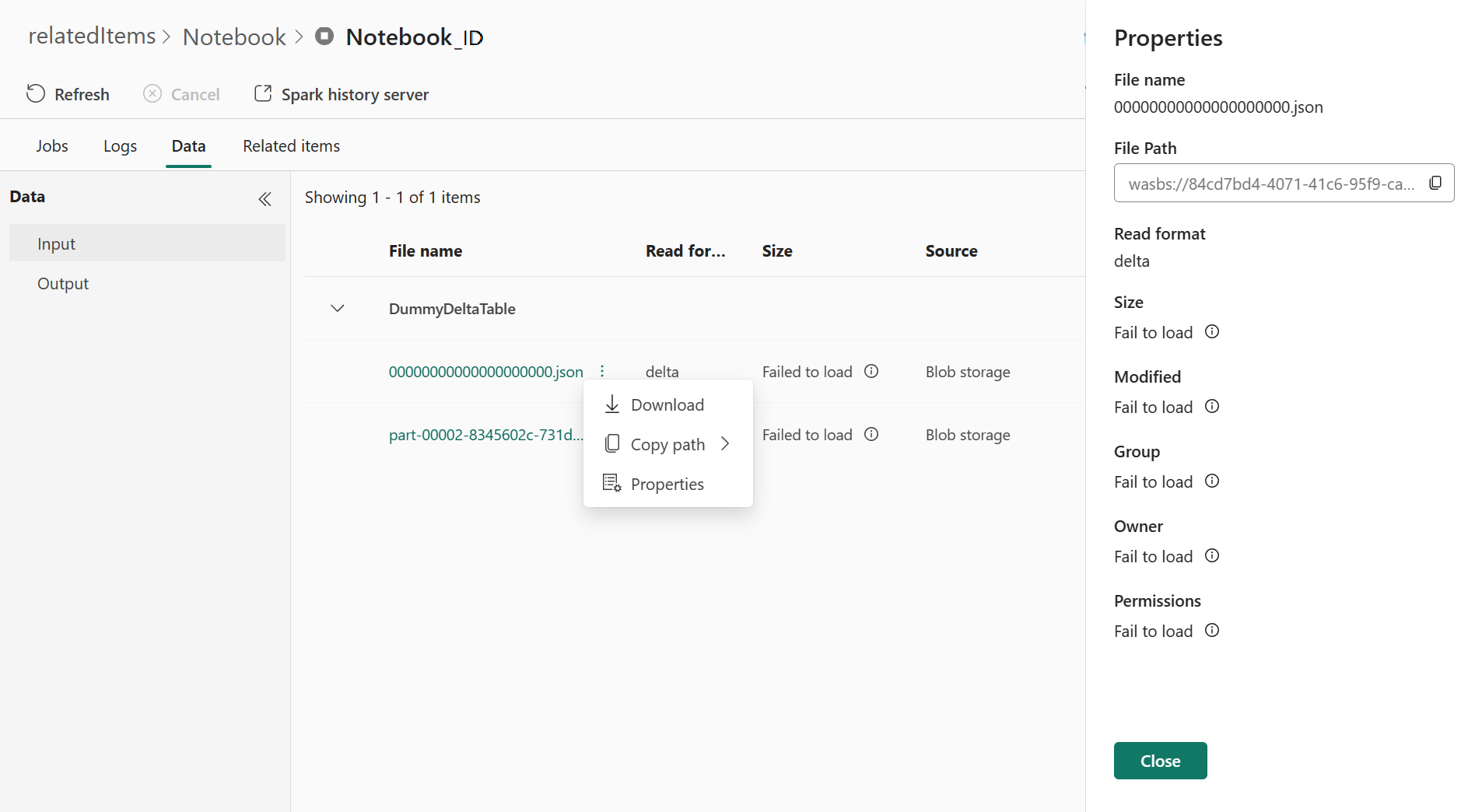

Na karcie Dane możesz skopiować listę danych w schowku, pobrać listę danych i pojedyncze dane oraz sprawdzić właściwości poszczególnych danych.

- Panel po lewej stronie można rozwinąć lub zwinąć.

- Nazwa, format odczytu, rozmiar, źródło i ścieżka plików wejściowych i wyjściowych będą wyświetlane na tej liście.

- Pliki w danych wejściowych i wyjściowych można pobrać, skopiować ścieżkę i wyświetlić właściwości.

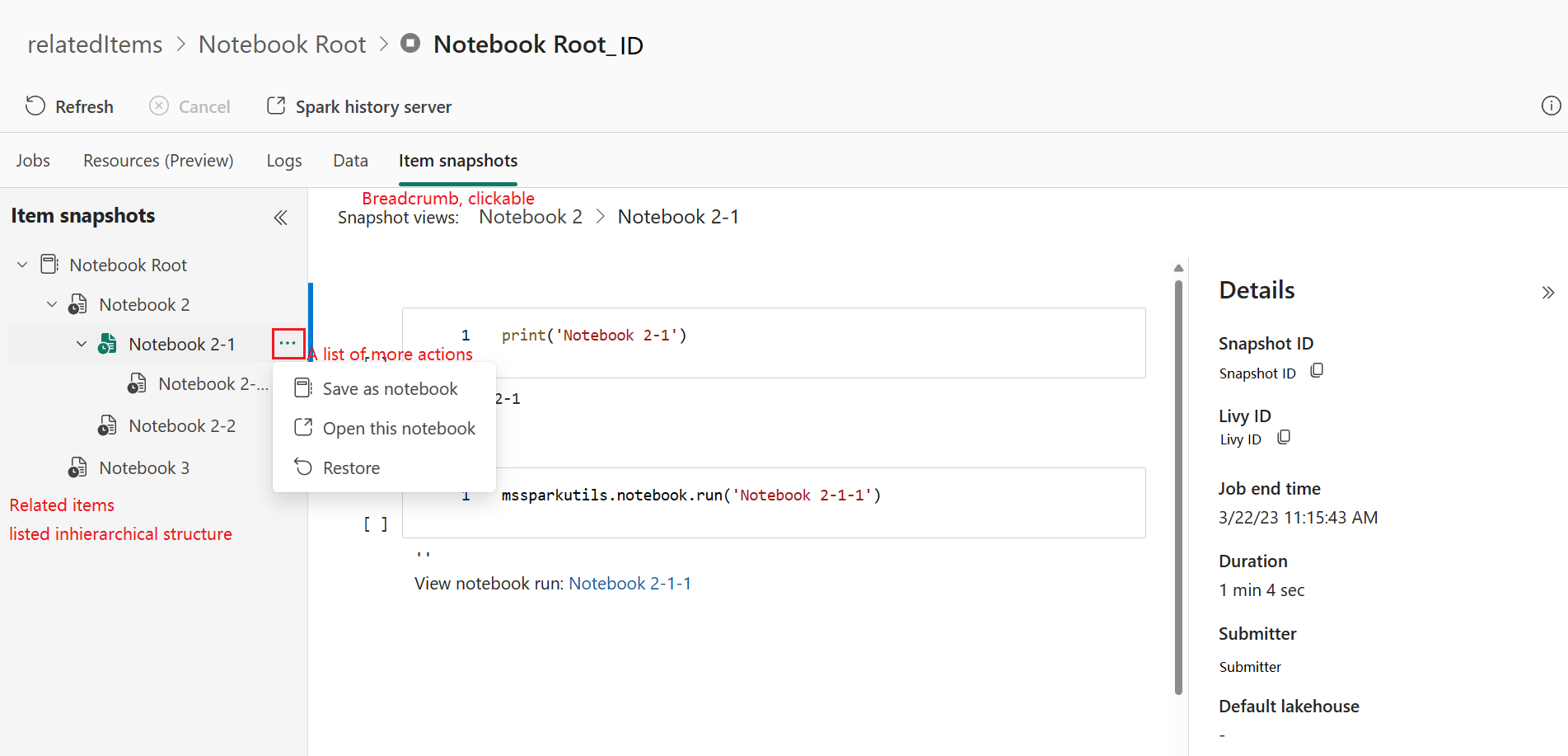

Migawki elementów

Karta Migawki elementów umożliwia przeglądanie i wyświetlanie elementów skojarzonych z aplikacją Apache Spark, w tym notesów, definicji zadań platformy Spark i/lub potoków. Na stronie migawek elementów jest wyświetlana migawka wartości kodu i parametrów w czasie wykonywania notesów. Przedstawia również migawkę wszystkich ustawień i parametrów w czasie przesyłania definicji zadań platformy Spark. Jeśli aplikacja Platformy Apache Spark jest skojarzona z potokiem, powiązana strona elementu zawiera również odpowiedni potok i działanie platformy Spark.

Na ekranie Migawki elementów można wykonywać następujące czynności:

- Przeglądaj i nawiguj po powiązanych elementach w drzewie hierarchicznym.

- Kliknij ikonę wielokropka "Lista większej liczby akcji" dla każdego elementu, aby wykonać różne akcje.

- Kliknij element migawki, aby wyświetlić jego zawartość.

- Wyświetl linki do stron nadrzędnych, aby wyświetlić ścieżkę z wybranego elementu do katalogu głównego.

Uwaga

Funkcja Migawek notesu obecnie nie obsługuje notesów, które znajdują się w stanie uruchomienia ani w sesji platformy Spark o wysokiej współbieżności.

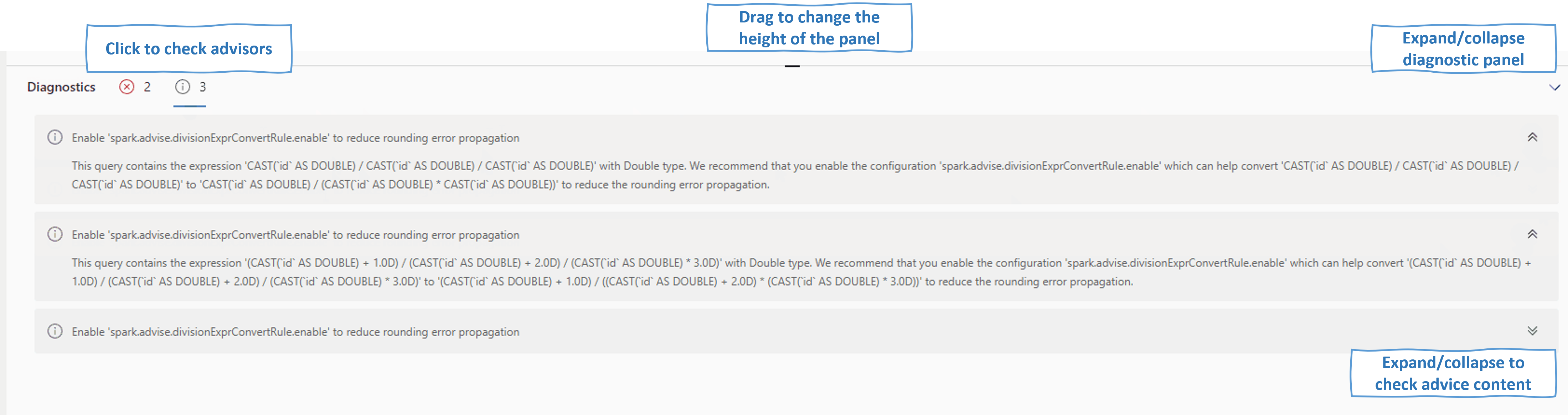

Diagnostyka

Panel diagnostyczny zapewnia użytkownikom rekomendacje i analizę błędów w czasie rzeczywistym, które są generowane przez doradcę Spark za pomocą analizy kodu użytkownika. Dzięki wbudowanym wzorcom doradca platformy Apache Spark pomaga użytkownikom uniknąć typowych błędów i analizować błędy w celu zidentyfikowania ich głównej przyczyny.

Powiązana zawartość

Następnym krokiem po wyświetleniu szczegółów aplikacji platformy Apache Spark jest wyświetlenie postępu zadania platformy Spark poniżej komórki Notes. Możesz odwołać się do: