Monitorowanie wykorzystania zasobów aplikacji platformy Apache Spark

Wykres użycia funkcji wykonawczej na karcie Zasoby wizualizuje alokację i wykorzystanie funkcji wykonawczych platformy Spark dla bieżącej aplikacji Spark w czasie niemal rzeczywistym podczas wykonywania platformy Spark. Wykres zapewnia również interaktywne środowisko, umożliwiające wyświetlanie zadań i prac Spark poprzez kliknięcie na uruchomionych wykonawcach w danym momencie. Obecnie ta funkcja obsługuje tylko środowisko uruchomieniowe platformy Spark w wersji 3.4 lub nowszej.

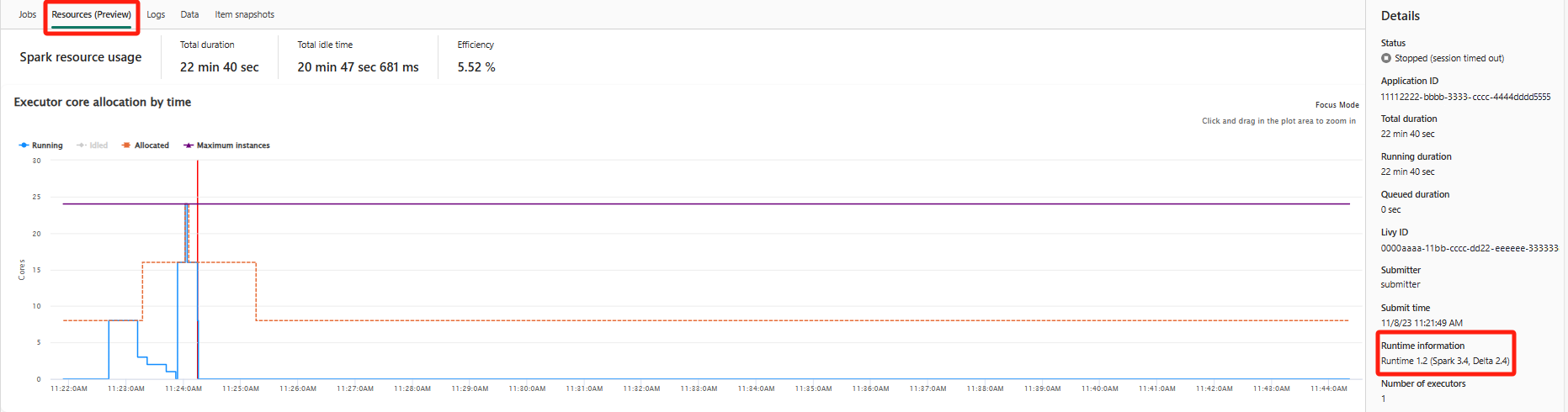

Zakładka zasoby

Kliknij kartę Zasoby, aby uzyskać dostęp do wykresu z czterema odrębnymi wykresami liniowymi, z których każdy przedstawia inny stan wykonawcy: Uruchomione, Bezczynne, Przydzielonei Maksymalna liczba wystąpień.

Running: pokazuje rzeczywistą liczbę rdzeni używanych przez aplikację Spark do uruchamiania zadań i zadań platformy Spark.

idled: reprezentuje liczbę rdzeni, które są dostępne, ale nieużywane, gdy aplikacja Spark jest uruchomiona.

Przydzielone: odnosi się to do rdzeni przydzielonych podczas działania aplikacji Spark.

maksymalna liczba wystąpień: wskazuje maksymalną liczbę rdzeni, które można przydzielić do aplikacji Spark.

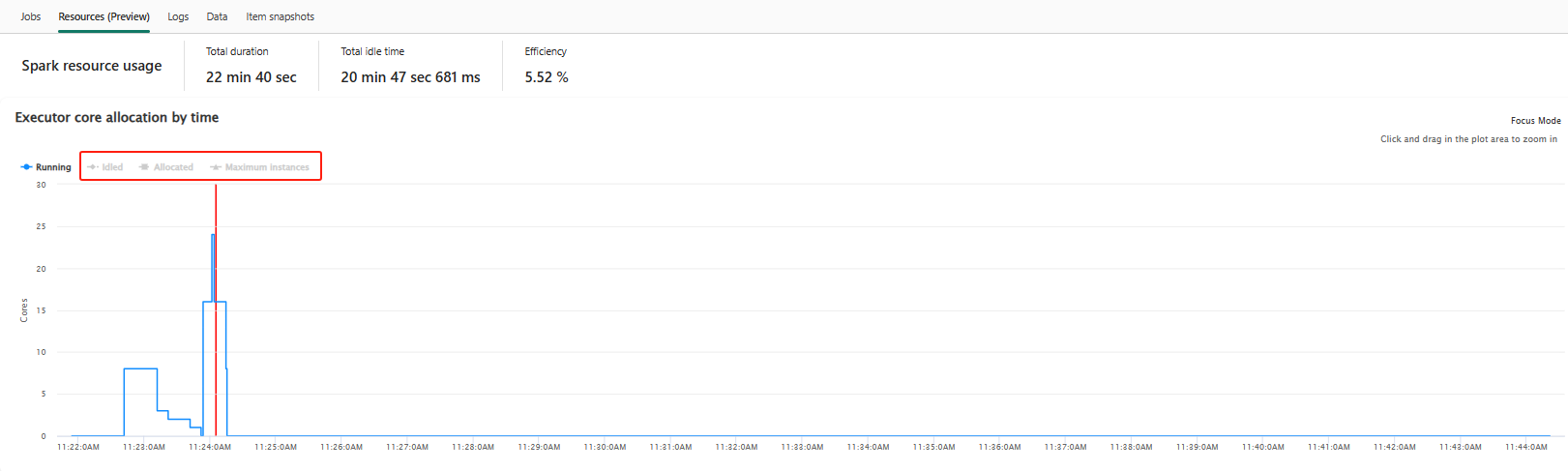

Przełącz legendę koloru, aby wybrać lub usunąć zaznaczenie odpowiedniego grafu na wykresie wykorzystania zasobów.

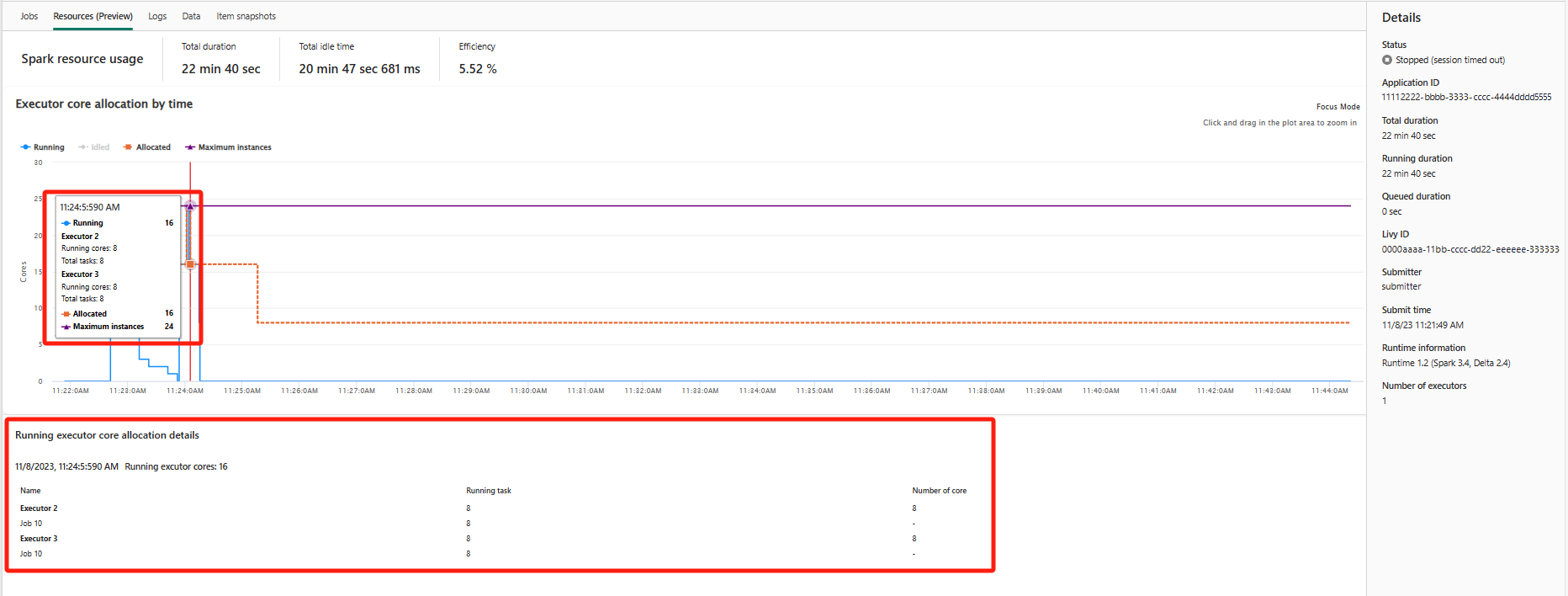

Wykres wykorzystania zasobów jest interaktywny. Po najechaniu wskaźnikiem myszy na wykres działających rdzeni wykonawczych zostanie wyświetlone podsumowanie rdzeni oraz odpowiednie informacje o wykonawcach. Kliknięcie punktu w linii rdzenia wykonawczego spowoduje wyświetlenie szczegółowych informacji o odpowiednim wykonawcy i zadaniu w danym momencie, widocznych w dolnej części wykresu.

Notatka

W niektórych przypadkach, w określonych momentach, liczba zadań może przekroczyć pojemność rdzeni wykonawczych (tj. liczba zadań > całkowite rdzenie wykonawcze / spark.task.cpus). Jest to oczekiwane, ponieważ może istnieć luka czasowa między zadaniem oznaczonym jako uruchomione a rzeczywistym wykonaniem na rdzeniu funkcji wykonawczej. W związku z tym niektóre zadania mogą być wyświetlane jako uruchomione, ale nie są aktywnie uruchomione na żadnym rdzeniu.

Powiązana zawartość

Aby uzyskać przegląd monitorowania Fabric Spark, monitorowania aplikacji Spark i monitorowania kontekstowego notesu, możesz odnieść się do: