Przeglądaj aplikacje Apache Spark w Monitorze Fabric

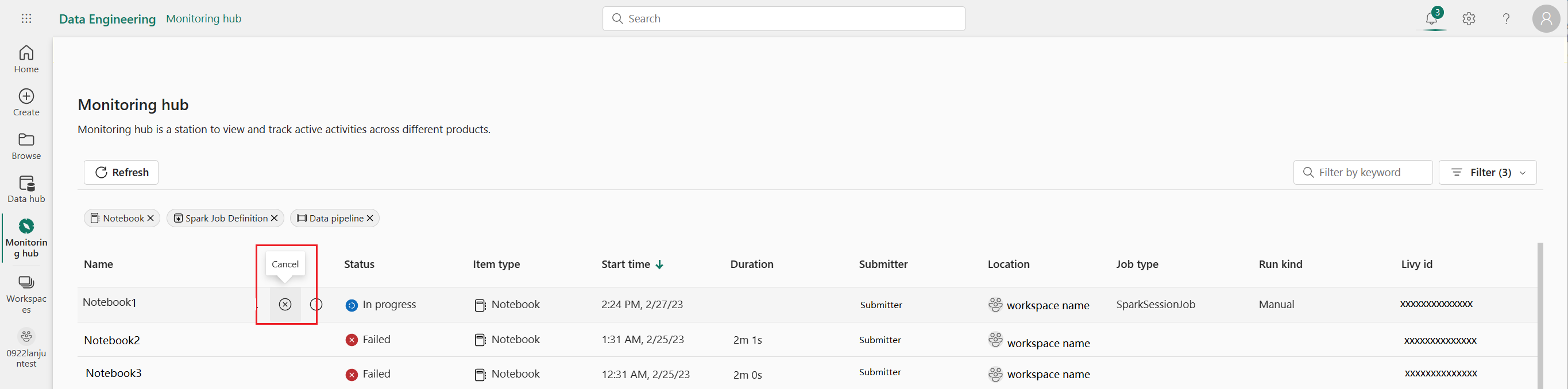

Okienko Monitorowanie służy jako scentralizowany portal do przeglądania działań platformy Apache Spark między elementami. W przypadku pracy z inżynierią danych lub nauką o danych możesz wyświetlać w toku aplikacje platformy Apache Spark wyzwalane z notesów, definicji zadań platformy Apache Spark i potoków. Możesz również wyszukiwać i filtrować aplikacje platformy Apache Spark na podstawie różnych kryteriów. Ponadto możesz anulować aplikacje Apache Spark w toku i zagłębić się w szczegóły, aby uzyskać więcej informacji o wykonaniu aplikacji Apache Spark.

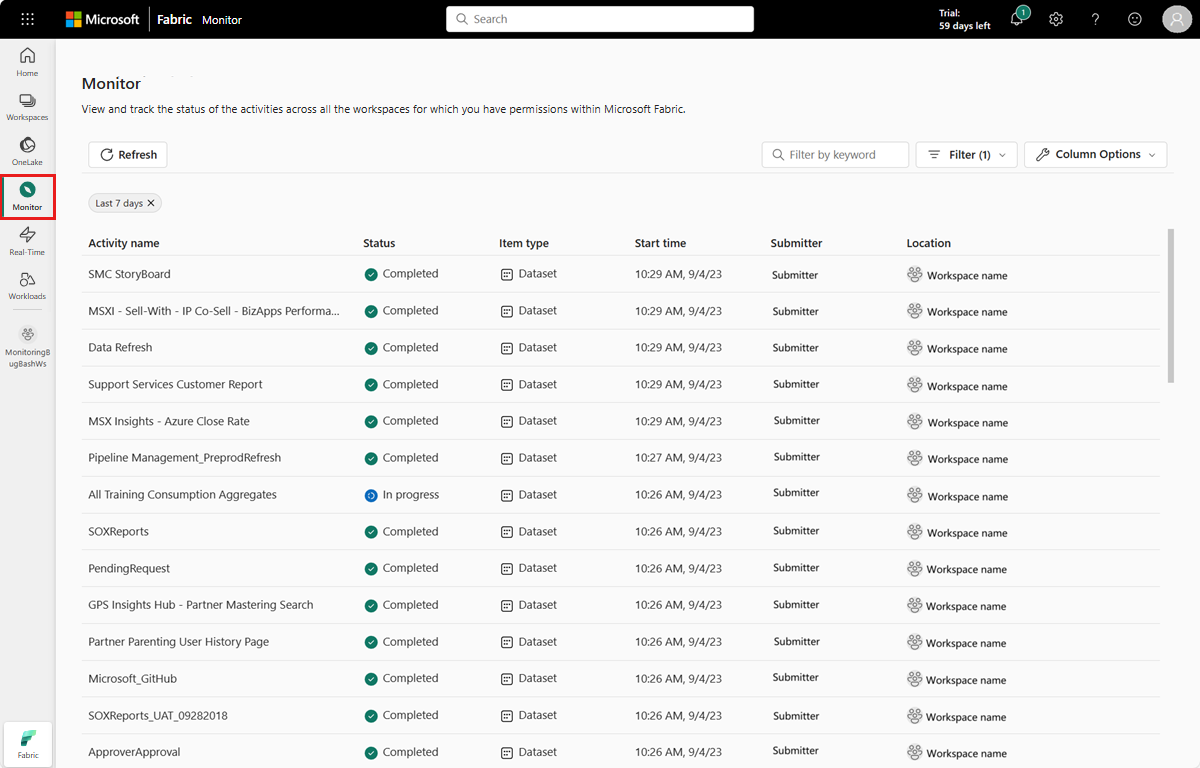

Otwórz okienko Monitor

Aby wyświetlić różne działania platformy Apache Spark, możesz uzyskać dostęp do okienka Monitor, wybierając pozycję Monitor na pasku nawigacyjnym.

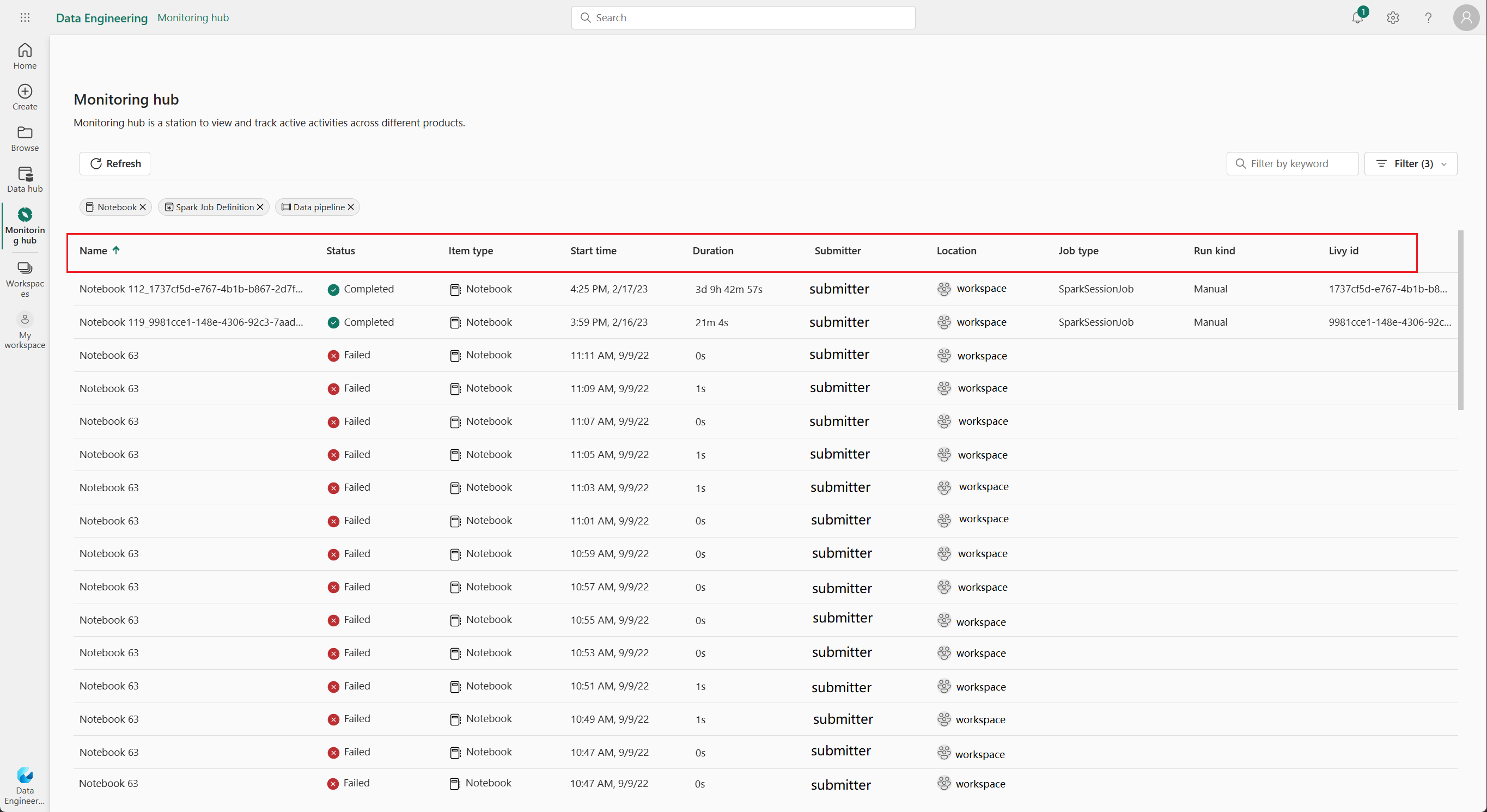

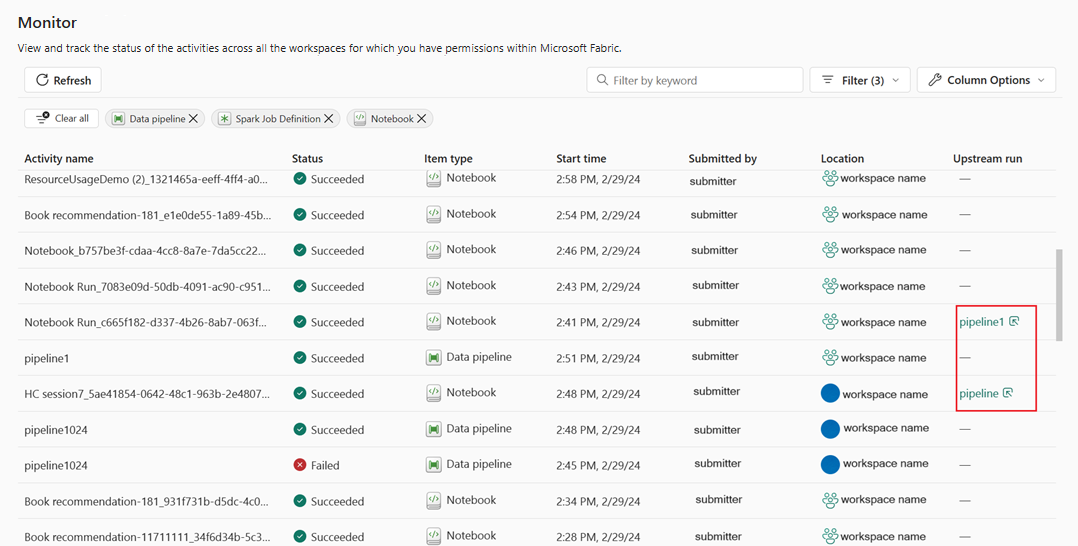

Opcje sortowania, wyszukiwania, filtrowania i kolumn platformy Apache Spark

Aby uzyskać lepszą użyteczność i możliwość odnajdywania, możesz sortować aplikacje platformy Apache Spark, wybierając różne kolumny w interfejsie użytkownika. Możesz również filtrować aplikacje na podstawie różnych kolumn i wyszukiwać określone aplikacje. Można również dostosować wyświetlanie i kolejność sortowania kolumn niezależnie za pomocą opcji kolumny.

Sortowanie aplikacji platformy Apache Spark

Aby posortować aplikacje platformy Apache Spark, możesz wybrać każdy nagłówek kolumny, na przykład Nazwa, Stan, Typ Elementu, Godzina Rozpoczęcia, Lokalizacja, itd.

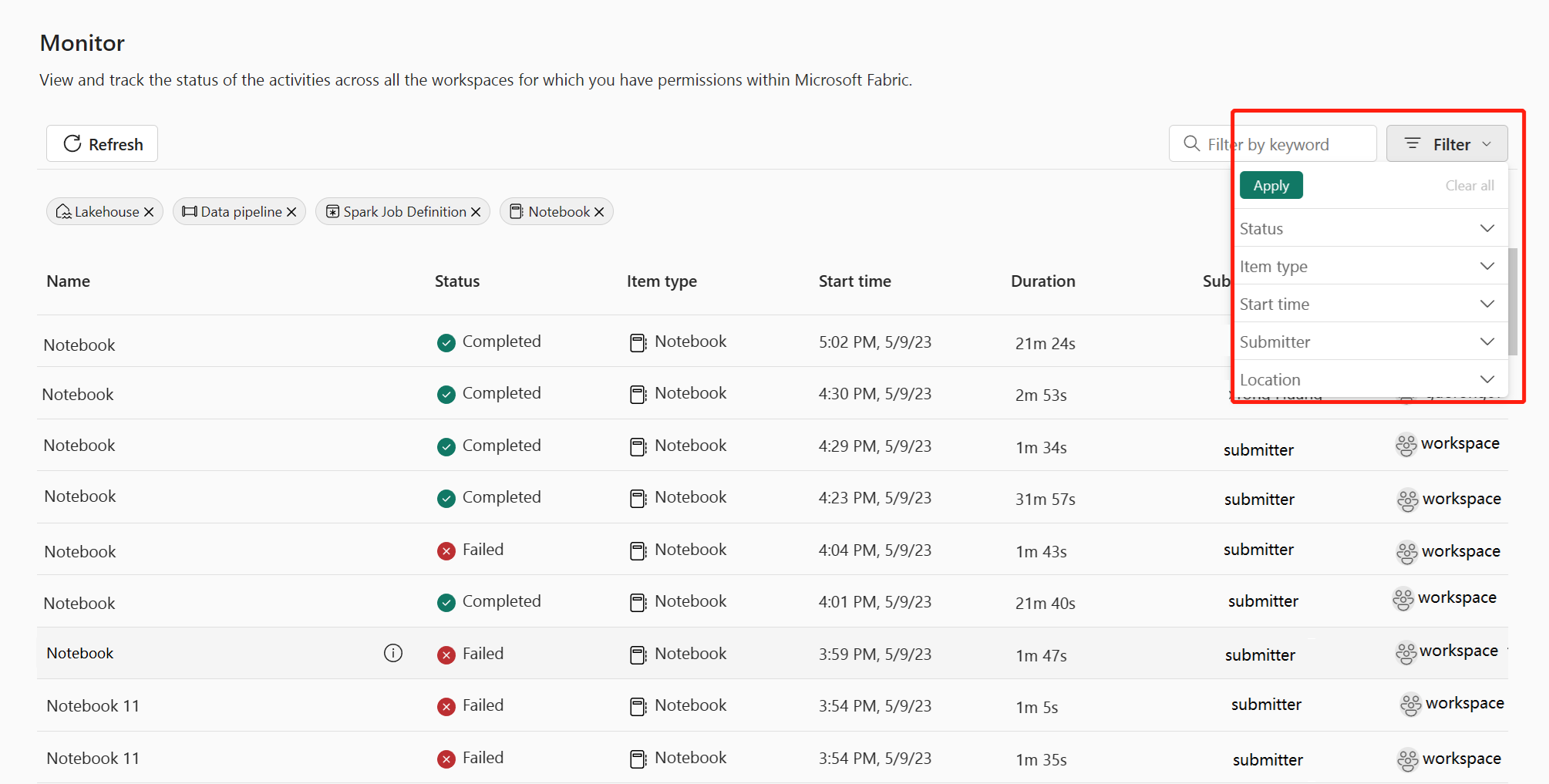

Filtrowanie aplikacji platformy Apache Spark

Aplikacje platformy Apache Spark można filtrować według Status, Typ Elementu, Godzina Rozpoczęcia, Nadawcai Lokalizacja przy użyciu panelu filtrów w prawym górnym rogu.

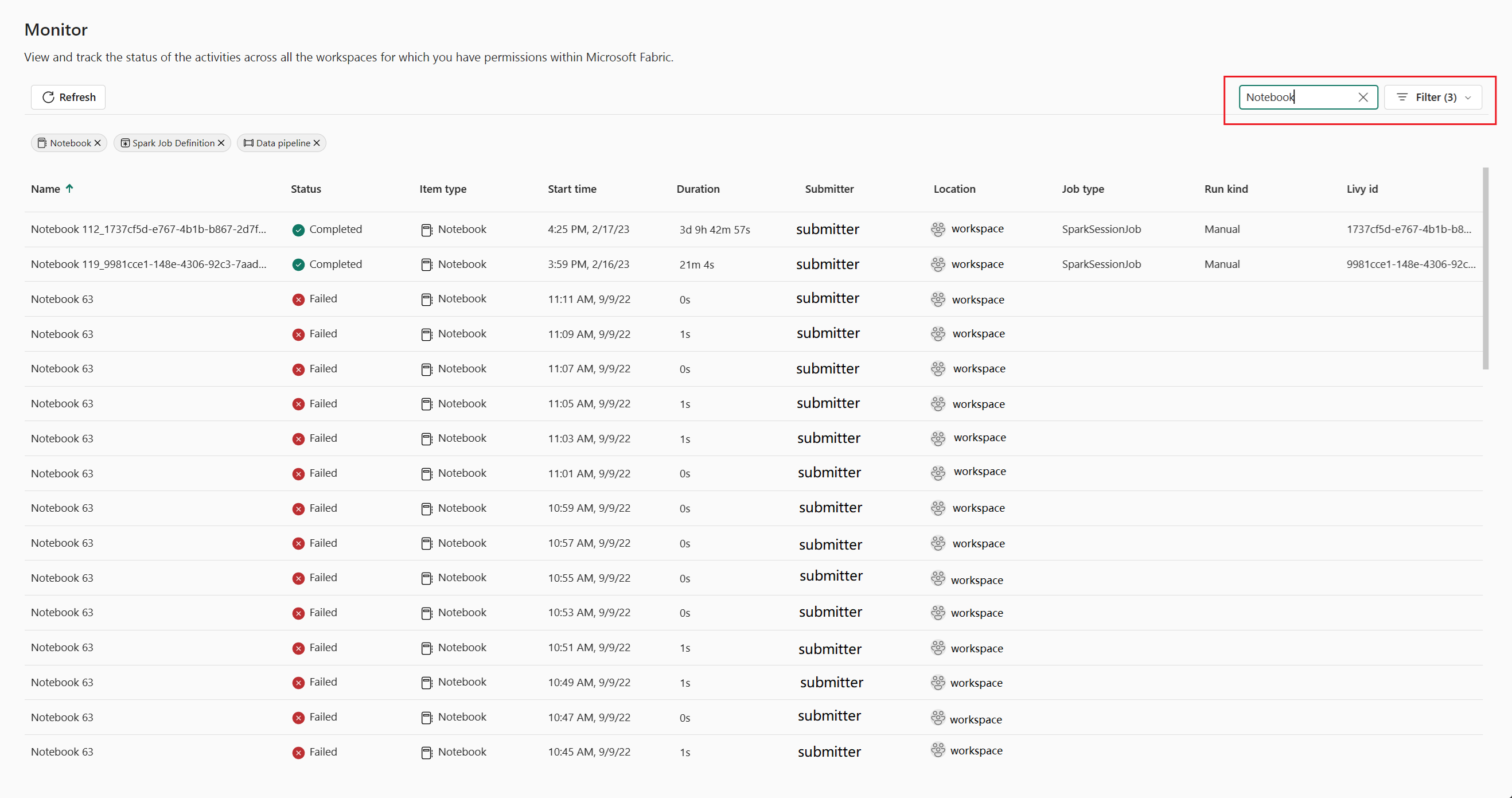

Wyszukiwanie aplikacji platformy Apache Spark

Aby wyszukać określone aplikacje platformy Apache Spark, możesz wprowadzić określone słowa kluczowe w polu wyszukiwania znajdującym się w prawym górnym rogu.

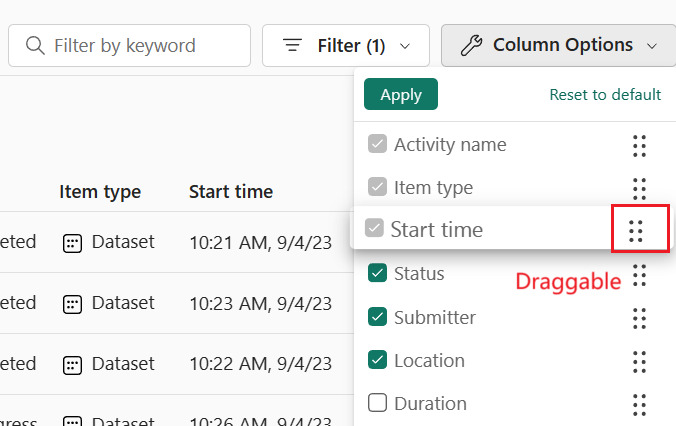

Opcje kolumn aplikacji platformy Apache Spark

Kolejność wyświetlania list można zmienić, wybierając listę, którą chcesz wyświetlić, a następnie przeciągając opcje listy.

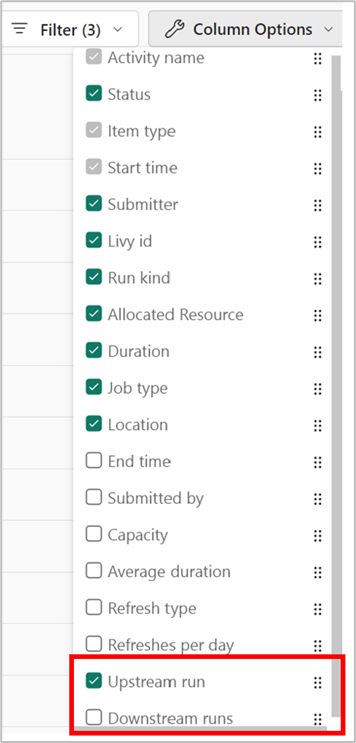

Włącz widok upstream dla powiązanych potoków

Jeśli zaplanowałeś uruchomienie definicji notebooków i zadań Spark w potokach, możesz wyświetlić czynności Spark z tych notebooków i definicji zadań w okienku Monitorowanie. Ponadto można wyświetlić odpowiedni potok nadrzędny i wszystkie jego działania w okienku Monitorowanie.

Wybierz opcję kolumny Upstream.

Wyświetl powiązane uruchomienie nadrzędnego potoku w kolumnie przebiegu nadrzędnego , a następnie kliknij przebieg potoku, aby wyświetlić wszystkie jego działania.

Zarządzanie aplikacją platformy Apache Spark

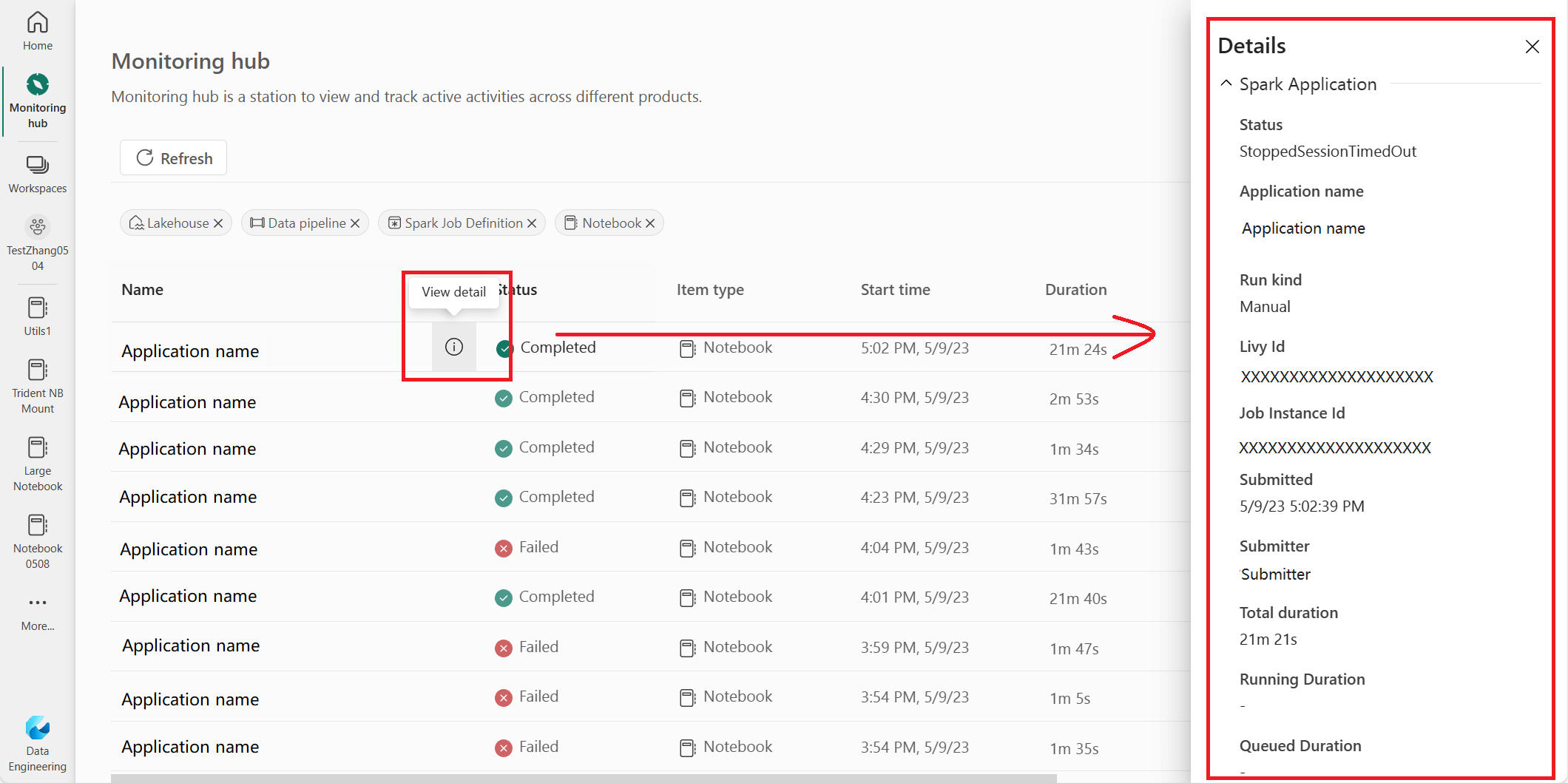

Po umieszczeniu wskaźnika myszy na wierszu aplikacji platformy Apache Spark można zobaczyć różne akcje na poziomie wiersza, które umożliwiają zarządzanie określoną aplikacją platformy Apache Spark.

Wyświetlanie okienka szczegółów aplikacji platformy Apache Spark

Możesz najechać kursorem na wiersz aplikacji Apache Spark i kliknąć ikonę Wyświetl szczegóły, aby otworzyć okienko szczegółów i wyświetlić więcej informacji o aplikacji Apache Spark.

Anulowanie aplikacji platformy Apache Spark

Jeśli musisz anulować aplikację platformy Apache Spark w toku, najedź kursorem na jej wiersz i kliknij ikonę Anuluj .

Przejdź do widoku szczegółów aplikacji platformy Apache Spark

Jeśli potrzebujesz więcej informacji na temat statystyk wykonywania platformy Apache Spark, uzyskiwania dostępu do dzienników platformy Apache Spark lub sprawdzania danych wejściowych i wyjściowych, możesz kliknąć nazwę aplikacji Apache Spark, aby przejść do odpowiedniej strony szczegółów aplikacji platformy Apache Spark.