Zaufanie i bezpieczeństwo usługi DatabricksIQ

Usługa Databricks rozumie znaczenie Twoich danych i zaufanie, które umieszczasz w nas podczas korzystania z naszej platformy i funkcji opartych na usłudze DatabricksIQ. Usługa Databricks jest zobowiązana do najwyższych standardów ochrony danych i wdrożyła rygorystyczne środki w celu zapewnienia, że informacje przesyłane do funkcji opartych na usłudze DatabricksIQ są chronione.

-

Dane pozostają poufne.

- Databricks nie szkoli generatywnych modeli bazowych na danych przesyłanych przez ciebie do tych funkcji i nie używa tych danych do generowania sugestii wyświetlanych innym klientom.

- Nasi partnerzy modelu nie zachowują danych przesyłanych za pośrednictwem tych funkcji, nawet w przypadku monitorowania nadużyć. Nasze funkcje pomocnicze sztucznej inteligencji oparte na partnerach korzystają z punktów końcowych zerowego przechowywania danych od naszych partnerów modelowych.

- Ochrona przed szkodliwymi danymi wyjściowymi. Usługa Databricks używa również filtrowania zawartości usługi Azure OpenAI, aby chronić użytkowników przed szkodliwą zawartością. Ponadto usługa Databricks przeprowadziła obszerną ocenę z tysiącami symulowanych interakcji użytkowników, aby zapewnić skuteczne stosowanie ochrony przed szkodliwą zawartością, jailbreakami, niezabezpieczonym generowaniem kodu i korzystaniem z zawartości praw autorskich innych firm.

- Usługa Databricks używa tylko danych niezbędnych do świadczenia usługi. Dane są wysyłane tylko w przypadku interakcji z funkcjami opartymi na usłudze DatabricksIQ. Usługa Databricks wysyła monit, odpowiednie metadane i wartości tabeli, błędy, a także kod wejściowy lub zapytania, aby pomóc w zwracaniu bardziej odpowiednich wyników. Usługa Databricks nie wysyła innych danych na poziomie wiersza do modeli innych firm.

- Dane są chronione podczas przesyłania. Cały ruch między usługą Databricks a partnerami modelu jest szyfrowany w trakcie przesyłania zgodnie z branżowym standardem szyfrowania TLS.

- Databricks oferuje mechanizmy kontroli nad lokalizacją przechowywania danych. Funkcje obsługiwane przez usługę DatabricksIQ są wyznaczonymi usługami i są zgodne z granicami rezydencji danych. Aby uzyskać więcej informacji, zobacz Databricks Geos: Data residency i Databricks Designated Services.

Aby uzyskać więcej informacji na temat prywatności w programie Databricks Assistant, zobacz Prywatność i zabezpieczenia.

Funkcje zarządzane przez ustawienie asystujących funkcji AI zasilanych przez partnerów

Sztuczna inteligencja oparta na partnerach odnosi się do usługi Azure OpenAI. Poniżej przedstawiono podział funkcji zarządzanych przez ustawienie funkcji pomocniczych sztucznej inteligencji opartej na partnerach:

| Funkcja | Gdzie jest hostowany model? | Kontrolowane przez ustawienie sztucznej inteligencji obsługiwanej przez partnerów? |

|---|---|---|

| Czat asystenta usługi Databricks | Azure OpenAI Service | Tak |

| Szybka poprawka | Azure OpenAI Service | Tak |

| Komentarze interfejsu użytkownika wygenerowane przez sztuczną inteligencję | Obszary robocze profilu zabezpieczeń zgodności (CSP): Usługa Azure OpenAI | Tak, dla wszystkich obszarów roboczych CSP. |

| Pulpit nawigacyjny AI/BI, wizualizacje wspomagane AI i towarzyszące przestrzenie Genie | Azure OpenAI Service | Tak |

| Dżin | Azure OpenAI Service | Tak |

| Asystent wbudowany usługi Databricks | Azure OpenAI Service | Tak |

| Automatyczne uzupełnianie asystenta usługi Databricks | Model hostowany w usłudze Databricks | Nie. |

| Wyszukiwanie inteligentne | Azure OpenAI Service | Tak |

Używanie modelu hostowanego w usłudze Databricks

Ważny

Ta funkcja jest dostępna w publicznej wersji zapoznawczej.

Dowiedz się więcej na temat używania modelu hostowanego przez usługę DatabricksIQ do zasilania funkcji DatabricksIQ, które w przeciwnym razie byłyby obsługiwane przez usługę Azure OpenAI. W tej sekcji wyjaśniono, jak to działa.

Jak to działa

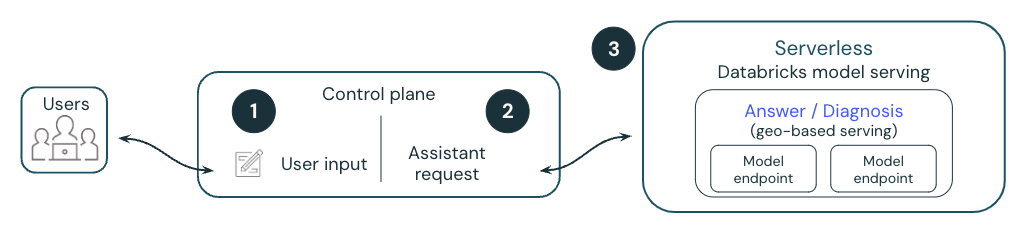

Na poniższym diagramie przedstawiono omówienie sposobu, w jaki model hostowany w usłudze DatabricksIQ obsługuje funkcje databricksIQ, takie jak szybka poprawka.

- Użytkownik wykonuje komórkę, co powoduje wystąpienie błędu.

- Usługa Databricks dołącza metadane do żądania i wysyła je do modelu dużego języka hostowanego w usłudze Databricks (LLM). Wszystkie dane są szyfrowane w stanie spoczynku. Klienci mogą używać klucza zarządzanego przez klienta (CMK).

- Model hostowany w usłudze Databricks reaguje na sugerowane zmiany kodu w celu naprawienia błędu wyświetlanego użytkownikowi.

Ta funkcja jest dostępna w publicznej wersji zapoznawczej i może ulec zmianie. Skontaktuj się z przedstawicielem, aby zapytać, które funkcje usługi DatabricksIQ mogą być obsługiwane przez model hostowany w usłudze Databricks.

Modele hostowane w usłudze Databricks

Gdy funkcje usługi DatabricksIQ korzystają z modeli hostowanych w usłudze Databricks, używają meta llama 3 lub innych modeli, które są również dostępne do użytku komercyjnego. Meta Llama 3 jest licencjonowany na platformie Meta Llama 3 Community License, Copyright © Meta Platforms, Inc. Wszelkie prawa zastrzeżone.

Często zadawane pytania dotyczące modeli hostowanych w usłudze Databricks dla Asystenta

Czy mogę mieć własną instancję serwującą prywatny model?

Nie w tej chwili. Ta wersja zapoznawcza używa punktów końcowych modelu , które są zarządzane i zabezpieczone przez Databricks. Punkty końcowe obsługujące modele są bezstanowe, chronione przez wiele warstw izolacji oraz implementują następujące mechanizmy kontroli zabezpieczeń w celu ochrony twoich danych:

- Każde żądanie klienta do obsługi modelu jest logicznie izolowane, uwierzytelniane i autoryzowane.

- Usługa mozaikowego modelu sztucznej inteligencji szyfruje wszystkie dane magazynowane (AES-256) i podczas przesyłania (TLS 1.2+).

Czy metadane wysyłane do modeli respektują uprawnienia użytkownika w Unity Catalog?

Tak, wszystkie dane wysyłane do modelu są zgodne z uprawnieniami katalogu Unity użytkownika. Na przykład nie wysyła metadanych odnoszących się do tabel, do których użytkownik nie ma uprawnień do wyświetlania.

Gdzie są przechowywane dane?

Historia czatów asystenta usługi Databricks jest przechowywana w bazie danych płaszczyzny sterowania wraz z notesem. Baza danych płaszczyzny sterowania to szyfrowanie AES-256-bitowe, a klienci, którzy wymagają kontroli nad kluczem szyfrowania, mogą korzystać z naszej funkcji klucza Customer-Managed.

Notatka

- Podobnie jak w przypadku innych obiektów obszaru roboczego okres przechowywania historii czatów asystenta usługi Databricks jest w zakresie cyklu życia samego obiektu. Jeśli użytkownik usunie notes, zostanie on usunięty i dowolna skojarzona historia czatu zostanie usunięta w ciągu 30 dni.

- Jeśli notes zostanie wyeksportowany, historia czatu nie zostanie wyeksportowana.

- Historie czatów w notatnikach i zapytań nie są dostępne ani dla innych użytkowników, ani dla administratorów, nawet jeśli zapytanie lub notatnik są udostępniane.

Czy mogę wprowadzić własny klucz interfejsu API dla mojego modelu lub hostować własne modele?

Nie w tej chwili. Asystent usługi Databricks jest w pełni zarządzany i hostowany przez usługę Databricks. Funkcje asystenta są w dużym stopniu zależne od funkcji obsługujących model (na przykład wywoływania funkcji), wydajności i jakości. Usługa Databricks stale ocenia nowe modele pod kątem najlepszej wydajności i może zaktualizować model w przyszłych wersjach tej funkcji.

Kto jest właścicielem danych wyjściowych? Jeśli Asystent generuje kod, kto jest właścicielem tego adresu IP?

Klient jest właścicielem swoich wyników.

Rezygnacja z korzystania z modeli hostowanych w usłudze Databricks

Aby zrezygnować z korzystania z modeli hostowanych w usłudze Databricks:

- Kliknij swoją nazwę użytkownika na górnym pasku obszaru roboczego usługi Databricks.

- Z menu wybierz pozycję Podglądy.

- Wyłącz Use Assistant z modelami hostowanymi w usłudze Databricks.

Aby dowiedzieć się więcej na temat zarządzania wersjami zapoznawczami, zobacz Manage Azure Databricks Previews (Zarządzanie wersjami zapoznawczami usługi Azure Databricks).