Monitoruj obsługiwane modele używając tabel inferencji obsługiwanych przez AI Gateway

Ważny

Ta funkcja jest dostępna w publicznej wersji zapoznawczej.

Ważny

W tym artykule opisano tematy dotyczące tabel inferencyjnych dla modeli zewnętrznych lub obciążeń związanych z aprowizowaną przepustowością. W przypadku modeli niestandardowych , zobacz tabele inferencji dotyczące monitorowania i debugowania modeli.

W tym artykule opisano tabele dotyczące wnioskowania obsługiwane przez bramę AI na potrzeby monitorowania obsługiwanych modeli. Tabela wnioskowania automatycznie przechwytuje przychodzące żądania i wychodzące odpowiedzi dla konkretnego punktu końcowego i rejestruje je jako tabelę Delta katalogu Unity. Dane w tej tabeli umożliwiają monitorowanie, ocenianie, porównywanie i dostosowywanie modeli uczenia maszynowego.

Czym są tabele wnioskowania z obsługą gateway sztucznej inteligencji?

Tabele inferencji obsługiwane przez bramę AI upraszczają monitorowanie i diagnostykę modeli przez ciągłe rejestrowanie danych wejściowych żądań i odpowiedzi (przewidywania) z punktów końcowych Mosaic AI Model Serving i zapisywanie ich w tabeli Delta w katalogu Unity Catalog. Następnie możesz użyć wszystkich możliwości platformy Databricks, takich jak zapytania SQL usługi Databricks i notesy, aby monitorować, debugować i optymalizować modele.

Możesz włączyć tabele inferencyjne dla istniejącego lub nowo utworzonego punktu końcowego obsługującego model, a żądania do tego punktu końcowego są następnie automatycznie rejestrowane w tabeli w katalogu Unity.

Niektóre typowe aplikacje dla tabel wnioskowania są następujące:

- Utwórz korpus treningowy. Łącząc tabele wnioskowania z etykietami podstawowych prawd, można utworzyć korpus treningowy, którego można użyć do ponownego trenowania lub dostosowywania i ulepszania modelu. Za pomocą zadań usługi Databricks można skonfigurować pętlę zwrotną i zautomatyzować ponowne uczenie.

- Monitorowanie jakości danych i modelu. Możesz stale monitorować wydajność modelu i dryf danych za pomocą monitoringu Lakehouse. Monitorowanie w Lakehouse automatycznie generuje pulpity nawigacyjne dotyczące jakości danych i modelu, które można udostępniać interesariuszom. Ponadto możesz włączyć alerty, aby wiedzieć, kiedy trzeba ponownie trenować model na podstawie zmian danych przychodzących lub zmniejszenia wydajności modelu.

- Debugowanie problemów z produkcją. Logi tabel inferencji zawierają dane takie jak kody stanu HTTP, kod JSON żądania i odpowiedzi, czasy uruchamiania modelu oraz ślady danych wyjściowych generowane podczas wykonywania modelu. Te dane wydajności można używać do celów debugowania. Możesz również użyć danych historycznych w tabelach wnioskowania, aby porównać wydajność modelu z żądaniami historycznymi.

Wymagania

Tabele wnioskowania z obsługą bramy sztucznej inteligencji są obsługiwane tylko w przypadku punktów końcowych, które używają aprowizowanej przepływności lub obsługują modele zewnętrzne .

Obszar roboczy Databricks w jednym z:

W przypadku obszarów roboczych, które mają prywatną łączność skonfigurowaną na koncie magazynowym Unity Catalog, wykonaj kroki opisane w Konfigurowanie prywatnej łączności z bezserwerowego przetwarzania.

Databricks zaleca włączenie optymalizacji predykcyjnej w celu zoptymalizowania wydajności tabel wnioskowania.

Obszar roboczy musi mieć włączony Unity Catalog.

Zarówno twórca punktu końcowego, jak i modyfikator muszą mieć uprawnienia Zarządzanie na punkcie końcowym. Zobacz listy kontroli dostępu.

Zarówno twórca punktu końcowego, jak i modyfikator muszą mieć następujące uprawnienia w katalogu Unity.

-

USE CATALOGuprawnienia do określonego katalogu. -

USE SCHEMAuprawnienia do określonego schematu. -

CREATE TABLEuprawnienia w schemacie.

-

Ostrzeżenie

Tabela wnioskowania może zatrzymać rejestrowanie danych lub zostać uszkodzona, jeśli wykonasz dowolną z następujących czynności:

- Zmień schemat tabeli.

- Zmień nazwę tabeli.

- Usuń tabelę.

- Utracić uprawnienia do katalogu Unity Catalog lub schematu.

Włączanie i wyłączanie tabel wnioskowania

W tej sekcji pokazano, jak włączyć lub wyłączyć tabele wnioskowania przy użyciu interfejsu użytkownika obsługującego. Właścicielem tabel wnioskowania jest użytkownik, który utworzył punkt końcowy. Wszystkie listy kontroli dostępu (ACL) w tabeli są zgodne ze standardowymi uprawnieniami Unity Catalog i mogą być modyfikowane przez właściciela tabeli.

Aby włączyć tabele wnioskowania podczas tworzenia punktu końcowego, wykonaj następujące kroki:

- Kliknij Serving w interfejsie użytkownika Databricks Mosaic AI.

- Kliknij pozycję Utwórz punkt końcowy obsługi.

- W sekcji Brama sztucznej inteligencji wybierz pozycję Włącz tabele wnioskowania.

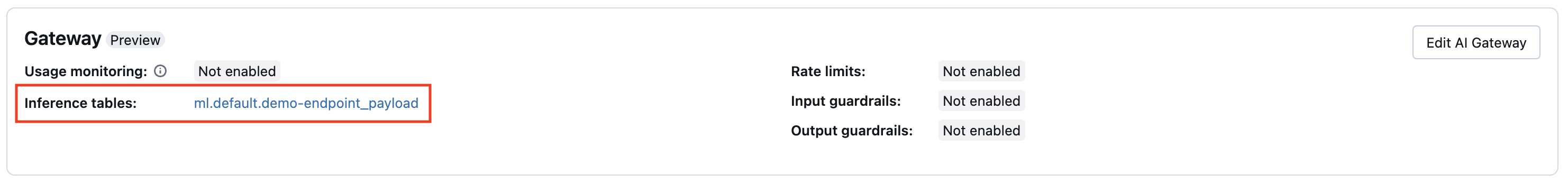

Tabele wnioskowania można również włączyć w istniejącym punkcie końcowym. Aby edytować istniejącą konfigurację punktu końcowego, wykonaj następujące czynności:

- W sekcji Brama AI kliknij pozycję Edytuj bramę AI.

- Wybierz pozycję Włącz tabele wnioskowania.

Postępuj zgodnie z tymi instrukcjami, aby wyłączyć tabele wnioskowania:

- Przejdź do strony punktu końcowego.

- Kliknij , aby edytować bramę AI.

- Kliknij Włącz tabelę wnioskowania, aby usunąć znacznik wyboru.

- Po spełnieniu wymagań dotyczących specyfikacji bramy sztucznej inteligencji kliknij pozycję Update.

Wykonywanie zapytań i analizowanie wyników w tabeli wnioskowania

Po dokonaniu gotowości obsługiwanych modeli wszystkie żądania wysyłane do modeli są rejestrowane automatycznie w tabeli wnioskowania wraz z odpowiedziami. Tabelę można wyświetlić w interfejsie użytkownika, wykonać zapytanie względem tabeli z bazy danych SQL usługi Databricks lub notesu albo wykonać zapytanie względem tabeli przy użyciu interfejsu API REST.

Aby wyświetlić tabelę w interfejsie użytkownika: Na stronie punktu końcowego kliknij nazwę tabeli wnioskowania, aby otworzyć tabelę w Eksploratorze wykazu.

Aby wykonać zapytanie dotyczące tabeli z poziomu usługi Databricks SQL lub notesu usługi Databricks: Możesz uruchomić kod podobny do poniższego, aby wykonać zapytanie w tabeli wnioskowania.

SELECT * FROM <catalog>.<schema>.<payload_table>

** Aby połączyć dane tabeli wnioskowania ze szczegółowymi informacjami na temat modelu bazowego obsługiwanego w punkcie końcowym:** Szczegóły modelu bazowego są przechwytywane w tabeli systemu system.serving.served_entities.

SELECT * FROM <catalog>.<schema>.<payload_table> payload

JOIN system.serving.served_entities se on payload.served_entity_id = se.served_entity_id

schemat tabeli wnioskowania z obsługą bramy sztucznej inteligencji

Tabele wnioskowania, dostępne za pośrednictwem portalu sztucznej inteligencji, mają następujący schemat:

| Nazwa kolumny | Opis | Typ |

|---|---|---|

request_date |

Data UTC, w której odebrano żądanie obsługi modelu. | DATA |

databricks_request_id |

Identyfikator wygenerowany przez Azure Databricks, dołączany do wszystkich żądań obsługi modeli. | STRUNA |

request_time |

Sygnatura czasowa, w której żądanie zostanie odebrane. | ZNAK CZASOWY |

status_code |

Kod stanu HTTP zwrócony z modelu. | INT |

sampling_fraction |

Ułamek próbkowania używany w przypadku, gdy żądanie zostało zredukowane. Ta wartość wynosi od 0 do 1, gdzie 1 oznacza, że uwzględniono 100% żądań przychodzących. | PODWÓJNY |

execution_duration_ms |

Czas w milisekundach, dla których model wykonał wnioskowanie. Nie obejmuje to ogólnych opóźnień sieciowych i odzwierciedla tylko czas, jaki zajęło modelowi generowanie prognoz. | BIGINT |

request |

Treść nieprzetworzonego żądania JSON, która została wysłana do punktu końcowego obsługującego model. | STRUNA |

response |

Treść nieprzetworzonej odpowiedzi JSON zwrócona przez punkt końcowy obsługujący model. | STRUNA |

served_entity_id |

Unikatowy identyfikator obsługiwanej jednostki. | STRUNA |

logging_error_codes |

Błędy, które wystąpiły, gdy nie można zarejestrować danych. Kody błędów obejmują MAX_REQUEST_SIZE_EXCEEDED i MAX_RESPONSE_SIZE_EXCEEDED. |

TABLICA |

requester |

Identyfikator użytkownika lub jednostki usługi, którego uprawnienia są wykorzystywane do żądania wywołania usługi na punkcie końcowym. | STRUNA |

Ograniczenia

Przydzielona przepustowość obciążeń:

- Jeśli tworzysz nowy punkt końcowy obsługi modelu wykorzystujący aprowizowaną przepustowość, obsługiwane są tylko tabele wnioskowania obsługiwane przez AI Gateway.

- Jeśli masz istniejący model obsługujący punkt końcowy korzystający z aprowizowanej przepływności i nigdy nie miał wcześniej skonfigurowanych tabel wnioskowania, możesz zaktualizować go, aby używać tabel wnioskowania z obsługą bramy sztucznej inteligencji.

- Jeśli masz istniejący model obsługujący punkt końcowy korzystający z aprowizowanej przepływności i ma tabele wnioskowania obecnie lub wcześniej skonfigurowane, możesz nie zaktualizować go do używania tabel wnioskowania z obsługą bramy sztucznej inteligencji.

Dostarczanie dzienników tabel wnioskowania jest obecnie najlepszym rozwiązaniem, ale można oczekiwać, że dzienniki będą dostępne w ciągu 1 godziny od żądania. Skontaktuj się z zespołem kont usługi Databricks, aby uzyskać więcej informacji.

Maksymalny rejestrowany rozmiar żądania i odpowiedzi to 1 MiB (1 048 576 bajtów). Ładunki żądań i odpowiedzi, które to przekraczają, są rejestrowane, a

nullilogging_error_codessą wypełniane wartościamiMAX_REQUEST_SIZE_EXCEEDEDlubMAX_RESPONSE_SIZE_EXCEEDED.

Aby zapoznać się z ograniczeniami dotyczącymi bramy AI, zobacz Ograniczenia. Aby uzyskać ogólne ograniczenia dotyczące obsługi punktów końcowych modeli, zobacz Limity obsługi modeli i regiony.