Jakość danych

Jakość danych to funkcja zarządzania analizą w skali chmury. Znajduje się ona w strefie docelowej zarządzania danymi i jest główną częścią ładu.

Zagadnienia dotyczące jakości danych

Jakość danych to odpowiedzialność każdej osoby, która tworzy i zużywa produkty danych. Twórcy powinni przestrzegać reguł globalnych i domen, podczas gdy konsumenci powinni zgłaszać niespójności danych do domeny danych właścicieli za pośrednictwem pętli opinii.

Ponieważ jakość danych ma wpływ na wszystkie dane dostarczone do tablicy, powinna zaczynać się od góry organizacji. Zarząd powinien mieć wgląd w jakość danych im dostarczanych.

Jednak proaktywne nadal wymaga posiadania ekspertów w zakresie jakości danych, którzy mogą czyścić zasobniki danych, które wymagają korygowania. Unikaj przekazywania tej pracy centralnemu zespołowi i zamiast tego skup się na domenie danych z określoną wiedzą specjalistyczną, aby oczyścić dane.

Metryki jakości danych

Metryki jakości danych są kluczem do oceny i zwiększenia jakości produktów danych. Na poziomie globalnym i domeny należy zdecydować o metrykach jakości. Zalecamy co najmniej następujące metryki:

| Metryki | Definicje metryk |

|---|---|

| Kompletność = % sumy wartości innych niż null + niepuste | Mierzy dostępność danych, pola w zestawie danych, które nie są puste, i wartości domyślne, które zostały zmienione. Jeśli na przykład rekord zawiera 01/01/1900 jako datę urodzenia, prawdopodobnie pole nigdy nie zostało wypełnione. |

| Unikatowość = % wartości nieduplikowanych | Mierzy unikatowe wartości w danej kolumnie w porównaniu z liczbą wierszy w tabeli. Na przykład przy użyciu czterech unikatowych wartości kolorów (czerwony, niebieski, żółty i zielony) w tabeli z pięcioma wierszami pole to 80% (lub 4/5). |

| Spójność = % danych mających wzorce | Mierzy zgodność w danej kolumnie z oczekiwanym typem lub formatem danych. Na przykład pole poczty e-mail zawierające sformatowane adresy e-mail lub pole nazwy z wartościami liczbowymi. |

| Ważność = % dopasowania referencji | Mierzy pomyślne dopasowanie danych do zestawu odwołań do domeny. Na przykład, biorąc pod uwagę pole kraju/regionu (zgodne z wartościami taksonomii) w systemie rekordów transakcyjnych, wartość "US of A" nie jest prawidłowa. |

| Dokładność = % wartości niezachwianych | Mierzy pomyślne odtworzenie zamierzonych wartości w wielu systemach. Jeśli na przykład faktura zrówna jednostkę SKU i cena rozszerzona różnią się od oryginalnego zamówienia, element wiersza faktury jest niedokładny. |

| Łączenie = % dobrze zintegrowanych danych | Mierzy pomyślne skojarzenie ze szczegółami referencyjnymi towarzyszącymi w innym systemie. Jeśli na przykład faktura zawiera niepoprawny opis jednostki SKU lub produktu, element wiersza faktury nie jest możliwy do połączenia. |

Profilowanie danych

Profilowanie danych analizuje produkty danych zarejestrowane w wykazie danych i zbiera statystyki i informacje o tych danych. Aby udostępnić podsumowanie i widoki trendów dotyczące jakości danych w czasie, zapisz te dane w repozytorium metadanych względem produktu danych.

Profile danych ułatwiają użytkownikom odpowiadanie na pytania dotyczące produktów danych, w tym:

- Czy można go użyć do rozwiązania mojego problemu biznesowego?

- Czy dane są zgodne z określonymi standardami lub wzorcami?

- Jakie są niektóre anomalie źródła danych?

- Jakie są możliwe wyzwania związane z integracją tych danych z moją aplikacją?

Użytkownicy mogą wyświetlać profil produktu danych przy użyciu pulpitu nawigacyjnego raportowania na platformie handlowej danych.

Możesz zgłaszać takie elementy jak:

- Kompletność: wskazuje procent danych, które nie są puste lub mają wartość null.

- Unikatowość: wskazuje procent danych, które nie są zduplikowane.

- Spójność: wskazuje dane, w których jest utrzymywana integralność danych.

Zalecenia dotyczące jakości danych

Aby zaimplementować jakość danych, należy użyć zarówno mocy ludzkiej, jak i obliczeniowej w następujący sposób:

Użyj rozwiązań, które obejmują algorytmy, reguły, profilowanie danych i metryki.

Skorzystaj z ekspertów z dziedziny, którzy mogą wejść w krok, gdy istnieje wymóg wytrenowania algorytmu z powodu dużej liczby błędów przechodzących przez warstwę obliczeniową.

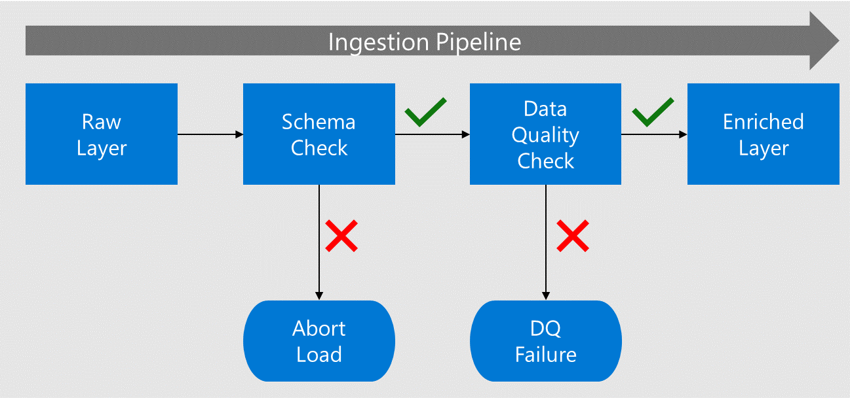

Zweryfikuj wcześnie. Tradycyjne rozwiązania stosują kontrole jakości danych po wyodrębnieniu, przekształceniu i załadowaniu danych. W tym czasie produkt danych jest już używany, a błędy są udostępniane produktom danych podrzędnych. Zamiast tego, ponieważ dane są pozyskiwane ze źródła, zaimplementuj kontrole jakości danych w pobliżu źródeł i przed użyciem produktów danych przez odbiorców podrzędnych. W przypadku pozyskiwania wsadowego z usługi Data Lake wykonaj te kontrole podczas przenoszenia danych z nieprzetworzonych do wzbogaconych.

Przed przeniesieniem danych do wzbogaconej warstwy jego schemat i kolumny są sprawdzane względem metadanych zarejestrowanych w wykazie danych.

Jeśli dane zawierają błędy, obciążenie zostanie zatrzymane, a zespół aplikacji danych zostanie powiadomiony o awarii.

Jeśli schemat i kolumna sprawdzają, dane są ładowane do wzbogaconych warstw z zgodnymi typami danych.

Przed przejściem do wzbogaconej warstwy proces jakości danych sprawdza zgodność z algorytmami i regułami.

Napiwek

Zdefiniuj reguły jakości danych zarówno na poziomie globalnym, jak i domeny. Dzięki temu firma może definiować standardy dla każdego utworzonego produktu danych i umożliwia domenom danych tworzenie dodatkowych reguł związanych z ich domeną.

Rozwiązania dotyczące jakości danych

Zalecamy ocenę Jakość danych w Microsoft Purview jako rozwiązania do oceny jakości danych i zarządzania nią, co ma kluczowe znaczenie dla niezawodnych szczegółowych informacji opartych na sztucznej inteligencji i podejmowania decyzji. Zawartość:

- Reguły no-code/low-code: Oceń jakość danych przy użyciu wbudowanych reguł generowanych przez sztuczną inteligencję.

- Profilowanie danych oparte na sztucznej inteligencji: zaleca kolumny profilowania i umożliwia interwencję człowieka w celu uściślenia.

- Ocenianie jakości danych: zapewnia wyniki dla zasobów danych, produktów danych i domen ładu.

- Alerty dotyczące jakości danych: powiadamia właścicieli danych o problemach z jakością.

Aby uzyskać więcej informacji, zobacz Co to jest jakość danych.

Jeśli Twoja organizacja zdecyduje się wdrożyć usługę Azure Databricks w celu manipulowania danymi, należy ocenić kontrole jakości danych, testowanie, monitorowanie i wymuszanie, które oferuje to rozwiązanie. Użycie oczekiwań może przechwytywać problemy z jakością danych podczas pozyskiwania, zanim wpłyną one na powiązane produkty danych podrzędnych. Aby uzyskać więcej informacji, zobacz Ustanawianie standardów jakości danych i zarządzanie jakością danych za pomocą usługi Databricks.

Możesz również wybrać spośród partnerów, rozwiązań typu open source i opcji niestandardowych rozwiązania do jakości danych.

Podsumowanie jakości danych

Naprawianie jakości danych może mieć poważne konsekwencje dla firmy. Może to prowadzić do tego, że jednostki biznesowe interpretują produkty danych na różne sposoby. Ta błędna interpretacja może okazać się kosztowna dla firmy, jeśli decyzje są oparte na produktach danych o niższej jakości danych. Naprawianie produktów danych z brakującymi atrybutami może być kosztownym zadaniem i może wymagać pełnego ponownego ładowania danych z kilku okresów.

Zweryfikuj jakość danych na wczesnym etapie i umieść procesy w celu proaktywnego reagowania na niską jakość danych. Na przykład produkt danych nie może zostać wydany do środowiska produkcyjnego, dopóki nie osiągnie określonej ilości kompletności.

Możesz użyć narzędzi jako wolnego wyboru, ale upewnij się, że zawiera oczekiwania (reguły), metryki danych, profilowanie i możliwość zabezpieczenia oczekiwań, aby można było zaimplementować oczekiwania globalne i oparte na domenie.