Zapoznaj się ze wzorcem referencyjnym sieci wdrażania magazynu pojedynczego serwera dla usługi Azure Local

Dotyczy: Azure Local 2311.2 i nowsze

W tym artykule opisano wzorzec referencyjny sieci magazynu pojedynczego serwera, którego można użyć do wdrożenia rozwiązania lokalnego platformy Azure. Informacje przedstawione w tym artykule ułatwiają również określenie, czy ta konfiguracja jest odpowiednia dla potrzeb dotyczących planowania wdrożenia. Ten artykuł jest przeznaczony dla administratorów IT, którzy wdrażają platformę Azure Lokalnie i zarządzają nią w swoich centrach danych.

Aby uzyskać informacje o innych wzorcach sieci, zobacz Wzorce wdrażania sieci lokalnej platformy Azure.

Wprowadzenie

Wdrożenia z jednym serwerem zapewniają korzyści związane z kosztami i miejscem, pomagając jednocześnie zmodernizować infrastrukturę i przenieść hybrydowe przetwarzanie platformy Azure do lokalizacji, które mogą tolerować odporność pojedynczej maszyny. Środowisko lokalne platformy Azure działające na jednej maszynie działa podobnie do usługi Azure Local w klastrze z wieloma węzłami: zapewnia natywną integrację z usługą Azure Arc, możliwość dodawania serwerów w celu skalowania systemu w poziomie i obejmuje te same korzyści platformy Azure.

Obsługuje również te same obciążenia, takie jak usługa Azure Virtual Desktop (AVD) i usługa AKS w środowisku lokalnym platformy Azure, obsługiwane i rozliczane w ten sam sposób.

Scenariusze

Użyj wzorca magazynu pojedynczego serwera w następujących scenariuszach:

Urządzenia, które mogą tolerować niższy poziom odporności. Rozważ zaimplementowanie tego wzorca za każdym razem, gdy lokalizacja lub usługa zapewniana przez ten wzorzec może tolerować niższy poziom odporności bez wpływu na twoją firmę.

Żywność, opieka zdrowotna, finanse, handel detaliczny, placówki rządowe. Niektóre scenariusze żywności, opieki zdrowotnej, finansów i handlu detalicznego mogą zastosować tę opcję, aby zminimalizować koszty bez wpływu na podstawowe operacje i transakcje biznesowe.

Mimo że usługi sieci zdefiniowanej programowo (SDN) warstwy 3 (L3) są w pełni obsługiwane w tym wzorcu, usługi routingu, takie jak Border Gateway Protocol (BGP), mogą być konieczne skonfigurowanie dla urządzenia zapory na przełączniku TOR (top-of-rack).

Funkcje zabezpieczeń sieci, takie jak mikrosegmentacja i jakość usługi (QoS), nie wymagają dodatkowej konfiguracji dla urządzenia zapory, ponieważ są one implementowane w warstwie wirtualnej karty sieciowej. Aby uzyskać więcej informacji, zobacz Microsegmentation with Azure Local (Mikrosegmentacja za pomocą usługi Azure Local).

Uwaga

Pojedyncze serwery muszą używać tylko jednego typu dysku: dyski SSD (Non-volatile Memory Express) lub SSD.

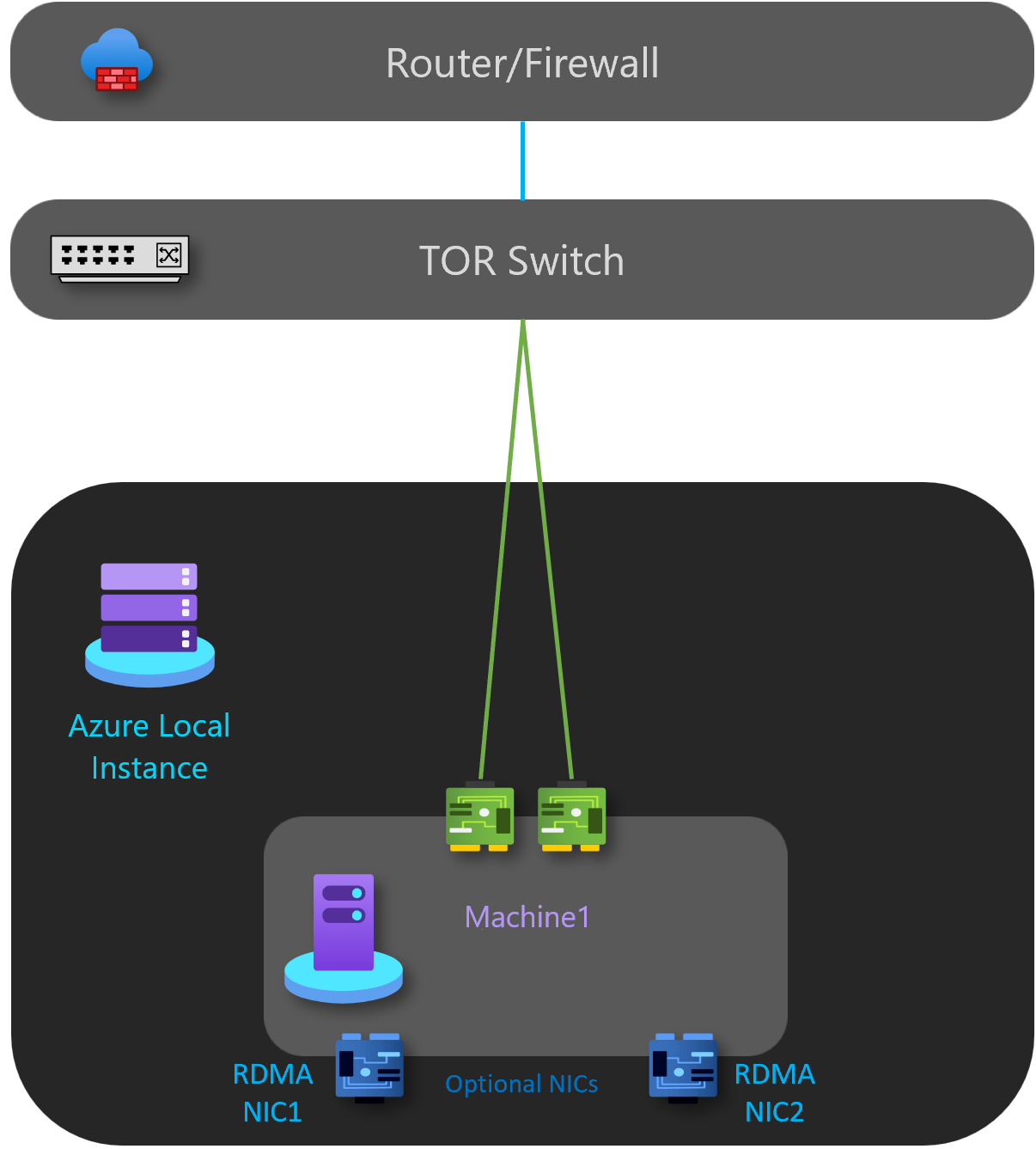

Składniki łączności fizycznej

Jak pokazano na poniższym diagramie, ten wzorzec ma następujące składniki sieci fizycznej:

- W przypadku ruchu przychodzącego na północ/południe wystąpienie lokalne platformy Azure jest implementowane przy użyciu pojedynczego przełącznika TOR L2 lub L3.

- Dwa porty sieciowe zespołu do obsługi zarządzania i ruchu obliczeniowego podłączonego do przełącznika.

- Dwie rozłączone karty sieciowe RDMA, które są używane tylko w przypadku dodania drugiego serwera do systemu na potrzeby skalowania w poziomie. Oznacza to brak zwiększonych kosztów okablowania ani portów przełącznika fizycznego.

- (Opcjonalnie) Karta BMC może służyć do zdalnego zarządzania środowiskiem. W celach bezpieczeństwa niektóre rozwiązania mogą używać konfiguracji bez użycia karty BMC.

W poniższej tabeli wymieniono wskazówki dotyczące wdrożenia pojedynczego serwera:

| Sieć | Zarządzanie i obliczenia | Storage | BMC |

|---|---|---|---|

| Szybkość łącza | Co najmniej 1 Gb/s, jeśli funkcja RDMA jest wyłączona, zalecane jest 10 Gb/s. | Co najmniej 10 Gb/s. | Zapoznaj się z producentem sprzętu. |

| Typ interfejsu | RJ45, SFP+lub SFP28 | SFP+ lub SFP28 | RJ45 |

| Porty i agregacja | Dwa porty zespołowe | Opcjonalnie, aby zezwolić na dodawanie drugiego serwera; rozłączone porty. | Jeden port |

| Dostęp RDMA | Opcjonalny. Zależy od wymagań dotyczących obsługi funkcji RDMA gościa i karty sieciowej. | Brak | Brak |

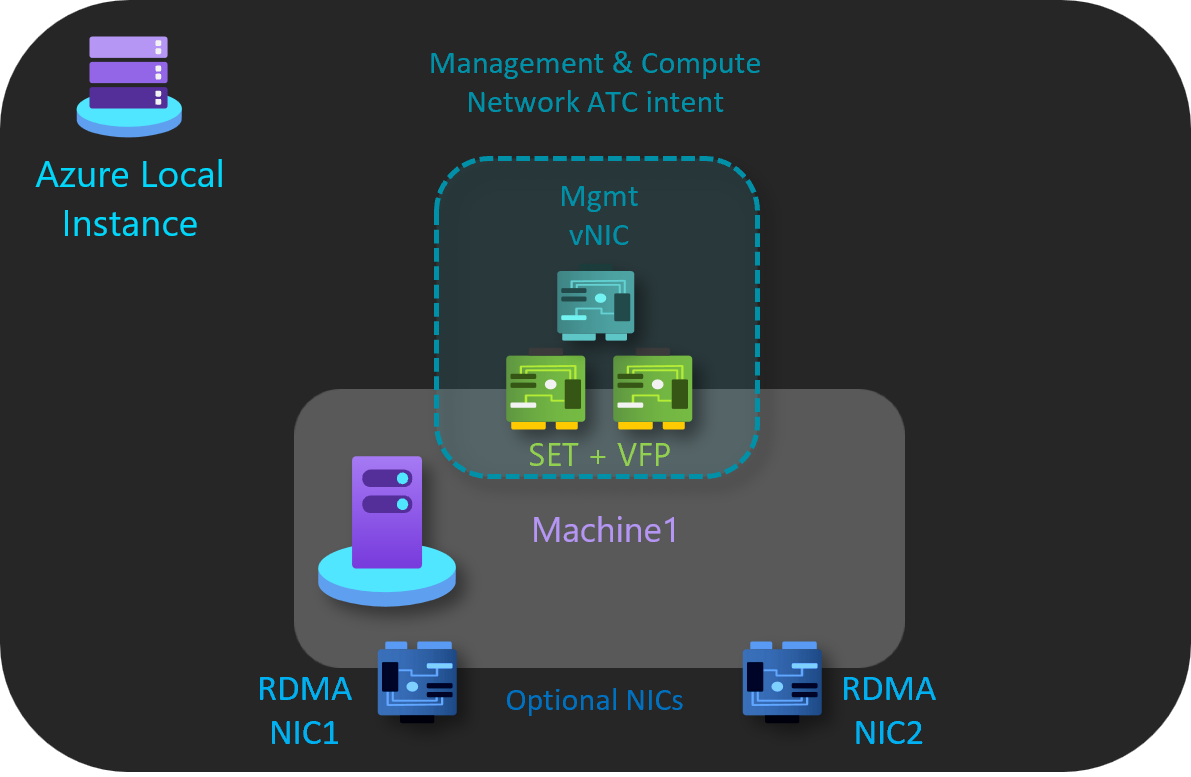

Intencje usługi ATC sieci

Wzorzec pojedynczego serwera używa tylko jednej intencji sieciowej usługi ATC do zarządzania i ruchu obliczeniowego. Interfejsy sieciowe RDMA są opcjonalne i rozłączone.

Intencja zarządzania i obliczeń

Intencja zarządzania i obliczeń ma następujące cechy:

- Typ intencji: Zarządzanie i obliczenia

- W tryb namiotu: Tryb klastra

- Tworzenie zespołu: Tak — pNIC01 i pNIC02 są zespołowe

- Domyślna sieć VLAN zarządzania: skonfigurowana sieć VLAN dla kart zarządzania jest zmodyfikowana

- Sieci VLAN pa i vNICs: sieć ATC jest przezroczysta dla sieci VNIC i sieci VLAN pa

- Obliczanie sieci VLAN i wirtualnych kart sieciowych: usługa Network ATC jest niewidoczna dla obliczeń wirtualnych kart sieciowych i sieci VLAN maszyn wirtualnych

Intencja magazynu

Intencja magazynu ma następujące cechy:

- Typ intencji: Brak

- W tryb namiotu: Brak

- Tworzenie zespołu: pNIC03 i pNIC04 są rozłączone

- Domyślne sieci VLAN: Brak

- Domyślne podsieci: Brak

Wykonaj następujące kroki, aby utworzyć intencję sieci dla tego wzorca referencyjnego:

Uruchom program PowerShell jako administrator.

Uruchom następujące polecenie:

Add-NetIntent -Name <management_compute> -Management -Compute -ClusterName <HCI01> -AdapterName <pNIC01, pNIC02>

Aby uzyskać więcej informacji, zobacz Deploy host networking: Compute and management intent (Wdrażanie sieci hostów: intencja obliczeniowa i zarządzanie).

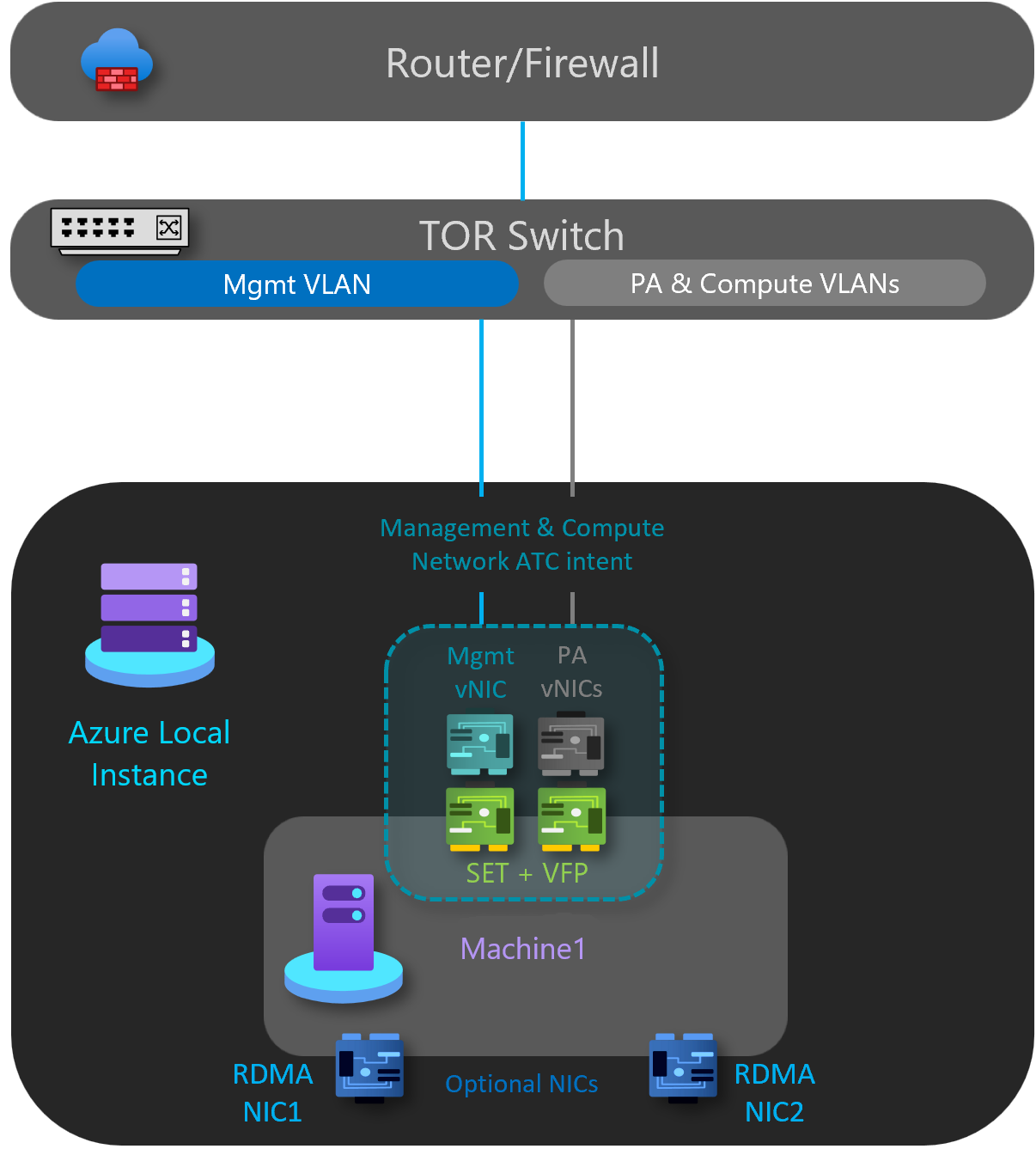

Składniki sieci logicznej

Jak pokazano na poniższym diagramie, ten wzorzec ma następujące składniki sieci logicznej:

Sieci VLAN sieci magazynu

Opcjonalnie — ten wzorzec nie wymaga sieci magazynu.

Sieć OOB

Sieć poza pasmem (OOB) jest przeznaczona do obsługi interfejsu zarządzania serwerem "lights-out" znanego również jako kontroler zarządzania płytą główną (BMC). Każdy interfejs BMC łączy się z przełącznikiem dostarczonym przez klienta. Kontroler BMC służy do automatyzowania scenariuszy rozruchu środowiska PXE.

Sieć zarządzania wymaga dostępu do interfejsu BMC przy użyciu portu 623 protokołu UDP (Intelligent Platform Management Interface).

Sieć OOB jest odizolowana od obciążeń obliczeniowych i jest opcjonalna w przypadku wdrożeń nienależących do rozwiązań.

Sieć VLAN zarządzania

Wszystkie hosty obliczeniowe fizyczne wymagają dostępu do sieci logicznej zarządzania. W przypadku planowania adresów IP każdy fizyczny host obliczeniowy musi mieć co najmniej jeden adres IP przypisany z sieci logicznej zarządzania.

Serwer DHCP może automatycznie przypisywać adresy IP dla sieci zarządzania lub ręcznie przypisywać statyczne adresy IP. Jeśli protokół DHCP jest preferowaną metodą przypisywania adresów IP, zalecamy używanie rezerwacji DHCP bez wygaśnięcia.

Sieć zarządzania obsługuje następujące konfiguracje sieci VLAN:

Natywna sieć VLAN — nie musisz dostarczać identyfikatorów sieci VLAN. Jest to wymagane w przypadku instalacji opartych na rozwiązaniach.

Oznakowana sieć VLAN — identyfikatory sieci VLAN są dostarczane w momencie wdrażania. połączenia dzierżawy w każdej bramie i przełącza ruch sieciowy do bramy rezerwowej, jeśli brama ulegnie awarii.

Bramy używają protokołu Border Gateway Protocol do anonsowania punktów końcowych GRE i ustanawiania połączeń punkt-punkt. Wdrożenie sieci SDN tworzy domyślną pulę bramy, która obsługuje wszystkie typy połączeń. W tej puli można określić, ile bram jest zarezerwowanych w stanie wstrzymania w przypadku awarii aktywnej bramy.

Aby uzyskać więcej informacji, zobacz Co to jest brama RAS dla sieci SDN?

Sieć zarządzania obsługuje cały ruch używany do zarządzania klastrem, w tym pulpitu zdalnego, Centrum administracyjnego systemu Windows i usługi Active Directory.

Aby uzyskać więcej informacji, zobacz Planowanie infrastruktury SDN: zarządzanie i dostawca HNV.

Obliczeniowe sieci VLAN

W niektórych scenariuszach nie trzeba używać sieci wirtualnych SDN z hermetyzacją wirtualnej sieci LAN (VXLAN). Zamiast tego można używać tradycyjnych sieci VLAN do izolowania obciążeń dzierżawy. Te sieci VLAN są konfigurowane na porcie przełącznika TOR w trybie magistrali. Podczas łączenia nowych maszyn wirtualnych z tymi sieciami VLAN odpowiedni tag sieci VLAN jest definiowany na wirtualnej karcie sieciowej.

Sieć adresu dostawcy HNV (PA)

Sieć adresów dostawcy wirtualizacji sieci funkcji Hyper-V (PA) służy jako podstawowa sieć fizyczna dla ruchu dzierżawy East/West (internal-internal), ruchu dzierżawy North/South (zewnętrznie-wewnętrzny) oraz wymiany informacji dotyczących komunikacji równorzędnej BGP z siecią fizyczną. Ta sieć jest wymagana tylko wtedy, gdy konieczne jest wdrożenie sieci wirtualnych przy użyciu hermetyzacji sieci VXLAN dla innej warstwy izolacji i wielodostępności sieci.

Aby uzyskać więcej informacji, zobacz Planowanie infrastruktury SDN: zarządzanie i dostawca HNV.

Opcje izolacji sieciowej

Obsługiwane są następujące opcje izolacji sieciowej:

Sieci VLAN (IEEE 802.1Q)

Sieci VLAN umożliwiają urządzeniom, które muszą być oddzielone, aby współużytkować okablowanie sieci fizycznej, a jednak nie mogą bezpośrednio wchodzić ze sobą w interakcje. To udostępnianie zarządzane daje zyski w prostocie, bezpieczeństwie, zarządzaniu ruchem i gospodarce. Na przykład sieć VLAN może służyć do oddzielania ruchu w firmie na podstawie poszczególnych użytkowników lub grup użytkowników lub ich ról lub na podstawie właściwości ruchu. Wiele usług hostingowych w Internecie używa sieci VLAN do oddzielania stref prywatnych od siebie, umożliwiając grupowanie serwerów każdego klienta w jednym segmencie sieci, niezależnie od tego, gdzie poszczególne serwery znajdują się w centrum danych. Niektóre środki ostrożności są potrzebne, aby zapobiec "ucieczki" ruchu z danej sieci VLAN, luki znanej jako przeskok sieci VLAN.

Aby uzyskać więcej informacji, zobacz Omówienie użycia sieci wirtualnych i sieci VLAN.

Domyślne zasady dostępu do sieci i mikrosegmentacja

Domyślne zasady dostępu do sieci zapewniają, że wszystkie maszyny wirtualne w klastrze azure Stack HCI są domyślnie zabezpieczone przed zagrożeniami zewnętrznymi. Dzięki tym zasadom domyślnie zablokujemy dostęp przychodzący do maszyny wirtualnej, zapewniając jednocześnie opcję włączania selektywnych portów przychodzących, a tym samym zabezpieczania maszyn wirtualnych przed atakami zewnętrznymi. To wymuszanie jest dostępne za pośrednictwem narzędzi do zarządzania, takich jak Windows Admin Center.

Mikrosegmentacja obejmuje tworzenie szczegółowych zasad sieciowych między aplikacjami i usługami. Zasadniczo zmniejsza to obwód zabezpieczeń do ogrodzenia wokół każdej aplikacji lub maszyny wirtualnej. To ogrodzenie umożliwia tylko niezbędną komunikację między warstwami aplikacji lub innymi granicami logicznymi, co sprawia, że niezwykle trudne dla cyberataków rozprzestrzenianie się poprzecznie z jednego systemu do innego. Mikrosegmentacja bezpiecznie izoluje sieci od siebie i zmniejsza całkowitą powierzchnię ataków zdarzeń zabezpieczeń sieci.

Domyślne zasady dostępu do sieci i mikrosegmentacja są realizowane jako pięć stanowych krotki (prefiks adresu źródłowego, port źródłowy, prefiks adresu docelowego, port docelowy i protokół) reguł zapory w klastrach usługi Azure Stack HCI. Reguły zapory są również nazywane sieciowymi grupami zabezpieczeń. Te zasady są wymuszane na porcie przełącznika wirtualnego każdej maszyny wirtualnej. Zasady są wypychane przez warstwę zarządzania, a kontroler sieci SDN dystrybuuje je do wszystkich odpowiednich hostów. Te zasady są dostępne dla maszyn wirtualnych w tradycyjnych sieciach sieci VLAN i w sieciach nakładek SDN.

Aby uzyskać więcej informacji, zobacz Co to jest zapora centrum danych?.

QoS dla kart sieciowych maszyn wirtualnych

Możesz skonfigurować jakość usług (QoS) dla karty sieciowej maszyny wirtualnej, aby ograniczyć przepustowość interfejsu wirtualnego, aby uniemożliwić maszynie wirtualnej o dużym natężeniu ruchu z innymi ruchem sieciowym maszyn wirtualnych. Możesz również skonfigurować funkcję QoS, aby zarezerwować określoną przepustowość dla maszyny wirtualnej, aby upewnić się, że maszyna wirtualna może wysyłać ruch niezależnie od innego ruchu w sieci. Można to zastosować do maszyn wirtualnych dołączonych do tradycyjnych sieci VLAN, a także maszyn wirtualnych dołączonych do sieci nakładek SDN.

Aby uzyskać więcej informacji, zobacz Konfigurowanie funkcji QoS dla karty sieciowej maszyny wirtualnej.

Sieci wirtualne

Wirtualizacja sieci udostępnia sieci wirtualne maszynom wirtualnym podobne do sposobu, w jaki wirtualizacja serwera (hypervisor) udostępnia maszyny wirtualne do systemu operacyjnego. Wirtualizacja sieci rozdziela sieci wirtualne z infrastruktury sieci fizycznej i usuwa ograniczenia przypisania sieci VLAN i hierarchicznego adresu IP z aprowizacji maszyny wirtualnej. Taka elastyczność ułatwia przejście do chmur IaaS infrastruktury jako usługi i jest wydajne dla hostów i administratorów centrów danych w celu zarządzania infrastrukturą oraz utrzymania niezbędnej izolacji wielodostępnej, wymagań dotyczących zabezpieczeń i nakładających się adresów IP maszyn wirtualnych.

Aby uzyskać więcej informacji, zobacz Wirtualizacja sieci funkcji Hyper-V.

Opcje usług sieciowych L3

Dostępne są następujące opcje usługi sieci L3:

Komunikacja równorzędna sieci wirtualnej

Komunikacja równorzędna sieci wirtualnych umożliwia bezproblemowe łączenie dwóch sieci wirtualnych. Po połączeniu równorzędnym sieci wirtualne są wyświetlane jako jedno. Korzystanie z wirtualnych sieci równorzędnych zapewnia m.in. następujące korzyści:

- Ruch między maszynami wirtualnymi w równorzędnych sieciach wirtualnych jest kierowany tylko przez infrastrukturę szkieletową za pośrednictwem prywatnych adresów IP. Komunikacja między sieciami wirtualnymi nie wymaga publicznego Internetu ani bram.

- Połączenie o małych opóźnieniach i dużej przepustowości między zasobami w różnych sieciach wirtualnych.

- Możliwość komunikacji zasobów w jednej sieci wirtualnej z zasobami w innej sieci wirtualnej.

- Brak przestoju dla zasobów w żadnej sieci wirtualnej podczas tworzenia komunikacji równorzędnej.

Aby uzyskać więcej informacji, zobacz Komunikacja równorzędna sieci wirtualnych.

Programowy moduł równoważenia obciążenia sieci SDN

Dostawcy usług w chmurze (CSP) i przedsiębiorstwa wdrażające programową sieć zdefiniowaną przez oprogramowanie (SDN) mogą używać programowego modułu równoważenia obciążenia (SLB), aby równomiernie dystrybuować ruch sieciowy klientów między zasobami sieci wirtualnej. SLB umożliwia wielu serwerom hostowanie tego samego obciążenia, zapewniając wysoką dostępność i skalowalność. Służy również do udostępniania przychodzących usług translatora adresów sieciowych (NAT) na potrzeby dostępu przychodzącego do maszyn wirtualnych i wychodzących usług NAT na potrzeby łączności wychodzącej.

Za pomocą usługi SLB można skalować w poziomie możliwości równoważenia obciążenia przy użyciu maszyn wirtualnych SLB na tych samych serwerach obliczeniowych funkcji Hyper-V, które są używane dla innych obciążeń maszyn wirtualnych. SLB obsługuje szybkie tworzenie i usuwanie punktów końcowych równoważenia obciążenia zgodnie z wymaganiami dotyczącymi operacji CSP. Ponadto SLB obsługuje dziesiątki gigabajtów na klaster, zapewnia prosty model aprowizacji i jest łatwy do skalowania w poziomie i w poziomie. SLB używa protokołu Border Gateway Protocol do anonsowania wirtualnych adresów IP do sieci fizycznej.

Aby uzyskać więcej informacji, zobacz Co to jest SLB dla sieci SDN?

Bramy sieci VPN sieci SDN

Brama SDN to oparty na oprogramowaniu router obsługujący protokół BGP (Border Gateway Protocol) przeznaczony dla dostawców usług w chmurze i przedsiębiorstw, które hostują wielodostępne sieci wirtualne przy użyciu wirtualizacji sieci funkcji Hyper-V (HNV). Brama RAS umożliwia kierowanie ruchu sieciowego między siecią wirtualną a inną siecią lokalną lub zdalną.

Brama SDN może służyć do:

Utwórz bezpieczne połączenia IPsec typu lokacja-lokacja między sieciami wirtualnymi SDN i zewnętrznymi sieciami klientów za pośrednictwem Internetu.

Utwórz połączenia protokołu GRE (Generic Routing Encapsulation) między sieciami wirtualnymi SDN i sieciami zewnętrznymi. Różnica między połączeniami typu lokacja-lokacja i połączeniami GRE polega na tym, że ten ostatni nie jest szyfrowanym połączeniem.

Aby uzyskać więcej informacji na temat scenariuszy łączności GRE, zobacz GRE Tunneling in Windows Server (Tunelowanie GRE w systemie Windows Server).

Utwórz połączenia warstwy 3 (L3) między sieciami wirtualnymi SDN i sieciami zewnętrznymi. W takim przypadku brama SDN działa po prostu jako router między siecią wirtualną a siecią zewnętrzną.

Brama SDN wymaga kontrolera sieci SDN. Kontroler sieci wykonuje wdrażanie pul bram, konfiguruje

Następne kroki

Dowiedz się więcej o wzorcach dwóch węzłów — wzorce wdrażania sieci lokalnej platformy Azure.