Ciągłe monitorowanie generowanych aplikacji sztucznej inteligencji

Ważne

Elementy oznaczone (wersja zapoznawcza) w tym artykule są obecnie dostępne w publicznej wersji zapoznawczej. Ta wersja zapoznawcza jest udostępniana bez umowy dotyczącej poziomu usług i nie zalecamy korzystania z niej w przypadku obciążeń produkcyjnych. Niektóre funkcje mogą być nieobsługiwane lub ograniczone. Aby uzyskać więcej informacji, zobacz Uzupełniające warunki korzystania z wersji zapoznawczych platformy Microsoft Azure.

Ciągłe postępy w zakresie generowania sztucznej inteligencji doprowadziły organizacje do tworzenia coraz bardziej złożonych aplikacji w celu rozwiązywania różnych problemów (czat-botów, systemów RAG, systemów agentów itp.). Te aplikacje są używane do wprowadzania innowacji, ulepszania środowisk klientów i ulepszania podejmowania decyzji. Chociaż modele (na przykład GPT-4) zasilające te aplikacje generujące sztuczną inteligencję są bardzo zdolne, ciągłe monitorowanie nigdy nie było ważniejsze w celu zapewnienia wysokiej jakości, bezpiecznych i niezawodnych wyników. Ciągłe monitorowanie jest skuteczne, gdy rozważa się wiele perspektyw podczas obserwowania aplikacji. Te perspektywy obejmują użycie i koszt tokenu, metryki operacyjne — opóźnienie, liczbę żądań itp. — i, co ważne, ciągłą ocenę. Aby dowiedzieć się więcej na temat oceny, zobacz Ocena aplikacji generacyjnych sztucznej inteligencji.

Usługi Azure AI i Azure Monitor zapewniają narzędzia do ciągłego monitorowania wydajności aplikacji generacyjnych sztucznej inteligencji z wielu perspektyw. Korzystając z oceny online usługi Azure AI, możesz stale oceniać aplikację niezależną od tego, gdzie została wdrożona, lub jakiej struktury aranżacji używa (na przykład LangChain). Możesz użyć różnych wbudowanych ewaluatorów, które utrzymują równoważność z zestawem AZURE AI Evaluation SDK lub definiują własne niestandardowe ewaluatory. Dzięki ciągłemu uruchamianiu odpowiednich ewaluatorów na zebranych danych śledzenia twój zespół może skuteczniej identyfikować i ograniczać obawy dotyczące bezpieczeństwa, jakości i bezpieczeństwa w miarę ich powstawania w przedprodukcyjnym lub poprodukcyjnym. Ocena online usługi Azure AI zapewnia pełną integrację z kompleksowym pakietem narzędzi do obserwacji dostępnych w usłudze Azure Monitor Application Insights, umożliwiając tworzenie niestandardowych pulpitów nawigacyjnych, wizualizowanie wyników oceny w czasie i konfigurowanie alertów na potrzeby zaawansowanego monitorowania aplikacji.

Podsumowując, monitorowanie generowanych aplikacji sztucznej inteligencji nigdy nie było ważniejsze ze względu na złożoność i szybki rozwój branży sztucznej inteligencji. Ocena online usługi Azure AI zintegrowana z usługą Azure Monitor Application Insights umożliwia ciągłą ocenę wdrożonych aplikacji w celu zapewnienia, że są one wydajne, bezpieczne i generują wysokiej jakości wyniki w środowisku produkcyjnym.

Jak działa ocena online

W tej sekcji dowiesz się, jak działa ocena online usługi Azure AI, jak integruje się z usługą Azure Monitor Application Insights i jak można jej używać do uruchamiania ciągłych ocen na podstawie danych śledzenia z generowanych aplikacji sztucznej inteligencji.

Śledzenie aplikacji generowania sztucznej inteligencji

Pierwszym krokiem ciągłego monitorowania aplikacji jest upewnienie się, że dane telemetryczne są przechwytywane i przechowywane na potrzeby analizy. Aby to osiągnąć, należy instrumentować kod aplikacji sztucznej inteligencji generującej, aby używać pakietu śledzenia AI platformy Azure do rejestrowania danych śledzenia do wybranego zasobu usługi Azure Monitor Application Insights. Ten pakiet jest w pełni zgodny ze standardem OpenTelemetry w celu obserwacji. Po instrumentacjach kodu aplikacji dane śledzenia zostaną zarejestrowane w zasobie usługi Application Insights.

Po dołączeniu śledzenia w kodzie aplikacji możesz wyświetlić dane śledzenia w usłudze Azure AI Foundry lub w zasobie usługi Application Insights usługi Azure Monitor. Aby dowiedzieć się więcej na temat tego, jak to zrobić, zobacz Monitorowanie generowania aplikacji sztucznej inteligencji.

Ocena online

Po instrumentacjach aplikacji w celu wysyłania danych śledzenia do usługi Application Insights nadszedł czas, aby skonfigurować harmonogram oceny online, aby stale oceniać te dane. Ocena online usługi Azure AI to usługa, która używa obliczeń sztucznej inteligencji platformy Azure do ciągłego uruchamiania zestawu ewaluatorów. Po skonfigurowaniu harmonogramu oceny online przy użyciu zestawu SDK projektu sztucznej inteligencji platformy Azure jest uruchamiany zgodnie z harmonogramem dostosowywalnym. Za każdym razem, gdy usługa jest uruchamiana, wykonuje następujące czynności:

- Wykonywanie zapytań dotyczących danych śledzenia aplikacji z połączonego zasobu usługi Application Insights przy użyciu podanego zapytania Kusto.

- Uruchom każdego ewaluatora na danych śledzenia i oblicz każdą metryki (na przykład uziemienie: 3).

- Zapisywanie wyników oceny z powrotem do każdego śledzenia przy użyciu standardowych konwencji semantycznych.

Uwaga

Ocena online usługi Azure AI obsługuje te same metryki co ocena usługi Azure AI. Aby uzyskać więcej informacji na temat sposobu działania oceny i obsługiwanych metryk oceny, zobacz Ocena aplikacji generowania sztucznej inteligencji przy użyciu zestawu AZURE AI Evaluation SDK

Załóżmy na przykład, że masz wdrożona aplikacja do czatu, która codziennie otrzymuje wiele pytań klientów. Chcesz stale oceniać jakość odpowiedzi z aplikacji. Skonfiguruj harmonogram oceny online z cyklem dziennym. Należy skonfigurować ewaluatorów: uziemienie, spójność i płynność. Codziennie usługa oblicza wyniki oceny dla tych metryk i zapisuje dane z powrotem do usługi Application Insights dla każdego śledzenia zebranego w przedziale czasu cyklu (w tym przykładzie w ciągu ostatnich 24 godzin). Następnie można wykonywać zapytania dotyczące danych z każdego śladu i udostępniane w usługach Azure AI Foundry i Azure Monitor Application Insights.

Wyniki oceny zapisane z powrotem do każdego śledzenia w usłudze Application Insights są zgodne z następującymi konwencjami. Unikatowy zakres zostanie dodany do każdego śladu dla każdej metryki oceny.

| Właściwości | Tabela usługi Application Insights | Pola dla danego operation_ID | Przykładowa wartość |

|---|---|---|---|

| Metryka oceny | traces, AppTraces | customDimensions[“event.name”] |

gen_ai.evaluation.relevance |

| Ocena wyniku metryki | traces, AppTraces | customDimensions[“gen_ai.evaluation.score”] |

3 |

| Komentarz metryki oceny (jeśli dotyczy) | traces, AppTraces | message |

{“comment”: “I like the response”} |

Teraz, gdy rozumiesz, jak działa ocena online usługi Azure AI i jak łączy się z usługą Azure Monitor Application Insights, nadszedł czas, aby dowiedzieć się, jak skonfigurować usługę.

Konfigurowanie oceny online

W tej sekcji dowiesz się, jak skonfigurować harmonogram oceny online w celu ciągłego monitorowania wdrożonej aplikacji generowania sztucznej inteligencji. Zestaw SDK projektu usługi Azure AI oferuje takie możliwości za pośrednictwem interfejsu API języka Python i obsługuje wszystkie funkcje dostępne w lokalnych ocenach. Wykonaj poniższe kroki, aby przesłać harmonogram oceny online na danych przy użyciu wbudowanych lub niestandardowych ewaluatorów.

Uwaga

Oceny są obsługiwane tylko w tych samych regionach , co metryki ryzyka i bezpieczeństwa wspomagane przez sztuczną inteligencję.

Wymagania wstępne

Wykonaj następujące kroki wymagań wstępnych, aby skonfigurować środowisko i uwierzytelnianie w niezbędnych zasobach:

- Subskrypcja platformy Azure.

- Grupa zasobów w regionie obsługiwanym przez ocenę.

- Nowa tożsamość zarządzana przypisana przez użytkownika w tej samej grupie zasobów i regionie. Zanotuj

clientIdelement ; będziesz go potrzebować później. - Usługa Azure AI Hub w tej samej grupie zasobów i regionie.

- Projekt sztucznej inteligencji platformy Azure w tym centrum znajduje się w temacie Create a project in Azure AI Foundry portal (Tworzenie projektu w portalu usługi Azure AI Foundry).

- Zasób usługi Application Insights usługi Azure Monitor.

- Przejdź do strony centrum w witrynie Azure Portal i dodaj zasób usługi Application Insights, zobacz Update aplikacja systemu Azure Insights i Azure Container Registry.

- Wdrożenie usługi Azure OpenAI z modelem GPT obsługującym

chat completionna przykładgpt-4. Connection Stringdla projektu sztucznej inteligencji platformy Azure w celu łatwego tworzeniaAIProjectClientobiektu. Możesz uzyskać parametry połączenia Project w obszarze Szczegóły projektu na stronie Przegląd projektu.- Przejdź do zasobu usługi Application Insights w witrynie Azure Portal i użyj karty Kontrola dostępu (IAM), aby dodać

Log Analytics Contributorrolę do utworzonej wcześniej tożsamości zarządzanej przypisanej przez użytkownika. - Dołącz tożsamość zarządzaną przypisaną przez użytkownika do projektu.

- Przejdź do usług Azure AI Services w witrynie Azure Portal i użyj karty Kontrola dostępu (IAM), aby dodać

Cognitive Services OpenAI Contributorrolę do utworzonej wcześniej tożsamości zarządzanej przypisanej przez użytkownika. - Upewnij się, że najpierw zalogowano się do subskrypcji platformy Azure, uruchamiając polecenie

az login.

Instrukcje instalacji

- Utwórz wybrane środowisko wirtualne. Aby utworzyć aplikację przy użyciu narzędzia Conda, uruchom następujące polecenie:

conda create -n online-evaluation

conda activate online-evaluation

- Zainstaluj wymagane pakiety, uruchamiając następujące polecenie:

pip install azure-identity azure-ai-projects azure-ai-ml

Napiwek

Opcjonalnie możesz pip install azure-ai-evaluation , jeśli chcesz, aby środowisko code-first pobierało identyfikator ewaluatora dla wbudowanych ewaluatorów w kodzie. Aby dowiedzieć się, jak to zrobić, zobacz Określanie ewaluatorów z biblioteki ewaluatora.

Konfigurowanie śledzenia dla aplikacji generowania sztucznej inteligencji

Pierwszym krokiem monitorowania aplikacji jest skonfigurowanie śledzenia. Aby dowiedzieć się, jak to zrobić, aby dane zostały zarejestrowane w usłudze Application Insights, zobacz Konfigurowanie śledzenia dla generowanej aplikacji sztucznej inteligencji.

Używanie nazwy usługi w danych śledzenia

Aby zidentyfikować usługę za pomocą unikatowego identyfikatora w usłudze Application Insights, możesz użyć właściwości OpenTelemetry nazwy usługi w danych śledzenia. Jest to szczególnie przydatne, jeśli rejestrujesz dane z wielu aplikacji do tego samego zasobu usługi Application Insights i chcesz je rozróżnić. Załóżmy na przykład, że masz dwie aplikacje: App-1 i App-2 ze śledzeniem skonfigurowanym do rejestrowania danych w tym samym zasobie usługi Application Insights. Być może chcesz skonfigurować aplikację App-1 do ciągłego oceniania według istotności i app-2, aby były oceniane w sposób ciągły przez groundedness. Za pomocą nazwy usługi można rozróżniać aplikacje w konfiguracjach oceny online.

Aby skonfigurować właściwość nazwy usługi, możesz to zrobić bezpośrednio w kodzie aplikacji, wykonując kroki, zobacz Używanie wielu dostawców śledzenia z różnymi zasobami. Alternatywnie można ustawić zmienną środowiskową OTEL_SERVICE_NAME przed wdrożeniem aplikacji. Aby dowiedzieć się więcej na temat pracy z nazwą usługi, zobacz Zmienne środowiskowe OTEL i konwencje semantyczne zasobów usługi.

Aby wysłać zapytanie dotyczące danych śledzenia dla danej nazwy usługi, wykonaj zapytanie dotyczące cloud_roleName właściwości. Dodaj następujący wiersz do zapytania KQL używanego w ramach konfiguracji oceny online:

| where cloud_RoleName == "service_name"

Wykonywanie zapytań dotyczących przechowywanych danych śledzenia w usłudze Application Insights

Korzystając z język zapytań Kusto (KQL), możesz wykonywać zapytania dotyczące danych śledzenia aplikacji generującej sztuczną inteligencję z usługi Application Insights, aby używać ich do ciągłej oceny online. Jeśli używasz pakietu śledzenia sztucznej inteligencji platformy Azure do śledzenia aplikacji generowania sztucznej inteligencji, możesz użyć następującego zapytania Kusto, aby wyświetlić dane w usłudze Application Insights:

Ważne

Zapytanie KQL używane przez usługę oceny online musi zawierać następujące kolumny: operation_Id, operation_ParentIdi gen_ai_response_id. Ponadto każdy ewaluator ma własne wymagania dotyczące danych wejściowych. Zapytanie KQL musi użyć tych kolumn jako danych wejściowych samych ewaluatorów. Aby uzyskać listę wymagań dotyczących danych dla ewaluatorów, zobacz wymagania dotyczące danych dla wbudowanych ewaluatorów.

let gen_ai_spans = (

dependencies

| where isnotnull(customDimensions["gen_ai.system"])

| extend response_id = tostring(customDimensions["gen_ai.response.id"])

| project id, operation_Id, operation_ParentId, timestamp, response_id

);

let gen_ai_events = (

traces

| where message in ("gen_ai.choice", "gen_ai.user.message", "gen_ai.system.message")

or tostring(customDimensions["event.name"]) in ("gen_ai.choice", "gen_ai.user.message", "gen_ai.system.message")

| project

id = operation_ParentId,

operation_Id,

operation_ParentId,

user_input = iff(

message == "gen_ai.user.message" or tostring(customDimensions["event.name"]) == "gen_ai.user.message",

parse_json(iff(message == "gen_ai.user.message", tostring(customDimensions["gen_ai.event.content"]), message)).content,

""

),

system = iff(

message == "gen_ai.system.message" or tostring(customDimensions["event.name"]) == "gen_ai.system.message",

parse_json(iff(message == "gen_ai.system.message", tostring(customDimensions["gen_ai.event.content"]), message)).content,

""

),

llm_response = iff(

message == "gen_ai.choice",

parse_json(tostring(parse_json(tostring(customDimensions["gen_ai.event.content"])).message)).content,

iff(tostring(customDimensions["event.name"]) == "gen_ai.choice", parse_json(parse_json(message).message).content, "")

)

| summarize

operation_ParentId = any(operation_ParentId),

Input = maxif(user_input, user_input != ""),

System = maxif(system, system != ""),

Output = maxif(llm_response, llm_response != "")

by operation_Id, id

);

gen_ai_spans

| join kind=inner (gen_ai_events) on id, operation_Id

| project Input, System, Output, operation_Id, operation_ParentId, gen_ai_response_id = response_id

Opcjonalnie możesz użyć operatora przykładowego lub wykonać operator w zapytaniu Kusto, tak aby zwracał tylko podzbiór śladów. Ponieważ oceny wspomagane przez sztuczną inteligencję mogą być kosztowne na dużą skalę, takie podejście może pomóc w kontrolowaniu kosztów, oceniając tylko losową próbkę (lub n ślady) danych.

Konfigurowanie oceny online przy użyciu zestawu SDK projektu sztucznej inteligencji platformy Azure

Zaplanowane zadanie oceny online można przesłać za pomocą zestawu SDK projektu AI platformy Azure za pośrednictwem interfejsu API języka Python. Zapoznaj się z poniższym skryptem, aby dowiedzieć się, jak skonfigurować ocenę online przy użyciu ewaluatorów z wydajnością i jakością (wspomaganą sztuczną inteligencją). Aby wyświetlić kompleksową listę obsługiwanych ewaluatorów, zobacz Ocena przy użyciu zestawu AZURE AI Evaluation SDK. Aby dowiedzieć się, jak używać niestandardowych ewaluatorów, zobacz niestandardowe ewaluatory.

Zacznij od zaimportowania wymaganych pakietów i skonfigurowania wymaganych zmiennych:

from azure.ai.projects import AIProjectClient

from azure.identity import DefaultAzureCredential

from azure.ai.projects.models import (

ApplicationInsightsConfiguration,

EvaluatorConfiguration,

EvaluationSchedule,

RecurrenceTrigger,

)

from azure.ai.evaluation import CoherenceEvaluator

# This sample includes the setup for an online evaluation schedule using the Azure AI Project SDK and Azure AI Evaluation SDK

# The schedule is configured to run daily over the collected trace data while running two evaluators: CoherenceEvaluator and RelevanceEvaluator

# This sample can be modified to fit your application's requirements

# Name of your online evaluation schedule

SAMPLE_NAME = "online_eval_name"

# Name of your generative AI application (will be available in trace data in Application Insights)

SERVICE_NAME = "service_name"

# Connection string to your Azure AI Foundry project

# Currently, it should be in the format "<HostName>;<AzureSubscriptionId>;<ResourceGroup>;<HubName>"

PROJECT_CONNECTION_STRING = "<HostName>;<AzureSubscriptionId>;<ResourceGroup>;<HubName>"

# Your Application Insights resource ID

APPLICATION_INSIGHTS_RESOURCE_ID = "appinsights_resource_id"

# Kusto Query Language (KQL) query to query data from Application Insights resource

# This query is compatible with data logged by the Azure AI Inferencing Tracing SDK (linked in documentation)

# You can modify it depending on your data schema

# The KQL query must output these required columns: operation_ID, operation_ParentID, and gen_ai_response_id

# You can choose which other columns to output as required by the evaluators you are using

KUSTO_QUERY = "let gen_ai_spans=(dependencies | where isnotnull(customDimensions[\"gen_ai.system\"]) | extend response_id = tostring(customDimensions[\"gen_ai.response.id\"]) | project id, operation_Id, operation_ParentId, timestamp, response_id); let gen_ai_events=(traces | where message in (\"gen_ai.choice\", \"gen_ai.user.message\", \"gen_ai.system.message\") or tostring(customDimensions[\"event.name\"]) in (\"gen_ai.choice\", \"gen_ai.user.message\", \"gen_ai.system.message\") | project id= operation_ParentId, operation_Id, operation_ParentId, user_input = iff(message == \"gen_ai.user.message\" or tostring(customDimensions[\"event.name\"]) == \"gen_ai.user.message\", parse_json(iff(message == \"gen_ai.user.message\", tostring(customDimensions[\"gen_ai.event.content\"]), message)).content, \"\"), system = iff(message == \"gen_ai.system.message\" or tostring(customDimensions[\"event.name\"]) == \"gen_ai.system.message\", parse_json(iff(message == \"gen_ai.system.message\", tostring(customDimensions[\"gen_ai.event.content\"]), message)).content, \"\"), llm_response = iff(message == \"gen_ai.choice\", parse_json(tostring(parse_json(tostring(customDimensions[\"gen_ai.event.content\"])).message)).content, iff(tostring(customDimensions[\"event.name\"]) == \"gen_ai.choice\", parse_json(parse_json(message).message).content, \"\")) | summarize operation_ParentId = any(operation_ParentId), Input = maxif(user_input, user_input != \"\"), System = maxif(system, system != \"\"), Output = maxif(llm_response, llm_response != \"\") by operation_Id, id); gen_ai_spans | join kind=inner (gen_ai_events) on id, operation_Id | project Input, System, Output, operation_Id, operation_ParentId, gen_ai_response_id = response_id"

Następnie zdefiniuj klienta i wdrożenie GPT usługi Azure OpenAI (na przykład GPT-4), które będzie używane do uruchamiania harmonogramu oceny online. Ponadto nawiąż połączenie z zasobem usługi Application Insights:

# Connect to your Azure AI Foundry Project

project_client = AIProjectClient.from_connection_string(

credential=DefaultAzureCredential(),

conn_str=PROJECT_CONNECTION_STRING

)

# Connect to your Application Insights resource

app_insights_config = ApplicationInsightsConfiguration(

resource_id=APPLICATION_INSIGHTS_RESOURCE_ID,

query=KUSTO_QUERY,

service_name=SERVICE_NAME

)

# Connect to your AOAI resource, you must use an AOAI GPT model

deployment_name = "gpt-4"

api_version = "2024-08-01-preview"

# This is your AOAI connection name, which can be found in your AI Foundry project under the 'Models + Endpoints' tab

default_connection = project_client.connections._get_connection(

"aoai_connection_name"

)

model_config = {

"azure_deployment": deployment_name,

"api_version": api_version,

"type": "azure_openai",

"azure_endpoint": default_connection.properties["target"]

}

Następnie skonfiguruj ewaluatorów, których chcesz użyć:

# RelevanceEvaluator

# id for each evaluator can be found in your AI Foundry registry - please see documentation for more information

# init_params is the configuration for the model to use to perform the evaluation

# data_mapping is used to map the output columns of your query to the names required by the evaluator

relevance_evaluator_config = EvaluatorConfiguration(

id="azureml://registries/azureml-staging/models/Relevance-Evaluator/versions/4",

init_params={"model_config": model_config},

data_mapping={"query": "${data.Input}", "response": "${data.Output}"}

)

# CoherenceEvaluator

coherence_evaluator_config = EvaluatorConfiguration(

id=CoherenceEvaluator.id,

init_params={"model_config": model_config},

data_mapping={"query": "${data.Input}", "response": "${data.Output}"}

)

Na koniec zdefiniuj cykl i utwórz harmonogram:

Uwaga: W krokach wymagań wstępnych utworzono tożsamość zarządzaną przypisaną przez użytkownika w celu uwierzytelnienia harmonogramu oceny online do zasobu usługi Application Insights. Parametr AzureMSIClientId w properties EvaluationSchedule klasie jest tą tożsamością clientId .

# Frequency to run the schedule

recurrence_trigger = RecurrenceTrigger(frequency="day", interval=1)

# Dictionary of evaluators

evaluators = {

"relevance": relevance_evaluator_config,

"coherence" : coherence_evaluator_config

}

name = SAMPLE_NAME

description = f"{SAMPLE_NAME} description"

# AzureMSIClientId is the clientID of the User-assigned managed identity created during set-up - see documentation for how to find it

properties = {"AzureMSIClientId": "your_client_id"}

# Configure the online evaluation schedule

evaluation_schedule = EvaluationSchedule(

data=app_insights_config,

evaluators=evaluators,

trigger=recurrence_trigger,

description=description,

properties=properties)

# Create the online evaluation schedule

created_evaluation_schedule = project_client.evaluations.create_or_replace_schedule(name, evaluation_schedule)

print(f"Successfully submitted the online evaluation schedule creation request - {created_evaluation_schedule.name}, currently in {created_evaluation_schedule.provisioning_state} state.")

Wykonywanie operacji zgodnie z harmonogramem oceny online

Harmonogramy oceny online można pobrać, wyświetlić i wyłączyć, dodając następujący kod do skryptu konfiguracji Oceny online:

Ostrzeżenie: Poczekaj niewielką ilość czasu (~30 sekund) między utworzeniem harmonogramu oceny online i uruchomieniem interfejsu get_schedule() API.

Pobierz harmonogram oceny online:

name = "<my-online-evaluation-name>"

get_evaluation_schedule = project_client.evaluations.get_schedule(name)

Wyświetl wszystkie harmonogramy oceny online:

count = 0

for evaluation_schedule in project_client.evaluations.list_schedule():

count += 1

print(f"{count}. {evaluation_schedule.name} "

f"[IsEnabled: {evaluation_schedule.is_enabled}]")

print(f"Total evaluation schedules: {count}")

Wyłącz (usuwanie nietrwałe) Harmonogram oceny online:

name = "<my-online-evaluation-name>"

project_client.evaluations.disable_schedule(name)

Monitorowanie aplikacji generowania sztucznej inteligencji

W tej sekcji dowiesz się, jak usługa Azure AI integruje się z usługą Azure Monitor Application Insights, aby zapewnić wbudowany widok pulpitu nawigacyjnego dostosowany do szczegółowych informacji dotyczących generowanej aplikacji sztucznej inteligencji, dzięki czemu możesz być na bieżąco z najnowszym stanem aplikacji.

Szczegółowe informacje dotyczące generowanej aplikacji sztucznej inteligencji

Jeśli ta konfiguracja nie jest skonfigurowana, poniżej przedstawiono kilka szybkich kroków:

- Przejdź do projektu w rozwiązaniu Azure AI Foundry.

- Wybierz stronę Śledzenie po lewej stronie.

- Połącz zasób usługi Application Insights z projektem.

Jeśli śledzenie zostało już skonfigurowane w portalu usługi Azure AI Foundry, wystarczy wybrać link, aby zapoznać się z pulpitem nawigacyjnym aplikacji generowania sztucznej inteligencji.

Po przesyłania strumieniowego danych do zasobu usługi Application Insights możesz automatycznie zobaczyć, że zostaną wypełnione na tym dostosowanym pulpicie nawigacyjnym.

Ten widok jest doskonałym miejscem na rozpoczęcie pracy z potrzebami monitorowania.

- Możesz wyświetlić użycie tokenu w czasie, aby dowiedzieć się, czy chcesz zwiększyć limity użycia, czy przeprowadzić dodatkową analizę kosztów.

- Metryki oceny można wyświetlać jako linie trendu, aby codziennie zrozumieć jakość aplikacji.

- Możesz debugować, kiedy mają miejsce wyjątki i przechodzić do szczegółów śladów, korzystając z widoku szczegółów transakcji kompleksowej usługi Azure Monitor, aby dowiedzieć się, co poszło nie tak.

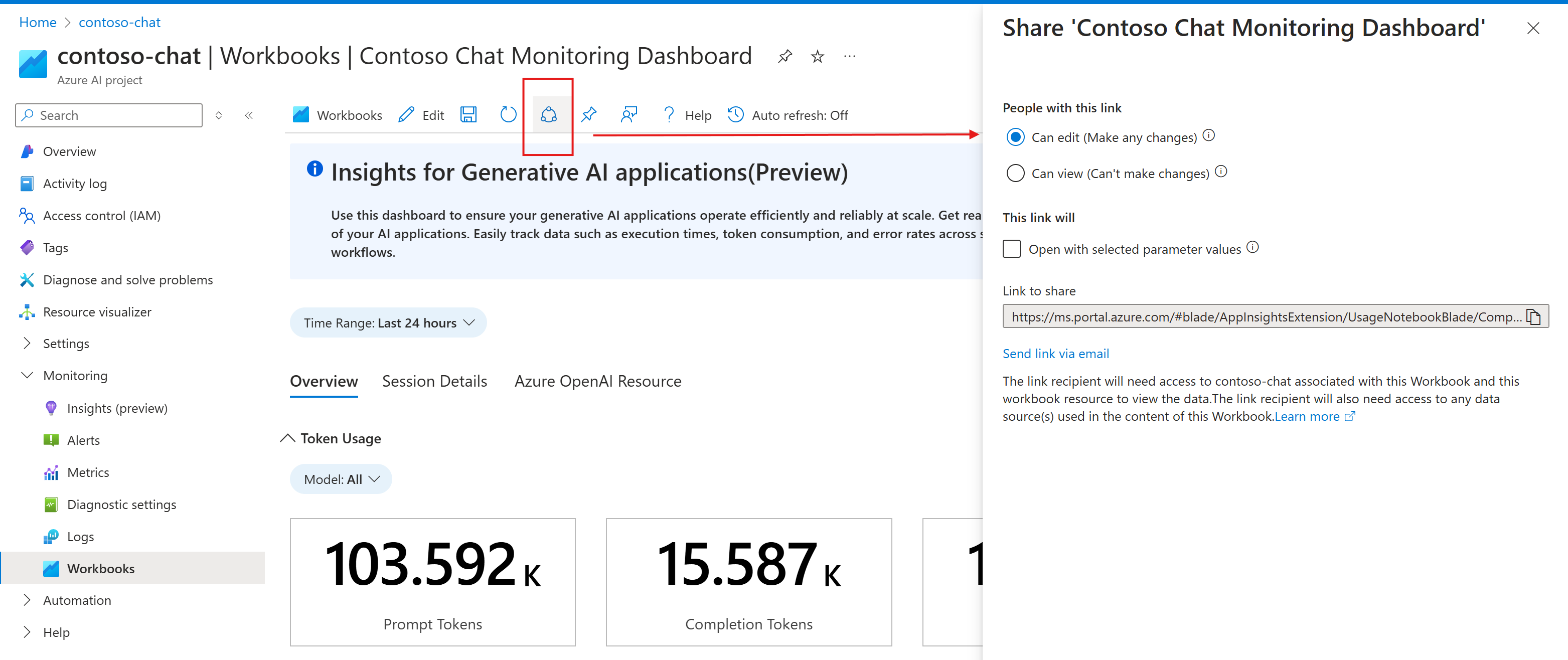

Jest to skoroszyt platformy Azure, który wykonuje zapytania dotyczące danych przechowywanych w zasobie usługi Application Insights. Możesz dostosować ten skoroszyt i dostosować go do własnych potrzeb biznesowych. Aby dowiedzieć się więcej, zobacz edytowanie skoroszytów platformy Azure.

Dzięki temu można dodawać dodatkowe niestandardowe ewaluatory, które mogły być rejestrowane lub inne tekst znaczników markdown, aby udostępniać podsumowania i używać ich do celów raportowania.

Możesz również udostępnić ten skoroszyt zespołowi, aby być na bieżąco z najnowszymi informacjami.