Jak skonfigurować filtry zawartości za pomocą rozwiązania Azure AI Foundry

System filtrowania zawartości zintegrowany z usługą Azure AI Foundry działa wraz z podstawowymi modelami, w tym modelami generowania obrazów DALL-E. Wykorzystuje ona zespół wieloklasowych modeli klasyfikacji do wykrywania czterech kategorii szkodliwych treści (przemoc, nienawiść, seksualna i samookaleczenia) odpowiednio na czterech poziomach ważności (bezpieczne, niskie, średnie i wysokie) oraz opcjonalne klasyfikatory binarne do wykrywania ryzyka jailbreaku, istniejącego tekstu i kodu w repozytoriach publicznych.

Domyślna konfiguracja filtrowania zawartości jest ustawiona tak, aby filtrować według progu średniej ważności w przypadku wszystkich czterech kategorii szkody dla zawartości monitów i uzupełniania. Oznacza to, że zawartość wykryta na średnim lub wysokim poziomie ważności jest filtrowana, podczas gdy zawartość wykryta na niskim lub bezpiecznym poziomie ważności nie jest filtrowana przez filtry zawartości. Dowiedz się więcej o kategoriach zawartości, poziomach ważności i zachowaniu systemu filtrowania zawartości tutaj.

Wykrywanie ryzyka zabezpieczeń systemu i chronione modele tekstu i kodu są opcjonalne i domyślnie włączone. W przypadku zdjęć zabezpieczeń systemu i chronionych modeli tekstu i kodu materiałowego funkcja konfigurowania umożliwia wszystkim klientom włączanie i wyłączanie modeli. Modele są domyślnie włączone i można je wyłączyć w danym scenariuszu. Niektóre modele muszą być włączone w niektórych scenariuszach, aby zachować zakres w ramach zobowiązania do praw autorskich klienta.

Uwaga

Wszyscy klienci mają możliwość modyfikowania filtrów zawartości i konfigurowania progów ważności (niska, średnia, wysoka). Zatwierdzenie jest wymagane do częściowego lub pełnego wyłączenia filtrów zawartości. Klienci zarządzani mogą ubiegać się tylko o pełną kontrolę filtrowania zawartości za pośrednictwem tego formularza: Przegląd ograniczonego dostępu usługi Azure OpenAI: zmodyfikowane filtry zawartości. Obecnie nie można stać się klientem zarządzanym.

Filtry zawartości można skonfigurować na poziomie zasobu. Po utworzeniu nowej konfiguracji można ją skojarzyć z co najmniej jednym wdrożeniem. Aby uzyskać więcej informacji na temat modeli wdrażania, zobacz przewodnik po modelach wdrażania).

Wymagania wstępne

- Aby skonfigurować filtry zawartości, musisz mieć zasób usługi Azure OpenAI i wdrożenie dużego modelu językowego (LLM). Postępuj zgodnie z przewodnikiem Szybki start , aby rozpocząć pracę.

Omówienie możliwości konfigurowania filtru zawartości

Usługa Azure OpenAI Service obejmuje domyślne ustawienia bezpieczeństwa stosowane do wszystkich modeli, z wyłączeniem interfejsu Azure OpenAI Whisper. Te konfiguracje zapewniają domyślnie środowisko odpowiedzialne, w tym modele filtrowania zawartości, listy zablokowanych, przekształcanie monitów, poświadczenia zawartości i inne. Przeczytaj więcej na ten temat tutaj.

Wszyscy klienci mogą również konfigurować filtry zawartości i tworzyć niestandardowe zasady bezpieczeństwa dostosowane do wymagań przypadków użycia. Funkcja konfigurowania umożliwia klientom dostosowywanie ustawień, oddzielnie w przypadku monitów i uzupełniania, filtrowanie zawartości dla każdej kategorii zawartości na różnych poziomach ważności zgodnie z opisem w poniższej tabeli. Zawartość wykryta na poziomie ważności "bezpieczne" jest oznaczona adnotacjami, ale nie podlega filtrowaniu i nie jest konfigurowalna.

| Odfiltrowana ważność | Konfigurowalny pod kątem monitów | Możliwość konfigurowania pod kątem uzupełniania | Opisy |

|---|---|---|---|

| Niski, średni, wysoki | Tak | Tak | Najostrzejsza konfiguracja filtrowania. Zawartość wykryta na niskich, średnich i wysokich poziomach ważności jest filtrowana. |

| Średni, wysoki | Tak | Tak | Zawartość wykryta na niskim poziomie ważności nie jest filtrowana, zawartość w średnim i wysokim poziomie jest filtrowana. |

| Wys. | Tak | Tak | Zawartość wykryta na niskich i średnich poziomach ważności nie jest filtrowana. Filtrowana jest tylko zawartość na wysokim poziomie ważności. |

| Brak filtrów | Jeśli zatwierdzono1 | Jeśli zatwierdzono1 | Żadna zawartość nie jest filtrowana niezależnie od wykrytego poziomu ważności. Wymaga zatwierdzenia1. |

| Dodawanie adnotacji tylko | Jeśli zatwierdzono1 | Jeśli zatwierdzono1 | Wyłącza funkcję filtrowania, więc zawartość nie będzie blokowana, ale adnotacje są zwracane za pośrednictwem odpowiedzi interfejsu API. Wymaga zatwierdzenia1. |

1 W przypadku modeli usługi Azure OpenAI tylko klienci, którzy zostali zatwierdzeni do zmodyfikowanego filtrowania zawartości, mają pełną kontrolę filtrowania zawartości i mogą wyłączyć filtry zawartości. Zastosuj do zmodyfikowanych filtrów zawartości za pomocą tego formularza: Przegląd ograniczonego dostępu usługi Azure OpenAI: zmodyfikowane filtry zawartości. W przypadku klientów platformy Azure Government zastosuj się do zmodyfikowanych filtrów zawartości za pośrednictwem tego formularza: Azure Government — żądanie zmodyfikowanego filtrowania zawartości dla usługi Azure OpenAI.

Konfigurowalne filtry zawartości dla danych wejściowych (monitów) i danych wyjściowych (uzupełniania) są dostępne dla wszystkich modeli usługi Azure OpenAI.

Konfiguracje filtrowania zawartości są tworzone w ramach zasobu w portalu usługi Azure AI Foundry i mogą być skojarzone z wdrożeniami. Dowiedz się więcej o możliwościach konfiguracji tutaj.

Klienci są odpowiedzialni za zapewnienie, że aplikacje integrujące usługę Azure OpenAI są zgodne z kodeksem postępowania.

Omówienie innych filtrów

Oprócz domyślnych filtrów kategorii szkód można skonfigurować następujące kategorie filtrów.

| Kategoria filtru | Stan | Ustawienie domyślne | Zastosowano do monitu lub ukończenia? | opis |

|---|---|---|---|---|

| Monitowanie osłon o bezpośrednie ataki (jailbreak) | Ogólna dostępność | Włączone | Monit użytkownika | Filtruje/dodawać adnotacje do monitów użytkownika, które mogą stanowić ryzyko jailbreaku. Aby uzyskać więcej informacji na temat adnotacji, odwiedź stronę Filtrowanie zawartości usługi Azure AI Foundry. |

| Monitowanie o osłony pod kątem ataków pośrednich | Ogólna dostępność | Wyłączona | Monit użytkownika | Filtrowanie/dodawanie adnotacji do ataków pośrednich, nazywanych również atakami pośredniego monitowania lub atakami polegającymi na wstrzyknięciu monitów między domenami, potencjalnej luki w zabezpieczeniach, w której inne firmy umieszczają złośliwe instrukcje wewnątrz dokumentów, do których system generujący sztuczną inteligencję może uzyskiwać dostęp i przetwarzać. Wymaga: osadzanie i formatowanie dokumentu. |

| Materiał chroniony — kod | Ogólna dostępność | Włączone | Zakończenie | Filtruje kod chroniony lub pobiera przykładowe cytaty i informacje o licencji w adnotacjach dla fragmentów kodu, które są zgodne z dowolnymi publicznymi źródłami kodu obsługiwanymi przez narzędzie GitHub Copilot. Aby uzyskać więcej informacji na temat używania adnotacji, zobacz przewodnik po pojęciach dotyczących filtrowania zawartości |

| Materiał chroniony — tekst | Ogólna dostępność | Włączone | Zakończenie | Identyfikuje i blokuje wyświetlanie znanej zawartości tekstowej w danych wyjściowych modelu (na przykład teksty piosenek, przepisy i wybrana zawartość internetowa). |

| Uziemienie* | Podgląd | Wyłączona | Zakończenie | Wykrywa, czy odpowiedzi tekstowe dużych modeli językowych (LLM) są uziemione w materiałach źródłowych dostarczanych przez użytkowników. Bezpodstawność odnosi się do wystąpień, w których LLMs tworzą informacje, które nie są faktyczne lub niedokładne z tego, co było obecne w materiałach źródłowych. Wymaga: osadzanie i formatowanie dokumentu. |

Tworzenie filtru zawartości w usłudze Azure AI Foundry

W przypadku dowolnego wdrożenia modelu w usłudze Azure AI Foundry możesz bezpośrednio użyć domyślnego filtru zawartości, ale możesz mieć większą kontrolę. Można na przykład zwiększyć lub bardziej łagodny filtr albo włączyć bardziej zaawansowane funkcje, takie jak osłony monitów i wykrywanie materiałów chronionych.

Napiwek

Aby uzyskać wskazówki dotyczące filtrów zawartości w projekcie usługi Azure AI Foundry, przeczytaj więcej na temat filtrowania zawartości usługi Azure AI Foundry.

Wykonaj następujące kroki, aby utworzyć filtr zawartości:

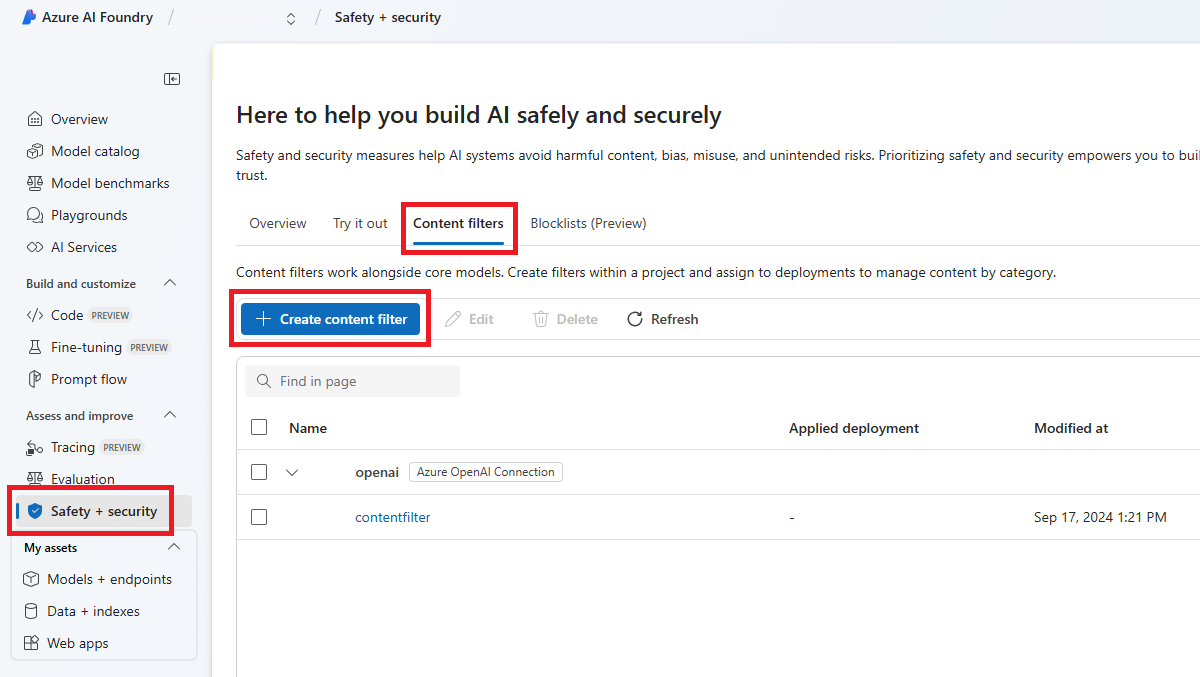

Przejdź do witryny Azure AI Foundry i przejdź do projektu. Następnie wybierz stronę Bezpieczeństwo i zabezpieczenia z menu po lewej stronie i wybierz kartę Filtry zawartości.

Wybierz pozycję + Utwórz filtr zawartości.

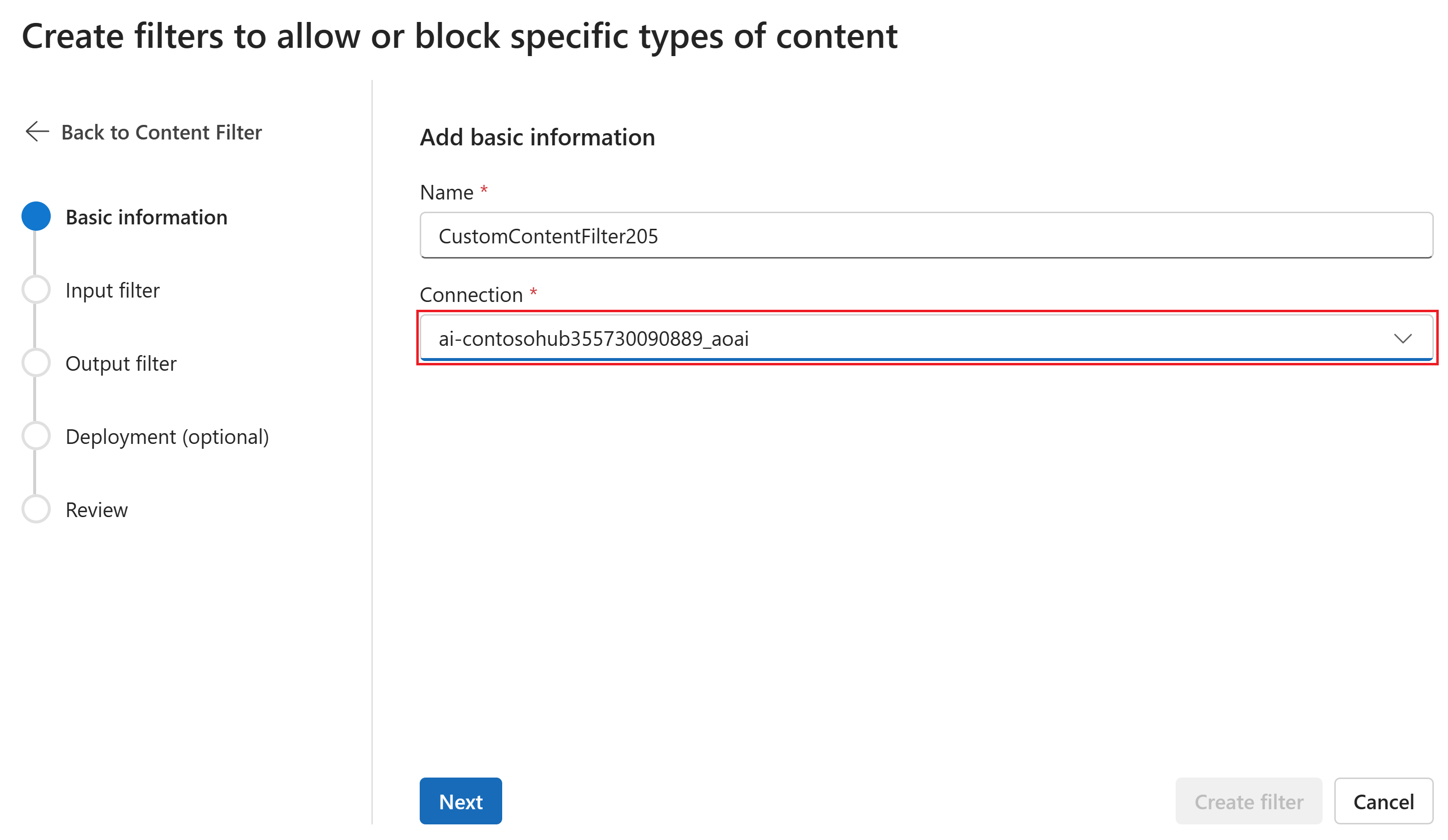

Na stronie Informacje podstawowe wprowadź nazwę konfiguracji filtrowania zawartości. Wybierz połączenie, które ma być skojarzone z filtrem zawartości. Następnie kliknij przycisk Dalej.

Teraz można skonfigurować filtry wejściowe (dla monitów użytkownika) i filtry wyjściowe (na potrzeby uzupełniania modelu).

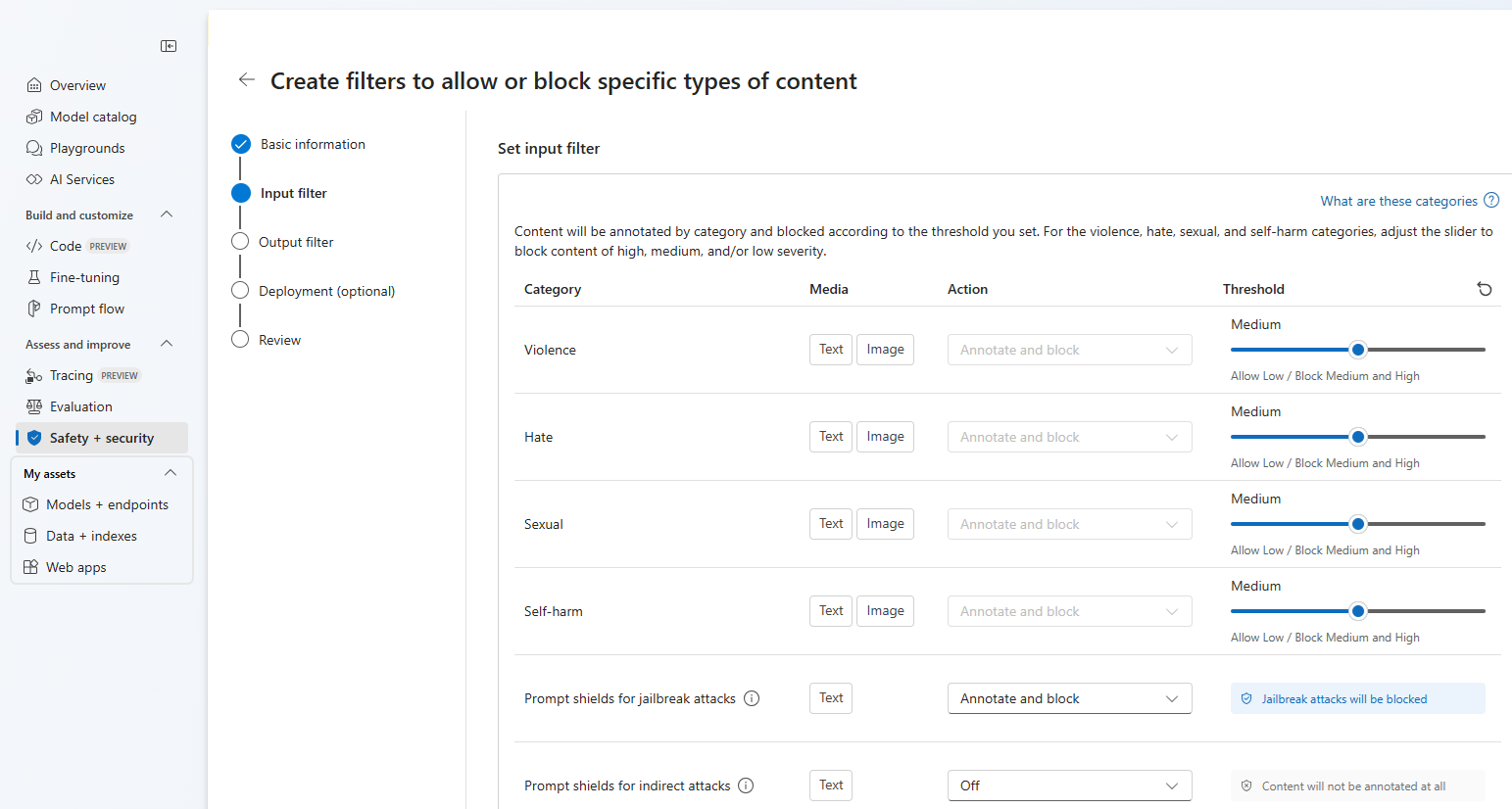

Na stronie Filtry wejściowe można ustawić filtr monitu wejściowego. W przypadku pierwszych czterech kategorii zawartości istnieją trzy poziomy ważności, które można skonfigurować: Niski, średni i wysoki. Możesz użyć suwaków, aby ustawić próg ważności, jeśli określisz, że aplikacja lub scenariusz użycia wymaga innego filtrowania niż wartości domyślne. Niektóre filtry, takie jak Monituj osłony i wykrywanie chronionych materiałów, umożliwiają określenie, czy model powinien dodawać adnotacje i/lub blokować zawartość. Wybranie pozycji Adnotacja powoduje uruchomienie odpowiedniego modelu i zwrócenie adnotacji za pośrednictwem odpowiedzi interfejsu API, ale nie spowoduje filtrowania zawartości. Oprócz dodawania adnotacji możesz również zablokować zawartość.

Jeśli twój przypadek użycia został zatwierdzony dla zmodyfikowanych filtrów zawartości, otrzymasz pełną kontrolę nad konfiguracjami filtrowania zawartości i możesz włączyć filtrowanie częściowo lub całkowicie wyłączone lub włączyć adnotacje tylko dla kategorii szkód związanych z zawartością (przemoc, nienawiść, seks i samookaleczenie).

Zawartość zostanie oznaczona adnotacją według kategorii i zablokowana zgodnie z ustawionym progiem. W przypadku kategorii przemocy, nienawiści, seksualnej i samookaleczenia dostosuj suwak, aby zablokować zawartość o wysokiej, średniej lub niskiej ważności.

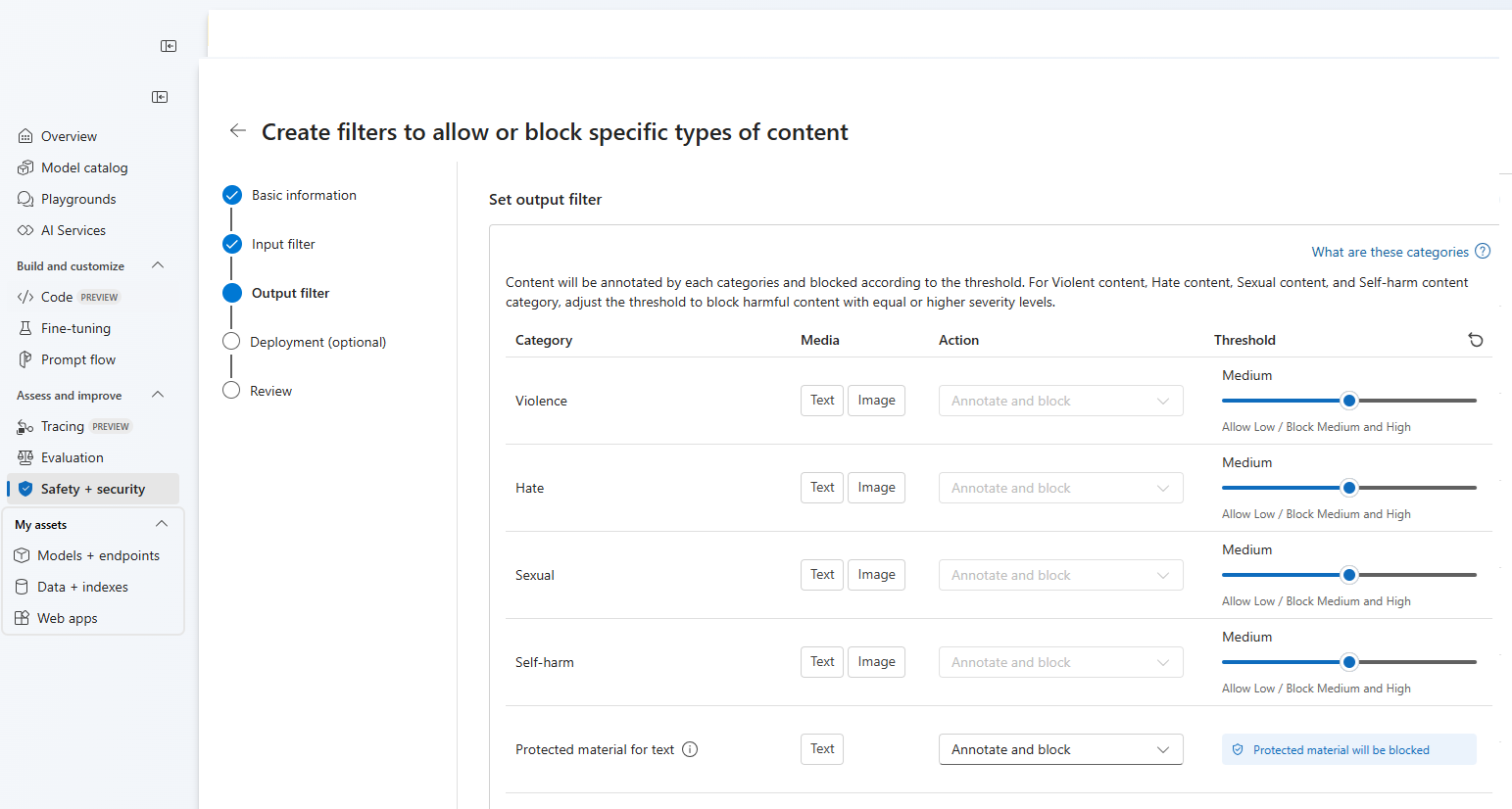

Na stronie Filtry wyjściowe można skonfigurować filtr wyjściowy, który zostanie zastosowany do całej zawartości wyjściowej wygenerowanej przez model. Skonfiguruj poszczególne filtry tak jak poprzednio. Ta strona zawiera również opcję Tryb przesyłania strumieniowego, która umożliwia filtrowanie zawartości niemal w czasie rzeczywistym w miarę generowania przez model, co zmniejsza opóźnienie. Po zakończeniu wybierz pozycję Dalej.

Zawartość zostanie oznaczona adnotacjami dla każdej kategorii i zablokowana zgodnie z progiem. W przypadku treści brutalnych, treści z nienawiści, treści seksualnych i kategorii treści samookaleczenia dostosuj próg, aby zablokować szkodliwą zawartość z równym lub wyższym poziomem ważności.

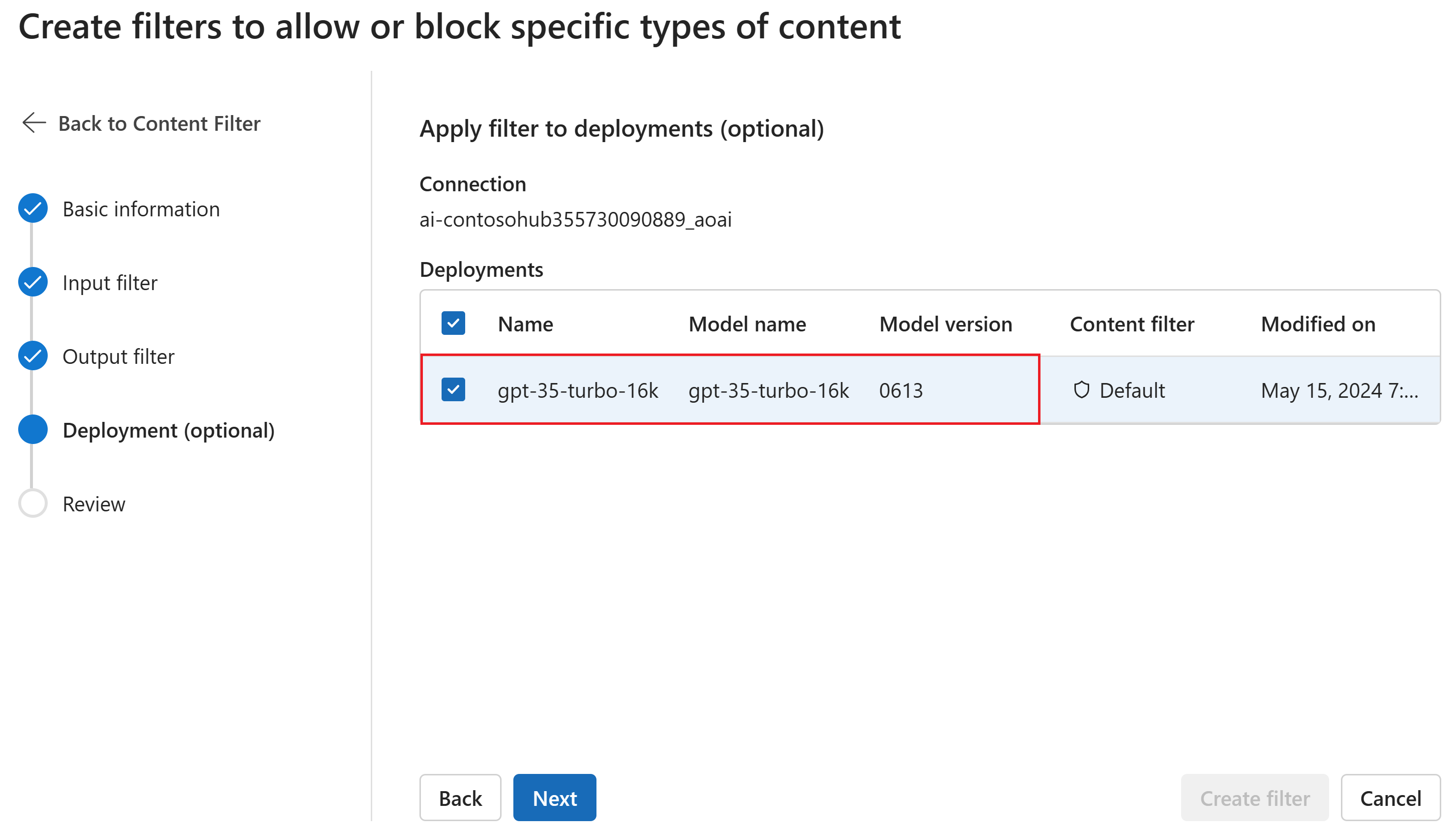

Opcjonalnie na stronie Wdrożenie można skojarzyć filtr zawartości z wdrożeniem. Jeśli wybrane wdrożenie ma już dołączony filtr, musisz potwierdzić, że chcesz go zamienić. Filtr zawartości można również skojarzyć z wdrożeniem później. Wybierz pozycję Utwórz.

Konfiguracje filtrowania zawartości są tworzone na poziomie centrum w portalu usługi Azure AI Foundry. Dowiedz się więcej o możliwościach konfiguracji w dokumentacji usługi Azure OpenAI Service.

Na stronie Przegląd przejrzyj ustawienia, a następnie wybierz pozycję Utwórz filtr.

Używanie listy bloków jako filtru

Możesz zastosować listę blokowania jako filtr wejściowy lub wyjściowy, lub oba. Włącz opcję Lista bloków na stronie Filtr danych wejściowych i/lub Filtr danych wyjściowych. Wybierz jedną lub więcej list blokowania z listy rozwijanej lub użyj wbudowanej listy blokowania wulgaryzmów. Możesz łączyć wiele list blokowania w tym samym filtrze.

Stosowanie filtru zawartości

Proces tworzenia filtru umożliwia zastosowanie filtru do żądanych wdrożeń. Możesz również w dowolnym momencie zmieniać lub usuwać filtry zawartości z wdrożeń.

Wykonaj następujące kroki, aby zastosować filtr zawartości do wdrożenia:

Przejdź do usługi Azure AI Foundry i wybierz projekt.

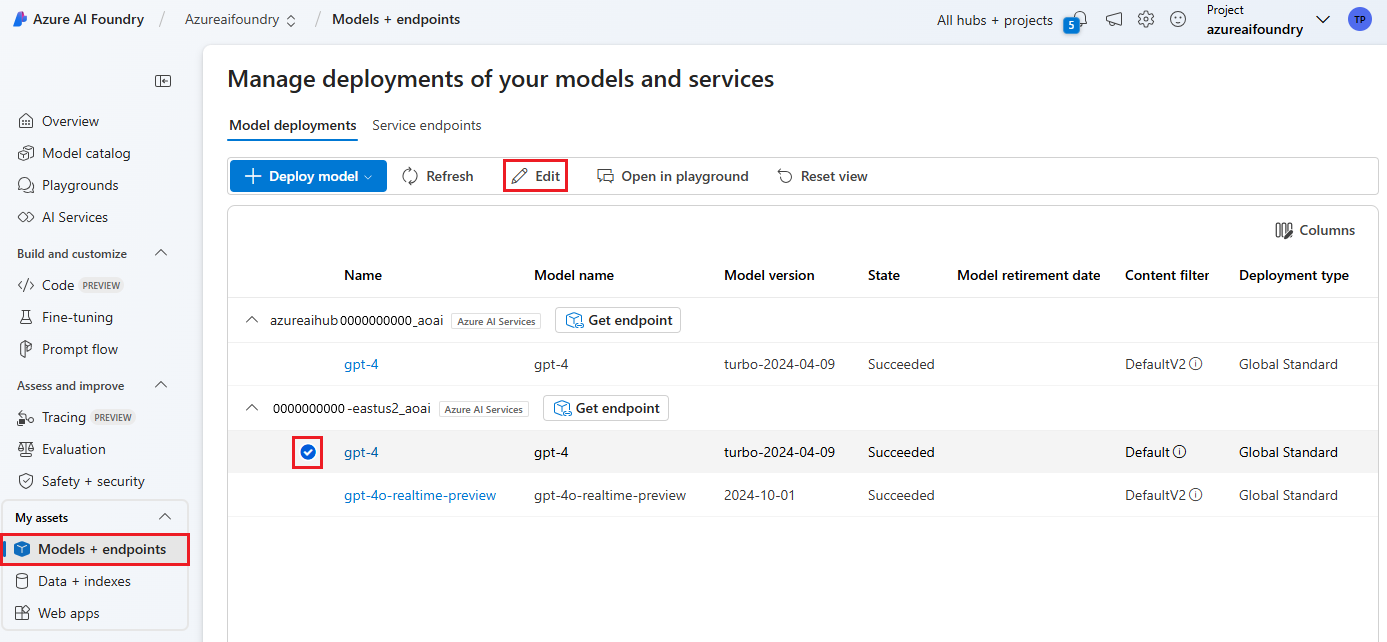

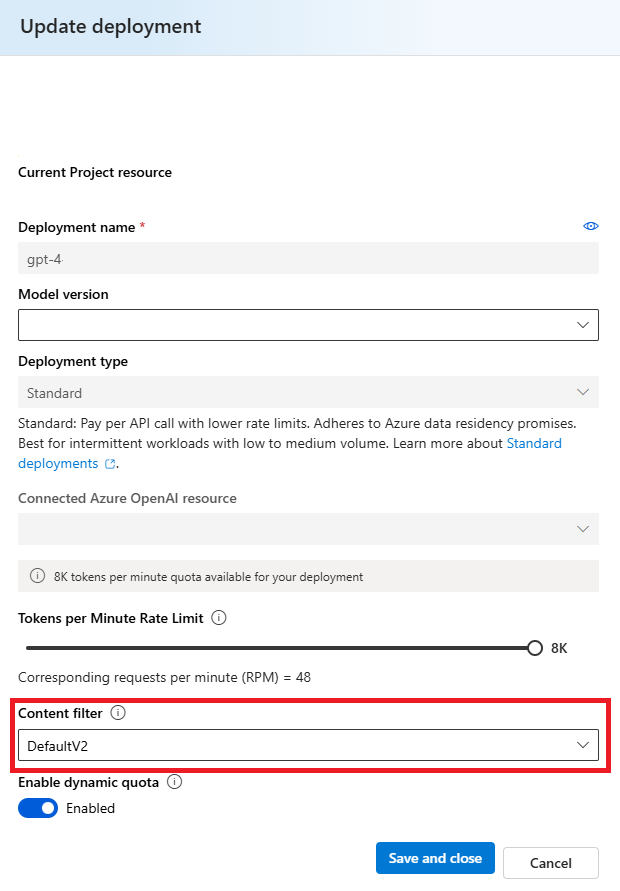

Wybierz pozycję Modele i punkty końcowe w okienku po lewej stronie i wybierz jedno z wdrożeń, a następnie wybierz pozycję Edytuj.

W oknie Wdrażanie aktualizacji wybierz filtr zawartości, który chcesz zastosować do wdrożenia. Następnie wybierz pozycję Zapisz i zamknij.

W razie potrzeby można również edytować i usuwać konfigurację filtru zawartości. Przed usunięciem konfiguracji filtrowania zawartości należy cofnąć przypisanie i zastąpić je z dowolnego wdrożenia na karcie Wdrożenia.

Teraz możesz przejść do placu zabaw, aby sprawdzić, czy filtr zawartości działa zgodnie z oczekiwaniami.

Zgłaszanie opinii dotyczących filtrowania zawartości

Jeśli napotkasz problem z filtrowaniem zawartości, wybierz przycisk Filtruj opinie w górnej części placu zabaw. Ta opcja jest włączona na placu zabaw Obrazy, Czat i Ukończenie po przesłaniu monitu.

Po wyświetleniu okna dialogowego wybierz odpowiedni problem z filtrowaniem zawartości. Uwzględnij jak najwięcej szczegółów dotyczących problemu z filtrowaniem zawartości, takich jak określony monit i napotkany błąd filtrowania zawartości. Nie dołączaj żadnych prywatnych ani poufnych informacji.

Aby uzyskać pomoc techniczną, prześlij bilet pomocy technicznej.

Postępuj zgodnie z najlepszymi rozwiązaniami

Zalecamy informowanie o decyzjach dotyczących konfiguracji filtrowania zawartości za pomocą iteracyjnej identyfikacji (na przykład testowania czerwonego zespołu, testowania obciążenia i analizy) oraz procesu pomiaru w celu rozwiązania potencjalnych szkód, które są istotne dla konkretnego modelu, aplikacji i scenariusza wdrażania. Po zaimplementowaniu środków zaradczych, takich jak filtrowanie zawartości, powtórz pomiar w celu przetestowania skuteczności. Rekomendacje i najlepsze rozwiązania dotyczące odpowiedzialnej sztucznej inteligencji dla usługi Azure OpenAI, zakorzenione w standardzie Odpowiedzialnej sztucznej inteligencji firmy Microsoft, można znaleźć w temacie Odpowiedzialne używanie sztucznej inteligencji — omówienie usługi Azure OpenAI.

Powiązana zawartość

- Dowiedz się więcej o praktykach dotyczących odpowiedzialnej sztucznej inteligencji dla usługi Azure OpenAI: omówienie praktyk dotyczących odpowiedzialnej sztucznej inteligencji dla modeli azure OpenAI.

- Przeczytaj więcej na temat kategorii filtrowania zawartości i poziomów ważności za pomocą usługi Azure AI Foundry.

- Dowiedz się więcej na temat red teaming from our: Introduction to red teaming large language models (LLMs) (Wprowadzenie do tworzenia zespołu red teaming large language models, LLMs).