Dodawanie i konfigurowanie modeli do wnioskowania modelu AI platformy Azure

Ważne

Elementy oznaczone (wersja zapoznawcza) w tym artykule są obecnie dostępne w publicznej wersji zapoznawczej. Ta wersja zapoznawcza jest udostępniana bez umowy dotyczącej poziomu usług i nie zalecamy korzystania z niej w przypadku obciążeń produkcyjnych. Niektóre funkcje mogą być nieobsługiwane lub ograniczone. Aby uzyskać więcej informacji, zobacz Uzupełniające warunki korzystania z wersji zapoznawczych platformy Microsoft Azure.

Możesz zdecydować i skonfigurować, które modele są dostępne do wnioskowania w punkcie końcowym wnioskowania. Po skonfigurowaniu danego modelu można wygenerować z niego przewidywania, wskazując jego nazwę modelu lub nazwę wdrożenia na żądaniach. Do użycia w kodzie nie są wymagane żadne dalsze zmiany.

W tym artykule dowiesz się, jak dodać nowy model do wnioskowania modelu AI platformy Azure w usłudze Azure AI Foundry.

Wymagania wstępne

Aby ukończyć pracę z tym artykułem, potrzebne są następujące zasoby:

Subskrypcja Azure. Jeśli używasz modeli GitHub, możesz uaktualnić środowisko i utworzyć subskrypcję platformy Azure w tym procesie. Przeczytaj artykuł Upgrade from GitHub Models to Azure AI model inference if's your case (Uaktualnianie modeli Usługi GitHub do wnioskowania modelu AI platformy Azure), jeśli tak jest.

Zasób usług AI platformy Azure.

Projekt sztucznej inteligencji połączony z zasobem usług Azure AI z funkcją Wdrażanie modeli w usłudze wnioskowania modelu AI platformy Azure.

- Możesz wykonać kroki opisane w artykule Configure Azure AI model inference service inference service in my project in my project in Azure AI Foundry (Konfigurowanie usługi wnioskowania modelu sztucznej inteligencji platformy Azure w moim projekcie w usłudze Azure AI Foundry).

Dodaj model

Modele można dodać do punktu końcowego wnioskowania modelu AI platformy Azure, wykonując następujące kroki:

Przejdź do sekcji Katalog modeli w portalu usługi Azure AI Foundry.

Przewiń do interesującego Cię modelu i wybierz go.

Szczegóły modelu można przejrzeć na karcie modelu.

Wybierz Wdróż.

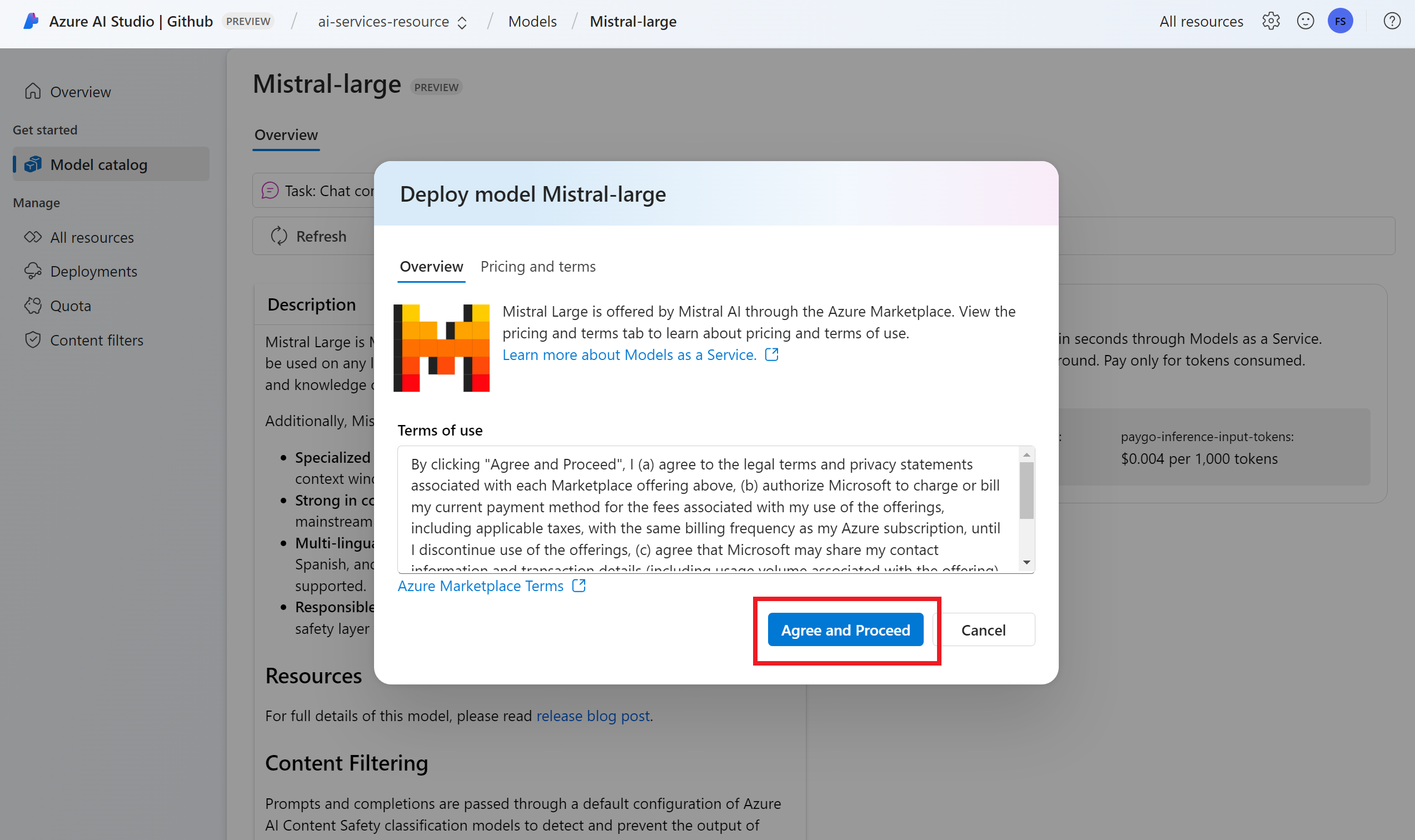

W przypadku dostawców modeli wymagających większej liczby warunków umowy zostanie wyświetlony monit o zaakceptowanie tych warunków. Dotyczy to na przykład modeli Mistral. Zaakceptuj warunki w tych przypadkach, wybierając pozycję Subskrybuj i wdróż.

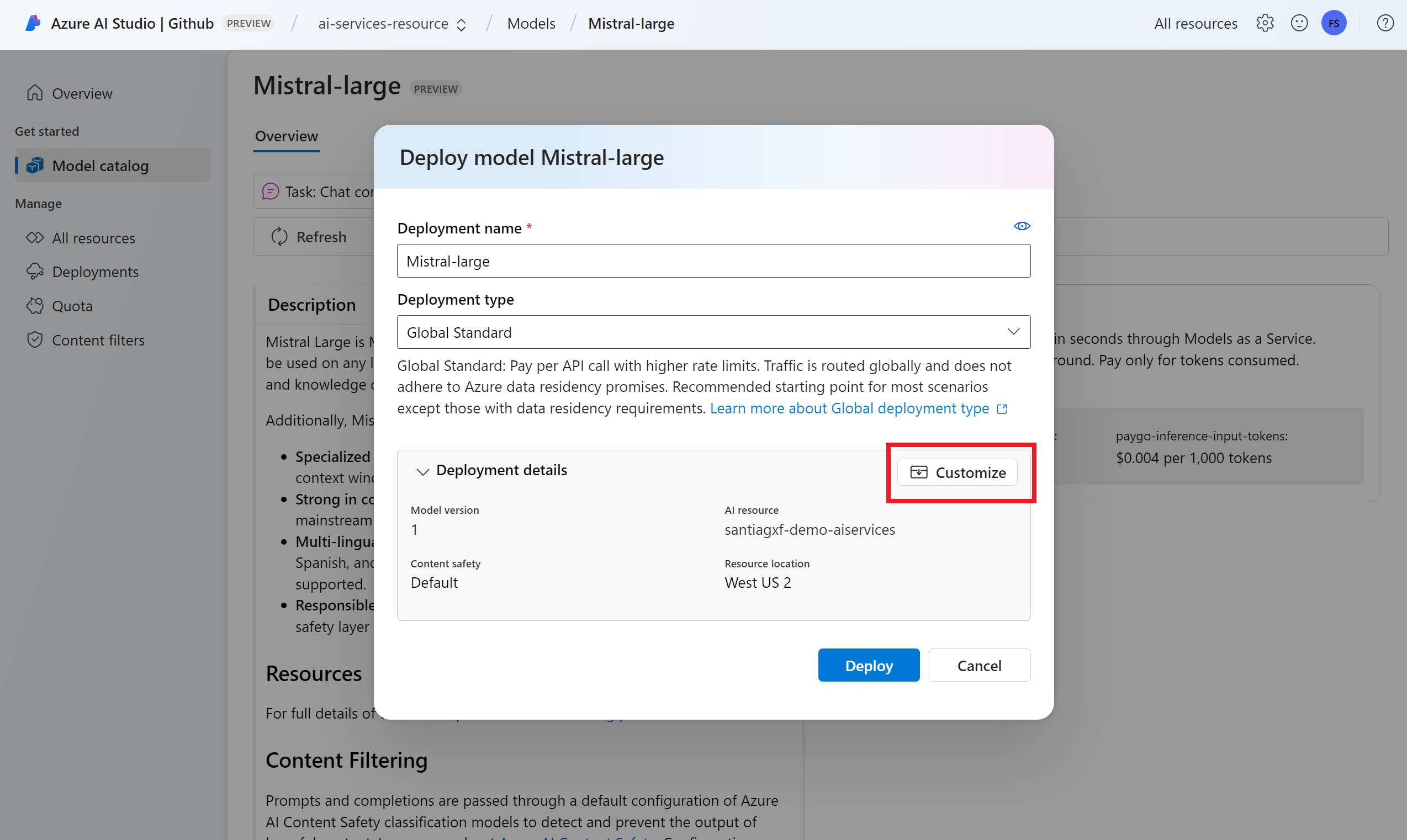

W tej chwili można skonfigurować ustawienia wdrożenia. Domyślnie wdrożenie otrzymuje nazwę wdrażanego modelu. Nazwa wdrożenia jest używana w parametrze

modelżądania do kierowania do tego konkretnego wdrożenia modelu. Umożliwia to również skonfigurowanie określonych nazw modeli podczas dołączania określonych konfiguracji. Na przykłado1-preview-safedla modelu z rygorystycznym filtrem zawartości bezpieczeństwa zawartości.Napiwek

Każdy model może obsługiwać różne typy wdrożeń, zapewniając różne gwarancje rezydencji danych lub przepływności. Aby uzyskać więcej informacji, zobacz Typy wdrożeń.

Automatycznie wybieramy połączenie usług Azure AI Services w zależności od projektu. Użyj opcji Dostosuj, aby zmienić połączenie na podstawie Twoich potrzeb. Jeśli wdrażasz w ramach standardowego typu wdrożenia, modele muszą być dostępne w regionie zasobu usługi Azure AI Services.

Napiwek

Jeśli żądany zasób nie znajduje się na liście, może być konieczne utworzenie połączenia z nim. Zobacz Konfigurowanie usługi wnioskowania modelu AI platformy Azure w moim projekcie w portalu Azure AI Foundry.

Wybierz Wdróż.

Po zakończeniu wdrażania nowy model zostanie wyświetlony na stronie i będzie gotowy do użycia.

Zarządzanie modelami

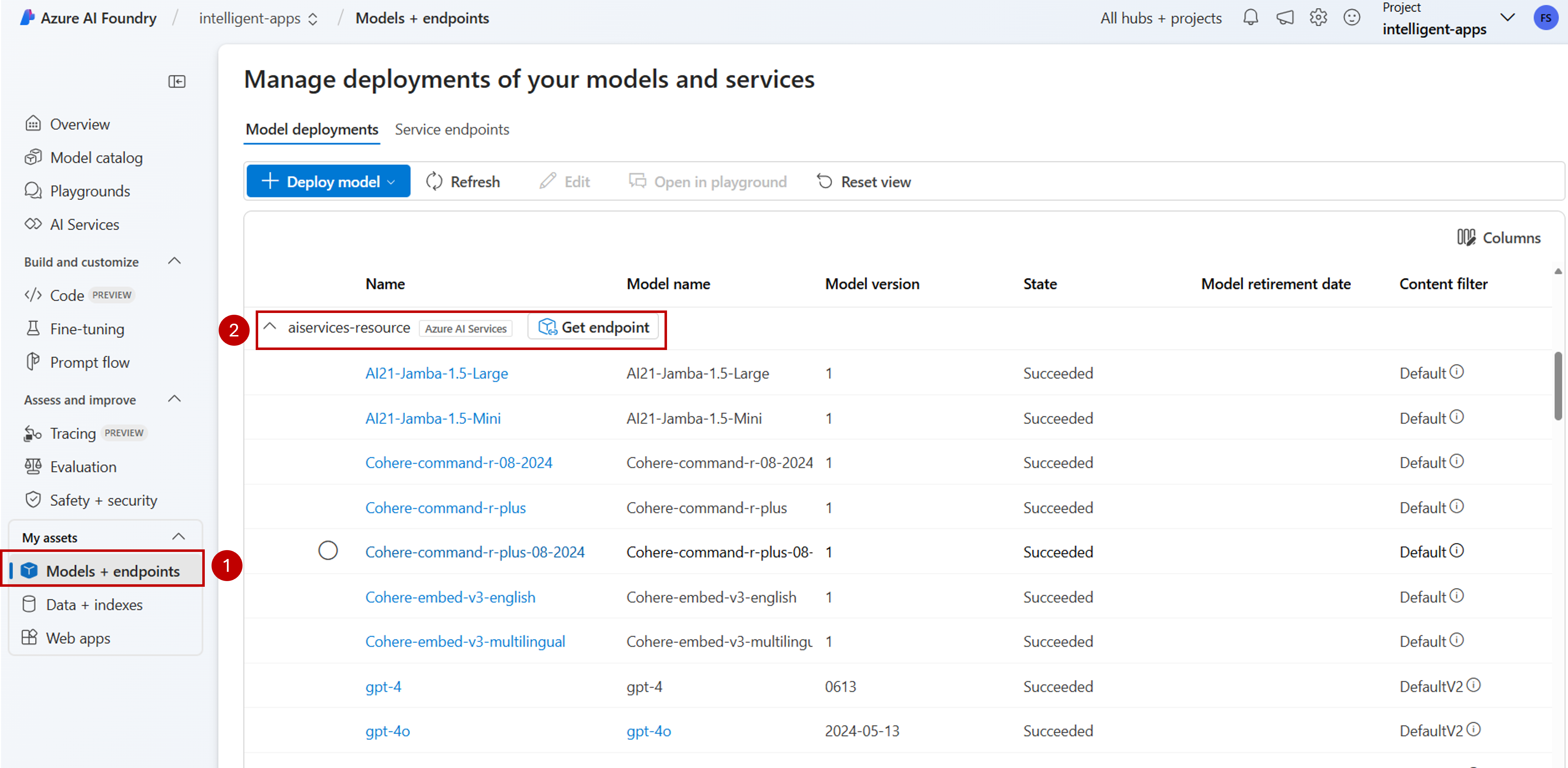

Istniejące wdrożenia modelu można zarządzać w zasobie przy użyciu portalu azure AI Foundry.

Przejdź do sekcji Modele i punkty końcowe w portalu usługi Azure AI Foundry.

Przewiń do połączenia z zasobem usług Azure AI Services. Wdrożenia modelu są grupowane i wyświetlane na połączenie.

Zostanie wyświetlona lista modeli dostępnych w ramach każdego połączenia. Wybierz interesujące Cię wdrożenie modelu.

Edytuj lub usuń wdrożenie zgodnie z potrzebami.

Testowanie wdrożenia na placu zabaw

Nowy model można wchodzić w interakcję z nowym modelem w portalu Azure AI Foundry przy użyciu placu zabaw:

Uwaga

Plac zabaw jest dostępny tylko podczas pracy z projektami sztucznej inteligencji w narzędziu Azure AI Foundry. Utwórz projekt sztucznej inteligencji, aby uzyskać pełny dostęp do wszystkich funkcji usługi Azure AI Foundry.

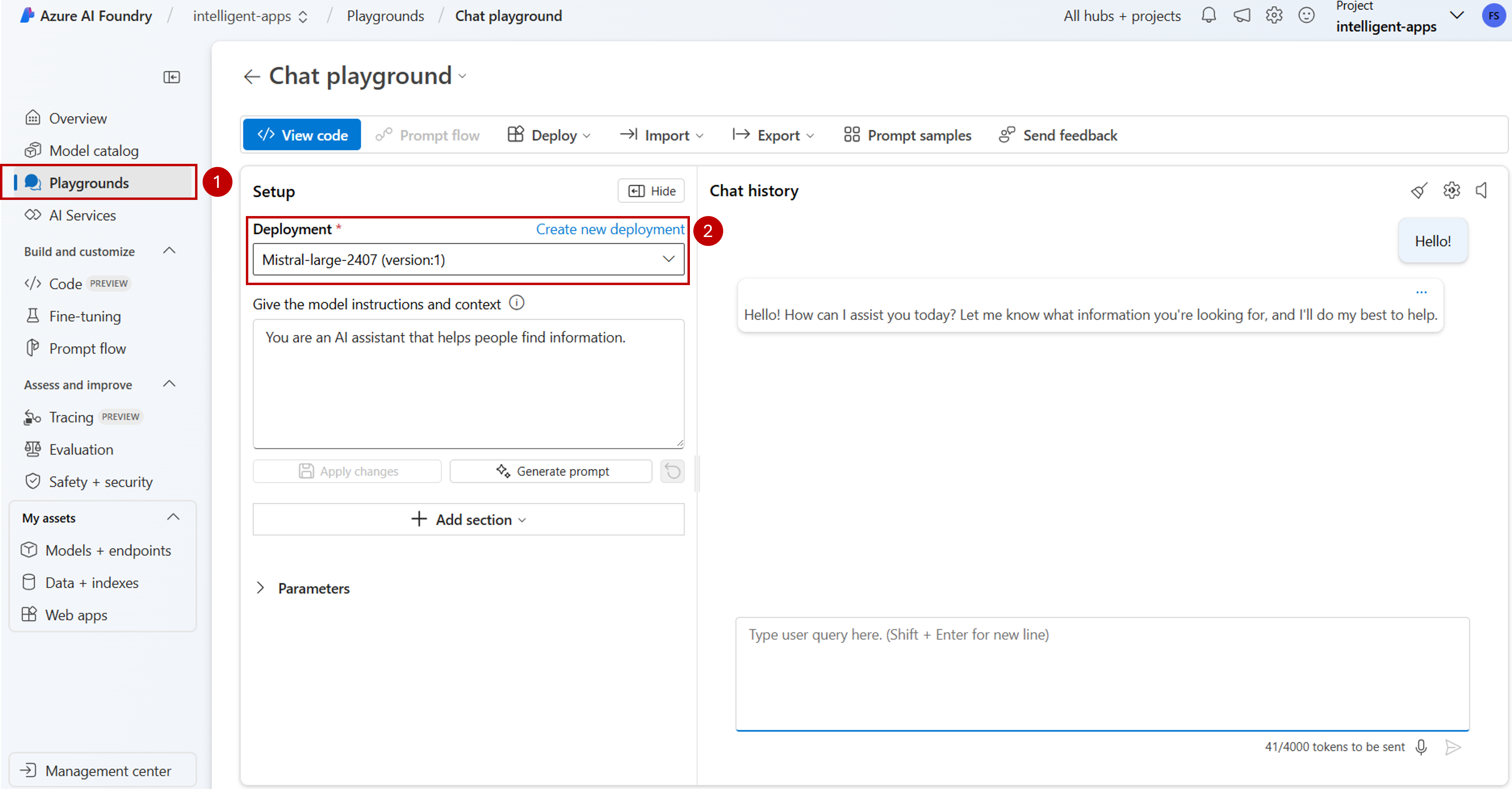

Przejdź do sekcji Place zabaw w portalu usługi Azure AI Foundry.

W zależności od typu wdrożonego modelu wybierz wymagany plac zabaw. W tym przypadku wybierzemy pozycję Plac zabaw czatu.

Na liście rozwijanej Wdrożenie w obszarze Konfiguracja wybierz nazwę utworzonego wdrożenia modelu.

Wpisz monit i wyświetl dane wyjściowe.

Ponadto możesz użyć opcji Wyświetl kod , aby wyświetlić szczegółowe informacje o sposobie programowego uzyskiwania dostępu do wdrożenia modelu.

Ważne

Elementy oznaczone (wersja zapoznawcza) w tym artykule są obecnie dostępne w publicznej wersji zapoznawczej. Ta wersja zapoznawcza jest udostępniana bez umowy dotyczącej poziomu usług i nie zalecamy korzystania z niej w przypadku obciążeń produkcyjnych. Niektóre funkcje mogą być nieobsługiwane lub ograniczone. Aby uzyskać więcej informacji, zobacz Uzupełniające warunki korzystania z wersji zapoznawczych platformy Microsoft Azure.

Możesz zdecydować i skonfigurować, które modele są dostępne do wnioskowania w punkcie końcowym wnioskowania. Po skonfigurowaniu danego modelu można wygenerować z niego przewidywania, wskazując jego nazwę modelu lub nazwę wdrożenia na żądaniach. Do użycia w kodzie nie są wymagane żadne dalsze zmiany.

W tym artykule dowiesz się, jak dodać nowy model do wnioskowania modelu AI platformy Azure w usłudze Azure AI Foundry.

Wymagania wstępne

Aby ukończyć pracę z tym artykułem, potrzebne są następujące zasoby:

Subskrypcja Azure. Jeśli używasz modeli GitHub, możesz uaktualnić środowisko i utworzyć subskrypcję platformy Azure w tym procesie. Przeczytaj artykuł Upgrade from GitHub Models to Azure AI model inference if's your case (Uaktualnianie modeli Usługi GitHub do wnioskowania modelu AI platformy Azure), jeśli tak jest.

Zasób usług AI platformy Azure.

Zainstaluj interfejs wiersza polecenia platformy Azure i

cognitiveservicesrozszerzenie dla usług Azure AI:az extension add -n cognitiveservicesNiektóre polecenia w tym samouczku używają

jqnarzędzia, które może nie być zainstalowane w systemie. Aby uzyskać instrukcje dotyczące instalacji, zobacz Pobieraniejqpliku .Zidentyfikuj następujące informacje:

Identyfikator subskrypcji platformy Azure.

Nazwa zasobu usług Azure AI Services.

Grupa zasobów, w której wdrożono zasób usług Azure AI Services.

Dodawanie modeli

Aby dodać model, należy najpierw zidentyfikować model, który chcesz wdrożyć. Dostępne modele można wykonywać w następujący sposób:

Zaloguj się do subskrypcji platformy Azure:

az loginJeśli masz więcej niż 1 subskrypcję, wybierz subskrypcję, w której znajduje się zasób:

az account set --subscription $subscriptionId>Ustaw następujące zmienne środowiskowe z nazwą zasobu usług Azure AI Services, którego chcesz użyć, i grupę zasobów.

accountName="<ai-services-resource-name>" resourceGroupName="<resource-group>"Jeśli nie masz jeszcze utworzonego konta usług Azure AI Services, możesz go utworzyć w następujący sposób:

az cognitiveservices account create -n $accountName -g $resourceGroupName --custom-domain $accountNameNajpierw zobaczmy, które modele są dostępne dla Ciebie i w ramach której jednostki SKU. Poniższe polecenie wyświetli listę wszystkich dostępnych definicji modelu:

az cognitiveservices account list-models \ -n $accountName \ -g $resourceGroupName \ | jq '.[] | { name: .name, format: .format, version: .version, sku: .skus[0].name, capacity: .skus[0].capacity.default }'Dane wyjściowe wyglądają następująco:

{ "name": "Phi-3.5-vision-instruct", "format": "Microsoft", "version": "2", "sku": "GlobalStandard", "capacity": 1 }Zidentyfikuj model, który chcesz wdrożyć. Potrzebne są właściwości

name, ,formatversionisku. Pojemność może być również potrzebna w zależności od typu wdrożenia.Napiwek

Zwróć uwagę, że nie wszystkie modele są dostępne we wszystkich jednostkach SKU.

Dodaj wdrożenie modelu do zasobu. W poniższym przykładzie dodano polecenie

Phi-3.5-vision-instruct:az cognitiveservices account deployment create \ -n $accountName \ -g $resourceGroupName \ --deployment-name Phi-3.5-vision-instruct \ --model-name Phi-3.5-vision-instruct \ --model-version 2 \ --model-format Microsoft \ --sku-capacity 1 \ --sku-name GlobalStandardModel jest gotowy do użycia.

Ten sam model można wdrożyć wiele razy, jeśli jest to konieczne, o ile ma inną nazwę wdrożenia. Ta funkcja może być przydatna w przypadku, gdy chcesz przetestować różne konfiguracje dla danego modelu, w tym bezpieczeństwo zawartości.

Zarządzanie wdrożeniami

Wszystkie wdrożenia są dostępne przy użyciu interfejsu wiersza polecenia:

Uruchom następujące polecenie, aby wyświetlić wszystkie aktywne wdrożenia:

az cognitiveservices account deployment list -n $accountName -g $resourceGroupNameSzczegółowe informacje o danym wdrożeniu można zobaczyć:

az cognitiveservices account deployment show \ --deployment-name "Phi-3.5-vision-instruct" \ -n $accountName \ -g $resourceGroupNameMożesz usunąć dane wdrożenie w następujący sposób:

az cognitiveservices account deployment delete \ --deployment-name "Phi-3.5-vision-instruct" \ -n $accountName \ -g $resourceGroupName

Korzystanie z modelu

Wdrożone modele w wnioskowaniu modelu AI platformy Azure można używać przy użyciu punktu końcowego wnioskowania modelu AI platformy Azure dla zasobu. Podczas konstruowania żądania wskaż parametr model i wstaw utworzoną nazwę wdrożenia modelu. Identyfikator URI punktu końcowego wnioskowania można uzyskać programowo przy użyciu następującego kodu:

Punkt końcowy wnioskowania

az cognitiveservices account show -n $accountName -g $resourceGroupName | jq '.properties.endpoints["Azure AI Model Inference API"]'

Aby wysyłać żądania do punktu końcowego wnioskowania modelu AI platformy Azure, dołącz trasę models, na przykład https://<resource>.services.ai.azure.com/models. Dokumentacja interfejsu API dla punktu końcowego jest widoczna na stronie dokumentacji interfejsu API wnioskowania modelu AI platformy Azure.

Klucze wnioskowania

az cognitiveservices account keys list -n $accountName -g $resourceGroupName

Ważne

Elementy oznaczone (wersja zapoznawcza) w tym artykule są obecnie dostępne w publicznej wersji zapoznawczej. Ta wersja zapoznawcza jest udostępniana bez umowy dotyczącej poziomu usług i nie zalecamy korzystania z niej w przypadku obciążeń produkcyjnych. Niektóre funkcje mogą być nieobsługiwane lub ograniczone. Aby uzyskać więcej informacji, zobacz Uzupełniające warunki korzystania z wersji zapoznawczych platformy Microsoft Azure.

Możesz zdecydować i skonfigurować, które modele są dostępne do wnioskowania w punkcie końcowym wnioskowania. Po skonfigurowaniu danego modelu można wygenerować z niego przewidywania, wskazując jego nazwę modelu lub nazwę wdrożenia na żądaniach. Do użycia w kodzie nie są wymagane żadne dalsze zmiany.

W tym artykule dowiesz się, jak dodać nowy model do wnioskowania modelu AI platformy Azure w usłudze Azure AI Foundry.

Wymagania wstępne

Aby ukończyć pracę z tym artykułem, potrzebne są następujące zasoby:

Subskrypcja Azure. Jeśli używasz modeli GitHub, możesz uaktualnić środowisko i utworzyć subskrypcję platformy Azure w tym procesie. Przeczytaj artykuł Upgrade from GitHub Models to Azure AI model inference if's your case (Uaktualnianie modeli Usługi GitHub do wnioskowania modelu AI platformy Azure), jeśli tak jest.

Zasób usług AI platformy Azure.

Zainstaluj interfejs wiersza polecenia platformy Azure.

Zidentyfikuj następujące informacje:

Identyfikator subskrypcji platformy Azure.

Nazwa zasobu usług Azure AI Services.

Grupa zasobów, w której wdrożono zasób usług Azure AI Services.

Nazwa modelu, dostawca, wersja i jednostka SKU, którą chcesz wdrożyć. Aby go zidentyfikować, możesz użyć portalu azure AI Foundry lub interfejsu wiersza polecenia platformy Azure. W tym przykładzie wdrożymy następujący model:

-

Nazwa modelu::

Phi-3.5-vision-instruct -

Dostawca:

Microsoft -

Wersja:

2 - Typ wdrożenia: Globalny standard

-

Nazwa modelu::

Informacje o tym samouczku

Przykład w tym artykule jest oparty na przykładach kodu zawartych w repozytorium Azure-Samples/azureai-model-inference-bicep . Aby uruchomić polecenia lokalnie bez konieczności kopiowania lub wklejania zawartości pliku, użyj następujących poleceń, aby sklonować repozytorium i przejść do folderu dla języka kodowania:

git clone https://github.com/Azure-Samples/azureai-model-inference-bicep

Pliki dla tego przykładu znajdują się w następujących elementach:

cd azureai-model-inference-bicep/infra

Dodawanie modelu

Użyj szablonu

ai-services-deployment-template.bicep, aby opisać wdrożenia modelu:ai-services-deployment-template.bicep

@description('Name of the Azure AI services account') param accountName string @description('Name of the model to deploy') param modelName string @description('Version of the model to deploy') param modelVersion string @allowed([ 'AI21 Labs' 'Cohere' 'Core42' 'DeepSeek' 'Meta' 'Microsoft' 'Mistral AI' 'OpenAI' ]) @description('Model provider') param modelPublisherFormat string @allowed([ 'GlobalStandard' 'Standard' 'GlobalProvisioned' 'Provisioned' ]) @description('Model deployment SKU name') param skuName string = 'GlobalStandard' @description('Content filter policy name') param contentFilterPolicyName string = 'Microsoft.DefaultV2' @description('Model deployment capacity') param capacity int = 1 resource modelDeployment 'Microsoft.CognitiveServices/accounts/deployments@2024-04-01-preview' = { name: '${accountName}/${modelName}' sku: { name: skuName capacity: capacity } properties: { model: { format: modelPublisherFormat name: modelName version: modelVersion } raiPolicyName: contentFilterPolicyName == null ? 'Microsoft.Nill' : contentFilterPolicyName } }Uruchom wdrożenie:

RESOURCE_GROUP="<resource-group-name>" ACCOUNT_NAME="<azure-ai-model-inference-name>" MODEL_NAME="Phi-3.5-vision-instruct" PROVIDER="Microsoft" VERSION=2 az deployment group create \ --resource-group $RESOURCE_GROUP \ --template-file ai-services-deployment-template.bicep \ --parameters accountName=$ACCOUNT_NAME modelName=$MODEL_NAME modelVersion=$VERSION modelPublisherFormat=$PROVIDER

Korzystanie z modelu

Wdrożone modele w wnioskowaniu modelu AI platformy Azure można używać przy użyciu punktu końcowego wnioskowania modelu AI platformy Azure dla zasobu. Podczas konstruowania żądania wskaż parametr model i wstaw utworzoną nazwę wdrożenia modelu.