Punkt końcowy wnioskowania modelu w usługach Azure AI Services

Wnioskowanie modelu sztucznej inteligencji platformy Azure w usługach Azure AI umożliwia klientom korzystanie z najbardziej zaawansowanych modeli od flagowych dostawców modeli przy użyciu jednego punktu końcowego i poświadczeń. Oznacza to, że można przełączać się między modelami i korzystać z nich z aplikacji bez konieczności zmieniania pojedynczego wiersza kodu.

W tym artykule wyjaśniono, jak modele są zorganizowane wewnątrz usługi i jak wywoływać je przy użyciu punktu końcowego wnioskowania.

Wdrożenia

Wnioskowanie modelu sztucznej inteligencji platformy Azure udostępnia modele przy użyciu koncepcji wdrażania . Wdrożenia to sposób na nadanie modelowi nazwy w ramach określonych konfiguracji. Następnie można wywołać taką konfigurację modelu, wskazując jego nazwę na żądaniach.

Przechwytywanie wdrożeń:

- Nazwa modelu

- Wersja modelu

- Typ aprowizacji/pojemności1

- Konfiguracjafiltrowania zawartości 1

- Konfiguracjaograniczania szybkości 1

1 Konfiguracje mogą się różnić w zależności od wybranego modelu.

Zasób usług sztucznej inteligencji platformy Azure może mieć dowolną liczbę wdrożeń modelu i nie ponosi kosztów, chyba że wnioskowanie jest wykonywane dla tych modeli. Wdrożenia to zasoby platformy Azure, dlatego podlegają zasadom platformy Azure.

Aby dowiedzieć się więcej na temat tworzenia wdrożeń, zobacz Dodawanie i konfigurowanie wdrożeń modelu.

Punkt końcowy wnioskowania usługi Azure AI

Punkt końcowy wnioskowania sztucznej inteligencji platformy Azure umożliwia klientom używanie pojedynczego punktu końcowego z tym samym uwierzytelnianiem i schematem w celu wygenerowania wnioskowania dla wdrożonych modeli w zasobie. Ten punkt końcowy jest zgodny z interfejsem API wnioskowania modelu AI platformy Azure, który obsługuje wnioskowanie wszystkich modeli w modelu AI platformy Azure. Obsługuje następujące modalidacje:

- Osadzanie tekstu

- Osadzanie obrazów

- Ukończenie czatu

Adres URL i poświadczenia punktu końcowego można wyświetlić w sekcji Przegląd :

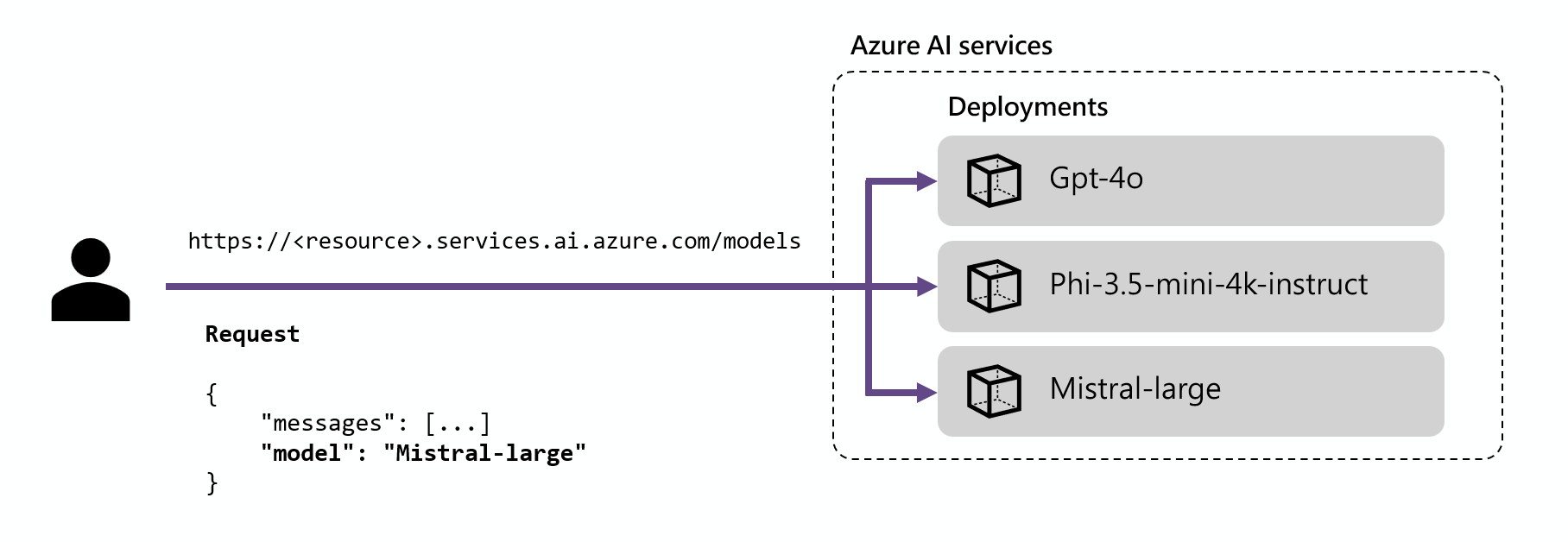

Routing

Punkt końcowy wnioskowania kieruje żądania do danego wdrożenia przez dopasowanie parametru name wewnątrz żądania do nazwy wdrożenia. Oznacza to, że wdrożenia działają jako alias danego modelu w ramach niektórych konfiguracji. Ta elastyczność umożliwia wielokrotne wdrażanie danego modelu w usłudze, ale w różnych konfiguracjach w razie potrzeby.

Jeśli na przykład utworzysz wdrożenie o nazwie Mistral-large, takie wdrożenie można wywołać jako:

Zainstaluj pakiet azure-ai-inference przy użyciu menedżera pakietów, takiego jak:

pip install azure-ai-inference

Następnie możesz użyć pakietu do korzystania z modelu. W poniższym przykładzie pokazano, jak utworzyć klienta w celu korzystania z uzupełniania czatu:

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

model = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZUREAI_ENDPOINT_KEY"]),

)

Zapoznaj się z naszymi przykładami i przeczytaj dokumentację referencyjną interfejsu API, aby rozpocząć pracę.

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

Napiwek

Routing wdrażania nie uwzględnia wielkości liter.

Zestawy SDK

Punkt końcowy wnioskowania modelu AI platformy Azure jest obsługiwany przez wiele zestawów SDK, w tym zestaw SDK wnioskowania usługi Azure AI, zestaw SDK usługi Azure AI Foundry i zestaw AZURE OpenAI SDK, które są dostępne w wielu językach. Wiele integracji jest również obsługiwanych w popularnych strukturach, takich jak LangChain, LangGraph, Llama-Index, Semantic Kernel i AG2. Aby uzyskać szczegółowe informacje, zobacz obsługiwane języki programowania i zestawy SDK .

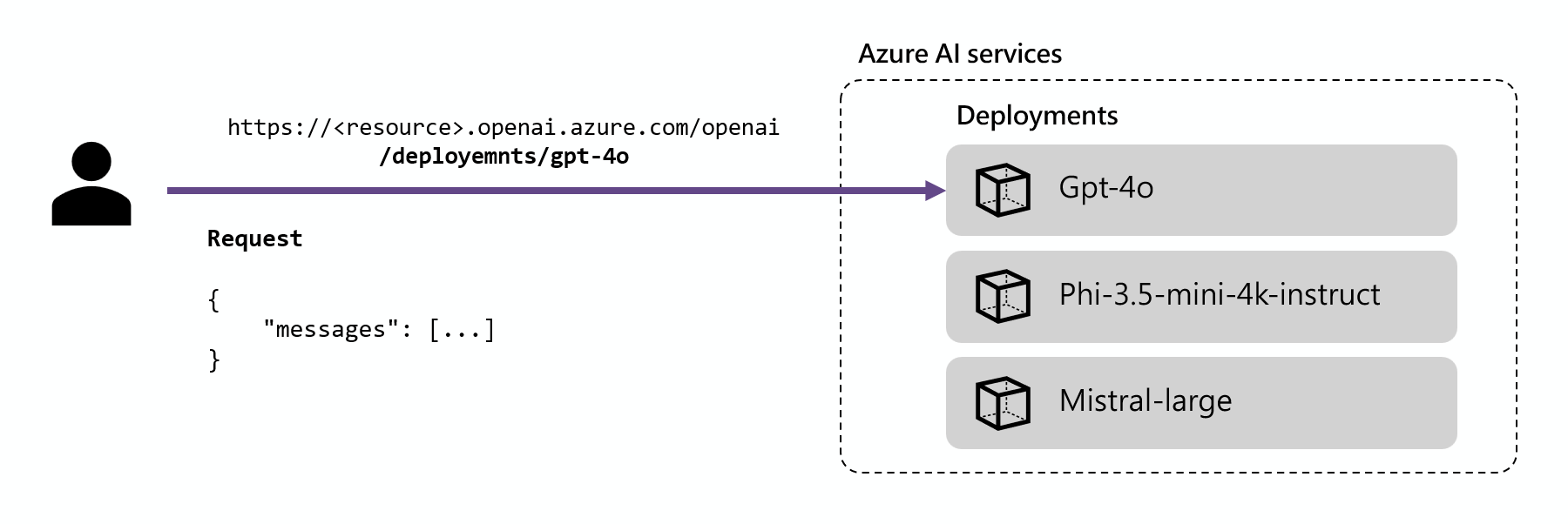

Punkt końcowy wnioskowania usługi Azure OpenAI

Modele usługi Azure OpenAI wdrożone w usługach sztucznej inteligencji obsługują również interfejs API Azure OpenAI. Ten interfejs API udostępnia pełne możliwości modeli OpenAI i obsługuje dodatkowe funkcje, takie jak asystenci, wątki, pliki i wnioskowanie wsadowe.

Punkty końcowe wnioskowania usługi Azure OpenAI działają na poziomie wdrożenia i mają własny adres URL skojarzony z każdym z nich. Jednak ten sam mechanizm uwierzytelniania może służyć do ich użycia. Dowiedz się więcej na stronie referencyjnej interfejsu API usługi Azure OpenAI

Każde wdrożenie ma adres URL, który jest połączeniem podstawowego adresu URL usługi Azure OpenAI i trasy /deployments/<model-deployment-name>.

Ważne

Nie ma mechanizmu routingu dla punktu końcowego usługi Azure OpenAI, ponieważ każdy adres URL jest wyłączny dla każdego wdrożenia modelu.

Zestawy SDK

Punkt końcowy usługi Azure OpenAI jest obsługiwany przez zestawy OPENAI SDK (AzureOpenAI klasa) i zestawy SDK usługi Azure OpenAI, które są dostępne w wielu językach. Aby uzyskać szczegółowe informacje, zobacz obsługiwane języki .