Gegevens opnemen in Fabric met behulp van de Azure Data Factory-Copy-activiteit

De Microsoft Fabric Lakehouse-connector in Azure Data Factory (ADF) en Azure Synapse Analytics maakt zowel lees- als schrijfbewerkingen mogelijk naar Microsoft Fabric Lakehouse (zowel voor tabellen als bestanden). Deze connector biedt u de mogelijkheid om uw bestaande ADF- en Synapse-pijplijnen en toewijzings-Gegevensstroom s te gebruiken om te communiceren met Fabric Lakehouses. Dit artikel helpt u bij het configureren van Microsoft Fabric om verificatie van service-principals toe te staan en demonstreert vervolgens de Lakehouse-Verbinding maken or voor zowel lezen als schrijven naar Fabric Lakehouse.

Zie Wat is een lakehouse voor meer informatie over Microsoft Fabric Lakehouse ?

Azure Data Factory Lakehouse Verbinding maken or

Een nieuwe gekoppelde Lakehouse-serviceconnector en twee nieuwe gegevenssets zijn nu beschikbaar voor klanten die willen beginnen met lezen en schrijven naar Microsoft Fabric Lakehouse. Raadpleeg gegevens kopiëren en transformeren in Microsoft Fabric Lakehouse Files (preview) voor een volledige handleiding over lakehouse-Verbinding maken or.

Verificatie

Gekoppelde Azure Data Factory-service

De Microsoft Fabric Lakehouse-connector vereist een service-principal (SPN)/app-registratie voor verificatie. Als u wilt beginnen, moet u een nieuwe SPN maken of een bestaande SPN gebruiken. Met Microsoft Fabric kan SPN toegang krijgen tot specifieke beveiligingsgroepen of voor de hele organisatie. Als een specifieke beveiligingsgroep de optie is die uw organisatie gebruikt, moet de SPN die wordt gebruikt in de Lakehouse-connector behoren tot een beveiligingsgroep die wordt toegevoegd aan de acceptatielijst.

Notitie

API van Power BI machtigingen (gedelegeerd) zijn niet nodig

Toegang tot API van Power BI s

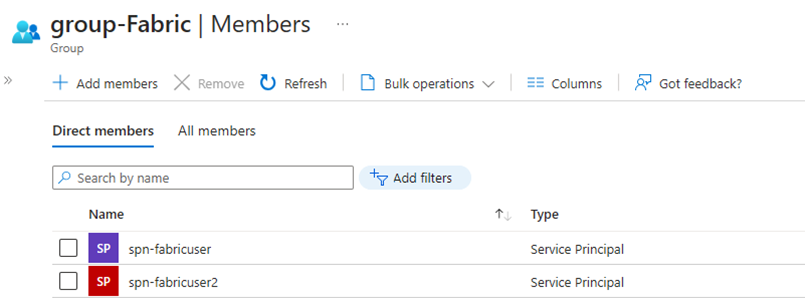

Vanuit de Power BI-beheerportal moet de Power BI-tenantbeheerder toestaan dat service-principals API van Power BI s kunnen gebruiken. De beveiligingsgroep moet worden opgegeven onder De instelling Service-principals toestaan API van Power BI te gebruiken of u kunt inschakelen voor de hele organisatie.

Raadpleeg power BI-inhoud insluiten in een ingesloten analysetoepassing met een service-principal en een toepassingsgeheim voor een volledige handleiding.

Notitie

Wanneer u de beveiligingsgroep toewijst aan de werkruimte, kan er een vertraging optreden voordat de service-principal toegang krijgt tot de werkruimte vanwege in de cache opslaan van machtigingen in Azure. Als u directe toegang nodig hebt, kunt u PowerShell gebruiken om een vernieuwing van de machtigingen van de gebruiker af te dwingen. Hiervoor opent u PowerShell als Beheer istrator en voert u vervolgens de volgende opdrachten uit:

Install-Module -Name MicrosoftPowerBIMgmt

Connect-PowerBIServiceAccount -Tenant '<TENANT ID>' -ServicePrincipal -Credential (Get-Credential)

Get-PowerBIWorkspace

Invoke-PowerBIRestMethod -URL 'https://api.powerbi.com/v1.0/myorg/RefreshUserPermissions' -Method Post -Body ''

Get-PowerBIWorkspace

Toegang tot werkruimte

Zodra de beveiligingsgroep is toegevoegd, moet de beveiligingsgroep of de service-principal ook worden toegevoegd aan elke werkruimte als lid, inzender of Beheer. Raadpleeg Gebruikers toegang geven tot werkruimten voor meer informatie.

Demo: Verificatie instellen

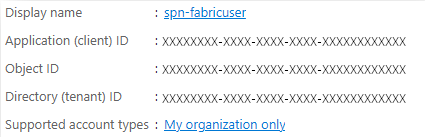

Service-principal voor app-registratie

Een bestaande service-principal voor app-registratie (SPN) maken of gebruiken. Volg de stappen in Een toepassing registreren met Microsoft Entra-id en maak een service-principal.

Notitie

U hoeft geen omleidings-URI toe te wijzen.

Beveiligingsgroep

Maak een nieuwe Microsoft Entra-beveiligingsgroep of gebruik een bestaande groep en voeg vervolgens de SPN eraan toe. Volg de stappen in Een basisgroep maken en voeg leden toe om een Microsoft Entra-beveiligingsgroep te maken.

Power BI-beheerportal

Ga in de Power BI-beheerportal naar Instellingen voor ontwikkelaars en selecteer Service-principals toestaan om API van Power BI s te gebruiken en schakel deze vervolgens in. Voeg vervolgens de beveiligingsgroep uit de vorige stap toe. Zie Tenantinstellingen voor meer informatie over de tenantinstellingen van de Power BI-beheerportal.

Notitie

Zorg ervoor dat de instelling Gebruikers toegang hebben tot gegevens die zijn opgeslagen in OneLake, met apps die extern zijn voor Fabric is ingeschakeld. Raadpleeg Apps die buiten Fabric worden uitgevoerd, toegang geven tot gegevens via OneLake.

Werkplek

Voeg de SPN of de servicegroep toe aan de werkruimte met toegang tot lid, inzender of Beheer.

Azure Data Factory: gekoppelde service

Maak vanuit Azure Data Factory een nieuwe gekoppelde Microsoft Fabric Lakehouse-service .

Notitie

Als u de werkruimte en Lakehouse-id's wilt vinden, gaat u naar uw Fabric Lakehouse en identificeert u deze via de URL. Bijvoorbeeld: https://.../groups/<Workspace ID>>/lakehouses/<Lakehouse ID>

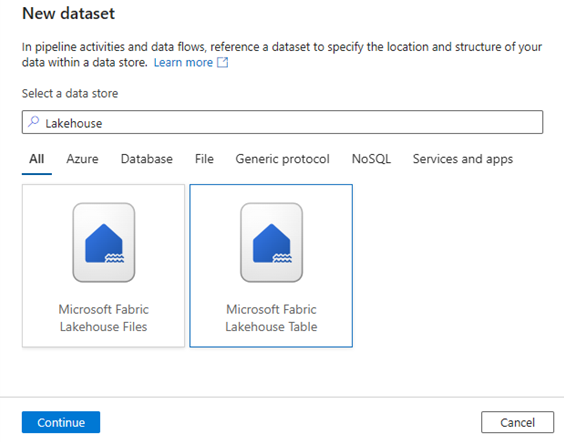

Azure Data Factory: gegevensset

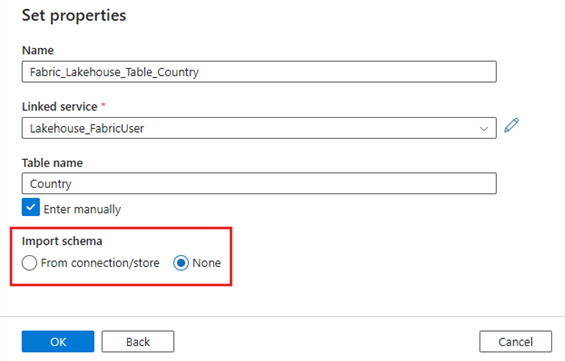

Maak een gegevensset die verwijst naar de gekoppelde Microsoft Fabric Lakehouse-service.

Notitie

Selecteer Geen voor de optie Schema importeren als de tabel nog niet bestaat en u handmatig een nieuwe tabelnaam opgeeft.

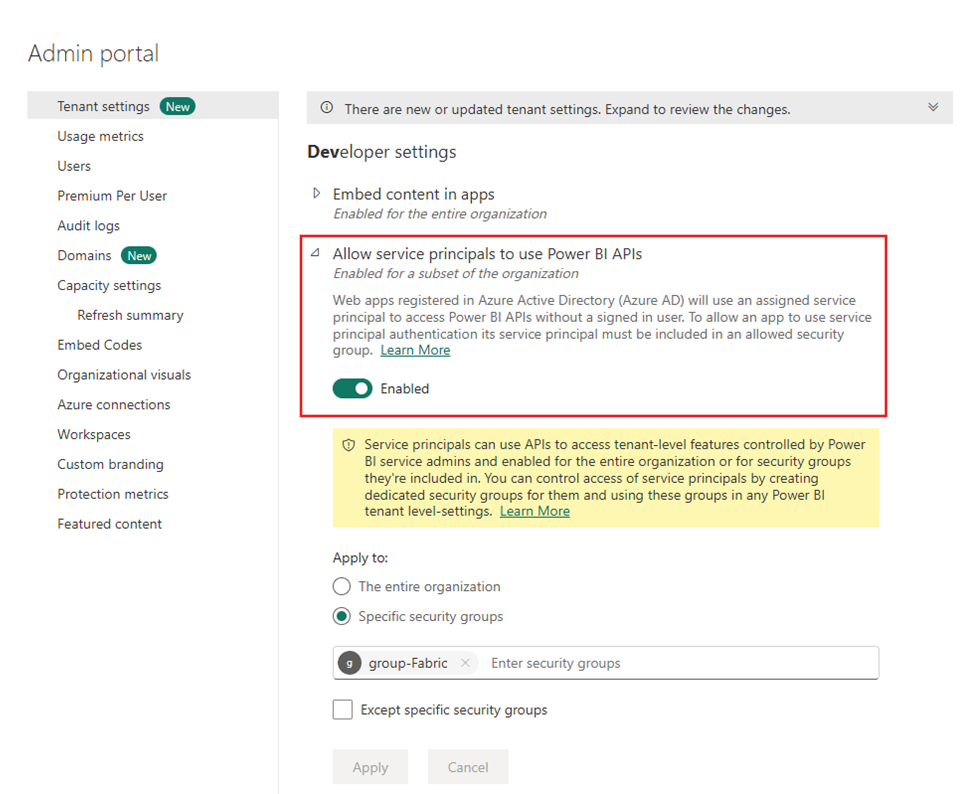

Demo: Schrijven naar een Fabric Lakehouse-tabel met een ADF-pijplijn

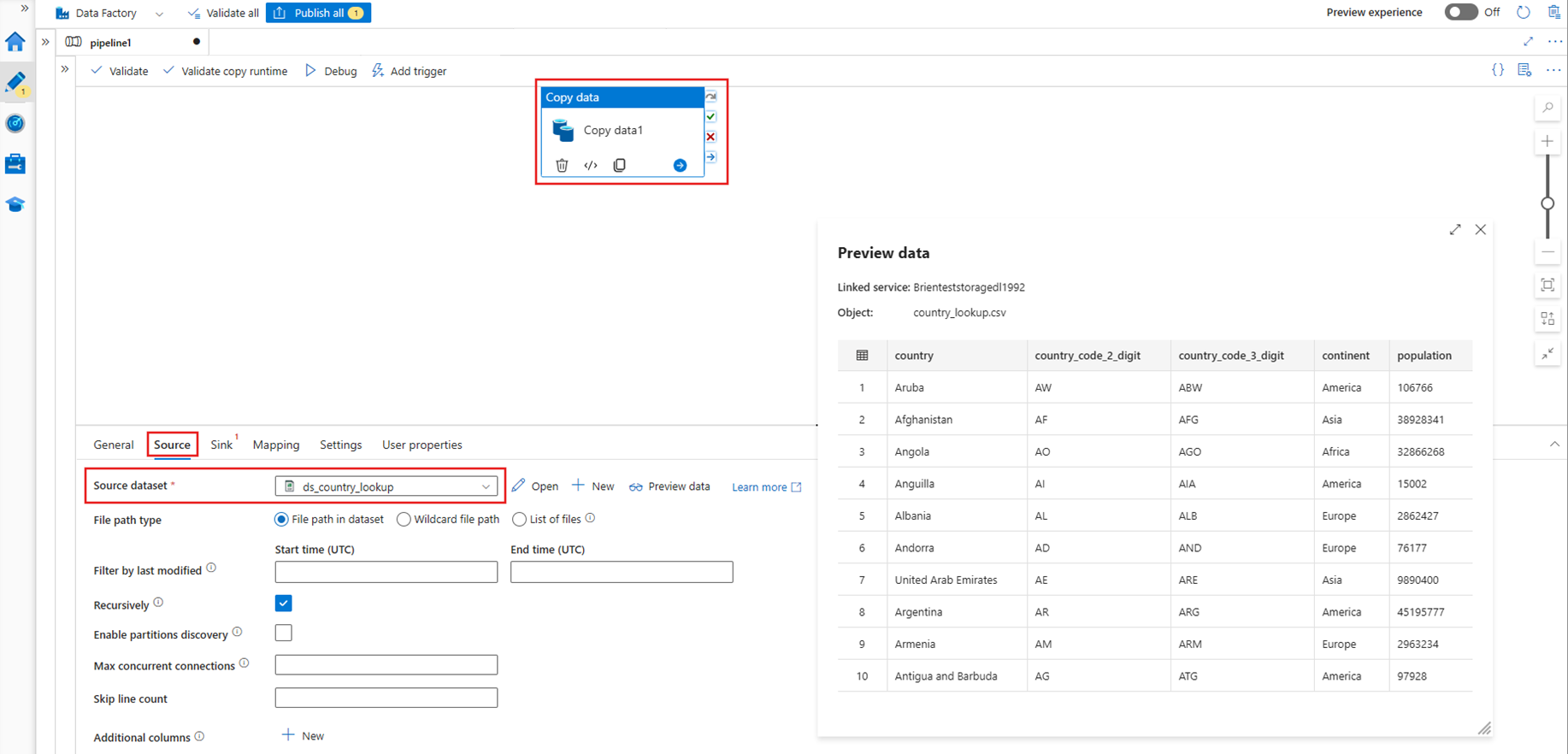

Bron

Maak een nieuwe pijplijn en voeg een Copy-activiteit toe aan het pijplijncanvas. Selecteer op het tabblad Bron van de Copy-activiteit een brongegevensset die u wilt verplaatsen naar een Lakehouse-tabel. In dit voorbeeld verwijzen we naar een .csv-bestand van een Azure Data Lake Storage Gen2-account (ADLS).

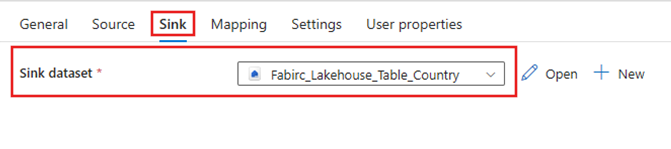

Sink

Navigeer naar het tabblad Sink van Copy-activiteit en selecteer de Fabric Lakehouse-gegevensset die eerder is gemaakt.

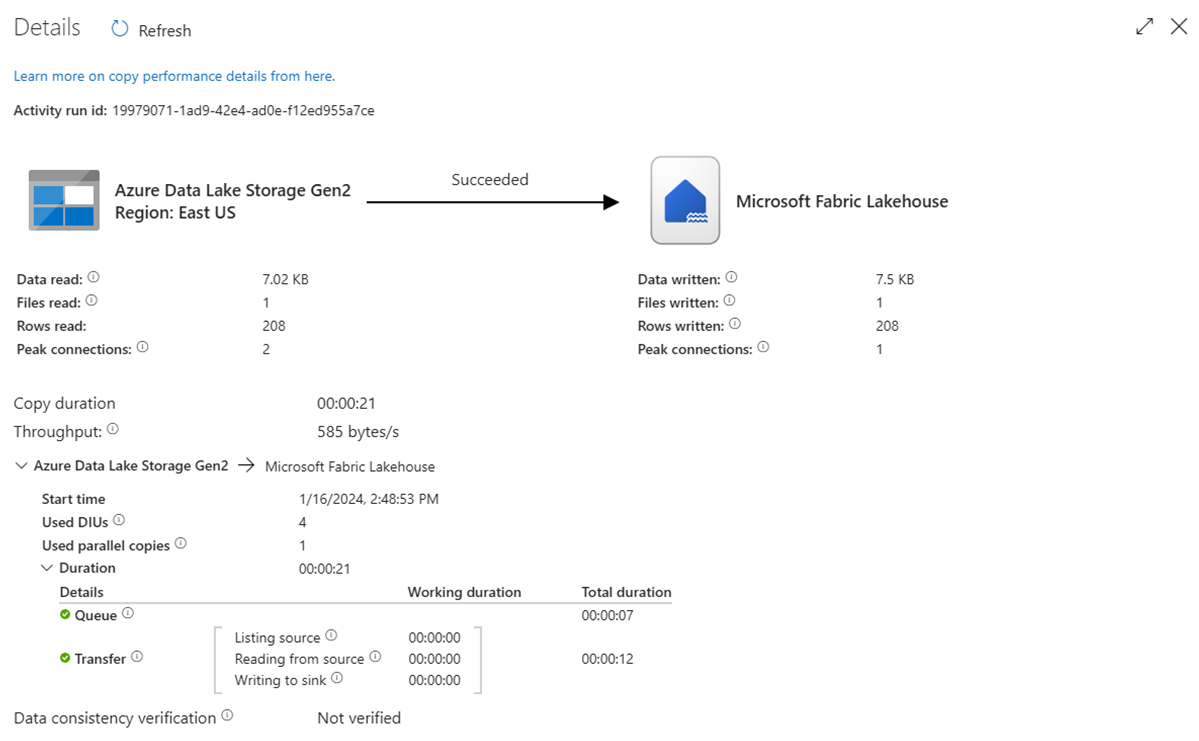

De pijplijn uitvoeren

Voer de pijplijn uit om de .csv gegevens naar de Tabel Fabric Lakehouse te verplaatsen.

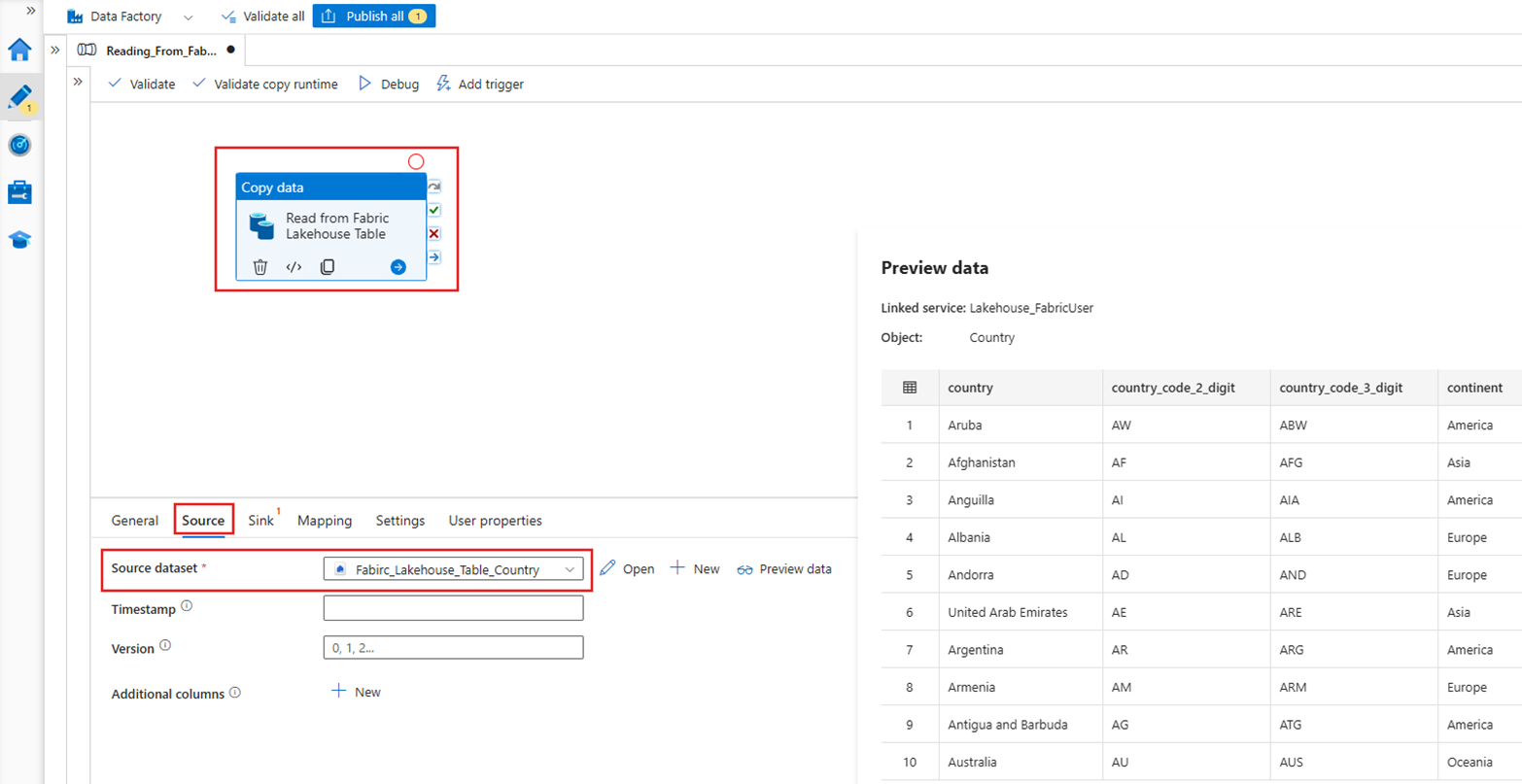

Demo: Lezen uit een Fabric Lakehouse-tabel met een ADF-pijplijn

In de bovenstaande sectie hebben we gedemonstreerd hoe u ADF kunt gebruiken om naar een Fabric Lakehouse-tabel te schrijven. Laten we nu lezen uit een Fabric Lakehouse-tabel en schrijven naar een Parquet-bestand in Azure Data Lake Storage (ADLS) Gen2 met een vergelijkbare pijplijn.

Bron

Maak een nieuwe pijplijn en voeg een Copy-activiteit toe aan het pijplijncanvas. Selecteer op het tabblad Bron van de Copy-activiteit de Fabric Lakehouse-gegevensset die eerder is gemaakt.

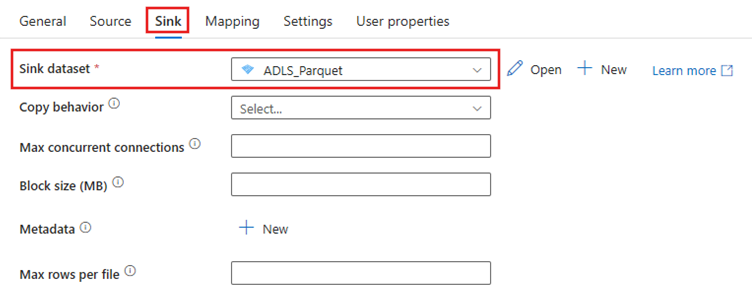

Sink

Navigeer naar het tabblad Sink van Copy-activiteit en selecteer de doelgegevensset. In dit voorbeeld is de bestemming Azure Data Lake Storage (Gen2) als parquet-bestand.

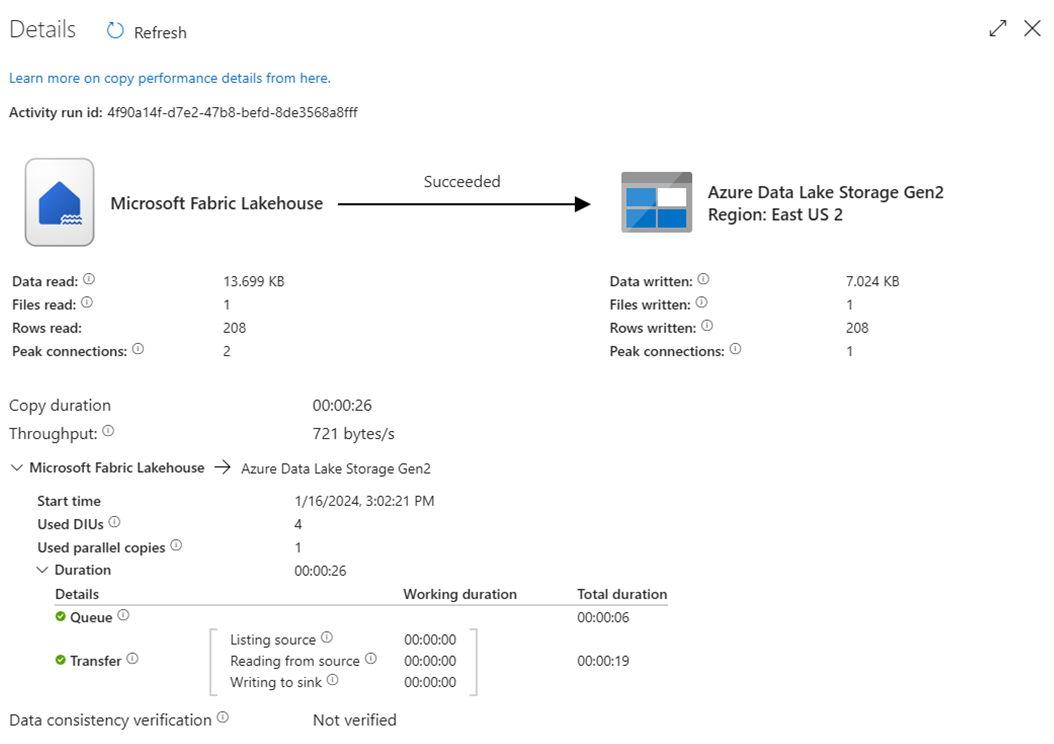

De pijplijn uitvoeren

Voer de pijplijn uit om de gegevens uit de Fabric Lakehouse-tabel te verplaatsen naar het Parquet-bestand in ADLS Gen2.

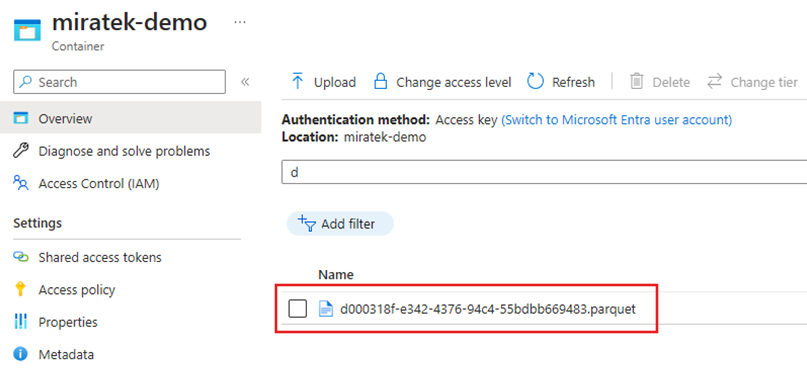

Het Parquet-bestand controleren in ADLS Gen2

De gegevens uit de Fabric Lakehouse-tabel zijn nu beschikbaar in ADLS Gen2 als parquet-bestand.

Samenvatting

In deze sectie hebben we de vereisten voor het Lakehouse-Verbinding maken or verkend met behulp van verificatie van service-principals voor een Microsoft Fabric Lakehouse. Vervolgens hebben we een voorbeeld doorlopen voor zowel lezen als schrijven naar het Lakehouse vanuit een Azure Data Factory-pijplijn. Deze connector en mogelijkheden zijn ook beschikbaar in Azure Data Factory-toewijzingen Gegevensstroom s, Azure Synapse Analytics en Azure Synapse Analytics-toewijzingen Gegevensstroom s.