Insluitmodellen gebruiken uit de Azure AI Foundry-modelcatalogus voor geïntegreerde vectorisatie

Belangrijk

Deze functie is beschikbaar als openbare preview onder aanvullende gebruiksvoorwaarden. De REST API 2024-05-01-Preview ondersteunt deze functie.

In dit artikel leert u hoe u toegang krijgt tot de insluitmodellen in de Azure AI Foundry-modelcatalogus voor vectorconversies tijdens het indexeren en uitvoeren van query's in Azure AI Search.

De werkstroom bevat stappen voor modelimplementatie. De modelcatalogus bevat het insluiten van modellen van Microsoft en andere bedrijven. Het implementeren van een model is factureerbaar volgens de factureringsstructuur van elke provider.

Nadat het model is geïmplementeerd, kunt u het gebruiken voor geïntegreerde vectorisatie tijdens het indexeren of met de Azure AI Foundry-vectorizer voor query's.

Tip

Gebruik de wizard Gegevens importeren en vectoriseren om een vaardighedenset te genereren die een AML-vaardigheid bevat voor geïmplementeerde insluitingsmodellen in Azure AI Foundry. De AML-vaardigheidsdefinitie voor invoer, uitvoer en toewijzingen wordt gegenereerd door de wizard, waarmee u een model eenvoudig kunt testen voordat u code schrijft.

Vereisten

Azure AI Search, elke regio en laag.

Azure AI Foundry en een Azure AI Foundry-project.

Ondersteunde insluitingsmodellen

Geïntegreerde vectorisatie en de wizard Gegevens importeren en vectoriseren ondersteunt de volgende insluitingsmodellen in de modelcatalogus:

Voor tekst insluitingen:

- Cohere-embed-v3-english

- Cohere-embed-v3-multilingual

Voor insluitingen van afbeeldingen:

- Facebook-DinoV2-Image-Embeddings-ViT-Base

- Facebook-DinoV2-Image-Embeddings-ViT-Giant

Een insluitmodel implementeren vanuit de Azure AI Foundry-modelcatalogus

Open de azure AI Foundry-modelcatalogus. Maak een project als u er nog geen hebt.

Pas een filter toe om alleen de insluitmodellen weer te geven. Selecteer Onder Deductietaken de optie Insluitingen:

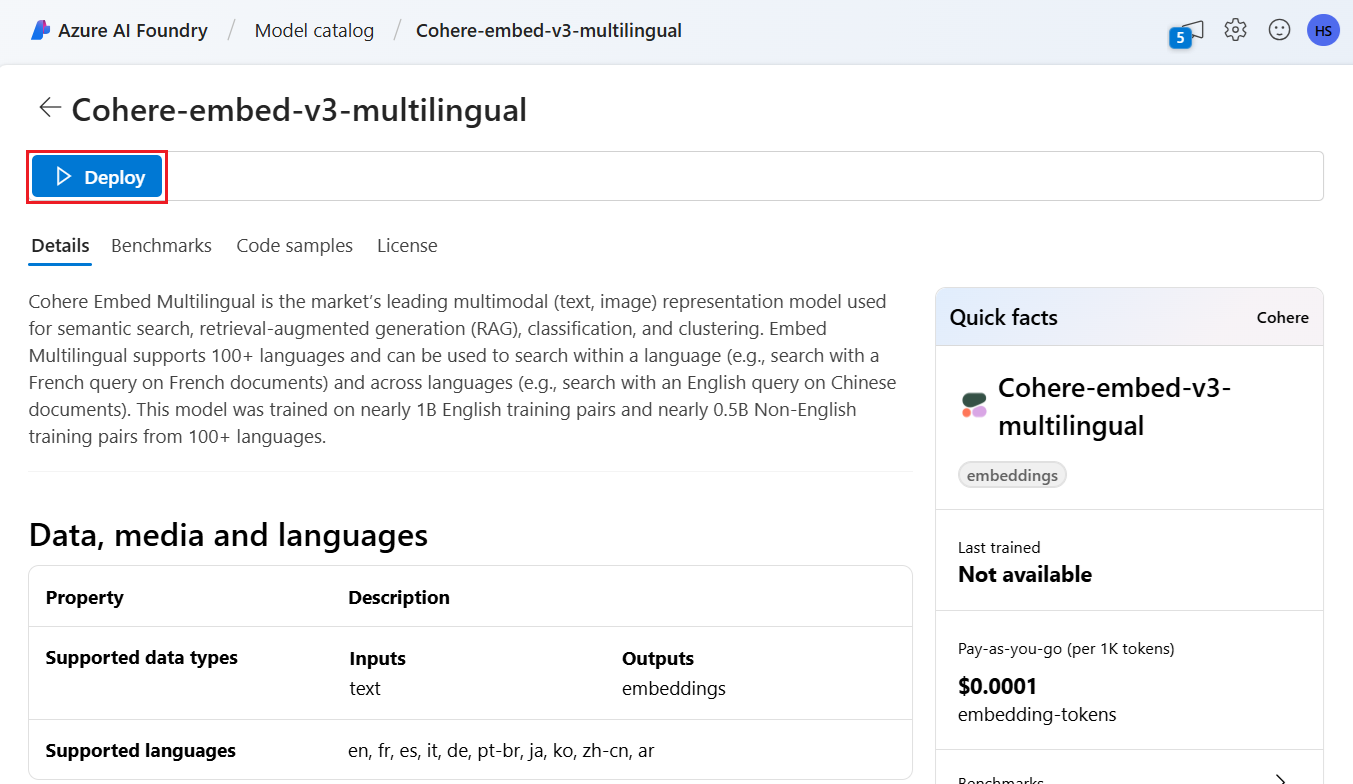

Selecteer een ondersteund model en selecteer vervolgens Implementeren.

Accepteer de standaardinstellingen of wijzig indien nodig en selecteer vervolgens Implementeren. De implementatiedetails variëren, afhankelijk van het model dat u selecteert.

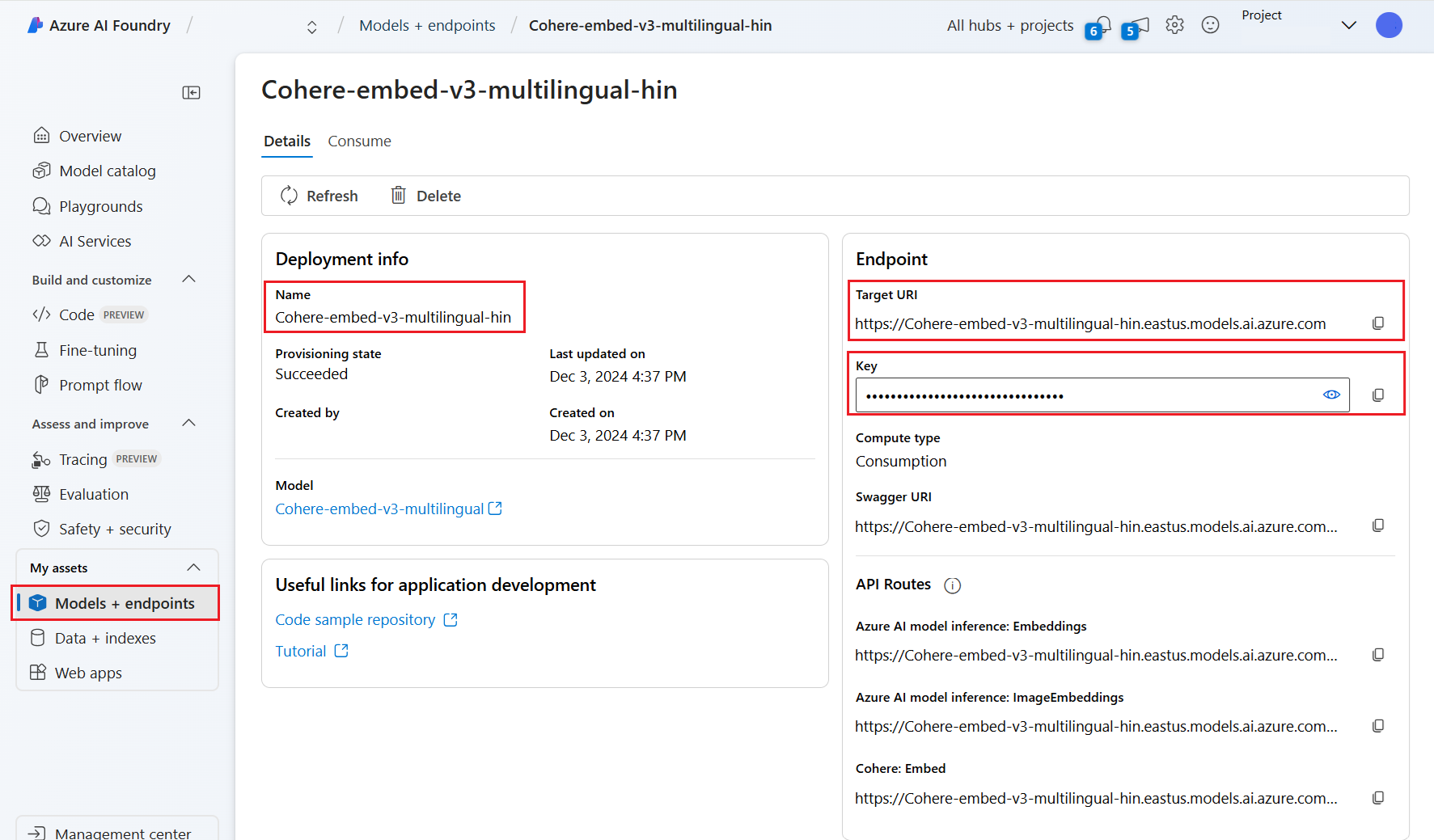

Wacht totdat het model is geïmplementeerd door de inrichtingsstatus te bewaken. Het moet worden gewijzigd van 'Inrichten' in 'Bijwerken' in 'Geslaagd'. Mogelijk moet u om de paar minuten Vernieuwen selecteren om de statusupdate weer te geven.

Noteer de doel-URI, sleutel en modelnaam. U hebt deze waarden nodig voor de vectorizerdefinitie in een zoekindex en voor de vaardighedenset die de modeleindpunten aanroept tijdens het indexeren.

U kunt eventueel uw eindpunt wijzigen om tokenverificatie te gebruiken in plaats van sleutelverificatie. Als u tokenverificatie inschakelt, hoeft u alleen de URI en modelnaam te kopiëren, maar noteer in welke regio het model is geïmplementeerd.

U kunt nu een zoekindex en indexeerfunctie configureren om het geïmplementeerde model te gebruiken.

Als u het model tijdens het indexeren wilt gebruiken, raadpleegt u de stappen om geïntegreerde vectorisatie in te schakelen. Zorg ervoor dat u de AML-vaardigheid (Azure Machine Learning) gebruikt en niet de vaardigheid AzureOpenAIEmbedding. In de volgende sectie wordt de configuratie van de vaardigheid beschreven.

Zie Een vectorizer configureren om het model te gebruiken als vectorizer tijdens het uitvoeren van query's. Zorg ervoor dat u de Azure AI Foundry-modelcatalogusvector voor deze stap gebruikt.

Voorbeeld van nettoladingen van AML-vaardigheden

Wanneer u insluitingsmodellen implementeert vanuit de Azure AI Foundry-modelcatalogus , maakt u er verbinding mee met behulp van de AML-vaardigheid in Azure AI Search voor indexeringsworkloads.

In deze sectie worden de AML-vaardigheidsdefinities en indextoewijzingen beschreven. Het bevat voorbeeldpayloads die al zijn geconfigureerd om te werken met hun bijbehorende geïmplementeerde eindpunten. Lees voor meer technische informatie over hoe deze nettoladingen werken over de vaardigheidscontext en de invoeraantekeningstaal.

Deze nettolading van AML-vaardigheden werkt met de volgende afbeelding die modellen uit Azure AI Foundry insluit:

- Facebook-DinoV2-Image-Embeddings-ViT-Base

- Facebook-DinoV2-Image-Embeddings-ViT-Giant

Hierbij wordt ervan uitgegaan dat uw afbeeldingen afkomstig zijn van het /document/normalized_images/* pad dat wordt gemaakt door ingebouwde afbeeldingsextractie in te schakelen. Als uw afbeeldingen afkomstig zijn van een ander pad of als URL's zijn opgeslagen, werkt u alle verwijzingen naar het pad bij op basis van het /document/normalized_images/* pad.

De URI en sleutel worden gegenereerd wanneer u het model vanuit de catalogus implementeert. Zie Hoe u grote taalmodellen implementeert met Azure AI Foundry voor meer informatie over deze waarden.

{

"@odata.type": "#Microsoft.Skills.Custom.AmlSkill",

"context": "/document/normalized_images/*",

"uri": "https://myproject-1a1a-abcd.eastus.inference.ml.azure.com/score",

"timeout": "PT1M",

"key": "bbbbbbbb-1c1c-2d2d-3e3e-444444444444",

"inputs": [

{

"name": "input_data",

"sourceContext": "/document/normalized_images/*",

"inputs": [

{

"name": "columns",

"source": "=['image', 'text']"

},

{

"name": "index",

"source": "=[0]"

},

{

"name": "data",

"source": "=[[$(/document/normalized_images/*/data), '']]"

}

]

}

],

"outputs": [

{

"name": "image_features"

}

]

}

Voorbeeld van azure AI Foundry vectorizer-nettolading

De Azure AI Foundry-vectorizer, in tegenstelling tot de AML-vaardigheid, is aangepast om alleen te werken met die ingesloten modellen die kunnen worden geïmplementeerd via de Azure AI Foundry-modelcatalogus. Het belangrijkste verschil is dat u zich geen zorgen hoeft te maken over de nettolading van aanvragen en antwoorden, maar u moet wel de modelName, die overeenkomt met de 'model-id' die u hebt gekopieerd na het implementeren van het model in de Azure AI Foundry-portal.

Hier volgt een voorbeeld van de wijze waarop u de vectorizer configureert in uw indexdefinitie op basis van de eigenschappen die zijn gekopieerd uit Azure AI Foundry.

Voor Cohere-modellen moet u niet het /v1/embed pad toevoegen aan het einde van uw URL, zoals u dat met de vaardigheid hebt gedaan.

"vectorizers": [

{

"name": "<YOUR_VECTORIZER_NAME_HERE>",

"kind": "aml",

"amlParameters": {

"uri": "<YOUR_URL_HERE>",

"key": "<YOUR_PRIMARY_KEY_HERE>",

"modelName": "<YOUR_MODEL_ID_HERE>"

},

}

]

Verbinding maken met behulp van tokenverificatie

Als u geen verificatie op basis van sleutels kunt gebruiken, kunt u in plaats daarvan de AML-vaardigheid en azure AI Foundry vectorizer-verbinding voor tokenverificatie configureren via op rollen gebaseerd toegangsbeheer in Azure. De zoekservice moet een door het systeem of de gebruiker toegewezen beheerde identiteit hebben en de identiteit moet eigenaars- of inzendermachtigingen hebben voor uw AML-projectwerkruimte. Vervolgens kunt u het sleutelveld verwijderen uit de definitie van uw vaardigheid en vectorizer, waarbij u dit vervangt door het resourceId-veld. Als uw AML-project en zoekservice zich in verschillende regio's bevinden, geeft u ook het regioveld op.

"uri": "<YOUR_URL_HERE>",

"resourceId": "subscriptions/<YOUR_SUBSCRIPTION_ID_HERE>/resourceGroups/<YOUR_RESOURCE_GROUP_NAME_HERE>/providers/Microsoft.MachineLearningServices/workspaces/<YOUR_AML_WORKSPACE_NAME_HERE>/onlineendpoints/<YOUR_AML_ENDPOINT_NAME_HERE>",

"region": "westus", // Only need if AML project lives in different region from search service