Een batchuitvoering verzenden om een stroom te evalueren

Een batchuitvoering voert een promptstroom uit met een grote gegevensset en genereert uitvoer voor elke gegevensrij. Als u wilt evalueren hoe goed uw promptstroom presteert met een grote gegevensset, kunt u een batchuitvoering indienen en evaluatiemethoden gebruiken om prestatiescores en metrische gegevens te genereren.

Nadat de batchstroom is voltooid, worden de evaluatiemethoden automatisch uitgevoerd om de scores en metrische gegevens te berekenen. U kunt de metrische evaluatiegegevens gebruiken om de uitvoer van uw stroom te beoordelen op basis van uw prestatiecriteria en doelstellingen.

In dit artikel wordt beschreven hoe u een batchuitvoering verzendt en een evaluatiemethode gebruikt om de kwaliteit van uw stroomuitvoer te meten. U leert hoe u het evaluatieresultaat en de metrische gegevens kunt bekijken en hoe u een nieuwe evaluatieronde start met een andere methode of subset van varianten.

Vereisten

Als u een batchstroom wilt uitvoeren met een evaluatiemethode, hebt u de volgende onderdelen nodig:

Een werkende Azure Machine Learning-promptstroom waarvoor u de prestaties wilt testen.

Een testgegevensset die moet worden gebruikt voor de batchuitvoering.

Uw testgegevensset moet de INDELING CSV, TSV of JSONL hebben en moeten headers bevatten die overeenkomen met de invoernamen van uw stroom. U kunt echter verschillende gegevenssetkolommen toewijzen aan invoerkolommen tijdens het installatieproces van de evaluatieuitvoering.

Een evaluatiebatchuitvoering maken en verzenden

Als u een batchuitvoering wilt verzenden, selecteert u de gegevensset waarmee u uw stroom wilt testen. U kunt ook een evaluatiemethode selecteren om metrische gegevens voor uw stroomuitvoer te berekenen. Als u geen evaluatiemethode wilt gebruiken, kunt u de evaluatiestappen overslaan en de batchuitvoering uitvoeren zonder metrische gegevens te berekenen. U kunt later ook een evaluatieronde uitvoeren.

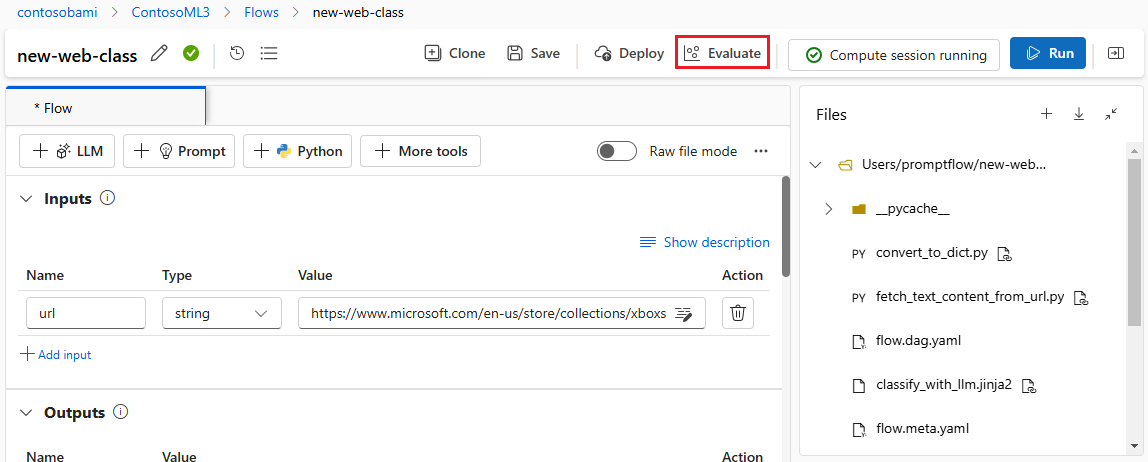

Als u een batchuitvoering wilt starten met of zonder evaluatie, selecteert u Evalueren boven aan de pagina promptstroom.

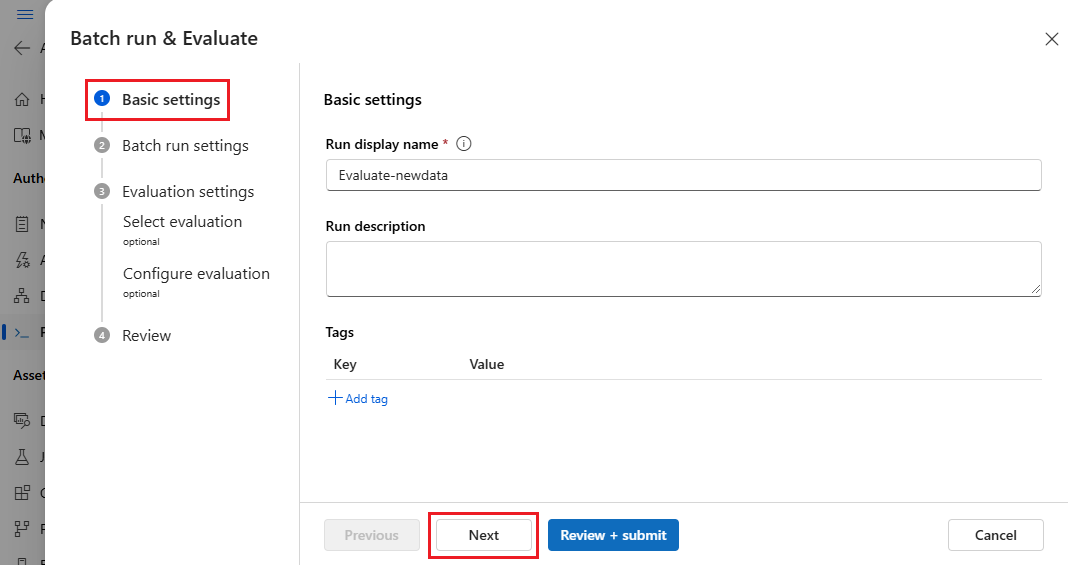

Pas op de pagina Basisinstellingen van de wizard Batch uitvoeren en evalueren desgewenst de weergavenaam Uitvoeren aan en geef desgewenst een beschrijving en tags voor uitvoeren op. Selecteer Volgende.

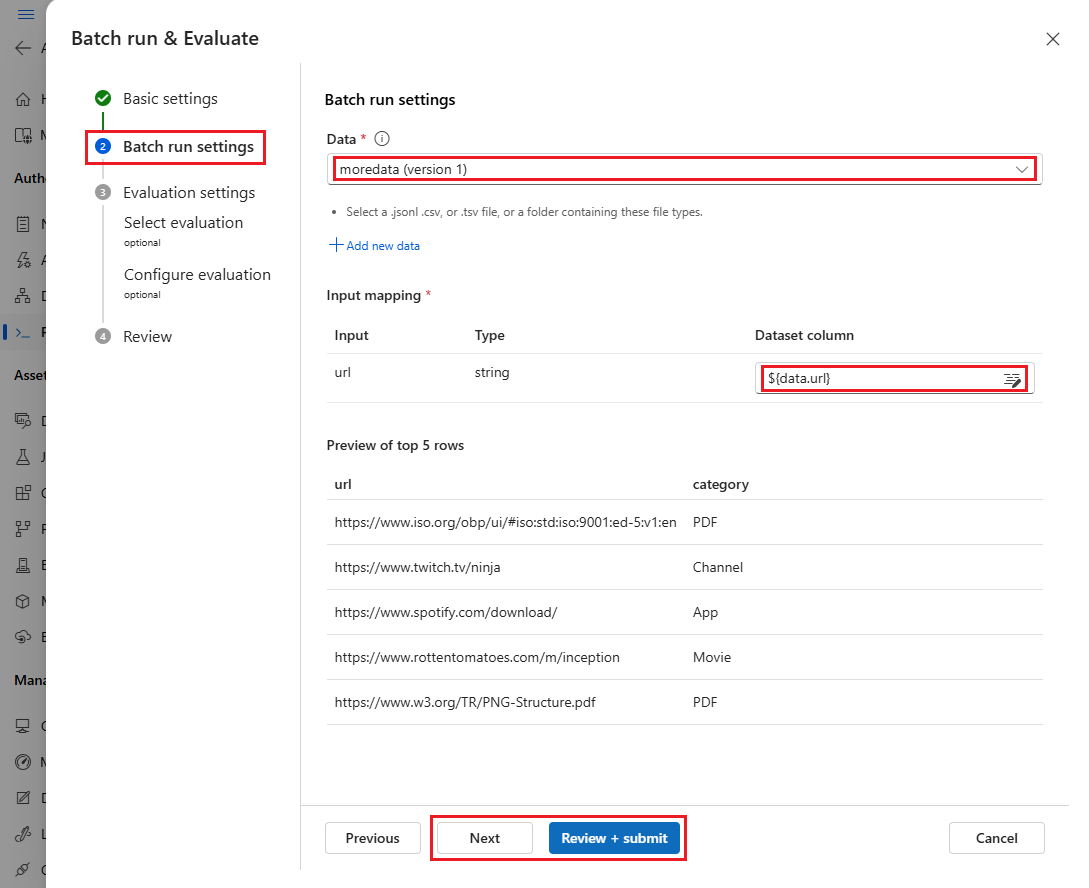

Selecteer op de pagina met instellingen voor Batch-uitvoering de gegevensset die u wilt gebruiken en configureer invoertoewijzing.

Promptstroom ondersteunt het toewijzen van uw stroominvoer aan een specifieke gegevenskolom in uw gegevensset. U kunt een gegevenssetkolom toewijzen aan een bepaalde invoer met behulp van

${data.<column>}. Als u een constante waarde wilt toewijzen aan een invoer, kunt u die waarde rechtstreeks invoeren.U kunt Beoordelen en verzenden selecteren om de evaluatiestappen over te slaan en de batchuitvoering uit te voeren zonder een evaluatiemethode te gebruiken. De batchuitvoering genereert vervolgens afzonderlijke uitvoer voor elk item in uw gegevensset. U kunt de uitvoer handmatig controleren of exporteren voor verdere analyse.

Als u anders een evaluatiemethode wilt gebruiken om de prestaties van deze uitvoering te valideren, selecteert u Volgende. U kunt ook een nieuwe evaluatieronde toevoegen aan een voltooide batchuitvoering.

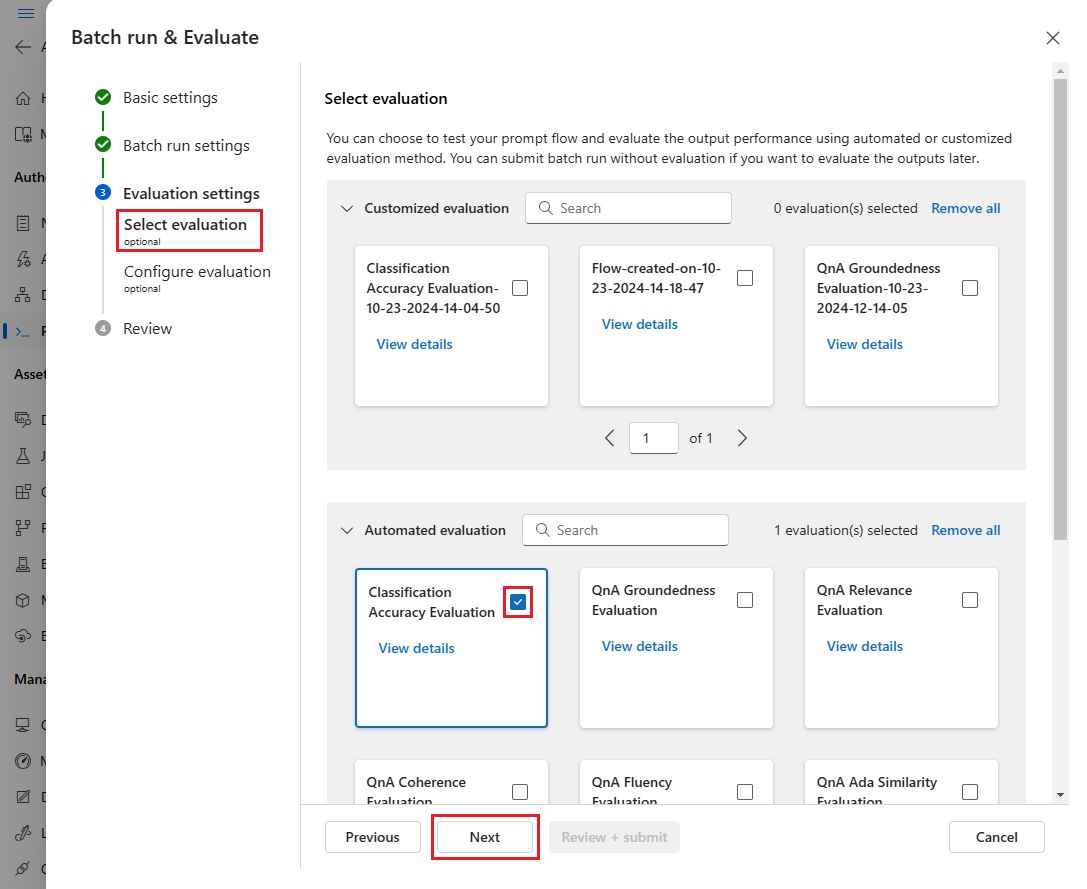

Selecteer op de pagina Evaluatie selecteren een of meer aangepaste of ingebouwde evaluaties die u wilt uitvoeren. U kunt de knop Details weergeven selecteren voor meer informatie over de evaluatiemethode, zoals de metrische gegevens die worden gegenereerd en de verbindingen en invoer die nodig zijn.

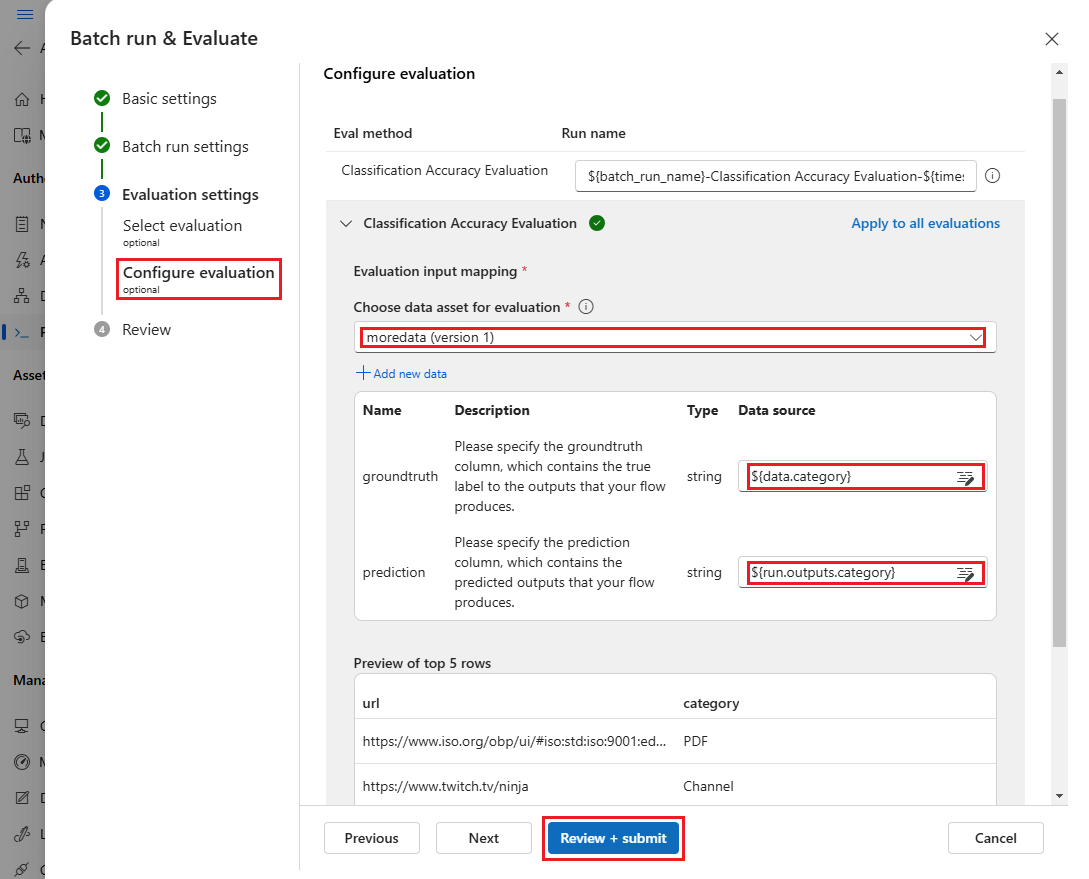

Geef vervolgens op het scherm Evaluatie configureren de bronnen op van de vereiste invoer voor de evaluatie. De kolom grondwaar kan bijvoorbeeld afkomstig zijn van een gegevensset. Evaluatie maakt standaard gebruik van dezelfde gegevensset als de algehele batchuitvoering. Als de bijbehorende labels of doelwaarden voor waarheidswaarden zich echter in een andere gegevensset bevinden, kunt u die gebruiken.

Notitie

Als uw evaluatiemethode geen gegevens uit een gegevensset vereist, is de selectie van gegevenssets een optionele configuratie die geen invloed heeft op de evaluatieresultaten. U hoeft geen gegevensset te selecteren of naar kolommen met gegevenssets in de sectie invoertoewijzing te verwijzen.

Geef in de sectie Evaluatieinvoertoewijzing de bronnen van de vereiste invoer voor de evaluatie aan.

- Als de gegevens afkomstig zijn uit uw testgegevensset, stelt u de bron in op

${data.[ColumnName]}. - Als de gegevens afkomstig zijn uit de uitvoer van de uitvoering, stelt u de bron in op

${run.outputs.[OutputName]}.

- Als de gegevens afkomstig zijn uit uw testgegevensset, stelt u de bron in op

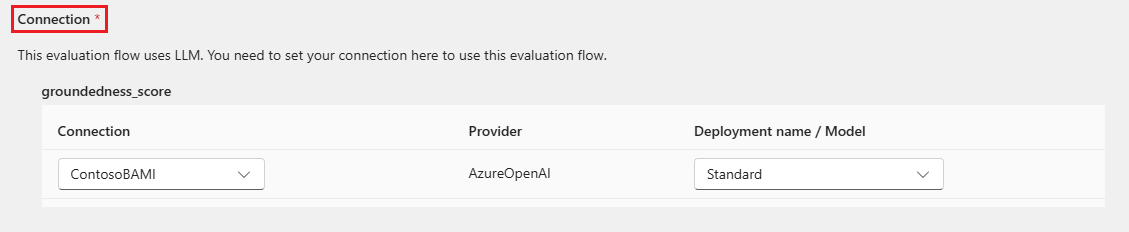

Voor sommige evaluatiemethoden zijn GROTE taalmodellen (LLM's) vereist, zoals GPT-4 of GPT-3, of andere verbindingen nodig om referenties of sleutels te gebruiken. Voor deze methoden moet u de verbindingsgegevens invoeren in de sectie Verbinding onder aan dit scherm om de evaluatiestroom te kunnen gebruiken. Zie Een verbinding instellen voor meer informatie.

Selecteer Beoordelen en verzenden om uw instellingen te controleren en selecteer vervolgens Verzenden om de batchuitvoering te starten met evaluatie.

Notitie

- Sommige evaluatieprocessen gebruiken veel tokens, dus het wordt aanbevolen een model te gebruiken dat =16k-tokens kan ondersteunen >.

- Batch-uitvoeringen hebben een maximale duur van 10 uur. Als een batchuitvoering deze limiet overschrijdt, wordt deze beëindigd en weergegeven als mislukt. Bewaak uw LLM-capaciteit om beperking te voorkomen. Overweeg indien nodig om de grootte van uw gegevens te verkleinen. Als u nog steeds problemen ondervindt, dient u een feedbackformulier of ondersteuningsaanvraag in.

Evaluatieresultaten en metrische gegevens weergeven

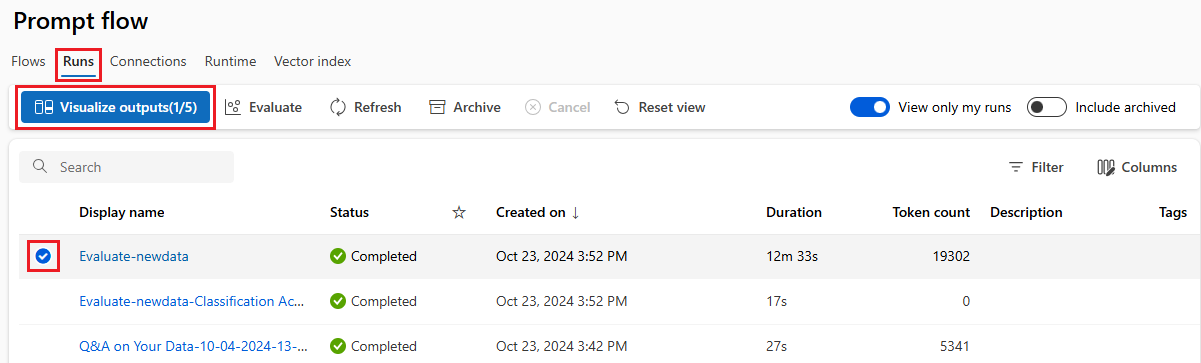

U vindt de lijst met ingediende batchuitvoeringen op het tabblad Runs op de pagina Azure Machine Learning-studio Promptstroom.

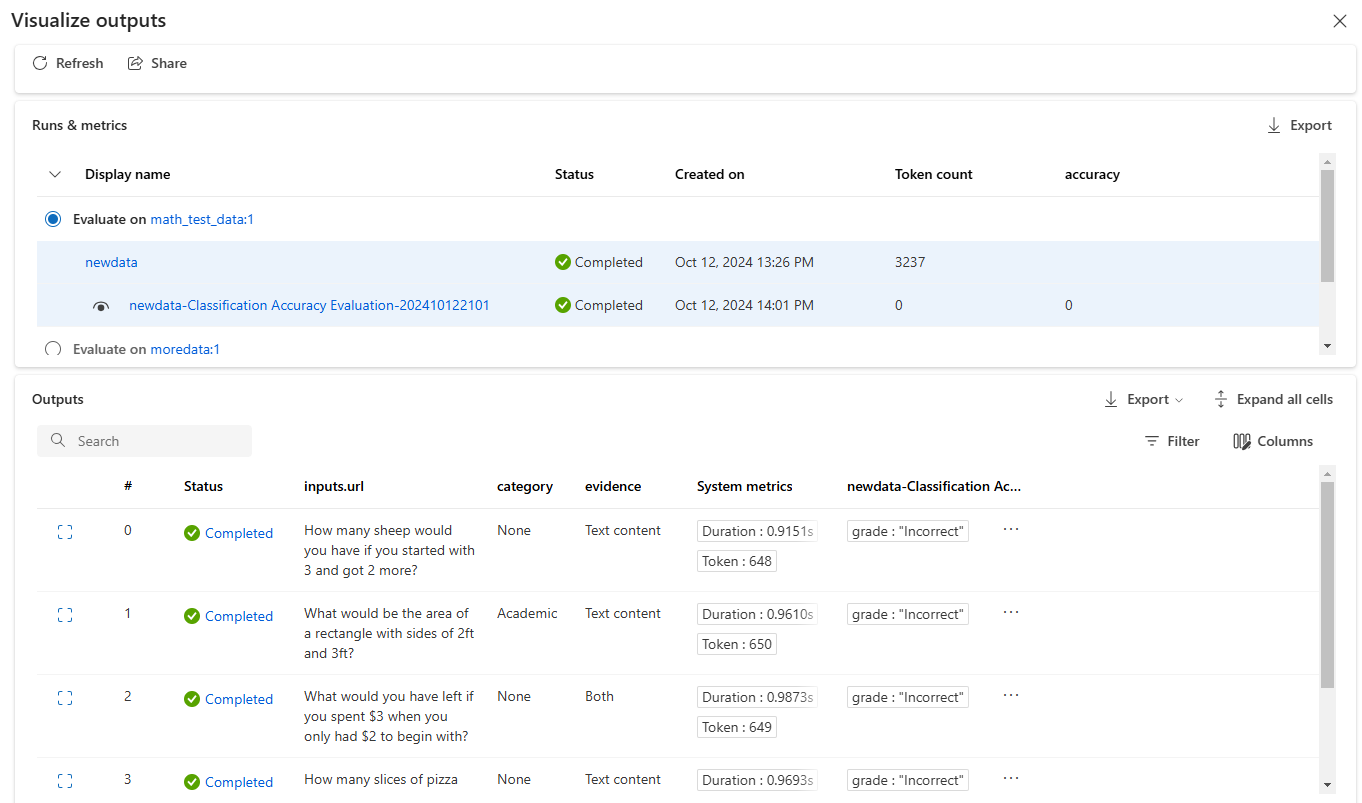

Als u de resultaten van een batchuitvoering wilt controleren, selecteert u de uitvoering en selecteert u Uitvoer visualiseren.

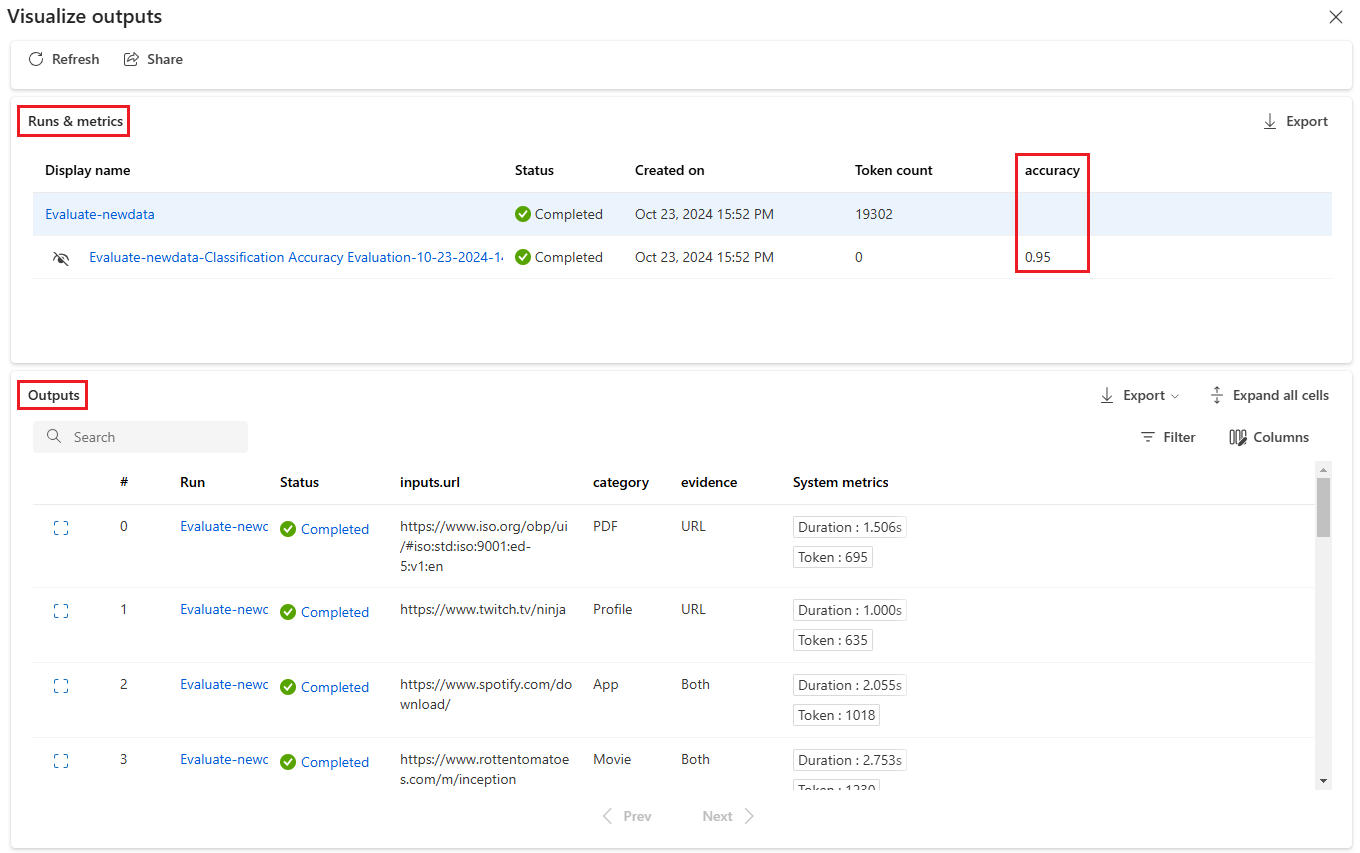

In het scherm Uitvoer visualiseren worden in de sectie Runs & metrics algemene resultaten weergegeven voor de batchuitvoering en de evaluatie-uitvoering. In de sectie Uitvoer ziet u de regel voor uitvoerinvoer in een resultatentabel die ook regel-id, uitvoering, status en metrische gegevens van het systeem bevat.

Als u het pictogram Weergave naast de evaluatieuitvoering inschakelt in de sectie Runs & metrics , wordt in de tabel Outputs ook de evaluatiescore of het cijfer voor elke regel weergegeven.

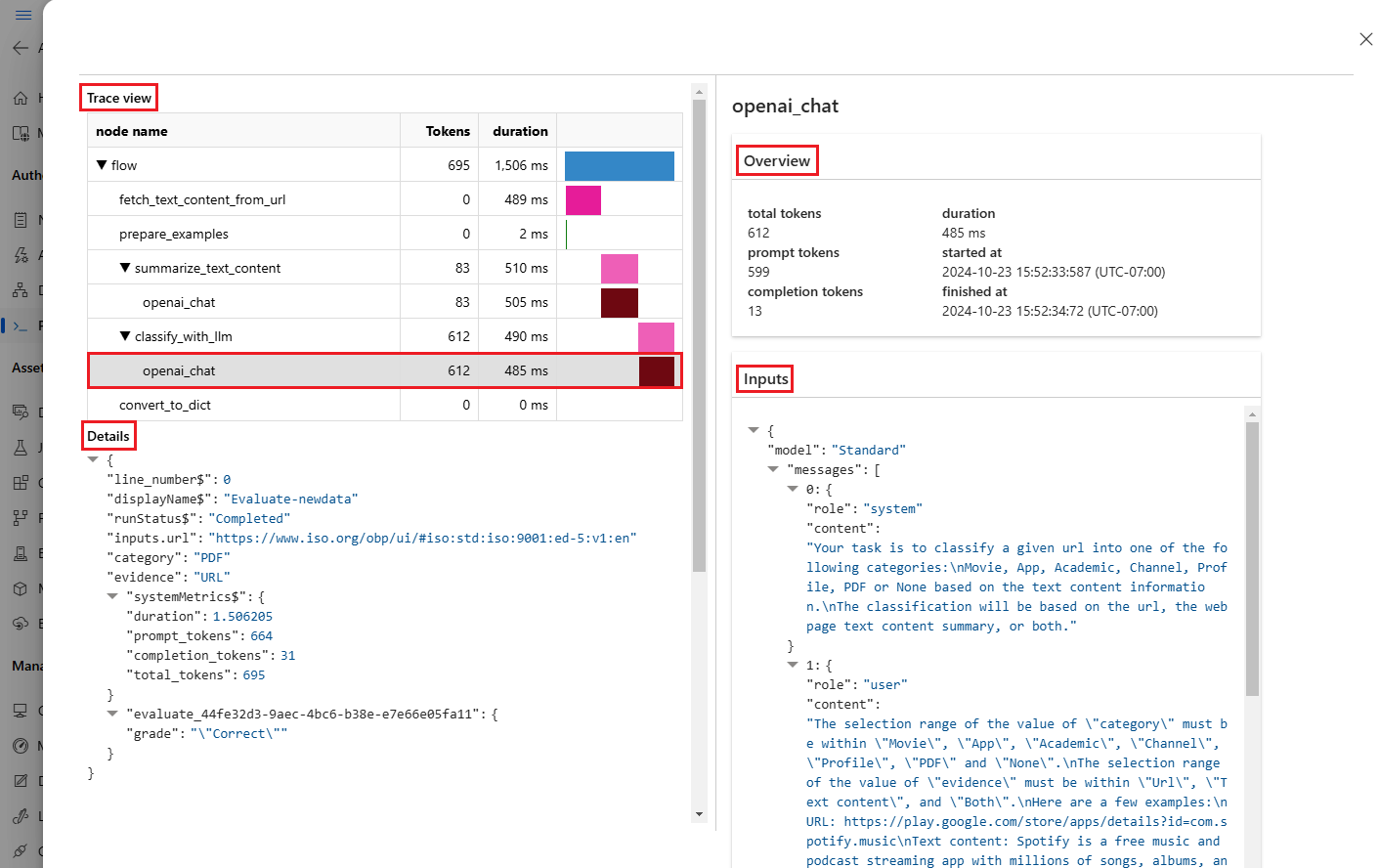

Selecteer het pictogram Details weergeven naast elke regel in de tabel Uitvoer om de traceringsweergave en details voor die testcase te bekijken en fouten op te sporen. In de traceringsweergave ziet u informatie zoals het aantal tokens en de duur voor dat geval. Vouw een stap uit en selecteer deze om het overzicht en de invoer voor die stap weer te geven.

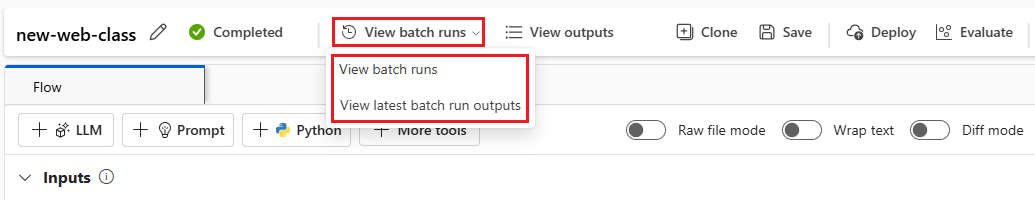

U kunt ook de resultaten van de evaluatieuitvoering bekijken vanuit de promptstroom die u hebt getest. Selecteer onder Batchuitvoeringen weergeven de optie Batchuitvoeringen weergeven om de lijst met batchuitvoeringen voor de stroom weer te geven of selecteer De meest recente uitvoer van batchuitvoeringen weergeven om de uitvoer voor de meest recente uitvoering weer te geven.

Selecteer in de lijst met batchuitvoeringen een batchuitvoeringsnaam om de stroompagina voor die uitvoering te openen.

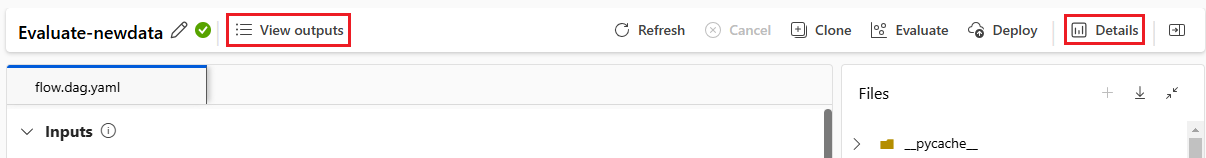

Selecteer op de stroompagina voor een evaluatieuitvoering uitvoer of Details weergeven om details voor de stroom weer te geven. U kunt de stroom ook klonen om een nieuwe stroom te maken of deze als een online-eindpunt implementeren .

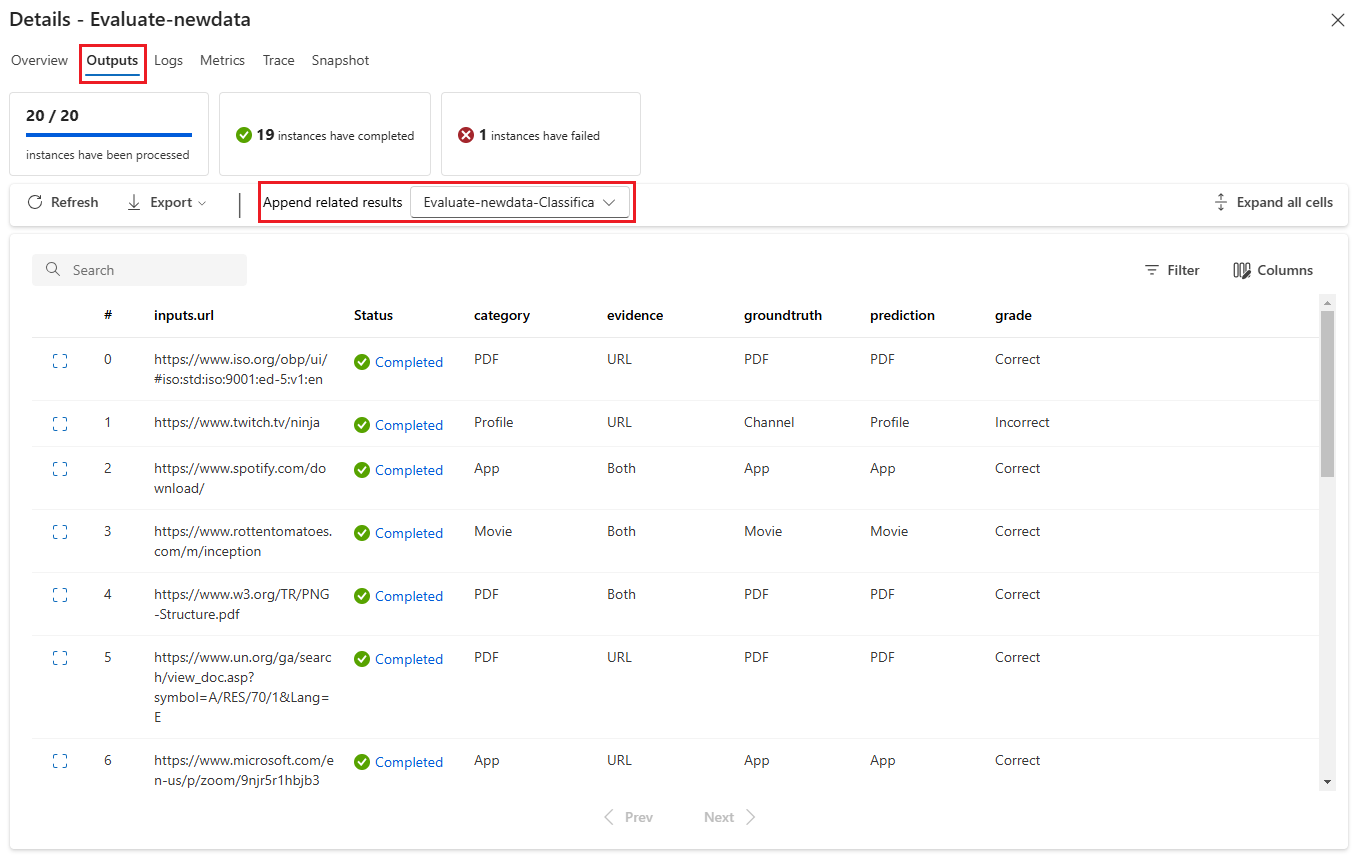

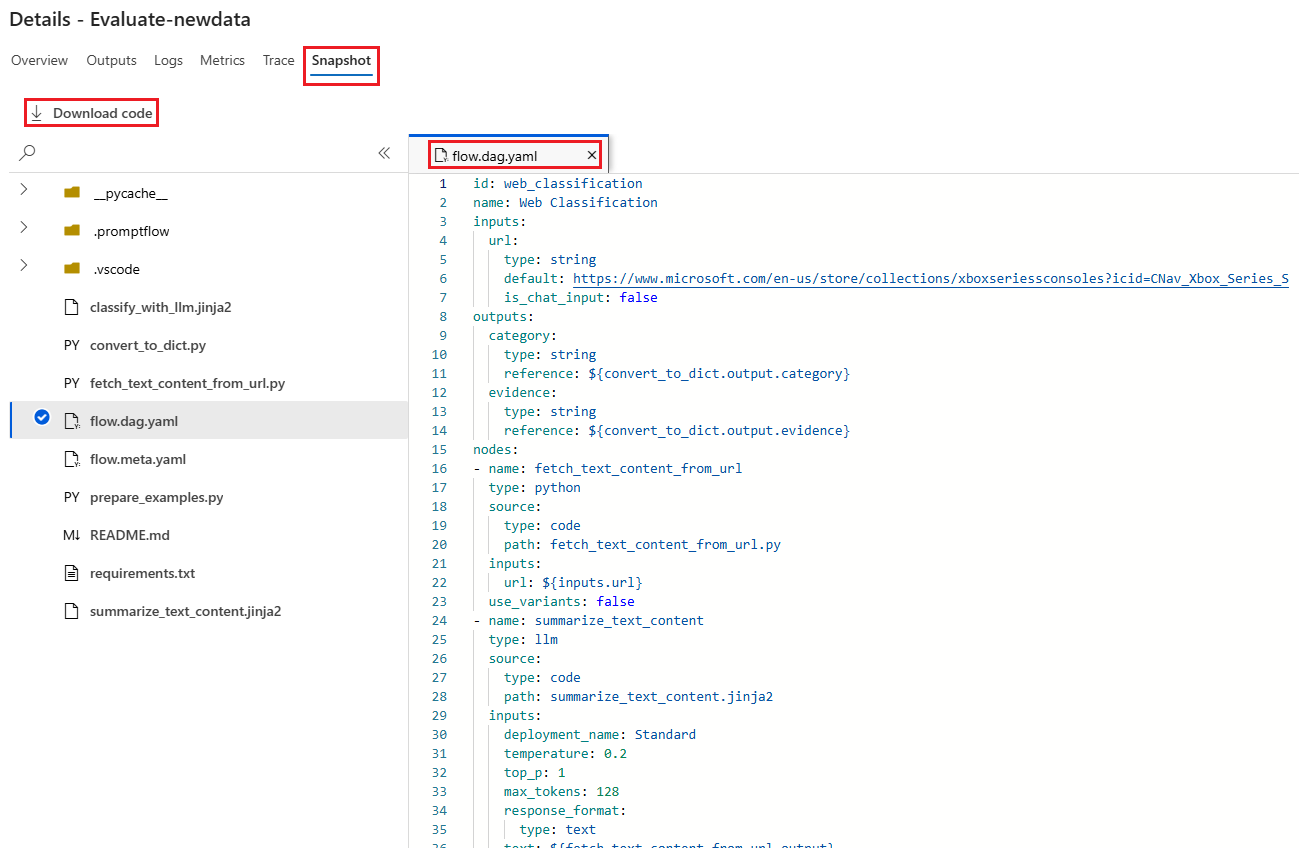

Op het scherm Details :

Op het tabblad Overzicht ziet u uitgebreide informatie over de uitvoering, waaronder uitvoeringseigenschappen, invoergegevensset, uitvoergegevensset, tags en beschrijving.

Op het tabblad Uitvoer ziet u een samenvatting van de resultaten boven aan de pagina, gevolgd door de tabel met batchuitvoeringsresultaten . Als u de evaluatieuitvoering selecteert naast Gerelateerde resultaten toevoegen, worden in de tabel ook de resultaten van de evaluatieuitvoering weergegeven.

Op het tabblad Logboeken worden de uitvoeringslogboeken weergegeven. Dit kan handig zijn voor gedetailleerde foutopsporing van uitvoeringsfouten. U kunt de logboekbestanden downloaden.

Het tabblad Metrische gegevens bevat een koppeling naar de metrische gegevens voor de uitvoering.

Het tabblad Tracering bevat gedetailleerde informatie, zoals het aantal tokens en de duur voor elke testcase. Vouw een stap uit en selecteer deze om het overzicht en de invoer voor die stap weer te geven.

Het tabblad Momentopname toont de bestanden en code van de uitvoering. U kunt de flow.dag.yaml-stroomdefinitie bekijken en een van de bestanden downloaden.

Een nieuwe evaluatieronde starten voor dezelfde uitvoering

U kunt een nieuwe evaluatieronde uitvoeren om metrische gegevens voor een voltooide batchuitvoering te berekenen zonder de stroom opnieuw uit te voeren. Dit proces bespaart de kosten voor het opnieuw uitvoeren van uw stroom en is handig in de volgende scenario's:

- U hebt geen evaluatiemethode geselecteerd toen u een batchuitvoering hebt ingediend en nu de prestaties van de uitvoering wilt evalueren.

- U hebt een evaluatiemethode gebruikt om een bepaalde metrische waarde te berekenen en u wilt nu een andere metrische waarde berekenen.

- De vorige evaluatieuitvoering is mislukt, maar de batchuitvoering heeft uitvoer gegenereerd en u wilt de evaluatie opnieuw proberen.

Als u een andere evaluatieronde wilt starten, selecteert u Evalueren boven aan de pagina batchuitvoeringsstroom. De wizard Nieuwe evaluatie wordt geopend op het scherm Evaluatie selecteren. Voltooi de installatie en verzend de nieuwe evaluatieuitvoering.

De nieuwe uitvoering wordt weergegeven in de lijst met promptstroomuitvoeringen. U kunt meer dan één rij in de lijst selecteren en vervolgens Uitvoer visualiseren selecteren om de uitvoer en metrische gegevens te vergelijken.

Evaluatierungeschiedenis en metrische gegevens vergelijken

Als u de stroom wijzigt om de prestaties te verbeteren, kunt u meerdere batchuitvoeringen indienen om de prestaties van de verschillende stroomversies te vergelijken. U kunt ook de metrische gegevens vergelijken die worden berekend door verschillende evaluatiemethoden om te zien welke methode geschikter is voor uw stroom.

Als u de uitvoeringsgeschiedenis van de stroombatch wilt controleren, selecteert u Batchuitvoeringen bovenaan de stroompagina weergeven. U kunt elke uitvoering selecteren om de details te controleren. U kunt ook meerdere uitvoeringen selecteren en uitvoer visualiseren selecteren om de metrische gegevens en de uitvoer van deze uitvoeringen te vergelijken.

Inzicht in ingebouwde metrische evaluatiegegevens

Azure Machine Learning-promptstroom biedt verschillende ingebouwde evaluatiemethoden om u te helpen de prestaties van uw stroomuitvoer te meten. Elke evaluatiemethode berekent verschillende metrische gegevens. In de volgende tabel worden de beschikbare ingebouwde evaluatiemethoden beschreven.

| Evaluatiemethode | Metrisch | Beschrijving | Verbinding vereist? | Vereiste invoer | Scorewaarden |

|---|---|---|---|---|---|

| Evaluatie van classificatienauwkeurigheid | Nauwkeurigheid | Meet de prestaties van een classificatiesysteem door de uitvoer ervan te vergelijken met grondwaar | Nee | voorspelling, grondwaar | In het bereik [0, 1] |

| QnA Groundedness Evaluation | Grondgebondenheid | Meet hoe de voorspelde antwoorden van het model zich in de invoerbron bevinden. Zelfs als de LLM-antwoorden juist zijn, zijn ze niet geaard als ze niet verifieerbaar zijn tegen de bron. | Ja | vraag, antwoord, context (geen grondwaar) | 1 tot 5, met 1 = slechtste en 5 = beste |

| QnA GPT-vergelijkbaarheidsevaluatie | GPT-gelijkenis | Meet overeenkomsten tussen door de gebruiker verstrekte antwoorden op grondwaar en het voorspelde antwoord van het model met behulp van een GPT-model | Ja | vraag, antwoord, grond waarheid (context niet nodig) | 1 tot 5, met 1 = slechtste en 5 = beste |

| QnA-relevantieevaluatie | Relevantie | Meet hoe relevant de voorspelde antwoorden van het model zijn op de gestelde vragen | Ja | vraag, antwoord, context (geen grondwaar) | 1 tot 5, met 1 = slechtste en 5 = beste |

| QnA-coherentieevaluatie | Samenhang | Meet de kwaliteit van alle zinnen in het voorspelde antwoord van een model en hoe ze op natuurlijke wijze bij elkaar passen | Ja | vraag, antwoord (geen grondwaar of context) | 1 tot 5, met 1 = slechtste en 5 = beste |

| Evaluatie van QnA-fluency | Vlotheid | Meet de grammaticale en taalkundige juistheid van het voorspelde antwoord van het model | Ja | vraag, antwoord (geen grondwaar of context) | 1 tot 5, met 1 = slechtste en 5 = beste |

| Evaluatie van QnA F1-scores | F1-score | Meet de verhouding van het aantal gedeelde woorden tussen de modelvoorspelling en de grondwaar | Nee | vraag, antwoord, grond waarheid (context niet nodig) | In het bereik [0, 1] |

| Evaluatie van QnA Ada-overeenkomsten | Gelijkenis van Ada | Berekeningen op zinsniveau (documentniveau) met behulp van de Ada embeddings-API voor zowel grondwaar als voorspelling, en berekent vervolgens cosinus-overeenkomsten tussen beide (één drijvendekommagetal) | Ja | vraag, antwoord, grond waarheid (context niet nodig) | In het bereik [0, 1] |

Stroomprestaties verbeteren

Als de uitvoering mislukt, controleert u de uitvoer- en logboekgegevens en voert u fouten in een stroomfout op. Als u de stroom wilt herstellen of de prestaties wilt verbeteren, wijzigt u de stroomprompt, het systeembericht, de stroomparameters of de stroomlogica.

Prompt-engineering

Prompt constructie kan moeilijk zijn. Zie Overzicht van prompts voor meer informatie over de concepten van prompts. Zie Prompt engineering techniques (Prompt engineering) voor meer informatie over het maken van een prompt die u kan helpen bij het bereiken van uw doelen.

Systeembericht

U kunt het systeembericht, ook wel een metaprompt of systeemprompt genoemd, gebruiken om het gedrag van een AI-systeem te begeleiden en de systeemprestaties te verbeteren. Zie Systeemberichten stapsgewijs ontwerpen voor meer informatie over het verbeteren van de prestaties van uw stroom met systeemberichten.

Gouden gegevenssets

Bij het maken van een copilot die gebruikmaakt van LLM's, wordt het model doorgaans in werkelijkheid geaard met behulp van brongegevenssets. Een gouden gegevensset zorgt ervoor dat de LLM's de meest nauwkeurige en nuttige antwoorden bieden op klantquery's.

Een gouden gegevensset is een verzameling realistische klantvragen en deskundige antwoorden die dienen als een hulpprogramma voor kwaliteitscontrole voor de LLM's die door uw copilot worden gebruikt. Gouden gegevenssets worden niet gebruikt om een LLM te trainen of context in een LLM-prompt te injecteren, maar om de kwaliteit van de antwoorden te beoordelen die de LLM genereert.

Als uw scenario betrekking heeft op een copilot of als u uw eigen copilot bouwt, raadpleegt u Golden Datasets produceren voor gedetailleerde richtlijnen en best practices.