Stap 4. De kwaliteit van de POC evalueren

Zie de GitHub-opslagplaats voor de voorbeeldcode in deze sectie.

Verwachte tijd: 5 - 60 minuten. De tijd varieert op basis van het aantal vragen in uw evaluatieset. Voor 100 vragen duurt de evaluatie ongeveer 5 minuten.

Overzicht en verwacht resultaat

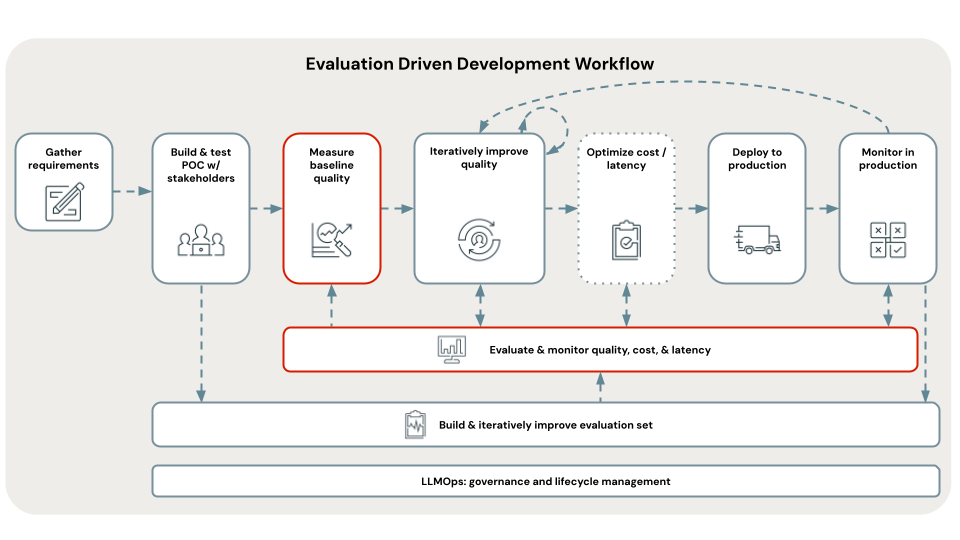

In deze stap wordt de evaluatieset gebruikt die u zojuist hebt samengesteld om uw POC-app te evalueren en de kwaliteit, kosten en latentie van de basislijn vast te stellen. De evaluatieresultaten worden in de volgende stap gebruikt om de hoofdoorzaak van kwaliteitsproblemen te identificeren.

Evaluatie wordt uitgevoerd met behulp van Mosaic AI Agent Evaluation en bekijkt grondig alle aspecten van kwaliteit, kosten en latentie die worden beschreven in de sectie metrische gegevens van deze zelfstudie.

De geaggregeerde metrische gegevens en evaluatie van elke vraag in de evaluatieset worden geregistreerd bij MLflow. Zie Evaluatie-uitvoer voor meer informatie.

Vereisten

- Evaluatieset is beschikbaar.

- Alle vereisten uit de vorige stappen.

Instructies

- Open het notitieblok in de

05_evaluate_poc_qualitydoor u gekozen POC-map en klik op Alles uitvoeren. - Controleer de resultaten van de evaluatie in het notebook of met behulp van MLflow. Als de resultaten voldoen aan uw vereisten voor kwaliteit, kunt u direct doorgaan naar Implementeren en bewaken. Omdat de POC-toepassing is gebouwd op Databricks, is deze gereed om te worden geïmplementeerd in een schaalbare, productieklare REST API.

Volgende stap

Met behulp van deze basislijnevaluatie van de kwaliteit van de POC identificeert u de hoofdoorzaken van kwaliteitsproblemen en lost u deze problemen iteratief op om de app te verbeteren. Zie stap 5. Identificeer de hoofdoorzaak van kwaliteitsproblemen.

< vorige: stap 3. Een evaluatieset cureren

Volgende: Stap 5. Identificeer hoofdoorzaken van kwaliteitsproblemen > inspringen