Stap 3. Een evaluatieset cureren op feedback van belanghebbenden

Zie de GitHub-opslagplaats voor de voorbeeldcode in deze sectie.

Verwachte tijd: 10 - 60 minuten. De tijd varieert op basis van de kwaliteit van de antwoorden van uw belanghebbenden. Als de antwoorden rommelig zijn of veel irrelevante query's bevatten, moet u meer tijd besteden aan het filteren en opschonen van de gegevens.

Overzicht en verwacht resultaat

Met deze stap wordt een evaluatieset opgestart met de feedback die belanghebbenden hebben gegeven met behulp van de beoordelings-app. Houd er rekening mee dat u een evaluatieset kunt opstarten met alleen vragen, dus zelfs als uw belanghebbenden alleen met de app chatten en geen feedback geven, kunt u deze stap uitvoeren.

Zie Invoerschema voor agentevaluatievoor het schema van de Agent Evaluatie. In de rest van deze sectie wordt verwezen naar de velden in dit schema.

Aan het einde van deze stap hebt u een evaluatieset die het volgende bevat:

- Aanvragen met een duim omhoog 👍:

-

request: zoals ingevoerd door de gebruiker. -

expected_response: Antwoord zoals bewerkt door de gebruiker. Als de gebruiker het antwoord niet heeft bewerkt, wordt het antwoord gegenereerd door het model.

-

- Aanvragen met een duim omlaag 👎:

-

request: zoals ingevoerd door de gebruiker. -

expected_response: Antwoord zoals bewerkt door de gebruiker. Als de gebruiker het antwoord niet heeft bewerkt, is het antwoord null.

-

- Aanvragen zonder feedback (geen duim omhoog 👍 of duim omlaag 👎)

-

request: zoals ingevoerd door de gebruiker.

-

Als de gebruiker voor alle aanvragen duimen 👍 selecteert voor een segment uit het retrieved_contextsegment, wordt het doc_uri gedeelte van dat segment voor expected_retrieved_context de vraag opgenomen.

Belangrijk

Databricks raadt aan dat uw evaluatieset ten minste 30 vragen bevat om aan de slag te gaan. Lees de deep dive van de evaluatieset voor meer inzicht in wat een 'goede' evaluatieset inhoudt.

Vereisten

- Belanghebbenden hebben uw POC gebruikt en feedback gegeven.

- Alle vereisten uit de vorige stappen.

Instructies

- Open het 04_create_evaluation_set notebook en klik op Alles uitvoeren.

- Inspecteer de evaluatieset om inzicht te hebben in de gegevens die zijn opgenomen. U moet controleren of uw evaluatieset een representatieve en uitdagende set vragen bevat. Pas de evaluatieset naar behoefte aan.

- Standaard wordt uw evaluatieset opgeslagen in de Delta-tabel die is geconfigureerd in

EVALUATION_SET_FQNin het 00_global_config notebook.

Volgende stap

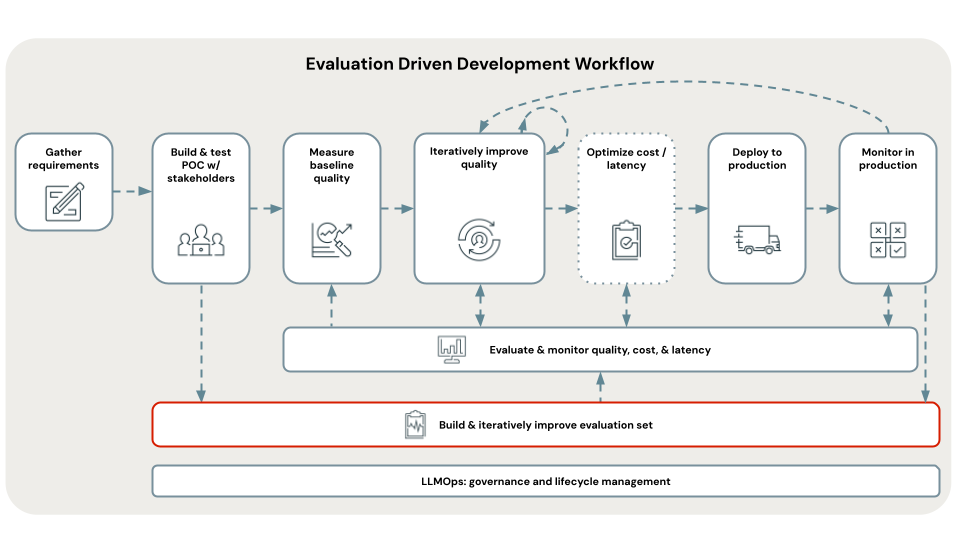

Nu u een evaluatieset hebt, kunt u deze gebruiken om de kwaliteit, kosten en latentie van de POC-app te evalueren. Zie stap 4. Evalueer de kwaliteit van de POC.