Zelfstudie: Python uitvoeren op een cluster en als een taak met behulp van de Databricks-extensie voor Visual Studio Code

Deze zelfstudie begeleidt u bij het instellen van de Databricks-extensie voor Visual Studio Code en het uitvoeren van Python op een Azure Databricks-cluster en als een Azure Databricks-taak in uw externe werkruimte. Zie Wat is de Databricks-extensie voor Visual Studio Code?

Vereisten

Voor deze zelfstudie is het volgende vereist:

- U hebt de Databricks-extensie voor Visual Studio Code geïnstalleerd. Zie De Databricks-extensie voor Visual Studio Code installeren.

- U hebt een extern Azure Databricks-cluster dat u kunt gebruiken. Noteer de naam van het cluster. Als u de beschikbare clusters wilt weergeven, klikt u in de zijbalk van uw Azure Databricks-werkruimte op Compute. Zie Compute.

Stap 1: Een nieuw Databricks-project maken

In deze stap maakt u een nieuw Databricks-project en configureert u de verbinding met uw externe Azure Databricks-werkruimte.

- Start Visual Studio Code en klik vervolgens op > en open een lege map op uw lokale ontwikkelcomputer.

- Klik op de zijbalk op het logopictogram van Databricks . Hiermee opent u de Databricks-extensie.

- Klik in de configuratieweergave op Migreren naar een Databricks-project.

- Het opdrachtpalet voor het configureren van uw Databricks-werkruimte wordt geopend. Voor Databricks Hostvoert u uw URL per werkruimte in of selecteert u deze, bijvoorbeeld

https://adb-1234567890123456.7.azuredatabricks.net. - Selecteer een verificatieprofiel voor het project. Zie De verificatie-instelling voor de Databricks-extensie voor Visual Studio Code.

Stap 2: clustergegevens toevoegen aan de Databricks-extensie en het cluster starten

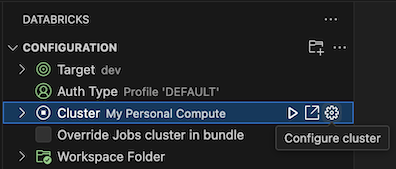

Als de configuratieweergave al is geopend, klikt u op Selecteer een cluster of klikt u op het tandwielpictogram (Cluster configureren).

Selecteer in het opdrachtpaletde naam van het cluster dat u eerder hebt gemaakt.

Klik op het afspeelpictogram (Cluster starten) als dit nog niet is gestart.

Stap 3: Python-code maken en uitvoeren

Maak een lokaal Python-codebestand: klik op de zijbalk op het mappictogram (Explorer).

Klik in het hoofdmenu op Bestand > nieuw bestand. Geef het bestand een naam demo.py en sla het op in de hoofdmap van het project.

Voeg de volgende code toe aan het bestand en sla deze vervolgens op. Met deze code wordt de inhoud van een eenvoudig PySpark-dataframe gemaakt en weergegeven:

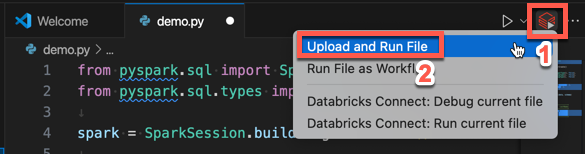

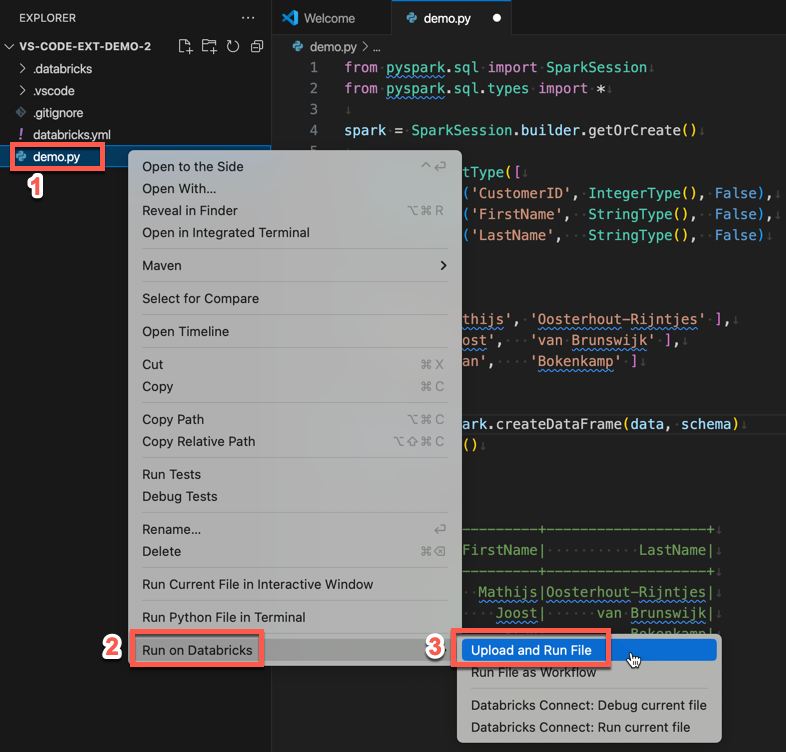

from pyspark.sql import SparkSession from pyspark.sql.types import * spark = SparkSession.builder.getOrCreate() schema = StructType([ StructField('CustomerID', IntegerType(), False), StructField('FirstName', StringType(), False), StructField('LastName', StringType(), False) ]) data = [ [ 1000, 'Mathijs', 'Oosterhout-Rijntjes' ], [ 1001, 'Joost', 'van Brunswijk' ], [ 1002, 'Stan', 'Bokenkamp' ] ] customers = spark.createDataFrame(data, schema) customers.show() # Output: # # +----------+---------+-------------------+ # |CustomerID|FirstName| LastName| # +----------+---------+-------------------+ # | 1000| Mathijs|Oosterhout-Rijntjes| # | 1001| Joost| van Brunswijk| # | 1002| Stan| Bokenkamp| # +----------+---------+-------------------+Klik op het pictogram Uitvoeren op Databricks naast de lijst met editortabbladen en klik vervolgens op uploaden en uitvoeren van bestand. De uitvoer wordt weergegeven in de consoleweergave voor foutopsporing.

U kunt ook in de Verkenner-weergave met de >

Stap 4: De code uitvoeren als een taak

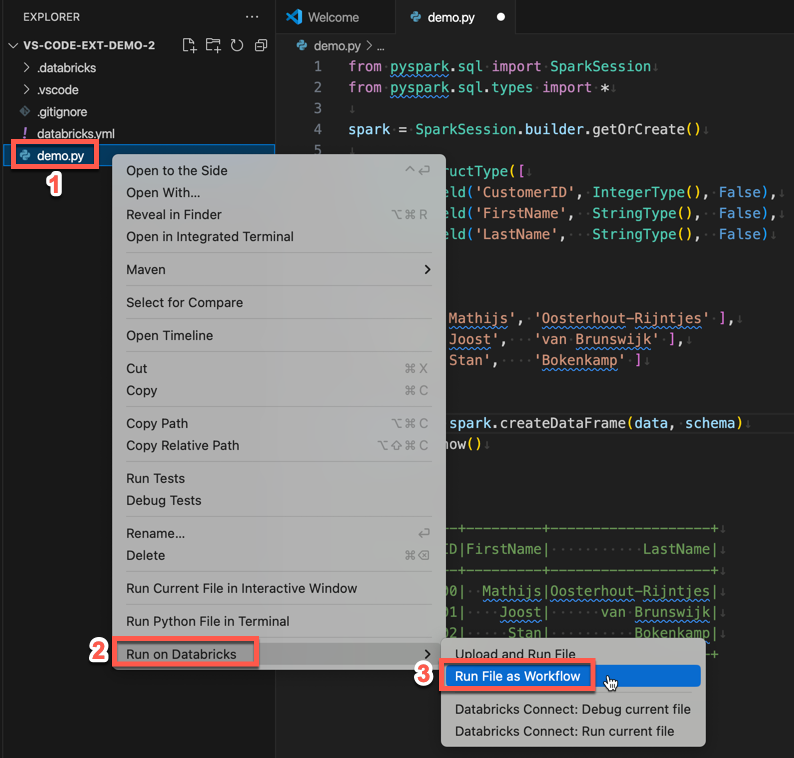

Als u demo.py als taak wilt uitvoeren, klikt u op het pictogram Uitvoeren op Databricks naast de lijst met editortabbladen en klikt u vervolgens op Bestand uitvoeren als werkstroom. De uitvoer wordt weergegeven op een afzonderlijk editortabblad naast de demo.py bestandseditor.

![]()

U kunt ook met de rechtermuisknop op het demo.py bestand klikken in het deelvenster Explorer en dan Uitvoeren op Databricks>Run File as Workflowselecteren.

Volgende stappen

Nu u de Databricks-extensie voor Visual Studio Code hebt gebruikt om een lokaal Python-bestand te uploaden en op afstand uit te voeren, kunt u ook het volgende doen:

- Verken Databricks Asset Bundels-resources en -variabelen met behulp van de gebruikersinterface van de extensie. Zie de extensiefuncties van Databricks Asset Bundles.

- Python-code uitvoeren of fouten opsporen met Databricks Connect. Zie Code voor foutopsporing met behulp van Databricks Connect voor de Databricks-extensie voor Visual Studio Code.

- Voer een bestand of notebook uit als een Azure Databricks-taak. Zie Een bestand uitvoeren op een cluster of een bestand of notebook als een taak in Azure Databricks met behulp van de Databricks-extensie voor Visual Studio Code.

- Voer tests uit met

pytest. Zie Test uitvoeren met pytest met behulp van de Databricks-extensie voor Visual Studio Code.