Een bestand uitvoeren op een cluster of een bestand of notebook als een taak in Azure Databricks met behulp van de Databricks-extensie voor Visual Studio Code

Met de Databricks-extensie voor Visual Studio Code kunt u uw Python-code uitvoeren op een cluster of uw Python-, R-, Scala- of SQL-code of -notebook als taak in Azure Databricks.

Bij deze informatie wordt ervan uitgegaan dat u de Databricks-extensie al hebt geïnstalleerd en ingesteld voor Visual Studio Code. Zie De Databricks-extensie voor Visual Studio Code installeren.

Notitie

Als u fouten wilt opsporen in code of notebooks vanuit Visual Studio Code, gebruikt u Databricks Connect. Zie Fouten opsporen in code met behulp van Databricks Connect voor de Databricks-extensie voor Visual Studio Code en Notebook-cellen uitvoeren en fouten opsporen met Databricks Connect met behulp van de Databricks-extensie voor Visual Studio Code.

Een Python-bestand uitvoeren op een cluster

Als u een Python-bestand wilt uitvoeren op een Azure Databricks-cluster met behulp van de Databricks-extensie voor Visual Studio Code, met de extensie en uw project geopend:

- Open het Python-bestand dat u wilt uitvoeren op het cluster.

- Ga op een van de volgende manieren te werk:

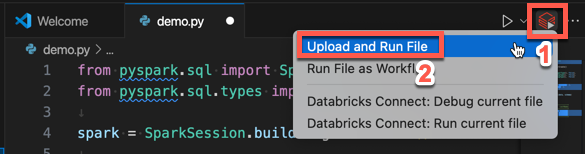

Klik in de titelbalk van de bestandseditor op het pictogram Uitvoeren op Databricks en klik vervolgens op Uploaden en Bestand uitvoeren.

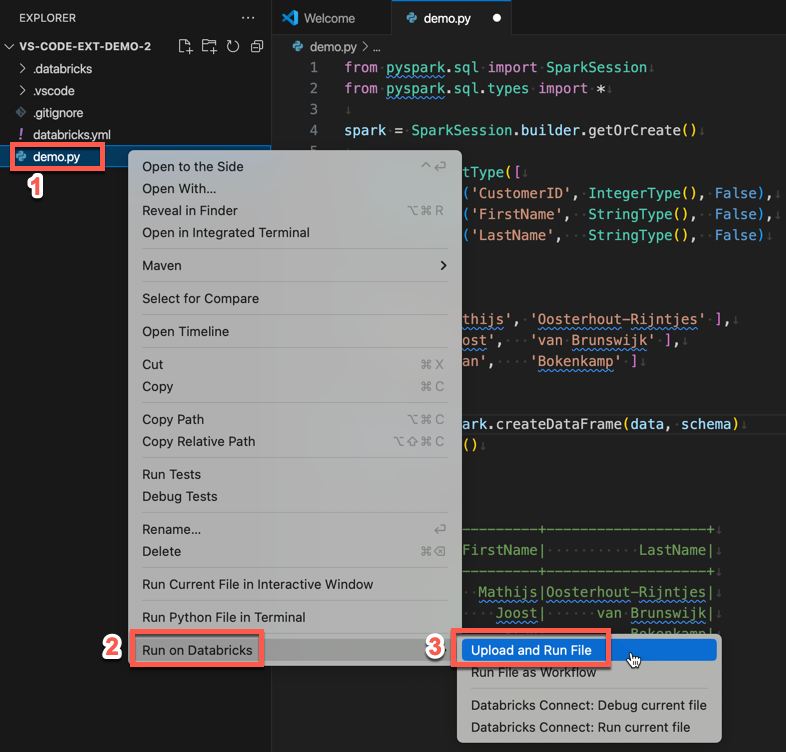

Klik in de Verkenner-weergave (View > Explorer) met de rechtermuisknop op het bestand en selecteer Vervolgens Uitvoeren op Databricks>Upload and Run File in het contextmenu.

Het bestand wordt uitgevoerd op het cluster en de uitvoer is beschikbaar in de Console voor foutopsporing (Weergave > foutopsporingsconsole).

Een Python-bestand uitvoeren als taak

Als u een Python-bestand wilt uitvoeren als een Azure Databricks-taak met behulp van de Databricks-extensie voor Visual Studio Code, met de extensie en uw project geopend:

- Open het Python-bestand dat u wilt uitvoeren als een taak.

- Ga op een van de volgende manieren te werk:

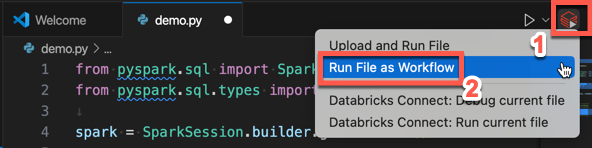

Klik in de titelbalk van de bestandseditor op het pictogram Uitvoeren op Databricks en klik vervolgens op Bestand uitvoeren als werkstroom.

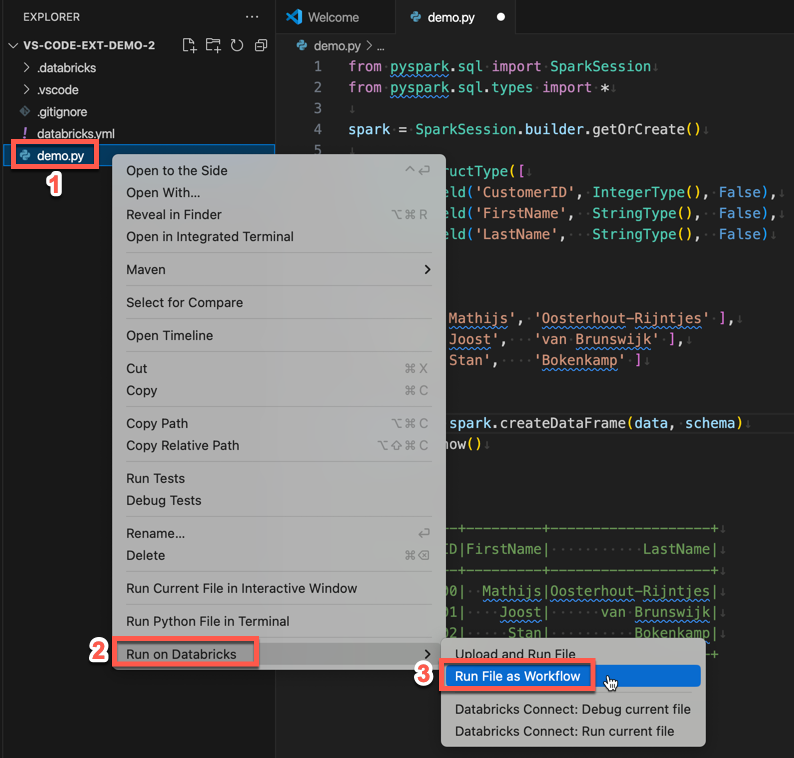

Klik in de Verkenner-weergave (View > Explorer) met de rechtermuisknop op het bestand en selecteer Vervolgens Uitvoeren op Databricks>Run File as Workflow in het contextmenu.

Er wordt een nieuw tabblad editor weergegeven met de titel Databricks-taakuitvoering. Het bestand wordt uitgevoerd als een taak in de werkruimte en eventuele uitvoer wordt afgedrukt naar het uitvoergebied van het nieuwe editortabblad.

Als u informatie over de taakuitvoering wilt weergeven, klikt u op de koppeling Taakuitvoerings-id op het nieuwe tabblad Taakuitvoering in Databricks Job Run . Uw werkruimte wordt geopend en de details van de taakuitvoering worden weergegeven in de werkruimte.

Een Python-, R-, Scala- of SQL-notebook uitvoeren als taak

Als u een notebook wilt uitvoeren als een Azure Databricks-taak met behulp van de Databricks-extensie voor Visual Studio Code, waarbij de extensie en uw project zijn geopend:

Open het notitieblok dat u wilt uitvoeren als een taak.

Tip

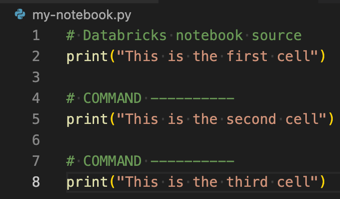

Als u een Python-, R-, Scala- of SQL-bestand wilt omzetten in een Azure Databricks-notebook, voegt u de opmerking

# Databricks notebook sourcetoe aan het begin van het bestand en voegt u de opmerking# COMMAND ----------toe vóór elke cel. Zie Een bestand importeren en converteren naar een notitieblok voor meer informatie.

Voer een van de volgende stappen uit:

- Klik in de titelbalk van de notebookbestandseditor op het pictogram Uitvoeren op Databricks en klik vervolgens op Bestand uitvoeren als werkstroom.

Notitie

Als Uitvoeren op Databricks niet beschikbaar is, raadpleegt u Een aangepaste uitvoeringsconfiguratie maken.

- Klik in de Verkenner-weergave (View > Explorer) met de rechtermuisknop op het notebookbestand en selecteer Vervolgens Uitvoeren op Databricks>Run File as Workflow in het contextmenu.

Er wordt een nieuw tabblad editor weergegeven met de titel Databricks-taakuitvoering. Het notebook wordt uitgevoerd als een taak in de werkruimte. Het notebook en de uitvoer worden weergegeven in het gebied Uitvoer van het nieuwe editortabblad.

Als u informatie over de taakuitvoering wilt weergeven, klikt u op de koppeling Taakuitvoerings-id op het tabblad Databricks Job Run Editor. Uw werkruimte wordt geopend en de details van de taakuitvoering worden weergegeven in de werkruimte.

Een aangepaste uitvoeringsconfiguratie maken

Met een aangepaste uitvoeringsconfiguratie voor de Databricks-extensie voor Visual Studio Code kunt u aangepaste argumenten doorgeven aan een taak of een notebook, of verschillende uitvoeringsinstellingen voor verschillende bestanden maken.

Als u een aangepaste uitvoeringsconfiguratie wilt maken, klikt u in het hoofdmenu in Visual Studio Code op Configuratie > toevoegen uitvoeren. Selecteer vervolgens Databricks voor een configuratie voor uitvoering op basis van een cluster of Databricks: Werkstroom voor een taakgebaseerde uitvoeringsconfiguratie.

Met de volgende aangepaste uitvoeringsconfiguratie wijzigt u bijvoorbeeld de opdracht Bestand uitvoeren als het starten van de werkstroom om het --prod argument door te geven aan de taak:

{

"version": "0.2.0",

"configurations": [

{

"type": "databricks-workflow",

"request": "launch",

"name": "Run on Databricks as Workflow",

"program": "${file}",

"parameters": {},

"args": ["--prod"]

}

]

}

Tip

Voeg "databricks": true toe aan uw "type": "python" configuratie als u python-configuratie wilt gebruiken, maar profiteer van de Databricks Connect-verificatie die deel uitmaakt van de installatie van de extensie.

Met aangepaste uitvoeringsconfiguraties kunt u ook opdrachtregelargumenten doorgeven en uw code uitvoeren door op F5 te drukken. Zie De startconfiguraties in de documentatie van Visual Studio Code voor meer informatie.