Weergegeven modellen bewaken met AI Gateway-geschikte inferentietabellen

Belangrijk

Deze functie bevindt zich in openbare preview-versie.

Belangrijk

In dit artikel worden onderwerpen beschreven die van toepassing zijn op deductietabellen voor externe modellen, ingerichte doorvoerworkloads of agentmodellen. Zie voor aangepaste modellende inferentietabellen voor het bewaken en opsporen van fouten.

In dit artikel worden de inferentietabellen met AI Gateway beschreven voor het bewaken van uitgevoerde modellen. De deductietabel legt automatisch binnenkomende aanvragen en uitgaande antwoorden vast voor een eindpunt en registreert deze als een Unity Catalog Delta-tabel. U kunt de gegevens in deze tabel gebruiken om machine learning-modellen te bewaken, evalueren, vergelijken en verfijnen.

Wat zijn deductietabellen met AI Gateway?

Inference-tabellen met AI Gateway-functionaliteit vereenvoudigen het monitoren en diagnosticeren van modellen door het continu loggen van aanvraaginvoer en antwoorden (voorspellingen) van Mosaic AI Model Serving-eindpunten, en ze op te slaan in een Delta-tabel in Unity Catalog. Vervolgens kunt u alle mogelijkheden van het Databricks-platform gebruiken, zoals Databricks SQL-query's en notebooks om uw modellen te bewaken, fouten op te sporen en te optimaliseren.

U kunt deductietabellen inschakelen op een bestaand of nieuw model dat het eindpunt bedient, en aanvragen voor dat eindpunt worden vervolgens automatisch geregistreerd bij een tabel in Unity Catalog.

Enkele algemene toepassingen voor deductietabellen zijn het volgende:

- Maak een trainingscorpus. Door deductietabellen samen te voegen met basiswaarlabels, kunt u een trainingslichaam maken dat u kunt gebruiken om uw model opnieuw te trainen of af te stemmen en te verbeteren. Met Databricks-taken kunt u een continue feedbackloop instellen en het opnieuw trainen automatiseren.

- Gegevens en modelkwaliteit bewaken. U kunt uw modelprestaties en gegevensdrift continu bewaken met Behulp van Lakehouse Monitoring. Lakehouse Monitoring genereert automatisch dashboards voor gegevens- en modelkwaliteit die u met belanghebbenden kunt delen. Daarnaast kunt u waarschuwingen inschakelen om te weten wanneer u uw model opnieuw moet trainen op basis van verschuivingen in binnenkomende gegevens of verminderingen van modelprestaties.

- Problemen met productie opsporen. Logboekgegevens van inferentietabellen, zoals HTTP-statuscodes, JSON-code voor aanvragen en antwoorden, modellooptijden en traceeruitvoer tijdens de looptijden van modellen. U kunt deze prestatiegegevens gebruiken voor foutopsporing. U kunt de historische gegevens in deductietabellen ook gebruiken om modelprestaties te vergelijken met historische aanvragen.

vereisten voor

AI Gateway-ingeschakelde inferentietabellen worden alleen ondersteund voor eindpunten die gebruikmaken van ingerichte doorvoer of externe modellenleveren.

Een Databricks-werkruimte in:

Volg de stappen in Privéconnectiviteit configureren vanuit serverloze computevoor werkruimten die privéconnectiviteit hebben geconfigureerd op het Unity Catalog-opslagaccount.

Databricks raadt u aan om voorspellende optimalisatie in te schakelen voor geoptimaliseerde prestaties van uw deductietabellen.

Voor uw werkruimte moet Unity Catalog zijn ingeschakeld.

Zowel de maker van het eindpunt als de bewerker moet beschikken over de machtiging Kan Beheren voor het eindpunt. Zie Toegangsbeheerlijsten.

Zowel de maker van het eindpunt als de aanpasser moeten de volgende machtigingen hebben in Unity Catalog.

-

USE CATALOGmachtigingen voor de opgegeven catalogus. -

USE SCHEMAmachtigingen voor het opgegeven schema. -

CREATE TABLEmachtigingen in het schema.

-

Waarschuwing

De deductietabel kan de logboekregistratie van gegevens stoppen of beschadigd raken als u een van de volgende handelingen uitvoert:

- Wijzig het tabelschema.

- Wijzig de tabelnaam.

- Verwijder de tabel.

- Machtigingen voor de Unity Catalog-catalogus of -schema verliezen.

Deductietabellen in- en uitschakelen

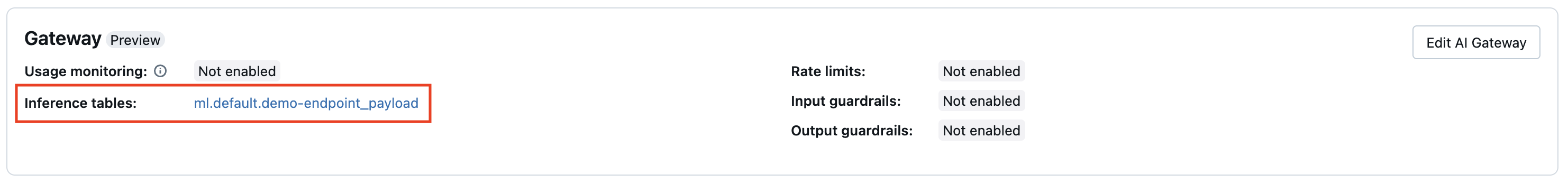

In deze sectie wordt beschreven hoe u inferentietabellen kunt in- of uitschakelen met de Serving-gebruikersinterface. De eigenaar van de deductietabellen is de gebruiker die het eindpunt heeft gemaakt. Alle toegangsbeheerlijsten (ACL's) in de tabel volgen de standaardmachtigingen voor Unity Catalog en kunnen worden gewijzigd door de eigenaar van de tabel.

Gebruik de volgende stappen om deductietabellen in te schakelen tijdens het maken van een eindpunt:

- Klik op Serving in de Databricks Mosaic AI-gebruikersinterface.

- Klik op Eindpunt voor de service maken.

- Selecteer in de sectie AI Gateway Deductietabellen inschakelen.

U kunt deductietabellen ook inschakelen op een bestaand eindpunt. Ga als volgt te werk om een bestaande eindpuntconfiguratie te bewerken:

- Klik in de sectie AI Gateway op AI Gateway bewerken.

- Selecteer Inferentietabellen inschakelen.

Volg deze instructies om deductietabellen uit te schakelen:

- Navigeer naar de eindpuntpagina.

- Klik op AI Gateway-bewerken.

- Klik op Inferentietabel inschakelen om het vinkje te verwijderen.

- Nadat u tevreden bent met de specificaties van de AI Gateway, klikt u op bijwerken.

Resultaten in de deductietabel opvragen en analyseren

Nadat uw aangeboden modellen gereed zijn, worden alle verzoeken die aan uw modellen worden gedaan, automatisch geregistreerd bij de inferentietabel, samen met de antwoorden. U kunt de tabel in de gebruikersinterface bekijken, een query uitvoeren op de tabel vanuit Databricks SQL of een notebook, of een query uitvoeren op de tabel met behulp van de REST API.

Als u de tabel in de gebruikersinterface wilt weergeven: Klik op de eindpuntpagina op de naam van de deductietabel om de tabel te openen in Catalog Explorer.

Om een query uit te voeren op de tabel vanuit Databricks SQL of een Databricks-notebook: U kunt code uitvoeren die vergelijkbaar is met het volgende om een query uit te voeren op de deductietabel.

SELECT * FROM <catalog>.<schema>.<payload_table>

** Als u uw deductietabelgegevens wilt samenvoegen met details over het onderliggende basismodel dat op uw eindpunt wordt geleverd:** Foundation-modelgegevens worden vastgelegd in de system.serving.served_entities systeemtabel.

SELECT * FROM <catalog>.<schema>.<payload_table> payload

JOIN system.serving.served_entities se on payload.served_entity_id = se.served_entity_id

door AI Gateway ondersteund inferentieschema

Deductietabellen die zijn ingeschakeld met behulp van AI Gateway, hebben het volgende schema:

| Kolomnaam | Beschrijving | Type |

|---|---|---|

request_date |

De UTC-datum waarop de aanvraag voor het verwerken van het model is ontvangen. | DATUM |

databricks_request_id |

Een door Azure Databricks gegenereerde aanvraag-id die is gekoppeld aan alle aanvragen voor het verwerken van modellen. | SNAAR |

request_time |

De tijdstempel waarop de aanvraag wordt ontvangen. | TIJDSTEMPEL |

status_code |

De HTTP-statuscode die is geretourneerd van het model. | INT |

sampling_fraction |

De steekproeffractie die wordt gebruikt in het geval dat de aanvraag is uitgevallen. Deze waarde ligt tussen 0 en 1, waarbij 1 aangeeft dat 100% binnenkomende aanvragen zijn opgenomen. | DUBBEL |

execution_duration_ms |

De tijd in milliseconden waarvoor het model deductie heeft uitgevoerd. Dit omvat geen overheadnetwerklatenties en vertegenwoordigt alleen de tijd die het model nodig heeft om voorspellingen te genereren. | BIGINT |

request |

De JSON-hoofdtekst van de onbewerkte aanvraag die is verzonden naar het eindpunt van de modelfunctie. | SNAAR |

response |

De onbewerkte antwoord-JSON-hoofdtekst die is geretourneerd door het model dat het eindpunt levert. | SNAAR |

served_entity_id |

De unieke id van de bediende entiteit. | SNAAR |

logging_error_codes |

De fouten die zijn opgetreden bij het niet registreren van de gegevens. Foutcodes omvatten MAX_REQUEST_SIZE_EXCEEDED en MAX_RESPONSE_SIZE_EXCEEDED. |

ARRAY |

requester |

De id van de gebruiker of service-principal waarvan de machtigingen worden gebruikt voor de aanroepaanvraag van het service-eindpunt. | SNAAR |

beperkingen voor

Ingerichte doorvoerworkloads:

- Als u een nieuw model voor eindpunt maakt dat gebruikmaakt van ingerichte doorvoer, worden alleen deductietabellen met AI Gateway ondersteund.

- Als u een bestaand model hebt dat een eindpunt biedt dat gebruikmaakt van ingerichte doorvoer en deze nog nooit deductietabellen had geconfigureerd, kunt u het bijwerken om deductietabellen met AI Gateway te gebruiken.

- Als u een bestaand model hebt dat een eindpunt biedt dat gebruikmaakt van ingerichte doorvoer en deze deductietabellen heeft die momenteel of eerder zijn geconfigureerd, kunt u het niet bijwerken om deductietabellen met AI Gateway te gebruiken.

- Voor het streamen van antwoordlogboeken van AI-agent worden alleen velden en traceringen die compatibel zijn met ChatCompletion samengevoegd.

De bezorging van logs van interpreteringstabellen is momenteel naar beste vermogen, maar u kunt verwachten dat logs binnen 1 uur na een verzoek beschikbaar zijn. Neem contact op met uw Databricks-accountteam voor meer informatie.

De maximale aanvraag- en antwoordgrootte die wordt geregistreerd, is 1 MiB (1.048.576 bytes). Nettoladingen voor aanvragen en antwoorden die deze overschrijden, worden geregistreerd als

nullenlogging_error_codesworden gevuld metMAX_REQUEST_SIZE_EXCEEDEDofMAX_RESPONSE_SIZE_EXCEEDED.

Zie Beperkingenvoor beperkingen die specifiek zijn voor AI Gateway. Zie Limieten en regio'svoor algemene eindpuntbeperkingen voor modellen die eindpunten leveren.