Gegevens kopiëren en transformeren met dynamische parameters per uur

VAN TOEPASSING OP:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Probeer Data Factory uit in Microsoft Fabric, een alles-in-één analyseoplossing voor ondernemingen. Microsoft Fabric omvat alles, van gegevensverplaatsing tot gegevenswetenschap, realtime analyses, business intelligence en rapportage. Meer informatie over het gratis starten van een nieuwe proefversie .

In dit scenario wilt u gegevens kopiëren van AWS S3 naar Azure Blob Storage en transformeren met Azure Databricks (met dynamische parameters in het script) volgens een uurschema voor 8 uur per dag gedurende meer dan 30 dagen.

De prijzen die in dit voorbeeld hieronder worden gebruikt, zijn hypothetisch en zijn niet bedoeld om exacte werkelijke prijzen te impliceren. Lees-/schrijf- en bewakingskosten worden niet weergegeven omdat ze doorgaans te verwaarlozen zijn en niet van invloed zijn op de totale kosten. Uitvoeringen van activiteiten worden ook afgerond op de dichtstbijzijnde 1000 in schattingen van de prijscalculator.

Raadpleeg de Azure-prijscalculator voor specifiekere scenario's en om uw toekomstige kosten te schatten voor het gebruik van de service.

Configuratie

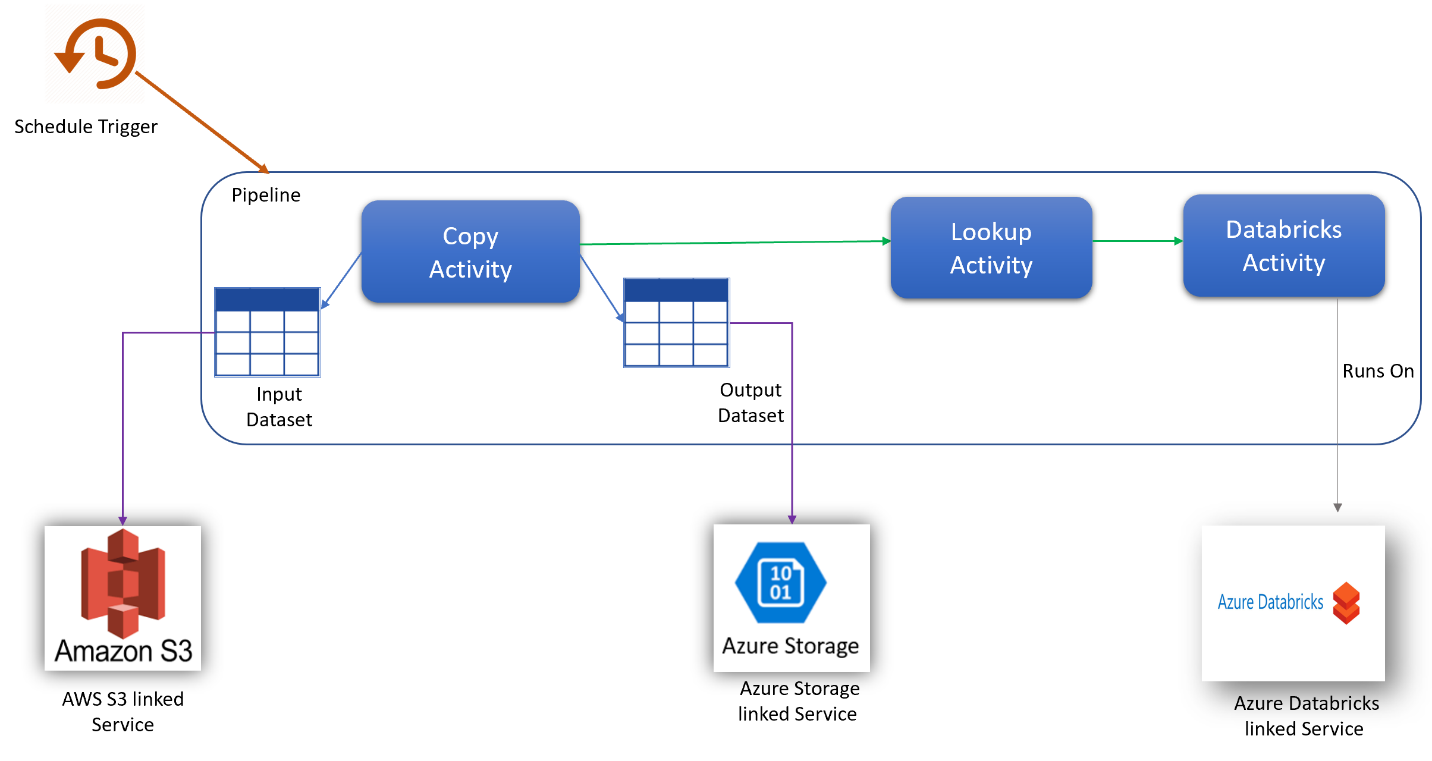

Als u het scenario wilt uitvoeren, moet u een pijplijn maken met de volgende items:

- Eén kopieeractiviteit met een invoergegevensset voor de gegevens die moeten worden gekopieerd uit AWS S3, een uitvoergegevensset voor de gegevens in Azure Storage.

- Eén opzoekactiviteit voor het dynamisch doorgeven van parameters aan het transformatiescript.

- Eén Azure Databricks-activiteit voor de gegevenstransformatie.

- Eén schematrigger voor het uitvoeren van de pijplijn elk uur gedurende 8 uur per dag. Wanneer u een pijplijn wilt uitvoeren, kunt u deze direct activeren of plannen. Naast de pijplijn zelf telt elk triggerexemplaren als één activiteitsuitvoering.

Schatting van kosten

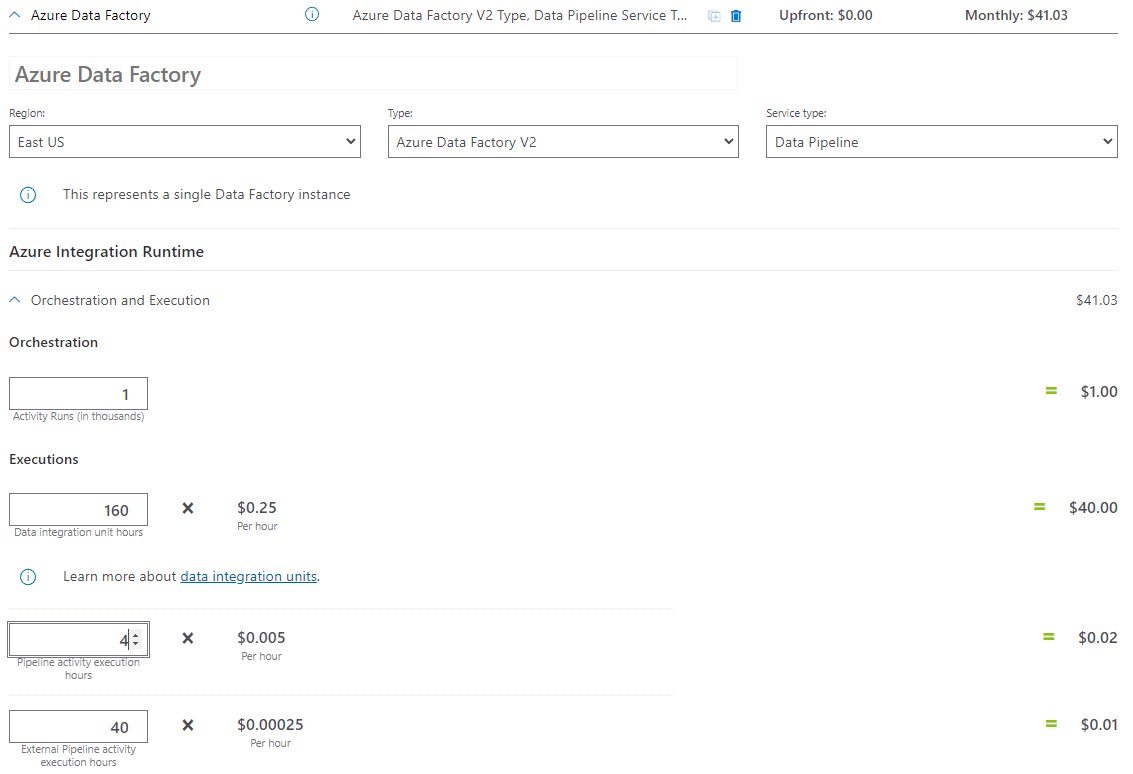

Voorbeeld van prijscalculator: voorbeeld van prijscalculator

Totaal aantal scenarioprijzen voor 30 dagen: $ 41,03

Gerelateerde inhoud

- Prijsvoorbeeld: Gegevens kopiëren van AWS S3 naar Azure Blob Storage gedurende 30 dagen

- Prijsvoorbeeld: Gegevens kopiëren en transformeren met Azure Databricks per uur gedurende 30 dagen

- Prijsvoorbeeld: SSIS-pakketten uitvoeren in Azure-SSIS Integration Runtime

- Prijsvoorbeeld: Foutopsporing voor toewijzingsgegevensstromen gebruiken voor een normale werkdag

- Prijsvoorbeeld: Gegevens transformeren in blobopslag met toewijzingsgegevensstromen

- Prijsvoorbeeld: Gegevensintegratie in beheerd VNET van Azure Data Factory

- Prijsvoorbeeld: Deltagegevens ophalen uit SAP ECC via SAP CDC in toewijzingsgegevensstromen