GPT-4o Realtime-API voor spraak en audio (preview)

Notitie

Deze functie is momenteel beschikbaar als openbare preview-versie. Deze preview wordt aangeboden zonder een service level agreement en we raden deze niet aan voor productieworkloads. Misschien worden bepaalde functies niet ondersteund of zijn de mogelijkheden ervan beperkt. Zie Aanvullende gebruiksvoorwaarden voor Microsoft Azure-previews voor meer informatie.

Azure OpenAI GPT-4o Realtime-API voor spraak en audio maakt deel uit van de GPT-4o-modelfamilie die ondersteuning biedt voor gesprekken met een lage latentie, spraak in spraak en spraak. De GPT-4o-audio-API realtime is ontworpen om realtime, gespreksinteracties met lage latentie af te handelen, waardoor het een uitstekende keuze is voor gebruiksvoorbeelden met live interacties tussen een gebruiker en een model, zoals klantondersteuningsmedewerkers, spraakassistenten en realtime vertalers.

De meeste gebruikers van de Realtime-API moeten in realtime audio leveren en ontvangen van een eindgebruiker, inclusief toepassingen die gebruikmaken van WebRTC of een telefoniesysteem. De Realtime-API is niet ontworpen om rechtstreeks verbinding te maken met apparaten van eindgebruikers en is afhankelijk van clientintegraties om audiostreams van eindgebruikers te beëindigen.

Ondersteunde modellen

De GPT 4o realtime modellen zijn beschikbaar voor wereldwijde implementaties.

-

gpt-4o-realtime-preview(versie2024-12-17) -

gpt-4o-mini-realtime-preview(versie2024-12-17) -

gpt-4o-realtime-preview(versie2024-10-01)

Zie de documentatie over modellen en versies voor meer informatie.

API-ondersteuning

Ondersteuning voor de Realtime-API is voor het eerst toegevoegd in api-versie 2024-10-01-preview. Gebruik de nieuwste 2024-12-17 modelversie.

Een model implementeren voor realtime audio

Het model implementeren gpt-4o-mini-realtime-preview in de Azure AI Foundry-portal:

- Ga naar de azure OpenAI-servicepagina in de Azure AI Foundry-portal. Zorg ervoor dat u bent aangemeld met het Azure-abonnement met uw Azure OpenAI Service-resource (met of zonder modelimplementaties).)

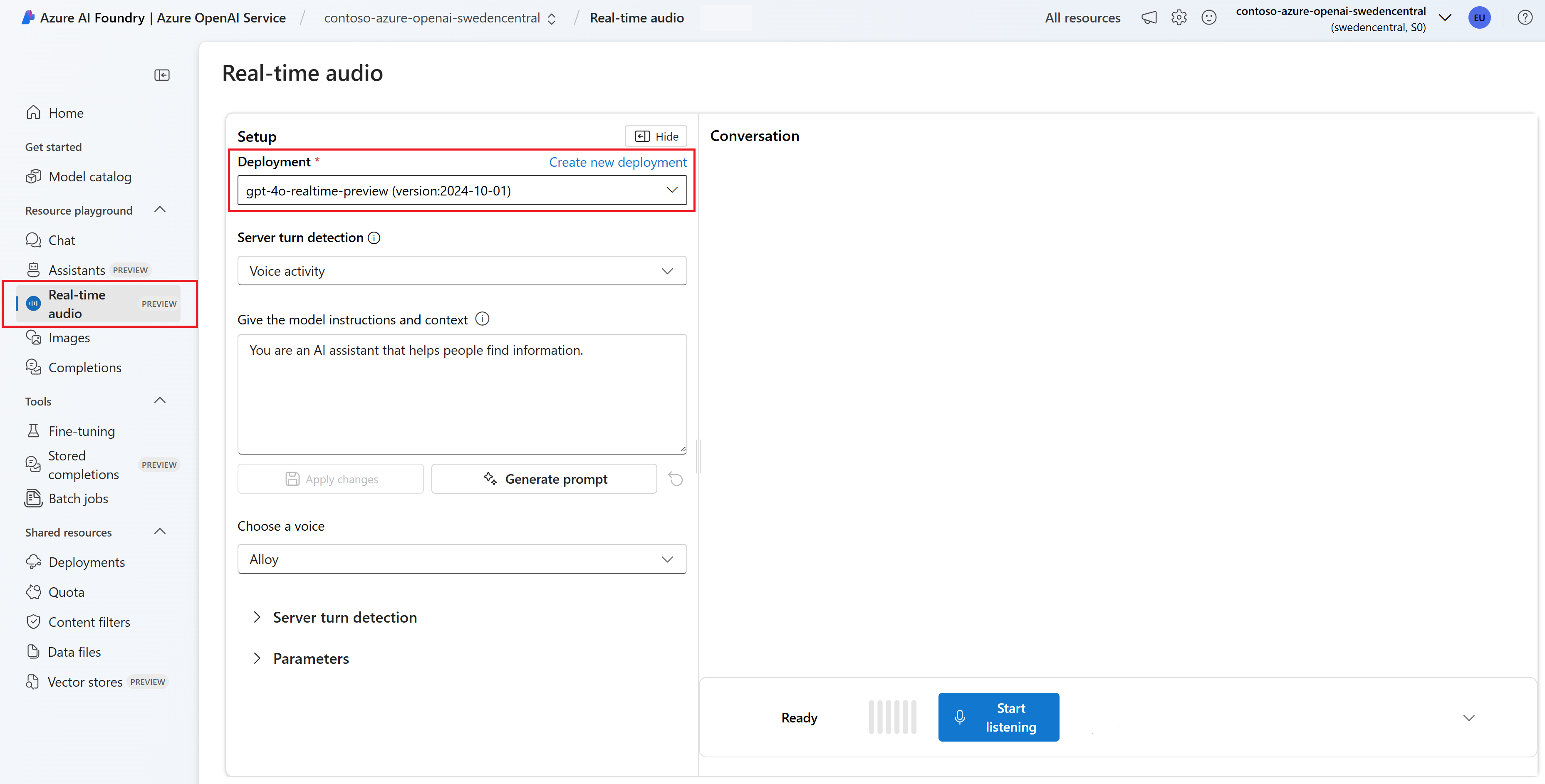

- Selecteer de realtime audiospeeltuin onder Speeltuinen in het linkerdeelvenster.

- Selecteer + Nieuwe implementatie>maken van basismodellen om het implementatievenster te openen.

- Zoek en selecteer het

gpt-4o-mini-realtime-previewmodel en selecteer vervolgens Implementeren naar geselecteerde resource. - Selecteer in de implementatiewizard de

2024-12-17modelversie. - Volg de wizard om het model te implementeren.

Nu u een implementatie van het gpt-4o-mini-realtime-preview model hebt, kunt u er in realtime mee werken in de Realtime audiospeeltuin of realtime-API van de Azure AI Foundry-portal.

De GPT-4o realtime audio gebruiken

Volg deze stappen om te chatten met uw geïmplementeerde gpt-4o-mini-realtime-preview model in de realtime audiospeeltuin van Azure AI Foundry:

Ga naar de azure OpenAI-servicepagina in de Azure AI Foundry-portal. Zorg ervoor dat u bent aangemeld met het Azure-abonnement met uw Azure OpenAI Service-resource en het geïmplementeerde

gpt-4o-mini-realtime-previewmodel.Selecteer de realtime audiospeeltuin onder Speeltuinen in het linkerdeelvenster.

Selecteer het geïmplementeerde

gpt-4o-mini-realtime-previewmodel in de vervolgkeuzelijst Implementatie .Selecteer Microfoon inschakelen om de browser toegang te geven tot uw microfoon. Als u al toestemming hebt verleend, kunt u deze stap overslaan.

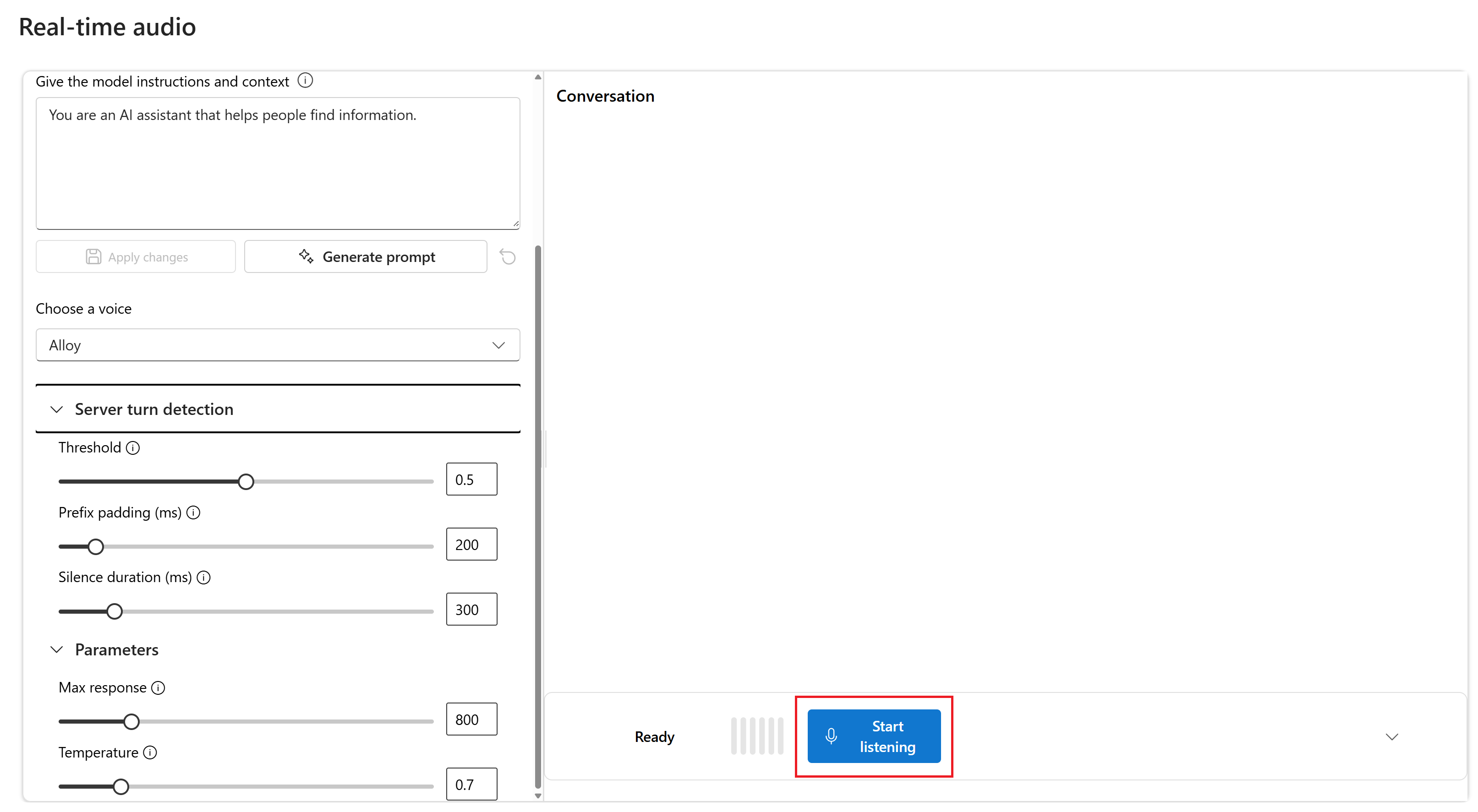

U kunt eventueel inhoud bewerken in het tekstvak Modelinstructies en context geven. Geef het model instructies over hoe het zich moet gedragen en eventuele context waarnaar wordt verwezen bij het genereren van een antwoord. U kunt de persoonlijkheid van de assistent beschrijven, vertellen wat het wel en niet moet beantwoorden en hoe u antwoorden kunt opmaken.

U kunt desgewenst instellingen wijzigen, zoals drempelwaarde, opvulling van voorvoegsels en stilteduur.

Selecteer Starten om de sessie te starten. U kunt in de microfoon spreken om een chat te starten.

U kunt de chat op elk gewenst moment onderbreken door te spreken. U kunt de chat beëindigen door de knop Luisteren stoppen te selecteren.

Vereisten

- Een Azure-abonnement - Een gratis abonnement maken

- Node.js LTS- of ESM-ondersteuning.

- Een Azure OpenAI-resource die is gemaakt in een van de ondersteunde regio's. Zie de documentatie over modellen en versies voor meer informatie over beschikbaarheid van regio's.

- Vervolgens moet u een

gpt-4o-mini-realtime-previewmodel implementeren met uw Azure OpenAI-resource. Zie Een resource maken en een model implementeren met Azure OpenAI voor meer informatie.

Vereisten voor Microsoft Entra-id

Voor de aanbevolen sleutelloze verificatie met Microsoft Entra-id moet u het volgende doen:

- Installeer de Azure CLI die wordt gebruikt voor sleutelloze verificatie met Microsoft Entra-id.

- Wijs de

Cognitive Services Userrol toe aan uw gebruikersaccount. U kunt rollen toewijzen in Azure Portal onder Toegangsbeheer (IAM)>Roltoewijzing toevoegen.

Een model implementeren voor realtime audio

Het model implementeren gpt-4o-mini-realtime-preview in de Azure AI Foundry-portal:

- Ga naar de azure OpenAI-servicepagina in de Azure AI Foundry-portal. Zorg ervoor dat u bent aangemeld met het Azure-abonnement met uw Azure OpenAI Service-resource (met of zonder modelimplementaties).)

- Selecteer de realtime audiospeeltuin onder Speeltuinen in het linkerdeelvenster.

- Selecteer + Nieuwe implementatie>maken van basismodellen om het implementatievenster te openen.

- Zoek en selecteer het

gpt-4o-mini-realtime-previewmodel en selecteer vervolgens Implementeren naar geselecteerde resource. - Selecteer in de implementatiewizard de

2024-12-17modelversie. - Volg de wizard om het model te implementeren.

Nu u een implementatie van het gpt-4o-mini-realtime-preview model hebt, kunt u er in realtime mee werken in de Realtime audiospeeltuin of realtime-API van de Azure AI Foundry-portal.

Instellingen

Maak een nieuwe map

realtime-audio-quickstartdie de toepassing bevat en open Visual Studio Code in die map met de volgende opdracht:mkdir realtime-audio-quickstart && code realtime-audio-quickstartMaak de

package.jsonopdracht met de volgende opdracht:npm init -yWerk de

package.jsonapp bij naar ECMAScript met de volgende opdracht:npm pkg set type=moduleInstalleer de realtime audioclientbibliotheek voor JavaScript met:

npm install https://github.com/Azure-Samples/aoai-realtime-audio-sdk/releases/download/js/v0.5.2/rt-client-0.5.2.tgzVoor de aanbevolen sleutelloze verificatie met Microsoft Entra ID installeert u het

@azure/identitypakket met:npm install @azure/identity

Resourcegegevens ophalen

U moet de volgende informatie ophalen om uw toepassing te verifiëren met uw Azure OpenAI-resource:

| Naam van de variabele | Weergegeven als |

|---|---|

AZURE_OPENAI_ENDPOINT |

Deze waarde vindt u in de sectie Sleutels en eindpunt bij het controleren van uw resource vanuit Azure Portal. |

AZURE_OPENAI_DEPLOYMENT_NAME |

Deze waarde komt overeen met de aangepaste naam die u hebt gekozen voor uw implementatie toen u een model hebt geïmplementeerd. Deze waarde vindt u onder Resource Management>Model Deployments in Azure Portal. |

OPENAI_API_VERSION |

Meer informatie over API-versies. |

Meer informatie over sleutelloze verificatie en het instellen van omgevingsvariabelen.

Let op

Als u de aanbevolen sleutelloze verificatie met de SDK wilt gebruiken, moet u ervoor zorgen dat de AZURE_OPENAI_API_KEY omgevingsvariabele niet is ingesteld.

Tekst in audio-out

Maak het

text-in-audio-out.jsbestand met de volgende code:import { DefaultAzureCredential } from "@azure/identity"; import { LowLevelRTClient } from "rt-client"; import dotenv from "dotenv"; dotenv.config(); async function text_in_audio_out() { // Set environment variables or edit the corresponding values here. const endpoint = process.env["AZURE_OPENAI_ENDPOINT"] || "yourEndpoint"; const deployment = "gpt-4o-mini-realtime-preview"; if (!endpoint || !deployment) { throw new Error("You didn't set the environment variables."); } const client = new LowLevelRTClient(new URL(endpoint), new DefaultAzureCredential(), { deployment: deployment }); try { await client.send({ type: "response.create", response: { modalities: ["audio", "text"], instructions: "Please assist the user." } }); for await (const message of client.messages()) { switch (message.type) { case "response.done": { break; } case "error": { console.error(message.error); break; } case "response.audio_transcript.delta": { console.log(`Received text delta: ${message.delta}`); break; } case "response.audio.delta": { const buffer = Buffer.from(message.delta, "base64"); console.log(`Received ${buffer.length} bytes of audio data.`); break; } } if (message.type === "response.done" || message.type === "error") { break; } } } finally { client.close(); } } await text_in_audio_out();Meld u aan bij Azure met de volgende opdracht:

az loginVoer het JavaScript-bestand uit.

node text-in-audio-out.js

Wacht even om het antwoord te krijgen.

Uitvoer

Het script ontvangt een antwoord van het model en drukt de ontvangen transcriptie- en audiogegevens af.

De uitvoer ziet er ongeveer als volgt uit:

Received text delta: Hello

Received text delta: !

Received text delta: How

Received text delta: can

Received text delta: I

Received 4800 bytes of audio data.

Received 7200 bytes of audio data.

Received text delta: help

Received 12000 bytes of audio data.

Received text delta: you

Received text delta: today

Received text delta: ?

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 24000 bytes of audio data.

Voorbeeld van webtoepassing

Ons JavaScript-webvoorbeeld op GitHub laat zien hoe u de GPT-4o Realtime-API gebruikt om in realtime met het model te communiceren. De voorbeeldcode bevat een eenvoudige webinterface waarmee audio van de microfoon van de gebruiker wordt vastgelegd en naar het model wordt verzonden voor verwerking. Het model reageert met tekst en audio, die de voorbeeldcode weergeeft in de webinterface.

U kunt de voorbeeldcode lokaal op uw computer uitvoeren door deze stappen uit te voeren. Raadpleeg de opslagplaats op GitHub voor de meest recente instructies.

Als u Node.js niet hebt geïnstalleerd, downloadt en installeert u de LTS-versie van Node.js.

Kloon de opslagplaats naar uw lokale computer:

git clone https://github.com/Azure-Samples/aoai-realtime-audio-sdk.gitGa naar de map in de

javascript/samples/webcode-editor van uw voorkeur.cd ./javascript/samplesVoer

download-pkg.ps1de vereiste pakketten uit ofdownload-pkg.shdownload deze.Ga naar de

webmap uit de./javascript/samplesmap.cd ./webVoer deze opdracht uit

npm installom pakketafhankelijkheden te installeren.Voer

npm run devdeze opdracht uit om de webserver te starten, waarbij u indien nodig door eventuele firewallmachtigingen navigeert.Ga naar een van de opgegeven URI's vanuit de console-uitvoer (zoals

http://localhost:5173/) in een browser.Voer de volgende informatie in de webinterface in:

-

Eindpunt: het resource-eindpunt van een Azure OpenAI-resource. U hoeft het

/realtimepad niet toe te voegen. Een voorbeeldstructuur kan zijnhttps://my-azure-openai-resource-from-portal.openai.azure.com. - API-sleutel: een bijbehorende API-sleutel voor de Azure OpenAI-resource.

-

Implementatie: de naam van het

gpt-4o-mini-realtime-previewmodel dat u in de vorige sectie hebt geïmplementeerd. - Systeembericht: Optioneel kunt u een systeembericht opgeven, zoals 'Je praat altijd als een vriendelijke piraat'.

- Temperatuur: Optioneel kunt u een aangepaste temperatuur opgeven.

- Spraak: U kunt desgewenst een stem selecteren.

-

Eindpunt: het resource-eindpunt van een Azure OpenAI-resource. U hoeft het

Selecteer de knop Record om de sessie te starten. Accepteer de machtigingen om uw microfoon te gebruiken als u hierom wordt gevraagd.

U ziet nu een

<< Session Started >>bericht in de hoofduitvoer. Vervolgens kunt u in de microfoon spreken om een chat te starten.U kunt de chat op elk gewenst moment onderbreken door te spreken. U kunt de chat beëindigen door de knop Stoppen te selecteren.

Vereisten

- Een Azure-abonnement. Maak gratis een account.

- Python 3.8 of nieuwere versie. U wordt aangeraden Python 3.10 of hoger te gebruiken, maar python 3.8 is vereist. Als u geen geschikte versie van Python hebt geïnstalleerd, kunt u de instructies in de VS Code Python-zelfstudie volgen voor de eenvoudigste manier om Python op uw besturingssysteem te installeren.

- Een Azure OpenAI-resource die is gemaakt in een van de ondersteunde regio's. Zie de documentatie over modellen en versies voor meer informatie over beschikbaarheid van regio's.

- Vervolgens moet u een

gpt-4o-mini-realtime-previewmodel implementeren met uw Azure OpenAI-resource. Zie Een resource maken en een model implementeren met Azure OpenAI voor meer informatie.

Vereisten voor Microsoft Entra-id

Voor de aanbevolen sleutelloze verificatie met Microsoft Entra-id moet u het volgende doen:

- Installeer de Azure CLI die wordt gebruikt voor sleutelloze verificatie met Microsoft Entra-id.

- Wijs de

Cognitive Services Userrol toe aan uw gebruikersaccount. U kunt rollen toewijzen in Azure Portal onder Toegangsbeheer (IAM)>Roltoewijzing toevoegen.

Een model implementeren voor realtime audio

Het model implementeren gpt-4o-mini-realtime-preview in de Azure AI Foundry-portal:

- Ga naar de azure OpenAI-servicepagina in de Azure AI Foundry-portal. Zorg ervoor dat u bent aangemeld met het Azure-abonnement met uw Azure OpenAI Service-resource (met of zonder modelimplementaties).)

- Selecteer de realtime audiospeeltuin onder Speeltuinen in het linkerdeelvenster.

- Selecteer + Nieuwe implementatie>maken van basismodellen om het implementatievenster te openen.

- Zoek en selecteer het

gpt-4o-mini-realtime-previewmodel en selecteer vervolgens Implementeren naar geselecteerde resource. - Selecteer in de implementatiewizard de

2024-12-17modelversie. - Volg de wizard om het model te implementeren.

Nu u een implementatie van het gpt-4o-mini-realtime-preview model hebt, kunt u er in realtime mee werken in de Realtime audiospeeltuin of realtime-API van de Azure AI Foundry-portal.

Instellingen

Maak een nieuwe map

realtime-audio-quickstartdie de toepassing bevat en open Visual Studio Code in die map met de volgende opdracht:mkdir realtime-audio-quickstart && code realtime-audio-quickstartMaak een virtuele omgeving. Als Python 3.10 of hoger al is geïnstalleerd, kunt u een virtuele omgeving maken met behulp van de volgende opdrachten:

Als u de Python-omgeving activeert, betekent dit dat wanneer u de opdrachtregel uitvoert

pythonofpipvanaf de opdrachtregel de Python-interpreter gebruikt die zich in de.venvmap van uw toepassing bevindt. U kunt dedeactivateopdracht gebruiken om de virtuele Python-omgeving af te sluiten en deze later opnieuw te activeren wanneer dat nodig is.Tip

U wordt aangeraden een nieuwe Python-omgeving te maken en te activeren om de pakketten te installeren die u nodig hebt voor deze zelfstudie. Installeer geen pakketten in uw globale Python-installatie. U moet altijd een virtuele of conda-omgeving gebruiken bij het installeren van Python-pakketten, anders kunt u uw globale installatie van Python verbreken.

Installeer de realtime audioclientbibliotheek voor Python met:

pip install "https://github.com/Azure-Samples/aoai-realtime-audio-sdk/releases/download/py%2Fv0.5.3/rtclient-0.5.3.tar.gz"Voor de aanbevolen sleutelloze verificatie met Microsoft Entra ID installeert u het

azure-identitypakket met:pip install azure-identity

Resourcegegevens ophalen

U moet de volgende informatie ophalen om uw toepassing te verifiëren met uw Azure OpenAI-resource:

| Naam van de variabele | Weergegeven als |

|---|---|

AZURE_OPENAI_ENDPOINT |

Deze waarde vindt u in de sectie Sleutels en eindpunt bij het controleren van uw resource vanuit Azure Portal. |

AZURE_OPENAI_DEPLOYMENT_NAME |

Deze waarde komt overeen met de aangepaste naam die u hebt gekozen voor uw implementatie toen u een model hebt geïmplementeerd. Deze waarde vindt u onder Resource Management>Model Deployments in Azure Portal. |

OPENAI_API_VERSION |

Meer informatie over API-versies. |

Meer informatie over sleutelloze verificatie en het instellen van omgevingsvariabelen.

Tekst in audio-out

Maak het

text-in-audio-out.pybestand met de volgende code:import base64 import asyncio from azure.identity.aio import DefaultAzureCredential from rtclient import ( ResponseCreateMessage, RTLowLevelClient, ResponseCreateParams ) # Set environment variables or edit the corresponding values here. endpoint = os.environ["AZURE_OPENAI_ENDPOINT"] deployment = "gpt-4o-mini-realtime-preview" async def text_in_audio_out(): async with RTLowLevelClient( url=endpoint, azure_deployment=deployment, token_credential=DefaultAzureCredential(), ) as client: await client.send( ResponseCreateMessage( response=ResponseCreateParams( modalities={"audio", "text"}, instructions="Please assist the user." ) ) ) done = False while not done: message = await client.recv() match message.type: case "response.done": done = True case "error": done = True print(message.error) case "response.audio_transcript.delta": print(f"Received text delta: {message.delta}") case "response.audio.delta": buffer = base64.b64decode(message.delta) print(f"Received {len(buffer)} bytes of audio data.") case _: pass async def main(): await text_in_audio_out() asyncio.run(main())Voer het Python-bestand uit.

python text-in-audio-out.py

Wacht even om het antwoord te krijgen.

Uitvoer

Het script ontvangt een antwoord van het model en drukt de ontvangen transcriptie- en audiogegevens af.

De uitvoer ziet er ongeveer als volgt uit:

Received text delta: Hello

Received text delta: !

Received text delta: How

Received 4800 bytes of audio data.

Received 7200 bytes of audio data.

Received text delta: can

Received 12000 bytes of audio data.

Received text delta: I

Received text delta: assist

Received text delta: you

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received text delta: today

Received text delta: ?

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 28800 bytes of audio data.

Vereisten

- Een Azure-abonnement - Een gratis abonnement maken

- Node.js LTS- of ESM-ondersteuning.

- TypeScript is wereldwijd geïnstalleerd.

- Een Azure OpenAI-resource die is gemaakt in een van de ondersteunde regio's. Zie de documentatie over modellen en versies voor meer informatie over beschikbaarheid van regio's.

- Vervolgens moet u een

gpt-4o-mini-realtime-previewmodel implementeren met uw Azure OpenAI-resource. Zie Een resource maken en een model implementeren met Azure OpenAI voor meer informatie.

Vereisten voor Microsoft Entra-id

Voor de aanbevolen sleutelloze verificatie met Microsoft Entra-id moet u het volgende doen:

- Installeer de Azure CLI die wordt gebruikt voor sleutelloze verificatie met Microsoft Entra-id.

- Wijs de

Cognitive Services Userrol toe aan uw gebruikersaccount. U kunt rollen toewijzen in Azure Portal onder Toegangsbeheer (IAM)>Roltoewijzing toevoegen.

Een model implementeren voor realtime audio

Het model implementeren gpt-4o-mini-realtime-preview in de Azure AI Foundry-portal:

- Ga naar de azure OpenAI-servicepagina in de Azure AI Foundry-portal. Zorg ervoor dat u bent aangemeld met het Azure-abonnement met uw Azure OpenAI Service-resource (met of zonder modelimplementaties).)

- Selecteer de realtime audiospeeltuin onder Speeltuinen in het linkerdeelvenster.

- Selecteer + Nieuwe implementatie>maken van basismodellen om het implementatievenster te openen.

- Zoek en selecteer het

gpt-4o-mini-realtime-previewmodel en selecteer vervolgens Implementeren naar geselecteerde resource. - Selecteer in de implementatiewizard de

2024-12-17modelversie. - Volg de wizard om het model te implementeren.

Nu u een implementatie van het gpt-4o-mini-realtime-preview model hebt, kunt u er in realtime mee werken in de Realtime audiospeeltuin of realtime-API van de Azure AI Foundry-portal.

Instellingen

Maak een nieuwe map

realtime-audio-quickstartdie de toepassing bevat en open Visual Studio Code in die map met de volgende opdracht:mkdir realtime-audio-quickstart && code realtime-audio-quickstartMaak de

package.jsonopdracht met de volgende opdracht:npm init -yWerk de

package.jsonapp bij naar ECMAScript met de volgende opdracht:npm pkg set type=moduleInstalleer de realtime audioclientbibliotheek voor JavaScript met:

npm install https://github.com/Azure-Samples/aoai-realtime-audio-sdk/releases/download/js/v0.5.2/rt-client-0.5.2.tgzVoor de aanbevolen sleutelloze verificatie met Microsoft Entra ID installeert u het

@azure/identitypakket met:npm install @azure/identity

Resourcegegevens ophalen

U moet de volgende informatie ophalen om uw toepassing te verifiëren met uw Azure OpenAI-resource:

| Naam van de variabele | Weergegeven als |

|---|---|

AZURE_OPENAI_ENDPOINT |

Deze waarde vindt u in de sectie Sleutels en eindpunt bij het controleren van uw resource vanuit Azure Portal. |

AZURE_OPENAI_DEPLOYMENT_NAME |

Deze waarde komt overeen met de aangepaste naam die u hebt gekozen voor uw implementatie toen u een model hebt geïmplementeerd. Deze waarde vindt u onder Resource Management>Model Deployments in Azure Portal. |

OPENAI_API_VERSION |

Meer informatie over API-versies. |

Meer informatie over sleutelloze verificatie en het instellen van omgevingsvariabelen.

Let op

Als u de aanbevolen sleutelloze verificatie met de SDK wilt gebruiken, moet u ervoor zorgen dat de AZURE_OPENAI_API_KEY omgevingsvariabele niet is ingesteld.

Tekst in audio-out

Maak het

text-in-audio-out.tsbestand met de volgende code:import { DefaultAzureCredential } from "@azure/identity"; import { LowLevelRTClient } from "rt-client"; import dotenv from "dotenv"; dotenv.config(); async function text_in_audio_out() { // Set environment variables or edit the corresponding values here. const endpoint: string = process.env["AZURE_OPENAI_ENDPOINT"] || "yourEndpoint"; const deployment = "gpt-4o-mini-realtime-preview"; if (!endpoint || !deployment) { throw new Error("You didn't set the environment variables."); } const client = new LowLevelRTClient( new URL(endpoint), new DefaultAzureCredential(), {deployment: deployment} ); try { await client.send({ type: "response.create", response: { modalities: ["audio", "text"], instructions: "Please assist the user." } }); for await (const message of client.messages()) { switch (message.type) { case "response.done": { break; } case "error": { console.error(message.error); break; } case "response.audio_transcript.delta": { console.log(`Received text delta: ${message.delta}`); break; } case "response.audio.delta": { const buffer = Buffer.from(message.delta, "base64"); console.log(`Received ${buffer.length} bytes of audio data.`); break; } } if (message.type === "response.done" || message.type === "error") { break; } } } finally { client.close(); } } await text_in_audio_out();Maak het

tsconfig.jsonbestand om de TypeScript-code te transpileren en kopieer de volgende code voor ECMAScript.{ "compilerOptions": { "module": "NodeNext", "target": "ES2022", // Supports top-level await "moduleResolution": "NodeNext", "skipLibCheck": true, // Avoid type errors from node_modules "strict": true // Enable strict type-checking options }, "include": ["*.ts"] }Transpile van TypeScript naar JavaScript.

tscMeld u aan bij Azure met de volgende opdracht:

az loginVoer de code uit met de volgende opdracht:

node text-in-audio-out.js

Wacht even om het antwoord te krijgen.

Uitvoer

Het script ontvangt een antwoord van het model en drukt de ontvangen transcriptie- en audiogegevens af.

De uitvoer ziet er ongeveer als volgt uit:

Received text delta: Hello

Received text delta: !

Received text delta: How

Received text delta: can

Received text delta: I

Received 4800 bytes of audio data.

Received 7200 bytes of audio data.

Received text delta: help

Received 12000 bytes of audio data.

Received text delta: you

Received text delta: today

Received text delta: ?

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 24000 bytes of audio data.

Gerelateerde inhoud

- Meer informatie over het gebruik van de Realtime-API

- Zie de naslaginformatie over de Realtime-API

- Meer informatie over Azure OpenAI-quota en -limieten