Gearchiveerde releaseopmerkingen

Samenvatting

Azure HDInsight is een van de populairste services van zakelijke klanten voor opensource-analyses in Azure. Abonneer u op de releaseopmerkingen voor HDInsight voor actuele informatie in HDInsight en alle HDInsight-versies.

Als u zich wilt abonneren, klikt u op de knop 'watch' in de banner en kijkt u uit voor HDInsight-releases.

Release-informatie

Releasedatum: 22 oktober 2024

Notitie

Dit is een hotfix-/onderhoudsrelease voor resourceprovider. Zie resourceprovider voor meer informatie.

In Azure HDInsight worden regelmatig onderhoudsupdates uitgebracht voor het leveren van bugfixes, prestatieverbeteringen en beveiligingspatches om ervoor te zorgen dat u up-to-date blijft met deze updates voor optimale prestaties en betrouwbaarheid.

Deze releasenotitie is van toepassing op

HDInsight 5.1-versie.

HDInsight 5.0-versie.

HDInsight 4.0-versie.

HDInsight-release is gedurende meerdere dagen beschikbaar voor alle regio's. Deze releasenotitie is van toepassing op afbeeldingsnummer 2409240625. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Notitie

Ubuntu 18.04 wordt ondersteund onder Extended Security Maintenance (ESM) door het Azure Linux-team voor Azure HDInsight juli 2023, release en hoger.

Zie HDInsight 5.x-onderdeelversies voor specifieke versies van workloads.

Bijgewerkt

Ondersteuning voor MSI-verificatie die beschikbaar is voor Azure Blob Storage.

- Azure HDInsight ondersteunt nu verificatie op basis van OAuth voor toegang tot Azure Blob Storage door gebruik te maken van Azure Active Directory (AAD) en beheerde identiteiten (MSI). Met deze uitbreiding maakt HDInsight gebruik van door de gebruiker toegewezen beheerde identiteiten voor toegang tot Azure Blob Storage. Zie Beheerde identiteiten voor Azure-resources voor meer informatie.

De HDInsight-service is overgestapt op het gebruik van standard load balancers voor alle clusterconfiguraties vanwege afschaffingsaankondiging van Azure Basic Load Balancer.

Notitie

Deze wijziging is beschikbaar in alle regio's. Maak het cluster opnieuw om deze wijziging te gebruiken. Neem contact op met de ondersteuning voor hulp.

Belangrijk

Wanneer u uw eigen virtuele netwerk (aangepast VNet) gebruikt tijdens het maken van het cluster, moet u er rekening mee hebben dat het maken van het cluster niet lukt zodra deze wijziging is ingeschakeld. We raden u aan om naar de migratiehandleiding te verwijzen om het cluster opnieuw te maken. Neem contact op met de ondersteuning voor hulp.

Binnenkort beschikbaar

Binnenkort beschikbaar

Vm's uit de Basic- en Standard A-serie buiten gebruik gesteld.

- Op 31 augustus 2024 gaan we vm's uit de Basic- en Standard A-serie buiten gebruik stellen. Vóór die datum moet u uw workloads migreren naar AV2-serie-VM's, die meer geheugen per vCPU bieden en snellere opslag op SSD's (Solid-State Drives).

- Als u serviceonderbrekingen wilt voorkomen, migreert u uw workloads van vm's uit de Basic- en Standard A-serie naar av2-serie-VM's vóór 31 augustus 2024.

Buitengebruikstellingsmeldingen voor HDInsight 4.0 en HDInsight 5.0.

Neem contact op met de ondersteuning van Azure als u nog vragen hebt.

U kunt ons altijd vragen over HDInsight in Azure HDInsight - Microsoft Q&A.

We luisteren: u bent welkom om hier meer ideeën en andere onderwerpen toe te voegen en erop te stemmen: HDInsight Ideas en volg ons voor meer updates op de AzureHDInsight-community.

Notitie

We adviseren klanten om te gebruiken voor de nieuwste versies van HDInsight-installatiekopieën wanneer ze het beste van opensource-updates, Azure-updates en beveiligingsoplossingen bieden. Zie Best practices voor meer informatie.

Releasedatum: 30 augustus 2024

Notitie

Dit is een hotfix-/onderhoudsrelease voor resourceprovider. Zie resourceprovider voor meer informatie.

In Azure HDInsight worden regelmatig onderhoudsupdates uitgebracht voor het leveren van bugfixes, prestatieverbeteringen en beveiligingspatches om ervoor te zorgen dat u up-to-date blijft met deze updates voor optimale prestaties en betrouwbaarheid.

Deze releasenotitie is van toepassing op

HDInsight 5.1-versie.

HDInsight 5.0-versie.

HDInsight 4.0-versie.

HDInsight-release is gedurende meerdere dagen beschikbaar voor alle regio's. Deze releasenotitie is van toepassing op het afbeeldingsnummer 2407260448. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Notitie

Ubuntu 18.04 wordt ondersteund onder Extended Security Maintenance (ESM) door het Azure Linux-team voor Azure HDInsight juli 2023, release en hoger.

Zie HDInsight 5.x-onderdeelversies voor specifieke versies van workloads.

Probleem opgelost

- Standaard-DB-foutoplossing.

Binnenkort beschikbaar

-

Vm's uit de Basic- en Standard A-serie buiten gebruik gesteld.

- Op 31 augustus 2024 gaan we vm's uit de Basic- en Standard A-serie buiten gebruik stellen. Vóór die datum moet u uw workloads migreren naar AV2-serie-VM's, die meer geheugen per vCPU bieden en snellere opslag op SSD's (Solid-State Drives).

- Als u serviceonderbrekingen wilt voorkomen, migreert u uw workloads van vm's uit de Basic- en Standard A-serie naar av2-serie-VM's vóór 31 augustus 2024.

- Buitengebruikstellingsmeldingen voor HDInsight 4.0 en HDInsight 5.0.

Neem contact op met de ondersteuning van Azure als u nog vragen hebt.

U kunt ons altijd vragen over HDInsight in Azure HDInsight - Microsoft Q&A.

We luisteren: u bent welkom om hier meer ideeën en andere onderwerpen toe te voegen en erop te stemmen: HDInsight Ideas en volg ons voor meer updates op de AzureHDInsight-community.

Notitie

We adviseren klanten om te gebruiken voor de nieuwste versies van HDInsight-installatiekopieën wanneer ze het beste van opensource-updates, Azure-updates en beveiligingsoplossingen bieden. Zie Best practices voor meer informatie.

Releasedatum: 09 augustus 2024

Deze releasenotitie is van toepassing op

HDInsight 5.1-versie.

HDInsight 5.0-versie.

HDInsight 4.0-versie.

HDInsight-release is gedurende meerdere dagen beschikbaar voor alle regio's. Deze releasenotitie is van toepassing op het afbeeldingsnummer 2407260448. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Notitie

Ubuntu 18.04 wordt ondersteund onder Extended Security Maintenance (ESM) door het Azure Linux-team voor Azure HDInsight juli 2023, release en hoger.

Zie HDInsight 5.x-onderdeelversies voor specifieke versies van workloads.

Updates

Toevoeging van Azure Monitor Agent voor Log Analytics in HDInsight

Toevoeging van SystemMSI en geautomatiseerde DCR voor Log Analytics, gezien de afschaffing van de nieuwe Azure Monitor-ervaring (preview).

Notitie

Effectieve afbeeldingsnummer 2407260448, klanten die de portal voor Log Analytics gebruiken, hebben standaard azure Monitor Agent-ervaring . Als u wilt overschakelen naar de Azure Monitor-ervaring (preview), kunt u uw clusters vastmaken aan oude installatiekopieën door een ondersteuningsaanvraag te maken.

Releasedatum: 05 juli 2024

Notitie

Dit is een hotfix-/onderhoudsrelease voor resourceprovider. Zie resourceprovider voor meer informatie

Problemen opgelost

HOBO-tags overschrijven gebruikerstags.

- HOBO-tags overschrijven gebruikerstags voor subresources in het maken van HDInsight-clusters.

Releasedatum: 19 juni 2024

Deze releasenotitie is van toepassing op

HDInsight 5.1-versie.

HDInsight 5.0-versie.

HDInsight 4.0-versie.

HDInsight-release is gedurende meerdere dagen beschikbaar voor alle regio's. Deze releasenotitie is van toepassing op afbeeldingsnummer 2406180258. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Notitie

Ubuntu 18.04 wordt ondersteund onder Extended Security Maintenance (ESM) door het Azure Linux-team voor Azure HDInsight juli 2023, release en hoger.

Zie HDInsight 5.x-onderdeelversies voor specifieke versies van workloads.

Problemen opgelost

Beveiligingsverbeteringen

- Verbeteringen in het gebruik van tags voor clusters in overeenstemming met de SFI-vereisten .

- Verbeteringen in testscripts volgens de SFI-vereisten .

Verbeteringen in de HDInsight Log Analytics met system Managed Identity-ondersteuning voor HDInsight-resourceprovider.

Toevoeging van nieuwe activiteit om de agentversie voor de

mdsdoude installatiekopieën bij te werken (gemaakt vóór 2024).MISE inschakelen in de gateway als onderdeel van de voortdurende verbeteringen voor MSAL-migratie.

Spark Thrift Server

Httpheader hiveConfopnemen in de Jetty HTTP ConnectionFactory.RANGER-3753 en RANGER-3593 herstellen.

De

setOwnerUserimplementatie in de release van Ranger 2.3.0 heeft een kritiek regressieprobleem bij gebruik door Hive. Wanneer In Ranger 2.3.0, wanneer HiveServer2 probeert het beleid te evalueren, probeert Ranger Client de eigenaar van de hive-tabel op te halen door de Metastore aan te roepen in de setOwnerUser-functie die in wezen aanroept naar opslag om de toegang tot die tabel te controleren. Dit probleem zorgt ervoor dat de query's traag worden uitgevoerd wanneer Hive wordt uitgevoerd op 2.3.0 Ranger.

Nieuwe regio's toegevoegd

- Italië - noord

- Israël - centraal

- Centraal Spanje

- Mexico - centraal

- Jio India - centraal

Toevoegen aan archiefnotities van juni 2024

Binnenkort beschikbaar

-

Vm's uit de Basic- en Standard A-serie buiten gebruik gesteld.

- Op 31 augustus 2024 gaan we vm's uit de Basic- en Standard A-serie buiten gebruik stellen. Vóór die datum moet u uw workloads migreren naar AV2-serie-VM's, die meer geheugen per vCPU bieden en snellere opslag op SSD's (Solid-State Drives).

- Als u serviceonderbrekingen wilt voorkomen, migreert u uw workloads van vm's uit de Basic- en Standard A-serie naar av2-serie-VM's vóór 31 augustus 2024.

- Buitengebruikstellingsmeldingen voor HDInsight 4.0 en HDInsight 5.0.

Neem contact op met de ondersteuning van Azure als u nog vragen hebt.

U kunt ons altijd vragen over HDInsight in Azure HDInsight - Microsoft Q&A.

We luisteren: u bent welkom om hier meer ideeën en andere onderwerpen toe te voegen en erop te stemmen: HDInsight Ideas en volg ons voor meer updates op de AzureHDInsight-community.

Notitie

We adviseren klanten om te gebruiken voor de nieuwste versies van HDInsight-installatiekopieën wanneer ze het beste van opensource-updates, Azure-updates en beveiligingsoplossingen bieden. Zie Best practices voor meer informatie.

Releasedatum: 16 mei 2024

Deze releasenotitie is van toepassing op

HDInsight 5.0-versie.

HDInsight 4.0-versie.

HDInsight-release is gedurende meerdere dagen beschikbaar voor alle regio's. Deze releasenotitie is van toepassing op afbeeldingsnummer 2405081840. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Notitie

Ubuntu 18.04 wordt ondersteund onder Extended Security Maintenance (ESM) door het Azure Linux-team voor Azure HDInsight juli 2023, release en hoger.

Zie HDInsight 5.x-onderdeelversies voor specifieke versies van workloads.

Problemen opgelost

- API in gateway toegevoegd om token voor Keyvault op te halen, als onderdeel van het SFI-initiatief.

- In de nieuwe logboekmonitortabel

HDInsightSparkLogs, voor logboektypeSparkDriverLog, ontbreken enkele velden. Bijvoorbeeld:LogLevel & Message. Met deze release worden de ontbrekende velden toegevoegd aan schema's en vaste opmaak voorSparkDriverLog. - Livy-logboeken zijn niet beschikbaar in de bewakingstabel

SparkDriverLogvan Log Analytics, wat te wijten was aan een probleem met het livy-logboekbronpad en het parseren van regex inSparkLivyLogconfiguraties. - Elk HDInsight-cluster, waarbij ADLS Gen2 als primair opslagaccount wordt gebruikt, kan gebruikmaken van MSI-toegang tot alle Azure-resources (bijvoorbeeld SQL, Keyvaults) die in de toepassingscode wordt gebruikt.

Binnenkort beschikbaar

-

Vm's uit de Basic- en Standard A-serie buiten gebruik gesteld.

- Op 31 augustus 2024 gaan we vm's uit de Basic- en Standard A-serie buiten gebruik stellen. Vóór die datum moet u uw workloads migreren naar AV2-serie-VM's, die meer geheugen per vCPU bieden en snellere opslag op SSD's (Solid-State Drives).

- Als u serviceonderbrekingen wilt voorkomen, migreert u uw workloads van vm's uit de Basic- en Standard A-serie naar av2-serie-VM's vóór 31 augustus 2024.

- Buitengebruikstellingsmeldingen voor HDInsight 4.0 en HDInsight 5.0.

Neem contact op met de ondersteuning van Azure als u nog vragen hebt.

U kunt ons altijd vragen over HDInsight in Azure HDInsight - Microsoft Q&A.

We luisteren: u bent welkom om hier meer ideeën en andere onderwerpen toe te voegen en erop te stemmen: HDInsight Ideas en volg ons voor meer updates op de AzureHDInsight-community.

Notitie

We adviseren klanten om te gebruiken voor de nieuwste versies van HDInsight-installatiekopieën wanneer ze het beste van opensource-updates, Azure-updates en beveiligingsoplossingen bieden. Zie Best practices voor meer informatie.

Releasedatum: 15 april 2024

Deze releasenotitie is van toepassing op HDInsight 5.1-versie.

HDInsight-release is gedurende meerdere dagen beschikbaar voor alle regio's. Deze releasenotitie is van toepassing op afbeeldingsnummer 2403290825. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Notitie

Ubuntu 18.04 wordt ondersteund onder Extended Security Maintenance (ESM) door het Azure Linux-team voor Azure HDInsight juli 2023, release en hoger.

Zie HDInsight 5.x-onderdeelversies voor specifieke versies van workloads.

Problemen opgelost

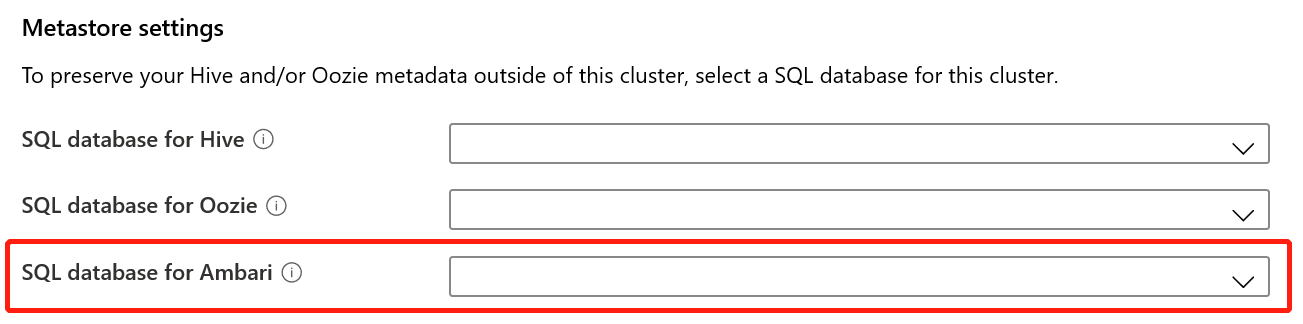

- Opgeloste fouten voor Ambari DB, Hive Warehouse Controller (HWC), Spark, HDFS

- Opgeloste fouten voor Log Analytics-module voor HDInsightSparkLogs

- CVE-oplossingen voor HDInsight-resourceprovider.

Binnenkort beschikbaar

-

Vm's uit de Basic- en Standard A-serie buiten gebruik gesteld.

- Op 31 augustus 2024 gaan we vm's uit de Basic- en Standard A-serie buiten gebruik stellen. Vóór die datum moet u uw workloads migreren naar AV2-serie-VM's, die meer geheugen per vCPU bieden en snellere opslag op SSD's (Solid-State Drives).

- Als u serviceonderbrekingen wilt voorkomen, migreert u uw workloads van vm's uit de Basic- en Standard A-serie naar av2-serie-VM's vóór 31 augustus 2024.

- Buitengebruikstellingsmeldingen voor HDInsight 4.0 en HDInsight 5.0.

Neem contact op met de ondersteuning van Azure als u nog vragen hebt.

U kunt ons altijd vragen over HDInsight in Azure HDInsight - Microsoft Q&A.

We luisteren: u bent welkom om hier meer ideeën en andere onderwerpen toe te voegen en erop te stemmen: HDInsight Ideas en volg ons voor meer updates op de AzureHDInsight-community.

Notitie

We adviseren klanten om te gebruiken voor de nieuwste versies van HDInsight-installatiekopieën wanneer ze het beste van opensource-updates, Azure-updates en beveiligingsoplossingen bieden. Zie Best practices voor meer informatie.

Releasedatum: 15 februari 2024

Deze release is van toepassing op HDInsight 4.x- en 5.x-versies. HDInsight-release is gedurende meerdere dagen beschikbaar voor alle regio's. Deze release is van toepassing op afbeeldingsnummer 2401250802. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Notitie

Ubuntu 18.04 wordt ondersteund onder Extended Security Maintenance (ESM) door het Azure Linux-team voor Azure HDInsight juli 2023, release en hoger.

Zie Voor workloadspecifieke versies

Nieuwe functies

- Apache Ranger-ondersteuning voor Spark SQL in Spark 3.3.0 (HDInsight versie 5.1) met enterprise-beveiligingspakket. Hier vindt u meer informatie.

Problemen opgelost

- Beveiligingsoplossingen van Ambari- en Oozie-onderdelen

Binnenkort beschikbaar

Binnenkort beschikbaar

- Vm's uit de Basic- en Standard A-serie buiten gebruik gesteld.

- Op 31 augustus 2024 gaan we vm's uit de Basic- en Standard A-serie buiten gebruik stellen. Vóór die datum moet u uw workloads migreren naar AV2-serie-VM's, die meer geheugen per vCPU bieden en snellere opslag op SSD's (Solid-State Drives).

- Als u serviceonderbrekingen wilt voorkomen, migreert u uw workloads van vm's uit de Basic- en Standard A-serie naar av2-serie-VM's vóór 31 augustus 2024.

Neem contact op met de ondersteuning van Azure als u nog vragen hebt.

U kunt ons altijd vragen over HDInsight in Azure HDInsight - Microsoft Q&A

We luisteren: u bent welkom om hier meer ideeën en andere onderwerpen toe te voegen en erop te stemmen - HDInsight Ideas en volg ons voor meer updates op de AzureHDInsight-community

Notitie

We adviseren klanten om te gebruiken voor de nieuwste versies van HDInsight-installatiekopieën wanneer ze het beste van opensource-updates, Azure-updates en beveiligingsoplossingen bieden. Zie Best practices voor meer informatie.

Volgende stappen

- Azure HDInsight: veelgestelde vragen

- Het patchschema voor het besturingssysteem configureren voor HDInsight-clusters op basis van Linux

- Vorige releasenotitie

Azure HDInsight is een van de populairste services van zakelijke klanten voor opensource-analyses in Azure. Als u zich wilt abonneren op releaseopmerkingen, bekijkt u releases in deze GitHub-opslagplaats.

Releasedatum: 10 januari 2024

Deze hotfixrelease is van toepassing op HDInsight 4.x- en 5.x-versies. HDInsight-release is gedurende meerdere dagen beschikbaar voor alle regio's. Deze release is van toepassing op afbeeldingsnummer 2401030422. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Notitie

Ubuntu 18.04 wordt ondersteund onder Extended Security Maintenance (ESM) door het Azure Linux-team voor Azure HDInsight juli 2023, release en hoger.

Zie Voor workloadspecifieke versies

Problemen opgelost

- Beveiligingsoplossingen van Ambari- en Oozie-onderdelen

Binnenkort beschikbaar

Binnenkort beschikbaar

- Vm's uit de Basic- en Standard A-serie buiten gebruik gesteld.

- Op 31 augustus 2024 gaan we vm's uit de Basic- en Standard A-serie buiten gebruik stellen. Vóór die datum moet u uw workloads migreren naar AV2-serie-VM's, die meer geheugen per vCPU bieden en snellere opslag op SSD's (Solid-State Drives).

- Als u serviceonderbrekingen wilt voorkomen, migreert u uw workloads van vm's uit de Basic- en Standard A-serie naar av2-serie-VM's vóór 31 augustus 2024.

Neem contact op met de ondersteuning van Azure als u nog vragen hebt.

U kunt ons altijd vragen over HDInsight in Azure HDInsight - Microsoft Q&A

We luisteren: u bent welkom om hier meer ideeën en andere onderwerpen toe te voegen en erop te stemmen - HDInsight Ideas en volg ons voor meer updates op de AzureHDInsight-community

Notitie

We adviseren klanten om te gebruiken voor de nieuwste versies van HDInsight-installatiekopieën wanneer ze het beste van opensource-updates, Azure-updates en beveiligingsoplossingen bieden. Zie Best practices voor meer informatie.

Releasedatum: 26 oktober 2023

Deze release is van toepassing op HDInsight 4.x en 5.x HDInsight-release is beschikbaar voor alle regio's gedurende meerdere dagen. Deze release is van toepassing op afbeeldingsnummer 2310140056. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Zie Voor workloadspecifieke versies

Nieuwe functies

HDInsight kondigt de algemene beschikbaarheid van HDInsight 5.1 aan vanaf 1 november 2023. Deze release brengt een volledige stackvernieuwing naar de opensource-onderdelen en de integraties van Microsoft.

- Nieuwste opensourceversies : HDInsight 5.1 wordt geleverd met de nieuwste stabiele opensource-versie . Klanten kunnen profiteren van alle nieuwste opensource-functies, prestatieverbeteringen van Microsoft en oplossingen voor fouten.

- Beveiligd: de nieuwste versies worden geleverd met de meest recente beveiligingsoplossingen, zowel opensource-beveiligingsoplossingen als beveiligingsverbeteringen van Microsoft.

- Lagere TCO: met prestatieverbeteringen kunnen klanten de operationele kosten verlagen, samen met verbeterde automatische schaalaanpassing.

Clustermachtigingen voor beveiligde opslag

- Klanten kunnen opgeven (tijdens het maken van clusters) of een beveiligd kanaal moet worden gebruikt voor HDInsight-clusterknooppunten om het opslagaccount te verbinden.

HDInsight-cluster maken met aangepaste VNets.

- Om de algehele beveiligingspostuur van de HDInsight-clusters te verbeteren, moeten HDInsight-clusters met behulp van aangepaste VNET's ervoor zorgen dat de gebruiker gemachtigd moet zijn om

Microsoft Network/virtualNetworks/subnets/join/actionbewerkingen te kunnen maken. De klant kan fouten ondervinden bij het maken als deze controle niet is ingeschakeld.

- Om de algehele beveiligingspostuur van de HDInsight-clusters te verbeteren, moeten HDInsight-clusters met behulp van aangepaste VNET's ervoor zorgen dat de gebruiker gemachtigd moet zijn om

Niet-ESP ABFS-clusters [Clustermachtigingen voor Word leesbaar]

- Niet-ESP ABFS-clusters beperken niet-Hadoop-groepsgebruikers van het uitvoeren van Hadoop-opdrachten voor opslagbewerkingen. Deze wijziging verbetert de beveiligingspostuur van het cluster.

Update van inlinequotum.

- Nu kunt u de quotumverhoging rechtstreeks aanvragen via de pagina Mijn quotum, met de directe API-aanroep is dit veel sneller. Als de API-aanroep mislukt, kunt u een nieuwe ondersteuningsaanvraag voor quotumverhoging maken.

Binnenkort beschikbaar

Binnenkort beschikbaar

De maximale lengte van de clusternaam wordt gewijzigd van 45 naar 59 tekens om de beveiligingspostuur van clusters te verbeteren. Deze wijziging wordt geïmplementeerd in alle regio's die beginnen met de aanstaande release.

Vm's uit de Basic- en Standard A-serie buiten gebruik gesteld.

- Op 31 augustus 2024 gaan we vm's uit de Basic- en Standard A-serie buiten gebruik stellen. Vóór die datum moet u uw workloads migreren naar AV2-serie-VM's, die meer geheugen per vCPU bieden en snellere opslag op SSD's (Solid-State Drives).

- Als u serviceonderbrekingen wilt voorkomen, migreert u uw workloads van vm's uit de Basic- en Standard A-serie naar av2-serie-VM's vóór 31 augustus 2024.

Neem contact op met de ondersteuning van Azure als u nog vragen hebt.

U kunt ons altijd vragen over HDInsight in Azure HDInsight - Microsoft Q&A

We luisteren: u bent welkom om hier meer ideeën en andere onderwerpen toe te voegen en erop te stemmen - HDInsight Ideas en volg ons voor meer updates op de AzureHDInsight-community

Notitie

Deze release heeft betrekking op de volgende CV's die op 12 september 2023 door MSRC zijn uitgebracht. De actie is om bij te werken naar de meest recente installatiekopieën 2308221128 of 2310140056. Klanten worden geadviseerd om dienovereenkomstig te plannen.

| CVE | Ernst | CVE-titel | Opmerking |

|---|---|---|---|

| CVE-2023-38156 | Belangrijk | Azure HDInsight Apache Ambari-uitbreiding van beveiligingsproblemen met bevoegdheden | Opgenomen in installatiekopie 2308221128 of 2310140056 |

| CVE-2023-36419 | Belangrijk | Azure HDInsight Apache Oozie Workflow Scheduler-uitbreiding van beveiligingsprobleem met bevoegdheden | Pas scriptactie toe op uw clusters of werk bij naar installatiekopie 2310140056 |

Notitie

We adviseren klanten om te gebruiken voor de nieuwste versies van HDInsight-installatiekopieën wanneer ze het beste van opensource-updates, Azure-updates en beveiligingsoplossingen bieden. Zie Best practices voor meer informatie.

Releasedatum: 7 september 2023

Deze release is van toepassing op HDInsight 4.x en 5.x HDInsight-release is beschikbaar voor alle regio's gedurende meerdere dagen. Deze release is van toepassing op afbeeldingsnummer 2308221128. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Zie Voor workloadspecifieke versies

Belangrijk

Deze release heeft betrekking op de volgende CV's die op 12 september 2023 door MSRC zijn uitgebracht. De actie is om bij te werken naar de meest recente installatiekopieën 2308221128. Klanten worden geadviseerd om dienovereenkomstig te plannen.

| CVE | Ernst | CVE-titel | Opmerking |

|---|---|---|---|

| CVE-2023-38156 | Belangrijk | Azure HDInsight Apache Ambari-uitbreiding van beveiligingsproblemen met bevoegdheden | Opgenomen in 2308221128 afbeelding |

| CVE-2023-36419 | Belangrijk | Azure HDInsight Apache Oozie Workflow Scheduler-uitbreiding van beveiligingsprobleem met bevoegdheden | Scriptactie toepassen op uw clusters |

Binnenkort beschikbaar

- De maximale lengte van de clusternaam wordt gewijzigd van 45 naar 59 tekens om de beveiligingspostuur van clusters te verbeteren. Deze wijziging wordt geïmplementeerd op 30 september 2023.

- Clustermachtigingen voor beveiligde opslag

- Klanten kunnen opgeven (tijdens het maken van clusters) of een beveiligd kanaal moet worden gebruikt voor HDInsight-clusterknooppunten om contact op te maken met het opslagaccount.

- Update van inlinequotum.

- Aanvraagquota verhogen rechtstreeks vanaf de pagina Mijn quotum. Dit is een directe API-aanroep. Dit is sneller. Als de APdI-aanroep mislukt, moeten klanten een nieuwe ondersteuningsaanvraag voor quotumverhoging maken.

- HDInsight-cluster maken met aangepaste VNets.

- Om de algehele beveiligingspostuur van de HDInsight-clusters te verbeteren, moeten HDInsight-clusters met behulp van aangepaste VNET's ervoor zorgen dat de gebruiker gemachtigd moet zijn om

Microsoft Network/virtualNetworks/subnets/join/actionbewerkingen te kunnen maken. Klanten moeten dienovereenkomstig plannen omdat deze wijziging een verplichte controle zou zijn om fouten bij het maken van clusters vóór 30 september 2023 te voorkomen.

- Om de algehele beveiligingspostuur van de HDInsight-clusters te verbeteren, moeten HDInsight-clusters met behulp van aangepaste VNET's ervoor zorgen dat de gebruiker gemachtigd moet zijn om

- Vm's uit de Basic- en Standard A-serie buiten gebruik gesteld.

- Op 31 augustus 2024 gaan we vm's uit de Basic- en Standard A-serie buiten gebruik stellen. Vóór die datum moet u uw workloads migreren naar AV2-serie-VM's, die meer geheugen per vCPU bieden en snellere opslag op SSD's (Solid-State Drives). Als u serviceonderbrekingen wilt voorkomen, migreert u uw workloads van vm's uit de Basic- en Standard A-serie naar av2-serie-VM's vóór 31 augustus 2024.

- Niet-ESP ABFS-clusters [Clustermachtigingen voor Word leesbaar]

- Plan om een wijziging in niet-ESP ABFS-clusters te introduceren, waardoor gebruikers die geen Hadoop-groep zijn, geen Hadoop-opdrachten kunnen uitvoeren voor opslagbewerkingen. Deze wijziging om het beveiligingspostuur van het cluster te verbeteren. Klanten moeten de updates plannen vóór 30 september 2023.

Neem contact op met de ondersteuning van Azure als u nog vragen hebt.

U kunt ons altijd vragen over HDInsight in Azure HDInsight - Microsoft Q&A

U bent van harte welkom om hier meer voorstellen en ideeën en andere onderwerpen toe te voegen en voor hen te stemmen - HDInsight Community (azure.com).

Notitie

We adviseren klanten om te gebruiken voor de nieuwste versies van HDInsight-installatiekopieën wanneer ze het beste van opensource-updates, Azure-updates en beveiligingsoplossingen bieden. Zie Best practices voor meer informatie.

Releasedatum: 25 juli 2023

Deze release is van toepassing op HDInsight 4.x en 5.x HDInsight-release is beschikbaar voor alle regio's gedurende meerdere dagen. Deze release is van toepassing op afbeeldingsnummer 2307201242. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Zie Voor workloadspecifieke versies

Wat is er nieuw

Wat is er nieuw

- HDInsight 5.1 wordt nu ondersteund met het ESP-cluster.

- Bijgewerkte versie van Ranger 2.3.0 en Oozie 5.2.1 maken nu deel uit van HDInsight 5.1

- Het Spark 3.3.1-cluster (HDInsight 5.1) wordt geleverd met Hive Warehouse Connector (HWC) 2.1, dat samen met het Interactive Query-cluster (HDInsight 5.1) werkt.

- Ubuntu 18.04 wordt ondersteund onder ESM (Uitgebreid beveiligingsonderhoud) door het Azure Linux-team voor Azure HDInsight juli 2023, release en hoger.

Belangrijk

Deze release heeft betrekking op de volgende CV's die op 8 augustus 2023 door MSRC zijn uitgebracht. De actie is om bij te werken naar de meest recente installatiekopieën 2307201242. Klanten worden geadviseerd om dienovereenkomstig te plannen.

| CVE | Ernst | CVE-titel |

|---|---|---|

| CVE-2023-35393 | Belangrijk | Beveiligingsprobleem met Azure Apache Hive-adresvervalsing |

| CVE-2023-35394 | Belangrijk | Beveiligingsprobleem met Spoofing van Azure HDInsight Jupyter Notebook |

| CVE-2023-36877 | Belangrijk | Beveiligingsprobleem met Azure Apache Oozie-adresvervalsing |

| CVE-2023-36881 | Belangrijk | Beveiligingsprobleem met Azure Apache Ambari-adresvervalsing |

| CVE-2023-38188 | Belangrijk | Beveiligingsprobleem met Azure Apache Hadoop-adresvervalsing |

Binnenkort beschikbaar

Binnenkort beschikbaar

- De maximale lengte van de clusternaam wordt gewijzigd van 45 naar 59 tekens om de beveiligingspostuur van clusters te verbeteren. Klanten moeten de updates plannen vóór 30 september 2023.

- Clustermachtigingen voor beveiligde opslag

- Klanten kunnen opgeven (tijdens het maken van clusters) of een beveiligd kanaal moet worden gebruikt voor HDInsight-clusterknooppunten om contact op te maken met het opslagaccount.

- Update van inlinequotum.

- Aanvraagquota verhogen rechtstreeks vanaf de pagina Mijn quotum. Dit is een directe API-aanroep. Dit is sneller. Als de API-aanroep mislukt, moeten klanten een nieuwe ondersteuningsaanvraag voor quotumverhoging maken.

- HDInsight-cluster maken met aangepaste VNets.

- Om de algehele beveiligingspostuur van de HDInsight-clusters te verbeteren, moeten HDInsight-clusters met behulp van aangepaste VNET's ervoor zorgen dat de gebruiker gemachtigd moet zijn om

Microsoft Network/virtualNetworks/subnets/join/actionbewerkingen te kunnen maken. Klanten moeten dienovereenkomstig plannen omdat deze wijziging een verplichte controle zou zijn om fouten bij het maken van clusters vóór 30 september 2023 te voorkomen.

- Om de algehele beveiligingspostuur van de HDInsight-clusters te verbeteren, moeten HDInsight-clusters met behulp van aangepaste VNET's ervoor zorgen dat de gebruiker gemachtigd moet zijn om

- Vm's uit de Basic- en Standard A-serie buiten gebruik gesteld.

- Op 31 augustus 2024 gaan we vm's uit de Basic- en Standard A-serie buiten gebruik stellen. Vóór die datum moet u uw workloads migreren naar AV2-serie-VM's, die meer geheugen per vCPU bieden en snellere opslag op SSD's (Solid-State Drives). Als u serviceonderbrekingen wilt voorkomen, migreert u uw workloads van vm's uit de Basic- en Standard A-serie naar av2-serie-VM's vóór 31 augustus 2024.

- Niet-ESP ABFS-clusters [Clustermachtigingen voor Word leesbaar]

- Plan om een wijziging in niet-ESP ABFS-clusters te introduceren, waardoor gebruikers die geen Hadoop-groep zijn, geen Hadoop-opdrachten kunnen uitvoeren voor opslagbewerkingen. Deze wijziging om het beveiligingspostuur van het cluster te verbeteren. Klanten moeten de updates plannen vóór 30 september 2023.

Neem contact op met de ondersteuning van Azure als u nog vragen hebt.

U kunt ons altijd vragen over HDInsight in Azure HDInsight - Microsoft Q&A

U kunt hier meer voorstellen en ideeën en andere onderwerpen toevoegen en voor hen stemmen - HDInsight Community (azure.com) en volg ons voor meer updates op X

Notitie

We adviseren klanten om te gebruiken voor de nieuwste versies van HDInsight-installatiekopieën wanneer ze het beste van opensource-updates, Azure-updates en beveiligingsoplossingen bieden. Zie Best practices voor meer informatie.

Releasedatum: 08 mei 2023

Deze release is van toepassing op HDInsight 4.x en 5.x HDInsight-release is beschikbaar voor alle regio's gedurende meerdere dagen. Deze release is van toepassing op afbeeldingsnummer 2304280205. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Zie Voor workloadspecifieke versies

![]()

Azure HDInsight 5.1 bijgewerkt met

- Apache HBase 2.4.11

- Apache Phoenix 5.1.2

- Apache Hive 3.1.2

- Apache Spark 3.3.1

- Apache Tez 0.9.1

- Apache Zeppelin 0.10.1

- Apache Livy 0.5

- Apache Kafka 3.2.0

Notitie

- Alle onderdelen zijn geïntegreerd met Hadoop 3.3.4 & ZK 3.6.3

- Alle bovenstaande bijgewerkte onderdelen zijn nu beschikbaar in niet-ESP-clusters voor openbare preview.

![]()

Verbeterde automatische schaalaanpassing voor HDInsight

Azure HDInsight heeft aanzienlijke verbeteringen aangebracht in stabiliteit en latentie op automatische schaalaanpassing. De essentiële wijzigingen omvatten verbeterde feedbacklus voor beslissingen over schaalaanpassing, aanzienlijke verbetering van de latentie voor schalen en ondersteuning voor het opnieuw toewijzen van de buiten gebruik gestelde knooppunten, meer informatie over de verbeteringen, het aanpassen en migreren van uw cluster naar verbeterde automatische schaalaanpassing. De verbeterde automatische schaalaanpassing is beschikbaar vanaf 17 mei 2023 in alle ondersteunde regio's.

Azure HDInsight ESP voor Apache Kafka 2.4.1 is nu algemeen beschikbaar.

Azure HDInsight ESP voor Apache Kafka 2.4.1 is sinds april 2022 in openbare preview. Nadat belangrijke verbeteringen in CVE-oplossingen en -stabiliteit zijn aangebracht, wordt Azure HDInsight ESP Kafka 2.4.1 nu algemeen beschikbaar en klaar voor productieworkloads. Lees hier meer informatie over het configureren en migreren van workloads.

Quotumbeheer voor HDInsight

HDInsight wijst momenteel quota toe aan klantabonnementen op regionaal niveau. De kernen die aan klanten zijn toegewezen, zijn algemeen en niet geclassificeerd op vm-familieniveau (bijvoorbeeld

Dv2Ev3,Eav4, enzovoort).HDInsight heeft een verbeterde weergave geïntroduceerd, die een gedetailleerde en classificatie van quota biedt voor VM's op familieniveau. Met deze functie kunnen klanten de huidige en resterende quota voor een regio op het niveau van de VM-familie bekijken. Met de verbeterde weergave hebben klanten uitgebreidere zichtbaarheid, voor het plannen van quota en een betere gebruikerservaring. Deze functie is momenteel beschikbaar in HDInsight 4.x en 5.x voor de regio VS - oost EUAP. Andere regio's die u later kunt volgen.

Zie Clustercapaciteitsplanning in Azure HDInsight | Microsoft Learn

![]()

- Polen - centraal

- De maximale lengte van de clusternaam wordt gewijzigd in 45 van 59 tekens om de beveiligingspostuur van clusters te verbeteren.

- Clustermachtigingen voor beveiligde opslag

- Klanten kunnen opgeven (tijdens het maken van clusters) of een beveiligd kanaal moet worden gebruikt voor HDInsight-clusterknooppunten om contact op te maken met het opslagaccount.

- Update van inlinequotum.

- Aanvraagquota verhogen rechtstreeks vanaf de pagina Mijn quotum. Dit is een directe API-aanroep. Dit is sneller. Als de API-aanroep mislukt, moeten klanten een nieuwe ondersteuningsaanvraag voor quotumverhoging maken.

- HDInsight-cluster maken met aangepaste VNets.

- Om de algehele beveiligingspostuur van de HDInsight-clusters te verbeteren, moeten HDInsight-clusters met behulp van aangepaste VNET's ervoor zorgen dat de gebruiker gemachtigd moet zijn om

Microsoft Network/virtualNetworks/subnets/join/actionbewerkingen te kunnen maken. Klanten moeten dienovereenkomstig plannen, omdat dit een verplichte controle zou zijn om fouten bij het maken van clusters te voorkomen.

- Om de algehele beveiligingspostuur van de HDInsight-clusters te verbeteren, moeten HDInsight-clusters met behulp van aangepaste VNET's ervoor zorgen dat de gebruiker gemachtigd moet zijn om

- Vm's uit de Basic- en Standard A-serie buiten gebruik gesteld.

- Op 31 augustus 2024 gaan we vm's uit de Basic- en Standard A-serie buiten gebruik stellen. Vóór die datum moet u uw workloads migreren naar AV2-serie-VM's, die meer geheugen per vCPU bieden en snellere opslag op SSD's (Solid-State Drives). Om serviceonderbrekingen te voorkomen, migreert u uw workloads vóór 31 augustus 2024 van vm's uit de Basic- en Standard A-serie naar av2-serie-VM's.

- Niet-ESP ABFS-clusters [Clustermachtigingen voor wereld leesbaar]

- Plan om een wijziging in niet-ESP ABFS-clusters te introduceren, waardoor gebruikers die geen Hadoop-groep zijn, geen Hadoop-opdrachten kunnen uitvoeren voor opslagbewerkingen. Deze wijziging om het beveiligingspostuur van het cluster te verbeteren. Klanten moeten plannen voor de updates.

Releasedatum: 28 februari 2023

Deze release is van toepassing op HDInsight 4.0. en 5.0, 5.1. HDInsight-release is beschikbaar voor alle regio's gedurende meerdere dagen. Deze release is van toepassing op afbeeldingsnummer 2302250400. Het installatiekopienummer controleren

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Zie Voor workloadspecifieke versies

Belangrijk

Microsoft heeft CVE-2023-23408 uitgegeven, wat is opgelost in de huidige release en klanten wordt aangeraden hun clusters te upgraden naar de nieuwste installatiekopie.

![]()

HDInsight 5.1

We zijn begonnen met het implementeren van een nieuwe versie van HDInsight 5.1. Alle nieuwe opensource-releases zijn toegevoegd als incrementele releases in HDInsight 5.1.

Zie HDInsight 5.1.0-versie voor meer informatie

![]()

Kafka 3.2.0-upgrade (preview)

- Kafka 3.2.0 bevat verschillende belangrijke nieuwe functies/verbeteringen.

- Zookeeper bijgewerkt naar 3.6.3

- Ondersteuning voor Kafka Streams

- Sterkere leveringsgaranties voor de Kafka-producent die standaard is ingeschakeld.

-

log4j1.x vervangen doorreload4j. - Stuur een hint naar de partitieleider om de partitie te herstellen.

-

JoinGroupRequestenLeaveGroupRequesthebben een reden bijgevoegd. - Broker count metrics8 toegevoegd.

- Mirror-verbeteringen

Maker2.

HBase 2.4.11 Upgrade (preview)

- Deze versie heeft nieuwe functies, zoals het toevoegen van nieuwe cachemechanismetypen voor blokcache, de mogelijkheid om de

hbase:metatabel te wijzigenhbase:meta tableen weer te geven vanuit de HBase WEB UI.

Phoenix 5.1.2 Upgrade (preview)

- Phoenix-versie is bijgewerkt naar 5.1.2 in deze release. Deze upgrade omvat de Phoenix Query Server. De Phoenix Query Server proxyt het standaard Phoenix JDBC-stuurprogramma en biedt een achterwaarts compatibel wire-protocol om dat JDBC-stuurprogramma aan te roepen.

Ambari-CV's

- Er zijn meerdere Ambari-CV's opgelost.

Notitie

ESP wordt niet ondersteund voor Kafka en HBase in deze release.

![]()

De volgende stap

- Automatisch schalen

- Automatisch schalen met verbeterde latentie en verschillende verbeteringen

- Beperking van wijziging van clusternaam

- De maximale lengte van de clusternaam wordt gewijzigd in 45 van 59 in Public, Azure China en Azure Government.

- Clustermachtigingen voor beveiligde opslag

- Klanten kunnen opgeven (tijdens het maken van clusters) of een beveiligd kanaal moet worden gebruikt voor HDInsight-clusterknooppunten om contact op te maken met het opslagaccount.

- Niet-ESP ABFS-clusters [Clustermachtigingen voor wereld leesbaar]

- Plan om een wijziging in niet-ESP ABFS-clusters te introduceren, waardoor gebruikers die geen Hadoop-groep zijn, geen Hadoop-opdrachten kunnen uitvoeren voor opslagbewerkingen. Deze wijziging om het beveiligingspostuur van het cluster te verbeteren. Klanten moeten plannen voor de updates.

- Opensource-upgrades

- Apache Spark 3.3.0 en Hadoop 3.3.4 zijn in ontwikkeling in HDInsight 5.1 en bevatten verschillende belangrijke nieuwe functies, prestaties en andere verbeteringen.

Notitie

We adviseren klanten om te gebruiken voor de nieuwste versies van HDInsight-installatiekopieën wanneer ze het beste van opensource-updates, Azure-updates en beveiligingsoplossingen bieden. Zie Best practices voor meer informatie.

Releasedatum: 12 december 2022

Deze release is van toepassing op HDInsight 4.0. en 5.0 HDInsight-release wordt gedurende meerdere dagen beschikbaar gesteld voor alle regio's.

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

Besturingssysteemversies

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

![]()

- Log Analytics : klanten kunnen klassieke bewaking inschakelen om de nieuwste OMS-versie 14.19 te verkrijgen. Als u oude versies wilt verwijderen, schakelt u klassieke bewaking uit en schakelt u deze in.

- Automatisch afmelden voor ambari-gebruikersinterface vanwege inactiviteit. Zie voor meer informatie hier

- Spark : een nieuwe en geoptimaliseerde versie van Spark 3.1.3 is opgenomen in deze release. We hebben Apache Spark 3.1.2 (vorige versie) en Apache Spark 3.1.3 (huidige versie) getest met behulp van de TPC-DS-benchmark. De test is uitgevoerd met behulp van de E8 V3-SKU voor Apache Spark op een workload van 1 TB. Apache Spark 3.1.3 (huidige versie) presteerde beter dan Apache Spark 3.1.2 (vorige versie) met meer dan 40% in de totale queryruntime voor TPC-DS-query's met dezelfde hardwarespecificaties. Het Microsoft Spark-team heeft optimalisaties toegevoegd die beschikbaar zijn in Azure Synapse met Azure HDInsight. Raadpleeg voor meer informatie uw gegevensworkloads versnellen met prestatie-updates voor Apache Spark 3.1.2 in Azure Synapse

![]()

- Qatar - centraal

- Duitsland - noord

![]()

HDInsight is verwijderd van Azul Zulu Java JDK 8 naar

Adoptium Temurin JDK 8, dat ondersteuning biedt voor hoogwaardige TCK-gecertificeerde runtimes en bijbehorende technologie voor gebruik in het Java-ecosysteem.HDInsight is gemigreerd naar

reload4j. Delog4jwijzigingen zijn van toepassing op- Apache Hadoop

- Apache Zookeeper

- Apache Oozie

- Apache Ranger

- Apache Sqoop

- Apache Pig

- Apache Ambari

- Apache Kafka

- Apache Spark

- Apache Zeppelin

- Apache Livy

- Apache Rubix

- Apache Hive

- Apache Tez

- Apache HBase

- OMI

- Apache Pheonix

![]()

HDInsight voor het implementeren van TLS1.2 in de toekomst en eerdere versies worden bijgewerkt op het platform. Als u toepassingen boven op HDInsight uitvoert en ze TLS 1.0 en 1.1 gebruiken, voert u een upgrade uit naar TLS 1.2 om onderbrekingen in services te voorkomen.

Zie Transport Layer Security (TLS) inschakelen voor meer informatie

![]()

Einde van de ondersteuning voor Azure HDInsight-clusters op Ubuntu 16.04 LTS vanaf 30 november 2022. HDInsight begint met het vrijgeven van clusterinstallatiekopieën met Ubuntu 18.04 vanaf 27 juni 2021. We raden onze klanten aan om clusters uit te voeren met Ubuntu 16.04 door hun clusters met de nieuwste HDInsight-installatiekopieën op 30 november 2022 opnieuw te bouwen.

Zie hier voor meer informatie over het controleren van de Ubuntu-versie van het cluster

Voer de opdracht 'lsb_release -a' uit in de terminal.

Als de waarde voor de eigenschap Beschrijving in de uitvoer 'Ubuntu 16.04 LTS' is, is deze update van toepassing op het cluster.

![]()

- Ondersteuning voor Beschikbaarheidszones selectie voor Kafka- en HBase-clusters (schrijftoegang).

Oplossingen voor opensource-fouten

Oplossingen voor Hive-fouten

| Bugfixes | Apache JIRA |

|---|---|

| HIVE-26127 | INSERT OVERWRITE-fout - Bestand niet gevonden |

| HIVE-24957 | Verkeerde resultaten wanneer subquery COALESCE heeft in correlatiepredicaat |

| HIVE-24999 | HiveSubQueryRemoveRule genereert een ongeldig plan voor IN-subquery met meerdere correlaties |

| HIVE-24322 | Als er direct invoegen is, moet de pogings-id worden gecontroleerd bij het lezen van het manifest mislukt |

| HIVE-23363 | DataNucleus-afhankelijkheid upgraden naar 5.2 |

| HIVE-26412 | Interface maken om beschikbare sites op te halen en de standaardwaarde toe te voegen |

| HIVE-26173 | Upgrade derby naar 10.14.2.0 |

| HIVE-25920 | Hobbel Xerce2 naar 2.12.2. |

| HIVE-26300 | Upgrade Jackson-gegevensbindingsversie naar 2.12.6.1+ om CVE-2020-36518 te voorkomen |

Releasedatum: 10-08-2022

Deze release is van toepassing op HDInsight 4.0. HdInsight-release wordt gedurende meerdere dagen beschikbaar gesteld voor alle regio's.

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

![]()

Nieuwe functie

1. Externe schijven koppelen in HDI Hadoop-/Spark-clusters

HDInsight-cluster wordt geleverd met vooraf gedefinieerde schijfruimte op basis van SKU. Deze ruimte is mogelijk niet voldoende in scenario's voor grote taken.

Met deze nieuwe functie kunt u meer schijven toevoegen in het cluster, die worden gebruikt als lokale map van knooppuntbeheer. Voeg het aantal schijven toe aan werkknooppunten tijdens het maken van hive- en Spark-clusters, terwijl de geselecteerde schijven deel uitmaken van de lokale mappen van knooppuntbeheer.

Notitie

De toegevoegde schijven zijn alleen geconfigureerd voor lokale mappen van knooppuntbeheer.

Zie voor meer informatie hier

2. Selectieve logboekregistratieanalyse

Selectieve logboekregistratieanalyse is nu beschikbaar voor alle regio's voor openbare preview. U kunt uw cluster verbinden met een Log Analytics-werkruimte. Zodra deze functie is ingeschakeld, kunt u de logboeken en metrische gegevens zien, zoals HDInsight-beveiligingslogboeken, Yarn Resource Manager, metrische systeemgegevens, enzovoort. U kunt workloads bewaken en zien hoe deze van invloed zijn op clusterstabiliteit. Met selectief logboekregistratie kunt u alle tabellen in- of uitschakelen of selectief tabellen inschakelen in log analytics-werkruimte. U kunt het brontype voor elke tabel aanpassen, omdat in een nieuwe versie van Genève één tabel meerdere bronnen heeft.

- Het bewakingssysteem van Genève maakt gebruik van mdsd(MDS-daemon), een bewakingsagent en vloeiend voor het verzamelen van logboeken met behulp van geïntegreerde logboekregistratielaag.

- Selectief logboekregistratie maakt gebruik van scriptacties om tabellen en hun logboektypen uit te schakelen/in te schakelen. Omdat er geen nieuwe poorten worden geopend of een bestaande beveiligingsinstelling wordt gewijzigd, zijn er geen beveiligingswijzigingen.

- Scriptactie wordt parallel uitgevoerd op alle opgegeven knooppunten en wijzigt de configuratiebestanden voor het uitschakelen/inschakelen van tabellen en de bijbehorende logboektypen.

Zie voor meer informatie hier

![]()

Vast

Logboekanalyses

Log Analytics die is geïntegreerd met Azure HDInsight met OMS versie 13, vereist een upgrade naar OMS versie 14 om de meest recente beveiligingsupdates toe te passen. Klanten die een oudere versie van het cluster gebruiken met OMS versie 13, moeten OMS versie 14 installeren om te voldoen aan de beveiligingsvereisten. (Huidige versie controleren en 14 installeren)

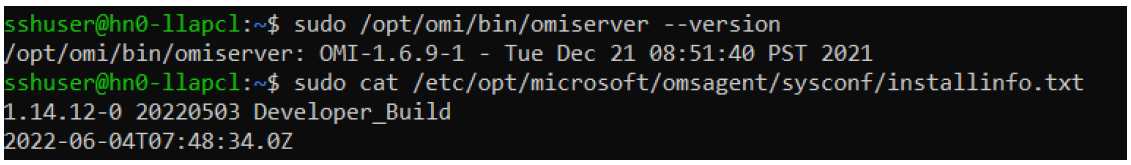

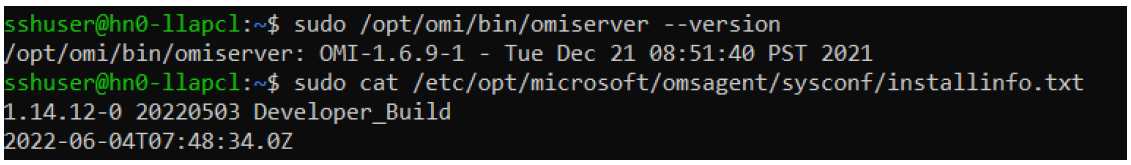

Uw huidige OMS-versie controleren

- Meld u aan bij het cluster met behulp van SSH.

- Voer de volgende opdracht uit in uw SSH-client.

sudo /opt/omi/bin/ominiserver/ --version

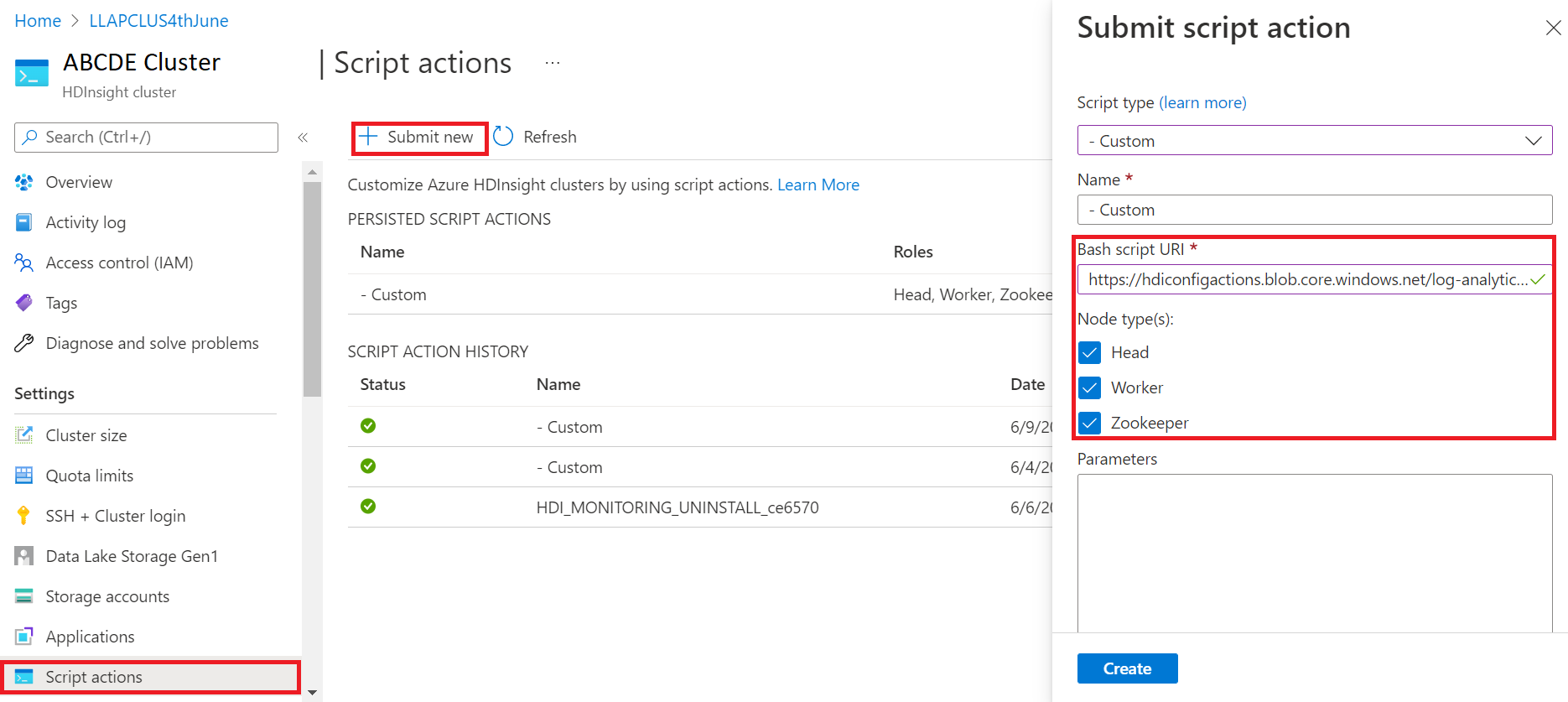

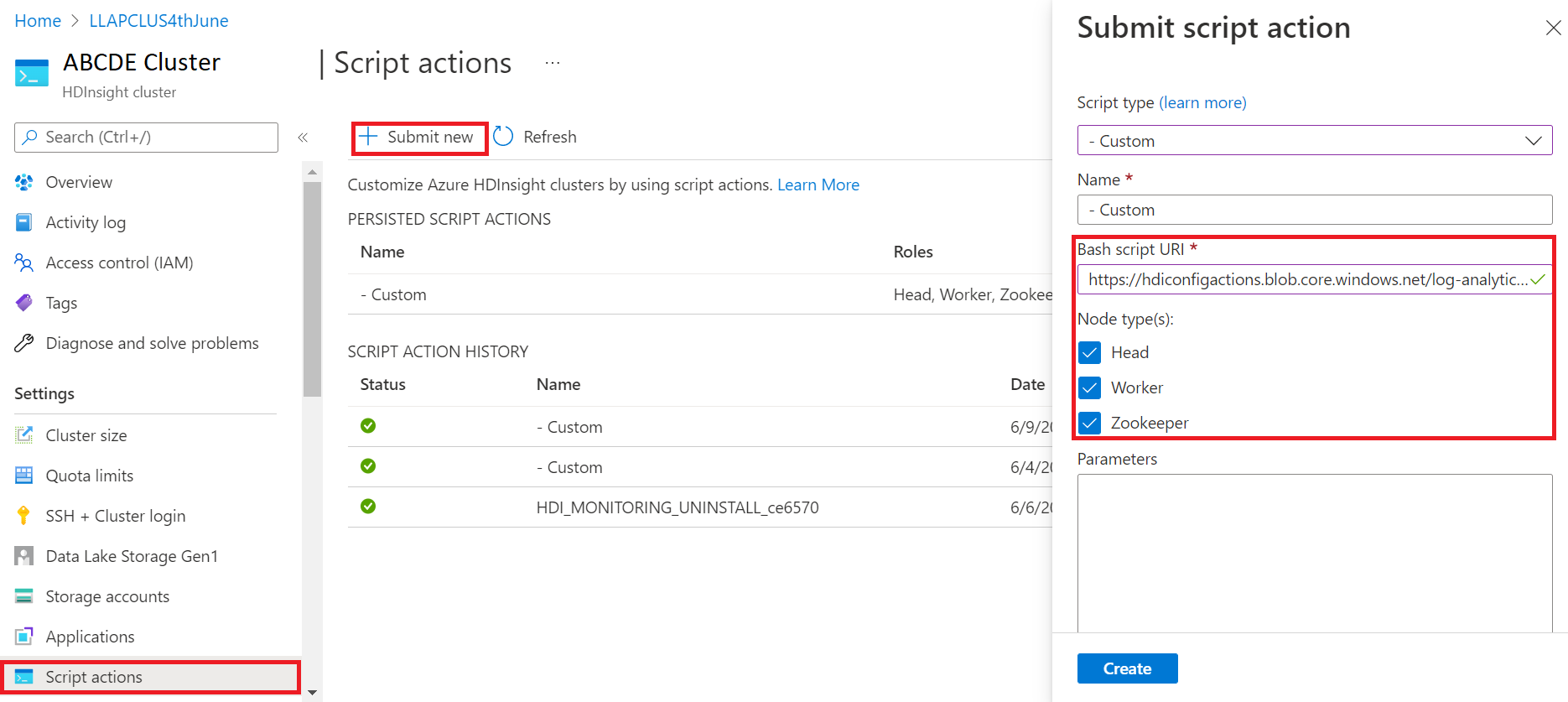

Uw OMS-versie upgraden van 13 naar 14

- Meld u aan bij het Azure Portal

- Selecteer in de resourcegroep de HDInsight-clusterresource

- Scriptacties selecteren

- Kies in het deelvenster Scriptactie verzenden het scripttype als aangepast

- Plak de volgende koppeling in het vak URL van het Bash-script https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Knooppunttype(en) selecteren

- Selecteer Maken.

Controleer de geslaagde installatie van de patch met behulp van de volgende stappen:

Meld u aan bij het cluster met behulp van SSH.

Voer de volgende opdracht uit in uw SSH-client.

sudo /opt/omi/bin/ominiserver/ --version

Andere oplossingen voor fouten

- De CLI van het Yarn-logboek kan de logboeken niet ophalen als deze

TFilebeschadigd of leeg zijn. - Er is een fout met ongeldige details van de service-principal opgelost tijdens het ophalen van het OAuth-token uit Azure Active Directory.

- Verbeterde betrouwbaarheid van het maken van clusters wanneer 100+ gewerkte knooppunten zijn geconfigureerd.

Oplossingen voor opensource-fouten

OPLOSSINGEN voor TEZ-fouten

| Bugfixes | Apache JIRA |

|---|---|

| Tez-buildfout: FileSaver.js niet gevonden | TEZ-4411 |

Verkeerde FS-uitzondering wanneer magazijn en scratchdir zich op verschillende FS bevinden |

TEZ-4406 |

| TezUtils.createConfFromByteString on Configuration groter dan 32 MB genereert com.google.protobuf.CodedInputStream-uitzondering | TEZ-4142 |

| TezUtils::createByteStringFromConf moet snappy gebruiken in plaats van DeflaterOutputStream | TEZ-4113 |

| Protobuf-afhankelijkheid bijwerken naar 3.x | TEZ-4363 |

Oplossingen voor Hive-fouten

| Bugfixes | Apache JIRA |

|---|---|

| Optimalisaties perf in ORC-splitsingsgeneratie | HIVE-21457 |

| Leestabel niet als ACID wanneer de tabelnaam begint met 'delta', maar tabel niet transactioneel is en BI Split Strategy wordt gebruikt | HIVE-22582 |

| Een FS#-aanroep verwijderen uit AcidUtils#getLogicalLength | HIVE-23533 |

| Vectorized OrcAcidRowBatchReader.computeOffset en bucketoptimalisatie | HIVE-17917 |

Bekende problemen

HDInsight is compatibel met Apache HIVE 3.1.2. Vanwege een fout in deze release wordt de Hive-versie weergegeven als 3.1.0 in Hive-interfaces. Er is echter geen invloed op de functionaliteit.

Releasedatum: 10-08-2022

Deze release is van toepassing op HDInsight 4.0. HdInsight-release wordt gedurende meerdere dagen beschikbaar gesteld voor alle regio's.

HDInsight maakt gebruik van veilige implementatieprocedures, waarbij geleidelijke implementatie van regio's is betrokken. Het kan maximaal 10 werkdagen duren voordat een nieuwe release of een nieuwe versie beschikbaar is in alle regio's.

![]()

Nieuwe functie

1. Externe schijven koppelen in HDI Hadoop-/Spark-clusters

HDInsight-cluster wordt geleverd met vooraf gedefinieerde schijfruimte op basis van SKU. Deze ruimte is mogelijk niet voldoende in scenario's voor grote taken.

Met deze nieuwe functie kunt u meer schijven toevoegen in het cluster, die worden gebruikt als lokale map van knooppuntbeheer. Voeg het aantal schijven toe aan werkknooppunten tijdens het maken van hive- en Spark-clusters, terwijl de geselecteerde schijven deel uitmaken van de lokale mappen van knooppuntbeheer.

Notitie

De toegevoegde schijven zijn alleen geconfigureerd voor lokale mappen van knooppuntbeheer.

Zie voor meer informatie hier

2. Selectieve logboekregistratieanalyse

Selectieve logboekregistratieanalyse is nu beschikbaar voor alle regio's voor openbare preview. U kunt uw cluster verbinden met een Log Analytics-werkruimte. Zodra deze functie is ingeschakeld, kunt u de logboeken en metrische gegevens zien, zoals HDInsight-beveiligingslogboeken, Yarn Resource Manager, metrische systeemgegevens, enzovoort. U kunt workloads bewaken en zien hoe deze van invloed zijn op clusterstabiliteit. Met selectief logboekregistratie kunt u alle tabellen in- of uitschakelen of selectief tabellen inschakelen in log analytics-werkruimte. U kunt het brontype voor elke tabel aanpassen, omdat in een nieuwe versie van Genève één tabel meerdere bronnen heeft.

- Het bewakingssysteem van Genève maakt gebruik van mdsd(MDS-daemon), een bewakingsagent en vloeiend voor het verzamelen van logboeken met behulp van geïntegreerde logboekregistratielaag.

- Selectief logboekregistratie maakt gebruik van scriptacties om tabellen en hun logboektypen uit te schakelen/in te schakelen. Omdat er geen nieuwe poorten worden geopend of een bestaande beveiligingsinstelling wordt gewijzigd, zijn er geen beveiligingswijzigingen.

- Scriptactie wordt parallel uitgevoerd op alle opgegeven knooppunten en wijzigt de configuratiebestanden voor het uitschakelen/inschakelen van tabellen en de bijbehorende logboektypen.

Zie voor meer informatie hier

![]()

Vast

Logboekanalyses

Log Analytics die is geïntegreerd met Azure HDInsight met OMS versie 13, vereist een upgrade naar OMS versie 14 om de meest recente beveiligingsupdates toe te passen. Klanten die een oudere versie van het cluster gebruiken met OMS versie 13, moeten OMS versie 14 installeren om te voldoen aan de beveiligingsvereisten. (Huidige versie controleren en 14 installeren)

Uw huidige OMS-versie controleren

- Meld u aan bij het cluster met behulp van SSH.

- Voer de volgende opdracht uit in uw SSH-client.

sudo /opt/omi/bin/ominiserver/ --version

Uw OMS-versie upgraden van 13 naar 14

- Meld u aan bij het Azure Portal

- Selecteer in de resourcegroep de HDInsight-clusterresource

- Scriptacties selecteren

- Kies in het deelvenster Scriptactie verzenden het scripttype als aangepast

- Plak de volgende koppeling in het vak URL van het Bash-script https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Knooppunttype(en) selecteren

- Selecteer Maken.

Controleer de geslaagde installatie van de patch met behulp van de volgende stappen:

Meld u aan bij het cluster met behulp van SSH.

Voer de volgende opdracht uit in uw SSH-client.

sudo /opt/omi/bin/ominiserver/ --version

Andere oplossingen voor fouten

- De CLI van het Yarn-logboek kan de logboeken niet ophalen als deze

TFilebeschadigd of leeg zijn. - Er is een fout met ongeldige details van de service-principal opgelost tijdens het ophalen van het OAuth-token uit Azure Active Directory.

- Verbeterde betrouwbaarheid van het maken van clusters wanneer 100+ gewerkte knooppunten zijn geconfigureerd.

Oplossingen voor opensource-fouten

OPLOSSINGEN voor TEZ-fouten

| Bugfixes | Apache JIRA |

|---|---|

| Tez-buildfout: FileSaver.js niet gevonden | TEZ-4411 |

Verkeerde FS-uitzondering wanneer magazijn en scratchdir zich op verschillende FS bevinden |

TEZ-4406 |

| TezUtils.createConfFromByteString on Configuration groter dan 32 MB genereert com.google.protobuf.CodedInputStream-uitzondering | TEZ-4142 |

| TezUtils::createByteStringFromConf moet snappy gebruiken in plaats van DeflaterOutputStream | TEZ-4113 |

| Protobuf-afhankelijkheid bijwerken naar 3.x | TEZ-4363 |

Oplossingen voor Hive-fouten

| Bugfixes | Apache JIRA |

|---|---|

| Optimalisaties perf in ORC-splitsingsgeneratie | HIVE-21457 |

| Leestabel niet als ACID wanneer de tabelnaam begint met 'delta', maar tabel niet transactioneel is en BI Split Strategy wordt gebruikt | HIVE-22582 |

| Een FS#-aanroep verwijderen uit AcidUtils#getLogicalLength | HIVE-23533 |

| Vectorized OrcAcidRowBatchReader.computeOffset en bucketoptimalisatie | HIVE-17917 |

Bekende problemen

HDInsight is compatibel met Apache HIVE 3.1.2. Vanwege een fout in deze release wordt de Hive-versie weergegeven als 3.1.0 in Hive-interfaces. Er is echter geen invloed op de functionaliteit.

Releasedatum: 06-03-2022

Deze release is van toepassing op HDInsight 4.0. HdInsight-release wordt gedurende meerdere dagen beschikbaar gesteld voor alle regio's. De releasedatum hier geeft de eerste releasedatum van de regio aan. Als u de volgende wijzigingen niet ziet, wacht u tot de release gedurende enkele dagen in uw regio live is.

Release-hoogtepunten

De Hive Warehouse Connector (HWC) op Spark v3.1.2

Met de Hive Warehouse Connector (HWC) kunt u profiteren van de unieke functies van Hive en Spark om krachtige big data-toepassingen te bouwen. HWC wordt momenteel alleen ondersteund voor Spark v2.4. Met deze functie wordt bedrijfswaarde toegevoegd door ACID-transacties in Hive-tabellen toe te staan met behulp van Spark. Deze functie is handig voor klanten die zowel Hive als Spark gebruiken in hun gegevensomgeving. Zie Apache Spark & Hive - Hive Warehouse Connector - Azure HDInsight | Microsoft Docs

Ambari

- Wijzigingen in het schalen en inrichten van wijzigingen

- HDI hive is nu compatibel met OSS versie 3.1.2

HDI Hive 3.1-versie wordt bijgewerkt naar OSS Hive 3.1.2. Deze versie bevat alle fixes en functies die beschikbaar zijn in open source Hive 3.1.2-versie.

Notitie

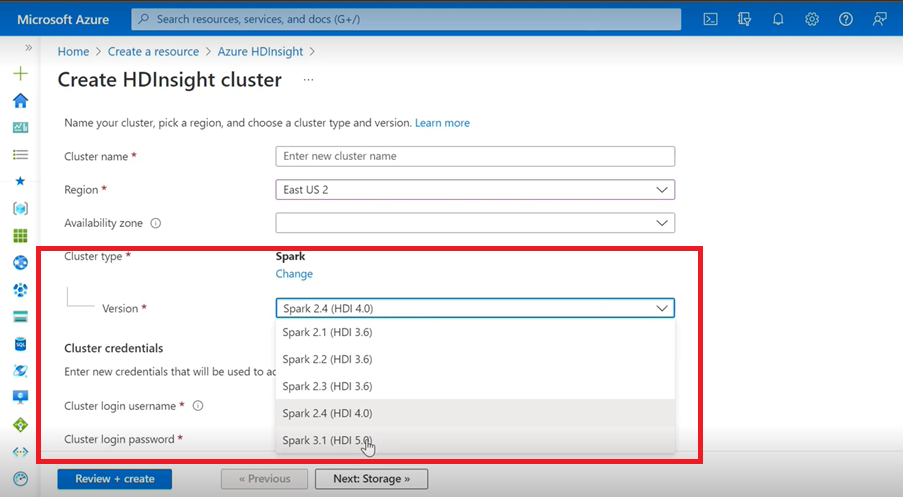

Spark

- Als u Azure User Interface gebruikt om een Spark-cluster voor HDInsight te maken, ziet u in de vervolgkeuzelijst een andere versie van Spark 3.1. (HDI 5.0) samen met de oudere versies. Deze versie is een hernoemde versie van Spark 3.1. (HDI 4.0). Dit is alleen een wijziging op gebruikersinterfaceniveau. Dit heeft geen invloed op de bestaande gebruikers en gebruikers die al gebruikmaken van de ARM-sjabloon.

Notitie

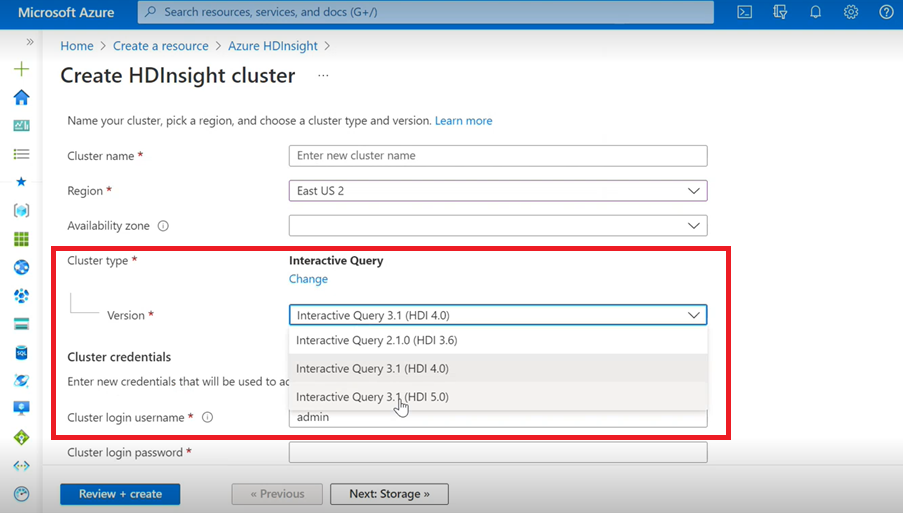

Interactieve query

- Als u een Interactive Query-cluster maakt, ziet u in de vervolgkeuzelijst een andere versie als Interactive Query 3.1 (HDI 5.0).

- Als u de Spark 3.1-versie samen met Hive gebruikt waarvoor ACID-ondersteuning is vereist, moet u deze versie Interactive Query 3.1 (HDI 5.0) selecteren.

OPLOSSINGEN voor TEZ-fouten

| Bugfixes | Apache JIRA |

|---|---|

| TezUtils.createConfFromByteString on Configuration groter dan 32 MB genereert com.google.protobuf.CodedInputStream-uitzondering | TEZ-4142 |

| TezUtils createByteStringFromConf moet snappy gebruiken in plaats van DeflaterOutputStream | TEZ-4113 |

Oplossingen voor HBase-fouten

| Bugfixes | Apache JIRA |

|---|---|

TableSnapshotInputFormat moet ReadType.STREAM gebruiken om te scannen HFiles |

HBASE-26273 |

| Optie toevoegen om scanMetrics uit te schakelen in TableSnapshotInputFormat | HBASE-26330 |

| Oplossing voor ArrayIndexOutOfBoundsException wanneer balancer wordt uitgevoerd | HBASE-22739 |

Oplossingen voor Hive-fouten

| Bugfixes | Apache JIRA |

|---|---|

| NPE bij het invoegen van gegevens met de component 'distribute by' met dynpart sort optimization | HIVE-18284 |

| MSCK REPAIR-opdracht met partitiefiltering mislukt tijdens het verwijderen van partities | HIVE-23851 |

| Er is een verkeerde uitzondering opgetreden als capaciteit<=0 | HIVE-25446 |

| Ondersteuning voor parallelle belasting voor HastTables - Interfaces | HIVE-25583 |

| MultiDelimitSerDe opnemen in HiveServer2 standaard | HIVE-20619 |

| Verwijder glassfish.jersey en mssql-jdbc-klassen uit jdbc-standalone jar | HIVE-22134 |

| Null-aanwijzer-uitzondering bij het uitvoeren van compressie op basis van een MM-tabel. | HIVE-21280 |

Hive-query met grote grootte mislukt knox met verbroken pijp schrijven is mislukt |

HIVE-22231 |

| Mogelijkheid toevoegen voor gebruiker om bindingsgebruiker in te stellen | HIVE-21009 |

| UDF implementeren om datum/tijdstempel te interpreteren met behulp van de interne weergave en de hybride kalender Gregoriaanse-Juliaanse | HIVE-22241 |

| Beeline-optie om het uitvoeringsrapport weer te geven/niet weer te geven | HIVE-22204 |

| Tez: SplitGenerator probeert te zoeken naar planbestanden, die niet bestaan voor Tez | HIVE-22169 |

Dure logboekregistratie verwijderen uit de LLAP-cache hotpath |

HIVE-22168 |

| UDF: FunctionRegistry synchroniseert op org.apache.hadoop.hive.ql.udf.UDFType-klasse | HIVE-22161 |

| Voorkomen dat de toevoegfunctie voor queryroutering wordt gemaakt als de eigenschap is ingesteld op false | HIVE-22115 |

| Kruisquerysynchronisatie verwijderen voor de partitie-eval | HIVE-22106 |

| Het instellen van hive scratch dir overslaan tijdens de planning | HIVE-21182 |

| Sla het maken van scratch-dirs voor tez over als RPC is ingeschakeld | HIVE-21171 |

Hive UDF's overschakelen om regex-engine te gebruiken Re2J |

HIVE-19661 |

| Gemigreerde geclusterde tabellen met bucketing_version 1 op hive 3 gebruikt bucketing_version 2 voor invoegingen | HIVE-22429 |

| Bucketing: Bucketing versie 1 is onjuist partitioneren van gegevens | HIVE-21167 |

| ASF-licentieheader toevoegen aan het zojuist toegevoegde bestand | HIVE-22498 |

| Verbeteringen van het schemahulpprogramma ter ondersteuning van mergeCatalog | HIVE-22498 |

| Hive met TEZ UNION ALL en UDTF resulteert in gegevensverlies | HIVE-21915 |

| Tekstbestanden splitsen, zelfs als koptekst/voettekst bestaat | HIVE-21924 |

| MultiDelimitSerDe retourneert verkeerde resultaten in de laatste kolom wanneer het geladen bestand meer kolommen heeft dan het bestand aanwezig is in het tabelschema | HIVE-22360 |

| Externe LLAP-client - LlapBaseInputFormat#getSplits() footprint verminderen | HIVE-22221 |

| Kolomnaam met gereserveerd trefwoord is ongezichtig wanneer query's toevoegen aan tabel met maskerkolom opnieuw worden geschreven (Zoltan Matyus via Zoltan Haindrich) | HIVE-22208 |

Afsluiten van LLAP op AMReporter gerelateerde RuntimeException voorkomen |

HIVE-22113 |

| LlAP-statusservicestuurprogramma kan vastlopen met de verkeerde Yarn-app-id | HIVE-21866 |

| OperationManager.queryIdOperation schoont meerdere queryIds niet goed op | HIVE-22275 |

| Het omlaag brengen van een knooppuntbeheerder blokkeert het opnieuw opstarten van de LLAP-service | HIVE-22219 |

| Stack OverflowError bij het neerzetten van veel partities | HIVE-15956 |

| Toegangscontrole is mislukt wanneer een tijdelijke map wordt verwijderd | HIVE-22273 |

| Onjuiste resultaten/MatrixOutOfBound-uitzondering in left outer map joins in specifieke grensvoorwaarden oplossen | HIVE-22120 |

| Distributiebeheertag verwijderen uit pom.xml | HIVE-19667 |

| Parseringstijd kan hoog zijn als er diep geneste subquery's zijn | HIVE-21980 |

Voor ALTER TABLE t SET TBLPROPERTIES ('EXTERNAL'='TRUE'); TBL_TYPE kenmerkwijzigingen worden niet weerspiegeld voor niet-CAPS |

HIVE-20057 |

JDBC: HiveConnection-interfaces log4j |

HIVE-18874 |

URL's voor opslagplaatsen bijwerken in poms vertakking 3.1-versie |

HIVE-21786 |

DBInstall tests die zijn verbroken op master en branch-3.1 |

HIVE-21758 |

| Gegevens laden in een bucketed tabel negeert partitiespecificaties en laadt gegevens in standaardpartitie | HIVE-21564 |

| Query's met joinvoorwaarde met tijdstempel of tijdstempel met letterlijke SemanticException in de lokale tijdzone | HIVE-21613 |

| Rekenstatistieken analyseren voor kolom laat faserings-dir achter in HDFS | HIVE-21342 |

| Incompatibele wijziging in hive-bucketberekening | HIVE-21376 |

| Geef een terugval autor op wanneer er geen andere autor wordt gebruikt | HIVE-20420 |

| Sommige alterPartitions-aanroepen gooien NumberFormatException: null | HIVE-18767 |

| HiveServer2: Vooraf geverifieerd onderwerp voor http-transport wordt in sommige gevallen niet bewaard gedurende de gehele duur van http-communicatie | HIVE-20555 |

Releasedatum: 10-03-2022

Deze release is van toepassing op HDInsight 4.0. HdInsight-release wordt gedurende meerdere dagen beschikbaar gesteld voor alle regio's. De releasedatum hier geeft de eerste releasedatum van de regio aan. Als u de volgende wijzigingen niet ziet, wacht u tot de release gedurende enkele dagen in uw regio live is.

De versies van het besturingssysteem voor deze release zijn:

- HDInsight 4.0: Ubuntu 18.04.5

Spark 3.1 is nu algemeen beschikbaar

Spark 3.1 is nu algemeen beschikbaar in HDInsight 4.0. Deze release bevat

- Uitvoering van adaptieve query's,

- Samenvoegen sorteren converteren naar Broadcast Hash Join,

- Spark Catalyst Optimizer,

- Dynamische partitie snoeien,

- Klanten kunnen nieuwe Spark 3.1-clusters maken en geen Spark 3.0-clusters (preview).

Zie de Apache Spark 3.1 nu algemeen beschikbaar in HDInsight - Microsoft Tech Community voor meer informatie.

Zie de releaseopmerkingen voor Apache Spark 3.1 voor een volledige lijst met verbeteringen.

Zie de migratiehandleiding voor meer informatie over migratie.

Kafka 2.4 is nu algemeen beschikbaar

Kafka 2.4.1 is nu algemeen beschikbaar. Zie de releaseopmerkingen van Kafka 2.4.1 voor meer informatie . Andere functies zijn de beschikbaarheid van MirrorMaker 2, de nieuwe metrische categorie AtMinIsr-onderwerppartitie, verbeterde opstarttijd van broker door lui op aanvraag mmap van indexbestanden, Meer metrische gegevens van consumenten om het gedrag van gebruikerspeilingen te observeren.

Toewijzingsgegevenstype in HWC wordt nu ondersteund in HDInsight 4.0

Deze release bevat Ondersteuning voor Map Datatype voor HWC 1.0 (Spark 2.4) via de spark-shell-toepassing en alle andere spark-clients die HWC ondersteunt. De volgende verbeteringen zijn opgenomen, net als andere gegevenstypen:

Een gebruiker kan

- Maak een Hive-tabel met een of meer kolommen met toewijzingsgegevenstype, voeg er gegevens in en lees de resultaten ervan.

- Maak een Apache Spark-gegevensframe met toewijzingstype en voer batch-/stream-lees- en schrijfbewerkingen uit.

Nieuwe regio’s

HDInsight heeft nu zijn geografische aanwezigheid uitgebreid naar twee nieuwe regio's: China - oost 3 en China - noord 3.

OSS-backportwijzigingen

OSS-backports die zijn opgenomen in Hive, waaronder HWC 1.0 (Spark 2.4) die ondersteuning biedt voor het gegevenstype Kaart.

Dit zijn de OSS-backported Apache JIRAs voor deze release:

| Beïnvloede functie | Apache JIRA |

|---|---|

| Metastore directe SQL-query's met IN/(NOT IN) moeten worden gesplitst op basis van de maximale parameters die zijn toegestaan door SQL DB | HIVE-25659 |

Upgrade log4j van 2.16.0 naar 2.17.0 |

HIVE-25825 |

Updateversie Flatbuffer |

HIVE-22827 |

| Systeemeigen ondersteuning voor kaartgegevenstype in pijlindeling | HIVE-25553 |

| EXTERNE LLAP-client: geneste waarden verwerken wanneer de bovenliggende struct null is | HIVE-25243 |

| Upgradepijlversie naar 0.11.0 | HIVE-23987 |

Kennisgevingen over afschaffing

Virtuele-machineschaalsets van Azure in HDInsight

HDInsight maakt geen gebruik meer van Virtuele-machineschaalsets van Azure om de clusters in te richten. Er wordt geen belangrijke wijziging verwacht. Bestaande HDInsight-clusters op virtuele-machineschaalsets hebben geen invloed, nieuwe clusters op de nieuwste installatiekopieën gebruiken geen virtuele-machineschaalsets meer.

Schalen van Azure HDInsight HBase-workloads wordt nu alleen ondersteund met handmatig schalen

Vanaf 01 maart 2022 biedt HDInsight alleen ondersteuning voor handmatige schaalaanpassing voor HBase. Dit heeft geen invloed op het uitvoeren van clusters. Nieuwe HBase-clusters kunnen geen automatische schaalaanpassing op basis van planning inschakelen. Raadpleeg onze documentatie over het handmatig schalen van Azure HDInsight-clusters voor meer informatie over het handmatig schalen van uw HBase-cluster

Releasedatum: 27-12-2021

Deze release is van toepassing op HDInsight 4.0. HdInsight-release wordt gedurende meerdere dagen beschikbaar gesteld voor alle regio's. De releasedatum hier geeft de eerste releasedatum van de regio aan. Als u de volgende wijzigingen niet ziet, wacht u tot de release gedurende enkele dagen in uw regio live is.

De versies van het besturingssysteem voor deze release zijn:

- HDInsight 4.0: Ubuntu 18.04.5 LTS

HdInsight 4.0-installatiekopie is bijgewerkt om het beveiligingsprobleem te beperken Log4j , zoals beschreven in het antwoord van Microsoft op CVE-2021-44228 Apache Log4j 2.

Notitie

- HDI 4.0-clusters die na 27 december 2021 00:00 UTC zijn gemaakt, worden gemaakt met een bijgewerkte versie van de installatiekopie, waardoor de

log4jbeveiligingsproblemen worden beperkt. Daarom hoeven klanten deze clusters niet te patchen/opnieuw op te starten. - Voor nieuwe HDInsight 4.0-clusters die zijn gemaakt tussen 16 december 2021 om 01:15 UTC en 27 december 2021 00:00 UTC, HDInsight 3.6 of in vastgemaakte abonnementen na 16 december 2021 wordt de patch automatisch toegepast binnen het uur waarin het cluster wordt gemaakt, maar klanten moeten hun knooppunten opnieuw opstarten om de patch te voltooien (met uitzondering van Kafka-beheerknooppunten, die automatisch opnieuw worden opgestart).

Releasedatum: 27-07-2021

Deze release is van toepassing op zowel HDInsight 3.6 als HDInsight 4.0. HdInsight-release wordt gedurende meerdere dagen beschikbaar gesteld voor alle regio's. De releasedatum hier geeft de eerste releasedatum van de regio aan. Als u de volgende wijzigingen niet ziet, wacht u tot de release binnen enkele dagen live is in uw regio.

De versies van het besturingssysteem voor deze release zijn:

- HDInsight 3.6: Ubuntu 16.04.7 LTS

- HDInsight 4.0: Ubuntu 18.04.5 LTS

Nieuwe functies

Azure HDInsight-ondersteuning voor beperkte openbare connectiviteit is algemeen beschikbaar op 15 oktober 2021

Azure HDInsight ondersteunt nu beperkte openbare connectiviteit in alle regio's. Hieronder ziet u enkele van de belangrijkste hoogtepunten van deze mogelijkheid:

- Mogelijkheid om resourceprovider om te keren naar clustercommunicatie, zodat deze uitgaand is van het cluster naar de resourceprovider

- Ondersteuning voor het alleen gebruiken van uw eigen private link-resources (bijvoorbeeld opslag, SQL, sleutelkluis) voor HDInsight-cluster voor toegang tot de resources via een particulier netwerk

- Er zijn geen openbare IP-adressen ingericht

Met deze nieuwe mogelijkheid kunt u ook de regels voor binnenkomende netwerkbeveiligingsgroepen (NSG)-servicetags voor HDInsight-beheer-IP's overslaan. Meer informatie over het beperken van openbare connectiviteit

Ondersteuning voor Azure HDInsight voor Azure Private Link is algemeen beschikbaar op 15 oktober 2021

U kunt nu privé-eindpunten gebruiken om via private link verbinding te maken met uw HDInsight-clusters. Private Link kan worden gebruikt in scenario's voor meerdere VNET's waarbij VNET-peering niet beschikbaar of ingeschakeld is.

Met Azure Private Link hebt u via een privé-eindpunt in uw virtuele netwerk toegang tot Azure PaaS-services (bijvoorbeeld Azure Storage en SQL Database) en in Azure gehoste services van klanten of partners.

Verkeer tussen uw virtuele netwerk en de service wordt via het Microsoft-backbonenetwerk verplaatst. U hoeft uw service niet langer bloot te stellen aan het openbare internet.

Laten we meer doen bij het inschakelen van een privékoppeling.

Nieuwe Integratie-ervaring van Azure Monitor (preview)

De nieuwe integratie-ervaring van Azure Monitor is preview in VS - oost en Europa - west met deze release. Meer informatie over de nieuwe Azure Monitor-ervaring vindt u hier.

Afschaffing

HDInsight 3.6-versie is afgeschaft vanaf 01 oktober 2022.

Gedragswijzigingen

HDInsight Interactive Query biedt alleen ondersteuning voor automatisch schalen op basis van schema's

Naarmate klantscenario's volwassener en diverser worden, hebben we enkele beperkingen geïdentificeerd met op load gebaseerde automatische schaalaanpassing op basis van Interactive Query (LLAP). Deze beperkingen worden veroorzaakt door de aard van LLAP-querydynamiek, toekomstige problemen met de nauwkeurigheid van de belastingvoorspelling en problemen in de herdistributie van de taak van de LLAP-planner. Vanwege deze beperkingen kunnen gebruikers zien dat hun query's langzamer worden uitgevoerd op LLAP-clusters wanneer automatische schaalaanpassing is ingeschakeld. Het effect op prestaties kan opwegen tegen de kostenvoordelen van automatische schaalaanpassing.

Vanaf juli 2021 biedt de workload Interactive Query in HDInsight alleen ondersteuning voor automatisch schalen op basis van een planning. U kunt automatisch schalen op basis van belasting niet meer inschakelen op nieuwe Interactive Query-clusters. Bestaande actieve clusters kunnen blijven worden uitgevoerd met de bekende beperkingen die hierboven worden beschreven.

Microsoft raadt u aan over te stappen op een op planning gebaseerde automatische schaalaanpassing voor LLAP. U kunt het huidige gebruikspatroon van uw cluster analyseren via het Grafana Hive-dashboard. Zie Azure HDInsight-clusters automatisch schalen voor meer informatie.

Toekomstige wijzigingen

De volgende wijzigingen vinden plaats in toekomstige releases.

Het ingebouwde LLAP-onderdeel in het ESP Spark-cluster wordt verwijderd