Overfør Spark-jobbdefinisjon fra Azure Synapse til Fabric

Hvis du vil flytte Spark-jobbdefinisjoner (SJD) fra Azure Synapse til Fabric, har du to forskjellige alternativer:

- Alternativ 1: Opprett Spark-jobbdefinisjon manuelt i Fabric.

- Alternativ 2: Du kan bruke et skript til å eksportere Spark-jobbdefinisjoner fra Azure Synapse og importere dem i Fabric ved hjelp av API-en.

Se forskjeller mellom Azure Synapse Spark og Fabric for vurderinger av Spark-jobbdefinisjoner.

Forutsetning

Hvis du ikke allerede har en, oppretter du et Fabric-arbeidsområde i leieren.

Alternativ 1: Opprett Spark-jobbdefinisjon manuelt

Slik eksporterer du en Spark-jobbdefinisjon fra Azure Synapse:

- Åpne Synapse Studio: Logg på Azure. Gå til Azure Synapse-arbeidsområdet og åpne Synapse Studio.

- Finn Python/Scala/R Spark-jobben: Finn og identifiser jobbdefinisjonen for Python/Scala/R Spark som du vil overføre.

-

Eksporter konfigurasjonen for jobbdefinisjon:

- Åpne Spark Job Definition i Synapse Studio.

- Eksporter eller noter ned konfigurasjonsinnstillingene, inkludert skriptfilplassering, avhengigheter, parametere og andre relevante detaljer.

Slik oppretter du en ny Spark-jobbdefinisjon (SJD) basert på den eksporterte SJD-informasjonen i Fabric:

- Access Fabric-arbeidsområdet: Logg deg på Fabric og få tilgang til arbeidsområdet.

-

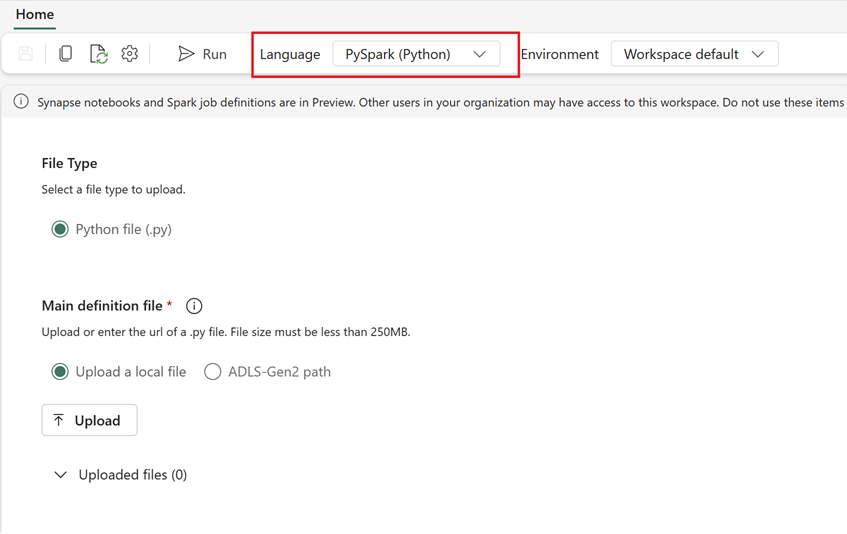

Opprett en ny Spark-jobbdefinisjon i Fabric:

- I Fabric går du til hjemmesiden Dataingeniør ing.

- Velg Spark Job Definition.

- Konfigurer jobben ved hjelp av informasjonen du eksporterte fra Synapse, inkludert skriptplassering, avhengigheter, parametere og klyngeinnstillinger.

- Tilpass og test: Gjør alle nødvendige tilpasninger til skriptet eller konfigurasjonen for å passe til Stoff-miljøet. Test jobben i Fabric for å sikre at den kjører riktig.

Når Spark-jobbdefinisjonen er opprettet, validerer du avhengigheter:

- Kontroller at du bruker samme Spark-versjon.

- Valider eksistensen av hoveddefinisjonsfilen.

- Valider eksistensen av de refererte filene, avhengighetene og ressursene.

- Koblede tjenester, datakildetilkoblinger og monteringspunkter.

Mer informasjon om hvordan du oppretter en Apache Spark-jobbdefinisjon i Fabric.

Alternativ 2: Bruk stoff-API-en

Følg disse viktige trinnene for overføring:

- Forutsetninger.

- Trinn 1: Eksporter Spark-jobbdefinisjon fra Azure Synapse til OneLake (.json).

- Trinn 2: Importer Spark-jobbdefinisjonen automatisk til Fabric ved hjelp av Fabric-API-en.

Forutsetning

Forutsetningene omfatter handlinger du må vurdere før du starter Overføring av Spark-jobbdefinisjon til Fabric.

- Et stoffarbeidsområde.

- Hvis du ikke har en allerede, kan du opprette et Fabric Lakehouse i arbeidsområdet.

Trinn 1: Eksporter Spark-jobbdefinisjon fra Azure Synapse-arbeidsområdet

Fokuset for trinn 1 er å eksportere Spark-jobbdefinisjon fra Azure Synapse-arbeidsområdet til OneLake i json-format. Denne prosessen er som følger:

- 1.1) Importer SJD-overføringsnotatblokk til Fabric-arbeidsområdet . Denne notatblokken eksporterer alle Spark-jobbdefinisjoner fra et gitt Azure Synapse-arbeidsområde til en mellomliggende katalog i OneLake. Synapse-API brukes til å eksportere SJD.

- 1.2) Konfigurer parameterne i den første kommandoen for å eksportere Spark-jobbdefinisjon til en mellomliggende lagringsplass (OneLake). Dette eksporterer bare json-metadatafilen. Følgende kodesnutt brukes til å konfigurere kilde- og målparameterne. Sørg for å erstatte dem med dine egne verdier.

# Azure config

azure_client_id = "<client_id>"

azure_tenant_id = "<tenant_id>"

azure_client_secret = "<client_secret>"

# Azure Synapse workspace config

synapse_workspace_name = "<synapse_workspace_name>"

# Fabric config

workspace_id = "<workspace_id>"

lakehouse_id = "<lakehouse_id>"

export_folder_name = f"export/{synapse_workspace_name}"

prefix = "" # this prefix is used during import {prefix}{sjd_name}

output_folder = f"abfss://{workspace_id}@onelake.dfs.fabric.microsoft.com/{lakehouse_id}/Files/{export_folder_name}"

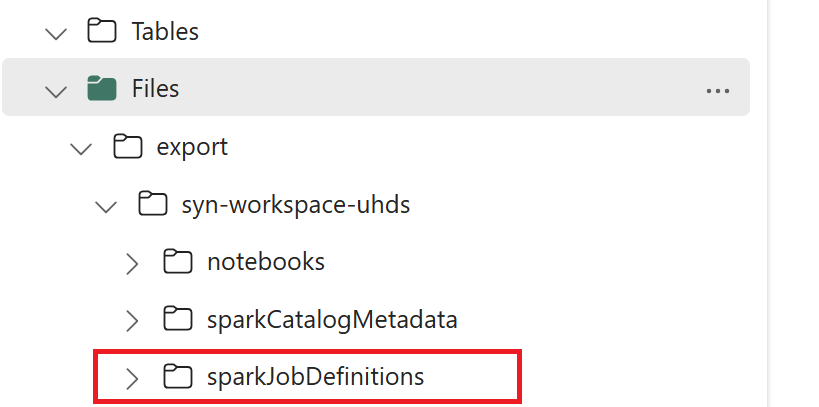

- 1.3) Kjør de to første cellene i eksport-/importnotatblokken for å eksportere metadata for Spark-jobbdefinisjon til OneLake. Når cellene er fullført, opprettes denne mappestrukturen under den mellomliggende utdatakatalogen.

Trinn 2: Importer Spark-jobbdefinisjon til Fabric

Trinn 2 er når Spark-jobbdefinisjoner importeres fra mellomliggende lagringsplass til Fabric-arbeidsområdet. Denne prosessen er som følger:

- 2.1) Valider konfigurasjonene i 1.2 for å sikre at det riktige arbeidsområdet og prefikset er angitt for å importere Spark-jobbdefinisjonene.

- 2.2) Kjør den tredje cellen i eksport-/importnotatblokken for å importere alle Spark-jobbdefinisjoner fra mellomliggende plassering.

Merk

Eksportalternativet sender ut en json-metadatafil. Kontroller at kjørbare filer, referansefiler og argumenter for Spark-jobbdefinisjon er tilgjengelige fra Fabric.