Alternativer for å hente data inn i Fabric Lakehouse

Hent dataopplevelsen dekker alle brukerscenarioer for å hente data inn i lakehouse, for eksempel:

- Koble til eksisterende SQL Server og kopiere data til Delta-tabellen på lakehouse.

- Laster opp filer fra datamaskinen.

- Kopiere og slå sammen flere tabeller fra andre innsjøer til et nytt Delta-bord.

- Koble til en strømmingskilde for å lande data i et lakehouse.

- Refererer til data uten å kopiere dem fra andre interne innsjøer eller eksterne kilder.

Ulike måter å laste inn data på i et lakehouse

I Microsoft Fabric finnes det noen måter du kan hente data inn i et lakehouse på:

- Filopplasting fra lokal datamaskin

- Kjøre et kopieringsverktøy i datasamlebånd

- Konfigurere en dataflyt

- Apache Spark-biblioteker i notatblokkkode

- Stream sanntidshendelser med Eventstream

- Hent data fra Eventhouse

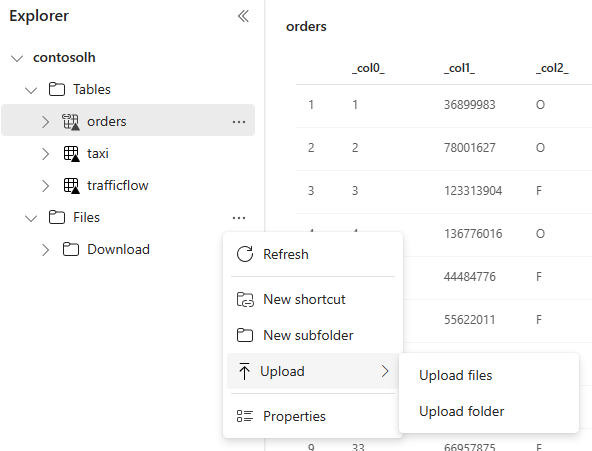

Lokal filopplasting

Du kan også laste opp data som er lagret på den lokale maskinen. Du kan gjøre det direkte i Lakehouse explorer.

Kopier verktøy i datasamlebånd

Kopier-verktøyet er en svært skalerbar dataintegreringsløsning som lar deg koble til forskjellige datakilder og laste inn dataene enten i opprinnelig format eller konvertere dem til en Delta-tabell. Kopieringsverktøy er en del av datasamlebåndaktiviteter som du kan endre på flere måter, for eksempel planlegging eller utløsing basert på en hendelse. Hvis du vil ha mer informasjon, kan du se Slik kopierer du data ved hjelp av kopieringsaktivitet.

Dataflyt

For brukere som er kjent med Power BI-dataflyter, er det samme verktøyet tilgjengelig for innlasting av data i lakehouse. Du kan raskt få tilgang til den fra Alternativet Hent data i Lakehouse explorer, og laste inn data fra over 200 koblinger. Hvis du vil ha mer informasjon, kan du se Hurtigstart: Opprett din første dataflyt for å hente og transformere data.

Notatblokkkode

Du kan bruke tilgjengelige Spark-biblioteker til å koble til en datakilde direkte, laste inn data til en dataramme og deretter lagre dem i et lakehouse. Denne metoden er den mest åpne måten å laste inn data i lakehouse som brukerkode er fullstendig administrerende.

Merk

Eksterne Delta-tabeller som er opprettet med Spark-kode, vil ikke være synlige for et SQL-analyseendepunkt. Bruk snarveier i tabellområdet til å gjøre eksterne Delta-tabeller synlige for et SQL Analytics-endepunkt. Hvis du vil lære hvordan du oppretter en snarvei, kan du se Opprette en snarvei til filer eller tabeller.

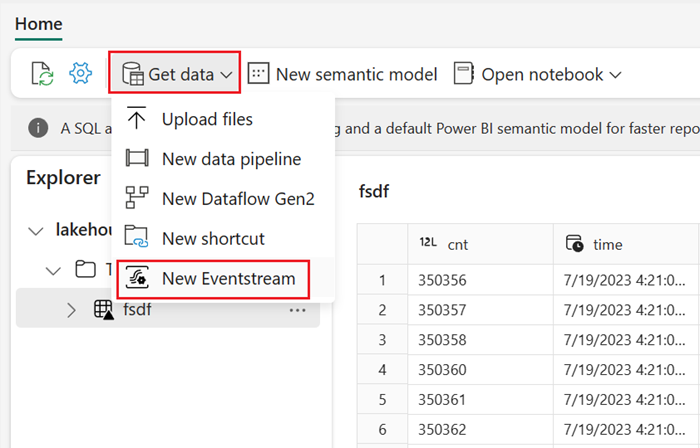

Stream sanntidshendelser med Eventstream

Med Eventstream kan du få, behandle og rute hendelser med store volumer i sanntid fra en rekke ulike kilder.

Hvis du vil se hvordan du legger til lakehouse som destinasjon for Eventstream, kan du se Hent data fra Eventstream i et lakehouse.

For optimal strømmingsytelse kan du strømme data fra Eventstream til et Eventhouse og deretter aktivere OneLake-tilgjengelighet.

Hent data fra Eventhouse

Når du aktiverer OneLake-tilgjengelighet på data i et Eventhouse, opprettes en Delta-tabell i OneLake. Denne Delta-tabellen kan nås av et lakehouse ved hjelp av en snarvei. Hvis du vil ha mer informasjon, kan du se OneLake-snarveier. Hvis du vil ha mer informasjon, kan du se Eventhouse OneLake-tilgjengelighet.

Vurderinger når du velger tilnærming til innlasting av data

| Brukseksempel | Anbefaling |

|---|---|

| Liten filopplasting fra lokal maskin | Bruk lokal filopplasting |

| Små data eller en bestemt kobling | Bruk dataflyter |

| Stor datakilde | Bruke kopieringsverktøy i datasamlebånd |

| Komplekse datatransformasjoner | Bruke notatblokkkode |

| Strømming av data | Bruk Eventstream til å strømme data til Eventhouse. aktivere OneLake-tilgjengelighet og opprette en snarvei fra Lakehouse |

| Tidsseriedata | Hent data fra Eventhouse |

Relatert innhold

- Utforsk dataene i lakehouse med en notatblokk

- Hurtigstart: Opprett det første datasamlebåndet for å kopiere data

- Slik kopierer du data ved hjelp av kopieringsaktivitet

- Flytte data fra Azure SQL DB til Lakehouse via kopieringsassistent

- Legge til et lakehouse-mål i en eventstream

- Eventhouse OneLake-tilgjengelighet