델타 라이브 테이블이란?

참고 항목

Delta Live 테이블에는 Premium 요금제필요합니다. 더 자세한 내용은 Databricks 계정 팀에 문의하세요.

Delta Live Tables는 신뢰할 수 있고 유지 관리 가능한 ETL(추출, 변환 및 로드) 파이프라인 생성을 간소화하도록 설계된 선언적 프레임워크입니다. 수집할 데이터와 이를 변환하는 방법을 지정하고 Delta Live Tables는 오케스트레이션, 컴퓨팅 관리, 모니터링, 데이터 품질 적용 및 오류 처리를 포함하여 데이터 파이프라인 관리의 주요 측면을 자동화합니다.

Delta Live Tables는 Apache Spark를 기반으로 하지만 일련의 별도 Apache Spark 작업을 사용하여 데이터 파이프라인을 정의하는 대신 시스템에서 만들어야 하는 스트리밍 테이블과 구체화된 뷰를 정의하고 해당 스트리밍 테이블과 구체화된 뷰를 채우고 업데이트하는 데 필요한 쿼리를 정의합니다.

Delta Live Tables를 사용하여 ETL 파이프라인을 빌드하고 실행하는 이점에 대한 자세한 내용은 Delta Live Tables 제품 페이지참조하세요.

델타 라이브 테이블의 이점: Apache Spark과의 비교

Apache Spark는 ETL을 비롯한 다양한 오픈 소스 통합 분석 엔진입니다. Delta Live Tables는 특정 및 일반적인 ETL 처리 작업을 해결하기 위해 Spark를 기반으로 합니다. 델타 라이브 테이블은 요구 사항에 다음을 비롯한 처리 작업이 포함된 경우 프로덕션 경로를 크게 가속화할 수 있습니다.

- 일반적인 원본에서 데이터를 수집합니다.

- 데이터를 증분 방식으로 변환합니다.

- CDC(변경 데이터 캡처) 수행

그러나 델타 라이브 테이블은 일부 유형의 절차 논리를 구현하는 데 적합하지 않습니다. 예를 들어 외부 테이블에 쓰거나 외부 파일 스토리지 또는 데이터베이스 테이블에서 작동하는 조건부를 포함하는 것과 같은 처리 요구 사항은 Delta Live Tables 데이터 세트를 정의하는 코드 내에서 수행할 수 없습니다. Delta Live Tables에서 지원되지 않는 처리를 구현하기 위해 Databricks는 Apache Spark를 사용하거나 별도의 작업 작업에서 처리를 수행하는 Databricks Job에 파이프라인을 포함하는 것이 좋습니다. 작업에 대한

다음 표에서는 Delta Live 테이블과 Apache Spark를 비교합니다.

| 능력 | 델타 라이브 테이블 | Apache Spark |

|---|---|---|

| 데이터 변환 | SQL 또는 Python을 사용하여 데이터를 변환할 수 있습니다. | SQL, Python, Scala 또는 R을 사용하여 데이터를 변환할 수 있습니다. |

| 증분 데이터 처리 | 많은 데이터 변환이 자동으로 증분 방식으로 처리됩니다. | 새로운 데이터를 파악하여 증분 방식으로 처리할 수 있어야 합니다. |

| 오케스트레이션 | 변환은 올바른 순서로 자동으로 오케스트레이션됩니다. | 다른 변환이 올바른 순서로 실행되도록 해야 합니다. |

| 병렬성 | 모든 변환은 올바른 수준의 병렬 처리로 실행됩니다. | 관련 없는 변환을 병렬로 실행하려면 스레드 또는 외부 오케스트레이터를 사용해야 합니다. |

| 오류 처리 | 실패는 자동으로 다시 시도됩니다. | 오류를 처리하고 다시 시도하는 방법을 결정해야 합니다. |

| 모니터링 | 메트릭 및 이벤트는 자동으로 기록됩니다. | 실행 또는 데이터 품질에 대한 메트릭을 수집하는 코드를 작성해야 합니다. |

델타 라이브 테이블의 주요 개념

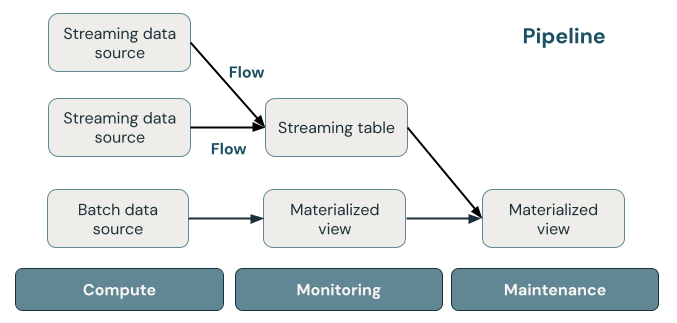

다음 그림에서는 Delta Live Tables 파이프라인의 중요한 구성 요소와 각 파이프라인에 대한 설명을 보여 줍니다.

Delta Live Tables의 주요 개념

스트리밍 테이블

스트리밍 테이블은 하나 이상의 스트림이 데이터를 쓰고 있는 델타 테이블입니다. 스트리밍 테이블은 입력 데이터를 정확히 한 번 처리하고 대량의 추가 전용 데이터를 처리할 수 있기 때문에 수집에 일반적으로 사용됩니다. 스트리밍 테이블은 대용량 데이터 스트림의 짧은 대기 시간 변환에도 유용합니다.

구체화된 뷰

구체화된 뷰는 구체화된 뷰를 정의하는 쿼리를 기반으로 미리 계산된 레코드를 포함하는 뷰입니다. 구체화된 뷰의 레코드는 파이프라인의 업데이트 일정 또는 트리거에 따라 Delta Live Tables에서 자동으로 최신 상태로 유지됩니다. 구체화된 뷰가 업데이트될 때마다 사용 가능한 최신 데이터에 대해 정의 쿼리를 실행하는 것과 동일한 결과가 보장됩니다. 그러나 이는 종종 증분 새로 고침을 사용하여 전체 결과를 처음부터 다시 계산하지 않고 수행됩니다. 구체화된 뷰는 일반적으로 변환에 사용됩니다.

보기

Azure Databricks에서 모든

파이프라인

파이프라인은 함께 업데이트되는 스트리밍 테이블 및 구체화된 뷰의 컬렉션입니다. 이러한 스트리밍 테이블 및 구체화된 뷰는 Python 또는 SQL 원본 파일에서 선언됩니다. 파이프라인에는 파이프라인이 실행될 때 스트리밍 테이블 및 구체화된 뷰를 업데이트하는 데 사용되는 컴퓨팅을 정의하는 구성도 포함됩니다. Terraform 템플릿이 클라우드 계정의 인프라를 정의하는 방법과 마찬가지로 Delta Live Tables 파이프라인은 데이터 처리에 대한 데이터 세트 및 변환을 정의합니다.

Delta Live Tables 데이터 세트는 어떻게 데이터를 처리합니까?

다음 표는 머티리얼라이즈드 뷰, 스트리밍 테이블 및 일반 뷰가 데이터를 처리하는 방법에 대해 설명합니다.

| 데이터 세트 형식 | 정의된 쿼리를 통해 레코드를 처리하는 방법 |

|---|---|

| 스트리밍 테이블 | 각 레코드는 정확히 한 번 처리됩니다. 이 경우 추가 전용 원본이 있다고 가정합니다. |

| 구체화된 뷰 | 레코드는 현재 데이터 상태에 대한 정확한 결과를 반환하는 데 필요한 대로 처리됩니다. 물리화된 뷰는 변환, 집계, 느린 쿼리의 사전 계산, 또는 자주 사용되는 계산과 같은 데이터 처리 작업에 사용해야 합니다. |

| View | 레코드는 뷰를 쿼리할 때마다 처리됩니다. 중간 변환 및 공용 데이터 세트에 게시해서는 안 되는 데이터 품질 검사에 대한 뷰를 사용합니다. |

Delta Live Tables에서 당신의 첫 번째 데이터 세트를 선언하십시오

Delta Live Tables에는 Python 및 SQL에 대한 새로운 구문이 도입되었습니다. 파이프라인 구문의 기본 사항을 알아보려면 Python을 사용하여 파이프라인 코드 개발 및 SQL을 사용하여 파이프라인 코드 개발을 참조하세요.

참고 항목

Delta Live Tables는 데이터 세트 정의를 업데이트 처리와 분리하며 Delta Live Tables Notebook은 대화형 실행을 위한 것이 아닙니다.

Delta Live Tables 파이프라인을 구성하려면 어떻게 해야 할까요?

Delta Live Tables 파이프라인에 대한 설정은 다음 두 가지 광범위한 범주로 구분됩니다.

- Delta Live Tables 구문을 사용하여 데이터 세트를 선언하는 Notebook 또는 파일(소스 코드)의 컬렉션을 정의하는 구성입니다.

- 파이프라인 인프라, 종속성 관리, 업데이트 처리 방법 및 테이블이 작업 영역에 저장되는 방법을 제어하는 구성입니다.

대부분의 구성은 선택 사항이지만 일부는 특히 프로덕션 파이프라인을 구성할 때 주의해야 합니다. 여기에는 다음이 포함됩니다.

- 파이프라인 외부에서 데이터를 사용할 수 있도록 하려면 Hive 메타스토어에 게시할 대상 스키마을 선언하거나 Unity 카탈로그에 게시할 대상 카탈로그 및 대상 스키마를 선언해야 합니다.

- 데이터 액세스 권한은 실행에 사용되는 클러스터를 통해 구성됩니다. 지정된 경우 클러스터에 데이터 원본 및 대상 스토리지 위치대해 구성된 적절한 권한이 있는지 확인합니다.

Python 및 SQL을 사용하여 파이프라인에 대한 소스 코드를 작성하는 방법에 대한 자세한 내용은 Delta Live Tables SQL 언어 참조 및 Delta Live Tables Python 언어 참조참조하세요.

파이프라인 설정 및 구성에 대한 자세한 내용은 Delta Live Tables 파이프라인 구성을 참조하세요.

첫 번째 파이프라인 배포 및 업데이트 트리거

Delta Live Tables를 사용하여 데이터를 처리하기 전에 파이프라인을 구성해야 합니다. 파이프라인이 구성되면 업데이트를 트리거하여 파이프라인의 각 데이터 세트에 대한 결과를 계산할 수 있습니다. Delta Live Tables 파이프라인 사용을 시작하려면 튜토리얼: 첫 번째 Delta Live Tables 파이프라인 실행하기를 참조하세요.

파이프라인 업데이트란?

파이프라인은 업데이트을 시작할 때 인프라를 배포하고 데이터 상태를 다시 계산합니다. 업데이트는 다음을 수행합니다.

- 올바른 구성으로 클러스터를 시작합니다.

- 정의된 모든 테이블 및 뷰를 검색하고 잘못된 열 이름, 누락된 종속성 및 구문 오류와 같은 분석 오류를 확인합니다.

- 사용 가능한 최신 데이터를 사용하여 테이블 및 뷰를 만들거나 업데이트합니다.

파이프라인은 사용 사례의 비용 및 대기 시간 요구 사항에 따라 지속적으로 또는 일정에 따라 실행할 수 있습니다. Delta Live Tables 파이프라인의 업데이트를 실행하세요.

Delta Live Tables를 사용하여 데이터 수집

Delta Live Tables는 Azure Databricks에서 사용할 수 있는 모든 데이터 원본을 지원합니다.

Databricks는 대부분의 수집 사용 사례에 스트리밍 테이블을 사용하는 것이 좋습니다. 클라우드 개체 스토리지에 도착하는 파일의 경우 Databricks는 자동 로더를 권장합니다. 대부분의 메시지 버스에서 Delta Live Tables를 사용하여 데이터를 직접 수집할 수 있습니다.

클라우드 스토리지에 대한 액세스 구성에 대한 자세한 내용은 클라우드 스토리지 구성을 참조하세요.

자동 로더에서 지원되지 않는 형식의 경우 Python 또는 SQL을 사용하여 Apache Spark에서 지원하는 모든 형식을 쿼리할 수 있습니다. Delta Live Tables로 데이터 로드를 참조하세요.

데이터 품질 모니터링 및 적용

기대치를 사용하여 데이터 세트의 내용에 대한 데이터 품질 제어를 지정할 수 있습니다. 제약 조건에 실패한 레코드를 추가하지 못하게 하는 기존 데이터베이스의 CHECK 제약 조건과 달리 데이터 품질 요구 사항에 실패한 데이터를 처리할 때 기대는 유연성을 제공합니다. 이러한 유연성 덕분에 지저분할 것으로 예상되는 데이터와 엄격한 품질 요구 사항을 충족해야 하는 데이터를 처리하고 저장할 수 있습니다.

파이프라인 기대를 통한 데이터 품질 관리보기.

Delta Live Tables 및 Delta Lake는 어떻게 관련되어 있나요?

Delta Live Tables는 Delta Lake의 기능을 확장합니다. Delta Live Tables에서 만들고 관리하는 테이블은 델타 테이블이므로 Delta Lake에서 제공하는 것과 동일한 보장 및 기능이 있습니다. Delta Lake란?을 참조하세요.

Delta Live Tables는 Delta Lake에서 설정할 수 있는 많은 테이블 속성 외에도 여러 테이블 속성을 추가합니다. Delta Live Tables 속성 참조 및 델타 테이블 속성 참조참조합니다.

Delta Live Tables에서 테이블을 만들고 관리하는 방법

Azure Databricks는 Delta Live Tables를 사용하여 만든 테이블을 자동으로 관리하여 테이블의 현재 상태를 올바르게 계산하기 위해 업데이트를 처리해야 하는 방법을 결정하고 다양한 유지 관리 및 최적화 작업을 수행합니다.

대부분의 작업의 경우 Delta Live Tables가 대상 테이블에 대한 모든 업데이트, 삽입 및 삭제를 처리하도록 허용해야 합니다. 자세한 내용 및 제한 사항은 수동 삭제 또는 업데이트 유지를 참조 하세요.

Delta Live Tables에서 수행하는 유지 관리 작업

Delta Live Tables는 업데이트되는 테이블의 24시간 이내에 유지 관리 작업을 수행합니다. 유지 관리는 이전 버전의 테이블을 제거하여 쿼리 성능을 향상시키고 비용을 절감할 수 있습니다. 기본적으로 시스템은 전체 OPTIMIZE 작업을 수행한 후에 VACUUM을(를) 수행합니다. 테이블의 OPTIMIZE에서 pipelines.autoOptimize.managed = false을 설정하여 의 사용을 중지할 수 있습니다. 유지 관리 작업은 유지 관리 작업이 예약되기 24시간 전에 파이프라인 업데이트가 실행된 경우에만 수행됩니다.

제한 사항

제한 사항 목록은 Delta Live Tables 제한 사항참조하세요.

Unity 카탈로그와 함께 Delta Live Tables를 사용할 때 필요한 요구 사항 및 제한 사항을 확인하려면 Delta Live Tables 파이프라인에서 Unity 카탈로그 사용을 참조하세요.

추가 리소스

- Delta Live Tables는 Databricks REST API에서 모든 지원을 제공합니다. DLT API를 참조하세요.

- 파이프라인 및 테이블 설정에 대해서는 Delta Live Tables 속성 참조를 확인하세요.

- 델타 라이브 테이블 SQL 언어 참조.

- Delta Live Tables Python 언어 참조.