Azure Data Lake Storage Gen1 を使用して Event Hubs からデータをキャプチャする

Azure Data Lake Storage Gen1 を使用して、Azure Event Hubs で受信したデータをキャプチャする方法を説明します。

前提条件

Azure サブスクリプション。 Azure 無料試用版の取得に関するページを参照してください。

Azure Data Lake Storage Gen1 アカウント。 これを作成する手順については、Azure Data Lake Storage Gen1 の使用開始に関する記事をご覧ください。

Event Hubs 名前空間。 手順については、「Event Hubs 名前空間を作成します」を参照してください。 Data Lake Storage Gen1 アカウントと Event Hubs 名前空間が同じ Azure サブスクリプションにあるようにしてください。

Event Hubs にアクセス許可を割り当てる

このセクションでは、Event Hubs からデータをキャプチャするアカウント内にフォルダーを作成します。 さらに、Event Hubs にアクセス許可を割り当てて、Data Lake Storage Gen1 アカウントにデータを書き込むことができるようにします。

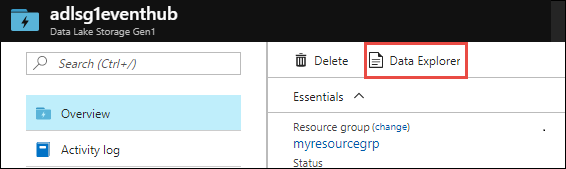

Event Hubs からデータをキャプチャする Data Lake Storage Gen1 アカウントを開き、 [データ エクスプローラー] をクリックします。

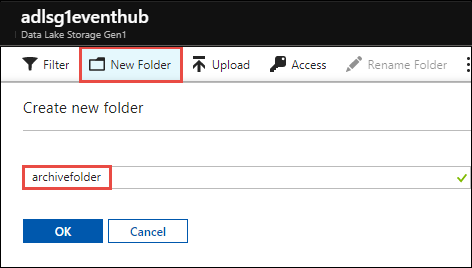

[新しいフォルダー] をクリックし、データをキャプチャするフォルダーの名前を入力します。

Data Lake Storage Gen1 のルートにアクセス許可を割り当てます。

a. [データ エクスプローラー] をクリックし、Data Lake Storage Gen1 アカウントのルートを選択して、 [アクセス] をクリックします。

![Data Lake Storage Gen1 ルートにアクセス許可を割り当てる アカウントのルートと [アクセス] オプションが強調表示されているデータ エクスプローラーのスクリーンショット。](media/data-lake-store-archive-eventhub-capture/data-lake-store-assign-permissions-to-root.png)

b. [アクセス] で [追加] 、 [ユーザーまたはグループの選択] の順にクリックし、

Microsoft.EventHubsを検索します。![Data Lake Storage Gen1 ルートにアクセス許可を割り当てる [追加] オプション、[ユーザーまたはグループの選択] オプション、Microsoft Eventhubs オプションが強調表示されている [アクセス] ページのスクリーンショット。](media/data-lake-store-archive-eventhub-capture/data-lake-store-assign-eventhub-sp.png)

[選択] をクリックします。

c. [アクセス許可の割り当て] で [アクセス許可の選択] をクリックします。 [アクセス許可] を [実行] に設定します。 [追加先] を [このフォルダーとすべての子] に設定します。 [追加ユーザー] を [アクセス許可エントリと既定のアクセス許可エントリ] に設定します。

重要

Azure Event Hubs で受信したデータをキャプチャするための新しいフォルダー階層を作成する際、これは宛先フォルダーに確実にアクセスする簡単な方法です。 ただし、子ファイルとフォルダーが多数含まれる最上位フォルダーのすべての子にアクセス許可を追加すると、長い時間がかかる可能性があります。 ルート フォルダーに多数のファイルとフォルダーが含まれている場合、最終的な宛先フォルダーへのパスに

Microsoft.EventHubsの 実行権限を各フォルダーに個別に追加した方が速いことがあります。![Data Lake Storage Gen1 ルートにアクセス許可を割り当てる [アクセス許可の選択] オプションが強調表示されている [アクセス許可の割り当て] セクションのスクリーンショット。[アクセス許可の選択] セクションの横では、[実行] オプション、[追加先] オプション、[追加ユーザー] オプションが強調表示されています。](media/data-lake-store-archive-eventhub-capture/data-lake-store-assign-eventhub-sp1.png)

[OK] をクリックします。

データをキャプチャする Data Lake Storage Gen1 アカウントのフォルダーにアクセス許可を割り当てます。

a. [データ エクスプローラー] をクリックし、Data Lake Storage Gen1 アカウントのフォルダーを選択して、 [アクセス] をクリックします。

![Data Lake Storage Gen1 フォルダーにアクセス許可を割り当てる アカウントのフォルダーと [アクセス] オプションが強調表示されているデータ エクスプローラーのスクリーンショット。](media/data-lake-store-archive-eventhub-capture/data-lake-store-assign-permissions-to-folder.png)

b. [アクセス] で [追加] 、 [ユーザーまたはグループの選択] の順にクリックし、

Microsoft.EventHubsを検索します。![Data Lake Storage Gen1 フォルダーにアクセス許可を割り当てる [追加] オプション、[ユーザーまたはグループの選択] オプション、Microsoft Eventhubs オプションが強調表示されているデータ エクスプローラーの [アクセス] ページのスクリーンショット。](media/data-lake-store-archive-eventhub-capture/data-lake-store-assign-eventhub-sp.png)

[選択] をクリックします。

c. [アクセス許可の割り当て] で [アクセス許可の選択] をクリックします。 [アクセス許可] を [読み取り、書き込み] と [実行] に設定します。 [追加先] を [このフォルダーとすべての子] に設定します。 最後に、 [追加ユーザー] を [アクセス許可エントリと既定のアクセス許可エントリ] に設定します。

![Data Lake Storage Gen1 フォルダーにアクセス許可を割り当てる [アクセス許可の選択] オプションが強調表示されている [アクセス許可の割り当て] セクションのスクリーンショット。[アクセス許可の選択] セクションの横では、[読み取り]、[書き込み]、[実行] の各オプション、[追加先] オプション、[追加ユーザー] オプションが強調表示されています。](media/data-lake-store-archive-eventhub-capture/data-lake-store-assign-eventhub-sp-folder.png)

[OK] をクリックします。

Data Lake Storage Gen1 にデータをキャプチャするよう Event Hubs を構成する

このセクションでは、Event Hubs 名前空間内にイベント ハブを作成します。 さらに、Azure Data Lake Storage Gen1 アカウントにデータをキャプチャするよう、そのイベント ハブを構成します。 このセクションでは、Event Hubs 名前空間を既に作成していることを前提としています。

Event Hubs 名前空間の [概要] ウィンドウで、 + [イベント ハブ] をクリックします。

![イベント ハブの作成 [イベント ハブ] オプションが強調表示されている [概要] ペインのスクリーンショット。](media/data-lake-store-archive-eventhub-capture/data-lake-store-create-event-hub.png)

次の値を設定して、Data Lake Storage Gen1 にデータをキャプチャするよう Event Hubs を構成します。

![イベント ハブの作成 [名前] テキスト ボックス、[キャプチャ] オプション、[キャプチャ プロバイダー] オプション、[Data Lake Store の選択] オプション、[Data Lake パス] オプションが強調表示されている [イベント ハブの作成] ダイアログ ボックスのスクリーンショット。](media/data-lake-store-archive-eventhub-capture/data-lake-store-configure-eventhub.png)

a. イベント ハブの名前を指定します。

b. このチュートリアルでは、 [パーティション数] と [メッセージのリテンション期間] を既定値に設定します。

c. [キャプチャ] を [オン] に設定します。 [時間枠] (キャプチャの頻度) と [ウィンドウのサイズ変更] (キャプチャするデータのサイズ) を設定します。

d. [Capture Provider]\(キャプチャ プロバイダー\) には [Azure Data Lake Store] を選択し、前に作成した Data Lake Storage Gen1 アカウントを選択します。 [Data Lake Path]\(Data Lake パス\) には、Data Lake Storage Gen1 アカウントに作成したフォルダーの名前を入力します。 入力するのはフォルダーの相対パスだけでかまいません。

e. [サンプルのキャプチャ ファイル名の形式] は既定値のままにします。 このオプションは、キャプチャ フォルダーの下に作成されるフォルダー構造を制御します。

f. Create をクリックしてください。

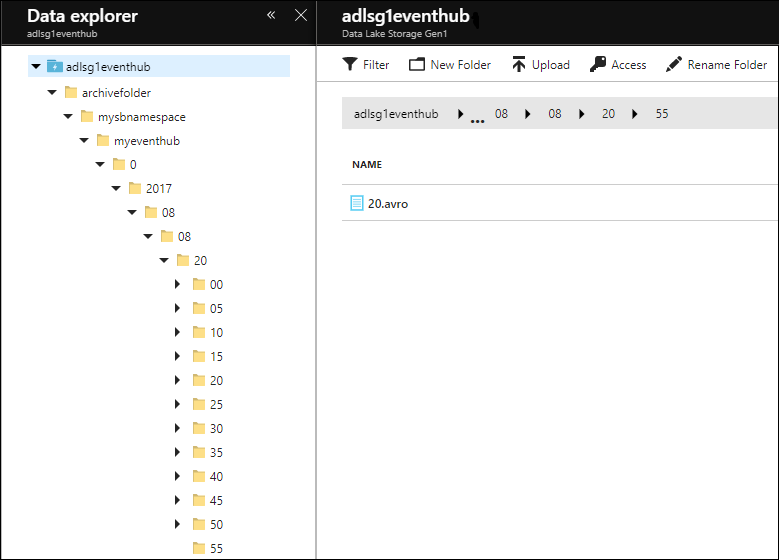

設定をテストする

Azure Event Hubs にデータを送信することで、ソリューションをテストできるようになりました。 Azure Event Hubs へのイベントの送信に関するページで説明されている手順に従ってください。 データの送信を開始すると、指定したフォルダー構造を使用して Data Lake Storage Gen1 に反映されたデータが表示されます。 例として、Data Lake Storage Gen1 アカウントに表示されたフォルダー構造を次のスクリーンショットに示します。

注意

Event Hubs に送信されたメッセージがない場合でも、Event Hubs はヘッダーだけの空ファイルを Data Lake Storage Gen1 アカウントに書き込みます。 これらのファイルは、イベント ハブの作成時に指定した期間と同じ間隔で書き込まれます。

Data Lake Storage Gen1 でのデータの分析

データが Data Lake Storage Gen1 に保存されると、分析ジョブを実行してデータを処理および高速処理できます。 Azure Data Lake Analytics を使用してこれを行う方法については、USQL Avro の例のページを参照してください。