Fabric Real-Time Hub にソースとして Apache Kafka を追加する (プレビュー)

この記事では、Fabric リアルタイム ハブで Apache Kafka をイベント ソースとして追加する方法について説明します。

前提条件

- 共同作成者以上のアクセス許可を使用した Fabric 容量ライセンス モード (または試用版ライセンス モード) でのワークスペースへのアクセス。

- 実行中の Apache Kafka クラスター。

- Apache Kafka にはパブリックにアクセスできる必要があり、ファイアウォールの内側にあったり、仮想ネットワークで保護されていたりしてはなりません。

データ ソース ページ

Microsoft Fabric にサインインします。

左側のナビゲーション バーで [リアルタイム] を選択します。

[リアルタイム ハブ] ページで、左側のナビゲーション メニューの [接続先] の下にある [+ データ ソース] を選択します。 また、右上にある [+ データ ソースに接続] ボタンを選択して、[すべてのデータ ストリーム] ページまたは [マイ データ ストリーム] ページから [データ ソース] ページにアクセスすることもできます。

Apache Kafka をソースとして追加する

Fabric Real-Time ハブで Apache Kafka トピックをソースとして追加する手順を次に示します。

[データ ソースの選択] ページで、[Apache Kafka] を選択します。

![[イベントの取得] ウィザードでソースの種類として Apache Kafka が選択されていることを示すスクリーンショット。](../real-time-intelligence/event-streams/includes/media/apache-kafka-source-connector/select-apache-kafka.png)

データ 接続ページで、新しい接続を選択します。

![イベントの取得ウィザードの [接続] ページで [新しい接続] リンクの選択を示すスクリーンショット。](../real-time-intelligence/event-streams/includes/media/apache-kafka-source-connector/new-connection-link.png)

[接続設定] セクションの [ブートストラップ サーバー] に、Apache Kafka のサーバー アドレスを入力します。

![イベントの取得ウィザードの [接続] ページで Apache Kafka Bootstrap サーバー フィールドを選択したことを示すスクリーンショット。](../real-time-intelligence/event-streams/includes/media/apache-kafka-source-connector/bootstrap-server.png)

Apache Kafka クラスターへの既存の接続がある場合は、[接続の資格情報] セクションで [接続] のドロップダウン リストからそれを選択します。 そうでない場合は、次の手順に従います。

- 接続名 には、接続の名前を入力します。

- [認証の種類] に [API キー] が選択されていることを確認します。

- [キー] と [シークレット] には、API キーとキーのシークレットを入力します。

[接続] を選択します。

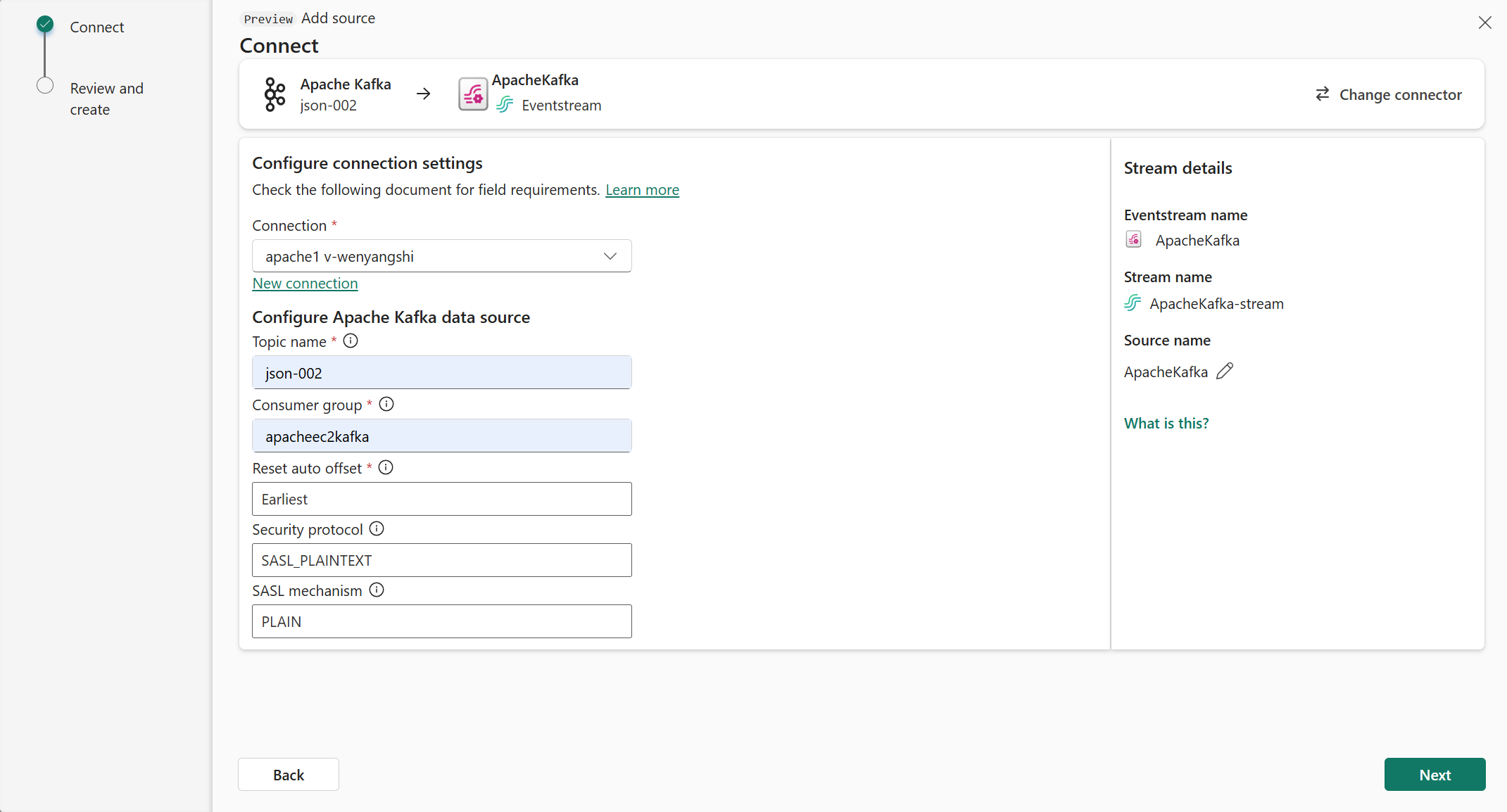

次に、[接続] ページで次の手順に従います。

[トピック] に Kafka トピックを入力します。

[コンシューマー グループ] に Apache Kafka クラスターのコンシューマー グループを入力します。 このフィールドには、イベントを取得するための専用のコンシューマー グループが用意されています。

[自動オフセットのリセット] を選択して、コミットがない場合にオフセットの読み取りを開始する場所を指定します。

[セキュリティ プロトコル] の既定値は SASL_PLAINTEXT です。

Note

現在、Apache Kafka ソースでは、Apache Kafka クラスターと Eventstream の間で暗号化されないデータ転送 (SASL_PLAINTEXT と PLAINTEXT) のみがサポートされています。 SSL による暗号化されたデータ転送は、近日中にサポートされる予定です。

既定の [SASL メカニズム] は、特に構成されていない限り通常は PLAIN です。 セキュリティ要件に合わせて、SCRAM-SHA-256 または SCRAM-SHA-512 メカニズムを選択できます。

[次へ] を選択します。 [確認と作成] 画面で、概要を確認し、[追加] を選択します。

データ ストリームの詳細を表示する

[確認と接続] ページで [イベントストリームを開く] を選択すると、選択した Apache Kafka ソースで作成されたイベントストリームがウィザードで開きます。 ページの下部の [閉じる] をクリックしてウィザードを終了します。

リアルタイム ハブで、リアルタイム ハブの [データ ストリーム] タブに切り替えます。 ページを最新の情報に更新します。 作成されたデータ ストリームが表示されます。

詳細な手順については、「Fabric リアルタイム ハブでのデータ ストリームの詳細の表示」を参照してください。

関連するコンテンツ

データ ストリームの使用について詳しくは、次の記事を参照してください。

![[データ ソースに接続] エクスペリエンスを起動する方法を示すスクリーンショット。](includes/media/launch-get-events-experience/select-real-time-hub.png)