Microsoft Fabric のデータ エンジニアリングとは

Microsoft Fabric のデータ エンジニアリングにより、ユーザーは、組織が大量のデータを収集、保存、処理、分析できるインフラストラクチャとシステムを設計、構築、管理できます。

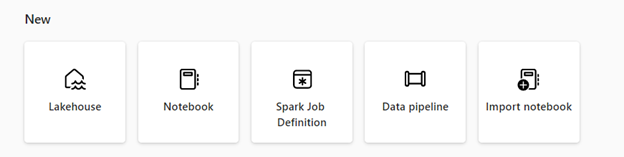

Microsoft Fabric には、データに簡単にアクセスでき、適切に整理され、高品質であることを保証するためのさまざまなデータ エンジニアリング機能が用意されています。 データ エンジニアリングのホームページでは、次のことができます。

Lakehouse を使用してデータを作成および管理する

レイクハウスにデータをコピーするためのパイプラインを設計する

Spark ジョブ定義を使用してバッチ/ストリーミング ジョブを Spark クラスターに送信する

ノートブックを使用してデータ インジェスト、準備、変換のコードを記述する

レイクハウス

Lakehouses は、組織がさまざまなツールやフレームワークを使用してそのデータを処理および分析することで、構造化データと非構造化データを 1 つの場所に格納および管理できるデータ アーキテクチャです。 これらのツールとフレームワークには、SQL ベースのクエリと分析のほか、機械学習やその他の高度な分析手法を含めることができます。

Apache Spark ジョブ定義

Spark ジョブ定義は、Spark クラスターでジョブを実行する方法を定義する一連の命令です。 これには、入力データ ソースと出力データ ソース、変換、Spark アプリケーションの構成設定などの情報が含まれます。 Spark ジョブ定義を使用すると、バッチ/ストリーミング ジョブを Spark クラスターに送信し、lakehouse でホストされているデータにさまざまな変換ロジックを他の多くのものを適用できます。

ノートパソコン

ノートブックは対話型コンピューティング環境であり、ユーザーはライブ コード、数式、視覚化、説明テキストを含むドキュメントを作成して共有できます。 ユーザーは、Python、R、Scala など、さまざまなプログラミング言語でコードを記述して実行できます。 ノートブックは、データ インジェスト、準備、分析、その他のデータ関連タスクに使用できます。

データ パイプライン

データ パイプラインは、生の形式から分析と意思決定に使用できる形式にデータを収集、処理、変換できる一連の手順です。 これらは、信頼性の高いスケーラブルで効率的な方法でデータをソースから宛先に移動する方法を提供するため、データ エンジニアリングの重要なコンポーネントです。

Fabric 試用版にサインアップするときに、Microsoft Fabric の Data Engineering を無料で使用できます。 Microsoft Fabric 容量または Fabric 予約容量を購入することもできます

関連コンテンツ

データエンジニアリングを始める

- レイクハウスの詳細については、「Microsoft Fabric のレイクハウスとは」を参照してください。

- レイクハウスの使用を開始するには、「Microsoft Fabric でレイクハウスを作成するを参照してください。

- Apache Spark ジョブ定義の詳細については、「Apache Spark ジョブ定義とは」を参照してください。

- Apache Spark ジョブ定義の使用を開始するには、「Fabricで Apache Spark ジョブ定義を作成する方法」を参照してください。

- ノートブックの詳細については、「ノートブックを作成し、を実行する」を参照してください。

- パイプライン コピー アクティビティの使用を開始するには、「コピー アクティビティを使用してデータをコピーする方法」を参照してください。