データ フロー エンドポイントを構成する

重要

このページには、プレビュー段階にある Kubernetes デプロイ マニフェストを使用して Azure IoT Operations コンポーネントを管理する手順が含まれます。 この機能はいくつかの制限を設けて提供されており、運用環境のワークロードには使用しないでください。

ベータ版、プレビュー版、または一般提供としてまだリリースされていない Azure の機能に適用される法律条項については、「Microsoft Azure プレビューの追加使用条件」を参照してください。

データ フローの使用を開始するには、まず、データ フロー エンドポイントを作成します。 データ フロー エンドポイントとは、データ フローの接続ポイントです。 エンドポイントは、データ フローのソースまたは宛先として使用できます。 エンドポイントの種類には、ソースと宛先の両方として使用できるものもあれば、宛先のみのものもあります。 データ フローには、少なくとも 1 つのソース エンドポイントと 1 つの宛先エンドポイントが必要です。

次の表を使用して、構成するエンドポイントの種類を選択します。

| [エンドポイントの種類] | 説明 | ソースとして使用可能 | 宛先として使用可能 |

|---|---|---|---|

| MQTT | MQTT ブローカー (Azure IoT Operations および Event Grid に組み込まれているものを含む) を使用した双方向メッセージングの場合。 | はい | はい |

| Kafka | Kafka ブローカー (Azure Event Hubs を含む) を使用した双方向メッセージングの場合。 | はい | はい |

| Data Lake | データを Azure Data Lake Gen2 ストレージ アカウントにアップロードする場合。 | いいえ | はい |

| Microsoft Fabric OneLake | データを Microsoft Fabric OneLake レイクハウスにアップロードする場合。 | いいえ | はい |

| Azure Data Explorer | Azure Data Explorer データベースにデータをアップロードする場合。 | いいえ | はい |

| ローカル ストレージ | ローカルで利用可能な永続ボリュームにデータを送信する場合向け。これにより、Azure Arc エッジ ボリュームで有効になっている Azure コンテナー ストレージ経由でデータをアップロードできます。 | いいえ | はい |

重要

ストレージ エンドポイントには、シリアル化にスキーマが必要です。 Microsoft Fabric OneLake、Azure Data Lake Storage、Azure Data Explorer、またはローカル記憶域でデータ フローを使用するには、スキーマ参照を指定する必要があります。

サンプル データ ファイルからスキーマを生成するには、Schema Gen Helper を使用します。

データ フローではローカル MQTT ブローカー エンドポイントの使用が必須

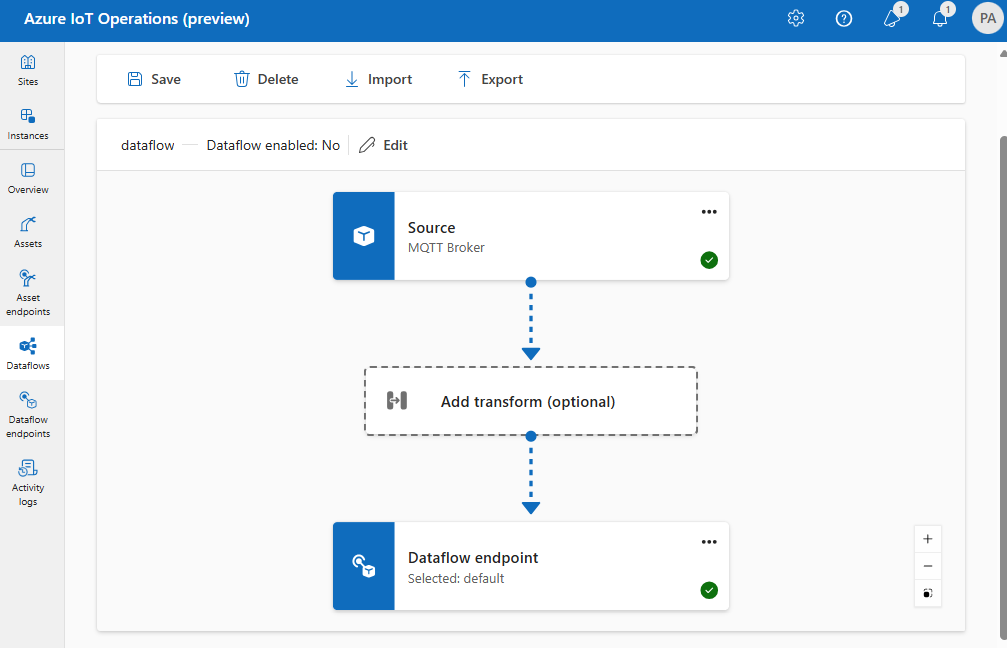

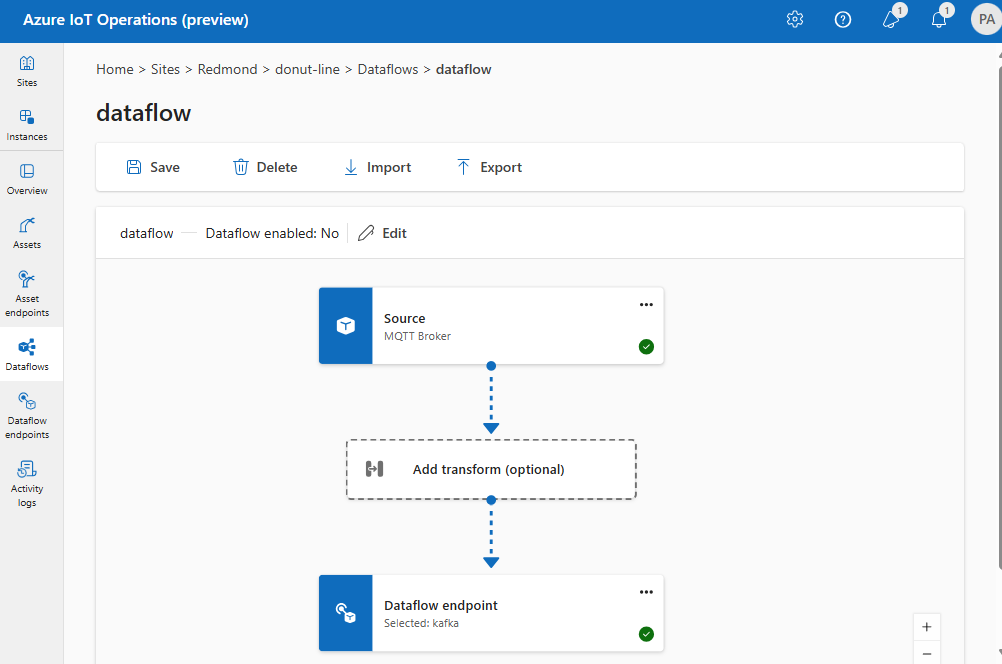

データ フローを作成する場合、ソースと宛先のエンドポイントを指定します。 データ フローは、ソース エンドポイントから宛先エンドポイントにデータを移動します。 複数のデータ フローに同じエンドポイントを使用できます。また、データ フロー内でソースと宛先の両方に同じエンドポイントを使用できます。

ただし、データ フロー内でソースと宛先の両方としてカスタム エンドポイントを使用することはサポートされていません。 この制限は、Azure IoT Operations の組み込み MQTT ブローカーが少なくとも 1 つのエンドポイントである必要があることを意味します。 ソースとターゲットのどちらか一方または両方にできます。 データ フローのデプロイ エラーを回避するには、既定の MQTT データ フロー エンドポイントをすべてのデータ フローのソースまたは宛先のいずれかとして使用します。

具体的な要件としては、各データ フローに、ホスト名が aio-broker である MQTT エンドポイントで構成されたソースまたは宛先のいずれかが必要です。 そのため、既定のエンドポイントの使用は厳密に必要ではありません。ホスト名が aio-broker である限り、ローカル MQTT ブローカーを指す追加のデータ フロー エンドポイントを作成できます。 ただし、混乱や管理の容易性の問題を回避するには、既定のエンドポイントが推奨される方法です。

次の表は、サポートされるシナリオを示しています。

| シナリオ | サポートされています |

|---|---|

| ソースとしての既定のエンドポイント | はい |

| 宛先としての既定のエンドポイント | はい |

| ソースとしてのカスタム エンドポイント | はい (宛先が既定のエンドポイントまたはホスト名が aio-broker の MQTT エンドポイントの場合) |

| 宛先としてのカスタム エンドポイント | はい (ソースが既定のエンドポイントまたはホスト名が aio-broker の MQTT エンドポイントの場合) |

| ソースと宛先としてのカスタム エンドポイント | いいえ (どちらか一方が、ホスト名が aio-broker の MQTT エンドポイントである場合を除く) |

エンドポイントを再利用する

各データ フロー エンドポイントは、データの送信元または送信先 (host 値)、エンドポイントでの認証方法、TLS 構成やバッチ処理の設定などのその他の設定を含む構成設定のバンドルと考えてください。 そのため、1 回作成するだけで、これらの設定が同じである複数のデータ フローで再利用できます。

エンドポイントをより簡単に再利用するために、MQTT または Kafka トピック フィルターは、エンドポイント構成に含まれません。 代わりに、データ フロー構成でトピック フィルターを指定します。 つまり、異なるトピック フィルターを使用する複数のデータ フローに同じエンドポイントを使用できます。

たとえば、既定の MQTT ブローカー データ フロー エンドポイントを使用できます。 これは、異なるトピック フィルターを使用してソースと宛先の両方に使用できます。

同様に、他のエンドポイントやトピックに同じ MQTT エンドポイントを使用する複数のデータ フローを作成できます。 たとえば、データを Event Hubs エンドポイントに送信するデータ フローに同じ MQTT エンドポイントを使用できます。

MQTT の例と同様に、異なるトピックに同じ Kafka エンドポイントを使用するか、または異なるテーブルに同じ Data Lake エンドポイントを使用する複数のデータ フローを作成できます。

次のステップ

データ フロー エンドポイントを作成する: