評価主導型の開発ワークフロー

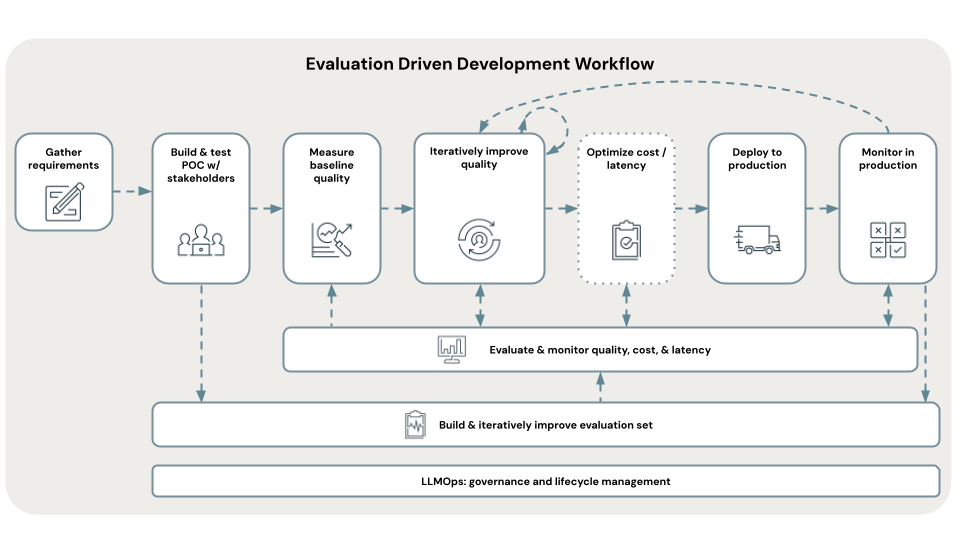

このセクションでは、高品質の RAG アプリケーション: 評価主導型の開発を構築、テスト、デプロイするための Databricks 推奨開発ワークフローについて説明します。 このワークフローは、高品質の RAG アプリケーションを構築して評価するための、Mosaic Research チーム推奨ベスト プラクティスに基づいています。 Databricks では、次の評価主導型ワークフローをお勧めします。

- 要件を定義する。

- 迅速な概念実証 (POC) に関する関係者からのフィードバックを収集する。

- POC の品質を評価する。

- 品質の問題の診断と修正を繰り返す。

- 運用への展開。

- 運用環境で監視する。

評価主導型の開発には、次の 2 つの主要な概念があります。

メトリック: 高品質の意味を定義します。

毎年ビジネス目標の設定方法を定義するように、ユース ケースにとって高品質とは何かを定義する必要があります。 Mosaic AI エージェント評価は、使用する推奨メトリック セットを提供しており、その中で最も重要なのは、応答の精度または正確性です。RAG アプリケーションは適切な応答を提供していますか?

評価セット: メトリックを客観的に測定します。

品質を客観的に測定するには、評価セットが必要です。これには、質問と、人間によって検証された既知の適切な応答が含まれています。 このガイドでは、この評価セットを開発し、反復的に改良していくプロセスについて説明します。

メトリックと評価セットに対するアンカー設定のメリットは次のとおりです。

- 開発中、アプリケーションの品質を自信を持って繰り返し改良できます。改善につながる変更かどうかを推測する必要がなくなりました。

- "アプリケーションはビジネスにとって最も重要な質問に正しく答え、決して誤認識しない" と自信を持って言うことができ、ビジネス関係者との、運用環境に向けたアプリケーションの準備状況に関する調整がさらに簡単になります。

評価主導型ワークフローの詳細なチュートリアルは、「前提条件: 要件を収集する」から開始してください。