Azure Stack Edge Pro GPU デバイスでのクラスタリング

適用対象:  Azure Stack Edge Pro - GPU

Azure Stack Edge Pro - GPU Azure Stack Edge Pro 2

Azure Stack Edge Pro 2

この記事では、Azure Stack Edge デバイスでのクラスタリングの概要について説明します。

フェールオーバー クラスタリングについて

Azure Stack Edge は、1 つのスタンドアロン デバイスまたは 2 ノード クラスターとしてセットアップできます。 2 ノード クラスターは、物理ケーブルとソフトウェアによって接続されている 2 つの独立した Azure Stack Edge デバイスで構成されます。 これらのノードがクラスター化されると、Windows のフェールオーバー クラスターと同様に動作し、クラスターで実行されているアプリケーションとサービスに高可用性が提供されます。

クラスター化されたノードの一方で障害が発生した場合は、もう一方のノードでサービスの提供が開始されます (このプロセスはフェールオーバーと呼ばれます)。 クラスター化されたロールも予防的に監視され、正常に動作していることが確認されます。 動作していない場合は、再起動されるか、2 番目のノードに移動します。

Azure Stack Edge では、Windows サーバー フェールオーバー クラスタリングが 2 ノード クラスターに使用されます。 詳細については、「Windows Server のフェールオーバー クラスタリング」を参照してください。

クラスター クォーラムと監視

クォーラムは、障害が発生した場合にオンラインの状態を維持するために、Azure Stack Edge クラスター上で常に維持されます。 ノードの 1 つで障害が発生した場合は、残りのノードの過半数で、クラスターがオンラインの状態で維持されることを確認する必要があります。 過半数の概念は、ノード数が奇数のクラスターにのみ存在します。 クラスター クォーラムの詳細については、クォーラムの概要に関する記事を参照してください。

2 つのノードを持つ Azure Stack Edge クラスターの場合、1 つのノードで障害が発生すると、クラスター監視によって 3 番目の投票が提供され、クラスターでオンラインの状態が維持されます (クラスターは 2/3 の投票 (過半数) のままであるため)。 Azure Stack Edge クラスターにクラスター監視が必要となります。 デバイスのローカル UI を使用して、クラウドまたはローカル ファイル共有に監視を設定できます。

- クラスター監視の詳細については、「Azure Stack Edge でのクラスター監視」を参照してください。

- クラウドでの監視の詳細については、「クラウド監視の構成」を参照してください。

- クラウド監視をデプロイする詳細な手順については、「フェールオーバー クラスターのクラウド監視のデプロイ」を参照してください。

インフラストラクチャ クラスター

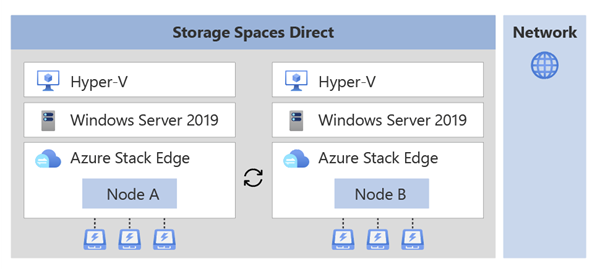

デバイス上のインフラストラクチャ クラスターでは、次の図に示すように、永続的なストレージが提供されます。

インフラストラクチャ クラスターは、Hyper-V レイヤーを持つ Windows Server オペレーティング システムで実行される 2 つの独立したノードで構成されます。 これらのノードには、ストレージ用の物理ディスクと、背中合わせで接続されるか、スイッチを持つネットワーク インターフェイスが含まれています。

2 つのノードのディスクは、論理記憶域プールの作成に使用されます。 このプールの記憶域スペース ダイレクトでは、クラスターのミラーリングとパリティが提供されます。

インフラストラクチャ クラスターの上にアプリケーションのワークロードをデプロイできます。

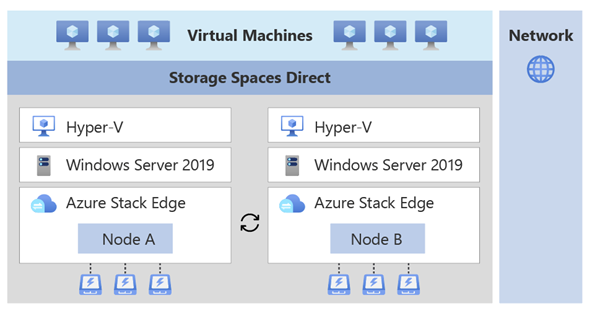

VM などのコンテナー化されていないワークロードは、インフラストラクチャ クラスターの上に直接デプロイできます。

コンテナー化されたワークロードでは、ワークロードのデプロイと管理に Kubernetes が使用されます。 1 つのマスター VM と 2 つのワーカー VM (ノードごとに 1 つ) で構成される Kubernetes クラスターは、インフラストラクチャ クラスターの上にデプロイされます。

Kubernetes クラスターではアプリケーションのオーケストレーションが可能ですが、インフラストラクチャ クラスターは永続的なストレージを提供します。

サポートされているネットワーク トポロジ

ユース ケースとワークロードに基づいて、2 つの Azure Stack Edge デバイス ノードを接続する方法を選択できます。 ネットワーク トポロジは、Azure Stack Edge Pro GPU デバイスと Azure Stack Edge Pro 2 デバイスのどちらを使用しているかによって異なります。

概要として、デバイスの種類ごとにサポートされているネットワーク トポロジについて、以下のように説明します。

Azure Stack Edge Pro GPU デバイスのノード上では、次のようになります。

- ポート 2 は、管理トラフィックに使用されます。

- ポート 3 とポート 4 は、ストレージとクラスターのトラフィックに使用されます。 このトラフィックには、ストレージのミラーリングに必要なトラフィックと、クラスターをオンラインにするために必要な Azure Stack Edge クラスターのハートビート トラフィックが含まれます。

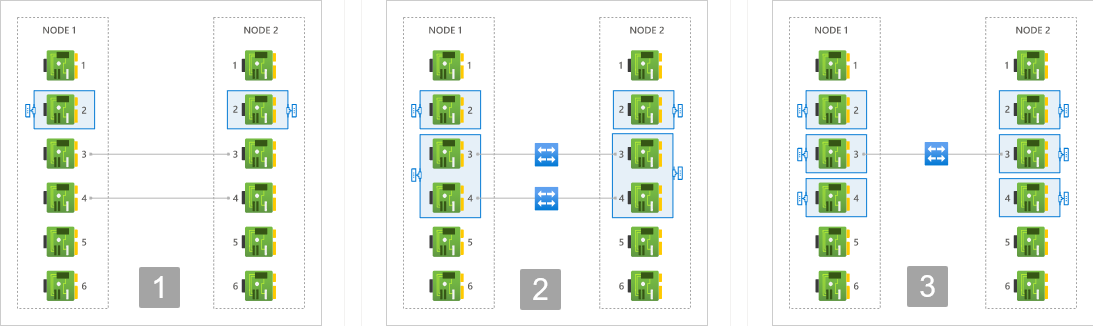

次のネットワーク トポロジを使用できます。

オプション 1 - スイッチレス - このオプションは、ストレージとクラスターのトラフィックに対して環境内で使用できる高速スイッチがない場合に使用します。

このオプションでは、ポート 3 とポート 4 はスイッチなしで背中合わせで接続されます。 これらのポートは、ストレージと Azure Stack Edge クラスターのトラフィック専用であり、ワークロードのトラフィックには使用できません。 必要に応じて、これらのポートの IP アドレスを指定することもできます。

オプション 2 - スイッチと NIC チーミングの使用 - このオプションは、ストレージとクラスターのトラフィックに対してデバイス ノードで使用できる高速スイッチがある場合に使用します。

デバイスの 2 つのノードのポート 3 とポート 4 は、それぞれ外部スイッチを介して接続されます。 ポート 3 とポート 4 は各ノードでチーミングされ、1 つの仮想スイッチと 2 つの仮想 NIC が作成されて、ストレージとクラスターのトラフィックに対するポート レベルの冗長性が実現されます。 これらのポートは、ワークロードのトラフィックにも使用できます。

オプション 3 - NIC チーミングなしでのスイッチの使用 - このオプションは、ストレージとクラスターのトラフィックに対してワークロードのトラフィックとポート レベルの冗長性に追加の専用ポートが必要な場合に使用します。

各ノードのポート 3 は、外部スイッチを介して接続されます。 ポート 3 で障害が発生した場合、クラスターがオフラインになることがあります。 個別の仮想スイッチが、ポート 3 とポート 4 に作成されます。

詳細については、デバイス ノードのネットワーク トポロジの選択に関する記事を参照してください。

クラスター デプロイ

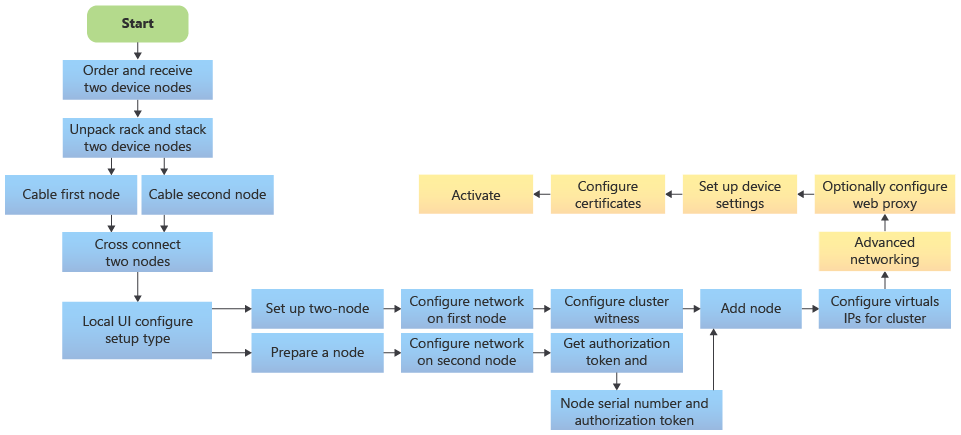

デバイスでクラスタリングを構成する前に、構成するサポートされているネットワーク トポロジの 1 つでデバイスをケーブル接続する必要があります。 Azure Stack Edge デバイスに 2 ノードのインフラストラクチャ クラスターをデプロイするには、次の大まかな手順に従います。

- 2 つの独立した Azure Stack Edge デバイスを注文します。 詳細については、Azure Stack Edge デバイスの注文に関する記事を参照してください。

- 1 ノードのデバイスの場合と同様に、各ノードを個別にケーブル接続します。 デプロイするワークロードに基づいて、スイッチを使用して (または使用せずに) これらのデバイスのネットワーク インターフェイスをケーブルでクロス接続します。 詳細な手順については、2 ノード クラスターのデバイスのケーブル接続に関するページを参照してください。

- 最初のノードでクラスターの作成を開始します。 2 つのノード間のケーブル接続に準拠するネットワーク トポロジを選択します。 選択したトポロジによって、ノード間のストレージとクラスタリングのトラフィックが制御されます。 詳細な手順については、デバイスでのネットワークと Web プロキシの構成に関する記事を参照してください。

- 2 番目のノードを準備します。 2 番目のノードのネットワークは、最初のノードの構成と同じ方法で構成します。 ポート設定が各アプライアンス上の同じポート名間で一致していることを確認します。 このノードで認証トークンを取得します。

- 準備されたノードからの認証トークンを使用し、このノードを最初のノードに参加させてクラスターを形成します。

- SMB ファイル共有で、Azure Storage アカウントまたはローカル監視を使用して、クラウド監視を設定します。

- Azure Consistent Services のエンドポイント、または NFS を使用する場合のエンドポイントを提供する仮想 IP を割り当てます。

- ネットワーク インターフェイスで作成された仮想スイッチに、コンピューティングまたは管理の意図を割り当てます。 コンピューティングに対して有効にされているネットワーク インターフェイスに対して、Kubernetes のノード IP とサービス IP をここで構成することもできます。

- 必要に応じて、Web プロキシの構成、デバイス設定の構成、証明書の構成、最後にデバイスのアクティブ化を行います。

詳細については、2 ノード デバイスのデプロイに関するチュートリアルをデプロイ構成チェックリストの取得に関する記事から開始して参照してください。

ワークロードのクラスタリング

2 ノード クラスターでは、コンテナー化されていないワークロードまたはコンテナー化されたワークロードをデプロイできます。

VM などのコンテナー化されていないワークロード: 2 ノード クラスターにより、デバイスのクラスターにデプロイされた仮想マシンの高可用性が確保されます。 VM のライブ マイグレーションはサポートされていません。

Kubernetes や IoT Edge などのコンテナー化されたワークロード: デバイスのクラスターの上にデプロイされた Kubernetes クラスターは、1 つの Kubernetes マスター VM と 2 つの Kubernetes ワーカー VM で構成されます。 各 Kubernetes ノードには、各 Azure Stack Edge ノードに固定されたワーカー VM があります。 フェールオーバーにより、Kubernetes マスター VM のフェールオーバー (必要な場合) と、残りのワーカー VM 上のポッドの Kubernetes ベースの再調整が行われます。

詳細については、クラスター化された Azure Stack Edge デバイス上の Kubernetes に関するページ参照してください。

クラスターの管理

Azure Stack Edge クラスターは、デバイスの PowerShell インターフェイスまたはローカル UI を使用して管理できます。 一般的な管理タスクは次のとおりです。

クラスターの更新

2 ノードのクラスター化されたデバイスのアップグレードでは、まずデバイスの更新プログラムが適用され、その後に Kubernetes クラスターの更新プログラムが適用されます。 デバイスのノードにローリング アップデートすると、ワークロードのダウンタイムを最小限に抑えることができます。

Azure portal を使用してこれらの更新プログラムを適用する場合は、1 つのノードでプロセスを開始するだけで、両方のノードが更新されます。 詳細な手順については、2 ノードの Azure Stack Edge デバイスへの更新プログラムの適用に関する記事を参照してください。

請求

Azure Stack Edge の 2 ノード クラスターをデプロイする場合は、各ノードに対して個別に請求されます。 詳細については、「Azure Stack Edge の価格」のページを参照してください。

次のステップ

- Azure Stack Edge のクラスター監視について学習します。

- Azure Stack Edge での Kubernetes を参照してください

- クラスターのフェールオーバーのシナリオを理解します