Azure Data Factory を使用して Microsoft 365 (Office 365) からデータを読み込む

適用対象: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

ヒント

企業向けのオールインワン分析ソリューション、Microsoft Fabric の Data Factory をお試しください。 Microsoft Fabric は、データ移動からデータ サイエンス、リアルタイム分析、ビジネス インテリジェンス、レポートまで、あらゆるものをカバーしています。 無料で新しい試用版を開始する方法について説明します。

この記事では、Data Factory を使用して Microsoft 365 (Office 365) から Azure BLOB ストレージにデータを読み込む 方法を示します。 同様の手順に従って Azure Data Lake Gen1 または Gen2 にデータをコピーすることもできます。 Microsoft 365 (Office 365) からデータをコピーするための一般的な方法については、Microsoft 365 (Office 365) コネクタに関する記事を参照してください。

Data Factory の作成

データ ファクトリをまだ作成していない場合は、「クイック スタート: Azure portal と Azure Data Factory Studio を使用してデータ ファクトリを作成する」の手順に従って作成してください。 作成した後、Azure portal 内のデータ ファクトリに移動します。

![[Open Azure Data Factory Studio] タイルを含む、Azure Data Factory のホーム ページ。](../reusable-content/ce-skilling/azure/media/data-factory/data-factory-home-page.png)

[Open Azure Data Factory Studio](Azure Data Factory Studio を開く) タイルで [開く] を選択して、別のタブでデータ統合アプリケーションを起動します。

パイプラインを作成する

ホーム ページで [調整] を選択します。

パイプラインの [全般] タブで、パイプラインの名前として「CopyPipeline」と入力します。

[アクティビティ] ツール ボックスの >[移動と変換] カテゴリ>で、ツール ボックスからパイプライン デザイナー画面に Copy アクティビティをドラッグ アンド ドロップします。 アクティビティ名として "CopyFromOffice365ToBlob" を指定します。

注意

ソースとシンクの両方のリンクされたサービスで Azure 統合ランタイムを使用してください。 セルフホステッド統合ランタイムとマネージド仮想ネットワーク統合ランタイムはサポートされていません。

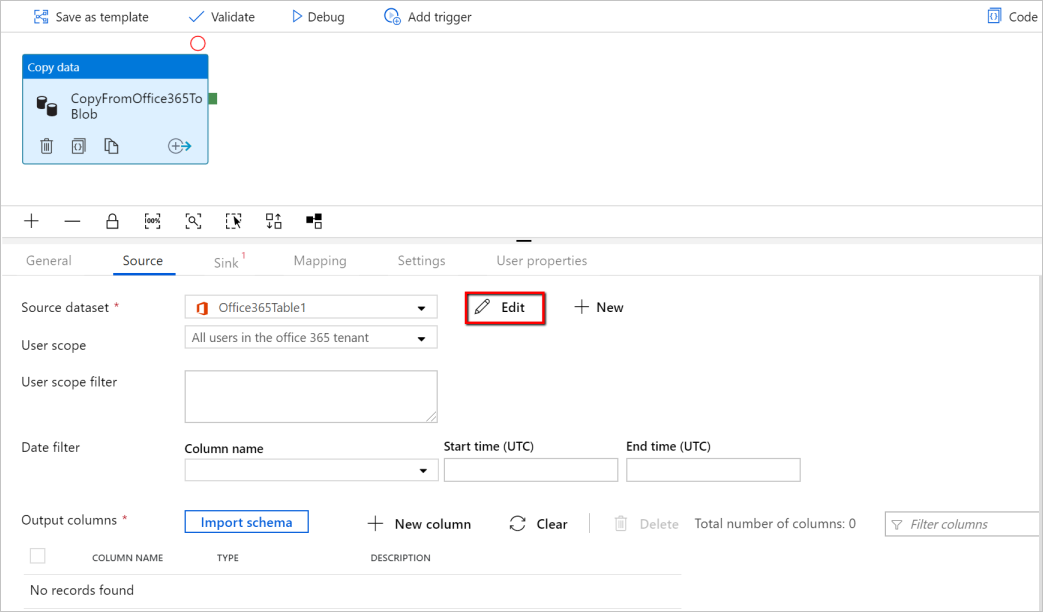

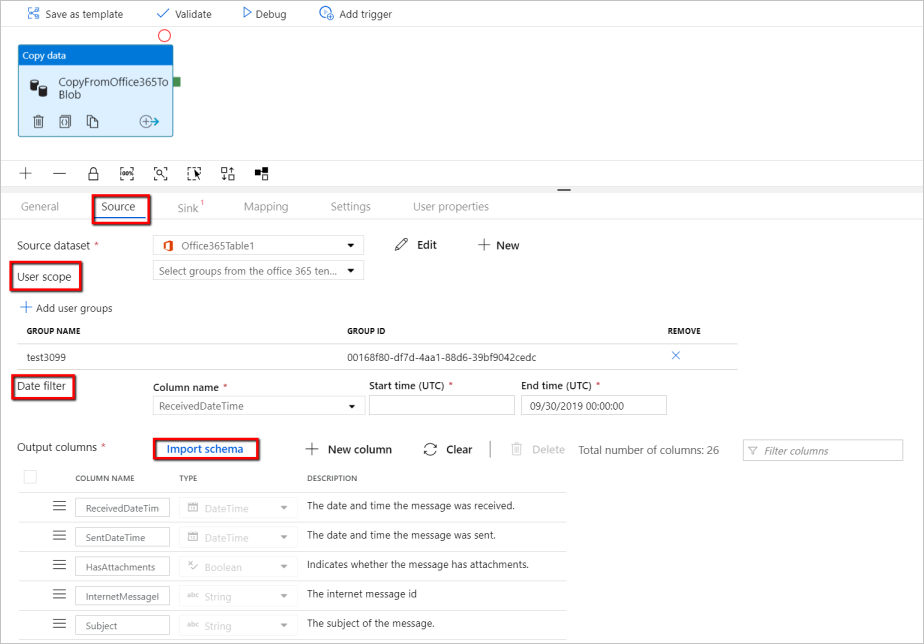

ソースの構成

パイプライン >[ソース] タブに移動し、[+ 新規] を選択してソース データセットを作成します。

[新しいデータセット] ウィンドウ内で [Microsoft 365] (Office 365) を選択し、[続行] を選択します。

コピー アクティビティの構成のタブが表示されます。Microsoft 365 (Office 365) データセットの横にある [編集] ボタンを選択して、データの構成を続行します。

Microsoft 365 (Office 365) データセット用の新しいタブが開きます。 プロパティ ウィンドウの下部にある [全般] タブで、[名前] に「SourceOffice365Dataset」と入力します。

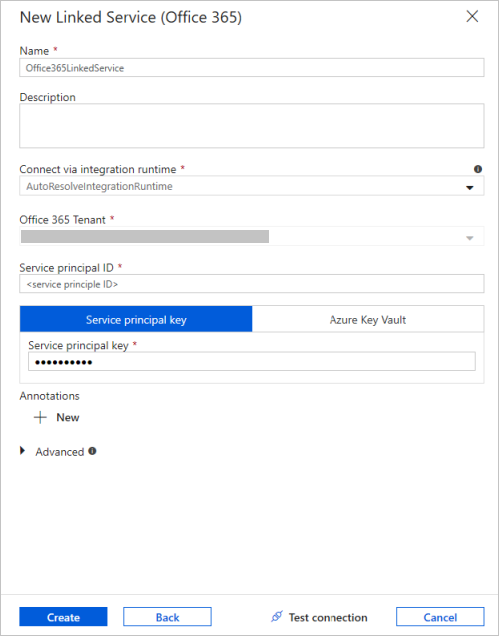

プロパティ ウィンドウの [接続] タブに移動します。 [リンクされたサービス] ボックスの横にある [+ 新規] を選択します。

[New Linked Service]\(新しいリンクされたサービス) ウィンドウで、名前として「Office365LinkedService」と入力し、サービス プリンシパル ID とサービス プリンシパル キーを入力したら、接続をテストし、 [作成] を選択して、リンクされたサービスをデプロイします。

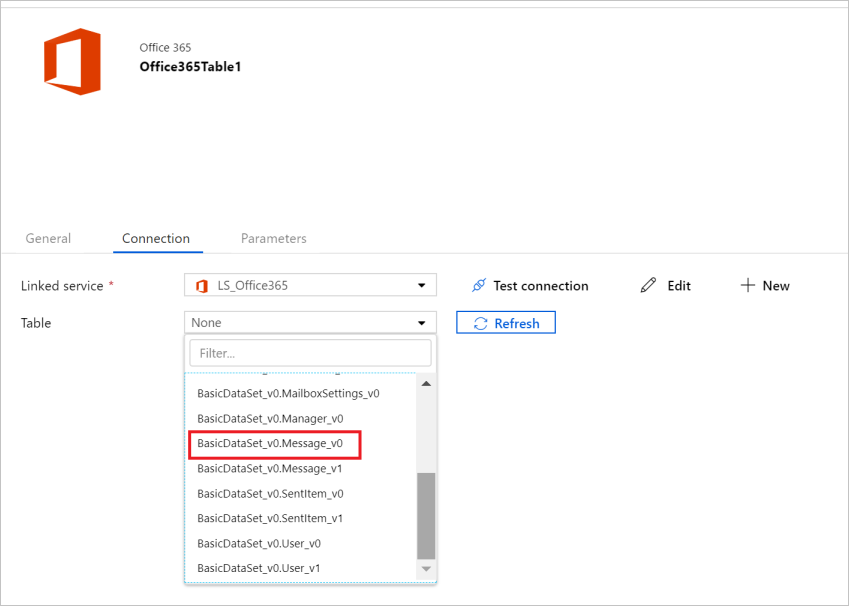

リンクされたサービスが作成されると、データセットの設定に戻ります。 [テーブル] の横にある下向き矢印を選択し、使用可能な Microsoft 365 (Office 365) データセットの一覧を展開して、ドロップダウン リストから "BasicDataSet_v0.Message_v0" を選択します。

次に、[パイプライン]>[ソース] タブに戻り、Microsoft 365 (Office 365) のデータ抽出のために引き続き追加プロパティを構成します。 ユーザー スコープとユーザースコープ フィルターは、Microsoft 365 (Office 365) から抽出するデータを制限するために定義できる省略可能な述語です。 これらの設定を構成する方法については、Microsoft 365 (Office 365) のデータセットのプロパティに関するセクションを参照してください。

日付フィルターの 1 つを選択し、開始時刻と終了時刻の値を指定する必要があります。

[インポート スキーマ] タブを選択して、メッセージ データセットのスキーマをインポートします。

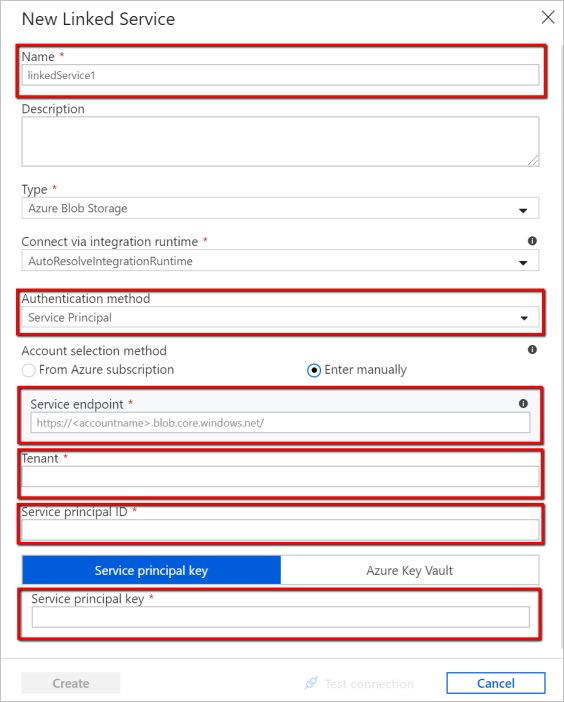

シンクの構成

パイプライン >[シンク] タブに移動し、[+ 新規] を選んでシンク データセットを作成します。

[新しいデータセット] ウィンドウでは、Microsoft 365 (Office 365) からコピーするときに、サポートされているコピー先のみが選択されていることに注意してください。 [Azure Blob Storage] を選択し、[バイナリ形式] を選択して、 [続行] を選択します。 このチュートリアルでは、Microsoft 365 (Office 365) のデータを Azure Blob Storage にコピーします。

Azure Blob Storage データセットの横にある [編集] ボタンを選択して、データの構成を続行します。

プロパティ ウィンドウの [General](一般) タブの [名前] に「OutputBlobDataset」と入力します。

プロパティ ウィンドウの [接続] タブに移動します。 [リンクされたサービス] ボックスの横にある [+ 新規] を選択します。

[New Linked Service]\(新しいリンクされたサービス) ウィンドウで、名前として「AzureStorageLinkedService」と入力し、認証方法のドロップダウン リストから [サービス プリンシパル] を選択します。サービス エンドポイント、テナント、サービス プリンシパル ID、およびサービス プリンシパル キーを入力したら、[保存] を選択し、リンクされたサービスをデプロイします。 Azure Blob Storage のサービス プリンシパルの認証を設定する方法については、ここを参照してください。

パイプラインを検証する

パイプラインを検証するには、ツール バーから [検証] を選択します。

右上隅にある [コード] をクリックすると、パイプラインに関連付けられている JSON コードを参照することもできます。

パイプラインを発行する

上部ツールバーの [すべて発行] を選択します。 これにより、作成したエンティティ (データセットとパイプライン) が Data Factory に発行されます。

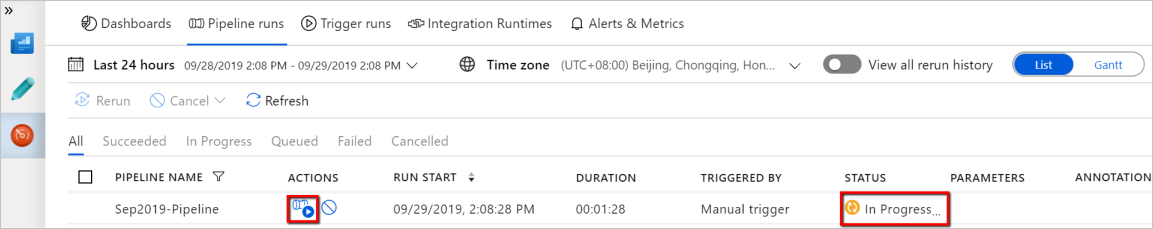

パイプラインを手動でトリガーする

ツール バーの [トリガーの追加] を選択し、 [Trigger Now](今すぐトリガー) を選択します。 [Pipeline Run](パイプラインの実行) ページで [完了] を選択します。

パイプラインの監視

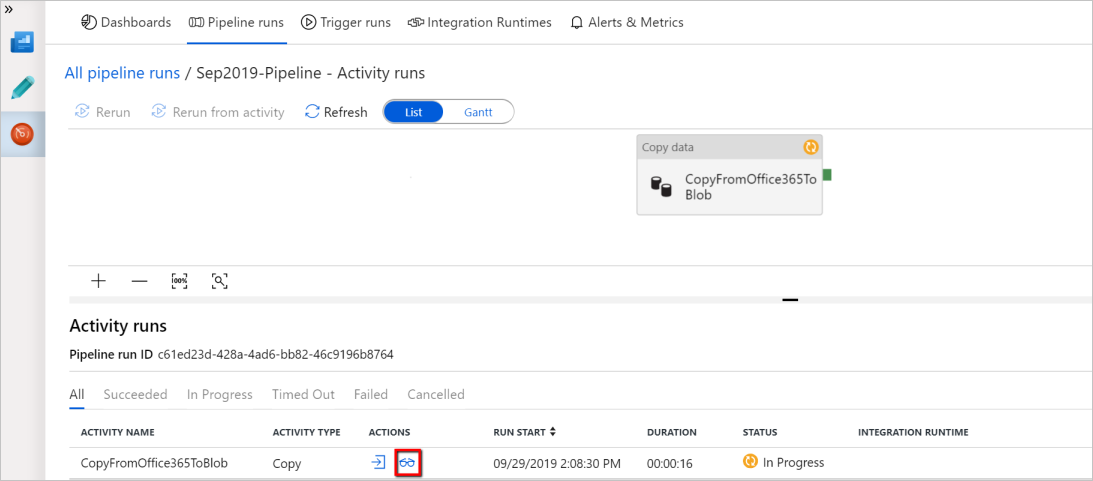

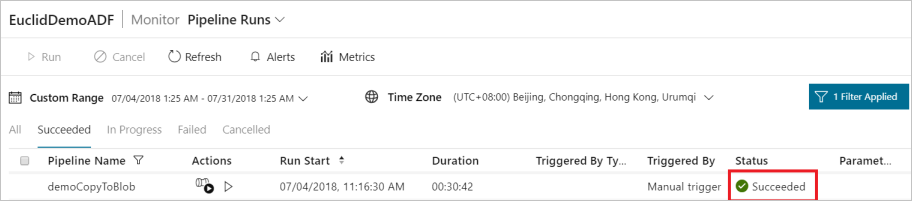

左側の [監視] タブに移動します。 手動トリガーによってトリガーされたパイプラインの実行が表示されます。 [アクション] 列のリンクを使用して、アクティビティの詳細を表示したりパイプラインを再実行したりできます。

パイプラインの実行に関連付けられているアクティビティの実行を表示するには、[アクション] 列の [View Activity Runs](アクティビティの実行の表示) リンクを選択します。 この例では、アクティビティが 1 つだけなので、一覧に表示されるエントリは 1 つのみです。 コピー操作の詳細を確認するには、[アクション] 列の [詳細] リンク (眼鏡アイコン) を選択します。

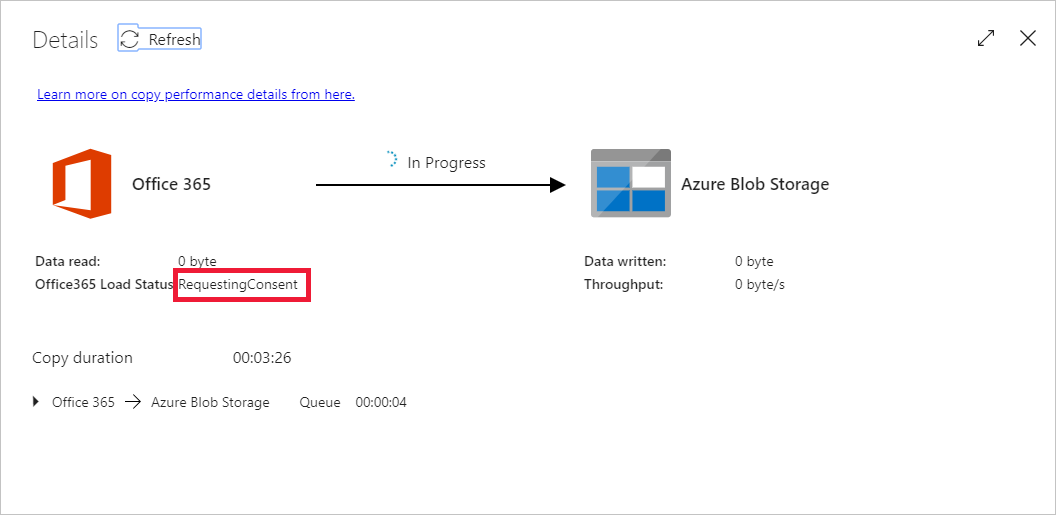

このコンテキスト (アクセス先のデータ テーブル、データを読み込む先のアカウント、データ アクセス要求を行っているユーザー ID の組み合わせ) に対して初めてデータを要求する場合、Copy アクティビティの状態は [進行中] と表示され、[アクション] の下にある [詳細] リンクを選んだときにのみ、[RequestingConsent] という状態が表示されます。 データの抽出を進めるには、データ アクセス承認者グループのメンバーが、Privileged Access Management で要求を承認する必要があります。

同意を要求しているときの状態:

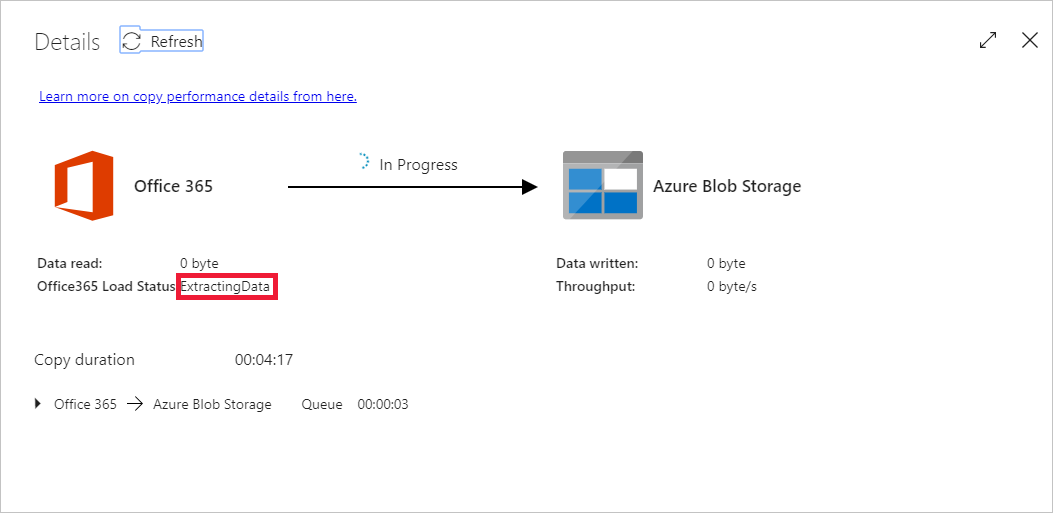

データを抽出しているときの状態:

同意が得られると、データの抽出が続行されて、しばらくするとパイプラインの実行が正常終了として表示されます。

抽出先の Azure Blob Storage に移動して、Microsoft 365 (Office 365) データがバイナリ形式で抽出されていることを確認します。

関連するコンテンツ

次の資料に進んで、Azure Synapse Analytics のサポートを確認します。