データをコピーし動的パラメーターで1時間ごとに変換する

適用対象:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

ヒント

企業向けのオールインワン分析ソリューション、Microsoft Fabric の Data Factory をお試しください。 Microsoft Fabric は、データ移動からデータ サイエンス、リアルタイム分析、ビジネス インテリジェンス、レポートまで、あらゆるものをカバーしています。 無料で新しい試用版を開始する方法について説明します。

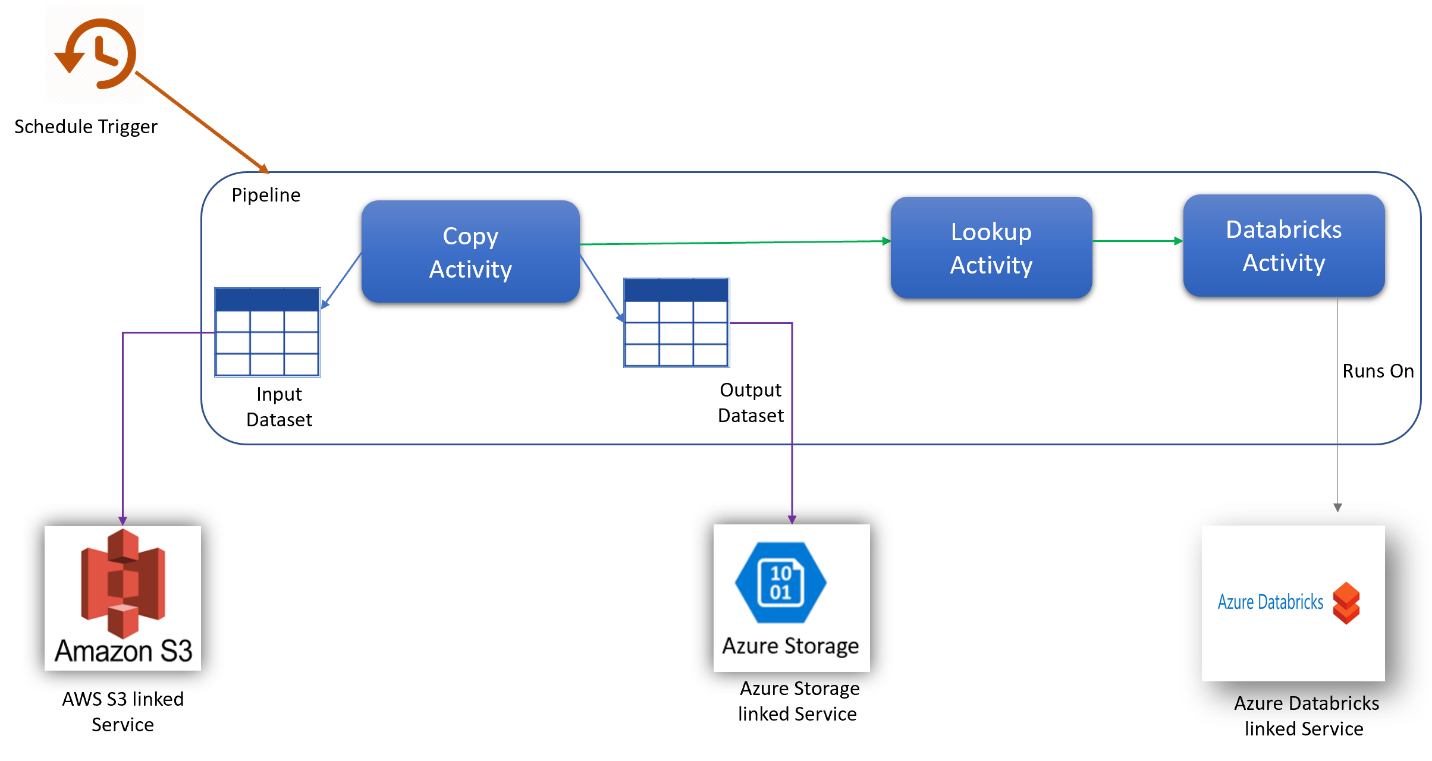

このシナリオでは、30 日間にわたり毎日 8 時間、1 時間ごとのスケジュールで AWS S3 から Azure BLOB ストレージにデータをコピーし、Azure Databricks (スクリプト内に動的パラメーターを含む) を使用して変換します。

以下の例で使用されている価格は架空なものであり、実際の価格を暗に示すものではありません。 読み取り/書き込みおよび監視のコストは、通常はごくわずかであり、全体的なコストに大きな影響を与えないため、表示されません。 アクティビティの実行も、料金計算ツールの見積もりで最も近い 1,000 に丸められます。

より具体的なシナリオが必要な場合や、将来、サービスを使用する際のコストを見積もる場合は、Azure 料金計算ツールを参照してください。

構成

シナリオを実現させるには、次の項目を含むパイプラインを作成する必要があります:

- AWS S3からコピーされるデータの入力データセット、Azure Storageのデータの出力データセットを含む1つのコピーアクティビティです。

- 変換スクリプトにパラメーターを動的に渡すための1つの検索アクティビティ。

- データ変換のための1つの Azure Databricks アクティビティ。

- 1 日あたり 8 時間、1 時間ごとにパイプラインを実行するための 1 つのスケジュール トリガー。 パイプラインを実行する場合は、すぐにトリガーするか、スケジュールを設定することができます。 パイプライン自体に加え、各トリガー インスタンスは 1 つのアクティビティの実行としてカウントされます。

コスト見積もり

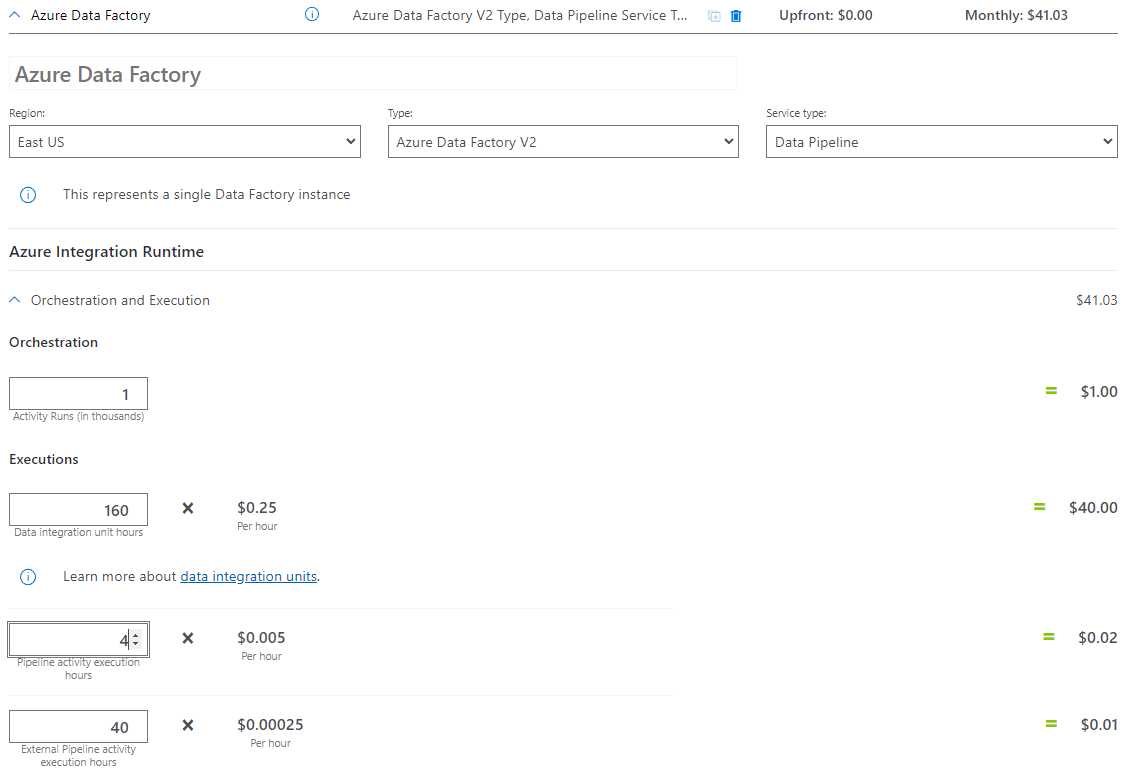

| 操作 | タイプとユニット |

|---|---|

| パイプラインを実行する | 実行ごとに 4 つのアクティビティ実行 (トリガー実行に 1 つ、アクティビティ実行に 3 つ) = 960 のアクティビティ実行。計算ツールでは 1000 の増分しか許可されないため、切り上げられます。 |

| データのコピーの前提条件: 実行ごとの DIU 時間 = 10 分 | 10 分 \ 60 分 * 4 つの Azure Integration Runtime (既定の DIU 設定 = 4) データ統合ユニットとコピー パフォーマンスの最適化の詳細については、この記事を参照してください。 |

| ルックアップ アクティビティの実行の前提条件: 実行ごとのパイプライン アクティビティの時間 = 1 分 | 1 分 / 60 分のパイプライン アクティビティの実行 |

| Databricks アクティビティの実行の前提条件: 実行ごとの外部実行時間 = 10 分 | 10 分 / 60 分の外部パイプライン アクティビティの実行 |

価格の例: 料金計算ツールの例

30 日間のシナリオの合計価格: 41.03 ドル

関連するコンテンツ

- 価格の例: 30 日間、AWS S3 から Azure Blob Storage に 1 時間ごとにデータをコピーする

- 価格の例: 30 日間、Azure Databricks を使用して 1 時間ごとにデータをコピーして変換する

- 価格の例: Azure-SSIS 統合ランタイムで SSIS パッケージを実行する

- 価格の例: 通常の平日にマッピング データ フロー デバッグを使用する

- 価格の例: マッピング データ フローを使用して BLOB ストア内のデータを変換する

- 価格の例: Azure Data Factory マネージド VNET でのデータ統合

- 価格の例: マッピング データ フローで SAP CDC を介して SAP ECC から差分データを取得する