Introduzione alle interazioni istintive

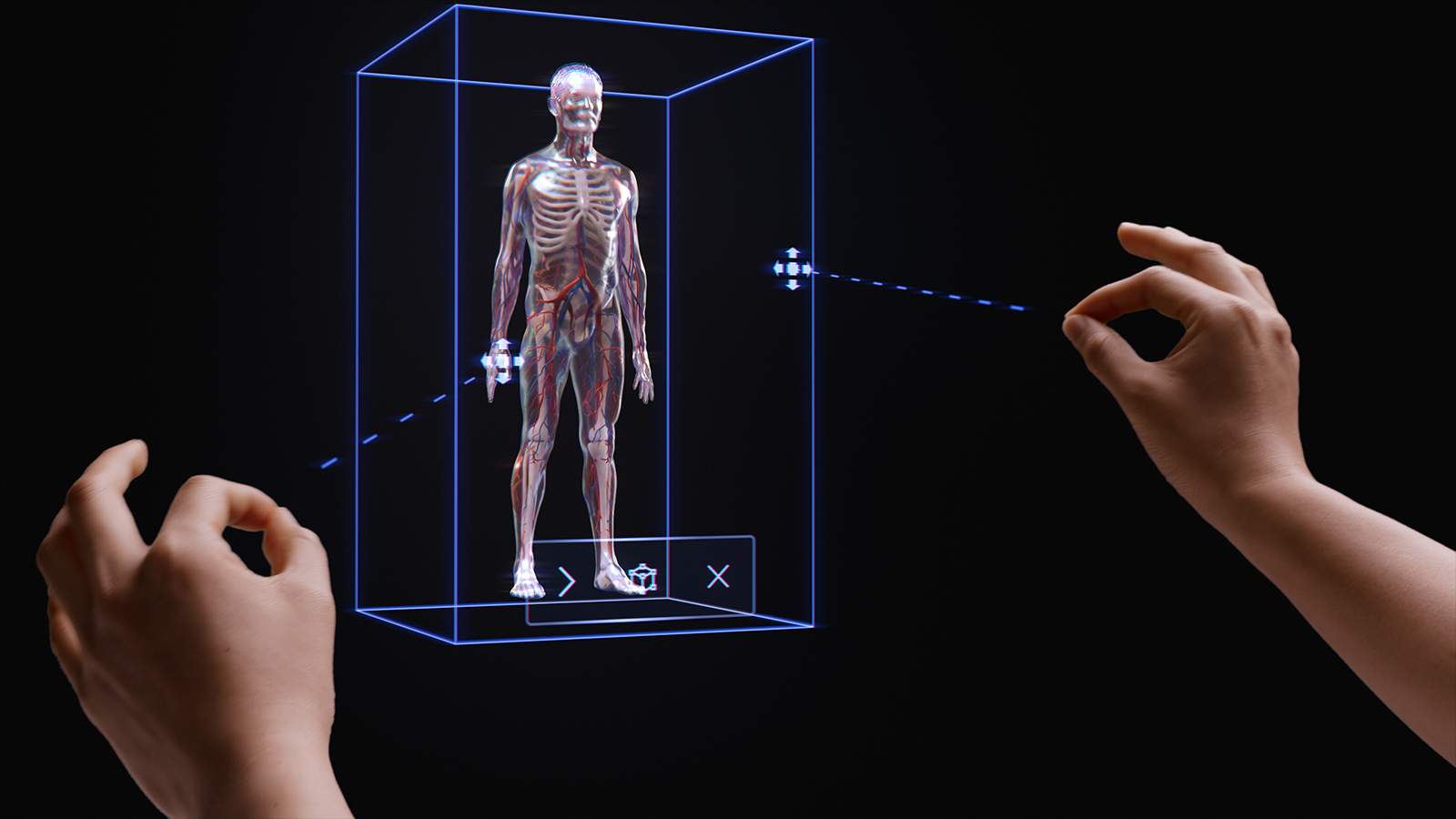

La filosofia delle interazioni semplici e istintive è intrecciata in tutta la piattaforma di realtà mista (MR). Sono stati eseguiti tre passaggi per garantire che gli sviluppatori e i progettisti di applicazioni possano offrire ai clienti interazioni semplici e intuitive.

In primo luogo, abbiamo fatto in modo che i sensori e le tecnologie di input si combinano in modelli di interazione multimodale. Questi modelli di interazione includono il tracciamento della mano e degli occhi insieme all'input del linguaggio naturale. Sulla base della nostra ricerca, la progettazione e lo sviluppo all'interno di un framework multimodale (e non basato su singoli input) è la chiave per creare esperienze istintive.

In secondo luogo, si riconosce che molti sviluppatori sono destinati a più dispositivi HoloLens, ad esempio HoloLens 2 e HoloLens (prima generazione) o HoloLens e VR. Sono stati quindi progettati modelli di interazione che funzionano tra i dispositivi, anche se la tecnologia di input varia in ogni dispositivo. Ad esempio, l'interazione di gran lunga su un visore VR immersivo di Windows con un controller 6DoF e HoloLens 2 entrambi usano inviti e modelli identici. Ciò semplifica lo sviluppo di applicazioni tra dispositivi e offre un'atmosfera naturale alle interazioni degli utenti.

Anche se sappiamo che in MR sono possibili migliaia di interazioni efficaci, coinvolgenti e magiche, abbiamo scoperto che l'uso intenzionale di un singolo modello di interazione in un'applicazione è il modo migliore per garantire che gli utenti abbiano successo e abbiano un'esperienza ottimale. A tale scopo, sono stati inclusi tre elementi in questa guida all'interazione:

- Indicazioni specifiche sui tre modelli di interazione principali e sui componenti e i modelli necessari per ognuno di essi.

- Indicazioni supplementari su altri vantaggi offerti dalla piattaforma.

- Linee guida generali che consentono di selezionare il modello di interazione appropriato per lo scenario di sviluppo.

Demo di base per il rilevamento delle mani e le interazioni istintive

Vedere la demo video Progettazione di ologrammi - Rilevamento della testa e tracciamento oculare di seguito, quindi passare ad argomenti più specifici:

Questo video è stato tratto dall'app "Progettazione di ologrammi" HoloLens 2. Scarica e goditi l'esperienza completa qui.

Modelli di interazione multimodale

Sulla base della ricerca e del feedback dei clienti, abbiamo scoperto che tre modelli di interazione principali si adattano alla maggior parte delle esperienze di realtà mista. In molti modi, il modello di interazione è il modello mentale dell'utente per come completare un flusso di lavoro. Ognuno di questi modelli di interazione è ottimizzato per un set di esigenze dei clienti ed è pratico, potente e utilizzabile se usato correttamente.

Il grafico seguente è una panoramica semplificata. Le informazioni dettagliate sull'uso di ogni modello di interazione sono collegate nelle pagine seguenti con immagini ed esempi di codice.

| Modello | Scenari di esempio | Adatto | Hardware |

| Mani e controller di movimento | Esperienze spaziali 3D, ad esempio layout e progettazione spaziale, manipolazione del contenuto o simulazione. | Ideale per i nuovi utenti abbinati a voce, tracciamento oculare o sguardo fisso. Curva di apprendimento bassa. Esperienza utente coerente tra il rilevamento della mano e i controller 6DoF. | HoloLens 2 Visori vr immersive |

| Vivavoce | Esperienze contestuali in cui le mani di un utente sono occupate, ad esempio l'apprendimento e la manutenzione sul lavoro. | È necessario un certo livello di apprendimento. Se le mani non sono disponibili, il dispositivo si associa bene con la voce e il linguaggio naturale. | HoloLens 2 HoloLens (prima generazione) Visori vr immersive |

| Sguardo fisso e commit | Esperienze click-through, ad esempio presentazioni 3D, demo. | Richiede il training sugli HMD, ma non sui dispositivi mobili. Ideale per i controller accessibili. Ideale per HoloLens (prima generazione). | HoloLens 2 HoloLens (prima generazione) Visori vr immersive Mobile AR |

Per evitare lacune nell'esperienza di interazione dell'utente, è consigliabile seguire le indicazioni per un singolo modello dall'inizio alla fine.

Le sezioni seguenti illustrano i passaggi per la selezione e l'implementazione di uno di questi modelli di interazione.

Alla fine di questa pagina, si comprenderanno le linee guida su:

- Scelta di un modello di interazione per il cliente

- Implementazione del modello di interazione

- Transizione tra modelli di interazione

- Progettare i passaggi successivi

Scegliere un modello di interazione per il cliente

In genere, sviluppatori e creatori hanno pensato ai tipi di interazioni che i clienti possono avere. Per incoraggiare un approccio alla progettazione incentrato sul cliente, è consigliabile seguire le indicazioni seguenti per selezionare il modello di interazione ottimizzato per il cliente.

Perché seguire queste indicazioni?

- I modelli di interazione vengono testati per individuare criteri oggettivi e soggettivi, inclusi lo sforzo fisico e cognitivo, l'intuitività e l'apprendibilità.

- Poiché le interazioni sono diverse, gli inviti visivi/audio e il comportamento degli oggetti potrebbero differire tra i modelli di interazione.

- La combinazione di parti di più modelli di interazione crea il rischio di inviti concorrenti, ad esempio raggi della mano simultanei e un cursore head-gaze. Ciò può sovraccaricare e confondere gli utenti.

Ecco alcuni esempi di come gli inviti e i comportamenti sono ottimizzati per ogni modello di interazione. Spesso i nuovi utenti hanno domande simili, ad esempio "come faccio a sapere che il sistema funziona","come faccio a sapere cosa posso fare" e "come faccio a sapere se ha capito quello che ho appena fatto?"

| Modello | Ricerca per categorie so che funziona? | Ricerca per categorie sapere cosa posso fare? | Ricerca per categorie sapere cosa ho appena fatto? |

| Mani e controller di movimento | Vedo una rete a mano, un'offerta con la punta delle dita o raggi mano/controller. | Vedo punti di manipolazione afferrabili o viene visualizzato un rettangolo di selezione quando la mano è vicina a un oggetto. | Sento toni udibili e vedo animazioni afferra e rilascia. |

| Sguardo e commit della testa | Viene visualizzato un cursore al centro del campo visivo. | Il cursore cambia stato quando si tratta di determinati oggetti. | Quando si esegue un'azione, si vedono/si sentono conferme visive e udibili. |

| Mani libere (sguardo e attesa) | Viene visualizzato un cursore al centro del campo visivo. | Quando mi sofferma su un oggetto interattivo, viene visualizzato un indicatore di stato. | Quando si esegue un'azione, si vedono/si sentono conferme visive e udibili. |

| Mani libere (comando vocale) | Vedo un indicatore di ascolto e didascalie che mostrano ciò che il sistema ha sentito. | Mi vengono richieste vocali e suggerimenti. Quando dico: "Cosa posso dire?" Viene visualizzato un feedback. | Quando si esegue un comando o si ottiene un'esperienza utente di disambiguazione quando necessario, vengono visualizzate/sentite conferme visive e udibili. |

Di seguito sono riportate le domande che sono state trovate per aiutare i team a selezionare un modello di interazione:

D: Gli utenti vogliono toccare gli ologrammi ed eseguire manipolazioni olografiche di precisione?

R: In tal caso, vedere il modello di interazione mani e controller di movimento per la selezione e la manipolazione della precisione.D: Gli utenti devono mantenere le mani libere per le attività reali?

R: In tal caso, esaminare il modello di interazione hands-free, che offre un'esperienza vivavoce tramite interazioni basate su sguardo fisso e voce.D: Gli utenti hanno il tempo di apprendere le interazioni per l'applicazione MR o hanno bisogno delle interazioni con la curva di apprendimento più bassa possibile?

R: Per la curva di apprendimento più bassa e le interazioni più intuitive, è consigliabile usare il modello Mani e controller di movimento, purché gli utenti possano usare le mani per l'interazione.D: Gli utenti usano i controller di movimento per puntare e modificare?

R: Il modello Mani e controller di movimento include tutte le indicazioni per un'esperienza ottimale con i controller di movimento.D: Gli utenti usano un controller di accessibilità o un controller Bluetooth comune, ad esempio un clicker?

R: È consigliabile usare il modello Head-gaze and commit per tutti i controller non monitorati. È progettato per consentire a un utente di attraversare un'intera esperienza con un semplice meccanismo di "destinazione e commit".D: Gli utenti passano solo attraverso un'esperienza facendo clic (ad esempio in un ambiente simile a una presentazione 3D), invece di esplorare layout densi di controlli dell'interfaccia utente?

R: Se gli utenti non hanno bisogno di controllare un sacco di interfaccia utente, head-gaze and commit offre un'opzione di apprendimento in cui gli utenti non devono preoccuparsi di targeting.D: Gli utenti usano sia HoloLens (prima generazione) che HoloLens 2/Windows Mixed Reality visori vr immersive (VR)?

R: Poiché lo sguardo visivo e il commit sono il modello di interazione per HoloLens (prima generazione), è consigliabile che gli autori che supportano HoloLens (prima generazione) useranno Lo sguardo fisso e il commit per tutte le funzionalità o le modalità che gli utenti potranno sperimentare in un auricolare HoloLens (prima generazione). Vedere la sezione successiva sui modelli di interazione di transizione per informazioni dettagliate su come creare un'esperienza ottimale per più generazioni di HoloLens.D: Che dire degli utenti che sono mobili, che coprono uno spazio grande o si spostano tra gli spazi, rispetto agli utenti che tendono a lavorare in un singolo spazio?

R: Tutti i modelli di interazione funzioneranno per questi utenti.

Nota

Altre indicazioni specifiche per la progettazione delle app saranno presto disponibili.

Transizione di modelli di interazione

Esistono anche casi d'uso che potrebbero richiedere l'uso di più modelli di interazione. Ad esempio, il flusso di creazione dell'applicazione usa il modello di interazione "mani e controller di movimento", ma si vuole usare una modalità vivavoce per i tecnici sul campo. Se l'esperienza richiede più modelli di interazione, gli utenti potrebbero avere difficoltà a passare da un modello a un altro, soprattutto quando non hanno familiarità con la realtà mista.

Nota

Stiamo lavorando costantemente su altre linee guida che saranno disponibili per sviluppatori e progettisti, informandoli su come, quando e perché usare più modelli di interazione mr.