Supporto nativo della qualità dei dati per il formato Iceberg (anteprima)

Il supporto nativo di Microsoft Purview per il formato di tabella aperta apache iceberg è disponibile in anteprima pubblica. I clienti Microsoft Purview che usano Microsoft Azure Data Lake Storage (ADLS) Gen2, Microsoft Fabric Lakehouse, Amazon Web Services (AWS) S3 e Google Cloud Platform (GCP) Google Cloud Storage (GCS) possono ora usare Microsoft Purview per gestire, gestire ed eseguire il controllo dell'integrità dei dati e la valutazione della qualità dei dati sugli asset di dati Iceberg.

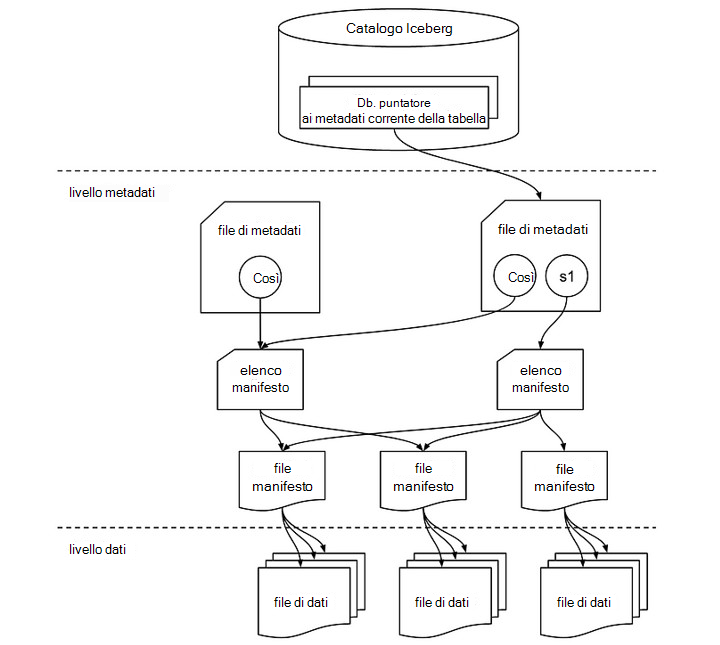

Struttura del file Iceberg

Una tabella Iceberg è più di una semplice raccolta di file di dati. Include vari file di metadati che tengono traccia dello stato della tabella e facilitano operazioni come letture, scritture ed evoluzione dello schema. Di seguito è riportata un'esplorazione dei componenti critici coinvolti in una tabella Iceberg. I file di dati in una tabella Iceberg vengono in genere archiviati in formati columnar come Apache Parquet, Apache Avro o Apache Optimized Row Columnar (ORC). Questi file contengono i dati effettivi con cui gli utenti interagiscono durante le query.

Catalogo Iceberg

Nella parte superiore è presente il catalogo Iceberg, che archivia il puntatore ai metadati corrente per ogni tabella. Questo catalogo consente di tenere traccia dello stato più recente di una tabella facendo riferimento al file di metadati corrente.

Livello metadati

Il livello dei metadati è fondamentale per la funzionalità di Iceberg ed è costituito da diversi elementi chiave:

- File di metadati: Questo file contiene informazioni sullo schema, il partizionamento e gli snapshot della tabella. Nel diagramma s0 fa riferimento a uno snapshot, che è essenzialmente un record dello stato della tabella in un determinato momento. Se sono presenti più snapshot, ad esempio s0 e s1, il file di metadati tiene traccia di entrambi.

- Elenco manifesto: Questo elenco punta a uno o più file manifesto. Un elenco di manifesti funge da contenitore di riferimenti a questi manifesti e consente a Iceberg di gestire in modo efficiente i file di dati da leggere o scrivere durante operazioni diverse. Ogni snapshot potrebbe avere un proprio elenco di manifesti.

Livello dati

Nel livello dati, i file manifesto fungono da intermediario tra i metadati e i file di dati effettivi. Ogni file manifesto punta a una raccolta di file di dati, fornendo una mappa dei file fisici archiviati nel data lake.

- File manifesto: questi file archivia i metadati per un gruppo di file di dati, inclusi i conteggi delle righe, le informazioni sulla partizione e i percorsi dei file. Consentono a Iceberg di eliminare e accedere rapidamente a file specifici, consentendo query efficienti.

- File di dati: i dati effettivi si trovano in questi file, che potrebbero essere in formati come Parquet, ORC o Avro. Iceberg organizza i file di dati in base alle partizioni, consentendo ottimizzazioni delle prestazioni durante l'esecuzione delle query riducendo al minimo le analisi dei dati non necessarie.

Come funziona insieme

Quando viene eseguita un'operazione come una query o un aggiornamento, Iceberg cerca innanzitutto il file di metadati della tabella tramite il catalogo. Il file di metadati fa riferimento allo snapshot corrente (o a più snapshot), che punta quindi all'elenco dei manifesti. L'elenco di manifesti contiene riferimenti ai file manifesto, che a loro volta elencano i singoli file di dati. Questa struttura gerarchica consente a Iceberg di gestire in modo efficiente set di dati di grandi dimensioni garantendo al tempo stesso la coerenza transazionale, consentendo funzionalità come il viaggio nel tempo e l'evoluzione dello schema.

Questa progettazione a più livelli migliora le prestazioni e la scalabilità delle operazioni batch e di streaming, poiché si accede solo ai file di dati necessari e gli aggiornamenti vengono gestiti tramite snapshot senza influire sull'intero set di dati.

Dati iceberg in OneLake

È possibile utilizzare facilmente i dati in formato Iceberg in Microsoft Fabric senza spostamento o duplicazione dei dati. È possibile usare i tasti di scelta rapida di OneLake per puntare direttamente a un livello dati.

I dati iceberg vengono archiviati in OneLake, scritti usando Snowflake o un altro writer Iceberg. OneLake virtualizza la tabella come tabella Delta Lake, garantendo un'ampia compatibilità tra i motori di Fabric. Ad esempio, è possibile creare un volume in Snowflake e puntarlo direttamente a Fabric Lakehouse. Dopo aver creato la tabella in Fabric OneLake, la sincronizzazione automatica garantisce che gli aggiornamenti dei dati vengano riflessi in tempo reale. Questo processo semplificato semplifica l'uso dei dati Iceberg in Microsoft Fabric. Per altre informazioni, vedere la documentazione di Snowflake.

Importante

Anche i dati Iceberg in AWS S3 e GCS devono essere sincronizzati automaticamente come delta per gestire, gestire e misurare e monitorare la qualità dei dati.

Qualità dei dati per i dati Iceberg

Per tutti gli utenti che idratano in modo nativo i dati in Iceberg in (Parquet, ORC, Avro) in ADLS Gen2 o Fabric Lakehouse devono semplicemente confidere un'analisi che punta alla posizione della directory che ospita i dati e i metadati directory Iceberg. Seguire i passaggi elencati di seguito:

Configurare ed eseguire un'analisi in Microsoft Purview Data Map.

Configurare il dir (hosting di dati e metadati) come asset di dati e associarlo al prodotto dati. Questo costituisce il set di dati Iceberg. Associare asset di dati Iceberg a un prodotto dati in Microsoft Purview Unified Catalog. Informazioni su come associare asset di dati a un prodotto dati.

In Unified Catalog, in Gestione integrità selezionare Data quality view per trovare i file Iceberg (asset di dati) e per configurare la connessione all'origine dati.

3.1 Per configurare la connessione AdlsG2, seguire i passaggi descritti nel documento sulla connessione DQ

3.2 Per configurare la connessione OneLake di Fabric, seguire i passaggi descritti nel documento DQ sull'infrastruttura di data estate.

Applicare regole di qualità dei dati ed eseguire analisi della qualità dei dati per l'assegnazione dei punteggi di qualità dei dati a livello di colonna e di tabella.

Nella pagina Schema del file Iceberg selezionato (asset di dati) selezionare Importa schema per importare lo schema dall'origine dati del file Iceberg.

Prima di eseguire il processo di profilatura o il processo di analisi della qualità dei dati, passare alla pagina Panoramica del file Iceberg e selezionare Iceberg dal menu a discesa Asset dati.

Profilatura e analisi della qualità dei dati

Dopo aver completato la configurazione della connessione e la selezione del formato del file di asset di dati, è possibile profilare, creare e applicare regole ed eseguire un'analisi della qualità dei dati nei file di formato aperto Iceberg. Seguire le linee guida dettagliate descritte nei documenti seguenti:

- Come configurare ed eseguire la profilatura dei dati dei dati

- Come configurare ed eseguire l'analisi della qualità dei dati

Importante

- Il supporto per il formato aperto Iceberg nelle funzionalità di individuazione, cura, profilatura dei dati e analisi della qualità dei dati è ora disponibile in anteprima.

- Per la profilatura dei dati e la valutazione della qualità dei dati, è necessario recuperare e impostare lo schema dalla pagina Schema qualità dati.

- Esperienza di individuazione consumer: i consumer non visualizzeranno lo schema nella visualizzazione asset di dati perché la mappa dati non supporta ancora il formato di tabella aperta Iceberg. L'amministratore di Data Quality sarà in grado di importare lo schema dalla pagina Dello schema Data Quality.

Limitazioni

La versione corrente supporta i dati creati in formato Iceberg solo con il catalogo Apache Hadoop .

Percorso Lakehouse e percorso ADLS Gen2

- I metadati iceberg archivia il percorso completo per i dati e i metadati. Assicurarsi di usare il percorso completo per ADLS Gen2 e Microsoft Fabric Lakehouse. Inoltre, per il percorso di Microsoft Fabric Lakehouse durante la scrittura, assicurarsi di operare (WRITES, UPSERTS) con i percorsi ID.

abfss://c4dd39bb-77e2-43d3-af10-712845dc2179@onelake.dfs.fabric.microsoft.com/5e8ea953-56fc-49c1-bc8c-0b3498cf1a9c/Files/CustomerData. - File system come ID e Lakehouse come ID. I percorsi assoluti e non relativi sono necessari per l'esecuzione di DQ in Iceberg da parte di Microsoft Purview. Per convalidare, assicurarsi di controllare il percorso degli snapshot in modo che punti come percorsi completi del nome completo (FQN).

Rilevamento dello schema

- Mappa dati ha una limitazione sull'impossibilità di rilevare lo schema Iceberg. Quando si curano le directory iceberg in Fabric Lakehouse o ADLS Gen2, non sarà possibile esaminare lo schema. Tuttavia, lo schema di recupero DQ è in grado di eseguire il pull dello schema per l'asset curato.

Consigli

- Se si usa SNOWFLAKE Catalog for Iceberg Format, con l'archiviazione VOLUME come ADLS Gen2, AWS S3 o GCP GCS, usare il collegamento a OneLake Table di Microsoft Fabric ed eseguire DQ come tabella DELTA. FYI: supporta solo Iceberg con formato di file Parquet.

- Se si usa ADLS per Il formato Iceberg con il catalogo Hadoop, analizzare direttamente la directory, usare il motore DQ come impostazione predefinita per Formato Iceberg per DQ. FYI: supporta Iceberg con formato di file Parquet, ORC, Avro.

- Se si usa il formato Snowflake per Iceberg, è possibile puntare l'archiviazione VOLUME direttamente al percorso di Microsoft Fabric Lakehouse e usare OneLake Table per creare una versione compatibile con Delta per DQ. FYI: supporta solo Iceberg con formato di file Parquet.

- Se si usa Microsoft Fabric Lakehouse per il formato Iceberg con il catalogo Hadoop, analizzare direttamente la directory lakehouse, usare il motore DQ come impostazione predefinita per Il formato Iceberg per DQ. FYI: supporta Iceberg con formato di file Parquet, ORC, Avro.