Instradare i flussi di dati in base al contenuto nei flussi di eventi di Fabric

Questo articolo illustra come indirizzare gli eventi in base al contenuto nei flussi di eventi di Microsoft Fabric.

È ora possibile usare l'editor no-code nell'area di disegno principale dei flussi di eventi di Fabric per creare una logica di elaborazione di flussi complessa senza scrivere codice. Questa funzionalità consente di personalizzare, trasformare e gestire più facilmente i flussi di dati. Dopo aver impostato le operazioni di elaborazione del flusso, è possibile inviare senza problemi i flussi di dati a destinazioni diverse in base allo schema e ai dati di flusso specifici.

Operazioni supportate

Ecco l'elenco delle operazioni supportate per l'elaborazione dei dati in tempo reale:

Aggregazione: supporta le funzioni SUM, AVG, MIN e MAX che eseguono calcoli su una colonna di valori, restituendo un singolo risultato.

Espandere: Espandi un valore matrice per creare una nuova riga per ogni valore all'interno di una matrice.

Filtro: selezionare o filtrare righe specifiche dal flusso di dati in base a una condizione.

Raggruppa per: aggrega tutti i dati dell'evento in un determinato intervallo di tempo, con l'opzione per raggruppare una o più colonne.

Gestisci campi: aggiungere, rimuovere o modificare il tipo di dati di un campo o di una colonna dei flussi di dati.

Unione: connettere due o più flussi di dati con campi condivisi con lo stesso nome e tipo di dati in un flusso di dati. I campi che non corrispondono vengono eliminati.

Combina: si tratta di una trasformazione per combinare i dati di due flussi in base a una condizione di corrispondenza tra di essi.

Destinazioni supportate

Le destinazioni supportate sono:

Lakehouse: questa destinazione offre la possibilità di trasformare gli eventi in tempo reale prima di inserirli nel lakehouse. Gli eventi in tempo reale vengono convertiti in formato Delta Lake e archiviati nelle tabelle lakehouse designate. Questa destinazione supporta scenari di archiviazione dati.

Eventhouse: questa destinazione consente di inserire i dati degli eventi in tempo reale in Eventhouse, in cui è possibile usare il potente linguaggio di query Kusto (KQL) per eseguire query e analizzare i dati. Con i dati in Eventhouse, è possibile ottenere informazioni più approfondite sui dati degli eventi e creare report e dashboard avanzati.

Activator dell'infrastruttura: questa destinazione consente di connettere direttamente i dati degli eventi in tempo reale a un attivatore dell'infrastruttura. Activator è un tipo di agente intelligente che contiene tutte le informazioni necessarie per connettersi ai dati, monitorare le condizioni e agire. Quando i dati raggiungono determinate soglie o corrispondono ad altri modelli, Activator esegue automaticamente azioni appropriate, ad esempio l'invio di avvisi agli utenti o l'avvio dei flussi di lavoro di Power Automate.

Endpoint personalizzato (conosciuta precedentemente come custom app):Con questa destinazione, è possibile indirizzare facilmente gli eventi in tempo reale a un endpoint personalizzato. Questa destinazione consente di connettere le proprie applicazioni al flusso di eventi e di utilizzare i dati dell'evento in tempo reale. È utile quando si vogliono far uscire dati in tempo reale verso un sistema esterno al di fuori di Microsoft Fabric.

Stream: questa destinazione rappresenta il flusso di eventi non elaborato predefinito trasformato da una serie di operazioni, detto anche flusso derivato. Dopo la creazione, è possibile visualizzare il flusso dall'hub in tempo reale.

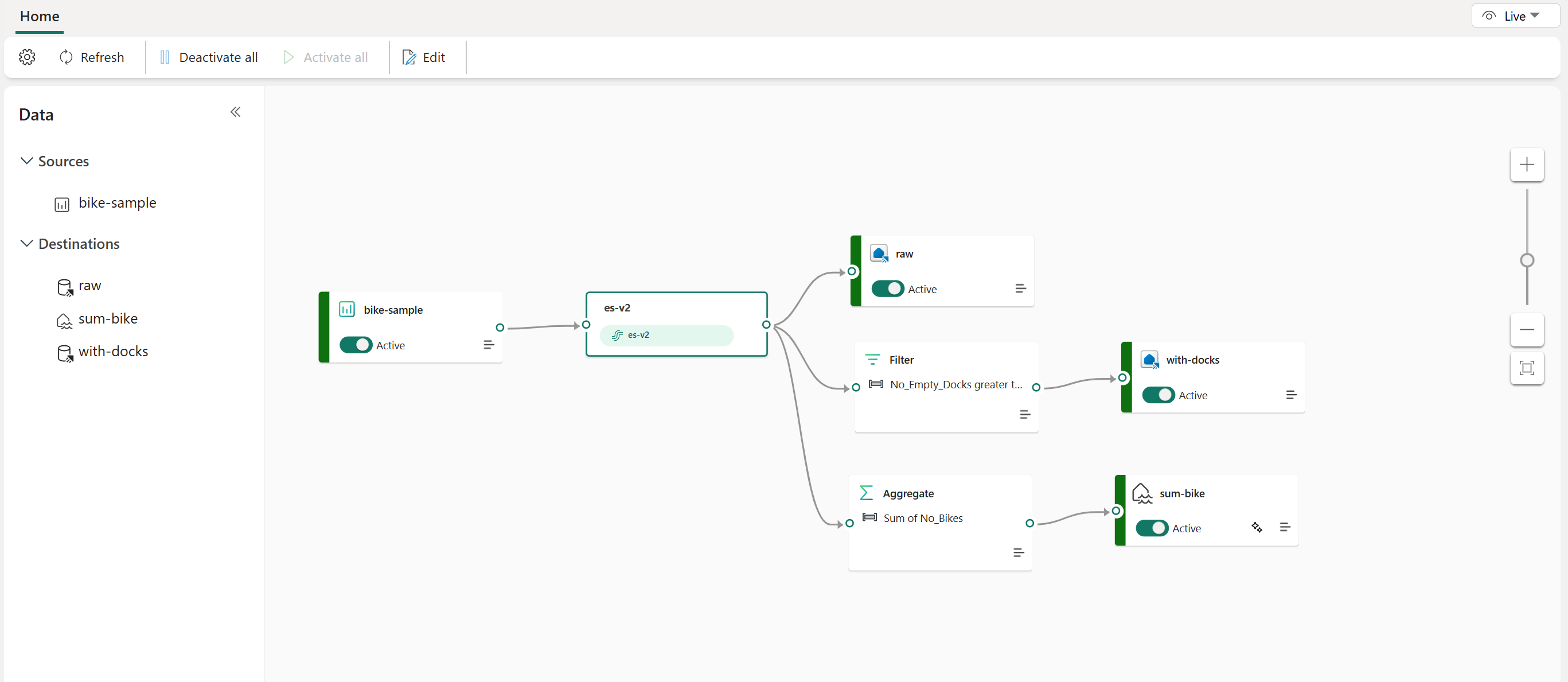

L'esempio seguente mostra come tre destinazioni eventstream di Fabric distinte possano gestire funzioni separate per una singola origine del flusso di dati. Un eventhouse è designato per l'archiviazione di dati non elaborati, un secondo eventhouse è per conservare i flussi di dati filtrati e lakehouse viene usato per l'archiviazione di valori aggregati.

Per trasformare e indirizzare il flusso di dati in base al contenuto, seguire la procedura descritta in Modificare e pubblicare un flusso di eventi e iniziare a progettare le logiche di elaborazione dei flussi per il flusso di dati.