Scenario end-to-end di Data Factory: introduzione e architettura

Questa esercitazione consente di accelerare il processo di valutazione per Data Factory in Microsoft Fabric fornendo istruzioni dettagliate per uno scenario di integrazione completa dei dati entro un'ora. Al termine di questa esercitazione si comprende il valore e le funzionalità chiave di Data Factory e si è appreso come completare uno scenario di integrazione dei dati end-to-end comune.

Informazioni generali: perché Data Factory in Microsoft Fabric?

Questa sezione illustra in generale il ruolo di Fabric e il ruolo svolto da Data Factory.

Comprendere il valore di Microsoft Fabric

Microsoft Fabric offre un punto di riferimento unico per tutte le esigenze analitiche per ogni azienda. Include una gamma completa di servizi, tra cui lo spostamento dei dati, il data lake, la progettazione dei dati, l'integrazione dei dati e l'analisi scientifica dei dati, l'analisi in tempo reale e la business intelligence. Con Fabric non è necessario unire servizi diversi da più fornitori. Gli utenti godono invece di un prodotto end-to-end, altamente integrato, singolo e completo, facile da comprendere, caricare, creare e gestire.

Comprendere il valore di Data Factory in Microsoft Fabric

Data Factory in Fabric combina la facilità d'uso di Power Query con la scalabilità e la potenza di Azure Data Factory. Riunisce il meglio di entrambi i prodotti in un'esperienza unificata. L'obiettivo è assicurarsi che Integrazione dei dati in Factory funzioni bene sia per i cittadini sia per gli sviluppatori di dati. Offre esperienze di preparazione e trasformazione dei dati abilitate per l'intelligenza artificiale a basso codice, trasformazione su scala petabyte, centinaia di connettori con connettività ibrida e multicloud. Purview offre governance e le funzionalità del servizio supportano impegni di dati/operazioni su scala aziendale, CI/CD, gestione del ciclo di vita delle applicazioni e monitoraggio.

Introduzione - Comprendere tre funzionalità chiave di Data Factory

- Inserimento dati: l’attività Copy nelle pipeline consente di spostare dati su scala petabyte da centinaia di origini dati in Data Lakehouse per un'ulteriore elaborazione.

- Trasformazione e preparazione dei dati: flusso di dati Gen2 offre un'interfaccia a basso codice per trasformare i dati usando più di 300 trasformazioni di dati, con la possibilità di caricare i risultati trasformati in più destinazioni, ad esempio database SQL di Azure, Lakehouse e altro ancora.

- Automazione del flusso di integrazione end-to-end: le pipeline offrono orchestrazione di attività che includono attività di copia, flusso di dati e notebook e altro ancora. In questo modo è possibile gestire tutte le attività in un'unica posizione. Le attività in una pipeline possono essere concatenate per funzionare in modo sequenziale o indipendentemente in parallelo.

In questo caso d'uso dell'integrazione dei dati end-to-end si apprenderà quanto segue:

- Come inserire dati usando l'assistente copia in una pipeline

- Come trasformare i dati usando un flusso di dati con un'esperienza senza codice o scrivendo codice personalizzato per elaborare i dati con un'attività Script o Notebook

- Come automatizzare l'intero flusso di integrazione dei dati end-to-end usando una pipeline con trigger e attività flessibili del flusso di controllo.

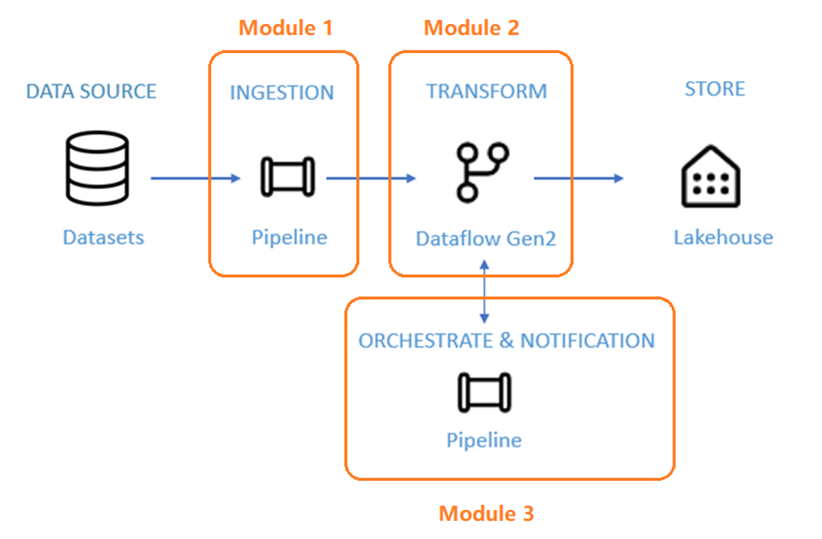

Architettura

Nei prossimi 50 minuti, viene richiesto di completare uno scenario di integrazione dei dati end-to-end. Ciò include l'inserimento di dati non elaborati da un archivio di origine nella tabella Bronze di una Lakehouse, l'elaborazione di tutti i dati, lo spostamento nella tabella Gold di Data Lakehouse, l'invio di un messaggio di posta elettronica per notificare il completamento di tutti i processi e infine la configurazione dell'intero flusso per l'esecuzione in base a una pianificazione.

Lo scenario è suddiviso in tre moduli:

- Modulo 1: Creare una pipeline con Data Factory per inserire dati non elaborati da un archivio BLOB a una tabella Bronze in un data Lakehouse.

- Modulo 2: Trasformare i dati con un flusso di dati in Data Factory per elaborare i dati non elaborati dalla tabella Bronze e spostarli in una tabella Gold in Data Lakehouse.

- Modulo 3: Completare il primo percorso di integrazione dei dati per inviare un messaggio di posta elettronica per inviare una notifica al completamento di tutti i processi e infine configurare l'intero flusso per l'esecuzione in base a una pianificazione.

Usare il set di dati di esempio NYC-Taxi come origine dati per l'esercitazione. Al termine, sarà possibile ottenere informazioni dettagliate sugli sconti giornalieri sulle tariffe dei taxi per un periodo di tempo specifico usando Data Factory in Microsoft Fabric.

Contenuto correlato

In questa introduzione all'esercitazione end-to-end per la prima integrazione dei dati con Data Factory in Microsoft Fabric si è appreso quanto segue:

- Il valore e il ruolo di Microsoft Fabric

- Il valore e il ruolo di Data Factory in Fabric

- Funzionalità chiave di Data Factory

- In questa esercitazione si apprenderà

Continuare con la sezione successiva per creare la pipeline di dati.