Eseguire la migrazione di configurazioni Spark da Azure Synapse Analytics a Fabric

Apache Spark offre numerose configurazioni che possono essere personalizzate per migliorare l'esperienza in vari scenari. In Azure Synapse Spark e Ingegneria dei dati Fabric è possibile incorporare queste configurazioni o proprietà per personalizzare l'esperienza. In Fabric è possibile aggiungere configurazioni di Spark a un ambiente e usare le proprietà di Spark inline direttamente all'interno dei processi Spark. Per spostare le configurazioni del pool di Azure Synapse Spark in Fabric, usare un ambiente.

Per considerazioni sulla configurazione di Spark, vedere le differenze tra Azure Synapse Spark e Fabric.

Prerequisiti

- Se non esiste ancora, creare un'area di lavoro di Fabric nel tenant.

- Se non esiste ancora, creare un ambiente nell'area di lavoro.

Opzione 1: aggiunta di configurazioni Spark a un ambiente personalizzato

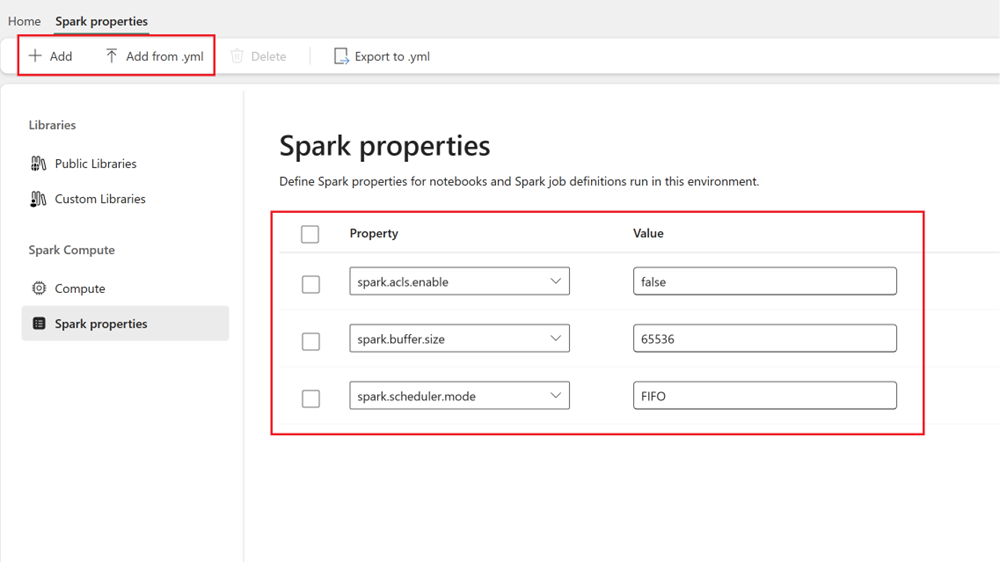

All'interno di un ambiente è possibile impostare le proprietà di Spark e tali configurazioni vengono applicate al pool di ambienti selezionato.

- Aprire Synapse Studio: accedere ad Azure. Passare all'area di lavoro di Azure Synapse e aprire Synapse Studio.

-

Individuare le configurazioni di Spark:

- Passare all'area Gestisci e selezionare i pool di Apache Spark.

- Trovare il pool di Apache Spark, selezionare Configurazione di Apache Spark e individuare il nome della configurazione di Spark per il pool.

- Ottenere le configurazioni di Spark: è possibile ottenere tali proprietà selezionando Visualizza configurazioni o esportando la configurazione (in formato .txt/.conf/.json) da Configurazioni + Librerie>Configurazioni di Apache Spark.

- Dopo aver creato le configurazioni di Spark, aggiungere proprietà di Spark personalizzate all'ambiente in Fabric:

- All’interno dell’ambiente, passare ad Ambiente di calcolo Spark>Proprietà di Spark.

- Aggiungere configurazioni di Spark. È possibile aggiungerle manualmente o importarle da .yml.

- Fare clic su Salva e scegliere Pubblica per le modifiche.

Altre informazioni sull'aggiunta di configurazioni Spark a un ambiente.