Databricks Runtime 7.4 (EoS)

Nota

Il supporto per questa versione di Databricks Runtime è terminato. Per la data di fine del supporto, vedere Cronologia di fine del supporto. Per tutte le versioni supportate di Databricks Runtime, vedere Versioni e compatibilità delle note sulla versione di Databricks Runtime.

Databricks ha rilasciato questa versione a novembre 2020.

Le note sulla versione seguenti forniscono informazioni su Databricks Runtime 7.4, basate su Apache Spark 3.0.

Nuove funzionalità

Contenuto della sezione:

- Funzionalità e miglioramenti di Delta Lake

- Il caricatore automatico supporta ora la delega della configurazione delle risorse di notifica dei file agli amministratori

-

I nuovi

USAGEprivilegi offrono agli amministratori un maggiore controllo sui privilegi di accesso ai dati - DBFS FUSE è ora abilitato per i cluster abilitati per il pass-through

Funzionalità e miglioramenti di Delta Lake

Questa versione offre le funzionalità e i miglioramenti di Delta Lake seguenti:

- La nuova API consente a Delta Lake di verificare che i dati aggiunti a una tabella soddisfino i vincoli

- La nuova API consente di eseguire il rollback di una tabella Delta a una versione precedente della tabella

- La nuova versione iniziale consente di restituire solo le modifiche più recenti in un'origine di streaming Delta Lake

-

Maggiore stabilità di

OPTIMIZE

La nuova API consente a Delta Lake di verificare che i dati aggiunti a una tabella soddisfino i vincoli

Delta Lake supporta CHECK ora i vincoli. Se specificato, Delta Lake verifica automaticamente che i dati aggiunti a una tabella soddisfino l'espressione specificata.

Per aggiungere CHECK vincoli, usare il ALTER TABLE ADD CONSTRAINTS comando . Per informazioni dettagliate, vedere Vincoli in Azure Databricks.

La nuova API consente di eseguire il rollback di una tabella Delta a una versione precedente della tabella

È ora possibile eseguire il rollback delle tabelle Delta alle versioni precedenti usando il RESTORE comando :

SQL

RESTORE <table> TO VERSION AS OF n;

RESTORE <table> TO TIMESTAMP AS OF 'yyyy-MM-dd HH:mm:ss';

Python

from delta.tables import DeltaTable

DeltaTable.forName(spark, "table_name").restoreToVersion(n)

DeltaTable.forName(spark, "table_name").restoreToTimestamp('yyyy-MM-dd')

Scala

import io.delta.tables.DeltaTable

DeltaTable.forName(spark, "table_name").restoreToVersion(n)

DeltaTable.forName(spark, "table_name").restoreToTimestamp("yyyy-MM-dd")

RESTORE crea un nuovo commit che esegue il rollback di tutte le modifiche apportate alla tabella perché la versione da ripristinare. Tutti i dati e i metadati esistenti vengono ripristinati, inclusi lo schema, i vincoli, gli ID delle transazioni di streaming, COPY INTO i metadati e la versione del protocollo di tabella. Per informazioni dettagliate, vedere Ripristinare una tabella Delta.

La nuova versione iniziale consente di restituire solo le modifiche più recenti in un'origine di streaming Delta Lake

Per restituire solo le modifiche più recenti, specificare startingVersion come latest. Per informazioni dettagliate, vedere Specificare la posizione iniziale.

Maggiore stabilità di OPTIMIZE

OPTIMIZE (senza predicati di partizione) può essere ridimensionato per l'esecuzione su tabelle con decine di milioni di file di piccole dimensioni. In precedenza il driver Apache Spark poteva esaurire la memoria e OPTIMIZE non sarebbe stato completato.

OPTIMIZE ora gestisce tabelle molto grandi con decine di milioni di file.

Il caricatore automatico supporta ora la delega della configurazione delle risorse di notifica dei file agli amministratori

Una nuova API Scala consente agli amministratori di configurare le risorse di notifica dei file per il caricatore automatico. I data engineer possono ora gestire i flussi del caricatore automatico con un minor numero di autorizzazioni delegando la configurazione iniziale delle risorse agli amministratori. Vedere Configurare o gestire manualmente le risorse di notifica dei file.

I nuovi USAGE privilegi offrono agli amministratori un maggiore controllo sui privilegi di accesso ai dati

Per eseguire un'azione su un oggetto in un database, è ora necessario concedere il USAGE privilegio a tale database oltre ai privilegi necessari per eseguire l'azione. Il USAGE privilegio viene concesso per un database o un catalogo. Con l'introduzione del privilegio, un proprietario della USAGE tabella non può più decidere unilateralmente di condividerlo con un altro utente. L'utente deve inoltre disporre del USAGE privilegio per il database contenente la tabella.

Nelle aree di lavoro in cui è abilitato il controllo di accesso alle tabelle, il users gruppo ha automaticamente il USAGE privilegio per la radice CATALOG.

Per informazioni dettagliate, vedere Privilegi DI UTILIZZO.

DBFS FUSE è ora abilitato per i cluster abilitati per il pass-through

È ora possibile leggere e scrivere da DBFS usando il montaggio FUSE in /dbfs/ quando si usa un cluster a concorrenza elevata abilitato per il pass-through delle credenziali. Sono supportati i montaggi regolari. I montaggi che richiedono credenziali pass-through non sono supportati.

Miglioramenti

Spark SQL supporta IFF e CHARINDEX come sinonimi per IF e POSITION

In Databricks Runtime IF() è un sinonimo di CASE WHEN <cond> THEN <expr1> ELSE <expr2> END

Databricks Runtime ora supporta IFF() come sinonimo di IF()

SELECT IFF(c1 = 1, 'Hello', 'World'), c1 FROM (VALUES (1), (2)) AS T(c1)

=> (Hello, 1)

(World, 2)

CHARINDEX è un nome alternativo per la POSITION funzione.

CHARINDEX trova la posizione della prima occorrenza di una stringa all'interno di un'altra stringa con un indice iniziale facoltativo.

VALUES(CHARINDEX('he', 'hello from hell', 2))

=> 12

Più output per cella abilitati per i notebook Python per impostazione predefinita

Databricks Runtime 7.1 ha introdotto il supporto per più output per cella nei notebook Python (e %python celle all'interno di notebook non Python), ma è stato necessario abilitare la funzionalità per il notebook. Questa funzionalità è abilitata per impostazione predefinita in Databricks Runtime 7.4. Vedere Visualizzare più output per cella.

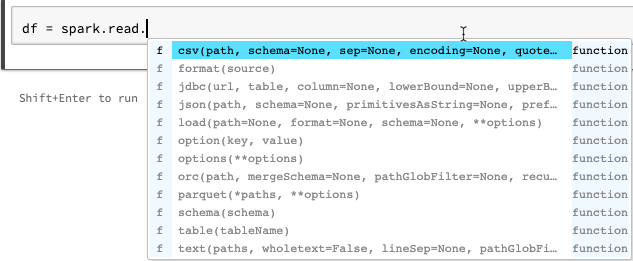

Miglioramenti del completamento automatico per i notebook Python

Il completamento automatico per Python mostra informazioni aggiuntive sul tipo generate dall'analisi statica del codice usando la libreria Jedi. È possibile premere TAB per visualizzare un elenco di opzioni.

Miglioramento display dei vettori di Spark ML nell'anteprima del dataframe Spark

Il display formato mostra ora le etichette per il tipo di vettore (sparse o dense), la lunghezza, gli indici (per i vettori di tipo sparse) e i valori.

Altre correzioni

- È stato risolto un problema di selezione con

collections.namedtuplenei notebook. - È stato risolto un problema di selezione con classi e metodi definiti in modo interattivo.

- Correzione di un bug che causava l'esito negativo delle chiamate

mlflow.start_run()al pass-through o ai cluster abilitati per il controllo di accesso alle tabelle.

Aggiornamenti della libreria

- Librerie Python aggiornate:

- Jedi aggiornato dalla versione 0.14.1 alla versione 0.17.2.

- koala aggiornati dalla versione 1.2.0 alla 1.3.0.

- parso aggiornato dalla versione 0.5.2 alla versione 0.7.0.

- Aggiornamento di diverse librerie R installate. Vedere Librerie R installate.

Apache Spark

Databricks Runtime 7.4 include Apache Spark 3.0.1. Questa versione include tutte le correzioni e i miglioramenti di Spark inclusi in Databricks Runtime 7.3 LTS (EoS), nonché le correzioni di bug e i miglioramenti aggiuntivi seguenti apportati a Spark:

- [SPARK-33170] [SQL] Aggiungere la configurazione SQL per controllare il comportamento di errore rapido in FileFormatWriter

- [SPARK-33136] [SQL] Correzione errata del parametro scambiato in V2WriteCommand.outputResolved

- [SPARK-33134] [SQL] Restituire risultati parziali solo per gli oggetti JSON radice

- [SPARK-33038] [SQL] Combina i piani iniziali e correnti di AQE...

- [SPARK-33118] [SQL] CREATE TEMPORARY TABLE non riesce a causa della posizione

- [SPARK-33101] [ML] Rendere il formato LibSVM propagare la configurazione hadoop dalle opzioni DS al file system HDFS sottostante

- [SPARK-33035] [SQL] Aggiorna le voci obsolete del mapping degli attributi in QueryPlan#transformUpWithNewOutput

- [SPARK-33091] [SQL] Evitare di usare map anziché foreach per evitare potenziali effetti collaterali nei chiamanti di OrcUtils.readCatalystSchema

- [SPARK-33073] [PYTHON] Migliorare la gestione degli errori in Pandas a errori di conversione arrow

- [SPARK-33043] [ML] Gestire spark.driver.maxResultSize=0 nel calcolo euristico RowMatrix

- [SPARK-29358] [SQL] Impostare unionByName facoltativamente per riempire le colonne mancanti con valori Null

- [SPARK-32996] [WEB-UI] Gestire executorMetrics vuoto in ExecutorMetricsJsonSerializer

- [SPARK-32585] [SQL] Supportare l'enumerazione scala in ScalaReflection

- [SPARK-33019] [CORE] Usare spark.hadoop.mapreduce.fileoutputcommitter.algorithm.version=1 per impostazione predefinita

- [SPARK-33018] [SQL] Correzione del problema relativo alle statistiche di stima se figlio ha 0 byte

- [SPARK-32901] [CORE] Non allocare memoria durante lo spilling di UnsafeExternalSorter

- [SPARK-33015] [SQL] Usare millisToDays() nella regola ComputeCurrentTime

- [SPARK-33015] [SQL] Calcolare la data corrente una sola volta

- [SPARK-32999] [SQL] Usare Utils.getSimpleName per evitare di raggiungere il nome della classe non valido in TreeNode

- [SPARK-32659] [SQL] Broadcast Array invece di Set in InSubqueryExec

- [SPARK-32718] [SQL] Rimuovere parole chiave non necessarie per le unità di intervallo

- [SPARK-32886] [WEBUI] Correzione del collegamento 'undefined' nella visualizzazione sequenza temporale eventi

- [SPARK-32898] [CORE] Correggere un executorRunTime errato quando l'attività viene terminata prima dell'avvio reale

- [SPARK-32635] [SQL] Aggiungere un nuovo test case nel modulo catalyst

- [SPARK-32930] [CORE] Sostituire i metodi isFile/isDirectory deprecati

- [SPARK-32906] [SQL] I nomi dei campi dello struct non devono cambiare dopo la normalizzazione dei valori float

- [SPARK-24994] [SQL] Aggiungere UnwrapCastInBinaryComparison Optimizer per semplificare il valore letterale integrale

- [SPARK-32635] [SQL] Correzione della propagazione piegabile

-

[SPARK-32738] [CORE] Ridurre il numero di thread attivi se si verifica un errore irreversibile

Inbox.process - [SPARK-32900] [CORE] Consenti a UnsafeExternalSorter di eseguire lo spill quando sono presenti valori Null

- [SPARK-32897] [PYTHON] Non visualizzare un avviso di deprecazione in SparkSession.builder.getOrCreate

- [SPARK-32715] [CORE] Correzione della perdita di memoria quando non è stato possibile archiviare parti di trasmissione

- [SPARK-32715] [CORE] Correzione della perdita di memoria quando non è stato possibile archiviare parti di trasmissione

- [SPARK-32872] [CORE] Impedire a BytesToBytesMap in MAX_CAPACITY di superare la soglia di crescita

- [SPARK-32876] [SQL] Modificare le versioni di fallback predefinite in 3.0.1 e 2.4.7 in HiveExternalCatalogVersionsSuite

- [SPARK-32840] [SQL] Il valore di intervallo non valido può essere semplicemente adesivo con l'unità

- [SPARK-32819] [SQL] Il parametro ignoreNullability deve essere efficace in modo ricorsivo

- [SPARK-32832] [SS] Usare CaseInsensitiveMap per le opzioni DataStreamReader/Writer

- [SPARK-32794] [SS] Correzione dell'errore raro del caso di angolo nel motore micro-batch con alcune query con stato + no-data-batch + origini V1

- [SPARK-32813] [SQL] Ottenere la configurazione predefinita del lettore vettorializzatore ParquetSource se non è attiva SparkSession

- [SPARK-32823] [INTERFACCIA UTENTE WEB] Correggere la segnalazione delle risorse dell'interfaccia utente master

- [SPARK-32824] [CORE] Migliorare il messaggio di errore quando l'utente dimentica la quantità in una configurazione della risorsa

- [SPARK-32614] [SQL] Non applicare l'elaborazione dei commenti se 'comment' non è stato impostato per CSV

- [SPARK-32638] [SQL] Corregge i riferimenti quando si aggiungono alias in WidenSetOperationTypes

- [SPARK-32810] [SQL] Le origini dati CSV/JSON devono evitare percorsi glob durante l'inferenza dello schema

- [SPARK-32815] [ML] Correzione dell'errore di caricamento dell'origine dati LibSVM nei percorsi di file con metacharacter glob

- [SPARK-32753] [SQL] Copiare solo i tag nel nodo senza tag

- [SPARK-32785] [SQL] L'intervallo con parti dangling non deve restituire null

- [SPARK-32764] [SQL] -0.0 deve essere uguale a 0.0

- [SPARK-32810] [SQL] Le origini dati CSV/JSON devono evitare percorsi glob durante l'inferenza dello schema

- [SPARK-32779] [SQL] Evitare di usare l'API sincronizzata di SessionCatalog in con il flussoClient, questo porta a DeadLock

- [SPARK-32791] [SQL] La metrica della tabella non partizionata non deve avere un tempo di eliminazione della partizione dinamica

- [SPARK-32767] [SQL] Il join di bucket deve funzionare se spark.sql.shuffle.partitions maggiore del numero di bucket

- [SPARK-32788] [SQL] L'analisi di tabelle non partizionate non deve avere un filtro di partizione

- [SPARK-32776] [SS] Il limite nel flusso non deve essere ottimizzato da PropagateEmptyRelation

- [SPARK-32624] [SQL] Correzione della regressione in CodegenContext.addReferenceObj nei tipi Scala annidati

- [SPARK-32659] [SQL] Migliorare il test per l'eliminazione di DPP in un tipo non atomico

- [SPARK-31511] [SQL] Make BytesToBytesMap iterators thread-safe

- [SPARK-32693] [SQL] Confrontare due dataframe con lo stesso schema ad eccezione della proprietà nullable

- [SPARK-28612] [SQL] Documento del metodo corretto di DataFrameWriterV2.replace()

Aggiornamenti di manutenzione

Vedere Aggiornamenti della manutenzione di Databricks Runtime 7.4.

Ambiente di sistema

- Sistema operativo: Ubuntu 18.04.5 LTS

- Java: Zulu 8.48.0.53-CA-linux64 (build 1.8.0_265-b11)

- Scala: 2.12.10

- Python: 3.7.5

- R: R versione 3.6.3 (2020-02-29)

- Delta Lake 0.7.0

Librerie Python installate

| Library | Versione | Library | Versione | Library | Versione |

|---|---|---|---|---|---|

| asn1crypto | 1.3.0 | backcall | 0.1.0 | boto3 | 1.12.0 |

| botocore | 1.15.0 | certifi | 2020.6.20 | cffi | 1.14.0 |

| chardet | 3.0.4 | cryptography | 2.8 | cycler | 0.10.0 |

| Cython | 0.29.15 | decorator | 4.4.1 | docutils | 0.15.2 |

| entrypoints | 0.3 | idna | 2.8 | ipykernel | 5.1.4 |

| ipython | 7.12.0 | ipython-genutils | 0.2.0 | jedi | 0.17.2 |

| jmespath | 0.10.0 | joblib | 0.14.1 | jupyter-client | 5.3.4 |

| jupyter-core | 4.6.1 | kiwisolver | 1.1.0 | koalas | 1.3.0 |

| matplotlib | 3.1.3 | numpy | 1.18.1 | pandas | 1.0.1 |

| parso | 0.7.0 | patsy | 0.5.1 | pexpect | 4.8.0 |

| pickleshare | 0.7.5 | pip | 20.0.2 | prompt-toolkit | 3.0.3 |

| Psycopg2 | 2.8.4 | ptyprocess | 0.6.0 | pyarrow | 1.0.1 |

| pycparser | 2.19 | Pygments | 2.5.2 | pygobject | 3.26.1 |

| pyOpenSSL | 19.1.0 | pyparsing | 2.4.6 | PySocks | 1.7.1 |

| API Python | 1.6.5+ubuntu0.3 | python-dateutil | 2.8.1 | pytz | 2019.3 |

| pyzmq | 18.1.1 | requests | 2.22.0 | s3transfer | 0.3.3 |

| scikit-learn | 0.22.1 | scipy | 1.4.1 | seaborn | 0.10.0 |

| setuptools | 45.2.0 | six | 1.14.0 | ssh-import-id | 5.7 |

| statsmodels | 0.11.0 | tornado | 6.0.3 | traitlets | 4.3.3 |

| aggiornamenti automatici | 0.1 | urllib3 | 1.25.8 | virtualenv | 16.7.10 |

| wcwidth | 0.1.8 | wheel | 0.34.2 |

Librerie R installate

Le librerie R vengono installate da Microsoft CRAN snapshot in XXXX-XX-XX.

| Library | Versione | Library | Versione | Library | Versione |

|---|---|---|---|---|---|

| askpass | 1.1 | assertthat | 0.2.1 | backports | 1.1.8 |

| base | 3.6.3 | base64enc | 0.1-3 | BH | 1.72.0-3 |

| bit | 1.1-15.2 | bit64 | 0.9-7 | blob | 1.2.1 |

| boot | 1.3-25 | brew | 1.0-6 | Scopa | 0.7.0 |

| callr | 3.4.3 | caret | 6.0-86 | cellranger | 1.1.0 |

| chron | 2.3-55 | class | 7.3-17 | cli | 2.0.2 |

| clipr | 0.7.0 | cluster | 2.1.0 | codetools | 0.2-16 |

| colorspace | 1.4-1 | commonmark | 1.7 | compilatore | 3.6.3 |

| config | 0.3 | covr | 3.5.0 | crayon | 1.3.4 |

| crosstalk | 1.1.0.1 | curl | 4.3 | data.table | 1.12.8 |

| datasets | 3.6.3 | DBI | 1.1.0 | dbplyr | 1.4.4 |

| desc | 1.2.0 | devtools | 2.3.0 | digest | 0.6.25 |

| dplyr | 0.8.5 | DT | 0.14 | puntini di sospensione | 0.3.1 |

| evaluate | 0.14 | fansi | 0.4.1 | farver | 2.0.3 |

| fastmap | 1.0.1 | forcats | 0.5.0 | foreach | 1.5.0 |

| foreign | 0.8-76 | forge | 0.2.0 | fs | 1.4.2 |

| generics | 0.0.2 | ggplot2 | 3.3.2 | gh | 1.1.0 |

| git2r | 0.27.1 | glmnet | 3.0-2 | globals | 0.12.5 |

| glue | 1.4.1 | Gower | 0.2.2 | grafica | 3.6.3 |

| grDevices | 3.6.3 | grid | 3.6.3 | gridExtra | 2.3 |

| gsubfn | 0,7 | gtable | 0.3.0 | haven | 2.3.1 |

| highr | 0,8 | hms | 0.5.3 | htmltools | 0.5.0 |

| htmlwidgets | 1.5.1 | httpuv | 1.5.4 | httr | 1.4.1 |

| hwriter | 1.3.2 | hwriterPlus | 1.0-3 | ini | 0.3.1 |

| ipred | 0.9-9 | isoband | 0.2.2 | Iteratori | 1.0.12 |

| jsonlite | 1.7.0 | KernSmooth | 2.23-17 | knitr | 1,29 |

| Etichettatura | 0.3 | later | 1.1.0.1 | Lattice | 0.20-41 |

| Java | 1.6.7 | lazyeval | 0.2.2 | lifecycle | 0.2.0 |

| lubridate | 1.7.9 | magrittr | 1,5 | markdown | 1.1 |

| MASS | 7.3-53 | Matrice | 1.2-18 | memoise | 1.1.0 |

| methods | 3.6.3 | mgcv | 1.8-33 | mime | 0.9 |

| ModelMetrics | 1.2.2.2 | modelr | 0.1.8 | munsell | 0.5.0 |

| nlme | 3.1-149 | nnet | 7.3-14 | numDeriv | 2016.8-1.1 |

| openssl | 1.4.2 | parallel | 3.6.3 | Concetto fondamentale | 1.4.6 |

| pkgbuild | 1.1.0 | pkgconfig | 2.0.3 | pkgload | 1.1.0 |

| plogr | 0.2.0 | plyr | 1.8.6 | praise | 1.0.0 |

| prettyunits | 1.1.1 | Proc | 1.16.2 | processx | 3.4.3 |

| prodlim | 2019.11.13 | Avanzamento | 1.2.2 | promises | 1.1.1 |

| proto | 1.0.0 | ps | 1.3.3 | purrr | 0.3.4 |

| r2d3 | 0.2.3 | R6 | 2.4.1 | randomForest | 4.6-14 |

| rappdirs | 0.3.1 | rcmdcheck | 1.3.3 | RColorBrewer | 1.1-2 |

| Rcpp | 1.0.5 | readr | 1.3.1 | readxl | 1.3.1 |

| ricette | 0.1.13 | rematch | 1.0.1 | rematch2 | 2.1.2 |

| remotes | 2.1.1 | reprex | 0.3.0 | reshape2 | 1.4.4 |

| rex | 1.2.0 | rjson | 0.2.20 | rlang | 0.4.7 |

| rmarkdown | 2.3 | RODBC | 1.3-16 | roxygen2 | 7.1.1 |

| rpart | 4.1-15 | rprojroot | 1.3-2 | Rserve | 1.8-7 |

| RSQLite | 2.2.0 | rstudioapi | 0.11 | rversions | 2.0.2 |

| rvest | 0.3.5 | Scalabilità | 1.1.1 | selectr | 0.4-2 |

| sessioninfo | 1.1.1 | Forma | 1.4.4 | shiny | 1.5.0 |

| sourcetools | 0.1.7 | sparklyr | 1.3.1 | SparkR | 3.0.0 |

| spaziale | 7.3-11 | Spline | 3.6.3 | sqldf | 0.4-11 |

| SQUAREM | 2020.3 | stats | 3.6.3 | stats4 | 3.6.3 |

| stringi | 1.4.6 | stringr | 1.4.0 | Sopravvivenza | 3.2-7 |

| sys | 3.3 | tcltk | 3.6.3 | TeachingDemos | 2.10 |

| testthat | 2.3.2 | tibble | 3.0.3 | tidyr | 1.1.0 |

| tidyselect | 1.1.0 | tidyverse | 1.3.0 | timeDate | 3043.102 |

| tinytex | 0,24 | tools | 3.6.3 | usethis | 1.6.1 |

| utf8 | 1.1.4 | utils | 3.6.3 | uuid | 0.1-4 |

| vctrs | 0.3.1 | viridisLite | 0.3.0 | whisker | 0.4 |

| withr | 2.2.0 | xfun | 0.15 | xml2 | 1.3.2 |

| xopen | 1.0.0 | xtable | 1.8-4 | yaml | 2.2.1 |

Librerie Java e Scala installate (versione del cluster Scala 2.12)

| ID gruppo | ID artefatto | Versione |

|---|---|---|

| antlr | antlr | 2.7.7 |

| com.amazonaws | amazon-distribuisci-client | 1.12.0 |

| com.amazonaws | aws-java-sdk-autoscaling | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudformation | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudfront | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudhsm | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudsearch | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudtrail | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudwatch | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudwatchmetrics | 1.11.655 |

| com.amazonaws | aws-java-sdk-codedeploy | 1.11.655 |

| com.amazonaws | aws-java-sdk-cognitoidentity | 1.11.655 |

| com.amazonaws | aws-java-sdk-cognitosync | 1.11.655 |

| com.amazonaws | aws-java-sdk-config | 1.11.655 |

| com.amazonaws | aws-java-sdk-core | 1.11.655 |

| com.amazonaws | aws-java-sdk-datapipeline | 1.11.655 |

| com.amazonaws | aws-java-sdk-directconnect | 1.11.655 |

| com.amazonaws | aws-java-sdk-directory | 1.11.655 |

| com.amazonaws | aws-java-sdk-dynamodb | 1.11.655 |

| com.amazonaws | aws-java-sdk-ec2 | 1.11.655 |

| com.amazonaws | aws-java-sdk-ecs | 1.11.655 |

| com.amazonaws | aws-java-sdk-efs | 1.11.655 |

| com.amazonaws | aws-java-sdk-elasticache | 1.11.655 |

| com.amazonaws | aws-java-sdk-elasticbeanstalk | 1.11.655 |

| com.amazonaws | aws-java-sdk-elasticloadbalancing | 1.11.655 |

| com.amazonaws | aws-java-sdk-elastictranscoder | 1.11.655 |

| com.amazonaws | aws-java-sdk-emr | 1.11.655 |

| com.amazonaws | aws-java-sdk-glacier | 1.11.655 |

| com.amazonaws | aws-java-sdk-iam | 1.11.655 |

| com.amazonaws | aws-java-sdk-importexport | 1.11.655 |

| com.amazonaws | aws-java-sdk-consultas | 1.11.655 |

| com.amazonaws | aws-java-sdk-kms | 1.11.655 |

| com.amazonaws | aws-java-sdk-lambda | 1.11.655 |

| com.amazonaws | aws-java-sdk-logs | 1.11.655 |

| com.amazonaws | aws-java-sdk-machinelearning | 1.11.655 |

| com.amazonaws | aws-java-sdk-opsworks | 1.11.655 |

| com.amazonaws | aws-java-sdk-rds | 1.11.655 |

| com.amazonaws | aws-java-sdk-redshift | 1.11.655 |

| com.amazonaws | aws-java-sdk-route53 | 1.11.655 |

| com.amazonaws | aws-java-sdk-s3 | 1.11.655 |

| com.amazonaws | aws-java-sdk-ses | 1.11.655 |

| com.amazonaws | aws-java-sdk-simpledb | 1.11.655 |

| com.amazonaws | aws-java-sdk-simpleworkflow | 1.11.655 |

| com.amazonaws | aws-java-sdk-sns | 1.11.655 |

| com.amazonaws | aws-java-sdk-sqs | 1.11.655 |

| com.amazonaws | aws-java-sdk-ssm | 1.11.655 |

| com.amazonaws | aws-java-sdk-storagegateway | 1.11.655 |

| com.amazonaws | aws-java-sdk-sts | 1.11.655 |

| com.amazonaws | aws-java-sdk-support | 1.11.655 |

| com.amazonaws | aws-java-sdk-swf-libraries | 1.11.22 |

| com.amazonaws | aws-java-sdk-workspaces | 1.11.655 |

| com.amazonaws | jmespath-java | 1.11.655 |

| com.chuusai | shapeless_2.12 | 2.3.3 |

| com.clearspring.analytics | stream | 2.9.6 |

| com.databricks | Rserve | 1.8-3 |

| com.databricks | jets3t | 0.7.1-0 |

| com.databricks.scalapb | compilerplugin_2.12 | 0.4.15-10 |

| com.databricks.scalapb | scalapb-runtime_2.12 | 0.4.15-10 |

| com.mdfsoftware | kryo-shaded | 4.0.2 |

| com.mdfsoftware | minlog | 1.3.0 |

| com.fasterxml | compagno di classe | 1.3.4 |

| com.fasterxml.jackson.core | annotazioni jackson | 2.10.0 |

| com.fasterxml.jackson.core | jackson-core | 2.10.0 |

| com.fasterxml.jackson.core | jackson-databind | 2.10.0 |

| com.fasterxml.jackson.dataformat | jackson-dataformat-cbor | 2.10.0 |

| com.fasterxml.jackson.datatype | jackson-datatype-joda | 2.10.0 |

| com.fasterxml.jackson.module | jackson-module-paranamer | 2.10.0 |

| com.fasterxml.jackson.module | jackson-module-scala_2.12 | 2.10.0 |

| com.github.ben-manes.caffeina | caffeina | 2.3.4 |

| com.github.fommil | jniloader | 1.1 |

| com.github.fommil.netlib | core | 1.1.2 |

| com.github.fommil.netlib | native_ref-java | 1.1 |

| com.github.fommil.netlib | native_ref-java-natives | 1.1 |

| com.github.fommil.netlib | native_system-java | 1.1 |

| com.github.fommil.netlib | native_system-java-natives | 1.1 |

| com.github.fommil.netlib | netlib-native_ref-linux-x86_64-natives | 1.1 |

| com.github.fommil.netlib | netlib-native_system-linux-x86_64-natives | 1.1 |

| com.github.joshelser | dropwizard-metrics-hadoop-metrics2-reporter | 0.1.2 |

| com.github.luben | zstd-jni | 1.4.4-3 |

| com.github.wendykierp | JTransforms | 3.1 |

| com.google.code.findbugs | jsr305 | 3.0.0 |

| com.google.code.gson | gson | 2.2.4 |

| com.google.flatbuffers | flatbuffers-java | 1.9.0 |

| com.google.guava | guaiava | 15.0 |

| com.google.protobuf | protobuf-java | 2.6.1 |

| com.h2database | h2 | 1.4.195 |

| com.helger | profiler | 1.1.1 |

| com.jcraft | jsch | 0.1.50 |

| com.jolbox | bonecp | 0.8.0.RELEASE |

| com.lihaoyi | sourcecode_2.12 | 0.1.9 |

| com.microsoft.azure | azure-data-lake-store-sdk | 2.2.8 |

| com.microsoft.sqlserver | mssql-jdbc | 8.2.1.jre8 |

| com.ning | compress-lzf | 1.0.3 |

| com.sun.mail | javax.mail | 1.5.2 |

| com.tdunning | JSON | 1.8 |

| com.thoughtworks.paranamer | paranamer | 2.8 |

| com.trueaccord.lenses | lenses_2.12 | 0.4.12 |

| com.twitter | chill-java | 0.9.5 |

| com.twitter | chill_2.12 | 0.9.5 |

| com.twitter | util-app_2.12 | 7.1.0 |

| com.twitter | util-core_2.12 | 7.1.0 |

| com.twitter | util-function_2.12 | 7.1.0 |

| com.twitter | util-jvm_2.12 | 7.1.0 |

| com.twitter | util-lint_2.12 | 7.1.0 |

| com.twitter | util-registry_2.12 | 7.1.0 |

| com.twitter | util-stats_2.12 | 7.1.0 |

| com.typesafe | config | 1.2.1 |

| com.typesafe.scala-logging | scala-logging_2.12 | 3.7.2 |

| com.univocità | univocità-parser | 2.9.0 |

| com.zaxxer | HikariCP | 3.1.0 |

| commons-beanutils | commons-beanutils | 1.9.4 |

| commons-cli | commons-cli | 1.2 |

| commons-codec | commons-codec | 1.10 |

| commons-collections | commons-collections | 3.2.2 |

| commons-configuration | commons-configuration | 1.6 |

| commons-dbcp | commons-dbcp | 1.4 |

| commons-digester | commons-digester | 1.8 |

| commons-fileupload | commons-fileupload | 1.3.3 |

| commons-httpclient | commons-httpclient | 3.1 |

| commons-io | commons-io | 2.4 |

| commons-lang | commons-lang | 2.6 |

| commons-logging | commons-logging | 1.1.3 |

| commons-net | commons-net | 3.1 |

| commons-pool | commons-pool | 1.5.4 |

| info.ganglia.gmetric4j | gmetric4j | 1.0.10 |

| io.airlift | aircompressor | 0,10 |

| io.dropwizard.metrics | metrics-core | 4.1.1 |

| io.dropwizard.metrics | metrics-graphite | 4.1.1 |

| io.dropwizard.metrics | metrics-healthchecks | 4.1.1 |

| io.dropwizard.metrics | metrics-jetty9 | 4.1.1 |

| io.dropwizard.metrics | metrics-jmx | 4.1.1 |

| io.dropwizard.metrics | metrics-json | 4.1.1 |

| io.dropwizard.metrics | metrics-jvm | 4.1.1 |

| io.dropwizard.metrics | metrics-servlets | 4.1.1 |

| io.netty | netty-all | 4.1.47.Final |

| jakarta.annotation | jakarta.annotation-api | 1.3.5 |

| jakarta.validation | jakarta.validation-api | 2.0.2 |

| jakarta.ws.rs | jakarta.ws.rs-api | 2.1.6 |

| javax.activation | activation | 1.1.1 |

| javax.el | javax.el-api | 2.2.4 |

| javax.jdo | jdo-api | 3.0.1 |

| javax.servlet | javax.servlet-api | 3.1.0 |

| javax.servlet.jsp | jsp-api | 2.1 |

| javax.transaction | jta | 1.1 |

| javax.transaction | transaction-api | 1.1 |

| javax.xml.bind | jaxb-api | 2.2.2 |

| javax.xml.stream | stax-api | 1.0-2 |

| javolution | javolution | 5.5.1 |

| jline | jline | 2.14.6 |

| joda-time | joda-time | 2.10.5 |

| log4j | apache-log4j-extras | 1.2.17 |

| log4j | log4j | 1.2.17 |

| net.razorvine | pirolite | 4.30 |

| net.sf.jpam | jpam | 1.1 |

| net.sf.opencsv | opencsv | 2.3 |

| net.sf.supercsv | super-csv | 2.2.0 |

| net.snowflake | snowflake-ingest-sdk | 0.9.6 |

| net.snowflake | snowflake-jdbc | 3.12.8 |

| net.snowflake | spark-snowflake_2.12 | 2.8.1-spark_3.0 |

| net.sourceforge.f2j | arpack_combined_all | 0.1 |

| org.acplt.remotetea | remotetea-oncrpc | 1.1.2 |

| org.antlr | ST4 | 4.0.4 |

| org.antlr | antlr-runtime | 3.5.2 |

| org.antlr | antlr4-runtime | 4.7.1 |

| org.antlr | stringtemplate | 3.2.1 |

| org.apache.ant | ant | 1.9.2 |

| org.apache.ant | ant-jsch | 1.9.2 |

| org.apache.ant | ant-launcher | 1.9.2 |

| org.apache.arrow | formato freccia | 0.15.1 |

| org.apache.arrow | freccia-memoria | 0.15.1 |

| org.apache.arrow | freccia-vettore | 0.15.1 |

| org.apache.avro | avro | 1.8.2 |

| org.apache.avro | avro-ipc | 1.8.2 |

| org.apache.avro | avro-mapred-hadoop2 | 1.8.2 |

| org.apache.commons | commons-compress | 1.8.1 |

| org.apache.commons | commons-crypto | 1.0.0 |

| org.apache.commons | commons-lang3 | 3.9 |

| org.apache.commons | commons-math3 | 3.4.1 |

| org.apache.commons | commons-text | 1.6 |

| org.apache.curator | curatore-cliente | 2.7.1 |

| org.apache.curator | curatore-framework | 2.7.1 |

| org.apache.curator | ricette curatori | 2.7.1 |

| org.apache.derby | derby | 10.12.1.1 |

| org.apache.directory.api | api-asn1-api | 1.0.0-M20 |

| org.apache.directory.api | api-util | 1.0.0-M20 |

| org.apache.directory.server | apacheds-i18n | 2.0.0-M15 |

| org.apache.directory.server | apacheds-kerberos-codec | 2.0.0-M15 |

| org.apache.hadoop | hadoop-annotations | 2.7.4 |

| org.apache.hadoop | hadoop-auth | 2.7.4 |

| org.apache.hadoop | hadoop-client | 2.7.4 |

| org.apache.hadoop | hadoop-common | 2.7.4 |

| org.apache.hadoop | hadoop-hdfs | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-app | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-common | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-core | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-jobclient | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-shuffle | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-api | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-client | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-common | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-server-common | 2.7.4 |

| org.apache.hive | hive-beeline | 2.3.7 |

| org.apache.hive | hive-cli | 2.3.7 |

| org.apache.hive | hive-common | 2.3.7 |

| org.apache.hive | hive-exec-core | 2.3.7 |

| org.apache.hive | hive-jdbc | 2.3.7 |

| org.apache.hive | hive-llap-client | 2.3.7 |

| org.apache.hive | hive-llap-common | 2.3.7 |

| org.apache.hive | hive-metastore | 2.3.7 |

| org.apache.hive | hive-serde | 2.3.7 |

| org.apache.hive | hive-shims | 2.3.7 |

| org.apache.hive | hive-storage-api | 2.7.1 |

| org.apache.hive | hive-vector-code-gen | 2.3.7 |

| org.apache.hive.shims | hive-shims-0.23 | 2.3.7 |

| org.apache.hive.shims | hive-shims-common | 2.3.7 |

| org.apache.hive.shims | hive-shims-scheduler | 2.3.7 |

| org.apache.htrace | htrace-core | Incubazione 3.1.0 |

| org.apache.httpcomponents | httpclient | 4.5.6 |

| org.apache.httpcomponents | httpcore | 4.4.12 |

| org.apache.ivy | ivy | 2.4.0 |

| org.apache.orc | orc-core | 1.5.10 |

| org.apache.orc | orc-mapreduce | 1.5.10 |

| org.apache.orc | orc-shim | 1.5.10 |

| org.apache.parquet | parquet-column | 1.10.1-databricks6 |

| org.apache.parquet | parquet-common | 1.10.1-databricks6 |

| org.apache.parquet | codifica parquet | 1.10.1-databricks6 |

| org.apache.parquet | formato parquet | 2.4.0 |

| org.apache.parquet | parquet-hadoop | 1.10.1-databricks6 |

| org.apache.parquet | parquet-jackson | 1.10.1-databricks6 |

| org.apache.thrift | libfb303 | 0.9.3 |

| org.apache.thrift | libthrift | 0.12.0 |

| org.apache.velocity | velocità | 1,5 |

| org.apache.xbean | xbean-asm7-shaded | 4.15 |

| org.apache.yetus | annotazioni del gruppo di destinatari | 0.5.0 |

| org.apache.zookeeper | zookeeper | 3.4.14 |

| org.codehaus.jackson | jackson-core-asl | 1.9.13 |

| org.codehaus.jackson | jackson-jaxrs | 1.9.13 |

| org.codehaus.jackson | jackson-mapper-asl | 1.9.13 |

| org.codehaus.jackson | jackson-xc | 1.9.13 |

| org.codehaus.janino | commons-compiler | 3.0.16 |

| org.codehaus.janino | janino | 3.0.16 |

| org.datanucleus | datanucleus-api-jdo | 4.2.4 |

| org.datanucleus | datanucleus-core | 4.1.17 |

| org.datanucleus | datanucleus-rdbms | 4.1.19 |

| org.datanucleus | javax.jdo | 3.2.0-m3 |

| org.eclipse.jetty | jetty-client | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-continuation | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-http | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-io | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-jndi | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-plus | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-proxy | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-security | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-server | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-servlet | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-servlets | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-util | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-webapp | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-xml | 9.4.18.v20190429 |

| org.fusesource.leveldbjni | leveldbjni-all | 1.8 |

| org.glassfish.hk2 | hk2-api | 2.6.1 |

| org.glassfish.hk2 | hk2-locator | 2.6.1 |

| org.glassfish.hk2 | hk2-utils | 2.6.1 |

| org.glassfish.hk2 | osgi-resource-locator | 1.0.3 |

| org.glassfish.hk2.external | aopalliance-repackaged | 2.6.1 |

| org.glassfish.hk2.external | jakarta.inject | 2.6.1 |

| org.glassfish.jersey.containers | jersey-container-servlet | 2.30 |

| org.glassfish.jersey.containers | jersey-container-servlet-core | 2.30 |

| org.glassfish.jersey.core | jersey-client | 2.30 |

| org.glassfish.jersey.core | maglia-comune | 2.30 |

| org.glassfish.jersey.core | jersey-server | 2.30 |

| org.glassfish.jersey.inject | jersey-hk2 | 2.30 |

| org.glassfish.jersey.media | jersey-media-jaxb | 2.30 |

| org.hibernate.validator | hibernate-validator | 6.1.0.Final |

| org.javassist | javassist | 3.25.0-GA |

| org.jboss.logging | jboss-logging | 3.3.2.Final |

| org.jdbi | jdbi | 2.63.1 |

| org.joda | joda-convert | 1.7 |

| org.jodd | jodd-core | 3.5.2 |

| org.json4s | json4s-ast_2.12 | 3.6.6 |

| org.json4s | json4s-core_2.12 | 3.6.6 |

| org.json4s | json4s-jackson_2.12 | 3.6.6 |

| org.json4s | json4s-scalap_2.12 | 3.6.6 |

| org.lz4 | lz4-java | 1.7.1 |

| org.mariadb.jdbc | mariadb-java-client | 2.1.2 |

| org.objenesis | objenesis | 2.5.1 |

| org.postgresql | postgresql | 42.1.4 |

| org.roaringbitmap | RoaringBitmap | 0.7.45 |

| org.roaringbitmap | Spessori | 0.7.45 |

| org.rocksdb | rocksdbjni | 6.2.2 |

| org.rosuda.REngine | REngine | 2.1.0 |

| org.scala-lang | scala-compiler_2.12 | 2.12.10 |

| org.scala-lang | scala-library_2.12 | 2.12.10 |

| org.scala-lang | scala-reflect_2.12 | 2.12.10 |

| org.scala-lang.modules | scala-collection-compat_2.12 | 2.1.1 |

| org.scala-lang.modules | scala-parser-combinators_2.12 | 1.1.2 |

| org.scala-lang.modules | scala-xml_2.12 | 1.2.0 |

| org.scala-sbt | test-interface | 1.0 |

| org.scalacheck | scalacheck_2.12 | 1.14.2 |

| org.scalactic | scalactic_2.12 | 3.0.8 |

| org.scalanlp | breeze-macros_2.12 | 1.0 |

| org.scalanlp | breeze_2.12 | 1.0 |

| org.scalatest | scalatest_2.12 | 3.0.8 |

| org.slf4j | jcl-over-slf4j | 1.7.30 |

| org.slf4j | jul-to-slf4j | 1.7.30 |

| org.slf4j | slf4j-api | 1.7.30 |

| org.slf4j | slf4j-log4j12 | 1.7.30 |

| org.spark-project.spark | inutilizzato | 1.0.0 |

| org.springframework | spring-core | 4.1.4.RELEASE |

| org.springframework | spring-test | 4.1.4.RELEASE |

| org.threeten | treten-extra | 1.5.0 |

| org.cortanaani | xz | 1,5 |

| org.typelevel | algebra_2.12 | 2.0.0-M2 |

| org.typelevel | cats-kernel_2.12 | 2.0.0-M4 |

| org.typelevel | machinist_2.12 | 0.6.8 |

| org.typelevel | macro-compat_2.12 | 1.1.1 |

| org.typelevel | spire-macros_2.12 | 0.17.0-M1 |

| org.typelevel | spire-platform_2.12 | 0.17.0-M1 |

| org.typelevel | spire-util_2.12 | 0.17.0-M1 |

| org.typelevel | spire_2.12 | 0.17.0-M1 |

| org.xerial | sqlite-jdbc | 3.8.11.2 |

| org.xerial.snappy | snappy-java | 1.1.7.5 |

| org.yaml | snakeyaml | 1.24 |

| oro | oro | 2.0.8 |

| pl.edu.icm | JLargeArrays | 1,5 |

| software.amazon.ion | ion-java | 1.0.2 |

| stax | stax-api | 1.0.1 |

| xmlenc | xmlenc | 0,52 |