Aggiungere e configurare modelli al servizio di inferenza del modello di intelligenza artificiale di Azure

È possibile decidere e configurare i modelli disponibili per l'inferenza nell'endpoint di inferenza del modello della risorsa. Quando un determinato modello è configurato, è quindi possibile generare stime da esso indicando il nome del modello o il nome della distribuzione nelle richieste. Non sono necessarie altre modifiche nel codice per usarle.

Questo articolo illustra come aggiungere un nuovo modello al servizio di inferenza del modello di intelligenza artificiale di Azure nei servizi di intelligenza artificiale di Azure.

Prerequisiti

Per completare questo articolo, devi avere quanto segue:

- Una sottoscrizione di Azure. Se si usano i modelli GitHub, è possibile aggiornare l'esperienza e creare una sottoscrizione di Azure nel processo. Per altre informazioni, vedere Eseguire l'aggiornamento da modelli GitHub a modelli di intelligenza artificiale di Azure in Servizi di intelligenza artificiale.

- Una risorsa dei servizi di intelligenza artificiale di Azure. Per altre informazioni, vedere Creare una risorsa di Servizi di intelligenza artificiale di Azure.

Aggiungi un modello

In alternativa ai modelli GitHub in cui tutti i modelli sono già configurati, la risorsa di Servizi di intelligenza artificiale di Azure consente di controllare quali modelli sono disponibili nell'endpoint e in quale configurazione.

È possibile aggiungere tutti i modelli necessari nell'endpoint usando Azure AI Foundry per GitHub. Nell'esempio seguente viene aggiunto un Mistral-Large modello nel servizio:

Passare alla sezione Catalogo modelli in Azure AI Foundry per GitHub.

Scorrere fino al modello a cui si è interessati e selezionarlo.

È possibile esaminare i dettagli del modello nella scheda del modello.

Seleziona Distribuisci.

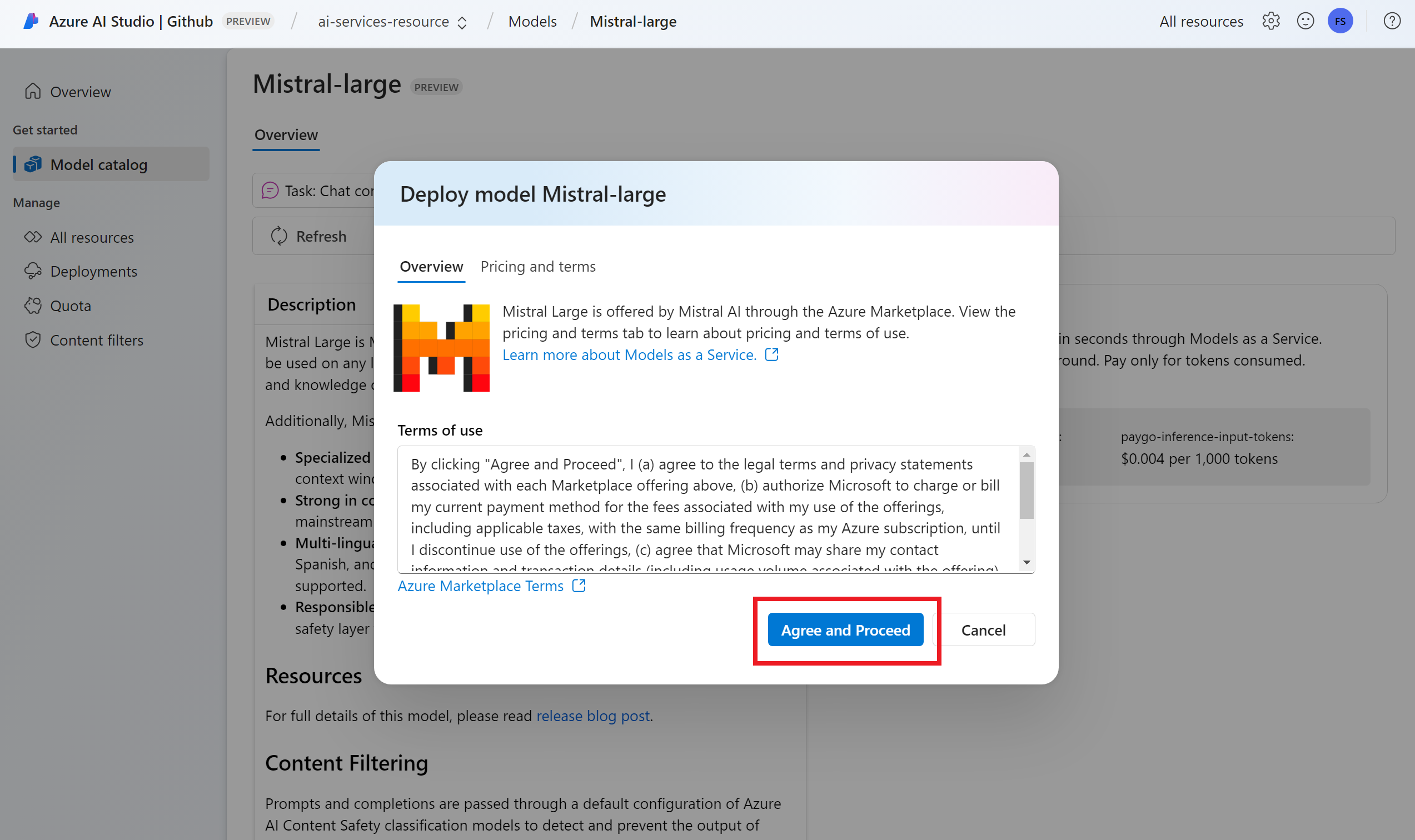

Per i provider di modelli che richiedono condizioni aggiuntive per il contratto, viene chiesto di accettare tali condizioni. Ad esempio, i modelli Mistral chiedono di accettare altri termini. Accettare i termini in questi casi selezionando Sottoscrivi e distribuisci.

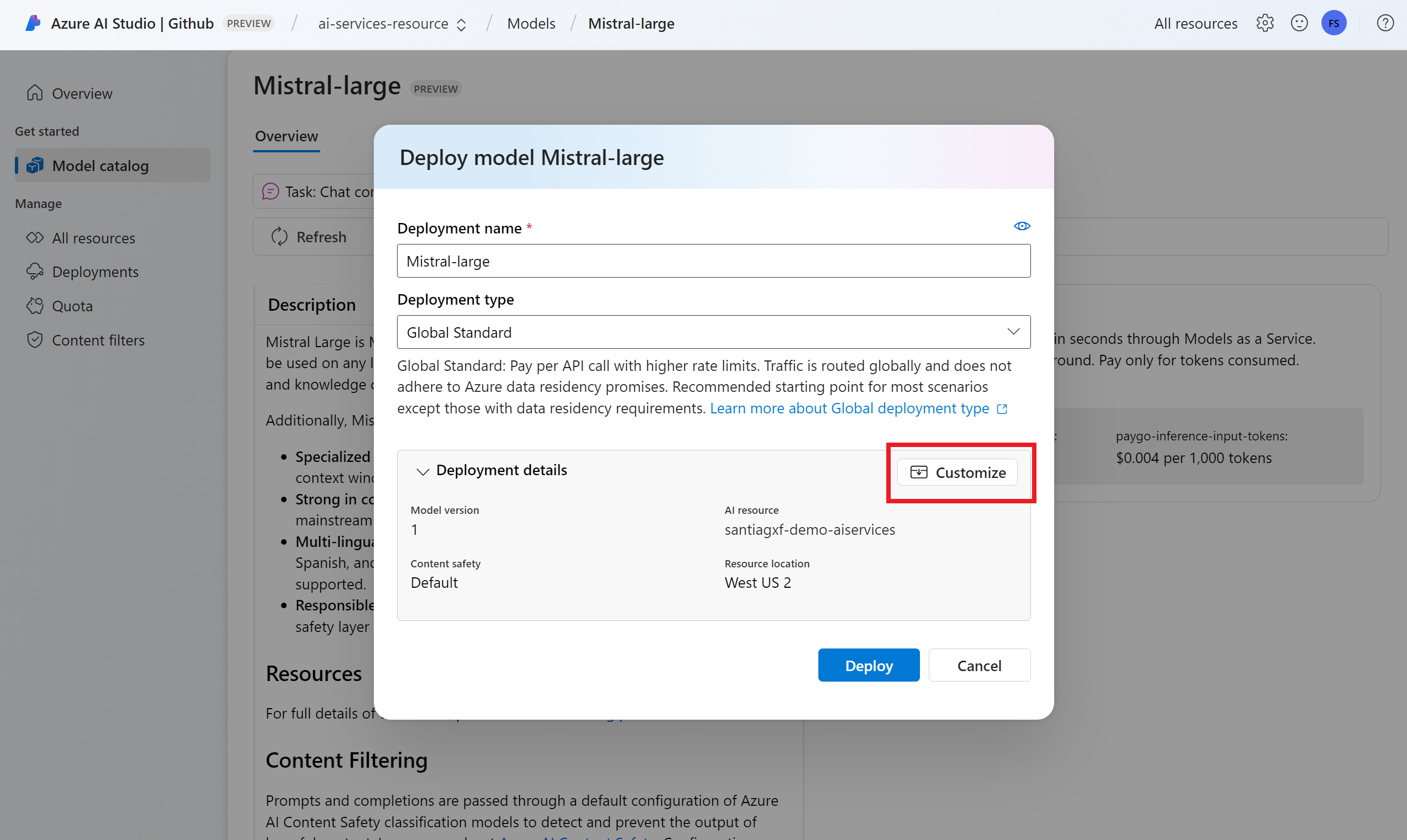

È possibile configurare le impostazioni di distribuzione in questo momento. Per impostazione predefinita, la distribuzione riceve il nome del modello che si sta distribuendo. Il nome della distribuzione viene usato nel parametro per la

modelrichiesta di instradamento a questa distribuzione specifica del modello. Questa impostazione consente anche di configurare nomi specifici per i modelli quando si allegano configurazioni specifiche. Ad esempio,o1-preview-safeper un modello con un filtro contenuto di sicurezza del contenuto rigoroso.

Suggerimento

Ogni modello può supportare diversi tipi di distribuzioni, fornendo garanzie di residenza dei dati o velocità effettiva diverse. Per altri dettagli, vedere Tipi di distribuzione.

- Usare l'opzione Personalizza se è necessario modificare le impostazioni, ad esempio il filtro del contenuto o la limitazione della frequenza (se disponibile).

Seleziona Distribuisci.

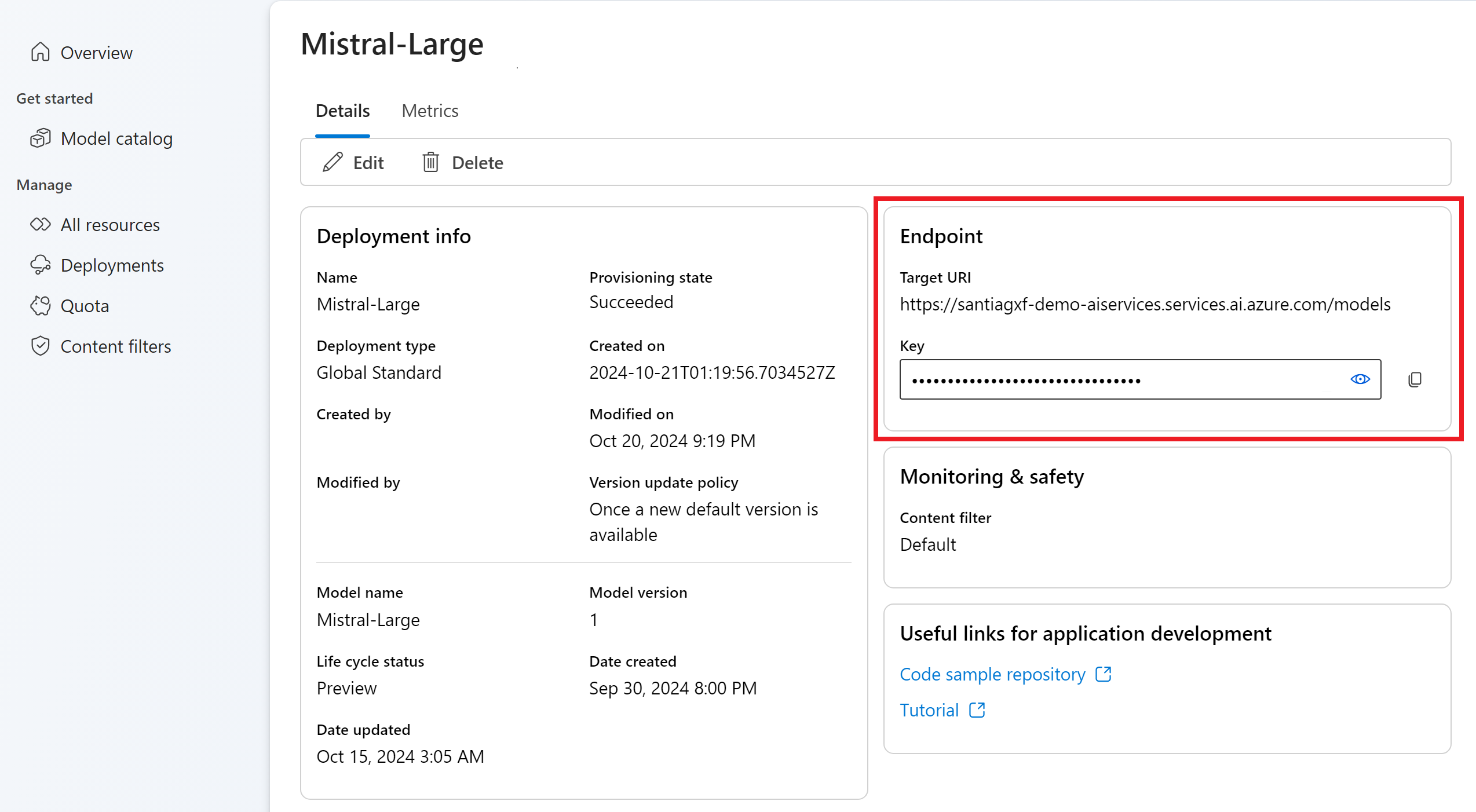

Al termine della distribuzione, il nuovo modello verrà elencato nella pagina ed è pronto per l'uso.

Usare il modello

I modelli distribuiti nei servizi di intelligenza artificiale di Azure possono essere usati usando l'endpoint di inferenza del modello di intelligenza artificiale di Azure per la risorsa.

Per usarla:

Ottenere l'URL e le chiavi dell'endpoint di inferenza del modello di intelligenza artificiale di Azure dalla pagina di distribuzione o dalla pagina Panoramica . Se si usa l'autenticazione microsoft Entra ID, non è necessaria una chiave.

Usare l'URL dell'endpoint di inferenza del modello e le chiavi precedenti durante la costruzione del client. L'esempio seguente usa il pacchetto di inferenza di Intelligenza artificiale di Azure:

Installare il pacchetto

azure-ai-inferenceusando la propria gestione pacchetti, come pip:pip install azure-ai-inference>=1.0.0b5Avviso

La risorsa di Servizi di intelligenza artificiale di Azure richiede la versione

azure-ai-inference>=1.0.0b5per Python.Quindi, è possibile usare il pacchetto per utilizzare il modello. Gli esempi seguenti mostrano come creare un client per utilizzare i completamenti chat:

import os from azure.ai.inference import ChatCompletionsClient from azure.core.credentials import AzureKeyCredential client = ChatCompletionsClient( endpoint=os.environ["AZUREAI_ENDPOINT_URL"], credential=AzureKeyCredential(os.environ["AZUREAI_ENDPOINT_KEY"]), )Esplorare gli esempi e leggere la documentazione di riferimento sulle API per iniziare.

Quando si costruisce la richiesta, indicare il parametro

modele inserire il nome di distribuzione del modello creato.from azure.ai.inference.models import SystemMessage, UserMessage response = client.complete( messages=[ SystemMessage(content="You are a helpful assistant."), UserMessage(content="Explain Riemann's conjecture in 1 paragraph"), ], model="mistral-large" ) print(response.choices[0].message.content)

Suggerimento

Quando si usa l'endpoint, è possibile modificare il model parametro in qualsiasi distribuzione del modello disponibile nella risorsa.

Inoltre, i modelli OpenAI di Azure possono essere usati usando l'endpoint del servizio OpenAI di Azure nella risorsa. Questo endpoint è esclusivo per ogni distribuzione del modello e ha un PROPRIO URL.

Personalizzazione della distribuzione del modello

Quando si creano distribuzioni di modelli, è possibile configurare altre impostazioni, tra cui il filtro del contenuto e i limiti di frequenza. Per configurare altre impostazioni, selezionare l'opzione Personalizza nella distribuzione guidata.

Nota

Le configurazioni possono variare a seconda del modello che si sta distribuendo.