Exécuter le notebook Jupyter pour produire un modèle de détection d’objets avec AutoML

Dans cette section, nous allons continuer à travailler dans le notebook Jupyter pour exécuter les étapes qui produisent notre modèle de détection d’objet. Cette tâche sera effectuée à l’aide de AutoML pour la vision par ordinateur. L’exécution d’une inférence sur un exemple de test qui n’a jamais été vu par le modèle pendant l’entraînement vous permet de voir votre modèle en action.

Exécuter le notebook Jupyter pour produire un modèle de détection d’objets avec AutoML

Si vous ne l’avez pas déjà fait, accédez à votre espace de travail Jupyter et sélectionnez le fichier AutoMLImage_ObjectDetection.ipynb pour ouvrir le bloc-notes Jupyter.

Passez à la section Configuration de votre exécution AutoML pour les tâches d’image et commencez à exécuter la cellule dans les valeurs d’hyperparamètre par défaut pour l’algorithme spécifié. Cette étape utilise AutoMLImageConfig pour créer une configuration d’entraînement de modèle qui affectera des hyperparamètres par défaut pour produire un modèle de détection d’objet optimisé.

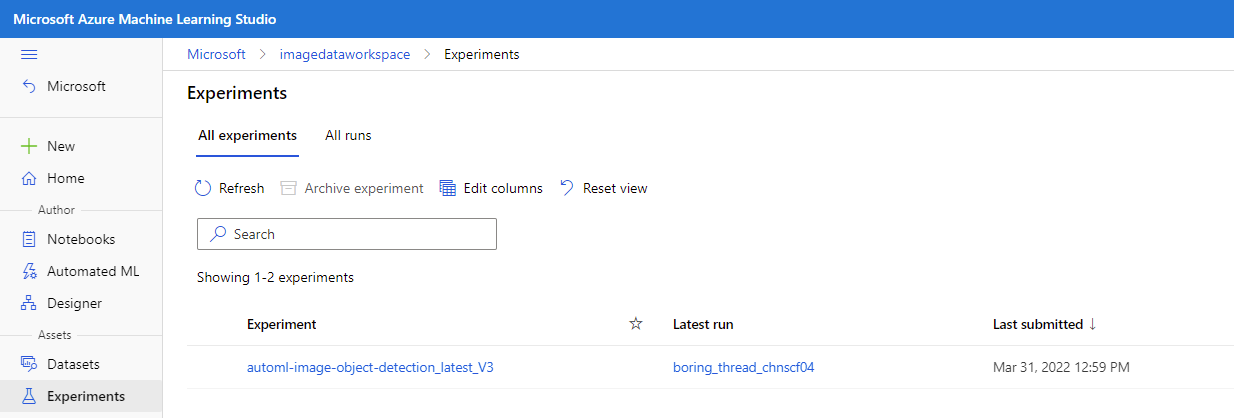

Continuez à exécuter les cellules de la section Envoi d’une exécution AutoML pour des tâches Vision par ordinateur. Cette opération envoie une tâche d’expérience qui s’exécute sur l’instance d’entraînement qui a été affectée dans la section configuration de la cible de calcul. Après avoir exécuté ces cellules, vous pouvez surveiller la progression dans Azure Machine Learning studio en accédant à la section Ressources du volet gauche et en sélectionnant Expériences.

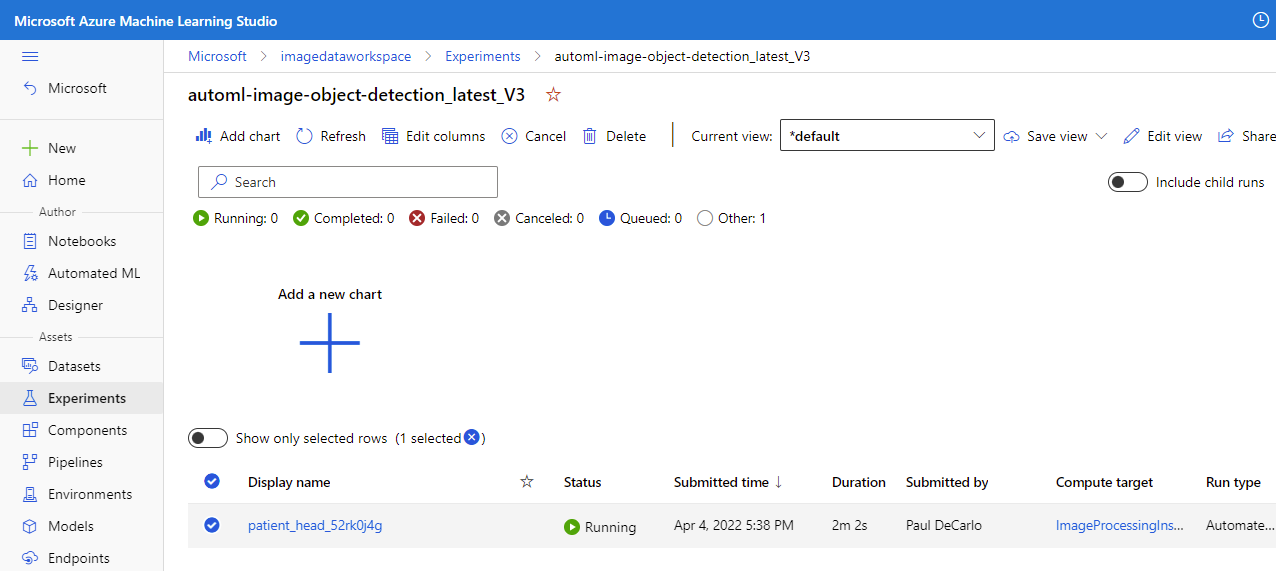

Vous pouvez ensuite sélectionner le travail en cours d’exécution, qui doit être nommé automl-image-object-detection_latest_V3. Cette action vous permettra d’afficher la progression de l’entraînement du modèle.

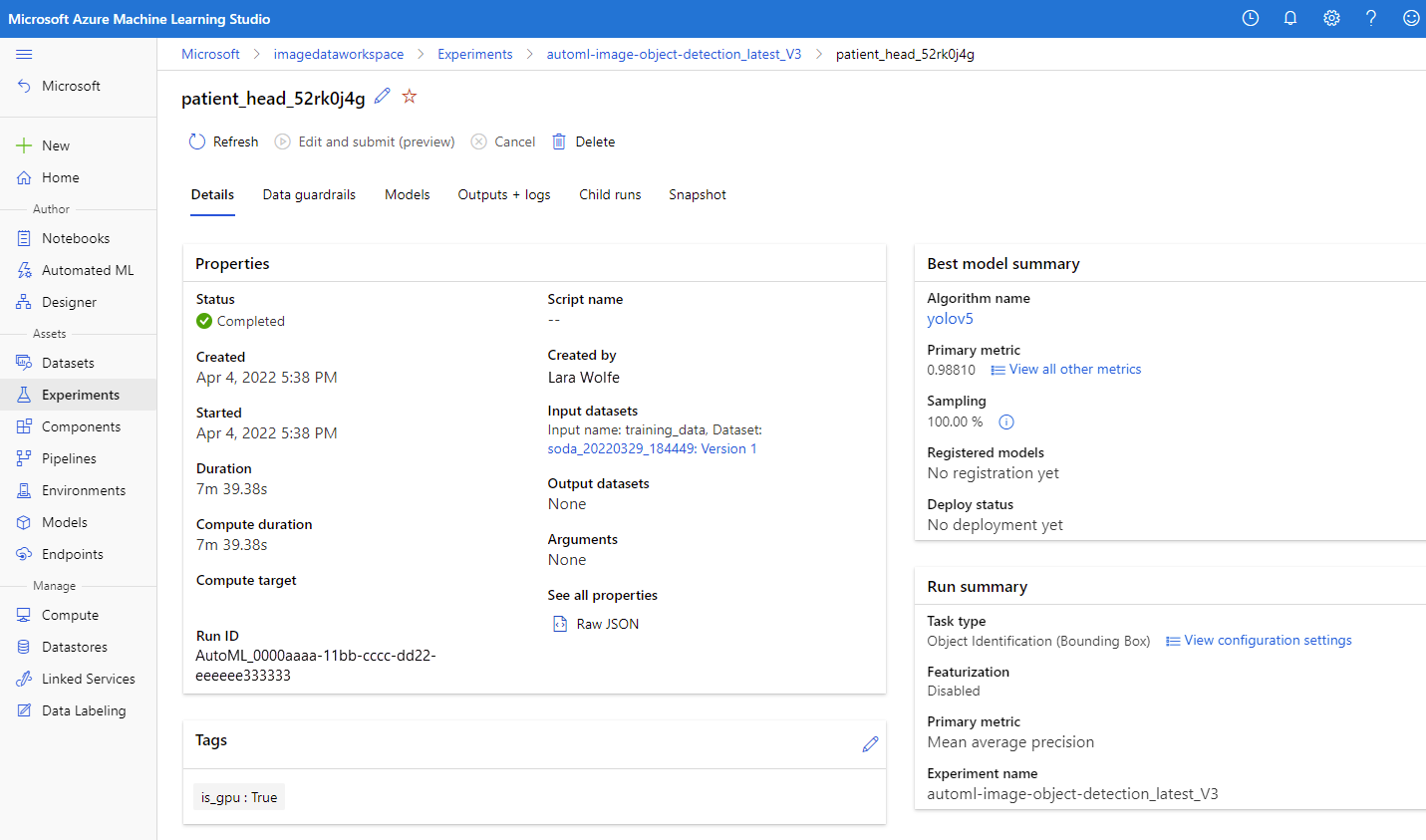

Une fois l’expérience terminée, vous verrez ce qui suit.

Sélectionnez le nom d’affichage du travail pour afficher les détails du travail dans lequel vous pouvez afficher les résultats de l’entraînement du modèle.

Maintenant que notre modèle est entraîné, nous pouvons continuer à exécuter les cellules du de la section Enregistrer le modèle de vision optimal à partir de l’exécution AutoML. Ce processus sélectionne automatiquement l’exécution enfant avec la précision la plus élevée.

Continuez à exécuter les cellules dans la section Télécharger le modèle et d’autres fichiers associés, par exemple, les étiquettes. Il existe une cellule facultative que vous pouvez exécuter en spécifiant une run_id AutoML spécifique. La sortie de l’une de ces cellules fournit le modèle et l’étiquette dans un dossier de modèles nouvellement créé accessible dans votre espace de travail Jupyter. Accédez à votre espace de travail Jupyter et ouvrez le dossier modèles et vous verrez la sortie label.json et model.onnx.

Sélectionnez labels.json et model.onnx , puis téléchargez les fichiers de sortie. Ces fichiers sont le modèle entraîné et les étiquettes associées.

Revenez au notebook Jupyter et exécutez toutes les cellules de la section Charger les étiquettes et les fichiers de modèle ONNX. Cette étape charge la sortie et les étiquettes du modèle pour préparer l’exécution.

Continuez à exécuter les cellules dans la section Obtenir les détails d’entrée et de sortie attendus pour un modèle ONNX. Cette tâche analyse le modèle pour déterminer les formes d’entrée et de sortie qui définissent le réseau neuronal Convolution présent dans le modèle.

Continuez à exécuter les cellules de la section Prétraitement d’inférence d’image. Cela effectue le prétraitement de l’exemple detest_image1.jpg qui a été chargé dans notre espace de travail précédemment. L’étape de prétraitement transforme l’image en fonction de la forme d’entrée attendue qui a été déterminée à l’étape précédente.

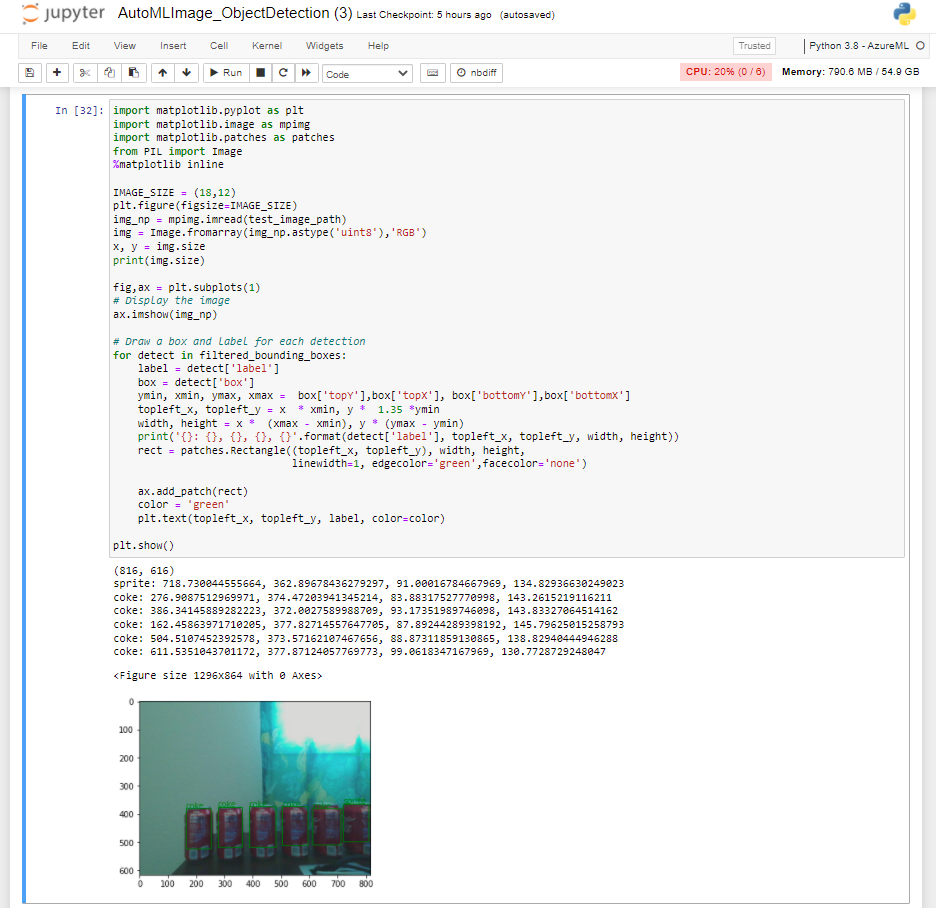

Continuez à exécuter les cellules de la section Détection d’objets avec YOLO. Cette section effectue une inférence sur l’exemple test_image1.jpg et illustre la sortie visuelle du modèle de détection d’objets dans la cellule finale. Ici, vous pouvez voir la précision de votre modèle car il détecte l’objet sur un exemple d’image jamais vu.