Paramètres d’administration de l’espace de travail Engineering données dans Microsoft Fabric

S’applique à :✅ Engineering données et Science des données dans Microsoft Fabric

Lorsque vous créez un espace de travail dans Microsoft Fabric, un pool de démarrage associé à cet espace de travail est automatiquement créé. Avec la configuration simplifiée dans Microsoft Fabric, il n’est pas nécessaire de choisir les tailles de nœud ou de machine, car ces options sont gérées pour vous en arrière-plan. Cette configuration offre une expérience de démarrage de session Apache Spark plus rapide (5 à 10 secondes) pour permettre aux utilisateurs de commencer et d’exécuter vos travaux Apache Spark dans de nombreux scénarios courants sans avoir à se soucier de la configuration du calcul. Pour les scénarios avancés avec des exigences de calcul spécifiques, les utilisateurs peuvent créer un pool Apache Spark personnalisé et dimensionner les nœuds en fonction de leurs besoins en matière de performances.

Pour apporter des modifications aux paramètres Apache Spark dans un espace de travail, vous devez avoir le rôle d’administrateur pour cet espace de travail. Pour plus d’informations, consultez Rôles dans les espaces de travail.

Pour gérer les paramètres Spark du pool associé à votre espace de travail :

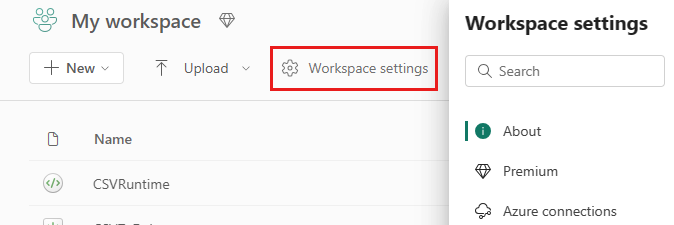

Accédez aux paramètres de l’espace de travail dans votre espace de travail et choisissez l’option Engineering données/Science pour développer le menu :

Vous voyez l’option Calcul Spark dans votre menu de gauche :

Remarque

Si vous remplacez le pool de démarrage par défaut par un pool Spark personnalisé, vous pouvez constater un démarrage de session plus long (environ 3 minutes).

Groupe

Pool par défaut pour l’espace de travail

Vous pouvez utiliser le pool de démarrage créé automatiquement ou créer des pools personnalisés pour l’espace de travail.

Pool de démarrage : pools en direct préhydratés, créés automatiquement pour une expérience plus rapide. Ces clusters sont de taille moyenne. Le pool de démarrage est défini sur une configuration par défaut basée sur la référence SKU de capacité Fabric achetée. Les administrateurs peuvent personnaliser le nombre maximal de nœuds et d’exécuteurs en fonction de leurs exigences de mise à l’échelle de charge de travail Spark. Pour plus d’informations, consultez Configurer des pools de démarrage

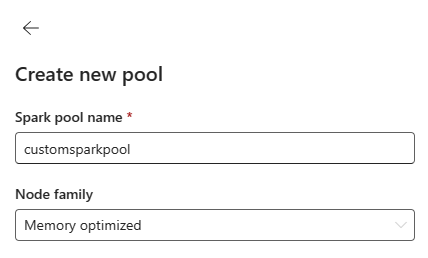

Pool Spark personnalisé : vous pouvez dimensionner les nœuds, mettre à l’échelle automatiquement et allouer dynamiquement des exécuteurs en fonction des exigences de votre travail Spark. Pour créer un pool Spark personnalisé, l’administrateur de capacité doit activer l’option Pools d’espaces de travail personnalisés dans la section Calcul Spark des paramètres Administrateur de capacité.

Remarque

Le contrôle au niveau de la capacité pour les pools d’espaces de travail personnalisés est activé par défaut. Pour en savoir plus, voi Configurer et gérer les paramètres d’Ingénieurs de données et de science des données pour des capacités Fabric.

Les administrateurs peuvent créer des pools Spark personnalisés en fonction de leurs besoins de calcul en sélectionnant l’option Nouveau pool.

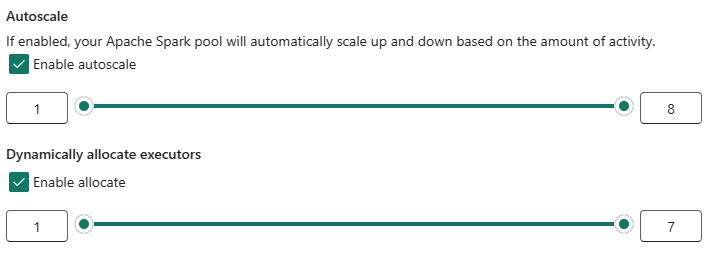

Apache Spark pour Microsoft Fabric Spark prend en charge les clusters à nœud unique, ce qui permet aux utilisateurs de sélectionner une configuration de nœud minimale de 1, auquel cas le pilote et l’exécuteur s’exécutent dans un seul nœud. Ces clusters à nœud unique offrent une haute disponibilité restaurable lors des défaillances de nœud et une meilleure fiabilité des travaux pour les charges de travail ayant des besoins en calcul plus modestes. Vous pouvez également activer ou désactiver l’option de mise à l’échelle automatique pour vos pools Spark personnalisés. Lorsqu’il est activé avec la mise à l’échelle automatique, le pool acquiert de nouveaux nœuds dans la limite maximale de nœuds spécifiée par l’utilisateur et les met hors service après l’exécution du travail pour de meilleures performances.

Vous pouvez également sélectionner l’option permettant d’allouer dynamiquement des exécuteurs au pool. Elle établit automatiquement le nombre optimal d’exécuteurs dans la limite maximale spécifiée en fonction du volume de données pour de meilleures performances.

En savoir plus sur le calcule Apache Spark pour Fabric.

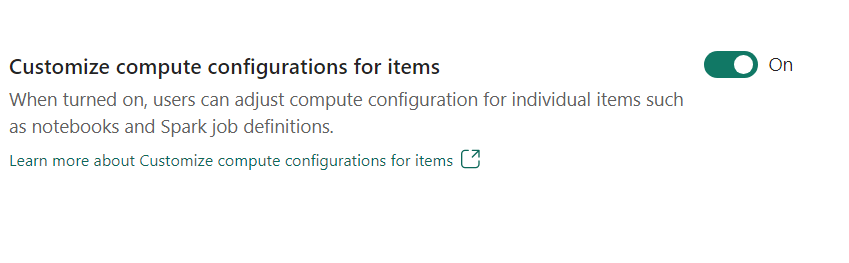

- Personnaliser la configuration de calcul pour les éléments : en tant qu’administrateur d’espace de travail, vous pouvez permettre aux utilisateurs d’ajuster les configurations de calcul (propriétés au niveau de session qui incluent Driver/Executor Core, Driver/Executor Memory) pour des éléments individuels tels que des notebooks, des définitions de travaux Spark, à l’aide de l’environnement.

Si le paramètre est désactivé par l’administrateur de l’espace de travail, le pool par défaut et ses configurations de calcul sont utilisés pour tous les environnements de l’espace de travail.

Environment

L’environnement fournit des configurations flexibles pour l’exécution de vos travaux Spark (notebooks, définitions du travail Spark). Dans un environnement, vous pouvez configurer des propriétés de calcul, sélectionner différents runtimes, configurer des dépendances de packages de bibliothèques en fonction des exigences de votre charge de travail.

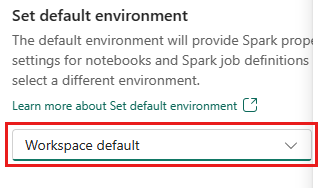

Dans l’onglet Environnement, vous avez la possibilité de définir l’environnement par défaut. Vous pouvez choisir la version de Spark que vous souhaitez utiliser pour l’espace de travail.

En tant qu’administrateur d’espace de travail Fabric, vous pouvez sélectionner un environnement en tant qu’environnement par défaut de l’espace de travail.

Vous pouvez également en créer un en utilisant la liste déroulante Environnement.

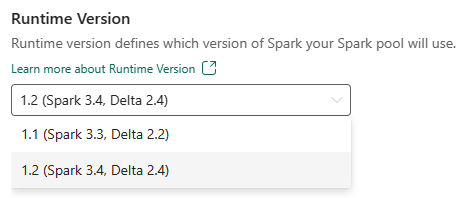

Si vous désactivez l’option permettant d’avoir un environnement par défaut, vous avez la possibilité de sélectionner la version du runtime Fabric dans les versions de runtime disponibles listées dans la sélection de liste déroulante.

En savoir plus sur les runtimes Apache Spark.

Tâches

Les paramètres des travaux permettent aux administrateurs de contrôler la logique d’admission de projet pour tous les travaux Spark dans l’espace de travail.

Par défaut, tous les espaces de travail sont activés avec l’admission optimiste de projet. Découvrez plus en détail l’admission de projet pour Spark dans Microsoft Fabric.

Vous pouvez activer le paramètre Réserver le nombre maximal de cœurs pour les travaux Spark actifs pour activer l’approche d’admission optimiste de projet et réserver le nombre maximal de cœurs pour les travaux Spark.

Vous pouvez également définir le délai d’expiration de session Spark pour personnaliser le délai d’expiration applicable à toutes les sessions interactives de notebook.

Remarque

Le délai d’expiration de session défini par défaut est de 20 minutes pour les sessions Spark interactives.

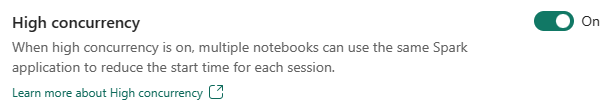

Concurrence élevée

Le mode de concurrence élevée permet aux utilisateurs de partager les mêmes sessions Spark dans Apache Spark pour l’Ingénieurs de données Fabric et les charges de travail de science des données. Un élément comme un notebook utilise une session Spark pour son exécution et, en cas d’activation, les utilisateurs peuvent partager une session Spark unique sur plusieurs notebooks.

En savoir plus sur la haute concurrence dans Apache Spark pour Fabric.

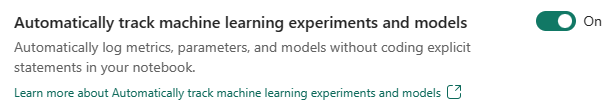

Journalisation automatique pour les modèles et expériences Machine Learning

Les administrateurs peuvent désormais activer la journalisation automatique pour leurs modèles et expériences Machine Learning. Cette option capture automatiquement les valeurs des paramètres d’entrée, des mesures de sortie et des éléments de sortie d’un modèle Machine Learning au fur et à mesure de son apprentissage. En savoir plus sur la journalisation automatique

Contenu connexe

- Consultez Runtimes Apache Spark dans Fabric : vue d’ensemble, contrôle de version, prise en charge de plusieurs runtimes et mise à niveau du protocole Delta Lake.

- Pour en savoir plus, consultez la documentation publique Apache Spark.

- Trouvez des réponses aux questions fréquemment posées : FAQ sur les paramètres d’administration de l’espace de travail Apache Spark.