Cycle de vie des runtimes Apache Spark dans Fabric

Le runtime Microsoft Fabric est une plateforme intégrée à Azure basée sur Apache Spark. Il facilite l’exécution et la gestion des flux de travail d’ingénierie des données et de science des données. Il synthétise les éléments essentiels des ressources propriétaires et open source pour offrir une solution complète. Par souci de simplicité, nous faisons référence au runtime Microsoft Fabric optimisé par Apache Spark en tant que Runtime Fabric.

Cadence de publication

Apache Spark publie généralement des versions mineures toutes les 6 à 9 mois. L’équipe Microsoft Fabric Spark s’engage à fournir les nouvelles versions du runtime avec célérité tout en assurant une qualité et une intégration optimales ainsi qu’un support continu. Chaque version comprend environ 110 composants. À mesure que le runtime s’étend au-delà d’Apache Spark, nous assurons une intégration transparente au sein de l’écosystème Azure.

Avec un engagement à l’excellence, nous abordons attentivement les nouvelles versions du runtime en préversion, en ciblant une préversion expérimentale dans environ3 mois mais au final en établissant des chronologies au cas par cas. Cela implique l’évaluation des composants critiques de chaque version spark, notamment Java, Scala, Python, R et Delta Lake. Après une évaluation approfondie, nous créons une chronologie détaillée décrivant la disponibilité et la progression du runtime à travers différentes étapes. Dans l’ensemble, notre objectif est d’établir un chemin de cycle de vie standard pour les runtimes Microsoft Fabric pour Apache Spark.

Conseil

Utilisez toujours la version la plus récente du runtime GA pour votre charge de travail de production, qui est actuellement Runtime 1.3.

Le tableau suivant répertorie le nom du runtime et les dates de publication des versions du runtime Azure Synapse prises en charge.

| Nom du runtime | Étape de publication | Date de fin de prise en charge |

|---|---|---|

| Runtime 1.3 basé sur Apache Spark 3.5 | GA | 30 septembre 2026 |

| Runtime 1.2 basé sur Apache Spark 3.4 | GA | mardi 31 mars 2026 |

| Runtime 1.1 basé sur Apache Spark 3.3 | EOSA | lundi 31 mars 2025 |

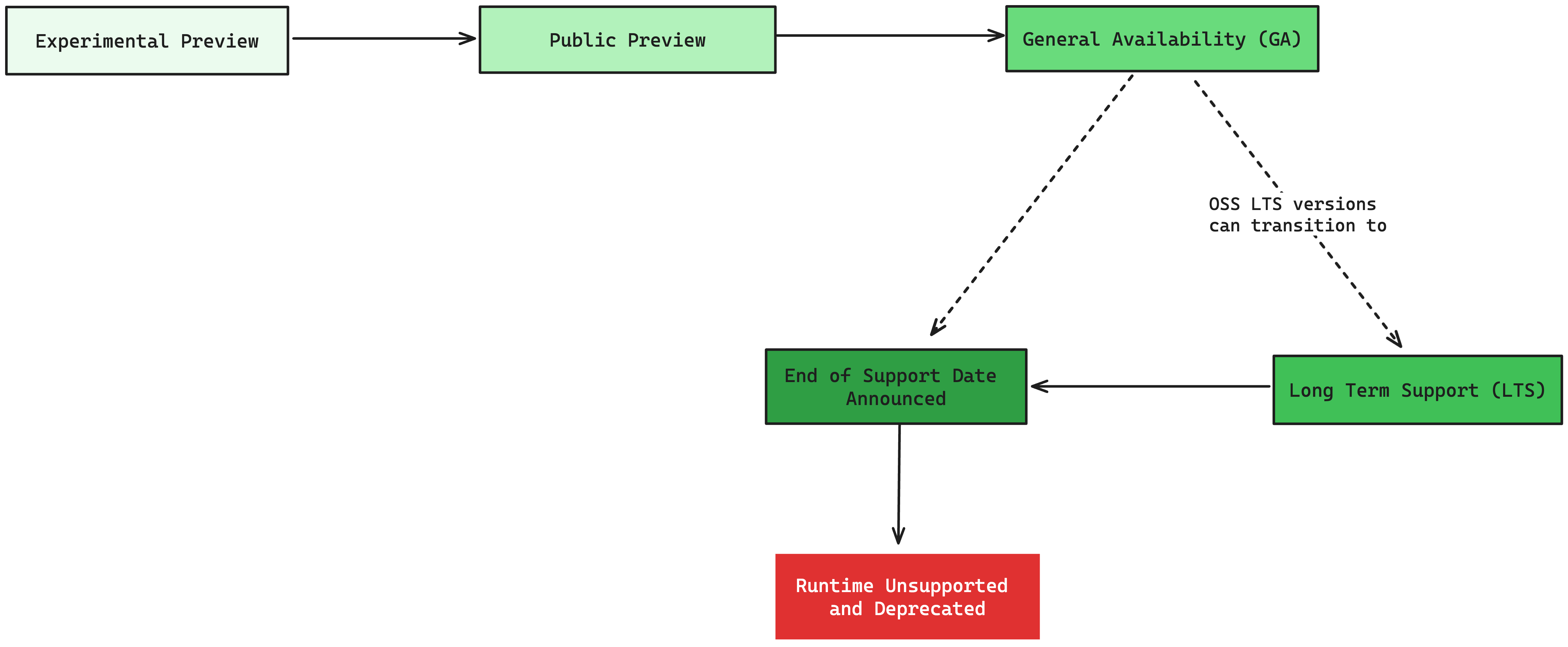

Le diagramme décrit le cycle de vie d’une version de runtime, depuis sa préversion publique expérimentale jusqu’à sa dépréciation et sa suppression.

| Étape | Description | Cycle de vie standard |

|---|---|---|

| Préversion publique expérimentale | La phase de préversion publique expérimentale marque la sortie initiale d’une nouvelle version du runtime. Au cours de cette phase, les utilisateurs sont invités à expérimenter les dernières versions d’Apache Spark et Delta Lake et à fournir des commentaires, malgré la présence de limitations documentées. Les conditions d’utilisation de la préversion Microsoft Azure s’appliquent. Consultez Conditions d’utilisation de la préversion. | 2-3 mois* |

| Préversion publique | Une fois que d’autres améliorations ont été apportées et que les limitations sont minimes, le runtime passe à la phase de préversion. Les conditions d’utilisation de la préversion Microsoft Azure s’appliquent. Consultez Conditions d’utilisation de la préversion. | 3 mois* |

| Disponibilité générale (GA) | Une fois qu’une version du runtime répond aux critères de disponibilité générale (GA), elle est publiée au public et convient aux charges de travail de production. Pour atteindre cette étape, le runtime doit répondre à des exigences strictes en termes de performances, d’intégration à la plateforme, d’évaluations de fiabilité et de sa capacité à répondre aux besoins des utilisateurs. | 24 mois |

| Support à long terme (LTS) | Après la version en disponibilité générale (GA), un runtime peut passer à l’étape de support à long terme (LTS), en fonction des exigences spécifiques de la version Spark. Cette phase LTS peut être annoncée, détaillant la durée de support prévue pour les clients, qui est généralement une année supplémentaire de support complet. | 12 mois* |

| Date de fin du support annoncée | Lorsqu’un runtime atteint sa fin du support, il ne reçoit aucune autre mise à jour ni support. En règle générale, un avis de six mois est donné avant la dépréciation du runtime. Cette date de fin du support est documentée par la mise à jour d’une table spécifique avec la date de fin de vie, qui marque l’arrêt du support. | 6 mois avant le jour de dépréciation |

| Date de fin du support. Runtime non pris en charge et déconseillé | Une fois que la date de fin du support annoncée arrive, le runtime n’est officiellement plus pris en charge. Cela implique qu’il ne recevra aucunes mises à jour ni correctifs de bogues, et aucune prise en charge ne sera fournie par l’équipe. Tous les tickets de support seront automatiquement résolus. L’utilisation d’un runtime non pris en charge est au risque de l’utilisateur. Le runtime sera supprimé des paramètres de l’espace de travail Fabric et de l’élément Environment, ce qui rendra son utilisation impossible au niveau de l’espace de travail. En outre, le runtime sera également supprimé des environnements et il n’y aura aucune option permettant de créer un environnement pour cette version du runtime prise en charge. Les travaux Spark existants exécutés sur les environnements existants ne pourront pas s’exécuter. | S/O |

| Runtime supprimé | Une fois que le runtime atteint la phase non prise en charge, tous les environnements utilisant ce runtime sont éliminés. Tous les composants liés au serveur principal associés à ce runtime sont également supprimés. | Quelques jours après la fin de la date de support |

* La durée attendue du runtime pour chaque étape. Ces délais sont donnés à titre d’exemple et peuvent varier en fonction de divers facteurs. Les chronologies du cycle de vie sont soumises à des modifications à la discrétion de Microsoft.

Gestion de version

Notre numérotation de version de runtime, bien qu’étroitement liée à la Gestion sémantique de version, suit une approche légèrement différente. La version principale de runtime correspond à la version principale Apache Spark. Par conséquent, Runtime 1 correspond à la version 3 de Spark. De la même façon, Runtime 2 à venir s’alignera sur Spark 4.0. Il est important de noter que des changements peuvent se produire entre les runtimes actuels, notamment l’ajout ou la suppression de différentes bibliothèques. En outre, notre plateforme propose une fonctionnalité de gestion de bibliothèques qui permet aux utilisateurs d’installer les bibliothèques souhaitées.

Contenu connexe

- Consultez Runtimes Apache Spark dans Fabric : vue d’ensemble, contrôle de version, prise en charge de plusieurs runtimes et mise à niveau du protocole Delta Lake

- Runtime 1.3 (Spark 3.5, Java 11, Python 3.11 et Delta Lake 3.2)

- Runtime 1.2 (Spark 3.4, Java 11, Python 3.10 et Delta Lake 2.4)

- Runtime 1.1 (Spark 3.3, Java 8, Python 3.10 et Delta Lake 2.2)