Perspective Well-Architected Framework sur Azure Load Balancer

Le processus d’équilibrage de charge distribue le trafic réseau à un groupe de deux serveurs principaux ou plus. Azure Load Balancer est un service natif Azure qui effectue l’équilibrage de charge de couche 4 pour le protocole UDP (User Datagram Protocol) et le protocole TCP (Transmission Control Protocol). Load Balancer permet de fournir une faible latence et une haute disponibilité pour les déploiements régionaux et globaux.

Cet article suppose qu’en tant qu’architecte, vous avez examiné les options d’équilibrage de charge dans Azure et choisi Load Balancer pour votre charge de travail. Les conseils fournis dans cet article proposent des recommandations architecturales correspondant aux principes des piliers du cadreWell-Architected.

Essentiel

Comment utiliser ce guide

Chaque section dispose d’une liste de contrôle de conception qui présente les domaines de préoccupations architecturales, ainsi que les stratégies de conception localisées dans l’étendue technologique.

Sont également incluses les recommandations relatives aux fonctionnalités technologiques qui peuvent aider à matérialiser ces stratégies. Les recommandations ne représentent pas une liste exhaustive de toutes les configurations disponibles pour Load Balancer et ses dépendances. Au lieu de cela, ils énumèrent les principales recommandations mappées aux perspectives de conception. Utilisez les recommandations pour créer votre preuve de concept ou optimiser vos environnements existants.

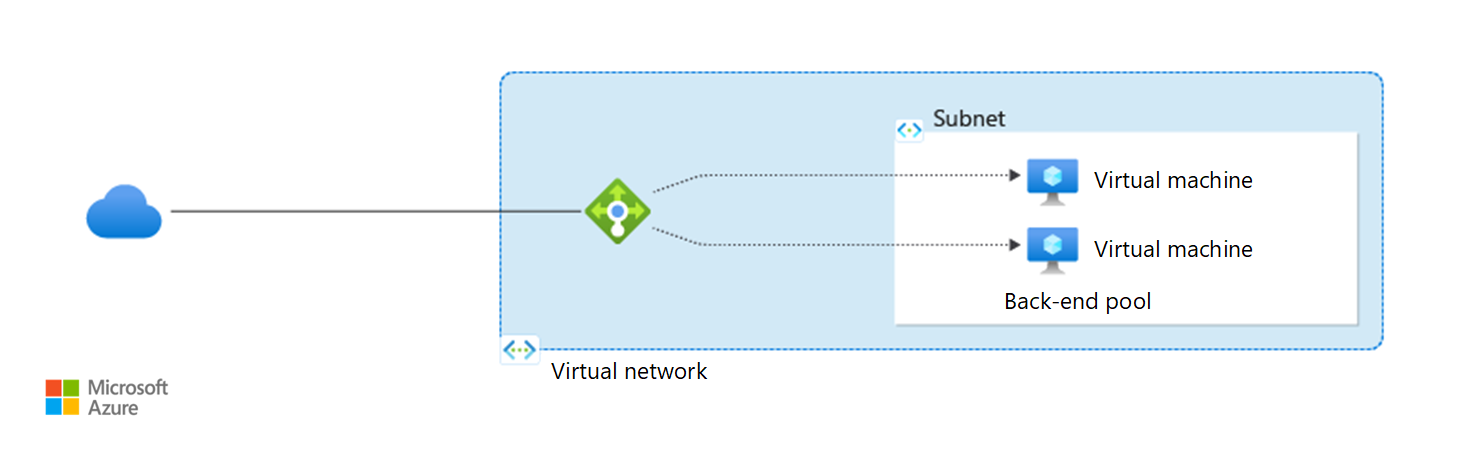

Architecture fondamentale qui illustre les recommandations clés :

Architecture de base des machines virtuelles Azure.

Champ d'application de la technologie

Cette révision se concentre sur les décisions interconnectées concernant les ressources Azure suivantes :

- Load Balancer

Ce guide porte sur le SKU Standard Load Balancer. Les SKU Basic Load Balancer et Gateway Load Balancer ne sont pas traités dans cet article.

Remarque

Pour les applications HTTP, envisagez Azure Application Gateway ou Azure Front Door au lieu de Load Balancer. Ces alternatives gèrent l’équilibrage de charge et fournissent également des fonctionnalités telles que le pare-feu d’applications web (WAF) et l’arrêt TLS (Transport Layer Security).

Pour plus d'informations, voir :

Fiabilité

L'objectif du pilier Fiabilité est de fournir une fonctionnalité continue en construisant suffisamment de résilience et la capacité de récupérer rapidement en cas de défaillance.

Les principes de conception pour la fiabilité fournissent une stratégie de conception de haut niveau appliquée aux composants individuels, aux flux du système et au système dans son ensemble.

Check-list pour la conception

Commencez votre stratégie de conception sur la base de la liste de contrôle de la revue de conception pour la fiabilité. Déterminez sa pertinence pour vos besoins métier tout en gardant à l’esprit les niveaux et fonctionnalités des machines virtuelles. Étendez la stratégie pour inclure davantage d’approches en fonction des besoins.

Comprendre l’impact des garanties soutenues par Microsoft. En plus d’autres composants de votre architecture, factorisez les contrats de niveau de service (SLA) dans la cible de fiabilité de votre charge de travail. Gardez à l’esprit les points importants suivants :

Si le point de terminaison à charge équilibrée ne peut pas se connecter à tous les serveurs principaux sains pendant une minute entière, cette minute est considérée comme indisponible. Toutefois, si au moins une requête réussit dans la même minute, même si d’autres échouent, cette minute n’est pas considérée comme un temps d’arrêt.

Les temps d’arrêt n’incluent pas les minutes provoquées par l’épuisement des ports SNAT (Source Network Address Translation). Veillez à configurer votre charge de travail pour gérer le nombre attendu de connexions et d’ouverture de ports en conséquence.

Prise en charge de la redondance de zone dans votre architecture de charge de travail. Nous vous recommandons la référence SKU Standard Load Balancer. Il dispose de fonctionnalités de fiabilité, telles que la prise en charge des zones de disponibilité, la distribution du trafic entre plusieurs régions et la possibilité de gérer davantage d’instances dans le pool principal. Ces fonctionnalités aident à résister aux défaillances zonales, régionales et individuelles de l’instance de machine virtuelle. Tenez compte des limitations, telles que la taille maximale du pool principal.

Remarque

Dans Load Balancer, vous gérez le nombre de machines virtuelles à équilibrage de charge, mais pas le nombre d’instances Load Balancer. Vous pouvez configurer une instance Load Balancer pour qu’elle soit redondante interzone ou l’épingler à une zone si la charge de travail doit colocaliser des machines virtuelles dans une seule zone. La configuration zonale ou multizone de l’adresse IP frontale détermine la redondance de l’équilibrage de charge.

Prendre en charge la redondance régionale dans votre architecture de charge de travail. Vous pouvez configurer Load Balancer pour qu’il s’agit d’un équilibreur de charge global. Dans cette configuration, Load Balancer a une adresse IP publique anycast statique qui diffuse dans plusieurs régions. Lorsque les clients demandent cette adresse IP, leurs requêtes accèdent à l’instance de serveur la plus proche. Load Balancer se connecte aux équilibreurs de charge régionaux pour distribuer efficacement le trafic.

Évaluez les modifications de votre pile réseau pour assurer une mise à l’échelle fiable. Envisagez d’étendre le pool de serveurs principaux en utilisant des règles de mise à l’échelle automatique. Tenez compte de l’épuisement potentiel du port SNAT pour le trafic sortant. Pour résoudre ce problème, utilisez la passerelle NAT Azure pour faciliter la configuration, mais comprenez qu’elle manque de redondance de zone de disponibilité. Vous pouvez également utiliser Load Balancer pour ajouter une redondance de zone. Pour plus d’informations, voir Connexions sortantes.

Atténuer les défaillances potentielles. Effectuez une analyse du mode d’échec et identifiez les atténuations. Le tableau suivant présente les types d’échecs et comment les atténuer.

Échec Limitation des risques Le trafic est acheminé vers des instances d’application non saines. Surveillez l’intégrité de l’instance de charge de travail. Implémentez des sondes d’intégrité HTTP qui incluent des vérifications des dépendances de charge de travail. Le trafic est acheminé vers une région qui a une panne. Déployez des instances supplémentaires dans une autre région. Ajoutez un équilibreur de charge global pour rediriger le trafic vers la nouvelle région. La base d’utilisateurs de la charge de travail a été développée pour prendre en charge les utilisateurs d’une nouvelle région et leur latence est élevée. L’application connaît désormais un nombre élevé de délais d’attente et d’échecs. Déployez des instances supplémentaires dans une nouvelle région et ajoutez-les dans la configuration du service. En tant qu’équilibreur de charge global, Azure Load Balancer achemine le trafic plus près des utilisateurs. Acheminer le trafic vers des instances saines. Vous pouvez utiliser HTTP ou TCP pour les sondes d’intégrité. Pour fournir des réponses de statut plus riches, envisagez de créer un point de terminaison HTTP pour les vérifications d’intégrité, même pour les applications qui ne sont pas basées sur HTTP. Cette approche est particulièrement utile pour la vérification des dépendances et des bases de données. Sans sondes HTTP, l’équilibreur de charge s’appuie sur les connexions TCP, ce qui peut ne pas refléter avec précision l’intégrité des machines virtuelles.

Vous pouvez configurer la sonde d’intégrité sur Load Balancer. Pour plus d’informations, consultez Directives de conception sur les sondes de santé.

Recommandations

| Recommandation | Avantage |

|---|---|

| Sélectionnez la référence SKU Standard Load Balancer. Pour plus d'informations, consultez le comparatif de SKU . |

Cette référence SKU prend en charge les fonctionnalités de fiabilité, telles que les zones de disponibilité et l’équilibrage de charge multirégion. |

| Configurez des règles pour mapper l’adresse IP front-end aux adresses IP des serveurs back-end pour permettre l’équilibrage de charge. Le pool d’adresses back-end devrait avoir au moins deux points de terminaison back-end afin d’équilibrer la charge pour la redondance. |

Les règles sont le cœur de l’algorithme d’équilibrage de charge. Sans cette configuration, les modes de distribution sont désactivés. |

| Configurez les sondes d’intégrité. - Définissez l’intervalle de détection et les valeurs de seuil. Prenez en compte le compromis entre la rapidité à laquelle vous pouvez détecter les défaillances et le nombre de requêtes adressées au point de terminaison. - Évaluez si vous souhaitez envoyer du trafic aux instances lorsque toutes les instances sont dans un état non sain. Vous pouvez utiliser cette configuration pour implémenter une expérience de dégradation progressive. Pour plus d’informations, consultez AllProbedUp. |

Seules les instances de pool principal saines reçoivent de nouvelles connexions. Cette configuration permet de maintenir la haute disponibilité et la fiabilité, car elle achemine le trafic loin des instances non saines. |

| Configurez les adresses IP privées et publiques pour qu’elles utilisent la redondance de zone. L’adresse IP détermine la redondance de zone de Load Balancer. | La redondance de zone aide la charge de travail à résister aux défaillances zonales. Lorsqu’une zone échoue, les services peuvent basculer vers l’une des zones restantes. |

Sécurité

L'objectif du pilier Sécurité est de fournir des garanties de confidentialité, d'intégrité et de disponibilité à la charge de travail.

Les principes de conception de la sécurité fournissent une stratégie de conception de haut niveau pour atteindre ces objectifs en appliquant des méthodes à la conception technique d'un répartiteur de charge.

Check-list pour la conception

Commencez votre stratégie de conception en vous basant sur la liste de contrôle de révision de conception pour la sécurité et identifiez les vulnérabilités et les contrôles permettant d’améliorer la posture de sécurité. Étendez la stratégie pour inclure davantage d’approches en fonction des besoins.

Passez en revue les bases de référence de sécurité. Pour améliorer la posture de sécurité de votre application qui est équilibrée par Azure Load Balancer, passez en revue la base de référence de sécurité pour Load Balancer.

Protégez les serveurs principaux. Déployez des ressources dans un réseau virtuel qui n’a pas d’exposition Directe à Internet. Placez le réseau virtuel devant un équilibreur de charge. Dans l’idéal, l’équilibreur de charge doit avoir des fonctionnalités de pare-feu. Pour les applications HTTP, envisagez Application Gateway ou Azure Front Door. Pour les applications non HTTP, envisagez Load Balancer avec une adresse IP privée (équilibreur de charge interne) et routez le trafic via le Pare-feu Azure pour renforcer la sécurité. Pour plus d’informations, consultez équilibreur de charge interne.

Vous pouvez également utiliser Load Balancer comme proxy inverse. Dans ce cas, l’équilibreur de charge a une adresse IP publique avec SNAT, qui expose les ressources tout en masquant leurs adresses IP.

Remarque

Pour filtrer le trafic vers des serveurs principaux, utilisez des groupes de sécurité réseau (NSG) sur les sous-réseaux qui contiennent le serveur frontal et le serveur principal. N’appliquez pas de groupe de sécurité réseau directement au service Load Balancer. Lorsque les groupes de sécurité réseau appliquent des règles, ils considèrent les ports sources, les ports de destination et les plages d’adresses des ordinateurs d’origine et de destination, et non l’équilibreur de charge.

Conception pour la connectivité privée. Load Balancer fonctionne avec Azure Private Link. Si vous répartissez des ressources d’application sur des réseaux virtuels, vous pouvez connecter des ressources dans différents réseaux virtuels. Utilisez le peering de réseaux virtuels ou placez Private Link devant l’équilibreur de charge interne. L’option Private Link fournit un accès plus sécurisé sans avoir besoin d’une adresse IP publique. Il restreint également l’accès à partir des réseaux non appairés.

Vous pouvez autoriser des liaisons privées via contrôle d’accès en fonction du rôle pour restreindre l’accès uniquement aux identités qui en ont besoin.

Protégez votre application contre les menaces à la périphérie du réseau. Pour les conceptions qui utilisent Load Balancer comme point d’entrée, implémentez l’inspection du trafic au niveau du point de terminaison. Cette conception n’a pas de fonctionnalités de sécurité intégrées comme un WAF. Vous devez donc ajouter des mesures supplémentaires pour sécuriser les applications HTTP. Pour plus d’informations, consultez la page Équilibreur de charge public. Veillez également à protéger les points de terminaison de l’équilibreur de charge contre les attaques par déni de service distribué (DDoS).

Chiffrer le trafic réseau. Load Balancer fonctionne au niveau de la couche 4 et prend entièrement en charge le trafic TCP et UDP d’équilibrage de charge. Load Balancer ne prend pas en charge l’arrêt SSL (Secure Sockets Layer) et TLS. Pour l’équilibrage de charge HTTPS au niveau de la couche Application, utilisez Application Gateway.

Recommandations

| Recommandation | Avantage |

|---|---|

| Configurer l’adresse IP frontale à une adresse IP privée dans un réseau virtuel. | Cette approche permet de s’assurer que l’adresse IP frontale et le réseau virtuel restent isolés de l’exposition directe à Internet. L’équilibreur de charge interne ne peut pas accepter le trafic entrant à partir d’Internet, ce qui réduit les vecteurs d’attaque potentiels. |

| Protéger l’équilibreur de charge public avec Azure DDoS Protection. | Un plan de protection DDoS fournit une protection avancée, y compris les fonctionnalités de détection qui surveillent le point de terminaison pour détecter les menaces et les signes d’abus. |

Optimisation des coûts

L’optimisation des coûts se concentre sur la détection des modèles de dépenses, la priorisation des investissements dans les domaines critiques et l’optimisation dans les autres afin de respecter le budget de l’organisation tout en répondant aux besoins de l’entreprise.

Les principes de conception de l’optimisation des coûts fournissent une stratégie de conception de haut niveau pour atteindre ces objectifs et faire des compromis si nécessaire dans la conception technique liée à Load Balancer et à son environnement.

Check-list pour la conception

Lancez votre stratégie de conception en vous basant sur la liste de contrôle de l'optimisation des coûts pour les investissements. Ajustez la conception afin que la charge de travail soit alignée sur le budget alloué pour la charge de travail. Votre conception doit utiliser les fonctionnalités Azure appropriées, surveiller les investissements et trouver des opportunités d’optimisation au fil du temps.

Tenez compte des dépenses d'équilibrage de charge dans votre modèle de coût. Tenez compte des principaux facteurs, tels que la quantité de données traitées par Load Balancer et le nombre de règles d’équilibrage de charge entrantes et sortantes. Pour une estimation précise des coûts, utilisez les journaux de trafic pour évaluer vos besoins de trafic entrant et sortant.

Définissez des contrôles sur les dépenses. Journaliser et analyser les coûts de Load Balancer. Pour gérer efficacement les coûts, utilisez Microsoft Cost Management pour créer des budgets et configurer des alertes. Les coûts peuvent s’accumuler en fonction de la quantité de données journalisées et de la durée de stockage, ce qui affecte la bande passante et les dépenses de stockage.

Supprimez les ressources inutilisées. Identifiez et supprimez les instances d’équilibreur de charge inutilisées. Analysez les journaux de connexion pour évaluer l’utilisation. Supprimez les instances d’équilibreur de charge qui ne sont pas associées aux machines virtuelles principales. Examinez les journaux de trafic pour rechercher les ressources sous-utilisées.

Optimiser les coûts de flux. Utilisez des protocoles et une compression de données efficaces pour réduire la charge sur le flux de trafic et réduire les coûts.

Pour optimiser les coûts, vous pouvez réduire le nombre de règles. Au lieu d’avoir des règles qui utilisent des adresses IP et des ports individuels pour chaque point de terminaison, définissez une règle pour une plage de ports dans le serveur frontal qui se connecte à un pool principal.

Implémentez l’optimisation dans les flux principaux. Par exemple, plusieurs requêtes de base de données interceptées par un équilibreur de charge peuvent augmenter les coûts par requête. Pour éviter ce coût supplémentaire, envisagez d’implémenter une procédure stockée pour consolider la séquence de requêtes.

Évaluez le coût des opérations. Tenez compte des dépenses de ressources et des coûts opérationnels, tels que la maintenance, la mise à l’échelle et la conformité. Les règles d’équilibreur de charge peuvent affecter considérablement les coûts. Réduisez le nombre de règles pour optimiser les coûts financiers et de gestion.

Recommandations

| Recommandation | Avantage |

|---|---|

| Utiliser la calculatrice de prix Azure pour estimer les coûts. | Vous pouvez convertir l’utilisation prévue du trafic en estimations de coûts, ce qui facilite la planification et le budget. |

| Évaluez le nombre de règles et réduisez-les, si possible. Déterminez si vous pouvez utiliser une règle pour résumer une plage de ports au lieu de définir plusieurs règles pour des adresses IP individuelles. Par exemple, vous pouvez utiliser règles NAT entrantes pour mapper des adresses IP et des ports à un pool principal plutôt qu’à des machines virtuelles individuelles. |

Les règles consolidées optimisent les coûts et simplifient les opérations. Lorsque vous effectuez un scale-up ou un scale-down, vous pouvez ajouter ou supprimer des adresses IP du pool principal sans modifier de règles. |

Excellence opérationnelle

L’excellence opérationnelle se concentre principalement sur les pratiques de développement , l’observabilité et la gestion des versions.

Les principes de conception d’excellence opérationnelle fournissent une stratégie de conception de haut niveau pour atteindre ces objectifs pour les besoins opérationnels de la charge de travail.

Check-list pour la conception

Commencez votre stratégie de conception en vous basant sur la liste de contrôle de révision de conception pour l’excellence opérationnelle afin de définir les processus d’observabilité, de test et de déploiement liés à Load Balancer.

Utilisez l’infrastructure en tant que code. Déployez et configurez Load Balancer avec d’autres composants réseau, tels que les réseaux virtuels, les appairages réseau, les points de terminaison privés et les groupes de sécurité réseau. Familiarisez-vous avec le type de ressource Microsoft.Network loadBalancers.

Utilisez le déploiement en couches pour les architectures hub-and-spoke. Déployez d’abord le hub, car il change moins fréquemment que la charge de travail déployée dans le réseau spoke. Déployez l’équilibreur de charge avec la charge de travail. Si vous réutilisez un équilibreur de charge unique sur plusieurs charges de travail, envisagez de le placer dans le hub.

Implémentez un système de surveillance réseau complet. Implémentez des fonctionnalités de diagnostic, telles que des métriques multidimensionnelles pour des analyses et des alertes en temps réel, des journaux de ressources basés sur le schéma d'événements de santé et le tableau de bord Azure Monitor Insights pour une surveillance complète du load balancer.

Recommandations

| Recommandation | Avantage |

|---|---|

| Utilisez les mesures multidimensionnelles. Pour réduire les alertes excessives, définissez le type d’agrégation sur Averageet utilisez une fenêtre de données de cinq minutes qui a un seuil de 95%. Pour plus d’informations, consultez Configurer des alertes pour les métriques multidimensionnelles. Passez en revue les exemples de disponibilité entrante et sortante. |

Les insights en temps réel complets et la configuration des alertes fournissent une détection améliorée des problèmes et activent les réponses rapides. |

| Capturez les journaux de ressources. Les entrées Load Balancer dépendent du schéma des événements d’intégrité. | Les journaux fournissent des enregistrements détaillés des événements afin que vous puissiez rapidement identifier et résoudre les problèmes. |

| Utilisez le tableau de bord intégré Azure Monitor Insights pour l'équilibreur de charge. | La visualisation facilite les choix de conception bien informés et vous aide à identifier, diagnostiquer et résoudre rapidement les problèmes. |

Pendant les opérations de maintenance, définissez l’état administrateur sur Down pour retirer une instance back-end de la rotation sans interrompre les connexions existantes. Cette configuration permet de s’assurer qu’aucune nouvelle connexion n’est transférée à l’instance back-end, tandis que les connexions existantes sont correctement arrêtées. |

Cette configuration État administrateur permet de réduire la surcharge et la complexité lorsque vous retirez une machine virtuelle de la rotation de l’équilibrage de charge pour la maintenance ou les correctifs réguliers. En guise de solution alternative pour retirer une instance back-end de la rotation, vous pouvez appliquer des groupes de sécurité réseau pour bloquer le trafic provenant de la sonde d’intégrité Load Balancer ou des adresses IP et ports du client. Cette option augmente la complexité. |

Efficacité des performances

L'efficacité des performances consiste à maintenir l'expérience de l'utilisateur même en cas d'augmentation de la charge en gérant la capacité. La stratégie inclut la mise à l’échelle des ressources, l’identification et l’optimisation des goulots d’étranglement potentiels, ainsi que l’optimisation pour des performances maximales.

Les principes de conception pour l’efficacité des performances fournissent une stratégie de conception de haut niveau pour atteindre ces objectifs de capacité en fonction de l’utilisation attendue.

Check-list pour la conception

Commencez votre stratégie de conception en vous basant sur la liste de contrôle de révision de conception pour l’efficacité des performances afin de définir une base de référence fondée sur les indicateurs clés de performance pour Load Balancer.

Déterminez les cibles de performances réseau. L’équilibreur de charge n’a aucune limite sur le trafic qu’il peut prendre en charge. Toutefois, lorsque vous définissez des cibles de performances et planifiez la capacité, vous devez tester les performances du réseau.

Utilisez des tests de contrainte pour comprendre les exigences de bande passante de la charge de travail. Incluez l’équilibreur de charge dans ces tests. Si un jeu d'échelle de machines virtuelles unique avec plusieurs VM n'est pas suffisant, vous pouvez ajouter un autre jeu d'échelle à l'aide du même équilibreur de charge. Si les machines virtuelles ne reçoivent pas suffisamment de demandes rapidement, vous devrez peut-être ajuster les composants réseau, tels que l’ajout d’équilibreurs de charge supplémentaires. Mais au lieu de modifier l’équilibreur de charge, envisagez d’apporter des modifications de conception et d’optimiser votre charge de travail pour mieux gérer la charge.

Comprendre les limites lorsque vous concevez votre stratégie de mise à l’échelle. Pour répondre aux exigences de performances et mettre à l’échelle votre charge de travail, ajoutez ou supprimez des machines virtuelles du pool principal. Un pool principal unique dans Standard Load Balancer peut gérer jusqu’à 5 000 machines virtuelles.

Load Balancer n’applique pas de limites de débit. Mais les limites de débit pour les machines virtuelles et les réseaux virtuels s’appliquent toujours. Pour plus d’informations, consultez Bande passante réseau d’une machine virtuelle.

Servir rapidement les demandes. Standard Load Balancer a un niveau qui route le trafic vers les points de terminaison principaux en fonction de leur proximité géographique avec l’utilisateur.

Load Balancer prend également en charge la distribution de charge en fonction de la persistance de session. Lorsque vous activez cette fonctionnalité, les demandes du même client sont constamment dirigées vers le même serveur principal qui a géré leurs sessions précédentes.

Collecter des données pour analyser les performances. Les mesures multidimensionnelles de Load Balancer peuvent analyser les performances du service. Configurez des alertes pour détecter les modifications de performances. Utilisez des outils comme le tableau de bord Azure Monitor Insights pour visualiser l’état de l'équilibreur de charge. Assurez-vous que la fonctionnalité d’intégrité des ressources surveille l’état d’intégrité, et restez informé des problèmes de performances et des pannes.

Optimisez le trafic réseau. Ne traitez pas les mêmes données plusieurs fois en étapes distinctes. Au lieu de cela, effectuez tous les calculs nécessaires dans un lot, puis conservez les données. Cette approche réduit la latence et réduit le trafic réseau, ce qui améliore les performances globales.

Recommandations

| Recommandation | Avantage |

|---|---|

| Sélectionnez le niveau global dans Standard Load Balancer si vous avez des utilisateurs globaux. | Le mode de distribution de géo-proximité de ce niveau traite les demandes des utilisateurs à partir de points de terminaison dans la région la plus proche, ce qui améliore les performances. |

| Déterminez si vous devez activer persistance de session lorsque vous souhaitez que les demandes du même utilisateur soient directes vers le même serveur principal. Du point de vue de la fiabilité, nous ne recommandons pas cette approche. Si vous utilisez cette option, l’application doit récupérer correctement sans perturber les sessions utilisateur. Il existe également un compromis d’équilibrage de charge, car il limite la flexibilité de la distribution du trafic sur plusieurs back-ends uniformément. |

La persistance de session peut optimiser les performances et maintenir la continuité des sessions utilisateur, en particulier lorsque les applications s’appuient sur la maintenance locale des informations d’état. Mais il y a des compromis. |

| Pendant le scale-out, envoyez un signal de sonde hors service jusqu’à ce que l’application soit entièrement initialisée et prête à traiter les requêtes. Pendant le scale-in, envoyez un signal de sonde hors service pour les nouvelles connexions sur le point de terminaison qui est mis à l’échelle. Les demandes en attente sur les connexions existantes continuent d’être traitées. |

Les sondes d’intégrité permettent d’optimiser les opérations de mise à l’échelle. Ils permettent de s’assurer que pendant le scale-out, l’application peut gérer la charge entrante. Avant une opération de mise à l’échelle, elles permettent une réduction fluide des instances sans perturber les opérations en cours. |

Stratégies Azure

Azure fournit un ensemble complet de stratégies intégrées liées à Load Balancer et à ses dépendances. Certaines des recommandations précédentes peuvent faire l’objet d’un audit via Azure Policy. Par exemple, vous pouvez vérifier si :

- Les équilibreurs de charge, à l’exception des équilibreurs de charge SKU de base, ont des fonctionnalités de résilience activées pour les adresses IP publiques dans leur interface frontale.

- Les journaux des ressources sont activés pour suivre les activités et les événements qui se produisent sur vos ressources et fournir une visibilité et des insights sur les modifications.

Pour une gouvernance complète, passez en revue les définitions intégrées Azure Policy pour Load Balancer et d’autres stratégies susceptibles d’affecter la sécurité de la distribution du trafic.

Recommandations Azure Advisor

Azure Advisor est un conseiller personnalisé basé dans le cloud qui décrit les meilleures pratiques à suivre pour optimiser vos déploiements Azure. Les recommandations d’Advisor sont alignées sur les piliers Well-Architected Framework.

Pour plus d’informations, consultez les recommandations de Azure Advisor.

Ressources associées

- architecture de base des machines virtuelles

- Documentation Load Balancer